前言:

用单机版的时候是不是感觉速度很慢,如果只有一个服务的话,挂了就直接GG拉。所以在实际的业务的时候我们一般用solr集群的来解决高并发,高可用的问题。

1.什么是SolrCloud

SolrCloud(solr 云)是Solr提供的分布式搜索方案,当你需要大规模,容错,分布式索引和检索能力时使用 SolrCloud。当一个系统的索引数据量少的时候是不需要使用SolrCloud的,当索引量很大,搜索请求并发很高,这时需要使用SolrCloud来满足这些需求。

SolrCloud是基于Solr和Zookeeper的分布式搜索方案,它的主要思想是使用Zookeeper作为集群的配置信息中心。

它有几个特色功能:

1)集中式的配置信息

2)自动容错

3)近实时搜索

4)查询时自动负载均衡

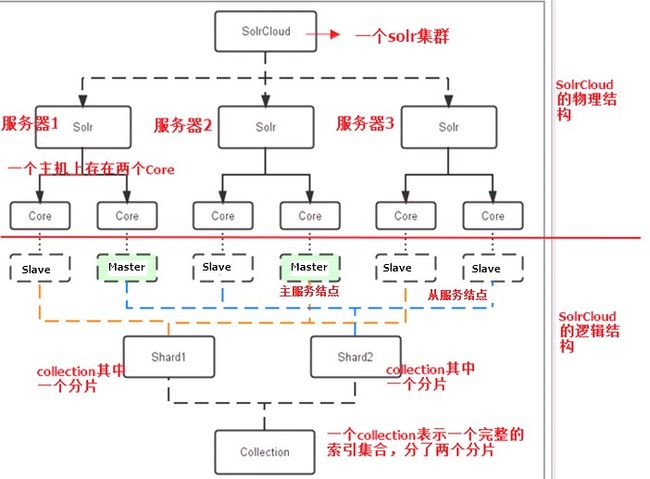

Solr集群的基本架构

物理结构

三个Solr实例( 每个实例包括两个Core),组成一个SolrCloud。

逻辑结构

索引集合包括两个Shard(shard1和shard2),shard1和shard2分别由三个Core组成,其中一个Leader两个Replication,Leader是由zookeeper选举产生,zookeeper控制每个shard上三个Core的索引数据一致,解决高可用问题。

用户发起索引请求分别从shard1和shard2上获取,解决高并发问题。

collection

Collection在SolrCloud集群中是一个逻辑意义上的完整的索引结构。它常常被划分为一个或多个Shard(分片),它们使用相同的配置信息。

比如:针对商品信息搜索可以创建一个collection。

collection=shard1+shard2+....+shardX

Core

每个Core是Solr中一个独立运行单位,提供 索引和搜索服务。一个shard需要由一个Core或多个Core组成。由于collection由多个shard组成所以collection一般由多个core组成。

Master或Slave

Master是master-slave结构中的主结点(通常说主服务器),Slave是master-slave结构中的从结点(通常说从服务器或备服务器)。同一个Shard下master和slave存储的数据是一致的,这是为了达到高可用目的。

Shard

Collection的逻辑分片。每个Shard被化成一个或者多个replication,通过选举确定哪个是Leader

2.需要实现的solr集群架构

上面的看的脑袋疼,搭个简单的好了

说明:

Zookeeper作为集群的管理工具。

1、集群管理:容错、负载均衡。

2、配置文件的集中管理

3、集群的入口

zookeeper也有投票制度(涉及redis的时候说明过),因为通过投票机制我们至少需要奇数的服务器,奇数的话1是不可能。那就至少3个;计划通。

然后根据上面的图我们还需要4个solr服务器。。。

需要7台虚拟机。。。 电脑吃不消;那么用伪分布式就好了:

搭建伪分布式需要三个zookeeper节点,4个tomcat节点;

推荐配置:

内存:2G!!一定要2G不然卡死,也有可能内存溢出

环境准备(你需要准备的东西)

- 一台虚拟机

- jdk-7u72-linux-i586.tar.gz

- apache-tomcat-7.0.47.tar.gz

- zookeeper-3.4.6.tar.gz

- solr-4.10.3.tgz

2.zookeeper(伪)集群搭建

第一步:安装jdk环境1.7(网上教程很多~)

第二步:把zookeeper的压缩包上传到服务器上(利用FileZilla工具)

第三步:解压

tar命令

第四步:把zookeeper复制三份

[root@localhost ~]# mkdir /usr/local/solr-cloud

[root@localhost ~]# cp -r zookeeper-3.4.6 /usr/local/solr-cloud/zookeeper01

[root@localhost ~]# cp -r zookeeper-3.4.6 /usr/local/solr-cloud/zookeeper02

[root@localhost ~]# cp -r zookeeper-3.4.6 /usr/local/solr-cloud/zookeeper03

第五步:在每个zookeeper目录下创建一个data目录。

第六步:在data目录下创建一个myid文件,文件名就叫做“myid”。内容就是每个实例的id。例如1、2、3

[root@localhost data]# echo 1 >> myid

[root@localhost data]# ll

total 4

-rw-r--r--. 1 root root 2 Apr 7 18:23 myid

[root@localhost data]# cat myid

1

记得每个都要改!

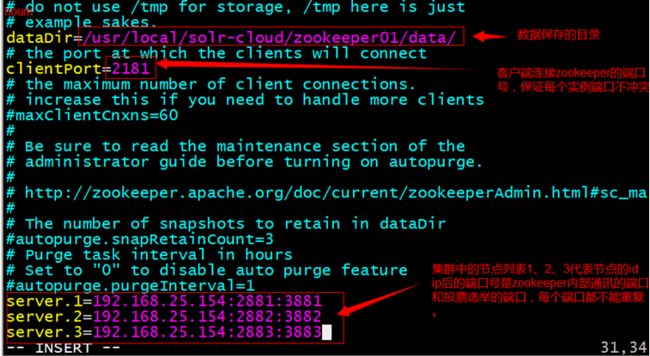

第七步:修改配置文件。把conf目录下的zoo_sample.cfg文件改名为zoo.cfg(IP号记得改成你自己的)

server.1=192.168.25.154:2881:3881

server.2=192.168.25.154:2882:3882

server.3=192.168.25.154:2883:3883

第八步:启动每个zookeeper实例。

写个启动文件

vim start-zookeeper.sh

cd zookeeper01/bin

./zkServer.sh start

cd ../../

cd zookeeper02/bin

./zkServer.sh start

cd ../../

cd zookeeper03/bin

./zkServer.sh start

cd ../../

~

./start-zookeeper.sh

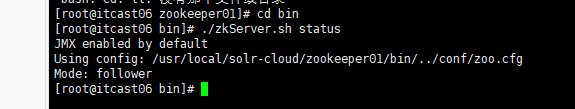

查看zookeeper的状态:

bin/zkServer.sh status

3.Solr集群的搭建

第一步:创建四个tomcat实例(复制黏贴)。每个tomcat运行在不同的端口。8180、8280、8380、8480

第二步:部署solr的war包。把单机版的solr工程复制到集群中的tomcat中。

第三步:为每个solr实例创建一个对应的solrhome。使用单机版的solrhome复制四份。

使用cp指令

第四步:需要修改solr的web.xml文件。把solrhome关联起来。(即和单机版的操作一样)

vim tomcat01/webapps/solr/web-inf/web.xml

第五步:配置solrCloud相关的配置。每个solrhome下都有一个solr.xml,把其中的ip及端口号配置好。

第六步:让zookeeper统一管理配置文件。需要把solrhome/collection1/conf目录上传到zookeeper。上传任意solrhome中的配置文件即可。

使用工具上传配置文件:/root/solr-4.10.3/example/scripts/cloud-scripts/zkcli.sh

./zkcli.sh -zkhost 192.168.25.154:2181,192.168.25.154:2182,192.168.25.154:2183 -cmd upconfig -confdir /usr/local/solr-cloud/solrhome01/collection1/conf -confname myconf

查看zookeeper上的配置文件:

使用zookeeper目录下的bin/zkCli.sh命令查看zookeeper上的配置文件:

[root@localhost bin]# ./zkCli.sh

[zk: localhost:2181(CONNECTED) 0] ls /

[configs, zookeeper]

[zk: localhost:2181(CONNECTED) 1] ls /configs

[myconf]

[zk: localhost:2181(CONNECTED) 2] ls /configs/myconf

[admin-extra.menu-top.html, currency.xml, protwords.txt, mapping-FoldToASCII.txt, _schema_analysis_synonyms_english.json, _rest_managed.json, solrconfig.xml, _schema_analysis_stopwords_english.json, stopwords.txt, lang, spellings.txt, mapping-ISOLatin1Accent.txt, admin-extra.html, xslt, synonyms.txt, scripts.conf, update-script.js, velocity, elevate.xml, admin-extra.menu-bottom.html, clustering, schema.xml]

[zk: localhost:2181(CONNECTED) 3]

退出:

[zk: localhost:2181(CONNECTED) 3] quit

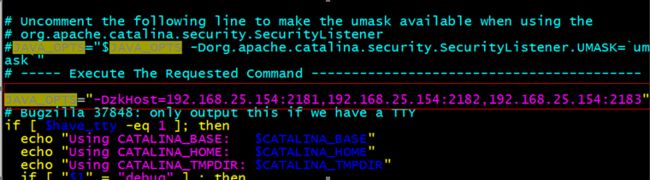

第七步:修改tomcat/bin目录下的catalina.sh 文件,关联solr和zookeeper。

把此配置添加到配置文件中:

JAVA_OPTS="-DzkHost=192.168.25.154:2181,192.168.25.154:2182,192.168.25.154:2183"

第八步:启动每个tomcat实例。要保证zookeeper集群是启动状态。

tomcat也弄个一键启动

vim start-tomcat.sh

/usr/local/solr-cloud/tomcat01/bin/startup.sh

/usr/local/solr-cloud/tomcat02/bin/startup.sh

/usr/local/solr-cloud/tomcat03/bin/startup.sh

/usr/local/solr-cloud/tomcat04/bin/startup.sh

第九步:访问集群

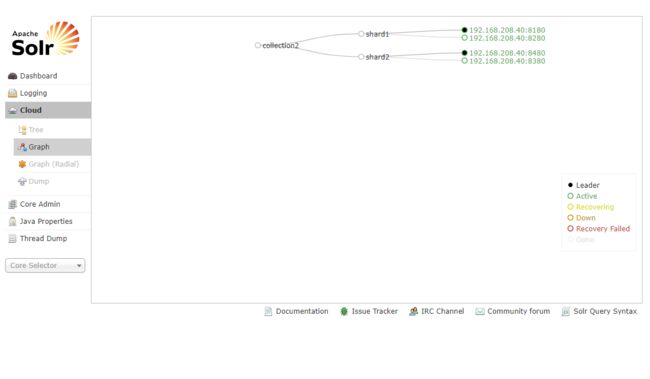

我这个是分片好的效果

创建新的Collection进行分片处理。

http://192.168.25.154:8180/solr/admin/collections?action=CREATE&name=collection2&numShards=2&replicationFactor=2

提示success就是成功了

删除不用的Collection。

http://192.168.25.154:8180/solr/admin/collections?action=DELETE&name=collection1