BP学习算法-构建三层神经网络

引:

人工神经网络(Artificial Neural Networks,简写为ANNs)也简称为神经网络(NNs)或称作连接模型(Connection Model),是一种模仿动物神经网络行为特征,进行分布式并行信息处理的算法数学模型。这种网络依靠系统的复杂程度,通过调整内部大量节点之间相互连接的关系,从而达到处理信息的目的。在人工神经网络发展的第二次热潮时期,1986年,鲁姆尔哈特(Rumelhart)和麦克劳(McCellan)等在《ParallelDistributedProcessing》中提出反向传播学习算法(B-P算法)。

下面首先对神经网络做简单的介绍,然后再结合实例对B-P算法的原理和编程实现的步骤进行剖析,代码实现部分附在最后面。

正文:

[ 1 ]神经网络模型

神经网络是一种模拟人脑的神经网络以期能够实现类人工智能的机器学习技术。人脑中的神经网络是一个非常复杂的组织。成人的大脑中估计有1000亿个神经元之多,它们彼此交织相连,可以完成学习、记忆、概括、推理等复杂工作。而人工神经网络也以神经元作为基本单位,在不断的训练过程中形成记忆,从而完成较为复杂的推理预测工作,其基本模型包括单层神经网络、多层神经网络以及全连接神经网络,如下图所示:

图中的箭头可视为数据流,表示数据的输入、流向和输出;圆形是神经元,用于模拟人脑神经元的功能,具备一定的职能,对输入到该神经元的数据依据激励函数进行变换,得到输出值。单层神经网络很容易理解。多层神经网络稍微复杂,如上图中的两层神经网络,在进行数据处理时,输入层的的输出值作为隐含层的输入值,隐含层的输入值又会作为输出层的输入,层层递进。二而对于全连接型的网络运算情况就更为复杂,在此不作深入阐述。

[ 2 ]人工神经元模型

下面来讨论一下“神经元”这个基本单元的构成及其工作方式。如下图所示:

图中,Xi(t),i=1,2,3,4,5作为该神经元模型的输入,w表示每个输入值对应的权值大小,两者经过乘积运算求和处理后被送入神经元Neuron i中;与阈值b经过某种映射变换f,最终得到输出值Yi(t)。这里的映射变换关系被称为作用在(b + ΣXi(t)*Wi)上的“激励函数”,即:三者之间存在的关系可表达为如下式子:

上式即可用于描述单个人工神经元的工作原理。

而关于激励函数(Transfer Function),也可称为传递函数,常用的激励函数包括:二值型函数、线性函数、S型函数等。在此不再进行详述,后面会有结合实例再次进行阐述。

[ 3 ]人工神经网络基本结构及其分类

如下图所示为多层神经网络的基本结构,上面我们提到“人工神经网络也以神经元作为基本单位,在不断的训练过程中形成记忆,从而完成较为复杂的推理预测工作”,那么,这里的记忆就对应于权值个阈值。BP算法中,权值的修正是通过一个误差反向传播过程完成的,属于反馈型网络,但相应的,也有前向型网络,因此,在这里我们对前向型神经网络和反馈型神经网络进行一个简单区分。①在前向型神经网络中,各神经元从输入层开始,接收前一级输入,并输出到下一级,直至输出层。整个网络中无反馈,可用一个有向无环图表示。

②而在反馈型神经网络中,每个神经元同时将自身的输出信号作为输入信号反馈给其他神经元,它需要工作一段时间才能达到稳定。其中全连接型神经网络就是后者的典型实例。

[ 4 ]监督学习与B-P神经网络

[ 4.1 ]监督学习

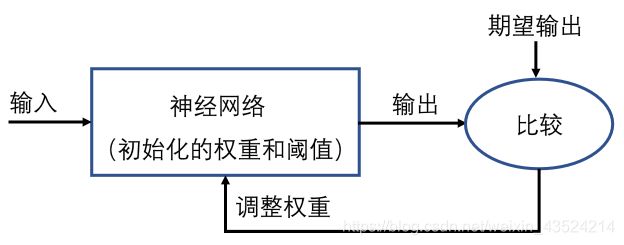

监督学习也被称为“有师学习”,具体而言,就是需要提供训练集:{p1,t1},{p2,t2},......{p1,t1},其中pi是输入,ti是输出。学习算法通过比较对应于每个输入的实际值和期望输出值,利用比较误差来调整整个网络的权值。其流程如下:

下面讨论的B-P学习算法的实现也属于有师学习范畴。但上述原理只是给出了在有输入值、实际输出值和期望输出值的条件下,进行权值调整的思路,但是对于多层神经网络中间的隐含层来说,它们并没有对应的可供参考的期望输出值,那么如何对隐含层发对应的权值进行调整?这就是下面在B-P算法中要讨论到的问题。

[ 4.2 ]B-P神经网络

B-P神经网络,是一种按照误差逆向传播算法训练的多层前馈神经网络,它系统地解决了多层神经网络隐含层连接权学习问题,并在数学上给出了完整推导。 它的基本网络结构如下图,

对于基本神经元之间的变换关系,在[ 2 ]人工神经元模型中已经做过叙述,下面,我们来看一下B-P神经网络的工作过程,即:从训练集到最终预测结果这中间经过的两大步骤。这也是之后我们在具体实例中求解问题的主要思路框架。

⚫第一阶段或网络训练阶段:给定N组输入样本:xi=[xi1,xi2,…,xip1]T

输出样本:di=[di1,di2,…,din],Ti=1,2,…,N

通过针对输入集和输出集的训练,对网络的连接权进行学习和调整,以使该网络实现给定样本的输入输出映射关系。

⚫第二阶段或称工作阶段:把实验数据或实际数据输入到网络,网络在误差范围内预测计算出结果。

[ 4.3 ]B-P学习算法基本原理

利用BP学习算法进行问题求解时,主要经历一下几个步骤:➢正向传播:输入样本——输入层——各隐含层——输出层,主要是为了通过输入值和权值以及激励函数获取每一层对应的实际输出值;

➢判断是否转入误差反向传播阶段:若输出层的实际输出与期望输出不符,则反向传播误差;

➢误差反传:误差以某种形式在各层表示——根据误差结果进行各层的权值调整;

➢终止条件:网络输出的误差达到可以接受的程度或则达到预先设定的学习次数

[ 4.4 ]B-P学习算法权值调整方式

权值调整也是BP算法关注的核心问题,下图中:Xji表示当前第n层的实际输入值,也就是第(n-1)层的实际输出值。ΔWji表示的是权值调整量,计算出权值调整量之后,在原先的权值基础上加上该调整量ΔWji即可得到修正后的权值。这在后面的代码中都有体现。

[ 5 ]问题描述与代码求解

[ 5.1 ]问题描述

| 月份 | 1 | 2 | 3 | 4 | 5 | 6 |

| 销量 | 2056 | 2395 | 2600 | 2298 | 1634 | 1600 |

| 月份 | 7 | 8 | 9 | 10 | 11 | 12 |

| 销量 | 1873 | 1478 | 1900 | 1500 | 2046 | 1556 |

[ 5.2 ]思路分析

【1】原始数据归一化处理。为方便后续计算,将原始数据用一维数组存放后进行归一化处理;【2】数据分组。通过数据分组确定训练集和输出值;

【3】初始化权重值。这一步可通过随机数生成函数来实现,为方便运算,最好生成0-1之间的浮点型随机数作为权值;

【4】构建神经网络。主要是确定每一层在激励函数控制下的运算规则,以确定输出值;

【5】确定训练次数和误差阈值;

【6】开始训练,直到达到预定训练次数或者小于指定误差阈值就终止;

【7】利用训练数据检验训练结果,并进行下一年的1月份销售额的预测。

[ 5.3 ]代码实现

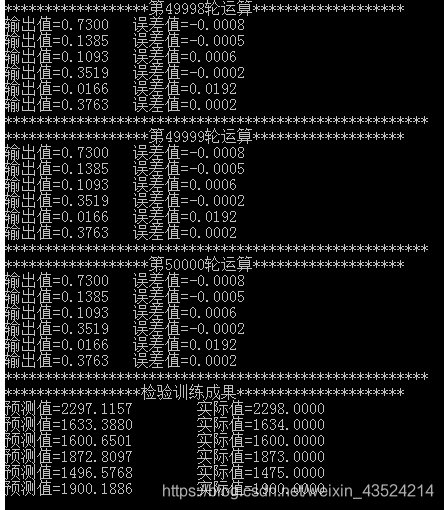

先上一张经过50000次训练后得到的误差值和检验训练结果的截图(所设置的学习常数的不同,对应的学习效率也会有所差别)下面是具体的实现代码,针对于每步所作的操作附有注释。

#include结束:

好了,分享到这里就结束了,以上内容来是所学建模课程实验内容的延申。谈一谈这中间的感悟就是:在使用BP算法求解实际问题时,我觉得最重要的还是得先理清思路,弄清楚每一步要干什么,比如:这一步需要什么样的输入,经过带入激励函数完成变换后,会产生什么样的输出,这个输出值对问题求解有什么意义。然后就是使用代码去实现这些想法了。但如果对问题确实没有什么明确的思路,也可以尝试着一边理解一边编写代码去实现,只不过最终实现之后将代码重新整理一遍就是了。

在此也作出说明:上述内容仅为个人对B-P学习算法的一些愚见,所附代码是针对上面实例所写,并不具备通用性,仅供参考。对于其他问题的求解,部分代码仍需结合实际情况自行修改。请大家多多指教!