“时代已经非复少年时代了,谁还有悠闲的心情在闷人的风雨中煮酒烹茶与琴诗为侣呢?”

2018年底,加入平安,工作生活一如既往紧张,如履薄冰。

第一件落在我头上的,便是“搞人工智能”。

如何开始的

对于一个开发者来说,拘泥于语言或者某种技术,是十分不好的。所谓“君子不器”,首先我们是人,其次是我们会用工具---而不是把我们变成工具。我本来是做后台开发的,50%java/50%php算是我的技术构成吧。

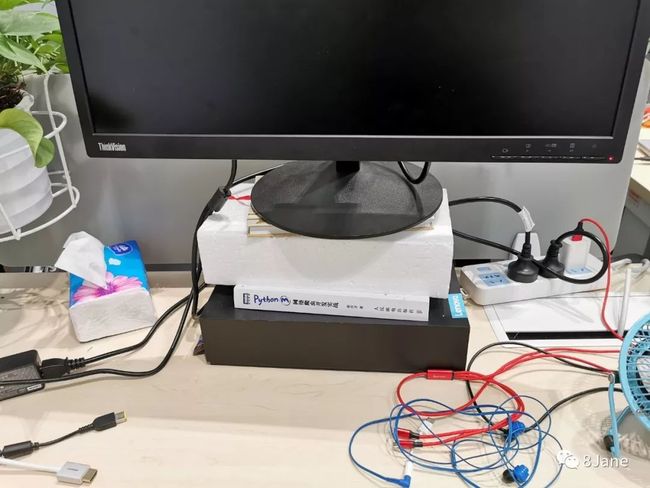

入职没多少天,我就被分到了一间会议室中,里面密密麻麻坐着十来位同事,环境很逼仄,对我这样的肩颈病患来说,可以说是相当不友好(之间喜欢把显示屏垫得老高,现在只能拿笔记本敲代码)。

有一天,架构师走了进来,拿出了“关卡选择”:EASY--单点登录、NORMAL--爬虫、HARD--CV方向深度学习,好让我们几个新人别闲置着。我果断选择了NORMAL难度(后来发现并不normal,一直在爬虫,反爬虫,反反爬虫之间游走),但是这个小爬虫,只做了不到一个月,没任何上线,也只是开启了我python之路,仅此而已。

分到搞深度学习那哥们,没弄几天,就做回老本行了。领导找到我,认为我也会python了,要不接一下?

好的,接吧。当时甚至还有些兴奋。

迷茫中探索

第一个需求就是识别一些违规场景,面对的一片漆黑的溪水,打着灯摸石子过河。训练样本图片怎么来?选用什么模型?怎么评估模型?怎么调优模型?部门没有人有太多经验。

我们用的是yolov3,前期因为缺乏经验,效果相当不好。那时也犯了焦虑,把很多很基础的理论知识都打算过一遍:

- 吴恩达的课程必不可少!

- 《python深度网络》必须刷一遍!

- 自己实现一个反向传播!

还有很多很多,浏览器的收藏夹塞得满满当当的。项目是紧迫的,它可不会给你太多优待。

当时认为深度学习并不像springboot,laravel这些技术,可以开箱即用,少了这份爽感的同时,也会让人束手无策。于是我就加了一些QQ群,在里面观察了几天,挑出了几个技术大佬,加了他们微信,5块钱问一个问题,美其名:“别客气,拿去喝啤酒”。

算法弃坑过程

之前的定位便错了,老想着修改模型结构,模型裁剪等等。前期“焦虑”而狼吞虎咽地学习一波理论知识,虽然有点囫囵吞枣消化不良,但给后期模型调参提供了理论支撑。若不是对场景识别效果相当严格的,深度学习也可以是“开箱即用”的。

“人工智能”,“AI”,这些存在于科幻电影里的词汇,即使是处处广告牌都是“AI赋能”,你也得承认,现阶段也仅仅存在于科幻电影里,我们只有深度学习和机器学习。

这是一篇文章的观点,本人表示很赞同。突然有一天,AlphaGo的新闻通过推送平台罗列在每个人的手机消息栏里,注定会有许多人像个小学生一样,通过几个词在自己的想象中发酵,大书特书。人即将成为神,可以造人,像极了电影《普罗米修斯》。

个人观点是,人工智能技术,必将被广泛应用,但是像从“蒸汽时代”过渡到“电气时代”这种程度,这就有点玄幻了。

很多公众号也开始带节奏,也正是这股风气,有点全民学AI的感觉。他们都抓住了一点,不学AI=失业,后台的同学们,赶紧学起来呀!

经过一年的摸爬滚打,慢慢从算法上弃坑了,观点有三:

- 算法能力要求过高,需要大量时间去重温高数,加之github很多优秀的神经网络可以选择;

- 算法工作有点“一夫当关万夫莫开”的感觉,就业面没有想象中那么广;

- 任何东西都需要落地,没有场景,模型拥有再好的精确度和召回率,也是纸上谈兵。

于是我着重做以下事情:

1.学会评估服务器资源

通过压力测试,找到服务器的支撑能力。在不同的框架下(如tensorflow或者pytorch)对显存的管理方案是不同的,tensorflow可以约定显存的使用率pytorch却不能,可以通过nvidia-docker的设置来限定显存使用,从而好预估服务线性拓展的能力,也能更好的利用宝贵的GPU资源。

2.学会评估深度神经网络的优劣

现在手上主打的深度神经网络是Cascade R-CNN和yolov3,前者检测更为精准,而后者则更快。之前与同事预研实时流AI检测,当时选用了yolov3。yolov3可以在数十毫秒完成检测,如果根据24帧/s来计算,只要检测速度进入40毫秒就可以了。当然这只是一个识别场景,即一个label,如果多几个识别场景,就需要从业务上进行优化了。

3.分布式训练

分布式训练一般有两类:相同时间内,loss值下降得更快;训练轮数相同时,loss值下降更快。经过测试,时间或者loss值的改变和GPU个数是类线性关系的,但是在实际的训练过程中,会逐渐偏离线性。个人认为使用第二种方案会比较好,因为在训练的后期loss值到一个平谷,那时时间再长,也走不出平谷,所以选用第一种方案可能前期loss值降的很快,但是后期都是在做无用功。用第二种方案,就能手动设置训练轮数,节省不必要的训练时间。测了几种分布式的方案,最终是选择了优步公司的Horovod作为分布式训练的技术选型。

4.自己开发小工具,减少重复劳动

为了减少重复工作开发了很多小工具,如统计标签,图片的数据增强等等,觉得最有用的是自己开发的样本分拣系统。由于标注的人员比较多,大家对标注的理解不一,会导致一些很差的样本混进训练集,随着样本数越来越庞大,我复核的时间也越来越长,相当辛苦。当时为了评估模型的好坏,用mAP算法对模型进行考核,突发奇想为何不把mAP作用到训练集呢?从而评估训练样本的优劣程度。通过自动化的检测+分拣,我审核的样本数量大大减少,从原来的1.2万张图片选出200多张质量差的样本,而不需要我将1.2万全量肉眼扫一遍了。

不管是算法类还是工程类,都遇到很多坑:分布式跑不通,github上issue没有回复,调几天终于调出来;和同事没日没夜标注,但效果不好,重新换一种标注方式,再从头来一遍;配置参数没经验,根据“控制变量法”,只能一个个调一次次跑,生怕“污染”了原本训练效果好的调参......这一些看似浪费了大量的时间,但也正是积累和扎根的过程,这一整年也是受益匪浅。想想做人工智能的科学家也真是伟大,能把万物提炼成简单的数字矩阵,存在小小的磁盘中,《普罗米修斯》、《黑客帝国》、《西部世界》这会不会就是未来呢?