块存储、对象存储、文件存储的联系和区别

块存储、对象存储、文件存储的联系和区别

通常来讲,磁盘阵列都是基于Block块的存储,而所有的NAS产品都是文件级存储。

\1. 块存储:DAS SAN

a) DAS(Direct Attach Storage): 是直接连接于主机服务器的一种存储方式,每台服务器有独立的存储设备,每台主机服务器的存储设备无法互通,需要跨主机存取资料室,必须经过相对复杂的设定,若主机分属不同的操作系统,则更复杂。

应用:单一网络环境下且数据交换量不大,性能要求不高的环境,技术实现较早。

b) SAN(Storage Area Network): 是一种高速(光纤)网络联接专业主机服务器的一种存储方式,此系统会位于主机群的后端,它使用高速I/O联接方式,如:SCSI,ESCON及Fibre-Channels.特点是,代价高、性能好。但是由于SAN系统的价格较高,且可扩展性较差,已不能满足成千上万个CPU规模的系统。

应用:对网速要求高、对数据可靠性和安全性要求高、对数据共享的性能要求高的应用环境中。

\2. 文件存储

通常NAS产品都是文件级存储。

NAS(Network Attached Storage):是一套网络存储设备,通常直接连在网络上并提供资料存取服务,一套NAS储存设备就如同一个提供数据文件服务的系统,特点是性价比高。

它采用NFS或CIFS命令集访问数据,以文件为传输协议,可扩展性好、价格便宜、用户易管理。目前在集群计算中应用较多的NFS文件系统,但由于NAS的协议开销高、带宽低、延迟大,不利于在高性能集群中应用。

\3. 对象存储:

总体上讲,对象存储同时兼具SAN高级直接访问磁盘特点及NAS的分布式共享特点。

核心是将数据通路(数据读或写)和控制通路(元数据)分离,并且基于对象存储设备(OSD),构建存储系统,每个对象存储设备具备一定的职能,能够自动管理其上的数据分布。

对象储存结构组成部分(对象、对象存储设备、元数据服务器、对象存储系统的客户端)

3.1 对象

一个对象实际就是文件的数据和一组属性信息的组合。

3.2 对象存储设备(OSD)

OSD具有一定的智能,它有自己的CPU、内存、网络和磁盘系统。

OSD提供三个主要功能:包括数据存储和安全访问

(1)数据存储 (2)智能分布 (3)每个对象元数据的管理

3.3 元数据服务器(Metadata Server , MDS)

MDS控制Client与OSD对象的交互,主要提供以下几个功能:

(1) 对象存储访问

允许Client直接访问对象,OSD接收到请求时先验证该能力,再访问。

(2) 文件和目录访问管理

MDS在存储系统上构建一个文件结构,限额控制、包括目录、文件的创建、访问控制等

(3) Client Cache 一致性

为提高性能,在对象存储系统设计时通常支持Client的Cache。因此带来了Cache一致性的问题,当Cache文件发生改变时,将通知Client刷新Cache,以防Cache不一致引发的问题。

对象存储:

一个文件包含了属性(术语叫matadata元数据,例如该文件的大小、修改时间、存储路径等)以及内容(简称数据)。

以往的文件系统,存储过程将文件按文件系统的最小块来打散,再写进硬盘,过程中没有区分元数据(metadata)和数据。而在每个块最后才会告知下一个块的地址,因此只能一个一个读,速度慢。

而对象存储则将元数据独立出来,控制节点叫元数据服务器(服务器+对象存储管理软件),里面主要存储对象的属性(主要是对象的数据被打散存放到了那几台分布式服务器中的信息),而其他负责存储数据的分布式服务器叫做OSD,主要负责存储文件的数据部分。当用户访问对象时,会先访问元数据服务器,元数据服务器只负责反馈对象存储在那些OSD。假设反馈文件A存储在B,C,D三台OSD,那么用户就会再次访问三台OSD服务器去读取数据。

这时三台OSD同时对外传输数据,因此传输的速度就加快了。OSD服务器数量越多,这种读写速度的提升就越大。

另一方面,对象存储软件有专门的文件系统,所以OSD对外又相当于文件服务器,那么就不存在文件共享方面的困难了,也解决了文件共享方面的问题。

因此对象存储的出现,很好的结合了块存储与文件存储的优点。

为什么还要使用块存储和文件存储:

1.有一类应用是需要存储直接裸盘映射的,比如数据库。因为数据库需要存储裸盘映射给自己后,再根据自己的数据库文件系统来对了裸盘进行格式化,因此不能采用其他已经被格式化为某种文件系统的存储。此类更适合块存储。

2.对象存储的成本比普通的文件存储还是较高,需要购买专门的对象存储软件以及大容量硬盘。如果对数据量要求不是海量,只是为了作文件共享的时候,直接用文件存储的形式就好了,性价比高。

对象存储、块存储、文件系统存储概念与区别

一、概念及区别

针对不同的应用场景,选择的分布式存储方案也会不同,因此有了对象存储、块存储、文件系统存储。这三者的主要区别在于它们的存储接口:

\1. 对象存储:

也就是通常意义的键值存储,其接口就是简单的GET,PUT,DEL和其他扩展,如七牛、又拍,Swift,S3

\2. 块存储:

这种接口通常以QEMU Driver或者Kernel Module的方式存在,这种接口需要实现Linux的Block Device的接口或者QEMU提供的Block Driver接口,如Sheepdog,AWS的EBS,青云的云硬盘和阿里云的盘古系统,还有Ceph的RBD(RBD是Ceph面向块存储的接口)

\3. 文件存储:

通常意义是支持POSIX接口,它跟传统的文件系统如Ext4是一个类型的,但区别在于分布式存储提供了并行化的能力,如Ceph的CephFS(CephFS是Ceph面向文件存储的接口),但是有时候又会把GFS,HDFS这种非POSIX接口的类文件存储接口归入此类。

二、IO特点

按照这三种接口和其应用场景,很容易了解这三种类型的IO特点,括号里代表了它在非分布式情况下的对应:

\1. 对象存储(键值数据库):

接口简单,一个对象我们可以看成一个文件,只能全写全读,通常以大文件为主,要求足够的IO带宽。

\2. 块存储(硬盘):

它的IO特点与传统的硬盘是一致的,一个硬盘应该是能面向通用需求的,即能应付大文件读写,也能处理好小文件读写。但是硬盘的特点是容量大,热点明显。因此块存储主要可以应付热点问题。另外,块存储要求的延迟是最低的。

\3. 文件存储(文件系统):

支持文件存储的接口的系统设计跟传统本地文件系统如Ext4这种的特点和难点是一致的,它比块存储具有更丰富的接口,需要考虑目录、文件属性等支持,实现一个支持并行化的文件存储应该是最困难的。但像HDFS、GFS这种自己定义标准的系统,可以通过根据实现来定义接口,会容易一点。

因此,这三种接口分别以非分布式情况下的键值数据库、硬盘和文件系统的IO特点来对应即可。至于冷热、快慢、大小文件而言更接近于业务。但是因为存储系统是通用化实现,通常来说,需要尽量满足各种需求,而接口定义已经一定意义上就砍去了一些需求,如对象存储会以冷存储更多,大文件为主。

三、Ceph的对象存储、块存储、文件系统存储

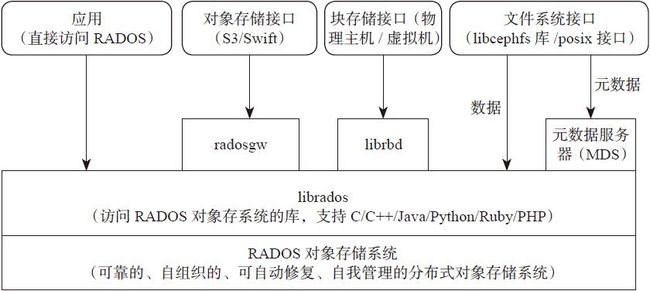

Ceph同时支持这三种存储,方法就是通过支持不同的接口来支持不同的存储。下面是Ceph的基本架构图,可以看到通过兼容AWS的S3和OpenStack的Swift接口来支持对象存储,通过librbd库提供块存储的接口,通过libcephfs库的文件系统接口或标准posix接口来支持文件系统存储。

种存储,方法就是通过支持不同的接口来支持不同的存储。下面是Ceph的基本架构图,可以看到通过兼容AWS的S3和OpenStack的Swift接口来支持对象存储,通过librbd库提供块存储的接口,通过libcephfs库的文件系统接口或标准posix接口来支持文件系统存储。