爬虫基础之基本库requests的使用

文章目录

- 使用requests

-

- 基本用法

-

- 1.准备工作

- 2.实例引入

- 3.GET请求

- 4.POST请求

- 5.响应

- 高级用法

-

- 1.文件上传

- 2.Cooikes

- 3.会话维持

- 4.SSL证书验证

- 5.代理设置

- 6.超时设置

- 7.身份认证

- 8.Prepared Request

使用requests

上一篇文章,我们了解了爬虫基础之基本库urllib的使用,但是其中有一些不方便,比如处理网页验证和Cooikes时,需要写Opener和Handler来处理。为了实现这些操作,就有了更为强大的库requests。

基本用法

1.准备工作

安装requests,可以使用pip命令安装,也可以在pycharm中下载插件。

2.实例引入

import requests

r = requests.get('https://www.baidu.com/')

print(type(r))

print(r.status_code)

print(type(r.text))

print(r.text)

print(r.cookies)

运行结果如下

<class 'requests.models.Response'>

200

<class 'str'>

DOCTYPE html>

<html> <head><meta content=always name=referrer><link rel=stylesheet type=text/css href=https://ss1.bdstatic.com/5eN1bjq8AAUYm2zgoY3K/r/www/cache/bdorz/baidu.min.css><title>ç™¾åº¦ä¸€ä¸‹ï¼Œä½ å°±çŸ¥é“title>head> <body link=#0000cc> <div id=wrapper> <div id=head> <div class=head_wrapper> <div class=s_form> <div class=s_form_wrapper> <div id=lg> <img hidefocus=true src=//www.baidu.com/img/bd_logo1.png width=270 height=129> div> <form id=form name=f action=//www.baidu.com/s class=fm> <input type=hidden name=bdorz_come value=1> <input type=hidden name=ie value=utf-8> <input type=hidden name=f value=8> <input type=hidden name=rsv_bp value=1> <input type=hidden name=rsv_idx value=1> <input type=hidden name=tn value=baidu><span class="bg s_ipt_wr"><input id=kw name=wd class=s_ipt value maxlength=255 autocomplete=off autofocus=autofocus>span><span class="bg s_btn_wr"><input type=submit id=su value=百度一下 class="bg s_btn" autofocus>span> form> div> div> <div id=u1> <a href=http://news.baidu.com name=tj_trnews class=mnav>æ–°é—»a> <a href=https://www.hao123.com name=tj_trhao123 class=mnav>hao123a> <a href=http://map.baidu.com name=tj_trmap class=mnav>地图a> <a href=http://v.baidu.com name=tj_trvideo class=mnav>视频a> <a href=http://tieba.baidu.com name=tj_trtieba class=mnav>è´´å§a> <noscript> &tpl=mn&u=http%3A%2F%2Fwww.baidu.com%2f%3fbdorz_come%3d1 name=tj_login class=lb>登录a> noscript> <script>document.write('+ encodeURIComponent(window.location.href+ (window.location.search === "" ? "?" : "&")+ "bdorz_come=1")+ '" name="tj_login" class="lb">登录');

script> <a href=//www.baidu.com/more/ name=tj_briicon class=bri style="display: block;">更多产å“a> div> div> div> <div id=ftCon> <div id=ftConw> <p id=lh> <a href=http://home.baidu.com>å

³äºŽç™¾åº¦a> <a href=http://ir.baidu.com>About Baidua> p> <p id=cp>©2017 Baidu <a href=http://www.baidu.com/duty/>使用百度å‰å¿

读a> <a href=http://jianyi.baidu.com/ class=cp-feedback>æ„è§å馈a> 京ICPè¯030173å· <img src=//www.baidu.com/img/gs.gif> p> div> div> div> body> html>

<Cookie BDORZ=27315 for .baidu.com/> ]>

这里我们调用get()方法实现了与urlopen()相同的操作,得到一个Response对象,然后分别输出了Response的类型、状态码、响应体的类型、内容以及Cooikes。

通过运行结果发现,返回类型是request.models.Response,响应体的类型是字符串str,Cooikes的类型是RequestsCooikeJar。同样,也可以用post()、put()、delete()等方法实现POST、PUT、DELETE等请求。

3.GET请求

HTTP中最常见的请求之一就是GET请求,下面首先来详细了解一下利用requests构建GET请求的方法。

基本实例

import requests

r = requests.get("http://httpbin.org/get")

print(r.text)

运行结果:

{

"args": {},

"headers": {

"Accept": "*/*",

"Accept-Encoding": "gzip, deflate",

"Host": "httpbin.org",

"User-Agent": "python-requests/2.26.0",

"X-Amzn-Trace-Id": "Root=1-616a54e1-79669ac34d6b6deb3ba5ac19"

},

"origin": "223.104.204.36",

"url": "http://httpbin.org/get"

}

可以发现,我们成功发起了GET请求,返回结果中包含请求头、URL、IP等信息。

那我们应该如何添加参数呢?往下看:

import requests

data = {

'name':'germey',

'age':22

}

r = requests.get('http://httpbin.org/get',params=data)

print(r.text)

运行结果如下:

{

"args": {

"age": "22",

"name": "germey"

},

"headers": {

"Accept": "*/*",

"Accept-Encoding": "gzip, deflate",

"Host": "httpbin.org",

"User-Agent": "python-requests/2.26.0",

"X-Amzn-Trace-Id": "Root=1-616a5583-1b62ab26727aa421693be457"

},

"origin": "223.104.204.36",

"url": "http://httpbin.org/get?name=germey&age=22"

}

从结果可以看出,请求链接自动被构造成了:http://httpbin.org/get?name=germey&age=2

另外,网页的返回类型实际上是str类型,但是它很特殊,是JSON格式的。所以,如果想直接解析返回结果,得到一个字典格式的话,可以直接调用json()方法。例如:

import requests

r = requests.get("http://httpbin.org/get")

print(type(r.text))

print(r.json())

print(type(r.json()))

运行结果:

{'args': {}, 'headers': {'Accept': '*/*', 'Accept-Encoding': 'gzip, deflate', 'Host': 'httpbin.org', 'User-Agent': 'python-requests/2.26.0', 'X-Amzn-Trace-Id': 'Root=1-616a568c-54ba73d465d3189d471e1454'}, 'origin': '223.104.204.36', 'url': 'http://httpbin.org/get'}

可以发现,调用json()方法,就可以将返回结果是JSON格式的字符串转化为字典。但是需要注意的书,如果返回结果不是JSON格式,便会出现解析错误,抛出json.decoder.JSONDecodeError异常。

抓取网页

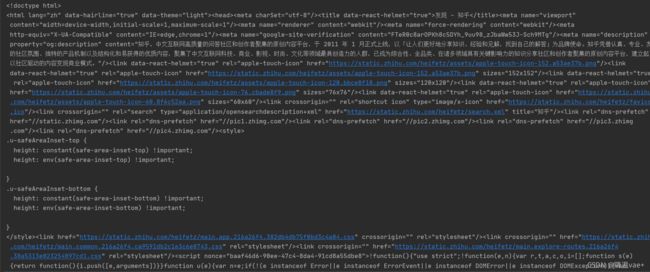

我们以知乎为例:

import requests

headers = {

'User-Agent':'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/94.0.4606.71 Safari/537.36'

}

r = requests.get("https://www.zhihu.com/explore",headers=headers)

print(r.text)

运行结果如下:

抓取二进制数据

上面的例子中,返回的是一个HTML文档。如果想抓取图片、音频、视频等文件,应该怎么办呢?

实际上这些文件都是由二进制码组成的,由于有特定的保存格式和对应的解析方式,我们才能看到,所以要抓取就要拿到它们的二进制码。

下面以Github的站点图标为例:

![]()

import requests

r = requests.get("http://github.com/favicon.ico")

print(r.text)

print(r.content)

运行结果如下,前面是text的结果,后面为content结果

可以看到,前者出现了乱码,后者前带有一个b,这就是bytes类型的数据。由于图片是二进制数据,所以前者在打印时转化为str类型,也就是图片直接转化为字符串,这理所当然会出现乱码。

我们将图片保存:

import requests

files = {

'file':open('favicon.ico','rb')}

r = requests.post("http://httpbin.org/post",files=files)

print(r.text)

这里使用了open()方法,它的第一个参数是文件名称,第二个参数代表以二进制写的形式打开,可以写入二进制数据。运行结束后,文件夹里多出了名为favicon.ico的图标,如图:

同样,音频和视频也可以使用这种方法获取。

添加headers

与urllib.request一样,我们也可以通过headers参数来传递头信息。

import requests

r = requests.get("https://www.zhihu.com/explore")

print(r.text)

运行结果如下:

<html>

<head><title>403 Forbiddentitle>head>

<body bgcolor="white">

<center><h1>403 Forbiddenh1>center>

<hr><center>openrestycenter>

body>

html>

但是加上headers并加上User-Agent信息就没问题了:

import requests

headers = {

'User-Agent':'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/94.0.4606.71 Safari/537.36'

}

r = requests.get("https://www.zhihu.com/explore",headers=headers)

print(r.text)

4.POST请求

另一种比较常见的请求方式是POST

实例:

import requests

data={

'name':'germey','age':'22'}

r = requests.post("http://htttpbin.org/post",data=data)

print(r.text)

运行结果

{

"args": {},

"data": "",

"files": {},

"form": {

"age": "22",

"name": "germey"

},

"headers": {

"Accept": "*/*",

"Accept-Encoding": "gzip, deflate",

"Content-Length": "18",

"Content-Type": "application/x-www-form-urlencoded",

"Host": "httpbin.org",

"User-Agent": "python-requests/2.26.0",

"X-Amzn-Trace-Id": "Root=1-616a60f0-6f707f19462de3d35a5bcece"

},

"json": null,

"origin": "223.104.204.36",

"url": "http://httpbin.org/post"

}

可以发现,我们成功获得了返回结果,其中form部分就是提交的数据,这就证明POST请求成功。

5.响应

import requests

r = requests.get('http://www.jianshu.com')

print(type(r.status_code),r.status_code)

print(type(r.headers),r.headers)

print(type(r.cookies),r.cookies)

print(type(r.url),r.url)

print(type(r.history),r.history)

运行结果

403

{'Server': 'Tengine', 'Date': 'Sat, 16 Oct 2021 05:24:04 GMT', 'Content-Type': 'text/html', 'Transfer-Encoding': 'chunked', 'Connection': 'keep-alive', 'Vary': 'Accept-Encoding', 'Strict-Transport-Security': 'max-age=31536000; includeSubDomains; preload', 'Content-Encoding': 'gzip'}

https://www.jianshu.com/

[]

这里分别打印输出status_code属性得到状态码,输出headers属性得到响应头,输出cookies属性得到Cooikes,输出url属性得到URL,输出history得到请求历史。

高级用法

1.文件上传

import requests

files = {

'file':open('favicon.ico','rb')}

r = requests.post("http://httpbin.org/post",files=files)

print(r.text)

我们用上一节保存的文件模拟上传过程。

运行结果如下:

{

"args": {},

"data": "",

"files": {

"file": "data:application/octet-stream;base64,AAABAAIAE.........="

},

"form": {},

"headers": {

"Accept": "*/*",

"Accept-Encoding": "gzip, deflate",

"Content-Length": "6665",

"Content-Type": "multipart/form-data; boundary=41d86d50393a0a142d8e0165ff1e2548",

"Host": "httpbin.org",

"User-Agent": "python-requests/2.26.0",

"X-Amzn-Trace-Id": "Root=1-616a64c6-50dd23497def21c426a0fec8"

},

"json": null,

"origin": "111.18.247.221",

"url": "http://httpbin.org/post"

}

2.Cooikes

import requests

r = requests.get("https://www.baidu.com")

print(r.cookies)

for key,value in r.cookies.items():

print(key+'='+value)

运行结果:

3.会话维持

我们怎么在代码中维持同一个会话呢?这时候就有了新的理器——Session对象

先来看这个例子:

import requests

requests.get('http://httpbin.org/cookies/set/number/123456789')

r = requests.get('http://httpbin.org/cookies')

print(r.text)

输出

{

"cookies": {}

}

好像没法获取到Cooikes,我们再试试Session:

import requests

s = requests.Session()

s.get('http://httpbin.org/cookies/set/number/123456789')

r = s.get('http://httpbin.org/cookies')

print(r.text)

输出

{

"cookies": {

"number": "123456789"

}

}

4.SSL证书验证

此外,requests还提供了证书验证的功能。当发送HTTP请求时,它会检查SSL证书,我们可以使用verify参数控制是否检查此证书。其实不加的话,默认是True,会自动验证。

同样也可以使用urllib3.disable_warnings()忽略警告。

5.代理设置

import requests

proxies = {

"http":"http://110.93.161.226:3128",

"https":"http://10.93.161.226:1080"

}

requests.get("https://www.taobao.com",proxies=proxies)

6.超时设置

import requests

r = requests.get("https://www.taobao,com",timeout=1)

print(r.status_code)

也可以这样写,分为连接和读取两个阶段

r = requests.get("https://www.taobao.com",timeout=(5,11,30))

永久等待可以这样写

r = requests.get("https://www.taobao.com",timeout=None)

或者直接不加参数

r = requests.get("https://www.taobao.com")

7.身份认证

import requests

from requests.auth import HTTPBasicAuth

r = requests.get('http://localhost:5000',auth=HTTPBasicAuth('username','password'))

print(r.status_code)

8.Prepared Request

之前说urllib可以将请求表示为数据结构,其中各个参数都可以通过Request对象表示。requests同样可以做到,这个数据结构就叫Prepared Request。例如:

from requests import Request,Session

url = 'http://httpbin.org/post'

data = {

'name':'germey'

}

headers = {

'User-Agent':'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/94.0.4606.71 Safari/537.36'

}

s = Session()

req = Request('POST',url,data=data,headers=headers)

prepped = s.prepare_request(req)

r = s.send(prepped)

print(r.text)

运行结果:

{

"args": {},

"data": "",

"files": {},

"form": {

"name": "germey"

},

"headers": {

"Accept": "*/*",

"Accept-Encoding": "gzip, deflate",

"Content-Length": "11",

"Content-Type": "application/x-www-form-urlencoded",

"Host": "httpbin.org",

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/94.0.4606.71 Safari/537.36",

"X-Amzn-Trace-Id": "Root=1-616a6c12-2273ef8613f764892e0e6050"

},

"json": null,

"origin": "111.18.247.221",

"url": "http://httpbin.org/post"

}

可以看到,同样达到了POST请求的效果。