CVPR 2021 | 对抗攻防新方向:动作识别算法容易被攻击!

智源导读:对抗样本是近年来非常热门的研究问题,但是大多数的研究往往针对于静态数据(图像、文本、几何),然而时序数据上的探索往往较少,本文主要是研究了一种特殊但十分重要的时序数据——骨架动作下的黑盒攻击。欢迎对对抗样本或者骨架运动识别感兴趣的读者对这个方向进一步探索。(本文系智源社区成员投稿)

原文链接:https://arxiv.org/abs/2103.05266

视频链接及附加材料:http://drhewang.com/pages/AAHAR.html

作者:Yunfeng Diao, Tianjia Shao, Yong-Liang Yang, Kun Zhou, He Wang

单位:利兹大学,西南交通大学,浙江大学,巴斯大学

01

引言

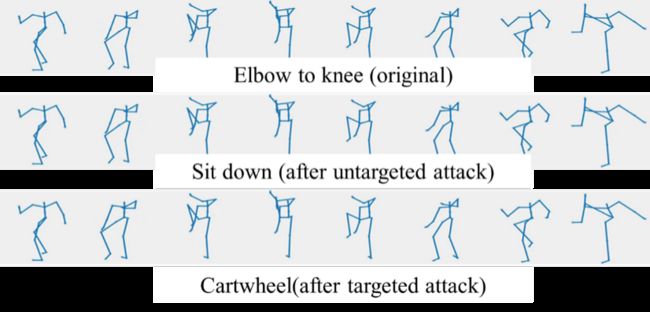

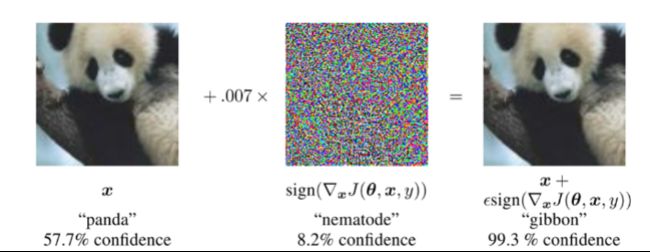

对抗样本通常是指对输入样本添加一些人为无法察觉到的扰动,导致模型以高置信度给出一个错误的输出,例如图例中原样本的标签为“熊猫”,经过添加扰动后,分类器分类为错误的标签“长臂猿”。目前对抗样本在静态数据上(图像、文本、几何)已经做了大量的研究,但是对于时序数据相关的研究较少。

骨架运动数据,作为一种特殊的时序数据,在人类行为活动识别中起着至关重要的作用,因此骨架行为识别的安全性问题最近开始也渐渐受到了大家的关注。但是当前的针对骨架行为识别的安全性研究主要有两个方面的问题还没有被解决:

1) 目前基于骨架行为识别的攻击方法和鲁棒性研究主要是在“白盒”设定下的,即模型参数可以完全被外界获取。然而,在现实场景中,模型参数往往难以获得,因此白盒设定下的骨架运动攻击无法被视为是现实中对模型真实存在的威胁。在本文中,我们证明了这种威胁在现实中是真实存在的。为此,我们提出了第一个骨架黑盒攻击方法BASAR。

2) 通常的观点认为对抗样本是被人为精心制造出来的,尽管这种扰动在现实中不存在,只要人工生成的扰动足够小,加入到图片等静态数据中往往难以被人察觉,但是这种生成对抗扰动的方式直接应用到骨架数据上时会面临一些问题。首先,骨架数据具有低维度性(Low-dimensionality)和Dynamics Sensitivity,骨骼运动具有人类感知系统可以充分识别的运动学特点,并且每帧的关节数是一定的,这就使得相比于图片,可以攻击的维度较少而易被察觉,并且就算是人为添加较小的扰动,也有可能破坏了运动学特性而被人轻易的观察出来。(例如添加在脊柱上的扰动,尽管很小但也可能违背了人体动力学而造成不自然的抖动)

为解决上述两个问题,我们提出了第一个骨架黑盒攻击方法BASAR。更重要的是,不同于一般对于对抗样本是人为制造出来,与原始样本不在同一个数据分布上的观点,我们利用BASAR证明了骨架上的对抗样本完全可以是现实中真实存在的,也就是说可以与原始样本在一个分布上。我们将这种对抗样本称为流形对抗样本(on-manifold adversarial samples)。

通过详尽的评估和比较,我们表明BASAR可以在不同的模型、数据集和攻击方式下完成攻击。另外,由于骨架运动独特的约束限制(骨长、关节旋转角度)和动力学特性,单单依靠传统的距离度量方法(比如欧式距离)无法在骨架运动问题上作为一个可靠的感知度量方法。因此,我们采用感知研究来评估BASAR生成样本的不可察觉性,结果表明BASAR可以实现有效而不易察觉的攻击。通过分析对不同行为识别算法的攻击,BASAR可以帮助确定其脆弱性的潜在原因,并提供了什么样的行为识别分类器可以更强大地抵御对抗攻击的见解。

我们希望通过我们的研究引起人们对行为识别模型的安全隐患的关注,因为通过本文已经证明了行为识别的对抗样本在现实中是真实存在的。

02

论文贡献

该论文的贡献可以总结为如下三条:

提出了第一个骨架黑盒攻击方法,并全面评估了几种最新骨架识别模型的脆弱性。

显示了流形对抗样本在不同数据集上的广泛存在,并对什么类型的分类器可以抵御流形对抗样本提出了自己的见解。

显示了流形对抗性样本是真正危险的,因为即使在严格的感知测试下,它们也不容易被发现。

03

方法

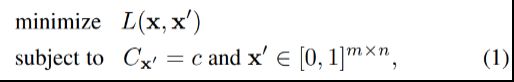

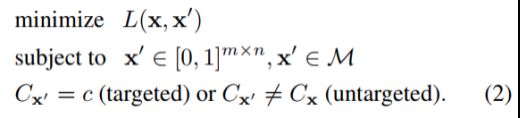

一般的对抗样本可以被定义为公式(1):

其中,![]() 和

和![]() 分别为原样本和对抗样本,

分别为原样本和对抗样本,![]() 为距离度量函数,

为距离度量函数, 为分类器的分类标签,

为分类器的分类标签,![]() 为正确的分类结果。然而,简单的在骨架运动中应用公式(1)是行不通的。考虑到人类的pose都位于一个自然的流形

为正确的分类结果。然而,简单的在骨架运动中应用公式(1)是行不通的。考虑到人类的pose都位于一个自然的流形![]() 上,我们因此对公式(1)添加了另一个约束

上,我们因此对公式(1)添加了另一个约束![]()

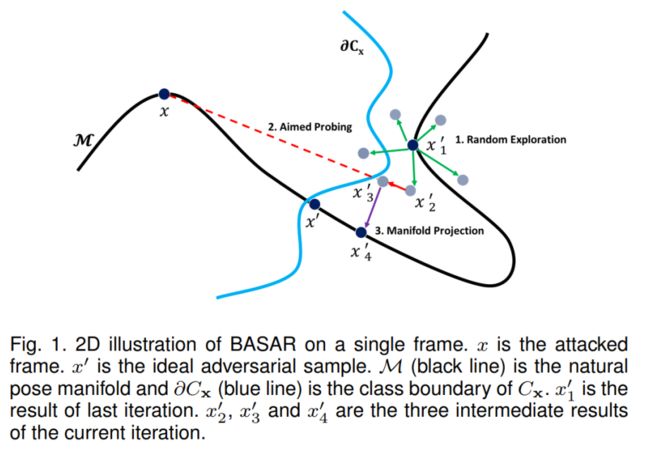

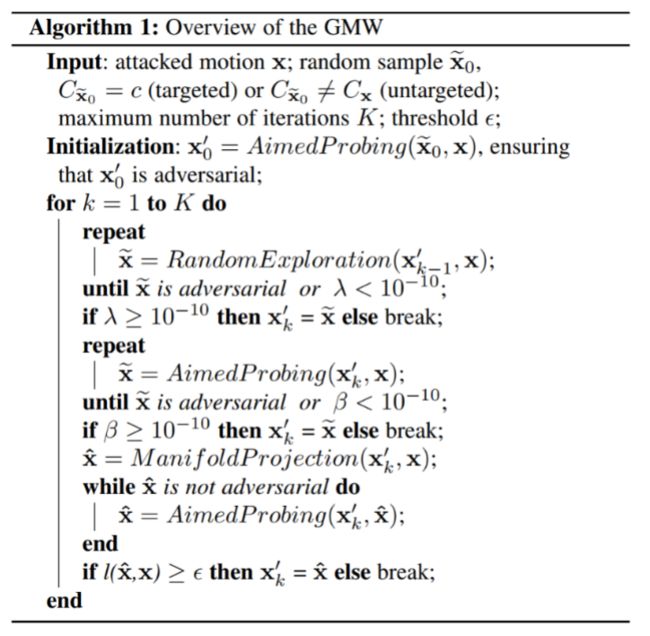

由于公式(2)是高度非线性的,难以用解析形式求解,我们因此提出了一种称为Guided Manifold Walk(GMW)的数值解方法。其主要思路是在每次迭代中,执行Random Exploration, Aimed Probing 和 Manifold Projection三个子程序。执行Random Exploration的目的是在接近分类边界的地方进行探索;执行Aimed Probing的目的是找到一个更接近原始样本的新的对抗样本。在执行完Random Exploration和Aimed Probing后的对抗样本通常远离真实的流形空间,使得pose看起来不真实和不自然。我们因此需要执行Manifold Projection将非流形空间上的对抗样本重新投影到流形空间上。更多的算法细节可以参考原文。

04

实验结果

4.1数值评估

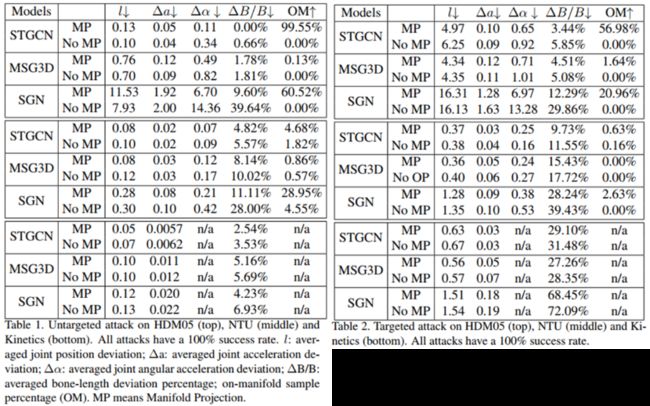

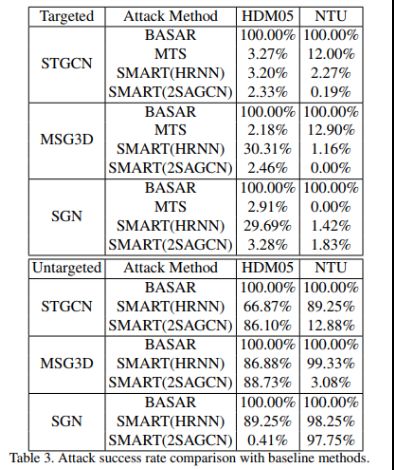

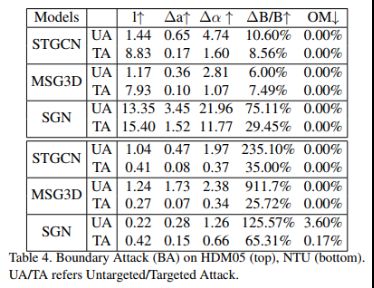

我们选择了三个state-of-the-art模型STGCN, MSG3D和 SGN;选择的数据集为HDM05, NTU 60和Kinetics。除了攻击成功率,我们还报告了对抗样本和原样本之间的距离误差 ,加速度误差

,加速度误差![]() ,角加速度误差

,角加速度误差![]() ,骨长误差

,骨长误差 和生成流形对抗样本的概率(OM)作为数值评估指标。如下表所示,BASAR在非目标攻击/目标攻击下生成流行对抗样本的概率可以高达99.55%/56.98%。同时通过消融实验可以发现,执行了Manifold Projection生成的对抗样本几乎各项数值评价指标都要高于未执行Manifold Projection生成的对抗样本。

和生成流形对抗样本的概率(OM)作为数值评估指标。如下表所示,BASAR在非目标攻击/目标攻击下生成流行对抗样本的概率可以高达99.55%/56.98%。同时通过消融实验可以发现,执行了Manifold Projection生成的对抗样本几乎各项数值评价指标都要高于未执行Manifold Projection生成的对抗样本。

由于BASAR是第一个黑盒骨架攻击方法,没有其他的基线方法可以用来比较,因此我们采用了与我们最相似的几种方法与我们的进行比较,分别是骨架迁移攻击SMART,时序数据黑盒攻击方法MTS和图像黑盒攻击方法Boundary Attack。从结果中可以看出,BASAR的表现远远高于这三种方法。

4.2感知评估

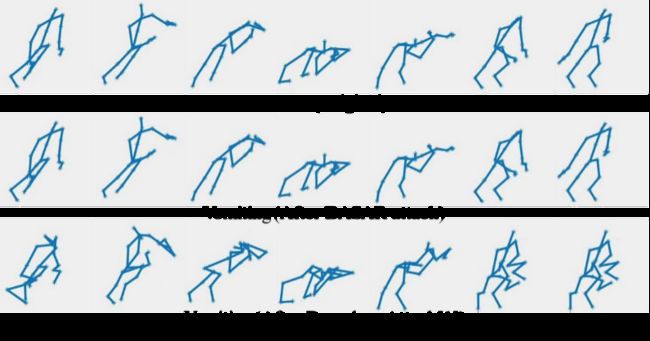

单独的数值评估并不足以评估骨架对抗样本的不可感知性,因为距离度量函数在高维空间下不符合人类的感性性,因此它们不能准确地表明攻击是否能被人类察觉。为此我们采用user-study的方式进行了三种感知研究:可欺骗性,自然性和不可分辨性。

可欺骗性(Deceitfulness)感知研究是用来测试BASAR是否在视觉上改变了动作的语义,结果显示79.64%的参加实验者认为BASAR在视觉上没有改变动作的语义。

自然性(Naturalness)感知研究是用来测试流形对抗样本和非流形对抗样本哪一种看起来更自然,结果显示85%的参加实验者认为执行了Manifold Projection的动作看起来更自然。

不可分辨性(Indistinguishability)是最严格的感知测试,用来测试用户是否可以察觉到对抗样本的任何改动,结果显示89.9%的对抗样本与原始样本无法区分。其中94.63%的流形对抗样本与原视样本无法被区分,84.69%的非流形对抗样本与原样本无法被区分。

4.3 模型鲁棒性的分析

从BASAR的攻击结果来看,一般考虑了运动的语义信息,骨长信息的模型防御表现更好,具体的分析结果请看原文。

本文系智源社区成员投稿,投稿细则参见公众号「投稿」一栏