- onnxruntime-1.22.0交叉编译arm64目标平台

1背景在上一实践《sherpa-onnxAI语音框架添加acl加速库实践》中,笔者基于最新github源码版本编译出的onnxruntime动态库(包括acl库)测试效果不理想,后续尝试下载onnxruntime的最新基线版本V.1.22.0源码重新验证。由于基于RK3588目标平台的本地native模式编译过程效率低,耗时久,而且编译过程中频繁导致系统假挂死(表现为编译过程停滞,串口无法活动;强

- CMake详解

竹子的人生

androidcmakeandroid

什么是CMake在androidstudio2.2及以上,构建原生库的默认工具是CMake。CMake是一个跨平台的构建工具,可以用简单的语句来描述所有平台的安装(编译过程)。能够输出各种各样的makefile或者project文件。Cmake并不直接建构出最终的软件,而是产生其他工具的脚本(如Makefile),然后再依这个工具的构建方式使用。CMake是一个比make更高级的编译配置工具,它可

- 深入浅出之CMake工具及CMakefile文件

浩瀚之水_csdn

#Pytorch框架深度学习目标检测YOLO目标检测深度学习

一、CMake工具CMake是一个跨平台的安装(编译)工具,它可以用简单的语句来描述所有平台的安装(编译)过程。以下是对CMake的详细解析:1.1、CMake的基本概念定义:CMake是一个跨平台的自动化建构系统,它使用一种名为CMakeLists.txt的配置文件来控制软件编译过程。功能:CMake可以编译源代码、制作程序库、产生适配器(wrapper),还可以用任意的顺序建构执行档。它支持i

- 编译原理简答题

编译过程一般可以分为哪些阶段?各自的作用是什么?涉及到四元式,三地址码的阶段有哪些?一般可以划分为五个工作阶段:(1)词法分析,对构成源程序的字符串进行扫描和分解,识别出一个个的单词(2)语法分析,根据语言的语法规则,把单词符号串分解成各类语法单位(3)语义分析与中间代码生成,即对各类语法单位,分析其含义并进行初步翻译(4)代码优化,以期产生更高效的代码(5)目标代码生成,把中间代码变换成特定机器

- svelte笔记

艾小逗

web笔记

svelte特性编译过程使用场景创建项目问题1:build报错基本语法响应式变量if语句for循环await加载数据Event组件通信父子组件跨组件通信storeslot插槽生命周期tickonMountonDestroySvelteKit与Svelte的区别项目结构路由+page+page.svelte+page.js/ts+error+layout+layout.sveltelayout.se

- uni-app 认识条件编译,了解多端部署

前端梦工厂+

uni-app前端开发vue.js前端uni-app

一.前言在使用uni-app进行跨平台开发的过程中,经常会遇到需要针对不同平台或不同环境进行条件编译的情况。条件编译是一种在编译过程中根据指定条件选择不同代码路径的技术,可以帮助我们在不同平台或环境下编写不同的代码,以适应不同的平台实现逻辑。在uni-app中,可以说条件编译是uni-app实现多端部署的核心思想,通过条件编译,我们可以根据当前的平台、环境或配置选项来控制代码的执行逻辑,从而实现定

- Ubuntu编译unixODBC源码报错libtool:error

藍色月光

ubuntulinux运维

#Ubuntu编译unixODBC源码报错libtool:error:cannotfindthelibrary''orunhandledargument'/home/cps/source'一般都是这样的错,可能的原因是因为源码路径中含有空格导致编译过程读取时错误,这里源码路径为/home/cps/sourcecode/unixodbc建议路径中不要含有任何汉字、空格、特殊字符、

- Spark底层原理详细解析

JavaShark

sparkbigdatahadoop

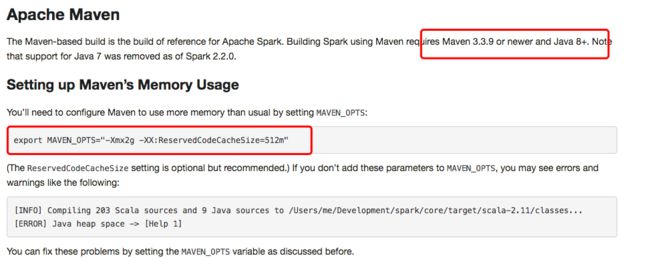

Spark简介ApacheSpark是用于大规模数据处理的统一分析引擎,基于内存计算,提高了在大数据环境下数据处理的实时性,同时保证了高容错性和高可伸缩性,允许用户将Spark部署在大量硬件之上,形成集群。Spark源码从1.x的40w行发展到现在的超过100w行,有1400多位大牛贡献了代码。整个Spark框架源码是一个巨大的工程。下面我们一起来看下spark的底层执行原理。Spark运行流程具

- Cmake入门及CMakeLists.txt 语法介绍

stonewu

C++开发cmakec++

一、Cmake简介cmake是一个跨平台、开源的构建系统。它是一个集软件构建、测试、打包于一身的软件。它使用与平台和编译器独立的配置文件来对软件编译过程进行控制。本文供C++软件开发者入门学习参考,主要内容来自网络。下载地址:DownloadCMakewindows下,可以下载Windowsx64ZIP当前最新版4.0.3。配置CMake确保CMake的安装路径被添加到系统的PATH环境变量中,这

- ZLMediaKit2023-10-15master分支编译版下载:实时音视频传输解决方案

昌焘同

ZLMediaKit2023-10-15master分支编译版下载:实时音视频传输解决方案去发现同类优质开源项目:https://gitcode.com/项目介绍ZLMediaKit是一款开源的实时音视频传输框架,专为流媒体传输而设计。2023年10月15日基于master分支编译完成的版本,为广大开发者提供了Windows平台下的便捷使用体验。该版本集成最新的功能特性,无需复杂编译过程,下载即可

- mosquitto-2.0.14 交叉编译

mxpan

linuxIOTarm开发linuxiot

在物联网开发中,MQTT协议作为轻量级消息传输协议被广泛应用,而mosquitto作为开源的MQTT代理服务器,是实现物联网通信的重要组件。本文将详细介绍如何编译ARM32和ARM64架构下mosquitto-2.0.14版本,包括环境准备、编译过程及相关依赖说明。一、环境准备在开始编译前,需要确保已安装以下工具和依赖:交叉编译工具链ARM32:arm-linux-gnueabihf-gcc/g+

- x210:uboot和系统移植扩展--uboot启动第一阶段

毛裤先生_2

嵌入式linuxuboot

从u-boot.lds中ENTRY所指定处可以看出,整个uboot程序的起始就是_start处。不简单的头文件包含(1)#include。config.h是在include目录下的,这个文件不是源码中本身存在的文件,而是配置过程中自动生成的文件(参考uboot配置和编译过程详解章节,该文件中的内容为#include)。可见start.S中包含的第一个头文件就是:include/configs/x2

- vue3 模板编译过程

椒盐大肥猫

vue3vue.js前端javascript

Vue3的模板编译过程将您在Vue单文件组件(.vue文件)或模板字符串中写的声明式模板转换成JavaScript渲染函数。这个过程发生在构建时(当使用VueCLI或其他打包工具时)或者在运行时(当使用全量构建时)。以下是该过程的精简概述:将模板解析成AST(抽象语法树):编译器首先使用解析器将模板字符串解析成AST。AST是一种树状结构,它详细描述了模板中的标签、属性、表达式等。在此过程中,编译

- 前端框架实战经验深度解析:美团#房源选房项目>>>Vue.js开发与跨端部署的那些事

small_wh1te_coder

前端性能优化vue前端javascriptvscodees6

跟着codewh全套教程看源码、怼项目也有两个月了,吸取前人经验、敲了几个项目之后也小有收获:1.遇事不决:源码开怼!从js高级到jquery到各中框架,碰到底层知识、实现中的小bug不懂、调试难题.....诸多此类类似于ast生成/编译过程/lexicalEnvironment分析等底层原理性难点,直接找技术手册或找到源码分析!程序员只有刨根问底才能获得最大程度的上的进化!2.觉得记不住?多敲多

- 解决 Rust 编译错误:link.exe 未找到

好奇的菜鸟

Rustrust开发语言后端

在使用Rust进行开发时,你可能会遇到一个令人困惑的错误:error:linker'link.exe'notfound。这个错误表明Rust编译器在尝试链接你的程序时,无法找到链接器link.exe。这通常是由于系统中缺少必要的编译工具或配置不正确导致的。本文将为你提供详细的解决方案,帮助你快速解决这个问题。一、问题背景Rust是一种系统编程语言,它在编译过程中需要链接器来将编译后的代码生成可执行

- Kotlin Multiplatform Mobile 的三模块问题,网易严选Android开发三面面经

Goog高工

程序员面试

值得一提的是,“作者”和“书”模块依赖于“身份验证”模块来服务经过身份验证的用户实体,以便后端可以返回个性化响应——作家和书籍。实际问题这种方法在Android应用程序中效果很好,但是一旦将其应用于导入了KMP驱动的框架的iOS应用程序中,就会产生繁琐的问题。实际的问题是,在iOS模块的编译过程中,Kotlin/Native插件包含了当前已编译的模块中全部的依赖关系,因此它是内置的。此外,为防止冲

- 编译器基础概念

喜欢打篮球的普通人

传统编译器c++

文章目录编译器与解释器解释器vs编译器对比编译方式Just-In-Time(JIT)编译Ahead-Of-Time(AOT)编译JIT(即时编译)与AOT(提前编译)对比什么时候用到JIT什么时候用到AOT?Pass和IRPass传统编译器编译器的发展历史(HistoryofCompiler)GCC编译过程与原理(GCCProcessandPrinciple)LLVM/Clang编译过程与原理(L

- OpenCV 4.2.0 && Qt5.14.1 编译好的库:加速计算机视觉开发

沈娜霞Morton

OpenCV4.2.0&&Qt5.14.1编译好的库:加速计算机视觉开发【下载地址】OpenCV4.2.0Qt5.14.1编译好的库这是一个专为Windows平台开发者设计的资源库,提供了OpenCV4.2.0和Qt5.14.1的预编译版本,基于MinGW编译器。通过集成pri子工程,开发者可以快速将这些库引入Qt项目,无需经历复杂的编译过程。该库特别适合需要在Release模式下工作的项目,并且

- Linux内核编译框架

生活需要深度

项目编译框架linux运维服务器

2.15.3.内核配置和编译体验本节进行内核的三步配置编译过程,目的是让大家学会内核的配置编译操作,方便之后学习原理。2.15.3.1、先确认Makefile(1)主要是检查交叉编译工具链有没有设置对。CROSS_COMPILE?=/usr/local/arm/arm-2009q3/bin/arm-none-linux-gnueabi-(2)确认ARCH=arm。主要目的是为了编译时能找到arch

- android关于pthread的使用过程

开发之奋斗人生

c++记录androidpthread

文章目录简介代码流程pthread使用hello_test.cppAndroid.bp编译过程报错处理验证过程简介android开发经常需要使用pthread来编写代码实现相关的业务需求代码流程pthread使用需要查询某个linux函数的方法使用,可以使用man+函数名//$manpthread_create#includeintpthread_create(pthread_t*thread,c

- android关于pthread的使用过程

开发之奋斗人生

c++记录androidpthread

文章目录简介代码流程pthread使用hello_test.cppAndroid.bp编译过程报错处理验证过程简介android开发经常需要使用pthread来编写代码实现相关的业务需求代码流程pthread使用需要查询某个linux函数的方法使用,可以使用man+函数名//$manpthread_create#includeintpthread_create(pthread_t*thread,c

- PL/0语言

一、设计任务1.1程序实现要求PL/0语言可以看成PASCAL语言的子集,它的编译程序是一个编译解释执行系统。PL/0的目标程序为假想栈式计算机的汇编语言,与具体计算机无关。PL/0的编译程序和目标程序的解释执行程序都是用JAVA语言书写的,因此PL/0语言可在配备JDK的任何机器上实现。其编译过程采用一趟扫描方式,以语法分析程序为核心,词法分析和代码生成程序都作为一个独立的过程,当语法分析需要读

- 深入理解编译器设计:PL0编译程序源代码分析与实现

Salton Z

本文还有配套的精品资源,点击获取简介:PL0是一种教学用的简单编程语言,由BrianW.Kernighan和P.J.Plauger设计,旨在教授编译器设计基础。该编译程序源代码提供了实现PL0语言编译器的详细代码,涵盖了编译过程的各个阶段,包括词法分析、语法分析、语义分析和代码生成。它对于学习和实践编译原理及编译器开发具有极大的价值。通过分析和理解PL0编译程序源代码,学生可以掌握构建编译器的关键

- 编译OpenSSL(ubuntu+openssl1.1.1)

꧁白杨树下꧂

linuxopenssl

前言笔者已经编译过多次openssl库了,之前一起没记录编译过程,本次简单记录下编译过程当前(今天是2025.03.28)openssl1.1.1库已经有点过时了,但很多旧库仍然使用,为了测试通用性,笔者测试的了ubuntu18.04、ubuntu20.04、ubuntu24.04,也遇到了一些问题,在此记录下,供有需要的小伙伴参考一、搭建开发环境在ubuntu下在线搭建比较简单,参考命令如下su

- FFmpeg跨平台编译指南:为armv7/armv7s/arm64/i386架构优化

Fkvision

本文还有配套的精品资源,点击获取简介:FFmpeg是用于处理多媒体数据的开源框架,涵盖转换、编码、解码等多种功能。针对iOS设备上不同处理器架构(armv7,armv7s,arm64,i386)的特殊需求,本文详细介绍了如何进行FFmpeg的交叉编译。从FFmpeg的基本介绍到不同架构的特点,再到64位编译和交叉编译的详细步骤,本文为iOS开发者提供了一个全面的编译流程。编译过程中还涵盖了如何配置

- (含linux gcc编译过程)分析和解决`GLIBCXX_3.4.x‘ not found问题及其他问题汇总,亲测有效

江木27

PaddleOCR系统计算机视觉图像处理pythonpipcondac++

问题描述:`GLIBCXX_3.4.x’notfound这里说下网上有的部分解决方法,一个是搜索本地中有缺失的GLIBCXX_3.4.x的libstdc++.so.6.0.xx文件,一个是condainstall-cconda-forgegcc=12.1.0首先第二种方法本人使用并没有解决,第一种肯定可以解决,但是会破坏系统环境建议不使用,本文提供的方法都在确保不破坏系统环境的前提下解决该问题本文

- Ubuntu创建修改 Swap 文件分区的步骤——解决嵌入式开发板编译ROS2程序卡死问题

地衣君

SLAMubuntulinux

Ubuntu创建修改Swap文件分区的步骤——解决嵌入式开发板编译ROS2程序卡死问题1.问题描述2.创建/修改Swap分区2.1创建Swap文件(推荐)2.2使用Swap分区(如果已经存在)3.注意事项同步发布在个人笔记Ubuntu创建修改Swap文件分区的步骤——解决嵌入式开发板编译ROS2程序卡死问题1.问题描述在RISC-V的嵌入式开发板上部署open_vins方案的时候,编译过程会导致板

- 【2025年软考中级】第二章2.3 编译程序基本原理

houliabc

笔记学习软考证书计算机系统

文章目录编译程序基本原理词法分析语法分析语义分析中间代码生成与优化目标代码生成编译程序基本原理编译程序是将高级语言源程序翻译成目标程序的软件工具。在编译过程中,需要不断收集、记录和使用源程序中相关符号的类型和特征等信息,并将这些信息存入符号表。整个编译过程主要分为以下几个阶段:词法分析词法分析是编译过程的第一个阶段,其主要任务是从左到右逐个字符地扫描源程序,根据预定义的构词规则识别出有意义的单词(

- ollvm混淆有哪些,怎么实现的,分析的方法有哪些,分别怎么做?

烬柒小云

安卓逆向面试题android安卓逆向面试

深入解析OLLVM混淆:原理、实现与破解思路在面对逆向分析时,OLLVM(Obfuscator-LLVM)是一种非常常见的代码混淆工具。它的强大之处在于基于LLVMIR(中间表示)进行混淆,这意味着无论是C还是C++代码,都能在编译过程中被深度改造,变得更加难以理解。今天,我想聊聊OLLVM的主要混淆手段,它们是如何实现的,以及在实际分析中如何应对它们。控制流平坦化(ControlFlowFlat

- _cxa_throw xocde运行卡住

磊怀

ITiOS_cxa_throwlibc++abi.dylib运行卡住

通常情况下,APP使用xcode运行可以畅通无阻的运行完,但是经常遇到一种情况是运行卡在了_cxa_throw位置需要不打断点才能运行下去,如下图看样子是项目中引用了libc++abi.dylib这个系统的库,导致编译过程中C++文件编译报错导致被卡主了。表现出来就是程序运行在不知道的地方有个断点。可能在项目中你有全局断点,找到全局断点,右键选择编辑断点在exception选项中选择Object-

- 312个免费高速HTTP代理IP(能隐藏自己真实IP地址)

yangshangchuan

高速免费superwordHTTP代理

124.88.67.20:843

190.36.223.93:8080

117.147.221.38:8123

122.228.92.103:3128

183.247.211.159:8123

124.88.67.35:81

112.18.51.167:8123

218.28.96.39:3128

49.94.160.198:3128

183.20

- pull解析和json编码

百合不是茶

androidpull解析json

n.json文件:

[{name:java,lan:c++,age:17},{name:android,lan:java,age:8}]

pull.xml文件

<?xml version="1.0" encoding="utf-8"?>

<stu>

<name>java

- [能源与矿产]石油与地球生态系统

comsci

能源

按照苏联的科学界的说法,石油并非是远古的生物残骸的演变产物,而是一种可以由某些特殊地质结构和物理条件生产出来的东西,也就是说,石油是可以自增长的....

那么我们做一个猜想: 石油好像是地球的体液,我们地球具有自动产生石油的某种机制,只要我们不过量开采石油,并保护好

- 类与对象浅谈

沐刃青蛟

java基础

类,字面理解,便是同一种事物的总称,比如人类,是对世界上所有人的一个总称。而对象,便是类的具体化,实例化,是一个具体事物,比如张飞这个人,就是人类的一个对象。但要注意的是:张飞这个人是对象,而不是张飞,张飞只是他这个人的名字,是他的属性而已。而一个类中包含了属性和方法这两兄弟,他们分别用来描述对象的行为和性质(感觉应该是

- 新站开始被收录后,我们应该做什么?

IT独行者

PHPseo

新站开始被收录后,我们应该做什么?

百度终于开始收录自己的网站了,作为站长,你是不是觉得那一刻很有成就感呢,同时,你是不是又很茫然,不知道下一步该做什么了?至少我当初就是这样,在这里和大家一份分享一下新站收录后,我们要做哪些工作。

至于如何让百度快速收录自己的网站,可以参考我之前的帖子《新站让百

- oracle 连接碰到的问题

文强chu

oracle

Unable to find a java Virtual Machine--安装64位版Oracle11gR2后无法启动SQLDeveloper的解决方案

作者:草根IT网 来源:未知 人气:813标签:

导读:安装64位版Oracle11gR2后发现启动SQLDeveloper时弹出配置java.exe的路径,找到Oracle自带java.exe后产生的路径“C:\app\用户名\prod

- Swing中按ctrl键同时移动鼠标拖动组件(类中多借口共享同一数据)

小桔子

java继承swing接口监听

都知道java中类只能单继承,但可以实现多个接口,但我发现实现多个接口之后,多个接口却不能共享同一个数据,应用开发中想实现:当用户按着ctrl键时,可以用鼠标点击拖动组件,比如说文本框。

编写一个监听实现KeyListener,NouseListener,MouseMotionListener三个接口,重写方法。定义一个全局变量boolea

- linux常用的命令

aichenglong

linux常用命令

1 startx切换到图形化界面

2 man命令:查看帮助信息

man 需要查看的命令,man命令提供了大量的帮助信息,一般可以分成4个部分

name:对命令的简单说明

synopsis:命令的使用格式说明

description:命令的详细说明信息

options:命令的各项说明

3 date:显示时间

语法:date [OPTION]... [+FORMAT]

- eclipse内存优化

AILIKES

javaeclipsejvmjdk

一 基本说明 在JVM中,总体上分2块内存区,默认空余堆内存小于 40%时,JVM就会增大堆直到-Xmx的最大限制;空余堆内存大于70%时,JVM会减少堆直到-Xms的最小限制。 1)堆内存(Heap memory):堆是运行时数据区域,所有类实例和数组的内存均从此处分配,是Java代码可及的内存,是留给开发人

- 关键字的使用探讨

百合不是茶

关键字

//关键字的使用探讨/*访问关键词private 只能在本类中访问public 只能在本工程中访问protected 只能在包中和子类中访问默认的 只能在包中访问*//*final 类 方法 变量 final 类 不能被继承 final 方法 不能被子类覆盖,但可以继承 final 变量 只能有一次赋值,赋值后不能改变 final 不能用来修饰构造方法*///this()

- JS中定义对象的几种方式

bijian1013

js

1. 基于已有对象扩充其对象和方法(只适合于临时的生成一个对象):

<html>

<head>

<title>基于已有对象扩充其对象和方法(只适合于临时的生成一个对象)</title>

</head>

<script>

var obj = new Object();

- 表驱动法实例

bijian1013

java表驱动法TDD

获得月的天数是典型的直接访问驱动表方式的实例,下面我们来展示一下:

MonthDaysTest.java

package com.study.test;

import org.junit.Assert;

import org.junit.Test;

import com.study.MonthDays;

public class MonthDaysTest {

@T

- LInux启停重启常用服务器的脚本

bit1129

linux

启动,停止和重启常用服务器的Bash脚本,对于每个服务器,需要根据实际的安装路径做相应的修改

#! /bin/bash

Servers=(Apache2, Nginx, Resin, Tomcat, Couchbase, SVN, ActiveMQ, Mongo);

Ops=(Start, Stop, Restart);

currentDir=$(pwd);

echo

- 【HBase六】REST操作HBase

bit1129

hbase

HBase提供了REST风格的服务方便查看HBase集群的信息,以及执行增删改查操作

1. 启动和停止HBase REST 服务 1.1 启动REST服务

前台启动(默认端口号8080)

[hadoop@hadoop bin]$ ./hbase rest start

后台启动

hbase-daemon.sh start rest

启动时指定

- 大话zabbix 3.0设计假设

ronin47

What’s new in Zabbix 2.0?

去年开始使用Zabbix的时候,是1.8.X的版本,今年Zabbix已经跨入了2.0的时代。看了2.0的release notes,和performance相关的有下面几个:

:: Performance improvements::Trigger related da

- http错误码大全

byalias

http协议javaweb

响应码由三位十进制数字组成,它们出现在由HTTP服务器发送的响应的第一行。

响应码分五种类型,由它们的第一位数字表示:

1)1xx:信息,请求收到,继续处理

2)2xx:成功,行为被成功地接受、理解和采纳

3)3xx:重定向,为了完成请求,必须进一步执行的动作

4)4xx:客户端错误,请求包含语法错误或者请求无法实现

5)5xx:服务器错误,服务器不能实现一种明显无效的请求

- J2EE设计模式-Intercepting Filter

bylijinnan

java设计模式数据结构

Intercepting Filter类似于职责链模式

有两种实现

其中一种是Filter之间没有联系,全部Filter都存放在FilterChain中,由FilterChain来有序或无序地把把所有Filter调用一遍。没有用到链表这种数据结构。示例如下:

package com.ljn.filter.custom;

import java.util.ArrayList;

- 修改jboss端口

chicony

jboss

修改jboss端口

%JBOSS_HOME%\server\{服务实例名}\conf\bindingservice.beans\META-INF\bindings-jboss-beans.xml

中找到

<!-- The ports-default bindings are obtained by taking the base bindin

- c++ 用类模版实现数组类

CrazyMizzz

C++

最近c++学到数组类,写了代码将他实现,基本具有vector类的功能

#include<iostream>

#include<string>

#include<cassert>

using namespace std;

template<class T>

class Array

{

public:

//构造函数

- hadoop dfs.datanode.du.reserved 预留空间配置方法

daizj

hadoop预留空间

对于datanode配置预留空间的方法 为:在hdfs-site.xml添加如下配置

<property>

<name>dfs.datanode.du.reserved</name>

<value>10737418240</value>

- mysql远程访问的设置

dcj3sjt126com

mysql防火墙

第一步: 激活网络设置 你需要编辑mysql配置文件my.cnf. 通常状况,my.cnf放置于在以下目录: /etc/mysql/my.cnf (Debian linux) /etc/my.cnf (Red Hat Linux/Fedora Linux) /var/db/mysql/my.cnf (FreeBSD) 然后用vi编辑my.cnf,修改内容从以下行: [mysqld] 你所需要: 1

- ios 使用特定的popToViewController返回到相应的Controller

dcj3sjt126com

controller

1、取navigationCtroller中的Controllers

NSArray * ctrlArray = self.navigationController.viewControllers;

2、取出后,执行,

[self.navigationController popToViewController:[ctrlArray objectAtIndex:0] animated:YES

- Linux正则表达式和通配符的区别

eksliang

正则表达式通配符和正则表达式的区别通配符

转载请出自出处:http://eksliang.iteye.com/blog/1976579

首先得明白二者是截然不同的

通配符只能用在shell命令中,用来处理字符串的的匹配。

判断一个命令是否为bash shell(linux 默认的shell)的内置命令

type -t commad

返回结果含义

file 表示为外部命令

alias 表示该

- Ubuntu Mysql Install and CONF

gengzg

Install

http://www.navicat.com.cn/download/navicat-for-mysql

Step1: 下载Navicat ,网址:http://www.navicat.com/en/download/download.html

Step2:进入下载目录,解压压缩包:tar -zxvf navicat11_mysql_en.tar.gz

- 批处理,删除文件bat

huqiji

windowsdos

@echo off

::演示:删除指定路径下指定天数之前(以文件名中包含的日期字符串为准)的文件。

::如果演示结果无误,把del前面的echo去掉,即可实现真正删除。

::本例假设文件名中包含的日期字符串(比如:bak-2009-12-25.log)

rem 指定待删除文件的存放路径

set SrcDir=C:/Test/BatHome

rem 指定天数

set DaysAgo=1

- 跨浏览器兼容的HTML5视频音频播放器

天梯梦

html5

HTML5的video和audio标签是用来在网页中加入视频和音频的标签,在支持html5的浏览器中不需要预先加载Adobe Flash浏览器插件就能轻松快速的播放视频和音频文件。而html5media.js可以在不支持html5的浏览器上使video和audio标签生效。 How to enable <video> and <audio> tags in

- Bundle自定义数据传递

hm4123660

androidSerializable自定义数据传递BundleParcelable

我们都知道Bundle可能过put****()方法添加各种基本类型的数据,Intent也可以通过putExtras(Bundle)将数据添加进去,然后通过startActivity()跳到下一下Activity的时候就把数据也传到下一个Activity了。如传递一个字符串到下一个Activity

把数据放到Intent

- C#:异步编程和线程的使用(.NET 4.5 )

powertoolsteam

.net线程C#异步编程

异步编程和线程处理是并发或并行编程非常重要的功能特征。为了实现异步编程,可使用线程也可以不用。将异步与线程同时讲,将有助于我们更好的理解它们的特征。

本文中涉及关键知识点

1. 异步编程

2. 线程的使用

3. 基于任务的异步模式

4. 并行编程

5. 总结

异步编程

什么是异步操作?异步操作是指某些操作能够独立运行,不依赖主流程或主其他处理流程。通常情况下,C#程序

- spark 查看 job history 日志

Stark_Summer

日志sparkhistoryjob

SPARK_HOME/conf 下:

spark-defaults.conf 增加如下内容

spark.eventLog.enabled true spark.eventLog.dir hdfs://master:8020/var/log/spark spark.eventLog.compress true

spark-env.sh 增加如下内容

export SP

- SSH框架搭建

wangxiukai2015eye

springHibernatestruts

MyEclipse搭建SSH框架 Struts Spring Hibernate

1、new一个web project。

2、右键项目,为项目添加Struts支持。

选择Struts2 Core Libraries -<MyEclipes-Library>

点击Finish。src目录下多了struts