多传感器融合定位开源工程与论文

目录

- (1)LIC-Fusion:基于激光雷达、惯性导航和相机结合的里程计

- (2)使用点线特征配合激光雷达辅助的单目视觉里程计

- (3)间歇的GPS辅助VIO:在线初始化和标定

- (4)强大的高精度视觉惯性激光SLAM系统

- **(5)地面机器人的视觉辅助定位(vins on wheel)

- **(6)松耦合的半直接法单目SLAM

- (7)VIL-SLAM双目视觉惯性雷达

- (8)LOL:在3D点云地图中仅使用激光雷达的里程计和定位

- (9)LINS:用于鲁棒且高效导航的激光雷达-惯性状态估计器

- (10)基于位姿图的无人水下航行器室内导航测试

- (11)PL-SLAM:结合点线特征的双目SLAM

- (12)基于地标外貌和空间相对位置的图匹配的长期地点识别

- (13)funny work 在水下领域基于状态估计的开源VIO实验对比

- (14)LIO-SAM:基于平滑和建图的紧密耦合激光雷达惯性里程计

- (15)基于先验雷达地图约束的视觉惯导定位

- **(16)面向AGV的惯导-2D激光SLAM在流形上的发展

- **(17)DISCOMAN:用于室内里程计,制图和导航的室内场景数据集

- **(18)开源代码介绍: DSM

- (19)以连通图为先验的主动2D激光SLAM

- (20)小改进:一种基于光流的动态环境移动机器人定位方案

- (21)在GPS-denied环境下结合UWB-Vision方法的UAVS自动停泊

- (22)基于基准点的开源视觉-惯导运动捕捉系统

- (23)FMD Stereo SLAM:融合MVG和直接方法,实现准确,快速的双目SLAM

- (24)小改进:加入提示的二进制特征描述子用于视觉地点重识别

- **(25)室内slam数据集:Lifelong SLAM数据集与挑战赛

- (26)基于VINS-Mono开发的SPVIS

- (27)基于动态边缘化的VI-DSO

- (28)<综述>基于滤波和优化的视觉惯性里程计综述

- **(29)具有占有率正态分布变换的基于图的实时SLAM

- **(30)激光-视觉-惯性里程计与建图

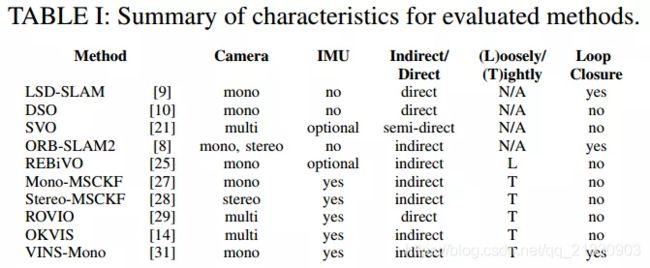

- (31)<实验测评>综合比较几种适用于无人机的单目惯性里程计算法

- (32)<2D/3D激光>IMLS-SLAM:基于3D数据的扫描到模型匹配

- (32)用于鲁棒定位的高效的视觉上下文分类器(特征点新的描述方法)

- **(33)<2D激光开源>动态环境中的高效长时间建图(IROS)

- **(34)GOMSF——基于多传感器融合的图优化无人机鲁棒位姿估计方法

- **(35)半直接单目视觉和视觉惯性SLAM及其闭环检测

- (36)<各种数据集>最强 SLAM Datasets 合辑

- (37)<标定>利用直线和平面对应关系自动标定相机与三维激光雷达之间的外参

- (38)港科大:利用四叉树加速的单目实时稠密建图

- (39)港科大:基于通用优化的多传感器全局位姿估计框架(vins-fusion)

- **(40)OmniSLAM:多鱼眼相机的SLAM系统

- **(41)基于ORB-SLAM2可持续保存地图的扩展方案

- (42)PVIO:基于先验平面约束的高效VIO

- (43) ORB-SLAM2 / ORB-SLAM3 相关改进代码

- (44)用于室内环境下的多传感器融合slam数据集

- (45)SlamBench2:视觉SLAM的多目标头对头基准测试

- ***(46)港科大——双目视觉深度估计及3D地图构建工作

(1)LIC-Fusion:基于激光雷达、惯性导航和相机结合的里程计

标题:LIC-Fusion: LiDAR-Inertial-Camera Odometry

作者:Xingxing Zuo, Patrick Genevayy, Woosik Leey, Yong Liu∗, and Guoquan Huang

来源:2019 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS)

泡泡机器人对此描述: https://mp.weixin.qq.com/s/6P1gD2z3Vz6mxfheT3aNOw

视频测试效果:

https://www.bilibili.com/video/BV1RE411G75C?from=search&seid=13639193494431328014

摘要介绍:

本文提出了一种称名为激光雷达-惯性导航仪-相机三合一(LIC-Fusion)的紧耦合多传感器融合算法,该算法可有效地融合IMU测量,稀疏的视觉特征和提取的激光雷达点。尤其是,提出的LIC-Fusion能够在三个异步传感器之间执行在线的空间和时间传感器标定,以补偿可能的标定偏差。本方法的关键贡献在于,能够基于高效的MSCKF框架,利用从激光雷达检测和跟踪到的系数边缘/surf特征点,以及稀疏的视觉特征与IMU读数,完成理想的(根据线性误差)多模态融合。我们在室内和室外环境中均进行了广泛的实验,结果表明,所提出的LIC-Fusion在估计精度和对剧烈运动的鲁棒性方面均优于最新的视觉惯性里程计(VIO)和激光雷达里程计方法。

(2)使用点线特征配合激光雷达辅助的单目视觉里程计

标题:Lidar-Monocular Visual Odometry using Point and Line Features

作者:Shi-Sheng Huang , Ze-Yu Ma , Tai-Jiang Mu, Hongbo Fu, and Shi-Min Hu

来源:ICRA 2020

泡泡机器人对此描述:

https://mp.weixin.qq.com/s/cvm6_zcw7scbAYcuX8JYQw

摘要介绍:

一种新颖的激光雷达与单目视觉传感器联合点线特征的视觉里程计,通过引入点和线特征,提供了一个鲁棒的点线深度提取方法,并且将提取深度信息作为先验参数进行点线联合平差,这种方法很好的降低了3D特征奇异从而提高姿态评估的准确性,形成了一套高效高精度的单目视觉里程计系统。

注:激光雷达在此起到深度校准,和ICP先验位姿信息的提供作用。

算法流程:

A. 特征提取与匹配

点特征使用ORB快速提取方法,线特征采用LSD算法,线匹配方法使用LBD方法;

B. 点和线深度提取

对于每个检测到的二维点或线段,分别使用相邻的图像块估计其深度。点的三维先验估计使用图像射线与平面的交点表示,线的3D对应通过最小化相应的能量函数得到;

C. 帧与帧间里程计

特征跟踪使用图像层面的特征匹配策略完成,三维点线通过B步骤获取,使用PNP或PNL方法得到帧间里程计信息;

D. 尺度纠正优化

将每帧点云ICP配准矩阵作为图像尺度先验信息输入,调整关键帧姿态求解,控制里程计尺度漂移;

E:点线平差

使用点和线重投影误差来优化里程计,平差策略与ORB-SLAM2类似,后端滑动窗口关键帧策略实现局部平差;

F:回环检测

使用DBoW训练点线特征,将关键帧使用特征词典描述,使用点线的BoW特征向量的相似度评价场景相似性,完成回环检测。

(3)间歇的GPS辅助VIO:在线初始化和标定

标题: Intermittent GPS-aided VIO: Online Initialization and Calibration

作者:Woosik Lee, Kevin Eckenhoff, Patrick Geneva, and Guoquan Huang

来源:2020 IEEE International Conference on Robotics and Automation (ICRA)

泡泡机器人描述:

https://mp.weixin.qq.com/s/btnoOfSqqWoald5—TKOQ

摘要描述:

本文提出一种有效而且鲁棒的GPS辅助的视觉惯导里程计(GPS-VIO)系统,该系统使用低频的GPS测量数据融合相机IMU数据。为了执行传感器融合,需要进行时空传感器标定和传感器参考帧之间的转换初始化。本文提出一种在线标定的方法对于GPS-IMU之间的外参、时间偏移以及对GPS传感器噪声具有鲁棒性的参考帧初始化步骤。此外,在VIO参考帧中进行估计时,证明了GPS-VIO系统存在四个不可观测的方向,并提出对GPS参考帧进行状态转换以实现完全可观。我们在蒙特卡罗仿真环境中广泛评估了所提出的方法,该方法中我们研究了系统对不同级别的噪声和GPS信号损失的鲁棒性并且另外研究了初始化过程中所使用的超参数。最后,在大规模的真实实验中验证了所提出的系统。

(4)强大的高精度视觉惯性激光SLAM系统

标题:Robust High Accuracy Visual-Inertial-Laser SLAM System

作者:Zengyuan Wang, Jianhua Zhang, Shengyong Chen, Conger Yuan, Jingqian Zhang and Jianwei Zhang

来源:IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS),2019

泡泡机器人描述:

https://mp.weixin.qq.com/s/ucXrgHflqVdUaw7JZj1SVA

摘要描述:

该系统从视觉-惯性紧密耦合的运动估计方法开始,然后进行扫描匹配以进一步优化估计和在地图上注册点云。此外,我们使模块能够自动灵活地进行调整。也就是说,当这些模块之一发生故障时,其余模块将承担运动跟踪任务。为了进一步提高精度,实施了闭环和接近检测以消除漂移累积。当检测到回路或接近度时,我们将执行六个自由度(6-DOF)姿态图优化,以实现全局一致性。我们的系统性能在公共数据集上得到了验证,实验结果表明,与其他最新算法相比,该方法具有更高的精度。

简要描述:通过vio初始化激光里程计位姿估计,并提供模块故障时的切换策略。

**(5)地面机器人的视觉辅助定位(vins on wheel)

标题:Vision-Aided Localization For Ground Robots

作者:Mingming Zhang, Yiming Chen and Mingyang Li

来源:IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS),2019

泡泡机器人介绍:

https://mp.weixin.qq.com/s/rdsfIfzGkYMdFG5T61NONA

摘要介绍:

通过融合摄像机,IMU和车轮里程表的测量结果,提出了一种专门针对地面机器人设计的新颖的基于视觉的定位算法。本文的第一个贡献是,我们提出了一种新颖的算法,该算法可通过参数表示逼近地面机器人的运动流形,并通过IMU和车轮里程计测量执行姿态积分。其次,通过使用基于滑动窗口的估计器,提出了一种完整的定位算法。估计器是基于迭代优化设计的,可以融合来自多个传感器的测量结果,并与建议的歧管表示形式相融合。我们显示,基于各种现实世界的实验,所提出的算法在很大程度上优于基于视觉的最新定位算法,尤其是在大规模复杂环境中部署时。

评:可以看下作者是如何把轮速计融入至vio的

**(6)松耦合的半直接法单目SLAM

标题:Loosely-Coupled Semi-Direct Monocular SLAM

作者:Seong Hun Lee and Javier Civera

来源:International Conference on Robotics and Automation (ICRA),2019

泡泡机器人描述:

https://mp.weixin.qq.com/s/ZkpkMPQb6TWZssliTJtATg

摘要描述:

本文提出了一种新颖的单目同步定位与建图(SLAM)方法,该方法结合了直接法和特征点法的优势。提出的对直接法视觉里程计和基于特征点法松耦合的SLAM执行三个层次的并行优化:(1)联合局部特征和相机运动的光度捆集调整(BA);(2)改善关键帧位姿和相关联地图点的几何BA;(3)存在闭环检测时全局地图一致性的位姿图优化。这是通过将基于特征的边缘化关键帧的操作限制为使用直接法里程计模块实时实现的。对两个数据集的详细评估表明,我们的系统在总体准确性和鲁棒性方面优于最新的单目里程计和SLAM系统。

贡献:

(1)局部:对于局部精度来说,使用直接法能够鲁棒,短期,半稠密并且迅速的来跟踪相机的位姿,

(2)全局:使用基于特征点法来改善关键帧的位姿,同时进行回环检测。建立了一个可以复用的全局,长期,稀疏特征点的地图。

评:可关注下作者是如何处理特征点法和直接法在前端的松耦合处理

算法开源: https://github.com/sunghoon031/LCSD_SLAM

(7)VIL-SLAM双目视觉惯性雷达

作者:W. Shao, S. Vijayarangan, C. Li, G. Kantor.

题目:Stereo Visual Inertial LiDAR Simultaneous Localization and Mapping. 来源:IEEE/RSJ International Conference on Intelligent Robots and Systems, 2019

简介描述:

https://mp.weixin.qq.com/s/bTwvU-mDZF0j_yBsbSXwpQ

泡泡机器人描述:

https://mp.weixin.qq.com/s/ItJlAeWqL35qn0KdIiv3dg

本文将Foster提出的紧耦合VIO(参考【论文阅读11】【论文阅读12】)和Ji Zhang提出的LOAM结合起来,并且加入了LiDAR增强的闭环模块。

·IMU预积分+非结构化视觉因子的紧耦合双目VIO

·基于LOAM的建图。主要改进,使用IMU频率的VIO输出用于点云去畸变。

·加粗样式LiDAR增强的闭环。在BoW回环检测和PnP回环约束构建之外增加ICP对齐。

评:作者为结合两种现有算法使用,IMU频率的VIO位姿优化LOAM

(8)LOL:在3D点云地图中仅使用激光雷达的里程计和定位

标题:使用LiDAR的大规模体积场景重建

作者: David Rozenberszki和Andras L. Majdik

来源:2020 IEEE国际机器人与自动化会议(ICRA)

泡泡机器人描述:网址

摘要描述:

我们解决了在城镇环境中过渡的,配备激光雷达的车辆的里程计和定位(存在一个预先建立的目标地图重新确定位置)问题。在我们的问题表述中,为了纠正基于的里程计的渐进漂移,我们使用了位置识别方法来检测在线3D点云和先验离线地图的几何上相似的位置。在提出的系统中,我们通过优势互补,将最新的仅Lidar里程计的算法与最近提出的3D点分割匹配方法集成在一起。以及,我们提出了额外的增强,以便减少在线3D点云与目标地图错误匹配的数量,并在何时检测到一个好的匹配时优化位置误差。我们在不同长度和环境的多个Kitti数据集上演示了提出的LOL系统的实用性,在某些情况下,重新定位的精确度和车辆轨迹的精度都得到了显着提高,同时仍然能够保持实时性能。

开源网址:https://github.com/RozDavid/LOL

视频地址:https://youtu.be/ektGb5SQGRM

(9)LINS:用于鲁棒且高效导航的激光雷达-惯性状态估计器

标题:LINS: A Lidar-Inertial State Estimator for Robust and Efficient Navigation

作者:Chao Qin, Haoyang Ye, Christian E. Pranata, Jun Han, Shuyang Zhang, and Ming Liu

来源:ICRA 2020

泡泡机器人描述:网址链接

摘要介绍:

一个轻量级的激光雷达-惯性估计器,用于实时的自我运动估计。提出的方法采用紧耦合方案融合6轴IMU和3D激光雷达,从而允许地面车辆在具有挑战性的环境(例如没有特征的场景)中鲁棒且高效的导航。我们设计了一个重复的误差状态卡尔曼滤波器,通过在每次迭代中生成新的特征对应来递归地校正估计的状态,并且它在计算上容易处理。而且,为了防止在长时间运行后滤波器发散,我们采用以机器人为中心的公式,它表达了局部坐标系中的状态。为了验证鲁棒性和通用性,我们在不同的场景进行了广泛的实验。实验结果表明,LINS在稳定性和精度方面,提供了与最先进的激光雷达-惯性里程计类似的性能,而在速度方面有数量级的提升。

评:作者使用了迭代卡尔曼滤波与误差状态卡尔曼滤波来处理后端。

代码链接:https://github.com/ChaoqinRobotics

视频展示:https://www.youtube.com/watch?v=Nmr1blC09qw&t=8s

(10)基于位姿图的无人水下航行器室内导航测试

泡泡机器人描述:

https://mp.weixin.qq.com/s/hpEMduMRuw9UbtB8u8m1PQ

摘要:

本文提出了基于位姿图的室内导航测试的初步实验结果,旨在应用于无人水下航行器(UUV)。为了验证其有效性并估计位姿图技术的性能,我们使用地面机器人kobuki进行了室内测试。在此实验中,机器人在办公室和走廊的室内移动来连续创建机器人路径的位姿图,位于机器人正面的LIDAR传感器也被用于构建地图。

评:作者在机器人上使用了激光和地表码,了解下

(11)PL-SLAM:结合点线特征的双目SLAM

标题:PL-SLAM: A Stereo SLAM System Through the Combination of Points and Line Segments

作者: Ruben Gomez-Ojeda, Francisco-Angel Moreno

来源:TRO 2019

泡泡机器人描述:

https://mp.weixin.qq.com/s/7IkFp8uubBLWW0CPHoeZAg

摘要描述:

本文提出了PL-SLAM,这是一种双目视觉SLAM系统,它结合了点和线段,能够在更广泛的场景中稳定地工作,特别是在点特征在图像中缺乏或分布不均匀的情况下。PL-SLAM在过程的所有实例中都利用了点和线段:视觉里程计、关键帧选择、束调整等。我们还通过一种新颖的词包方法提供了一个循环闭合过程,该方法利用了这两种特征的组合描述能力。

主要贡献:

1.第一个实时开源的同时使用点和线分割特征深度SLAM系统,并且在弱纹理环境中传统点特征方法失效的情况下拥有较高的运行鲁棒性。

2.一种新的同时处理点和线特征调整关键字位姿。

3.一种扩展BoW方法同时考虑点和线特征分割提高闭环检测

注:整个方法基于ORB-SLAM进行开展。

C++代码的开源版本: https://github.com/rubengooj/pl-slam

(12)基于地标外貌和空间相对位置的图匹配的长期地点识别

标题:Long-term Place Recognition through Worst-case Graph Matching to Integrate Landmark Appearances and Spatial Relationships

作者:Peng Gao and Hao Zhang

来源:ICRA2020

泡泡机器人描述:

https://mp.weixin.qq.com/s/tUlFR3WzBU94gQoZdcM5HQ

摘要描述:

地点识别是很多机器人应用中的SLAM技术中的重要环节。最近,一些采用地标信息来解决长期地点识别中场景变化问题的方法取得了不错的效果。然而先前的方法未考虑地标的变化,例如旧的地标的消失和新的地标的出现。并且,这些方法对地标的描述通常仅仅使用了地标的视觉信息或者几何信息。本文设计了一个图表示一个地方,通过编码距离和角度空间关系以及地标的视觉外观。然后,地点识别问题可以转换为最坏情况下的图匹配问题。该算法方法通过计算相似性最小的地标之间的距离和角度空间关系来度量地点的相似度。如果最差情况下,地标的视觉相似度较低,那么即使其几何位置相识度较高,也被作为不同的地点。

主要贡献:

1、提出了一种融合地标视觉信息和相对位置的几何信息的地点编码方法,改善了基于地标的地点编码方式;

2、将地点识别问题作为最差情况下的图匹配问题,从而有效解决了长期地点识别中路标变动的问题

(13)funny work 在水下领域基于状态估计的开源VIO实验对比

标题:Experimental Comparison of Open Source Visual-Inertial-Based State Estimation Algorithms in the Underwater Domain

作者:Bharat Joshi, Sharmin Rahman, Michail Kalaitzakis, Brennan Cain, James Johnson, Marios Xanthidis, Nare Karapetyan, Alan Hernandez, Alberto Quattrini Li, Nikolaos Vitzilaios, and Ioannis Rekleitis

来源:2019 IROS

泡泡机器人描述:

https://mp.weixin.qq.com/s/xYo921zm9ItwOOgJlMaEsg

摘要描述:

本文中比较了最近的10个VIO开源包为了提供对它们性能的见解和解决当前挑战的指导方针。具体地,选择了直接法和间接法来融合相机和惯性测量单元数据。实验是通过对我们实验室多年来收集的水下机器人数据集的所有包进行测试。所有数据集都是在线提供的。

(14)LIO-SAM:基于平滑和建图的紧密耦合激光雷达惯性里程计

标题:LIO-SAM: Tightly-coupled Lidar Inertial Odometry viaSmoothing and Mapping

作者:Tixiao Shan, Brendan Englot, Drew Meyers, Wei Wang, Carlo Ratti, and Daniela Rus

来源:IROS2020

泡泡机器人介绍:

https://mp.weixin.qq.com/s/G8bY5yDCuS2N8rNGKM2EMg

摘要介绍:

本文提出了一个基于平滑和建图的紧密耦合激光雷达惯性里程计的框架,LIO-SAM。该框架可以实现高精度,实时的移动机器人轨迹估计和地图构建。LIO-SAM在因子图上实现了激光雷达惯性里程计,从而可以将不同来源的相对和绝对测量(包括回环)作为因子加入系统中。惯性测量单元(IMU)预积分的运动估计被用来去处激光雷达运动畸变,并为激光雷达里程计的优化提供初值。获得的激光雷达里程计的结果用来估计IMU的偏差。为了兼顾实时与高性能,本文将激光雷达扫描边缘化后进行位姿优化,而不是将激光雷达的扫描配准到全局地图。在局部范围而不是全局范围进行扫描匹配显著的提高了系统的实时性能,选择性的引入关键帧和将新关键帧配准到固定大小的先验“子关键帧”集合的高效滑动窗口方法也显著提高了实时性能。本文提出的方法在不同规模和环境的三个平台收集的数据集上进行了广泛的评估。

LEGO-LOAM升级版

开源地址:https://github.com/TixiaoShan/LIO-SAM

(15)基于先验雷达地图约束的视觉惯导定位

标题:Visual-Inertial Localization with Prior LiDAR Map Constraints

作者:Xingxing Zuo, Patrick Geneva, Yulin Yang, Wenlong Ye, Yong Liu, and Guoquan Huang

来源:IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS),2019

泡泡机器人描述:

https://mp.weixin.qq.com/s/seOXO8-4MUwAszQkjaIueQ

摘要描述:

我们开发了一种低成本的双目相机-惯导定位系统,该系统有效利用多状态约束卡尔曼滤波(MSCKF)的视觉惯性里程计同时利用先验雷达地图提供有界误差的三维导航。除了VIO中使用的标准的稀疏视觉特征点测量,在紧耦合的MSCKF更新中利用了之前的激光雷达地图上的视觉半直接法的全局注册,从而校正了累积误差。

**(16)面向AGV的惯导-2D激光SLAM在流形上的发展

标题:A Development of Inertial-2D LiDAR SLAM on Manifolds Towards AGV

作者:Nam Dinh Van and Gon-Woo Kim

来源:IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS) 2019

泡泡机器人描述:

https://mp.weixin.qq.com/s/SSmcXi8ng1vOhO02v38czg

在本文中,我们提出了一种新的SLAM框架开发方法,该框架基于基于因子图的传感器与2D LiDAR和IMU融合在一起,用于自动导引车(AGV)。通过预集成和李理论进行的这项工作处理与现有的2D LiDAR SLAM框架相比。我们的第一个贡献是在与IMU融合的情况下正式讨论和分析2D LiDAR里程表。第二个贡献是,通过在歧管上使用预集成理论,提出了一条融合IMU和2D LiDAR的管道。最后的贡献是展示如何使用管道实施。

**(17)DISCOMAN:用于室内里程计,制图和导航的室内场景数据集

标题:DISCOMAN: Dataset of Indoor SCenes for Odometry, Mapping and Navigation

作者:Pavel Kirsanov, Airat Gaskarov, Filipp Konokhov, Konstantin Sofiiuk, Anna Vorontsova, Igor Slinko, Dmitry Zhukov, Sergey Bykov, Olga Barinova, Anton Konushin

来源:IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS),2019

泡泡机器人描述:

https://mp.weixin.qq.com/s/FBcyKQTq3UCGP9_qC7DW5A

摘要描述:

我们提供了一个用于训练和基准化语义SLAM方法的新颖数据集,该数据集由200个长序列组成,每个序列包含3000-5000个数据帧。 ,我们对模拟简单的家用机器人运动的轨迹进行采样,然后沿这些轨迹渲染框架。每个数据帧包含:a)使用基于物理的渲染生成的RGB图像,b)模拟的深度测量,c)模拟的IMU与现有数据集索引,我们的数据集具有更广泛的用途,并且是针对SLAM映射组件的第一个大型基准测试。数据集分为从我们介绍了基于经典几何[1],[2]和最近基于学习[3]的SLAM算法,基准线映射方法[4],语义分割[ 5]和全景分割[6]的基准测试结果。用于复制我们的实验的数据集和源代码将在发布时公开提供。

评:可用于室内环境下slam仿真

**(18)开源代码介绍: DSM

推荐人: hudeshun

推荐指数:⭐⭐⭐⭐

推荐理由: Direct Sparse Mapping(DSM)是一个采用直接法的单目视觉SLAM系统,可以看成是DSO的一个增强版本。DSM与DSO最大的不同在于,DSM可以处理地图点的重观测。 为此,DSM借鉴了ORB-SLAM2中的局部窗口和共视关系等概念。DSM最大的优点在于代码的模块化做的很好,程序的各个模块和各个类都做了很好的封装,比DSO的代码要清晰易懂的多。而且DSM的代码里也有很多可以借鉴的地方,例如DSM会实时统计各个帧的光度误差的分布(用学生t分布去拟合),DSM内部也用内存池和线程池来对内存资源和计算资源进行抽象和封装。DSM非常适合对直接法感兴趣的朋友去学习。

代码链接:

https://github.com/jzubizarreta/dsm

论文链接:

https://arxiv.org/pdf/1904.06577.pdf

视频展示:

https://youtu.be/sj1GIF-7BYo

相关参考:

https://www.cnblogs.com/tweed/p/12141935.html

https://arxiv.org/pdf/1607.02565.pdf

论文名称: Direct Sparse Mapping

算法简介: 之前的直接法里程计,例如DSO,采用Schur Complement来边缘化掉滑窗外的点和位姿,这导致其无法处理地图点的重新观测。本文提出一个完整的单目直接法SLAM系统,可以处理地图点的重观测,并且在EuRoC数据集上取得了直接法里面最精确的结果。本文的贡献在于:可以处理地图点的重观测,利用共视关系来选择关键帧,采用coarse-to-fine的策略来做光度优化以增加收敛半径以及用t分布拟合光度误差来进行外点管理。

(19)以连通图为先验的主动2D激光SLAM

标题:Active SLAM using Connectivity Graphs as Priors

作者:Alberto Soragna, Marco Baldini, Dominik Joho, Rainer Kummerle, Giorgio Grisetti

来源:2019 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS)

泡泡机器人描述:

https://mp.weixin.qq.com/s/_WSAVTonpEXw4bsQLNudjQ

摘要描述:

在本文中,我们提出了一个新的框架来鲁棒地解决主动SLAM问题,在这种情况下,一些关于环境的先验信息以拓扑图的形式存在。这些信息通常是可用的,或者可以在工业环境中轻松开发,但通常会受到不确定性的影响。

特别地,我们的方法的显著特点是:包含用于解决主动SLAM问题的先验信息;利用该信息寻求主动闭环;在线修正所提供数据中的不一致性。

(20)小改进:一种基于光流的动态环境移动机器人定位方案

标题:AnAccurate Localization Scheme for Mobile Robots Using Optical Flow in DynamicEnvironments

作者:Jiyu Cheng, Yuxiang Sun, Wenzheng Chi, Chaoqun Wang, Hu Cheng and Max Q.-H. Meng

来源:2018 IEEE International Conference on Robotics and Biomimetics

泡泡机器人描述:

https://mp.weixin.qq.com/s/UytzSjuCKKu48ZByGuh1Dg

摘要描述:

提出了一种利用光流从提取的特征点中识别和消除动态特征点的新方法。将静态特征点加入到视觉SLAM算法中进行位姿估计。我们将我们的方法与ORB-SLAM系统集成,并利用TUM数据集中的动态序列验证了所提出的方法。整个系统可以实时运行。定性和定量的评估表明,我们的方法大大提高了视觉SLAM在动态场景中的性能。

评:利用前后帧特征点变换,计算光流大小来移除动态点

(21)在GPS-denied环境下结合UWB-Vision方法的UAVS自动停泊

标题:Integrated UWB-Vision Approach for Autonomous Docking of UAVs in GPS-denied Environments

作者:Thien-Minh Nguyen ; Thien Hoang Nguyen ; Muqing Cao ; et. al

来源:ICRA 2019

泡泡机器人描述:

https://mp.weixin.qq.com/s/Czif-xVRHRbTq2EVo8yOcw

主要贡献:

- 结合UWB测距和视觉移动测量,提出了一种基于递归最小二乘优化的相对定位方案,并证明了估计误差以指数形式收敛。

2)相较于以往着陆于固定台的方案,我们实现了与移动着陆台的协同对接,这让对接任务灵活性更强。

3)在着陆阶段提出了结合相对位置估计和测距的方法实现更精确的着陆,通过大量实验验证了方案在长达50米时的有效性。

(22)基于基准点的开源视觉-惯导运动捕捉系统

标题:An Open Source, Fiducial Based, Visual-Inertial Motion Capture System

作者:Michael Neunert ,Michael Bloesch,Jonas Buchli

来源:FUSION 2016

泡泡机器人描述:

https://mp.weixin.qq.com/s/XJlpoVfqlAeusFMtzgZfyA

主要贡献:

本文提出了一种基于单目-惯导EKF-SLAM的轻量级运动估计系统,该系统使用了人工地标。这项工作通过使用6 DoF的地标的角点观察并改编相应的卡尔曼滤波器,紧耦合SLAM和基于基准点的定位。这允许更小的地图尺寸和更精简的估计。与已有的依赖6DoF基准点的现有方法相比,所提出的框架在单个估计器中处理视觉测量和惯导数据,这保证了一致的数据并避免预校准和再校准

(23)FMD Stereo SLAM:融合MVG和直接方法,实现准确,快速的双目SLAM

标题:FMD Stereo SLAM: Fusing MVG and Direct Formulation Towards Accurate and Fast Stereo SLAM

作者:Fulin Tang, Heping Li, Yihong Wu

来源:2019 IEEE International Conference on Robotics and Automation (ICRA), May 20-24, 2019, Montreal, Canada

(中科院,特征点法和直接法结合)

泡泡机器人描述:

https://mp.weixin.qq.com/s/YIP9FzcxC38pcuk03JER3Q

摘要描述:

我们提出了一种新颖的双目视觉SLAM框架,同时兼顾了精度和速度。该框架充分利用了基于关键特征的多视图几何(MVG)和基于直接方法的优势。在前端,我们的系统执行直接公式和恒定运动模型来预测稳健的初始姿势,重新投影局部地图以找到3D-2D对应,并通过重投影误差最小化来最终确定姿势。这个前端过程使我们的系统更快。在后端,MVG用于估计3D结构。插入新关键帧时,通过三角测量生成新的地图点。为了提高所提出系统的准确性,删除了坏的地图点并通过束调整保持全局地图。特别地,执行立体约束以优化地图。这种后端流程使我们的系统更加准确。对EuRoC数据集的实验评估表明,所提出的算法可以在消费者计算机上以每秒100帧以上的速度运行,同时实现高度竞争的准确性。

(24)小改进:加入提示的二进制特征描述子用于视觉地点重识别

标题:Adding Cues to Binary Feature Descriptors for Visual Place Recognition

作者:Dominik Schlegel and Giorgio Grisetti

来源:The International Conference in Robotics and Automation(ICRA) 2019

泡泡机器人描述:

https://mp.weixin.qq.com/s/C5kqOsBiv6lu-OOCQWXLOQ

摘要描述:

本文提出了一种将连续或有选择的提示嵌入用于视觉地点重识别的二进制描述子的方法。该嵌入方法将原来的描述子与编码提示的二进制字符串进行组合,并支持使用汉明距离作为度量。将该种方式增广的描述子应用于原有应用无需过多改进。

**(25)室内slam数据集:Lifelong SLAM数据集与挑战赛

论文地址:

https://arxiv.org/pdf/1911.05603.pdf

数据集地址:

https://lifelong-robotic-vision.github.io/dataset/scene

比赛以及数据集介绍:

https://mp.weixin.qq.com/s/SWHMo5YEF_tV_0O5XHlvPg

2019赛况介绍:

https://www.leiphone.com/news/201911/0WH1bTUDrHrMLJck.html

csdn相关解释:

https://blog.csdn.net/weixin_47658743/article/details/107693430

** 相关数据集:九号机器人实验室使用的

http://drive.segwayrobotics.com/dataset/sample

数据集下载地址:

https://shimo.im/docs/HhJj6XHYhdRQ6jjk/read

(26)基于VINS-Mono开发的SPVIS

ICRA 2020

Hierarchical Quadtree Feature Optical Flow Tracking Based Sparse Pose-Graph Visual-Inertial SLAM

基于VINS-Mono开发了SPVIS,前端提出hierarchical quadtree方法提高optical flow feature tracking的性能,大幅降低需要的feature数量。后端采用固定时长的sliding window做全局优化,窗口之外仅保留pose graph。整个系统效率很高,从而支持长期运行。

(27)基于动态边缘化的VI-DSO

标题:Direct Sparse Visual-Inertial Odometry using Dynamic Marginalization

作者:Lukas von Stumberg, Vladyslav Usenko, Daniel Cremers

来源:IEEE International Conference on Robotics and Automation (ICRA), 2018, Brisbane

泡泡机器人描述:

https://mp.weixin.qq.com/s/Kv_SiyL17hJlMzP_ZtlmAw

摘要描述:

本文提出了一个新的视觉惯导里程计(VIO)VI-DSO,其通过光度最小化和IMU的测量值来估计相机的位姿和恢复稀疏场景。

在视觉部分,VI-DSO也使用了光束法平差进行优化,但是与传统基于特征点的系统不同,本系统中优化的对象是光度误差;这意味着,本系统不仅能够跟踪角点,还可以跟踪梯度足够大的像素点。

而对于IMU部分,本文使用预积分获取视频帧之间的相对关系,并将其作为约束添加到优化过程中;在本系统中,尺度和重力方向也是需要估计的参数,与位姿参数等等一起进行估计和优化。同时针对IMU一般需要一段时间后才能获取尺度信息的问题,本文中的VI-DSO能够首先以任意尺度初始化,而不需要等待IMU得到足够的观测值。

另外,为提高计算效率,本文对“老”的参数进行部分边缘化(partial marginalization),即本文提出的动态边缘化(Dynamic Marginalization);这种边缘化方法甚至能够在尺度未知的情况下进行部分边缘化。最后本文在EuRoC数据上进行测试,实验结果表明VI-DSO是目前最优的算法。

(28)<综述>基于滤波和优化的视觉惯性里程计综述

标题:A review of visual inertial odometry from filtering and optimisation perspectives

作者:Jianjun Gui∗, Dongbing Gu, Sen Wang and Huosheng Hu

来源:Advanced Robotics, 2015

泡泡机器人描述:

https://mp.weixin.qq.com/s/eIICr1I5Mzjm0tqxOfaJWw

**(29)具有占有率正态分布变换的基于图的实时SLAM

标题: Real-Time Graph-Based SLAM with Occupancy Normal Distributions Transforms

作者:Cornelia Schulz and Andreas Zell

来源:2020 IEEE International Conference on Robotics and Automation (ICRA)

基于NDT地图的2D laser SLAM,比occupancy版本的baseline(Cartographer)精度和速度都更好一些。

泡泡机器人:

https://www.sohu.com/a/426672065_715754

摘要描述:

在这项工作中,我们对(O)NDT匹配函数进行了重新格式化,使其成为最小二乘问题,可以使用各种健壮的数值和分析非线性优化器来解决。此外,我们提出了一种新颖的全局(O)NDT扫描匹配器,用于闭环。在我们的评估中,我们的NDT和ONDT方法能够胜过我们从Google Cartographer实施中采用的基于占用网格图的方法。

**(30)激光-视觉-惯性里程计与建图

评:可以关注下作者在处理传感器退化问题上的处理步骤

标题:Laser–visual–inertial odometry and mapping with high robustness and low drift

作者:Ji Zhang,Sanjiv Singh

来源:JOURNAL OF FIELD ROBOTICS

泡泡机器人描述:

https://mp.weixin.qq.com/s/rQpqlhNcohbfGAUFPsqImA

摘要描述:

1.文章提出了一种模块化的处理流程利用激光雷达,相机和IMU来进行运动估计和多层优化来建图。

2.文章提出的处理流程可以绕开失效模块,利用其余部分来处理持续工作,可以解决环境恶化和侵略性运动。

3.文章提出的方法可以用于在已有的地图上进行定位和建图。

4.文章提出的方法在复杂环境下进行了多次的实验。

(31)<实验测评>综合比较几种适用于无人机的单目惯性里程计算法

标题:A Benchmark Comparison of Monocular Visual-Inertial Odometry Algorithms for Flying Robots

作者:Jeffrey Delmerico and Davide Scaramuzza

来源:2018 IEEE International Conference on Robotics and Automation (ICRA), May 21-25, 2018, Brisbane, Australia

泡泡机器人描述:

https://mp.weixin.qq.com/s/Os31KhL-Q1TxoL3CbngKgQ

本文在不同硬件条件下(包括无人机最常见的单一计算平台的情况)评估了一系列开源VIO算法(MSCKF, OKVIS, ROVIO, VINS-Mono, SVO+MSF, SVO+GTSAM)。我们在EuRoC数据集上测试了各个算法的位姿估计精度、处理每一帧所用的时间以及CPU和内存的占用情况,该数据集包含无人机各种典型的6自由度飞行轨迹。我们展示了所有对比的数据,这可以为其他相关研究提供对比基准。文章的视频已经公开在YouTube上:https://youtu.be/ymI3FmwU9AY

(32)<2D/3D激光>IMLS-SLAM:基于3D数据的扫描到模型匹配

标题:IMLS-SLAM: scan-to-model matching based on 3D data

作者:Jean-Emmanuel Deschaud

来源:2018 IEEE International Conference on Robotics and Automation (ICRA)

泡泡机器人描述:

https://mp.weixin.qq.com/s/jyEyzSEoW8oOD5ERTiYSWg

摘要描述:

机器人社区已经对同时定位和建图(SLAM)问题进行了很好的研究,特别是使用单目,双目摄像机或深度传感器。3D深度传感器,如Velodyne雷达,在过去10年中已被证明对于自动驾驶中的环境感知非常有用,但是很少有方法直接将这些3D数据用于里程计。我们提出了一种仅基于3D雷达数据的新型低漂移SLAM算法。我们的方法依赖于扫描到模型的匹配框架。我们首先使用一个基于LiDAR扫描的特定采样策略。然后,我们将模型定义为先前已定位的LiDAR扫描,并使用隐式移动最小二乘(IMLS)曲面来表示该模型。

(32)用于鲁棒定位的高效的视觉上下文分类器(特征点新的描述方法)

标题:LandmarkBoost: Efficient Visual Context Classifiers for Robust Localization

作者:Marcin Dymczyk, Igor Gilitschenski, Juan Nieto, Simon Lynen, Bernhard Zeis, and Roland Siegwart

来源:International Conference on Intelligent Robots and Systems (IROS 2018)

泡泡机器人描述:

https://mp.weixin.qq.com/s/WIsg1M3rvks7JPONHK6ORA

摘要描述:

自动化系统的日益扩展,产生对可靠和有效的尺度位置检索算法的需求。当前使用的方法依赖依赖二进制代码的最近邻搜索来执行2D3D匹配并保证移动平台上的实时能力。然而,这些方法与地图的大小增加,视点或外观的变化以及环境中存在的视觉混叠相矛盾。

我们提出LandmarkBoost方法,与传统的2D-3D匹配方法分类,这种方法将搜索问题作为标志性的分类任务。

**(33)<2D激光开源>动态环境中的高效长时间建图(IROS)

标题:Efficient Long-term Mapping in Dynamic Environments

作者:Mar´ıa T. Lázaro, Roberto Capobianco and Giorgio Grisetti Sapienza University of Rome

来源:IROS 2018

泡泡机器人:

https://mp.weixin.qq.com/s/gLmMKL62_FplJP4Wr-O-QA

注:代码开源,但是还未找到

摘要描述:

自主移动机器人越来越多被引入长期运行的现实环境中,长期建图的困难引起机器人研究界的关注。本文提出一个SLAM系统,能够通过单个或跨建图任务中解决动态环境的建图问题。本文使用位姿图的SLAM系统,该系统将以二维点云数据的形式存储局部地图,随着时间的推移,存储的环境将实时更新。我们系统的核心是基于ICP的高效配准以及解决非静态环境点云配准。该系统通过删除鲁棒性的回环检测上过时的节点来保持图的复杂性,并且通过浓缩测量保持图的一致性。用大量实时的数据实验证明本文方法的精度,准确性和长时间操纵机器人进行地图管理的有效性。

**(34)GOMSF——基于多传感器融合的图优化无人机鲁棒位姿估计方法

标题:GOMSF—Graph-Optimization Based Multi-Sensor Fusion for robust UAV Pose estimation

作者:Ruben Mascaro, Lucas Teixeira, Timo Hinzmann, Roland Siegwart and Margarita Chli

来源:2018 IEEE International Conference on Robotics and Automation (ICRA)

评:作者使用的方法似乎和vins-fusion中融合GPS的思想很一致,进一步看下

泡泡机器人:

https://mp.weixin.qq.com/s/zrnhObDL-TWeD1MEBrquRQ

知乎讲解:

https://zhuanlan.zhihu.com/p/72206494

摘要描述:

本文提出了一种解耦的基于多传感器融合的图优化方法(GOMSF),它结合6自由度的视觉惯性里程计的估计位姿和3自由度的全局位置来实时推断全局坐标系下的机器人6自由度位姿。该方法将融合问题视为局部视觉惯性里程计下的位姿和全局位置的实时对齐问题。对齐的坐标转换关系通过优化包含了最近几帧机器人状态的滑动窗口中的位姿图进行持续更新。

我们用小型UAV在仿真数据和大尺度的室外实验中评估了目前存在的位姿估计方法和本文方法,结果表明本文提出的方法在位姿估计方面基本比其他解耦的融合策略更加精确。我们也和紧耦合的融合了视觉、惯性测量单元和GPS测量的扩展卡尔曼滤波方法进行了比较,本文方法能在直接处理不同的输入资源的情况下得到和紧耦合方法相当的结果。

**(35)半直接单目视觉和视觉惯性SLAM及其闭环检测

标题:Semi-direct monocular visual and visual-inertial SLAM with loop closuredetection

作者:Shao-peng Li, Tao Zhang, Xiang Gao, Duo Wang, Yong Xian

来源:Robotics and Autonomous Systems 2018

泡泡机器人:

https://mp.weixin.qq.com/s/kHVLwB1KbTQts6paYWjJ4g

摘要描述:

作者提出了 一个新的半直接单目视觉同时定位与建图(SLAM)系统。它既能保持直接法的快速性,又能具有基于特征方法的高精度和闭环检测能力。该系统提取和匹配每一个关键帧中的ORB特征,并使用不需要特征提取和匹配的直接法来跟踪每一个非关键帧。关键帧用来全局或局部优化以及闭环,而非关键帧则用来做快速跟踪和定位,因此该系统结合了直接法和特征方法的优势。此外,还提出一个单目视觉惯性SLAM系统,基于视觉SLAM来融合惯性测量数据。该系统能够成功恢复尺度信息。

主要贡献:

1. 提出了一个新的半直接单目视觉SLAM系统 - SVL (semi-direct, visual and loop closure detection);

2. 同时还提出了一个半直接单目视觉惯性SLAM系统,即在上述系统基础上融合惯性测量数据 - SVL-VI (visual-inertial);

3. 既能保持直接法的快速性,又具有基于特征方法的高精度和闭环检测能力。

4. 给出了半直接SLAM系统具有竞争力的测试结果。

(36)<各种数据集>最强 SLAM Datasets 合辑

泡泡机器人:

https://mp.weixin.qq.com/s/zRjwus68Kf4unIqPIubraw

数据集介绍链接:

https://github.com/PaoPaoRobot/awesome-slam-datasets

(37)<标定>利用直线和平面对应关系自动标定相机与三维激光雷达之间的外参

标题:Automatic Extrinsic Calibration of a Camera and a 3D LiDAR using Line and Plane Correspondences

作者:Lipu Zhou, Zimo Li, and Michael Kaess

来源:2018 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS)

泡泡机器人:

https://mp.weixin.qq.com/s/xBBnqVFVbwJbB6VbKcpiNg

摘要:

本文中使用棋盘格标定板处理了相机与三维激光雷达之间的外参标定。与之前要求至少三个棋盘格标定板位置不同,我们的算法通过联合三维线和面对应关系将最少需要的棋盘格位置减少到1。

(38)港科大:利用四叉树加速的单目实时稠密建图

标题:Quadtree-Accelerated Real-Time Monocular Dense Mapping

作者:Kaixuan Wang, Wenchao Ding, and Shaojie Shen

来源:2018 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS)

泡泡机器人:

https://mp.weixin.qq.com/s/DcrsbapA0adX7GG7CSIU6g

摘要描述:

本文为机器人导航提出了一种新型的建图方式。使用一个移动的摄像头实时地估计高质量的稠密深度图并融合进3D重建中。

利用强度图片的四叉树结构,在多分辨率上估计深度图来减少计算负担。本文提出基于四叉树的像素选择和动态置信传播来加速建图过程:被选择的像素根据其在四叉树的水平,用其对应的计算资源来进行深度优化。

求解的深度估计被进一步插值并在时间上融合至全分辨率的深度图中,并使用基于截断的带符号距离函数(TSDF)融合至稠密三维地图。

开源地址:

https://github.com/HKUST-Aerial-Robotics/open_quadtree_mapping

(39)港科大:基于通用优化的多传感器全局位姿估计框架(vins-fusion)

标题:A General Optimization-based Framework for GlobalPose Estimation with Multiple Sensors

作者:Tong Qin, Shaozu Cao, Jie Pan, and Shaojie Shen

来源:arXiv 2019

泡泡机器人:

https://mp.weixin.qq.com/s/k80x1ucWueR6-UmFi1NoIg

开源地址:

https://github.com/HKUST-Aerial-Robotics/VINS-Fusion

**(40)OmniSLAM:多鱼眼相机的SLAM系统

文章:OmniSLAM: Omnidirectional Localization and Dense Mapping for Wide-baseline Multi-camera Systems

作者:Changhee Won, Hochang Seok , Zhaopeng Cui , Marc Pollefeys , and Jongwoo Lim

介绍链接:

https://mp.weixin.qq.com/s/cRcKeGyMwirKk8ai2odXUA

文章主要贡献:

主要贡献总结如下:

(i) 提出了一种轻量化和改进的网络鱼眼相机的深度估计。网络的精度、参数个数、运行时间等都比以前的版本有了很大的提高,使本系统更加实用。

(ii)通过将深度图集成到ROVO(鲁棒的视觉里程计)中,并增加回环闭合模块,构建了一个鲁棒的全向视觉SLAM系统。在具有挑战性的室内和大型室外环境中,估算的轨迹精度比以前的版本有所提高。

(iii)提出了一个完整的全方位定位和稠密地图系统,并在合成环境和真实的室内外环境中进行了大量的实验,结果表明我们的系统能够为各种场景生成重建良好的三维稠密地图

简评:作者利用轻量化模型进行深度估计,并将生成的深度图集成至ROVO中。

**(41)基于ORB-SLAM2可持续保存地图的扩展方案

文章:Persistent Map Saving for Visual Localization for Autonomous Vehicles: An ORB-SLAM 2 Extension

作者:Felix Nobis∗, Odysseas Papanikolaou, Johannes Betz and Markus Lienkamp

增加了地图保存和先验地图定位功能

工作介绍:

该工程是支持ROS的,定位模式时需要提供一个map文件,其中包含ORB SLAM类的对象:map、MapPoint、Keyframe和KeyframeDatabase,以及每个关键帧的DBoW2 BoWVector和FeatureVector。因此,我们创建了一个SaveMap方法,它在SLAM进程结束时将此信息保存在二进制文件中。对于连续运行时,用户可以通过设置文件指定是否加载地图文件。如果用户决定使用保存的地图,则在系统启动时调用LoadMap方法,该方法加载保存的地图和KeyframeDatabase,并将系统设置为定位模式。定位模式是自动完成的,用户无需在线手动更改系统模式。SaveMap和LoadMap方法都集成在ORB-SLAM 2的系统类中,该类处理所有主要功能。

开源地址:

https://github.com/TUMFTM/orbslam-map-saving-extension

(42)PVIO:基于先验平面约束的高效VIO

论文:

Jinyu Li, Bangbang Yang, Kai Huang, Guofeng Zhang, and Hujun Bao*. Robust and Efficient Visual-Inertial Odometry with Multi-plane Priors. PRCV 2019, LNCS 11859, pp. 283–295, 2019.

下载链接:

http://www.cad.zju.edu.cn/home/gfzhang/projects/prcv2019-planeVIO.pdf

简介:

https://mp.weixin.qq.com/s/mShX53WQzlFGNUti1jpjtg

代码仓库:

https://www.github.com/zju3dv/PVIO

摘要描述:

在人造环境中,通常都会有平面结构,如果这些平面信息能够被有效地利用起来,将有助于提升VIO的鲁棒性。为此,我们提出了一个基于多平面先验信息的高效鲁棒的轻量级VIO系统PVIO。在这个工作中,我们提出了一个新颖的视觉-惯性-平面PnP算法来实现快速的定位,同时基于重投影一致性来可靠地扩展平面,从而增强在深度高度不确定情况下的跟踪鲁棒性。此外,在滑动窗口优化模块中提出了一个无结构的平面距离约束项,以及相应的边缘化和滑窗策略,可以有效降低计算复杂度,同时保证良好的精度。EuRoC和TUM-VI两个数据集上的实验结果表明,PVIO在跟踪精度上跟现在的前沿VI-SLAM系统VINS-Mono相当,但只需要单线程运行,效率上具有明显的优势。

(43) ORB-SLAM2 / ORB-SLAM3 相关改进代码

介绍链接:

https://mp.weixin.qq.com/s/mRTNmQhJGFZvIgCQqYDC1g

本文总结了特征点法SLAM中目前效果最好的方法:ORB-SLAM2 / ORB-SLAM3 相关改进代码汇总,包括加速、多传感器融合、稠密建图、线特征、点线融合、导航、动态环境、多平台移植等。具体见下。

ORB-SLAM2 相关改进代码汇总:

论文发表于2017年的IEEE Transactions on Robotics,论文名称《ORB-SLAM2: an Open-Source SLAM System for Monocular, Stereo and RGB-D Cameras》

ORB-SLAM2 特点:

首个(2017年发布时)支持单目,双目和RGB-D相机的完整的开源SLAM方案,具有回环检测和重新定位的功能。

能够在CPU上进行实时工作,可以用于移动终端如 移动机器人、手机、无人机、汽车。

特征点法的巅峰之作,定位精度极高,可达厘米级。

能够实时计算出相机的位姿,并生成场景的稀疏三维重建地图。

代码非常整洁,包含很多实际应用中的技巧,非常实用。

支持仅定位模式,该模式适用于轻量级以及在地图已知情况下长期运行,此时不使用局部建图和回环检测的线程

PAPER,

CODE,

[超详细中文注释版]

(https://github.com/electech6/ORBSLAM2_detailed_comments)

改进方法

ORBSLAM2_with_pointcloud_map,

高翔实现的添加稠密点云地图

[ORB-SLAM2_RGBD_DENSE_MAP]

(https://github.com/tiantiandabaojian/ORB-SLAM2_RGBD_DENSE_MAP),在高翔基础上添加了稠密闭环地图

[ORB-YGZ-SLAM]

(https://github.com/gaoxiang12/ORB-YGZ-SLAM),

使用SVO中直接法来跟踪代替耗时的特征点提取匹配,在保持同样精度的情况下,是原始ORB-SLAM2速度的3倍

[YGZ-stereo-inertial SLAM]

(https://github.com/gaoxiang12/ygz-stereo-inertial),

双目VIO版本,加入了LK光流和滑动窗口BA优化

[VI-ORB] https://github.com/jingpang/LearnVIORB

京胖实现的VI-ORB-SLAM2

[Fisheye-ORB-SLAM]

(https://github.com/lsyads/fisheye-ORB-SLAM),添加了支持鱼眼

[Save and load orb-slam2 maps]

(https://github.com/AlejandroSilvestri/osmap),添加保存和导入地图功能

[ORB_SLAM2 with map load/save function]

(https://github.com/Jiankai-Sun/ORB_SLAM2_Enhanced),添加保存和导入地图功能

[Viewer for maps from ORB-SLAM2 Osmap]

(https://github.com/AlejandroSilvestri/Osmap-viewer),

添加了地图可视化

[Add line feature based ORB-SLAM2]

(https://github.com/atlas-jj/ORB_Line_SLAM),添加了线特征

[RGBD-SLAM with Point and Line Features, developed based on ORB_SLAM2]

(https://github.com/maxee1900/RGBD-PL-SLAM),添加了点线融合

[Good Feature Selection for Least Squares Pose Optimization in VO/VSLAM]

(https://github.com/ivalab/gf_orb_slam2),使用了一种更好的特征选择方法

ORB_SLAM2_SSD_Semantic,

动态语义SLAM 目标检测+VSLAM+光流/多视角几何动态物体检测+octomap地图+目标数据库

[Tracking Enhanced ORB-SLAM2]

(https://github.com/Eralien/TE-ORB_SLAM2),

用YOLO v3的语义信息来增加跟踪性能

YOLO Dynamic ORB_SLAM,用YOLO来做动态环境的检测

多平台移植代码

[Windows version ORBSLAM2,Easy built by visual studio]

(https://github.com/phdsky/ORBSLAM24Windows),

Windows平台版本,可以用 visual studio轻松编译

[ORB-SLAM-Android, test on Sony Xperia Z]

(https://github.com/castoryan/ORB-SLAM-Android),

Android移植,在 Sony Xperia上测试

[ORBSLAM2 on Mac OSX]

(https://github.com/meiroo/ORBSLAM2-OSX),Mac OSX版本

[ROS interface for ORBSLAM2]

(https://github.com/ethz-asl/orb_slam_2_ros),添加ROS接口

ORB-SLAM3 相关代码

ORB-SLAM3

2020年07月开源, 论文《ORB-SLAM3: An Accurate Open-Source Library for Visual, Visual-Inertial and Multi-Map SLAM》

ORB-SLAM3特点

支持视觉、视觉加惯导、混合地图的SLAM系统,可以在单目,双目和RGB-D相机上利用针孔或者鱼眼模型运行。

基于特征的紧耦合的VIO系统,仅依赖于最大后验估计(包括IMU初始化时)。因此不管是在大场景还是小场景,室内还是室外都能鲁棒实时的运行,精度上相比于上一版提升了2到5倍

根据新的重定位模块来构建的多地图系统,可以让系统在特征不是很好的场景中长期运行。

第一个能够在所有算法阶段重用所有先前信息的系统,可以在BA的时候使用相隔很远的共视关键帧。

https://arxiv.org/pdf/2007.11898.pdf

https://github.com/UZ-SLAMLab/ORB_SLAM3

ORB_SLAM3-RGBD-Inertial

增加了RGBD-IMU的运行模式和ROS接口,增加了单目IMU和双目IMU的ROS接口,替换了词典为二进制格式,加载速度更快。依据ORB_SLAM3重写了RGBD-IMU的ROS接口,避免出现队列拥塞,提供了Kinect for Azure的参数文件

https://github.com/xiefei2929/ORB_SLAM3-RGBD-Inertial

(44)用于室内环境下的多传感器融合slam数据集

http://www.rawseeds.org/rs/datasets/view//6

(45)SlamBench2:视觉SLAM的多目标头对头基准测试

摘要:

SLAM正在成为机器人和增强现实(AR)系统的关键组成部分。虽然大量的SLAM算法被提出,但是很少的努力花在统一这些算法的接口,或者对它们的能力进行整体比较上。这是一个问题,因为不同的SLAM应用程序可以有不同的功能和非功能需求。例如,基于手机的AR应用程序有着很紧的能耗预算,而无人机导航系统通常需要很高的精度。SlamBench2是一个基准框架,用于评估现有和未来的SLAM系统,包括开放源代码和封闭源代码,以及可扩展的数据集列表,同时使用可比较且明确指定的性能指标列表。支持现有的各种SLAM算法和数据集,例如ElasticFusion、InfiniTAM、ORB-SLAM2、OKVIS,并且整合新的算法和数据集是由框架直接而明确地指定的。SlamBench2是一个公开可用的软件框架,它代表了定量、可比较和可验证的实验研究的起点,以研究跨SLAM系统的权衡。

泡泡机器人链接

***(46)港科大——双目视觉深度估计及3D地图构建工作

关于如何判断vins-mon运行失败,轨迹已经漂移,可以参考港科大工作:

VINS-Fusion with Cerebro:

https://github.com/HKUST-Aerial-Robotics/VINS-kidnap

双目大视角鱼眼vins-fusion

开源工程:

https://github.com/xuhao1/VINS-Fisheye

知乎介绍:

https://zhuanlan.zhihu.com/p/105978076

文章中介绍了关于双目深度计算的部分以及开发过程,很有参考意义,并且代码中也将该部分独立了出来:

基于深度学习的双目深度计算:

HKUST-Aerial-Robotics——MVDepthNet

使用样例,港科大高飞使用vins-mono和MVDepthNet进行三维环境障碍物地图精细重建,开源地址:

https://github.com/HKUST-Aerial-Robotics/DenseSurfelMapping

更加详细的内容合并资源,港科大教学重复计划(无人驾驶飞机比赛):

https://github.com/HKUST-Aerial-Robotics/Teach-Repeat-Replan

很强大的无人机概率地图生成:

https://github.com/HKUST-Aerial-Robotics/Fast-Planner

该项目包含用于四旋翼快速飞行的强大且计算效率高的算法的集合:

运动学路径搜索

基于B样条的轨迹优化

拓扑路径搜索和路径引导优化

感知感知的计划策略(出现)

有用之处,改进的概率地图构建形式

所有计划算法以及其他关键模块(例如映射)均在fast_planner中实现:

plan_env:在线映射算法。它以深度图像(或点云)和相机姿态(测距)对作为输入,进行射线投射以更新概率体积图,并为规划系统构建欧几里德距离标记场(ESDF)。

path_searching:前端路径搜索算法。目前,它包括一个动力学动力学路径搜索,该搜索尊重了四旋翼的动力学。它还包含基于采样的拓扑路径搜索算法,以生成捕获3D环境结构的多个拓扑独特的路径。

bspline:基于B样条的轨迹表示的实现。

bspline_opt:使用B样条轨迹的基于梯度的轨迹优化。

active_perception:感知感知的计划策略,使四旋翼飞机能够主动观察并避免未知障碍,并在将来出现。

plan_manage:计划和调用映射和计划算法的高级模块。此处包含用于启动整个系统的接口以及配置文件。

除了文件夹fast_planner之外,还使用轻量级的uav_simulator进行测试。

周指导内嵌在Fast-Planner[13]内改进的hlx的FIESTA地图[14],使用现有数据做了一个demo,方块即为最后的障碍物。