狂神docker笔记

1. Docker概述

1.1 Docker为什么出现

-

一款产品,开发上线两套环境,配置

-

开发运维问题,我的电脑可以运行,版本更新导致服务不可用,对于运维来说考验比较大,docker可以做到开发即运维

-

环境配置麻烦,每个机器都要部署环境(如Redis ES Hadoop集群),不能跨平台

-

JRE — 多个应用(端口冲突)–原来都是交叉的

1.2 Docker作用

传统:开发jar,运维来做

现在:开发打包部署上线一套流程走完,发布一个项目(jar +(Redis MySQL jdk ES)),项目能够带上环境的安装打包

java – apk – 发布 (应用商店)— 张三使用apk — 安装即可用!

java — jar(环境) —- 打包项目带上环境(镜像) — (Docker仓库:商店)— 下载我们的镜像 — 直接运行即可

Docker思想来自于集装箱!

隔离:Docker的核心思想!打包装箱,每个箱子都是相互隔离的,通过隔离机制,可以将服务器利用到极致

1.3 Docker的历史

在容器技术出现之前,我们使用的都是虚拟机技术

虚拟机:在windows中装一个Vmware,通过这个软件我们可以虚拟一台或者多台电脑,比较笨重

虚拟机也是属于虚拟化技术,Docker容器技术,也是一种虚拟化技术!

vm: linux centos原生镜像(一个电脑)隔离:需要开启多个虚拟机 几个G

docker: 隔离,镜像(最核心的环境 4m+jdk+mysql)十分的小巧,运行镜像就可以了 几个M 秒级启动

1.4 Docker能干嘛

-

之前的虚拟机

- 资源占用很慢

- 冗余步骤多

- 启动很慢

-

容器化技术,不是一个完整的操作系统

-

容器内的应用直接运行在宿主机的内容,容器没有自己的内核,也没有虚拟我们的硬件,所以就轻便了

-

每个容器内相互隔离,每个容器内都有一个属于自己的文件系统,互不影响

-

-

DevOps(开发、运维)

-

应用快速的交付和部署

传统:一堆帮助文档,安装程序

Docker:打包镜像发布测试,一键运行

-

更便捷的升级和缩扩容

使用Docker之后,部署应用就像搭积木一样,项目打包为一个镜像,扩展服务器A 服务器B

-

更简单的系统运维

在容器化之后,我们的开发,测试环境都是高度一致的

-

更高效的计算资源应用

Docker是内核级的虚拟化,可以在一个物理机上运行很多个容器,服务器的性能可以被运用到极致

-

2. Docker安装

2.1 Docker的基本组成

镜像(image):

Docker镜像就好像是一个模板,可以通过这个模板来创建容器服务,tomcat镜像 = =>run= =>tomcat01容器(提供服务),通过这个镜像可以创建多个容器(服务或者项目就是运行在容器内)

容器(container):

Docker利用容器技术,独立运行一个或者一组应用,通过镜像来创建的

启动,停止,删除,基本命令

目前就可以把这个容器理解为简单的linux系统

仓库(repository):

仓库就是存放镜像的地方,分为私有仓库或者共有仓库Docker Hub,阿里云都有仓库(配置镜像加速)

2.2 安装Docker

-

购买阿里云或者本地装个linux虚拟机,这里以centos7为例

-

根据docker官方文档从零开始使用docker

Docker - Eric’s blog (gitee.io)

2.3 回顾HelloWorld流程

2.4 底层原理

Docker时怎么工作的?

Docker是一个Client-Server结构的系统,Docker的守护进程运行在主机上,通过Socket从客户端访问,DockerServer接受到Docker-Client的指令,就会执行这个指令

Docker为什么比VM块?

1、Docker有着比虚拟机更少的抽象层

2、docker利用的是宿主机的内核,vm需要的是Guest OS

所以说新建一个容器的时候,docker不需要像虚拟机一样去加载一个操作系统内核,避免引导,虚拟机是加载Guest OS,分钟级别的,而docker是利用宿主机的操作系统,省略了复杂的过程,是秒级的

3. Docker的常用命令

3.1 帮助命令

docker version # 显示docker的版本信息

docker info # 显示dockers的系统信息,包括镜像和容器的数量

docker 命令 --help # 帮助命令

3.2 镜像命令

docker images查看所有本地主机上的镜像

[root@localhost ~]# docker images

REPOSITORY TAG IMAGE ID CREATED SIZE

hello-world latest d1165f221234 8 weeks ago 13.3kB

#解释

REPOSITORY 镜像的仓库源

TAG 镜像的标签

IMAGE ID 镜像的id

CREATED 镜像的创建时间

SIZE 镜像的大小

# 可选项

--all , -a # 列出所有镜像

--quiet , -q # 只显示镜像的id

docker search搜索镜像

docker pull下载镜像

# 下载镜像 docker pull 镜像名[:tag]

[root@localhost ~]# docker pull mysql

Using default tag: latestn # 如果不写tag,默认是latest

latest: Pulling from library/mysql

f7ec5a41d630: Pull complete # 分层下载,docker image 的核心,联合文件系统

9444bb562699: Pull complete

6a4207b96940: Pull complete

181cefd361ce: Pull complete

8a2090759d8a: Pull complete

15f235e0d7ee: Pull complete

d870539cd9db: Pull complete

493aaa84617a: Pull complete

bfc0e534fc78: Pull complete

fae20d253f9d: Pull complete

9350664305b3: Pull complete

e47da95a5aab: Pull complete

Digest: sha256:04ee7141256e83797ea4a84a4d31b1f1bc10111c8d1bc1879d52729ccd19e20a # 签名

Status: Downloaded newer image for mysql:latest

docker.io/library/mysql:latest # 真实地址

# 等价于它

docker pull mysql

docker pull docker.io/library/mysql:latest

# 指定版本下载

[root@localhost ~]# docker pull mysql:5.7

5.7: Pulling from library/mysql

f7ec5a41d630: Already exists

9444bb562699: Already exists

6a4207b96940: Already exists

181cefd361ce: Already exists

8a2090759d8a: Already exists

15f235e0d7ee: Already exists

d870539cd9db: Already exists

cb7af63cbefa: Pull complete

151f1721bdbf: Pull complete

fcd19c3dd488: Pull complete

415af2aa5ddc: Pull complete

Digest: sha256:a655529fdfcbaf0ef28984d68a3e21778e061c886ff458b677391924f62fb457

Status: Downloaded newer image for mysql:5.7

docker.io/library/mysql:5.7

docker rmi删除镜像

[root@localhost ~]# docker rmi -f 87eca374c0ed # 删除指定的奖项

[root@localhost ~]# docker rmi -f 镜像id1 镜像id2 镜像id3 # 删除多个奖项

[root@localhost ~]# docker rmi -f $(docker images -aq) # 删除全部镜像

3.3 容器命令

说明:有了镜像才能创建容器,linux,下载一个centos镜像来测试学习

docker pull centos

新建容器再启动

docker run [可选参数] image

# 参数说明

--name="name" 容器名字 tomcat01 tomcat02 用来区分容器

-d 后台方式运行

-it 使用交互方式运行

-p 指定容器的端口 -p 8080:8080

-p ip:主机端口:容器端口

-p 主机端口:容器端口(常用)

-p 容器端口

容器端口

-P 随机指定端口

# 测试,启动并进入容器

[root@localhost ~]# docker run -it centos /bin/bash

[root@021e303bcf9c /]# ls # 查看容器内的centos基础版本,很多命令都是不完善的

bin dev etc home lib lib64 lost+found media mnt opt proc root run sbin srv sys tmp usr var

# 从容器中退回主机

[root@021e303bcf9c /]# exit

exit

[root@localhost ~]# ls

anaconda-ks.cfg initial-setup-ks.cfg 公共 模板 视频 图片 文档 下载 音乐 桌面

列出所有运行的容器

# docker ps 命令

# 列出当前正在运行的容器

-a # 当前正在运行的容器+历史运行过的容器

-n=? # 显示最近创建的容器

-q # 只显示容器的编号

[root@localhost ~]# docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

[root@localhost ~]# docker ps -a

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

021e303bcf9c centos "/bin/bash" 19 hours ago Exited (0) 19 hours ago zealous_lamport

22670b1c561e d1165f221234 "/hello" 20 hours ago Exited (0) 20 hours ago magical_euclid

退出容器

exit # 直接容器停止并退出

Ctrl + P + Q # 容器不停止退出

删除容器

docker rm 容器id #删除指定容器,不能删除正在运行的容器

docker rm -f $(docker ps -aq) # 删除所有容器

docker ps -a -q|xargs docker rm # 删除所有容器

启动和停止容器的操作

docker start 容器id # 启动容器

docker restart 容器id # 重启容器

docker stop 容器id # 停止当前正在运行的容器

docker kill 容器id # 强制停止当前容器

3.4 常用其他命令

后台启动容器

# 命令 docker run -d 镜像名

[root@localhost ~]# docker run -d centos

# 问题是docker ps停止了centos

# 常见的坑:docker容器使用后台运行就必须要有一个前台进程,容器发现没有应用,就会自动停止

# nginx,容器启动后,发现自己没有提供服务,就会立刻停止,就是没有程序了

查看日志

docker logs -f -t --tail 容器id

# 自己编写一段shell脚本

[root@localhost ~]# docker run -d centos /bin/sh -c "while true;do echo eric;sleep 1;done"

[root@localhost ~]# docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

4f95779df41b centos "/bin/sh -c 'while t…" 3 seconds ago Up 3 seconds nostalgic_edison

# 显示日志

-tf # 显示日志

--tail [number] # 要显示的日志条数

[root@localhost ~]# docker logs -f -t --tail 10 4f95779df41b

查看容器中的进程信息ps

# 命令 docker top 容器id

[root@localhost ~]# docker top 4f95779df41b

UID PID PPID C STIME TTY TIME CMD

root 10225 10205 0 18:30 ? 00:00:00 /bin/sh -c while true;do echo eric;sleep 1;done

root 10607 10225 0 18:34 ? 00:00:00 /usr/bin/coreutils --coreutils-prog-shebang=sleep /usr/bin/sleep 1

查看镜像元数据

# 命令 docker inspect 容器id

[root@localhost ~]# docker inspect 4f95779df41b

进入当前正在运行的容器

# 我们通常容器都是在后台运行,需要进入容器,修改一些配置

# 命令

docker exec -it 容器id bashshell

[root@localhost ~]# docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

4f95779df41b centos "/bin/sh -c 'while t…" 10 minutes ago Up 10 minutes nostalgic_edison

[root@localhost ~]# docker exec -it 4f95779df41b /bin/bash

[root@4f95779df41b /]# ls

bin dev etc home lib lib64 lost+found media mnt opt proc root run sbin srv sys tmp usr var

# 方式二

dcoker attach 容器id

# 测试

[root@localhost ~]# docker attach dce7bshk8oou7

正在执行当前的代码...

docker exec #进入容器后开启一个新的终端

docker attach # 进入容器正在执行的终端,不会启动新的进程

从容器内拷贝文件到主机上

docker cp 容器id:容器内路径 目的主机路径

# 查看当前主机目录下

[root@localhost home]# ls

eric

[root@localhost home]# touch eric.java

[root@localhost home]# ls

eric eric.java

[root@localhost home]# docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

2ae552528a84 centos "/bin/bash" About a minute ago Up About a minute sleepy_kowalevski

# 进入docker容器内部

[root@localhost home]# docker attach 2ae552528a84

[root@2ae552528a84 /]# cd /home

[root@2ae552528a84 home]# ls

# 在容器内部进行创建文件

[root@2ae552528a84 home]# touch test.java

[root@2ae552528a84 home]# exit

exit

[root@localhost home]# docker ps -a

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

2ae552528a84 centos "/bin/bash" 3 minutes ago Exited (0) 6 seconds ago sleepy_kowalevski

# 见文件拷贝出来到主机上

[root@localhost home]# docker cp 2ae552528a84:/home/test.java /home

[root@localhost home]# ls

eric eric.java test.java

# 拷贝是一个手动过程,未来我们可以使用-v卷的技术,可以实现自动同步 /home /home

3.5 小结

3.6 安装

- 安装nginx

# 1、搜索镜像

[root@localhost home]# docker search nginx

# 2、拉取镜像

[root@localhost home]# docker pull nginx

# 3、查看镜像

[root@localhost home]# docker images

REPOSITORY TAG IMAGE ID CREATED SIZE

nginx latest 62d49f9bab67 3 weeks ago 133MB

centos latest 300e315adb2f 4 months ago 209MB

# 4、启动运行

[root@localhost home]# docker run -d --name nginx01 -p 3344:80 nginx

66f84ea1a1679cc5f062e4c7aab26f051d30df710e23e7685597257933eb7d61

# 5、查看运行情况

[root@localhost home]# docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

66f84ea1a167 nginx "/docker-entrypoint.…" 31 seconds ago Up 29 seconds 0.0.0.0:3344->80/tcp, :::3344->80/tcp nginx01

# -d 后台运行

# --name 给容器起名字

# -p 宿主机端口:容器内部端口

# 6、本机自测运行情况

[root@localhost home]# curl localhost:3344

Welcome to nginx!

Welcome to nginx!

If you see this page, the nginx web server is successfully installed and

working. Further configuration is required.

For online documentation and support please refer to

nginx.org.

Commercial support is available at

nginx.com.

Thank you for using nginx.

# 7、进入容器,修改配置

[root@localhost home]# docker exec -it nginx01 /bin/bash

root@66f84ea1a167:/# whereis nginx

nginx: /usr/sbin/nginx /usr/lib/nginx /etc/nginx /usr/share/nginx

root@66f84ea1a167:/# cd /etc/nginx

root@66f84ea1a167:/etc/nginx# ls

conf.d fastcgi_params koi-utf koi-win mime.types modules nginx.conf scgi_params uwsgi_params win-utf

root@66f84ea1a167:/etc/nginx#

端口暴露的概念

思考问题:我们每次都需要改动nginx配置,都需要进入容器内部?十分的麻烦,我们要是可以在容器外部提供一个映射路径,达到可以在容器外部修改文件名,容器内部就可以进行自动修改?-数据卷

- 使用docker安装一个tomcat

# 官方使用

docker run -it --rm tomcat:9.0

# 我们之前的启动都是后台,停止了容器之后,容器还是可以查到 docker run -it --rm一般用来测试,用完就删除

# 下载再启动

docker pull tomcat

# 启动运行

[root@localhost home]# docker run -d -p 3355:8080 --name tomcat01 tomcat

# 访问测试没有问题

# 进入容器

[root@localhost ~]# docker exec -it tomcat01 /bin/bash

# 发现问题:1、Linux命令少量 2、webapps无内容 阿里云镜像的原因,默认是最小的镜像,所有不必要的都剔除掉,保证最小可运行的环境

思考问题:如果每次部署都要进入容器是不是非常麻烦?我们要是可以在容器外部提供一个映射路径,webapps,我们在外部防止项目,就自动同步到内部就好了

4. Docker镜像讲解

4.1 镜像是什么

镜像是一种轻量级、可执行的独立软件包,用来打包软件运行环境和基于运行环境开发的软件,它包含运行某个软件所需的所有内容,包括代码、运行时、库、环境变量和配置文件。

所有的应用,直接打包docker镜像,就可以直接跑起来

如何得到镜像:

- 从远处仓库下载

- 朋友拷贝给你

- 自己制作一个镜像DockerFile

4.2 Docker镜像加载原理

-

UnionFS(联合文件系统)

UnionFS(联合文件系统):Union文件系统(UnionFS)是一种分层、轻量级并且高性能的文件系统,它支持对文件系统的修改作为一次提交来一层层的叠加,同时可以将不同目录挂载到同一个虚拟文件系统下(unite several directories into a single virtual filesystem)。Union 文件系统是 Docker 镜像的基础。镜像可以通过分层来进行继承,基于基础镜像(没有父镜像),可以制作各种具体的应用镜像。

特性:一次同时加载多个文件系统,但从外面看起来,只能看到一个文件系统,联合加载会把各层文件系统叠加起来,这样最终的文件系统会包含所有底层的文件和目录。

-

镜像加载原理

bootfs(boot file system)主要包含bootloader和kernel, bootloader主要是引导加载kernel, Linux刚启动时会加载bootfs文件系统,在Docker镜像的最底层是bootfs。这一层与我们典型的Linux/Unix系统是一样的,包含boot加载器和内核。当boot加载完成之后整个内核就都在内存中了,此时内存的使用权已由bootfs转交给内核,此时系统也会卸载bootfs。

rootfs (root file system),在bootfs之上。包含的就是典型 Linux 系统中的 /dev,/proc,/bin,/etc 等标准目录和文件。rootfs就是各种不同的操作系统发行版,比如Ubuntu,Centos等等。

平时我们安装虚拟机的centos都是好几个G,为什么Docker这里才200M?

对于一个精简的OS,rootfs 可以很小,只需要包含最基本的命令,工具和程序库就可以了,因为底层直接用Host的kernel,自己只需要提供rootfs就可以了。由此可见对于不同的linux发行版, bootfs基本是一致的,rootfs会有差别,因此不同的发行版可以公用bootfs。

虚拟机是分钟级别的,容器是秒级别的。

4.3 分层的镜像

我们去下载一个镜像,注意观察下载的日志输出,可以看到是一层一层的在下载!

思考:为什么要采用这种分层的结构呢?

最大的好处,我觉得莫过于是资源共享了,比如有多个镜像都从相同的Base镜像构建而来,那么宿主机只需要在磁盘上保留一份base镜像,同时内存中只需要加载一份base镜像,这样就可以为多有的容器服务了,而且每一层都可以被共享

查看镜像分层的方式可以通过docker image inspect 命令

[root@localhost ~]# docker image inspect redis:latest

"RootFS": {

"Type": "layers",

"Layers": [

"sha256:7e718b9c0c8c2e6420fe9c4d1d551088e314fe923dce4b2caf75891d82fb227d",

"sha256:89ce1a07a7e4574d724ea605b4877f8a73542cf6abd3c8cbbd2668d911fa5353",

"sha256:9eef6e3cc2937e452b2325b227ca28120a70481be25404ed9aad27fa81219fd0",

"sha256:ee748697d275b904f1d5604345d70b647a8c145b9f05aeb5ca667e1f256e43d8",

"sha256:f1f7964d40afa49c6ef63ab11af91044e518a2539f567783ce997d3cea9ce8f6",

"sha256:3d9fda8ff875e549d54e9d7504ce17d27423fe27dafbb92127c603dddad7fa13"

]

},

理解:

所有的 Docker|镜像都起始于一个基础镜像层,当进行修改或增加新的内容时,就会在当前镜像层之上,创建新的镜像层。

举一个简单的例子,假如基于 Ubuntu Linux 16.04 创建一个新的镜像,这就是新镜像的第一层;如果在该镜像中添加 Python包,就会在基础镜像层之上创建第二个镜像层;如果继续添加一个安全补丁,就会创建第三个镜像层。

该镜像当前已经包含 3 个镜像层,如下图所示(这只是一个用于演示的很简单的例子)。

在添加额外的镜像层的同时,镜像始终是保持当前所有镜像的组合,理解这一点是非常重要的。下图拒了一个简单的例子,每个镜像包含三个文件,而镜像包含了来自两个镜像层的6个文件。

上图中的镜像层和之前的图中略有区别,主要目的是便于展示文件

下图中展示了一个稍微复杂的三层镜像,在外部看来整个镜像只有6个文件,这是因为最上层的文件7是文件5的一个更新版

这种情况下,上层镜像层中的文件覆盖了底层镜像层中的文件。这样就使得文件的更新版本作为一个新镜像层添加到镜像当中。 Docker 通过存储引擎(新版本采用快照机制)的方式来实现镜像层堆栈,并保证多镜像层对外展示为统一的文件系統。 Linux 上可用的存储引擎有 AUFS、Overlay2、Device Mapper、Btrfs 以及 ZFS。顾名思义,每种存储引擎都基于 Linux 中对应的文件系统或者块设备技术,并且每种存储引擎都有其独有的性能特点。

Docker 在 Windows 上仅支持 windowsfiter一种存储引擎,该引擎基于 NTFS 文件系统之上实现了分层和 CoW[1]。

下图展示了与系统显示相同的三层镜像。所有镜像层堆叠并合井,对外提供统一的视图。

特点

Docker镜像都是只读的,当容器启动时,一个新的可写层被加载到镜像顶部!

这一层就是我们通常说的容器层,容器之下的都叫镜像层

4.4 commit镜像

docker commit 提交容器成为一个新的副本# 命令和git原理类似docker commit -m="提交的描述信息" -a="作者" 容器id 目标镜像名:[tag]

实战测试

# 启动一个默认的tomcat# 发现这个默认的tomcat是没有webapps应用的,镜像的原因:官方镜像默认webapps下面没有文件的!# 我自己拷贝进去了基本的文件# 将我们自己操作过后的容器通过commit提交为一个镜像,我们以后就可以使用自己修改过的镜像,这就是我们自己的一个修改过的镜像[root@localhost ~]# docker commit -a="eric" -m="add webapps application" 6f4fd55369bb tomcat02:1.0sha256:a3eec2c2487fdc97ca6adeecb21d5e02e7ba7501a561256528ba7efb9021d228# 查看修改过后的镜像

如果你想要保存当前的状态,就通过commit提交,获得一个镜像,就好比我们以前学习VM时候,快照

5. 容器数据卷

5.1 什么是容器数据卷

将应用环境打包成一个镜像!

数据?如果数据都在容器中,那么我们容器删除,数据就会丢失!需求:数据可以持久化

MySQL,容器删除了,删库跑路!需求:MySQL的数据可以存储在本地

容器之间可以有一个数据共享的技术!docker容器中产生的数据,同步到本地

这就是卷技术,目录的挂载,将容器内的目录挂载在Linux上面

总结一句话:容器的持久化和同步操作,容器间也是可以数据共享的

5.2 使用命令来挂载

docker run -it -v 主机目录:容器的目录

# 测试

[root@localhost home]# docker run -it -v /home/ceshi:/home centos /bin/bash

# 容器启动的时候我们可以通过docker inspect 容器id

测试文件的同步

再来测试

1.停止容器

2、宿主机上修改文件

3、启动容器

4、容器内的数据依旧是同步的

好处:我们以后修改只需要在本地进行修改即可,容器内部会自动进行同步!

实战:安装MySQL

# 获取镜像[root@localhost ~]# docker pull mysql:5.7# 运行容器,需要做数据挂载,安装MySQL需要配置密码,下面是官方命令# docker run --name some-mysql -e MYSQL_ROOT_PASSWORD=my-secret-pw -d mysql:tag# 启动我们的-d 后台运行-p 端口映射-v 数据卷挂载-e 环境配置--name 容器名字[root@localhost ~]# docker run -d -p 3310:3306 -v /home/mysql/conf:/etc/mysql/conf.d -v /home/mysql/data:/var/lib/mysql -e MYSQL_ROOT_PASSWORD=338218 --name mysql01 mysql:5.7# 在启动成功后,我们在本地使用sqlyog来测试连接一下# sqlyog--连接到服务器3310---3310和容器内部的3306进行映射,这个时候我们就可以连接上了# 在本地测试新建一个数据库,查看一下我们映射的路径是否ok

删除容器,挂在在本地的数据卷依旧没有丢失,这就是容器的持久化功能

5.3 具名和匿名挂载

# 匿名挂载,注意这里使用-P表示的指定随机的端口号,没有指定主机的位置信息-v 容器内路径docker run -d -P --name nginx01 -v /etc/nginx nginx# 查看所有卷的情况[root@localhost ~]# docker volume lslocal 1d0b3ba7045ef37ab30b087687b36325c1941d2178961c23d511a89f38d757aa# 这里发现,这种就是匿名挂载,我们在-v只写了容器内的路径,没有写容器外的路径# 具名挂载[root@localhost ~]# docker run -d -P --name nginx02 -v juming-nginx:/etc/nginx nginx8571cb0d59725be9ab6f9efabcfd2a9d709ff99ceee59348494f567872829a67[root@localhost ~]# docker volume lsDRIVER VOLUME NAMElocal 1d0b3ba7045ef37ab30b087687b36325c1941d2178961c23d511a89f38d757aalocal 455e0591eae1c3969b1b8bf82da94c821a8e94c156650b328bf0720498f2dee6local juming-nginx# 通过 -v 卷名:容器内路径# 查看一下这个卷

所有的docker容器内的卷,在没有指定目录的情况下都是在/var/lib/docker/volumes/xxx/_data

我们通过具名挂载可以方便找到我们的一个卷,大多数情况下都是使用具名挂载

# 如何确定是匿名挂载还是具名挂载,还是指定路径挂载

-v 容器内路径 # 匿名挂载

-v 卷名:容器内路径 # 具名挂载

-v 宿主机路径:容器内路径 # 指定路径挂载

拓展:

# 通过 -v 容器内路径:ro rw 改变读写权限

ro readonly # 只读

rw readwrite # 可读可写

# 一旦设置了这个容器权限,容器对我们挂载出来的内容就有了限定了

docker run -d -P --name nginx02 -v juming-nginx:/etc/nginx:ro nginx

docker run -d -P --name nginx02 -v juming-nginx:/etc/nginx:rw nginx

# ro 只要看到ro就说明这个路径只能通过宿主机来操作,容器内部是无法进行操作的

5.4 初识DockerFile

DockerFile就是用来构建docker镜像的构建文件,命令脚本,先体验一下

通过这个脚本可以生成一个镜像,镜像是一层层的,所以脚本是一个个的命令

# 创建一个dockerfile文件,名字可以随机,建议Dockerfile# 文件中的内容 指令(大写) 参数FROM centosVOLUME ["volume01","volume02"]CMD echo "---end---"CMD /bin/bash# 这里的每个命令就是镜像的一层

启动一下自己写的容器

这个卷和外部一定有一个同步的目录

查看一下卷挂载的路径

[root@localhost data]# docker inspect fca535846c94

测试一下文件是否已经被同步出去了

这种方式未来的使用非常多,因为我们自己通常会构建自己的镜像

假设构建镜像的时候没有挂载,需要自己手动挂载镜像 -v 卷名:容器内路径

5.5 数据卷容器

多个MySQL同步数据

启动3个容器,通过我们刚在自己写的镜像启动

docker01的数据同步到了docker02

# 测试 :可以删除容器dcoker01,查看docker02和docker03时候还可以访问这个文件

# 测试结果是依然可以访问到

多个MySQL实现数据共享

docker run -d -p 3310:3306 -v /etc/mysql/conf.d -v /var/lib/mysql -e MYSQL_ROOT_PASSWORD=338218 --name mysql01 mysql:5.7docker run -d -p 3311:3306 -e MYSQL_ROOT_PASSWORD=338218 --name mysql02 --volumes-from mysql01 mysql:5.7# 这个时候可以实现两个容器数据同步

结论:

容器之间配置信息的传递,数据卷容器的生命周期这一直持续到没有容器使用为止

但是一旦持久化到了本地,这个时候,本地的数据不会被删除

6. DockerFile

6.1 DockerFile介绍

dockerfile是用来构建docker镜像的文件,命令参数脚本

构建步骤:

1、编写一个dockerfile文件

2、docker build构建为一个镜像

3、docker run 运行镜像

4、docker push发布镜像(DockerHub、阿里云镜像仓库)

查看一下官方是怎么做的

很多官方的镜像都是基础包,很多功能都没有,我们通常会自己搭建自己的镜像

官方可以制作镜像,那我们也可以

6.2 DockerFile镜像的构建

基础知识:

1、每个保留关键字(指令)都是必须是大写字母

2、执行从上到下顺序执行

3、#表示注释

4、每一个指令都会创建提交一个新的镜像层,并提交

dockerfile是面向开发的,我们以后要发布项目,做镜像,就需要编写dockerfile文件,这个文件十分简单!

Docker镜像逐渐成为了企业交付的标准,必须要掌握

步骤:开发,部署,运维…缺一不可

DockerFile:构建文件,定义了一切的步骤,源代码

DockerImages:通过DockerFile构建生成的镜像,最终发布和运行的产品

Docker容器:容器就是镜像运行起来提供服务的

6.3 Docker指令

FROM # 基础镜像,一切从这里开始

MAINTAINER # 镜像是谁写的,姓名+邮箱

RUN # 镜像构建的时候需要运行的命令

ADD # 步骤:tomcat镜像,这个tomcat压缩包,添加内容

WORKDIR # 镜像的工作目录

VOLUME #挂载的目录

EXPOSE # 暴露端口配置

CMD # 指定容器运行时的shell命令,只有最后一个生效,可被替代

ENTRYPOINT # 指定容器运行时的shell命令,可以追加命令

ONBUILD # 当构建一个被继承DockerFile这个还是会就会运行ONBUILD的指令,触发指令

COPY # 类似ADD,将我们文件拷贝到镜像中

ENV # 构建的时候设置环境变量

6.4 实战训练

Docker Hub中99%的镜像都是从这个基础镜像过来的FROM scratch,然后配置需要的软件和配置来进行构建的

创建一个自己的centos

# 1、编写Dockerfile文件[root@localhost dockerfile]# cat mydockerfile-centos FROM centosMAINTAINER ericENV MYPATH /usr/localWORKDIR $MYPATHRUN yum -y install vimRUN yum -y install net-toolsEXPOSE 80CMD echo $MYPATHCMD echo "----end----"CMD /bin/bash# 2、通过这个文件构建镜像# 命令 docker build -f dockerfile文件路径 -t 镜像名:[tag]Successfully built dc4556607d09Successfully tagged mycentos:0.1# 3、测试运行

对比:之前原生的centos

我们增加之后的镜像

我们可以列出本地镜像的变更历史:docker history 镜像id

[root@localhost ~]# docker history dc4556607d09

6.5 用实战看CMD和ENTRYPOINT的区别

CMD和ENTRYPOINT的区别

通过测试可以看出:

1、CMD和ENTRYPOINT都可以执行其中的命令

2、如果在运行的时候追加命令,CMD会报错,而ENTRYPOINT会将追加的命令拼接在其文件中的命令之后,并且会正常运行

6.6 实战Tomcat镜像

1、准备镜像文件,tomcat

2、编写dockerfile文件,文件命名为Dockerfile,就不需要-f去指定了,build会自动寻找这个文件

FROM centos

MAINTAINER chenzhijian<[email protected]>

COPY readme.txt /usr/local/readme.txt

ADD jdk-8u151-linux-x64.tar.gz /usr/local/

ADD apache-tomcat-9.0.45.tar.gz /usr/local/

RUN yum -y install vim

ENV MYPATH /usr/local

WORKDIR $MYPATH

ENV JAVA_HOME /usr/local/jdk1.8.0_151

ENV CLASSPATH $JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar

ENV CATALINA_HOME /usr/local/apache-tomcat-9.0.45

ENV CATALINA_BASH /usr/local/apache-tomcat-9.0.45

ENV PATH $PATH:$JAVA_HOME/bin:$CATALINA_HOME/lib:$CATALINA_HOME/bin

EXPOSE 8080

CMD /usr/local/apache-tomcat-9.0.45/bin/startup.sh && tail -F /usr/local/apache-tomcat-9.0.45/bin/logs/catalina.out

3、构建镜像

[root@localhost tomcat]# docker build -t diytomcat .

4、启动镜像

[root@localhost tomcat]# docker run -d -p 9090:8080 --name erictomcat -v /home/eric/build/tomcat/test:/usr/local/apache-tomcat-9.0.45/webapps/test -v /home/eric/build/tomcat/tomcatlogs/:/usr/local/apache-tomcat-9.0.45/logs diytomcat

# 解释,第一个挂载是将webapps下的test映射到本地tomcat下的test

-v /home/eric/build/tomcat/test:/usr/local/apache-tomcat-9.0.45/webapps/test

# 解释,第二个挂载是将apache-tomcat-9.0.45下的日志映射到本地tomcat下的tomcatlogs

-v /home/eric/build/tomcat/tomcatlogs/:/usr/local/apache-tomcat-9.0.45/logs

5、访问测试

访问http://192.168.58.129:9090,可以看到成功的界面

6、发布项目(由于做了卷挂载,我们直接在本地编写项目就可以发布了)

在本地tomcat/test文件夹下创建WEB-INF文件夹,在WEB-INF下编写web.xml文,在/test 下编写index.jsp文件,再访问http://192.168.58.129:9090/test/

<%@ page language="java" contentType="text/html; charset=UTF-8"

pageEncoding="UTF-8"%>

<%@ page import="java.io.*,java.util.*, javax.servlet.*" %>

hello,eric

显示当前时间与日期

<%

Date date = new Date();

out.print( "" +date.toString()+"

");

%>

可以看到成功访问的页面

我们以后的开发步骤:需要掌握Dockerfile的编写,我们之后的一切都是使用docker镜像来发布运行!

6.7 发布自己的镜像

Docker Hub

1、地址https://hub.docker.com/

2、注册账号,确定这个账号可以登录

3、登录服务器

# 使用docker login -u [用户名],然后输入密码就可以登录成功[root@localhost tomcat]# docker login -u ericbooneyPassword: WARNING! Your password will be stored unencrypted in /root/.docker/config.json.Configure a credential helper to remove this warning. Seehttps://docs.docker.com/engine/reference/commandline/login/#credentials-storeLogin Succeeded

4、登录完毕后就可以提交上去镜像,就是一步 docker push

# 这里提交出现了错误,因为需要在diytomcat前面加上自己docker hub的username[root@localhost tomcat]# docker push diytomcatUsing default tag: latestThe push refers to repository [docker.io/library/diytomcat]a8724fc7877e: Preparing 39a8a3af5dab: Preparing b0a26c702c9b: Preparing 7560bca74509: Preparing 2653d992f4ef: Preparing denied: requested access to the resource is denied

一定要修改diytomcat的镜像名字为ericbooney/diytomcat,所以为了避免出现错误,在build的时候就要在名称前面加上自己docker hub的用户名

# 修改diytomcat为ericbooney/diytomcat:1.0,也尽量带上版本号[root@localhost tomcat]# docker tag diytomcat ericbooney/diytomcat:1.0

# 再次进行提交,可以看到成功提交[root@localhost tomcat]# docker push ericbooney/diytomcat:1.0Using default tag: latestThe push refers to repository [docker.io/ericbooney/diytomcat]a8724fc7877e: Pushed 39a8a3af5dab: Pushed b0a26c702c9b: Pushing [==================================> ] 277.3MB/406.7MB7560bca74509: Pushed 2653d992f4ef: Pushed

阿里云参照上面的文档

小结

7. Docker网络

7.1 理解网络

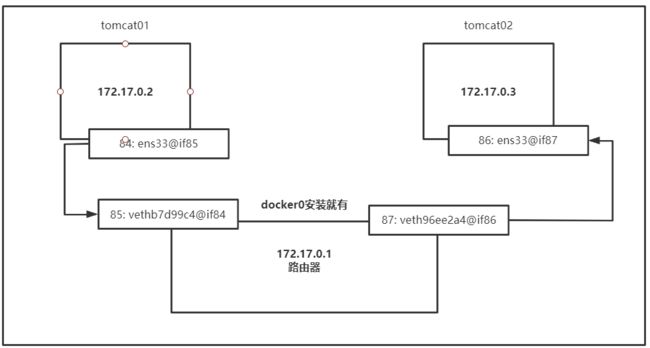

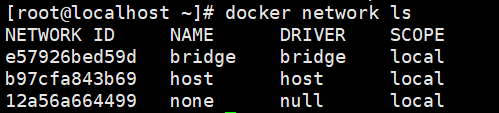

三个网络

问题:docker是如何处理容器网络访问的?

[root@localhost ~]# docker run -d -P --name tomcat01 tomcat

# 查看容器的内部网络地址 ip addr,发现容器启动的是否会得到一个eth0@if85 ip地址,docker分配

[root@localhost ~]# docker exec -it tomcat01 ip addr

1: lo: mtu 65536 qdisc noqueue state UNKNOWN group default qlen 1000

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

84: eth0@if85: mtu 1500 qdisc noqueue state UP group default

link/ether 02:42:ac:11:00:02 brd ff:ff:ff:ff:ff:ff link-netnsid 0

inet 172.17.0.2/16 brd 172.17.255.255 scope global eth0

valid_lft forever preferred_lft forever

# 思考Linux能不能ping通容器内部

[root@localhost ~]# ping 172.17.0.2

PING 172.17.0.2 (172.17.0.2) 56(84) bytes of data.

64 bytes from 172.17.0.2: icmp_seq=1 ttl=64 time=0.395 ms

64 bytes from 172.17.0.2: icmp_seq=2 ttl=64 time=0.149 ms

# Linux可以ping通docker容器内部

原理

1、我们每启动一个docker容器,docker就会给docker容器分配一个ip,我们只要安装了docker,就会有一个网卡docker0桥接模式,使用的技术是evth-pair技术

再次测试ip addr,多了一对网卡

2、再启动一个容器测试,发现又多了一对网卡

# 我们发现这些网卡都是一对对的

# veth-pair 就是一对的虚拟设备接口,它们都是成对出现的,一段连着协议,一段彼此相连

# 正因为有这个特性veth-pair充当一个桥梁,连接各种虚拟网络设备

# OpenStack,Docker容器之间的连接,OVS的连接,都是使用veth-pair技术

结论:tomcat01和tomcat02是共用的一个路由器,docker0

所有的容器在不指定网络的情况下,都是由docker0路由的,docker会给我们的容器分配一个默认的可用ip

小结

Docker使用的是Linux桥接,宿主机中是一个Docker容器的网桥 docker0

Docker中所有的网络接口都是虚拟的,虚拟的转发效率比较高(内网传递文件)

只要容器删除,对应的网桥就没了

7.2 --link

思考一个场景,我们编写了一个微服务,database url=ip:,项目不重启,数据库ip换掉了,我们希望可以处理这个问题,可以通过名字来访问容器?

# 如何去解决这个问题# 通过--link就可以解决问题了[root@localhost ~]# docker run -d -P --name tomcat03 --link tomcat02 tomcata8ba2a00467a9ff82520bd381973609e6a6ee64a99c1d82734d17c32693913c3[root@localhost ~]# docker exec -it tomcat03 ping tomcat02PING tomcat02 (172.17.0.3) 56(84) bytes of data.64 bytes from tomcat02 (172.17.0.3): icmp_seq=1 ttl=64 time=0.260 ms64 bytes from tomcat02 (172.17.0.3): icmp_seq=2 ttl=64 time=0.131 ms64 bytes from tomcat02 (172.17.0.3): icmp_seq=3 ttl=64 time=0.212 ms# 反向的连接可以ping通吗,不可以[root@localhost ~]# docker exec -it tomcat02 ping tomcat03ping: tomcat03: Name or service not known

其实这个tomcat03就是本地配置了tomcat02的配置

本质探究:–link就是我们在hosts配置中增加了一个172.17.0.3 tomcat02 9f6a048802b9

我们现在 玩Docker已经不建议使用–link了!

自定义网络!不适用于docker0!

dcoker0问题:他不支持容器名连接访问!

7.3 自定义网络

查看所有的docker网络

docker network ls

网络模式

bridge:桥接 docker(默认,自己创建的也是使用bridge模式)

none:不配置网络

host:和宿主机共享网络

container:容器内网络连通!(用的少!局限很大)

测试

# 我们直接启动的命令 --net bridge 而这个就是我们的docker0

docker run -d -P --name tomcat01 tomcat

docker run -d -P --name tomcat01 --net bridge tomcat

# docker0特点:默认,域名不能访问,--link可以打通连接

# 我么可以自定义一个网络

# --driver bridge

# --subnet 192.168.0.0/16 192.168.0.2 192.168.255.255

# --gateway 192.168.0.1

[root@localhost ~]# docker network create --driver bridge --subnet 192.168.0.0/16 --gateway 192.168.0.1 mynet

7637416b83c39b59e8af8e5b79f95f55b2cf3700017a547c3b5f2596fa637fd2

[root@localhost ~]# docker network ls

NETWORK ID NAME DRIVER SCOPE

e57926bed59d bridge bridge local

b97cfa843b69 host host local

7637416b83c3 mynet bridge local

12a56a664499 none null local

我们自己的网络就创建好了

[root@localhost ~]# docker run -d -P --name tomcat-net-01 --net mynet tomcat

959374947ce0f666073cd160b0ed3f727c72f24f907754c62d377d66d48b885d

[root@localhost ~]# docker run -d -P --name tomcat-net-02 --net mynet tomcat

7b6b415d88222daf44c8542121cd7256e398fb4dd2880c74a8d4db0077245a8b

[root@localhost ~]# docker network inspect mynet

[

{

"Name": "mynet",

"Id": "7637416b83c39b59e8af8e5b79f95f55b2cf3700017a547c3b5f2596fa637fd2",

"Created": "2021-05-08T21:49:56.658124832+08:00",

"Scope": "local",

"Driver": "bridge",

"EnableIPv6": false,

"IPAM": {

"Driver": "default",

"Options": {},

"Config": [

{

"Subnet": "192.168.0.0/16",

"Gateway": "192.168.0.1"

}

]

},

"Internal": false,

"Attachable": false,

"Ingress": false,

"ConfigFrom": {

"Network": ""

},

"ConfigOnly": false,

"Containers": {

"7b6b415d88222daf44c8542121cd7256e398fb4dd2880c74a8d4db0077245a8b": {

"Name": "tomcat-net-02",

"EndpointID": "9c8a2979e3c1b9914fde4502298ec3aa35bd004a178d695222629fc613f482df",

"MacAddress": "02:42:c0:a8:00:03",

"IPv4Address": "192.168.0.3/16",

"IPv6Address": ""

},

"959374947ce0f666073cd160b0ed3f727c72f24f907754c62d377d66d48b885d": {

"Name": "tomcat-net-01",

"EndpointID": "b98aee7d07ecaea623dad5318076b32dd67bbb7a4eafa35e6d1e9605ab71f661",

"MacAddress": "02:42:c0:a8:00:02",

"IPv4Address": "192.168.0.2/16",

"IPv6Address": ""

}

},

"Options": {},

"Labels": {}

}

]

# 再次测试ping连接

[root@localhost ~]# docker exec -it tomcat-net-01 ping 192.168.0.3

PING 192.168.0.3 (192.168.0.3) 56(84) bytes of data.

64 bytes from 192.168.0.3: icmp_seq=1 ttl=64 time=0.177 ms

64 bytes from 192.168.0.3: icmp_seq=2 ttl=64 time=0.130 ms

64 bytes from 192.168.0.3: icmp_seq=3 ttl=64 time=0.216 ms

64 bytes from 192.168.0.3: icmp_seq=4 ttl=64 time=0.311 ms

64 bytes from 192.168.0.3: icmp_seq=5 ttl=64 time=0.135 ms

--- 192.168.0.3 ping statistics ---

5 packets transmitted, 5 received, 0% packet loss, time 11ms

rtt min/avg/max/mdev = 0.130/0.193/0.311/0.068 ms

# 现在不需要使用--link也可以ping名字了!

[root@localhost ~]# docker exec -it tomcat-net-01 ping tomcat-net-02

PING tomcat-net-02 (192.168.0.3) 56(84) bytes of data.

64 bytes from tomcat-net-02.mynet (192.168.0.3): icmp_seq=1 ttl=64 time=0.087 ms

64 bytes from tomcat-net-02.mynet (192.168.0.3): icmp_seq=2 ttl=64 time=0.164 ms

64 bytes from tomcat-net-02.mynet (192.168.0.3): icmp_seq=3 ttl=64 time=0.116 ms

64 bytes from tomcat-net-02.mynet (192.168.0.3): icmp_seq=4 ttl=64 time=0.103 ms

**小结:**我们自定义的网络docker都已经帮我们维护好了对应的关系,推荐使用这个网络

好处:

redis - 不同集群使用不同的网络,保证集群是健康和安全的

mysql - 不同集群使用不同的网络,保证集群是健康和安全的

### 网络连通

![]()

![]()

# 测试打通 tomcat01 - mynet

[root@localhost ~]# docker network connect mynet tomcat01

# 连通之后将tomcat01放到了mynet网络下

# 一个容器两个ip地址 阿里云服务:公网ip 私网ip

# tomcat01 和tomcat-net-01是打通的

[root@localhost ~]# docker exec -it tomcat01 ping tomcat-net-01

PING tomcat-net-01 (192.168.0.2) 56(84) bytes of data.

64 bytes from tomcat-net-01.mynet (192.168.0.2): icmp_seq=1 ttl=64 time=0.099 ms

64 bytes from tomcat-net-01.mynet (192.168.0.2): icmp_seq=2 ttl=64 time=0.139 ms

64 bytes from tomcat-net-01.mynet (192.168.0.2): icmp_seq=3 ttl=64 time=0.165 ms

# tomcat02 和tomcat-net-01是没打通的

[root@localhost ~]# docker exec -it tomcat02 ping tomcat-net-01

ping: tomcat-net-01: Name or service not known

**结论:**如果需要跨网络操作别人,就需要使用docker network connect进行连通

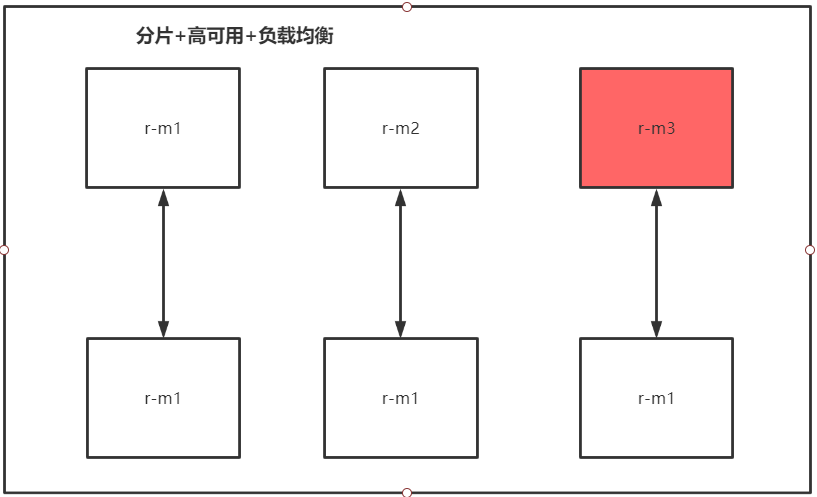

7.4 实战:部署Redis集群

shell脚本

# 创建网卡

docker network create redis --subnet 172.38.0.0/16

# 通过脚本创建六个redis配置

for port in $(seq 1 6); \

do \

mkdir -p /mydata/redis/node-${port}/conf

touch /mydata/redis/node-${port}/conf/redis.conf

cat << EOF >/mydata/redis/node-${port}/conf/redis.conf

port 6379

bind 0.0.0.0

cluster-enabled yes

cluster-config-file nodes.conf

cluster-node-timeout 5000

cluster-announce-ip 172.38.0.1${port}

cluster-announce-port 6379

cluster-announce-bus-port 16379

appendonly yes

EOF

done

# 运行6个节点

docker run -p 6371:6379 -p 16371:16379 --name redis-1 \

-v /mydata/redis/node-1/data:/data \

-v /mydata/redis/node-1/conf/redis.conf:/etc/redis/redis.conf \

-d --net redis --ip 172.38.0.11 redis:5.0.9-alpine3.11 redis-server /etc/redis/redis.conf

docker run -p 6372:6379 -p 16372:16379 --name redis-2 \

-v /mydata/redis/node-2/data:/data \

-v /mydata/redis/node-2/conf/redis.conf:/etc/redis/redis.conf \

-d --net redis --ip 172.38.0.12 redis:5.0.9-alpine3.11 redis-server /etc/redis/redis.conf

docker run -p 6373:6379 -p 16373:16379 --name redis-3 \

-v /mydata/redis/node-3/data:/data \

-v /mydata/redis/node-3/conf/redis.conf:/etc/redis/redis.conf \

-d --net redis --ip 172.38.0.13 redis:5.0.9-alpine3.11 redis-server /etc/redis/redis.conf

docker run -p 6374:6379 -p 16374:16379 --name redis-4 \

-v /mydata/redis/node-4/data:/data \

-v /mydata/redis/node-4/conf/redis.conf:/etc/redis/redis.conf \

-d --net redis --ip 172.38.0.14 redis:5.0.9-alpine3.11 redis-server /etc/redis/redis.conf

docker run -p 6375:6379 -p 16375:16379 --name redis-5 \

-v /mydata/redis/node-5/data:/data \

-v /mydata/redis/node-5/conf/redis.conf:/etc/redis/redis.conf \

-d --net redis --ip 172.38.0.15 redis:5.0.9-alpine3.11 redis-server /etc/redis/redis.conf

docker run -p 6376:6379 -p 16376:16379 --name redis-6 \

-v /mydata/redis/node-6/data:/data \

-v /mydata/redis/node-6/conf/redis.conf:/etc/redis/redis.conf \

-d --net redis --ip 172.38.0.16 redis:5.0.9-alpine3.11 redis-server /etc/redis/redis.conf

# 创建集群

/data # redis-cli --cluster create 172.38.0.11:6379 172.38.0.12:6379 172.38.0.13:6379 172.38.0.14:6379 172.38.0.15:6379 172.38.0.16:6379 --cluster-replicas 1

>>> Performing hash slots allocation on 6 nodes...

Master[0] -> Slots 0 - 5460

Master[1] -> Slots 5461 - 10922

Master[2] -> Slots 10923 - 16383

Adding replica 172.38.0.15:6379 to 172.38.0.11:6379

Adding replica 172.38.0.16:6379 to 172.38.0.12:6379

Adding replica 172.38.0.14:6379 to 172.38.0.13:6379

M: ebfbbc88a83fa84c3d73fe048fc37ab82841fa0e 172.38.0.11:6379

slots:[0-5460] (5461 slots) master

M: ed7bac9d22ce436c650f9a51c3ae7a3aa84a7537 172.38.0.12:6379

slots:[5461-10922] (5462 slots) master

M: 2f1fdb553165c31c599f5cdbac5a42fa15901602 172.38.0.13:6379

slots:[10923-16383] (5461 slots) master

S: d2edadd37c2b243ffa3a13ac7bb352062160f4b8 172.38.0.14:6379

replicates 2f1fdb553165c31c599f5cdbac5a42fa15901602

S: 98bec4772bd3cdc7335111f75bc3f6b6ad2fae26 172.38.0.15:6379

replicates ebfbbc88a83fa84c3d73fe048fc37ab82841fa0e

S: 6e8dda893836d8182af1a7cbe0ff71b32d0743ef 172.38.0.16:6379

replicates ed7bac9d22ce436c650f9a51c3ae7a3aa84a7537

Can I set the above configuration? (type 'yes' to accept): yes

>>> Nodes configuration updated

>>> Assign a different config epoch to each node

>>> Sending CLUSTER MEET messages to join the cluster

Waiting for the cluster to join

....

>>> Performing Cluster Check (using node 172.38.0.11:6379)

M: ebfbbc88a83fa84c3d73fe048fc37ab82841fa0e 172.38.0.11:6379

slots:[0-5460] (5461 slots) master

1 additional replica(s)

S: 98bec4772bd3cdc7335111f75bc3f6b6ad2fae26 172.38.0.15:6379

slots: (0 slots) slave

replicates ebfbbc88a83fa84c3d73fe048fc37ab82841fa0e

S: d2edadd37c2b243ffa3a13ac7bb352062160f4b8 172.38.0.14:6379

slots: (0 slots) slave

replicates 2f1fdb553165c31c599f5cdbac5a42fa15901602

S: 6e8dda893836d8182af1a7cbe0ff71b32d0743ef 172.38.0.16:6379

slots: (0 slots) slave

replicates ed7bac9d22ce436c650f9a51c3ae7a3aa84a7537

M: 2f1fdb553165c31c599f5cdbac5a42fa15901602 172.38.0.13:6379

slots:[10923-16383] (5461 slots) master

1 additional replica(s)

M: ed7bac9d22ce436c650f9a51c3ae7a3aa84a7537 172.38.0.12:6379

slots:[5461-10922] (5462 slots) master

1 additional replica(s)

[OK] All nodes agree about slots configuration.

>>> Check for open slots...

>>> Check slots coverage...

[OK] All 16384 slots covered.

docker搭建redis集群完成

我们使用了docker后,所有技术都会变得更加方便

7.5 SpringBoot微服务打包Dockers镜像

1、架构springboot项目

2、打包应用

3、编写dockerfile(idea中安装docker插件比较方便)

4、将jar包和Dockerfile文件传输到Linux服务器上

5、构建镜像eric666

6、发布运行

7、测试,可以看到成功打印出"hello,kungshen"

以后我们使用了Docker之后,给别人交互的就是一个镜像即可!

8. Docker Compose

8.1 简介

Docker

DockerFile build run 手动操作,单个容器

微服务,100个微服务,依赖关系

Docker Compose来轻松高效的管理容器,定义运行多个容器

官方介绍

定义、运行多个容器

YAML file配置文件

single command,命令有哪些?

Compose is a tool for defining and running multi-container Docker applications. With Compose, you use a YAML file to configure your application’s services. Then, with a single command, you create and start all the services from your configuration. To learn more about all the features of Compose, see the list of features.

Compose works in all environments: production, staging, development, testing, as well as CI workflows. You can learn more about each case in Common Use Cases.

Using Compose is basically a three-step process:

- Define your app’s environment with a Dockerfile so it can be reproduced anywhere.

- Dockerfile保证我们的项目在任何地方都可以运行

- Define the services that make up your app in docker-compose.yml so they can be run together in an isolated environment.

- services什么是服务

- docker-compose.yml这个文件怎么写

- Run docker compose up and the Docker compose command starts and runs your entire app. You can alternatively run docker-compose up using the docker-compose binary.

- 启动项目

作用:批量容器编排。

我自己的理解

Compose是Docker官方的开源项目,需要安装

Dockerfile让程序在任何地方运行,web服务,redis、mysql、nginx…多个容器

Compose

version: "3.9" # optional since v1.27.0

services:

web:

build: .

ports:

- "5000:5000"

volumes:

- .:/code

- logvolume01:/var/log

links:

- redis

redis:

image: redis

volumes:

logvolume01: {}

docker compose up 100个服务

Compose:重要的概念。

- 服务services,容器,应用(web、redis、mysql)

- 项目project,一组关联的容器。

8.2 安装

-

下载

sudo curl -L "https://github.com/docker/compose/releases/download/1.29.1/docker-compose-$(uname -s)-$(uname -m)" -o /usr/local/bin/docker-compose # 这个可能快点 curl -L https://get.daocloud.io/docker/compose/releases/download/1.29.1/docker-compose-`uname -s`-`uname -m` > /usr/local/bin/docker-compose -

授权

sudo chmod +x /usr/local/bin/docker-compose

8.3 体验

官网地址

python应用,计数器,redis

1、应用app.py

- 为项目创建文件夹

mkdir composetest

cd composetest

- 创建

app.py文件

import time

import redis

from flask import Flask

app = Flask(__name__)

cache = redis.Redis(host='redis', port=6379)

def get_hit_count():

retries = 5

while True:

try:

return cache.incr('hits')

except redis.exceptions.ConnectionError as exc:

if retries == 0:

raise exc

retries -= 1

time.sleep(0.5)

@app.route('/')

def hello():

count = get_hit_count()

return 'Hello World! I have been seen {} times.\n'.format(count)

- 创建`requirements.txt`文件

flask

redis

2、Dockerfile应用打包为镜像

创建Dockerfile文件

# syntax=docker/dockerfile:1

FROM python:3.7-alpine

WORKDIR /code

ENV FLASK_APP=app.py

ENV FLASK_RUN_HOST=0.0.0.0

RUN apk add --no-cache gcc musl-dev linux-headers

COPY requirements.txt requirements.txt

RUN pip install -r requirements.txt

EXPOSE 5000

COPY . .

CMD ["flask", "run"]

3、Docker-compose yaml文件(定义整个服务于,需要的环境,web、redis)

version: "3.9"

services:

web:

build: .

ports:

- "5000:5000"

redis:

image: "redis:alpine"

4、启动compose

docker-compose up

docker-compose up的执行流程

1、创建网络

2、执行Docker-compose yaml

3、启动服务

Creating composetest_web_1 … done

Creating composetest_redis_1 … done

docker images

自动的默认规则

1、文件名 composetest

2、服务

默认的服务名 文件名_num

多个服务器,集群 A B_num 副本数量

服务redis服务=>4个副本

集群状态,服务都不可能只有一个运行实例。弹性、10 HA 高并发

3、网络规则

10个服务=>项目(项目中的内容都在同一个网络下,域名访问)

如果在同一个网络下,我们可以通过域名进行访问

停止命令

docker-compose down

Ctrl+C

docker-compose

以前都是单个docker run启动容器

docker-compose通过docker-compose编写yaml配置文件、可以通过compose一键启动所有服务,停止

Docker小结:

1、Docker镜像,run=>容器

2、DockerFile构建镜像(服务打包)

3、docker-compose启动项目(编排、多个微服务/环境)

4、Docker网络

8.4 yaml 规则

docker-compose.yaml 核心

官方例子链接

# 3层

version: '' # 版本

services: # 服务

服务1: web

# 服务配置

images

build

network

......

服务2: redis

.....

服务3: mysql

.....

# 其他配置 网络/卷 全局规则

volumes:

networks:

configs

8.5 实战

- 使用Compose一键部署WP博客

- 自己编写微服务上线