吃瓜笔记--西瓜书学习笔记一二章

第一章 绪论

1.1 引言

机器学习定义:

- 它致力于研究如何通过计算的手段,利用经验来改善系统自身的性能。

- 假设用P来评估计算机程序在某任务类T上的性能,若一个程序通过利用经验E在T中任务上获得了性能改善,我们就说关于T和P,该程序对E进行了学习。

机器学习所研究的主要内容:关于在计算机上从数据中产生“模型”的算法,即“学习算法”。

本书中模型泛指从数据中学得的结果。

1.2 基本术语

- 数据

数据集(data set):一组记录的集合。

示例(instance)/ 样本(sample):数据集中的一条记录,是关于一个事件或对象的描述。

属性(attribute)/ 特征(feature):反映事件或对象在某方面的表现或性质的事项。

属性值(attribute value):属性的具体取值。

属性空间(attribute space)/ 样本空间(sample space)/ 输入空间:属性张成的空间。

特征向量(feature vector):一个示例。

- 学习 / 训练

学习 /训练:从数据中学习模型的过程。

训练数据(training data):训练过程中使用的数据。每一个样本叫训练样本(training sample) 或训练示例(training instance)。

假设:学习的对应了关于数据的某种潜在的规律的模型。

标记(label):我们建立的预测。

- 学习任务

分类(classification):预测的结果是离散值的任务。对二分类(binary classificaton)任务,通常称一个为“正类”(positive class)另一个叫反类(negative class);涉及多分类任务时称为多分类(multi-class classification)。

回归(regression):预测的结果是连续值的任务。

聚类(clustering):对数据集进行分组,分组结果预先不知,学习过程中使用的训练样本通常不拥有标记信息。

监督学习(supervised learning):有标记信息的学习任务,代表是分类和回归。

非监督学习(unsupervised learning):没有标记信息的学习任务,代表是聚类。

泛化(generalization)能力:习得模型适用新样本的能力。

1.3 假设空间

归纳和演绎是科学推理的两大手段。

- 归纳(induction):从特殊推到一般的泛化,从样例中学习就是归纳过程。

- 演绎(deduction):从一般到特殊的泛华。

学习的目的是通过训练,得到一个模型,而这个模型可以对新样例的标签进行精准的预测。

学习的过程也可以看做在所有假设组成的空间中进行搜索的过程。假设,就是说该数据集对应的潜在规律;这个规律可能有很多种,学习的过程就是找到与训练数据匹配的一组假设。

第二章 模型评估与选择

2.1 概念

错误率(error rate):分类错误的样本数占样本总数的比例。

精度(accuracy):精度 = 1 - 错误率。

误差(error):学习器的实际预测输出与样本的真实输出之间的差异。

训练误差(training error)/经验误差(empirical error):学习器在训练集上的误差。

泛化误差(generalization error):学习器在新样本上的误差。

过拟合(overfitting):学习器把训练样本学习得“太好”了,把训练样本自身的一些特点当作了所有潜在样本都会具有的一般性质,导致泛化性能下降。

欠拟合(underfitting):学习器对训练样本的一般性质尚未学好。

2.2 评估方法

如果我们还有一个包含m个样例的数据集D={(x1,y1),(x2,y2),...,(xm,ym)},既要训练,又要测试,就需要通过对D进行适当的处理,从中产生出训练集S和测试集T。

1,留出法 (hold-out)

2,交叉验证法(cross validation)

3,自助法 (bootstrapping)

2.3 性能度量

性能度量(performance measure):衡量模型泛化能力的评价标准。

均方误差:回归任务常用。均等代价假设。计算欧几里得距离作为代价函数。

查准率(precision):记号为P,是真正例在所有预测为正例中的比率。

查全率(recall):记号为R,是真正例在所有真实为正例中的比率。

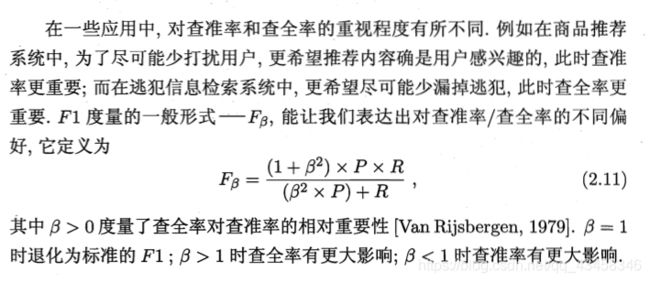

查准率和查全率是一对矛盾的度量。一般来说,增大查准率会减小查全率,增大查全率会减小查准率。

P-R曲线:用来衡量模型性能的曲线。学习器的P-R曲线下围成面积越大,学习器性能越好。

平衡点(Break-Even Point,简称BEP):为了在PR图中识别学习器的性能谁更优异,人们设计了一些综合考虑查准率、查全率的性能度量。平衡点就是其中之一,值的大小为 P = R 时的取值。对于两个学习器,若各自P-R曲线围城面积相同,则平衡点取值较大的学习器性能更优。