【论文解读】跨域小样本学习:A Broader Study of Cross-Domain Few-Shot Learning

1. 介绍

论文地址:

A Broader Study of Cross-Domain Few-Shot Learning

参考代码:

https://github.com/IBM/cdfsl-benchmark

针对问题:小样本学习、跨域学习Cross-Domain

少数镜头学习的最新进展在很大程度上依赖于元学习的注释数据:从与新类相同的域中采样的基类。然而,在许多应用中,为元学习收集数据是不可行或不可能的。这就导致了跨领域的少镜头学习问题,在这个问题中,基本类域和新类域之间有很大的变化。尽管存在Cross-Domain FSL场景的研究,但是这些作品仅限于仍然包含高度视觉相似性的自然图像。目前还没有研究在现实世界场景中看到的跨不同图像,如航空和医学成像。

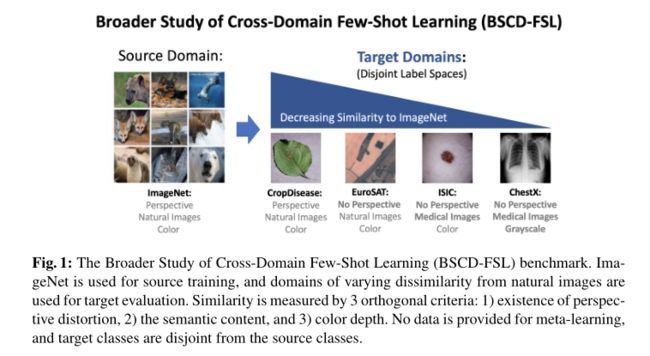

在本文中,提出了更广泛的跨域少数镜头学习(BSCD-FSL)基准研究,该基准包括来自各种图像采集方法的图像数据。这包括自然图像,如作物疾病图像,但也包括与自然图像越来越不相似的图像,如卫星图像、皮肤病图像和放射学图像。对所提出的基准进行了广泛的实验,以评估最先进的元学习方法、迁移学习方法以及跨领域少数镜头学习的新方法。

结果表明,最先进的元学习方法令人惊讶地优于早期的元学习方法,所有元学习方法相对于简单微调的平均准确率差12.8%。在某些情况下,元学习甚至比随机权重的网络表现更差。在这个更具挑战性的基准测试中,以前通过Cross-Domain FSL的专门方法观察到的性能提升消失了。最后,所有方法的准确性往往与数据集与自然图像的相似性相关,验证了基准的价值,以更好地代表实践中看到的数据的多样性,并指导未来的研究。

文章贡献:

-

我们建立了一个新的更广泛的跨域少数镜头学习(BSCDFSL)基准研究,包括来自不同图像类型的图像,根据1)透视失真、2)语义内容和3)颜色深度,与自然图像具有不同的相似性;

-

在这些条件下,我们广泛评估了当前元学习方法的性能,包括专门为跨域fewshot学习定制的方法,以及各种微调方法;

-

结果表明,最先进的元学习方法优于旧的元学习方法,所有元学习方法在简单微调方面的平均准确率低于12.8%。在某些情况下,MetalLearning甚至在具有随机权重的网络中也表现不佳;

-

结果还表明,在这个新的具有挑战性的基准测试中,跨域少镜头学习方法的精度增益失效;

-

最后,我们发现所有方法的准确性都与所提出的自然图像数据相似性度量相关,验证了问题表示的多样性,以及基准对未来研究的价值。

2. 方法

上图是提出的Broader Study of Cross-Domain FSL(BSCD-FSL)基准,ImageNet用于源训练,与自然图像不同的域用于目标评估。它涵盖了与自然图像具有不同相似度的图像类型的光谱。相似性由3个正交标准定义:1)图像是否包含透视失真,2)图像的语义内容,3)颜色深度。数据集包括农业图像(自然图像,但特定于农业工业)、卫星(失去透视失真)、皮肤病学(失去透视失真,并包含不同语义内容)和放射图像(根据所有3个标准的不同)。现有的最先进的元学习方法、迁移学习方法和为Cross-Domain FSL定制的方法的性能在所提出的基准上被严格测试。

2.1 Proposed Benchmark(数据集构造)

介绍更广泛的跨域少数镜头学习(BSCD-FSL)基准研究,其中包括来自Cropdiseas、EuroSA T、ISIC2018和ChestX数据集的数据。这些数据集分别包括植物疾病图像、卫星图像、皮肤损伤的皮肤镜图像和X射线图像。选定的数据集反映了精心策划的真实世界用例,用于少量镜头学习。此外,从上述领域收集足够多的示例通常很困难,而且成本高昂、甚至无法获取。

图像与自然图像的相似性通过3个正交标准来衡量:1)透视失真的存在,2)语义数据内容,3)颜色深度。根据这一标准,数据集展示了以下图像类型:1)Cropdises图像是自然图像,但非常专业化(类似于现有的跨域少镜头设置,但特定于农业),2)EuroSAT图像不太相似,因为它们失去了透视失真,但仍然是自然场景的彩色图像,3)ISIC2018图像更不相似,因为它们失去了透视失真,不再代表自然场景,4)ChestX图像最不相似,因为它们失去了透视失真,不代表自然场景,并且失去了2个颜色通道。来自ImageNet和建议的基准数据集的示例图像如上图所示。

在源域(如ImageNet)上训练一些镜头学习模型,可以推广到这些域,这是非常理想的,因为它可以有效地学习新类型图像中的稀有类别,而以前没有对其进行过详细研究。

2.2 Cross-Domain Few-Shot Learning Formulation

我们将一个域定义为输入空间 X和标签空间 y上的联合分布 P 。我们使用对 (X,y)来表示样本 x 和来自联合分布 p 的相应标签y。对于一个模型 和损失函数 l 的 ,期望误差定义为:

在跨域少镜头学习中,我们有一个源域(Xs,Ys)和一个目标域(Xt,Yt),分别具有联合分布ps和pt,并且Ys与Yt不相交。基类数据从源域采样,新类数据从目标域采样。在训练或元训练阶段,模型fθ根据基类数据进行训练(或元训练)。在测试(或元测试)阶段,模型使用支持集S={xi,yi}K×ni=1表示,该支持集由K个新类中的N个示例组成。这种配置被称为“K-way-n-shot”少镜头学习,因为支持集有K个新类,每个新类有N个训练示例。在模型适应支持集后,使用来自新类的查询集来评估模型性能。

base 类的数据从源域采样, novel 类的数据从目标域采样.

-

训练时, 模型在 base 类数据上训练.

-

测试时, 模型在 novel 类数据上测试. 其中会提供支撑集(support set) S={xi,yi}K×Ni=1S={xi,yi}i=1K×N, 其中包含 KK 和类别, 每个类别 NN 个带标签的样本, 称为 K-way N-shot 的少样本学习. 在模型适应到支撑集后使用查询集(query set)测试.

3. Evaluated Methods for Cross-Domain Few-Shot Learning

3.1 Meta-learning based methods

以 task 的形式训练模型. 每个 task 从固定的分布中抽取 Ti∼P(T)Ti∼P(T) . 比如, 在 FSL 中, 每个 task 都是一个小型数据集 Di:={xj,yj}K×Nj=1Di:={xj,yj}j=1K×N . 使用 Ps(T)Ps(T) 和 Pt(T)Pt(T) 分别表示源域和目标域上的 task.

-

meta-training 阶段: 模型在 TT 个 task {Ti}Ti=1{Ti}i=1T 上训练, 这 TT 个 采样于 Ps(T)Ps(T); .

-

meta-testing 阶段: 希望模型可以快速适应于新的 task Tj∼Pt(T)

-

在 meta-learning 中潜在的存在这样的假设: Ps(T)=Pt(T)Ps(T)=Pt(T), 这也是在跨域的时候表现差的原因.

Tj∼Pt(T)

3.2 Transfer learning based methods

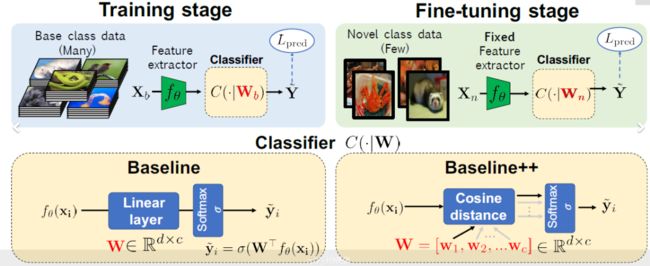

解决少镜头学习问题的另一种方法是基于迁移学习,其中初始模型fθ以标准的监督学习方式在基类数据上训练,并在新类上重用。

Single Model Methods:广泛评估了以下单模型微调的常见变体

-

固定特征提取器(Fixed):简单地利用预先训练的模型作为固定特征提取器;

-

微调所有层(Ft all):使用标准监督学习调整新任务上所有预先训练的参数;

-

微调last-k(Ft last-k):仅针对新任务优化预训练模型的最后k层。在本文中,我们考虑了精细调谐LAST-1,精细调谐LAST-2,精细调谐LAST-3;

-

Transductive fine-tuning(Transductive Ft):在Transductive fine-tuning中,通过批量标准化使用novel 类查询图像的统计信息。

此外,我们将这些单模型转移学习技术与由随机初始化网络(称为随机)形成的嵌入基线进行比较,以与没有预训练的固定特征向量进行对比。单模型微调的所有变体都基于线性分类器,但在微调单模型特征提取器的方法上有所不同。

对于少量镜头学习,平均质心分类器和基于余弦相似性的分类器比线性分类器更有效。

平均质心分类器(基于原型的方法):

其中d()是距离函数。在实验中,我们使用负余弦相似性。与ProtoNet不同,fθ是以标准的有监督学习方式在基类数据上进行预训练的.

基于余弦相似性的分类器(直接学习原型):

每个权重向量的余弦相似性计算如下

在基于余弦相似性的分类器中,每个类k被表示为一个随机初始化的d维权重向量,而不是使用预先训练好的模型直接计算类原型。

Transfer from Multiple Pre-trained Models:

该方法利用在类似ImageNet的自然图像源域上预先训练的多个模型。请注意,对于跨域少数镜头学习设置,所有域仍然与目标数据集不相交。其目的是通过利用从不同于目标域的数据中训练的模型集合来衡量性能可以提高多少。所描述的方法不需要改变模型的训练方式,是一种现成的解决方案,可以利用现有的预训练模型进行跨域少镜头学习,而无需访问源数据集。

假设我们有 CC 个分别在不同数据集上预训练的模型 {Mc}Cc=1{Mc}c=1C , 记所有预训练模型的所有网络层为 FF, 给定支撑集 S={(xi,yi)}K×Ni=1S={(xi,yi)}i=1K×N 其中 (xi,yi)∼Pt(xi,yi)∼Pt , 我们的目标是寻找 FF 的子集 II 来产生特征向量使得测试误差最小:

其中 T(⋅)T(⋅) 是结合一组特征向量的函数, aa 是 II 中的网络层, fsfs 是线性分类器.

II 的筛选方法:

-

每一个预训练模型的每一层都训练一个分类器, 然后每个模型最好的层加入 I1I1

-

把 I1I1 中的层累进式地加入 II, 可以降低误差则保留, 否则丢弃

4. 实验 四个数据集 + 三种训练方法 + 三种分类器

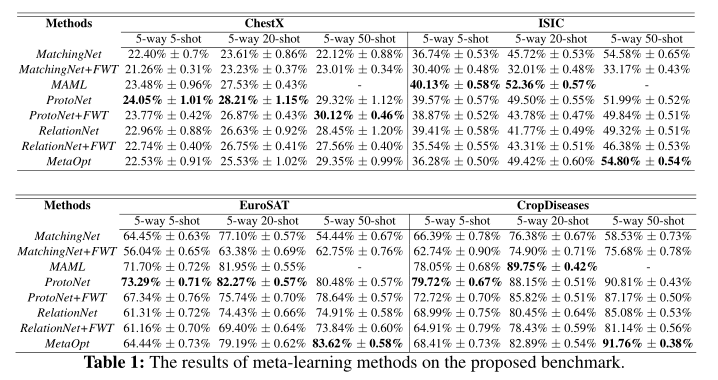

4.1Meta-learning based results

现有的最先进的MetaOptNet已不再是最先进的,因为它的性能次优于ProtoNet。此外,专门为跨域少镜头学习设计的方法在这个新的具有挑战性的基准测试中会导致一致的性能下降。最后,总体而言,性能与数据集与ImageNet的相似性呈强正相关,这证实了基准的有意设计允许我们调查跨领域困难中的少量镜头学习。

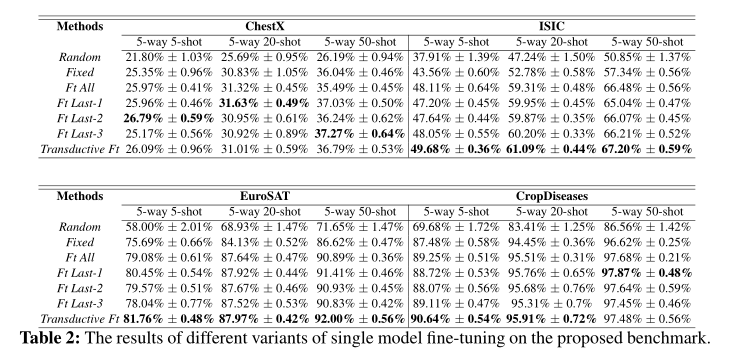

4.2 Transfer learning based results

第一个观察结果是,尽管元学习方法在标准的少数镜头学习设置中比qian移学习具有更高的性能,但在跨领域的少数镜头学习设置中,这种情况是相反的:元学习方法的性能明显低于简单的微调方法。事实上,MatchingNet的性能比随机生成的固定嵌入差。一种可能的解释是,元学习方法在基本类数据上拟合任务分布,在这种情况下提高了性能,但妨碍了通用到另一个任务分布的能力。第二个观察结果是,通过利用测试数据的统计数据,如前所述,与标准微调和元学习相比,转换微调继续获得更高的结果。然而,尽管转换微调假设所有查询都可以作为未标记的数据使用。第三个观察结果是,基准测试中大多数方法的准确性仍然取决于数据集与ImageNet的相似程度:Cropdiseas的平均性能最高,而EuroSAT排名第二,ISIC排名第三,ChestX排名第四。这进一步支持了基准设计背后的动机,即瞄准视觉领域与自然图像越来越不相似的应用程序。

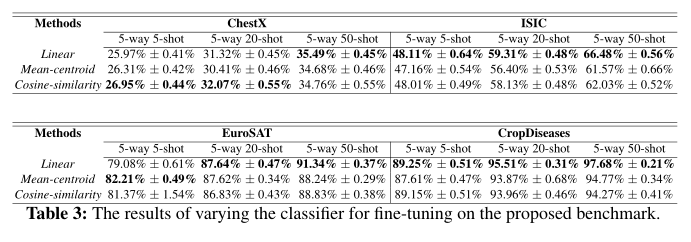

虽然平均质心分类器和余弦相似性分类器在传统的少镜头学习环境中比简单线性分类器更有效,但我们的结果表明,在5镜头情况下,平均质心和余弦相似性分类器在ChestX和EuroSAT上仅比线性分类器具有边际优势。随着镜头的增加,线性分类器开始主导平均质心和余弦相似性分类器。

Transfer from Multiple Pre-trained Models:

使用多个预先训练的模型比只使用一个模型更有益,即使这些模型是从不同领域和不同图像类型的数据中训练出来的。

4.3 单模型迁移方法, 微调对参数的影响

-

第一层的参数变化最大: 说明跨域学习所需要的低级特征是相当不同的

-

有一些层的参数变化很小

对此的解释是模型内层的异质性特点(heterogeneous characteristic)7 , 即网络层是可以分为 ambient(周围的) 和 critical(关键的) 两类的, 即层的鲁棒性:

-

重置 ambient 层的参数对模型几乎没有影响

-

充值 critical 层的参数让模型几乎失去预测能力(变成随机输出)

4.4 多模型迁移方法, 预训练模型的选择性

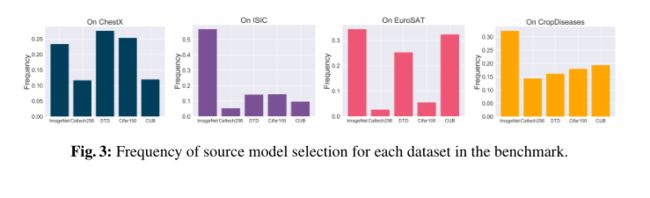

使用前面提到的模型选择的方法重复每个实验600个episodes, 并统计模型被选择的频率.不同数据集对预训练模型是有倾向性的

更多精彩内容:

【论文整理】小样本学习Few-shot learning论文整理收藏(最全,持续更新)