Docker资源控制与TLS加密通信

文章目录

- Docker资源控制

-

- 使用stress工作测试cpu和内存

- cup周期限制

- CPU Core 控制

- cpu配额控制参数的混合使用

- 内存限额

- IO限制

- bps和iops的限制

- Docker-TLS加密通信

-

- 实验需求

- 远程连接docker

Docker资源控制

-

Docker通过Cgroup 来控制容器使用的资源配额,包括CPU、内存、磁盘三大方面,基本覆盖了常见的资源配额和使用量控制。

-

Cgroup是Control Groups的缩写,是Lnux内核提供的一种可以限制、记录、隔离进程组所使用的物理资源(如CPU、内存、磁盘IO等等)的机制,

这些具体的资源管理功能称为Cgroup子系统,有以下几大子系统实现:

-

**blkio:**设置限制每个块设备的输入输出控制。例如:磁盘,光盘以及usb等

-

**CPU:**使用调度程序为cgroup任务提供CPU的访问。

-

**cpuacct:**产生cgroup任务的CPU 资源报告。

-

cpuset:如果是多核心的CPU,这个子系统会为cgroup任务分配单独的CPU和内存。

-

**devices:**允许或拒绝cgroup任务对设备的访问。

-

**freezer:**暂停和恢复cgroup任务。

-

memory:设置每个cgroup的内存限制以及产生内存资源报告。

-

**net_cls:**标记每个网络包以供cgroup方便使用。

-

**ns:**命名空间子系统。

-

**perf_event:**增加了对每个group的监测跟踪的能力,可以监测属于某个特定的group的所有线程以及运行在特定CPU上的线程。

下面开始利用stress压力测试工具来测试CPU 和内存使用状况。

使用stress工作测试cpu和内存

使用Dockerfile来创建一个基于Centos的stress的工作镜像

[root@localhost opt]# mkdir stress

[root@localhost opt]# cd stress

[root@localhost stress]# vim Dockerfile

FROM centos:7

MAINTAINER chen "[email protected]"

RUN yum -y install wget

RUN wget -O /etc/yum.repos.d/epel.repo http://mirrors.aliyun.com/repo/epel-7.repo

RUN yum install -y stress

运行脚本

[root@localhost stress]# docker build -t centos:stress .

使用下面命令创建容器,命令中–cpu-shares参数不能保证获得1个VCPU或多个CPU资源,它仅仅是一个弹性加权值

docker run -itd --cpu-shares 100 centos:stress

1:说明:说明:默认情况下,每个Docker容器的CPU份额都是1024。单独一个容器的份额是没有意义的。只有在同时运行多个容器时,容器的CPU加权的效果

2:例如,两个容器AB的CPU份额分别为1000和500,在CPU进行时间片分配的时候,容器A比容器B多一倍的机会获得CPU的时间片。分配的结果取决于当时主机和其他容器的运行状态,实际上也无法保证容器A一定能获得CPU时间片。比如容器A的进程一直是空闲的,那么容器B是可以获取比容器A更多的CPU时间片的。极端情况下,例如主机上只运行了一个容器,即使它的CPU份额只有50,它也可以独占整个主机

创建容器

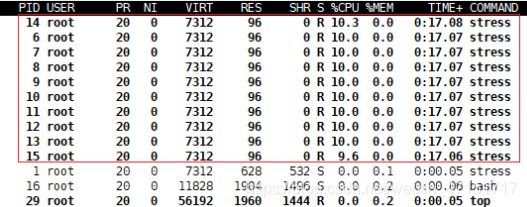

docker run -tid --name cpu512 --cpu-shares 512 centos:stress stress -c 10

stress -c 10:容器产生10个子函数进程

进入容器

docker exec -it 0aa895961d13 bash

输入top查看我们已经创建了10个进程(1master带10个进程)

再开一台终端容器做比较

docker run -tid --name cpu1024 --cpu-shares 1024 centos:stress stress -c 10

进入容器

docker exec -it f5f6dac70fa2 bash

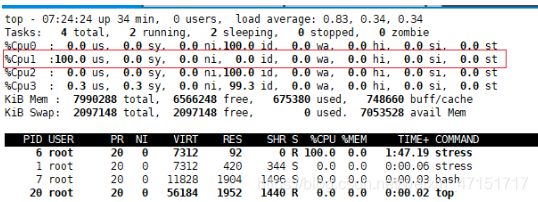

两台cpu对比,我们可以看到%CPU份额是另一台的一半(使用top对比两个的%CPU,比例是1:2)

cup周期限制

Docker提供了–cpu-period、–cpu-quota两个参数控制容器可以分配到的CPU时钟周期。

- –cpu-period是用来指定容器对CPU的使用要在多长时间内做一次重新分配.

- --cpu-quota是用来指定在这个周期内,最多可以有多少时间用来跑这个容器。与–cpu-shares 不同的是,这种配置是指定一个绝对值,容器对CPU资源的使用绝对不会超过配置的值。

- cpu-period和cpu-quota 的单位为微秒(us). cpu-period的最小值为1000微秒,最大值为1秒(10^6 us),默认值为0.1秒(10000 us)cpu-quota的值默认为-1,表示不做控制。cpu-period和cpu-quota参数一般联合使用。

- 例如:容器进程需要每1秒使用单个CPU的0.2秒时间,可以将cpu-period设置为1000000 (即1秒),cpu-quota设置为20000(0.2秒)当然,在多核情况下,如果允许容器进程完全占用两个CPU,则可以将cpu-period 设置为100000(即0.1秒),cpu-quota设置为200000 (0.2)

我么先把前面的容器停止

停止容器

[root@localhost stress]# docker stop f5f6dac70fa2

f5f6dac70fa2

[root@localhost stress]# docker stop b69f01e20458

下面我们配置容器名字为cuptest 资源分配100000秒,cpu配额为200000,针对 centos:stress镜像

docker run -itd --name cuptest --cpu-period 100000 --cpu-quota 200000 centos:stress

进入容器

[root@localhost stress]# docker exec -it 6078e84e4b6c bash

查看资源分配,cpu配额

[root@6078e84e4b6c /]# cat /sys/fs/cgroup/cpu/cpu.cfs_period_us

100000

[root@6078e84e4b6c /]# cat /sys/fs/cgroup/cpu/cpu.cfs_quota_us

200000

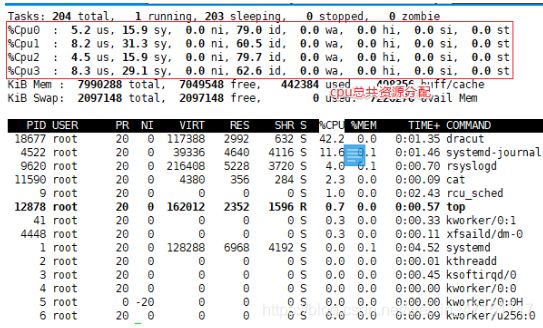

修改内存8G核心数4

CPU Core 控制

对多核CPU的服务,Docker还可以控制容器运行使用哪些CPU内核,即使用–cpuuset-cpus参数。这对具多CPU的服务器尤其有用,可以对需要高性能计算进行性能最优的配置

docker run -itd --name cpu1 --cpuset-cpus 0-1 centos:stress

ps:以上命令需要宿主机为双核,表示创建容器只可以用0,1两内核

进入容器

[root@localhost ~]# docker exec -it 9cdded9c10de bash

查看cpu

[root@9cdded9c10de /]# cat /sys/fs/cgroup/cpuset/cpuset.cpus

0-1

下面指令可以看到容器中进程与cpu核心的绑定关系,达到绑定CPU内核的目的

[root@localhost ~]# docker exec c0ffab515796 taskset -c -p 1

压测测试

[root@localhost ~]# docker exec -it 9cdded9c10de bash

[root@9cdded9c10de /]# stress -c 10

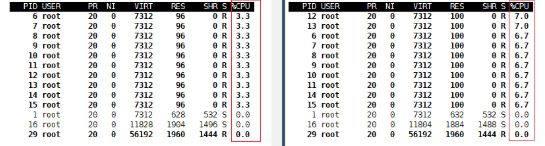

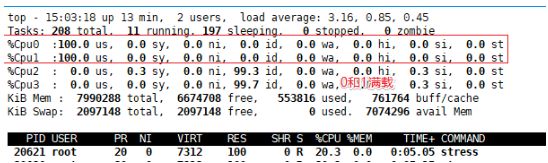

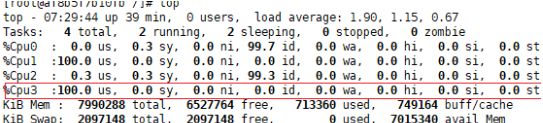

cpu配额控制参数的混合使用

通过cpuset-cpus参数指定容器A使用CPU内核0,容器B只是用CPU内核1.

在主机上只有这两个容器使用对应CPU内核的情况,它们各自占用全部的内核资源,cpu-shares没有明显效果。

cpuset-cpus、cpuset-mems参数只在多核、多内存节点上的服务器上有效,并且必须与实际的物理配置匹配。否则也无法达到资源控制的目的。

在系统具有多个CPU内核的情况下,需要通过cpuset-cpus参数为设置容器CPU内核才能方便地进行测试。

[root@localhost ~]# docker run -tid --name cpu3 --cpuset-cpus 1 --cpu-shares 512 centos:stress stress -c 1

进入查看资源

[root@localhost ~]# docker exec -it af8b5f7b10fb bash

在开一台

[root@localhost ~]# docker run -tid --name cpu4 --cpuset-cpus 3 --cpu-shares 1024 centos:stress stress -c 1

总结:上面的centos:stress镜像安装了stress工具,用来测试CPU和内存的负载。通过在两个容器上分别执行stress -c1命令,会给系统一个随机负载,产生1个进程。这个进程都反复不停的计算由rand()产生随机数的平方根,直到资源耗尽。察到宿主机上的CPU使用率,第三个内核的使用率接近100%,并且一批进程的CPU使用率明显存在2:1的使用比例的对比。

内存限额

与操作系统类似,容器可使用的内存包括两部分:物理内存和Swap.

Docker通过下面两组参数来控制容器内存的使用量。

-m或–memory:设置内存的使用限额,例如10OM、1024M.

–memory-swap:设置内存+swap的使甩限额。

执行如下命令允许该容器最多使用20OM的内存和30OM的swap.

[root@localhost ~]# docker run -it -m 200M --memory-swap=300M progrium/stress --vm 1 --vm-bytes 280M

–vm 1:启动1个内存工作线程。

–vm-bvtes 280M:每个线程分配28OM内存。

如果让工作线程分配的内存超过300M,分配的内存超过限额,stress线程报错,容器退出。

[root@localhost stress]# docker run -it -m 200M --memory-swap=300M progrium/stress --vm 1 --vm-bytes 310M

IO限制

默认情况下,所有容器能平等地读写磁盘,可以通过设置–blkio-weight参数来改变容器block lO的优先级。

–blkio-weight与–cpu-shares类似。设置的是相对权重值,默认为500。

在下面的例子中,容器A读写磁盘的带宽是容器B的两倍。

[root@localhost ~]# docker run -idt --name container_A --blkio-weight 600 centos:stress

[root@localhost ~]# docker exec -it f1eff11d5926 bash

[root@f1eff11d5926 /]# cat /sys/fs/cgroup/blkio/blkio.weight

600

在建立一个权重为300的

[root@localhost ~]# docker run -idt --name container_B --blkio-weight 300 centos:stress

[root@localhost ~]# docker exec -it a9799eb70c64 bash

[root@a9799eb70c64 /]# cat /sys/fs/cgroup/blkio/blkio.weight

300

总结600的读写更快

bps和iops的限制

- bps是byte per second,每秒读写的数据量。

- ops是io per second.每秒IO的次数。

通过以下参数控制客器的bps和iops: - -device-read-bps。限制读某个设备的bps.

- -device-write-bps,限制写某个设备的bps.

- -device-read-iops,限制读某个设备的iops.

- -device-write-iops,限制写某个设备的iops.

面的示例是限制容器写/dev/sda的速率为5MB/s.

docker run -it --device-write-bps /dev/sda:5MB centos:stress

先容器中不停的读写(我们发现写的很慢)

[root@24ce8fee6b6a /]# dd if=/dev/zero of=test bs=1M count=1024 oflag=direct

1024+0 records in

1024+0 records out

1073741824 bytes (1.1 GB) copied, 204.806 s, 5.2 MB/s

我们不设置限制(发现很快就好了)

[root@localhost ~]# docker run -it centos:stress

[root@ef487c7c1cee /]# dd if=/dev/zero of=test bs=1M count=1024 oflag=direct

1024+0 records in

1024+0 records out

1073741824 bytes (1.1 GB) copied, 1.89416 s, 567 MB/s

Docker-TLS加密通信

安全传输层协议(TLS)用于在两个通信应用程序之间提供保密性和数据完整性。

该协议由两层组成: TLS 记录协议(TLS Record)和 TLS(TLS Handshake)。

- 对称:DES 3DES AES 长度不同 长度越长安全越高,解密速度越慢

- 非对称:RSA公钥,私钥 ,公钥:所有人可知(锁)私钥 (钥匙)个人身份信息,不可抵赖。

- 证书:个人信息,密钥,有效期

- ca:证书颁发机构 ca证书

实验过程;

创建ca密钥>>创建ca证书

创建服务器私钥>>签名密钥>>使用ca证书与私钥证书签名

生成客户端密钥>>签名客户端>>使用ca证书与客户签名证书

实验需求

使用需要服务2台服务去,一台配置证书:一台实验对接

centos7:192.168.136.90

centos7:192.168.136.81

设置master主机名

[root@localhost ~]# hostnamectl set-hostname master

配置解析(在另一台也配上为了名称对应地址)

[root@ef487c7c1cee /]# vim /etc/hosts

192.168.136.90 master

配置步骤:

创建ca密钥

[root@master ~]# openssl genrsa -aes256 -out ca-key.pem 4096

输入密码:123123

创建ca证书

openssl req -new -x509 -days 1000 -key ca-key.pem -sha256 -subj "/CN=*" -out ca.pem

创建服务器私钥

openssl genrsa -out server-key.pem 4096

签名密钥

openssl req -subj "/CN=*" -sha256 -new -key server-key.pem -out server.csr

使用ca证书与私钥证书签名,输入123123

openssl x509 -req -days 1000 -sha256 -in server.csr -CA ca.pem -CAkey ca-key.pem -CAcreateserial -out server-cert.pem

生成客户端密钥

openssl genrsa -out key.pem 4096

签名客户端

openssl req -subj "/CN=client" -new -key key.pem -out client.csr

创建配置文件

echo extendedKeyUsage=clientAuth > extfile.cnf

签名证书,输入123123(需要签名客户端,ca证书,ca密钥)

openssl x509 -req -days 1000 -sha256 -in client.csr -CA ca.pem -CAkey ca-key.pem -CAcreateserial -out cert.pem -extfile extfile.cnf

删除多余文件

[root@localhost ~]# rm -rf ca.srl client.csr server.csr extfile.cnf

配置docker证书

[root@localhost ~]# vim /lib/systemd/system/docker.service

14行加#号

15 ExecStart=/usr/bin/dockerd --tlsverify --tlscacert=/tls/ca.pem --tlscert=/tls/server-cert.pem --tlskey=/tls/server-key.pem -H tcp://0.0.0.0:2376 -H unix:///var/run/docker.sock

创建证书目录

[root@localhost ~]# mkdir /tls

[root@localhost ~]# mv *.pem /tls/

重启服务

[root@localhost ~]# systemctl daemon-reload

[root@localhost ~]# systemctl restart docker

查看端口

[root@master ~]# netstat -ntap | grep 2376

tcp6 0 0 :::2376 :::* LISTEN 13907/dockerd

本地验证(查看docker版本)

[root@master tls]# cd /tls/

[root@localhost docker]#docker --tlsverify --tlscacert=ca.pem --tlscert=cert.pem --tlskey=key.pem -H tcp://master:2376 version

远程连接docker

开启客户端192.168.136.81

服务端复制证书给客户端

[root@maseter tls]# scp ca.pem [email protected]:/etc/docker

[root@maseter tls]# scp cert.pem [email protected]:/etc/docker

[root@maseter tls]# scp key.pem [email protected]:/etc/docker

在客户端查看查看docker版本

[root@localhost docker]# cd /etc/docker/

[root@localhost docker]#docker --tlsverify --tlscacert=ca.pem --tlscert=cert.pem --tlskey=key.pem -H tcp://master:2376 version

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-yXVBV2Lt-1601091015551)(C:\Users\19437\AppData\Roaming\Typora\typora-user-images\image-20200925163645642.png)]](http://img.e-com-net.com/image/info8/cbcd9de2ca7246c18804ed1ba56482a1.jpg)