在 Kubernetes 上搭建 EFK 日志收集系统

https://www.qikqiak.com/post/install-efk-stack-on-k8s/

Kubernetes 中比较流行的日志收集解决方案是 Elasticsearch、Fluentd 和 Kibana(EFK)技术栈,也是官方现在比较推荐的一种方案。

Elasticsearch 是一个实时的、分布式的可扩展的搜索引擎,允许进行全文、结构化搜索,它通常用于索引和搜索大量日志数据,也可用于搜索许多不同类型的文档。

Elasticsearch 通常与 Kibana 一起部署,Kibana 是 Elasticsearch 的一个功能强大的数据可视化 Dashboard,Kibana 允许你通过 web 界面来浏览 Elasticsearch 日志数据。

Fluentd是一个流行的开源数据收集器, 将在 Kubernetes 集群节点上安装 Fluentd,通过获取容器日志文件、过滤和转换日志数据,然后将数据传递到 Elasticsearch 集群,在该集群中对其进行索引和存储。

部署环境:

Kubernetes: v1.17.0

Elasticsearch : v7.5.2

Kibana : v7.5.2

Fluentd : v3.0.1

创建 Elasticsearch 集群

1.创建一个命名空间,在其中安装所有日志相关的资源对象

建一个 kube-logging.yaml

apiVersion: v1

kind: Namespace

metadata:

name: logging

然后通过 kubectl 创建该资源清单,创建一个名为 logging 的 namespace:

$ kubectl create -f kube-logging.yaml

namespace/logging created

$ kubectl get ns

NAME STATUS AGE

default Active 244d

istio-system Active 100d

kube-ops Active 179d

kube-public Active 244d

kube-system Active 244d

logging Active 4h

monitoring Active 35d

SVC资源文件

# elasticsearch-svc.yaml

kind: Service

apiVersion: v1

metadata:

name: elasticsearch

namespace: logging

labels:

app: elasticsearch

spec:

selector:

app: elasticsearch

clusterIP: None

ports:

- port: 9200

name: rest

- port: 9300

name: inter-node

Elasticsearch StatefulSet 资源清单文件

# elasticsearch-statefulset.yaml

apiVersion: apps/v1

kind: StatefulSet

metadata:

name: es

namespace: logging

spec:

serviceName: elasticsearch

replicas: 3

selector:

matchLabels:

app: elasticsearch

template:

metadata:

labels:

app: elasticsearch

spec:

nodeSelector:

es: log

initContainers:

- name: increase-vm-max-map

image: busybox

command: ["sysctl", "-w", "vm.max_map_count=262144"]

securityContext:

privileged: true

- name: increase-fd-ulimit

image: busybox

command: ["sh", "-c", "ulimit -n 65536"]

securityContext:

privileged: true

containers:

- name: elasticsearch

image: docker.elastic.co/elasticsearch/elasticsearch:7.6.2

ports:

- name: rest

containerPort: 9200

- name: inter

containerPort: 9300

resources:

limits:

cpu: 1000m

requests:

cpu: 1000m

volumeMounts:

- name: data

mountPath: /usr/share/elasticsearch/data

env:

- name: cluster.name

value: k8s-logs

- name: node.name

valueFrom:

fieldRef:

fieldPath: metadata.name

- name: cluster.initial_master_nodes

value: "es-0,es-1,es-2"

- name: discovery.zen.minimum_master_nodes

value: "2"

- name: discovery.seed_hosts

value: "elasticsearch"

- name: ES_JAVA_OPTS

value: "-Xms512m -Xmx512m"

- name: network.host

value: "0.0.0.0"

volumeClaimTemplates:

- metadata:

name: data

labels:

app: elasticsearch

spec:

accessModes: [ "ReadWriteOnce" ]

storageClassName: rook-ceph-block

resources:

requests:

storage: 50Gi

使用 kubectl 工具部署即可:

$ kubectl create -f elasticsearch-statefulset.yaml

$ kubectl create -f elasticsearch-svc.yaml

创建 Kibana 服务

定义两个资源对象,一个 Service 和 Deployment

# kibana.yaml

apiVersion: v1

kind: Service

metadata:

name: kibana

namespace: logging

labels:

app: kibana

spec:

ports:

- port: 5601

type: NodePort

selector:

app: kibana

---

apiVersion: apps/v1

kind: Deployment

metadata:

name: kibana

namespace: logging

labels:

app: kibana

spec:

selector:

matchLabels:

app: kibana

template:

metadata:

labels:

app: kibana

spec:

nodeSelector:

es: log

containers:

- name: kibana

image: docker.elastic.co/kibana/kibana:7.6.2

resources:

limits:

cpu: 1000m

requests:

cpu: 1000m

env:

- name: ELASTICSEARCH_HOSTS

value: http://elasticsearch:9200

ports:

- containerPort: 5601

配置完成后,直接使用 kubectl 工具创建:

$ kubectl create -f kibana.yaml

创建完成后,可以查看 Kibana Pod 的运行状态:

$ kubectl get pods --namespace=logging

NAME READY STATUS RESTARTS AGE

es-0 1/1 Running 0 85m

es-1 1/1 Running 0 84m

es-2 1/1 Running 0 83m

kibana-5c565c47dd-xj4bd 1/1 Running 0 80m

$ kubectl get svc -n logging

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

elasticsearch ClusterIP None <none> 9200/TCP,9300/TCP 3h22m

kibana NodePort 10.111.223.99 <none> 5601:31139/TCP 3h20m

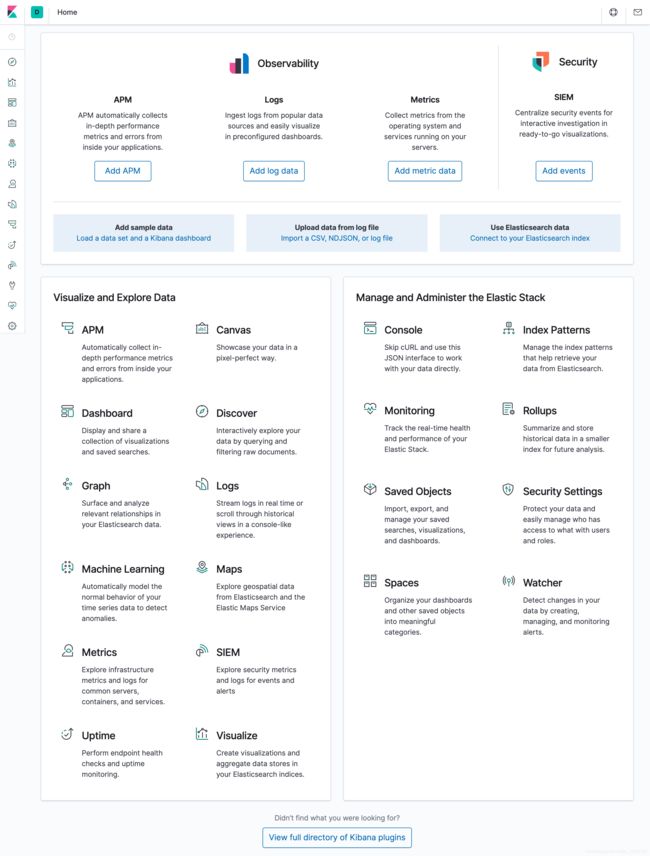

如果 Pod 已经是 Running 状态了,证明应用已经部署成功了,然后可以通过 NodePort 来访问 Kibana 这个服务,在浏览器中打开http://<任意节点IP>:31139即可,如果看到如下欢迎界面证明 Kibana 已经成功部署到了 Kubernetes集群之中

部署 Fluentd

Fluentd 是一个高效的日志聚合器,是用 Ruby 编写的,并且可以很好地扩展。对于大部分企业来说,Fluentd 足够高效并且消耗的资源相对较少,另外一个工具Fluent-bit更轻量级,占用资源更少,但是插件相对 Fluentd 来说不够丰富,所以整体来说,Fluentd 更加成熟,使用更加广泛,所以 这里也同样使用 Fluentd 来作为日志收集工具

工作原理

Fluentd 通过一组给定的数据源抓取日志数据,处理后(转换成结构化的数据格式)将它们转发给其他服务,比如 Elasticsearch、对象存储等等。Fluentd 支持超过300个日志存储和分析服务,所以在这方面是非常灵活的。主要运行步骤如下:

配置

通过 ConfigMap 对象来指定 Fluentd 配置文件,新建 fluentd-configmap.yaml 文件

kind: ConfigMap

apiVersion: v1

metadata:

name: fluentd-config

namespace: logging

data:

system.conf: |-

>

root_dir /tmp/fluentd-buffers/

>

containers.input.conf: |-

>

@id fluentd-containers.log

@type tail # Fluentd 内置的输入方式,其原理是不停地从源文件中获取新的日志。

path /var/log/containers/*.log # 挂载的服务器Docker容器日志地址

pos_file /var/log/es-containers.log.pos

tag raw.kubernetes.* # 设置日志标签

read_from_head true

> # 多行格式化成JSON

@type multi_format # 使用 multi-format-parser 解析器插件

>

format json # JSON解析器

time_key time # 指定事件时间的时间字段

time_format %Y-%m-%dT%H:%M:%S.%NZ # 时间格式

>

>

format /^(?>.+) (?>stdout|stderr) [^ ]* (?>.*)$/

time_format %Y-%m-%dT%H:%M:%S.%N%:z

>

>

>

# 在日志输出中检测异常,并将其作为一条日志转发

# https://github.com/GoogleCloudPlatform/fluent-plugin-detect-exceptions

> # 匹配tag为raw.kubernetes.**日志信息

@id raw.kubernetes

@type detect_exceptions # 使用detect-exceptions插件处理异常栈信息

remove_tag_prefix raw # 移除 raw 前缀

message log

stream stream

multiline_flush_interval 5

max_bytes 500000

max_lines 1000

>

> # 拼接日志

@id filter_concat

@type concat # Fluentd Filter 插件,用于连接多个事件中分隔的多行日志。

key message

multiline_end_regexp /\n$/ # 以换行符“\n”拼接

separator ""

>

# 添加 Kubernetes metadata 数据

>

@id filter_kubernetes_metadata

@type kubernetes_metadata

>

# 修复 ES 中的 JSON 字段

# 插件地址:https://github.com/repeatedly/fluent-plugin-multi-format-parser

>

@id filter_parser

@type parser # multi-format-parser多格式解析器插件

key_name log # 在要解析的记录中指定字段名称。

reserve_data true # 在解析结果中保留原始键值对。

remove_key_name_field true # key_name 解析成功后删除字段。

>

@type multi_format

>

format json

>

>

format none

>

>

>

# 删除一些多余的属性

>

@type record_transformer

remove_keys $.docker.container_id,$.kubernetes.container_image_id,$.kubernetes.pod_id,$.kubernetes.namespace_id,$.kubernetes.master_url,$.kubernetes.labels.pod-template-hash

>

# 只保留具有logging=true标签的Pod日志

>

@id filter_log

@type grep

>

key $.kubernetes.labels.logging

pattern ^true$

>

>

###### 监听配置,一般用于日志聚合用 ######

forward.input.conf: |-

# 监听通过TCP发送的消息

>

@id forward

@type forward

>

output.conf: |-

>

@id elasticsearch

@type elasticsearch

@log_level info

include_tag_key true

host elasticsearch

port 9200

logstash_format true

logstash_prefix k8s # 设置 index 前缀为 k8s

request_timeout 30s

>

@type file

path /var/log/fluentd-buffers/kubernetes.system.buffer

flush_mode interval

retry_type exponential_backoff

flush_thread_count 2

flush_interval 5s

retry_forever

retry_max_interval 30

chunk_limit_size 2M

queue_limit_length 8

overflow_action block

>

>

配置文件中 只配置了 docker 容器日志目录,收集到数据经过处理后发送到 elasticsearch:9200 服务

然后新建一个 fluentd-daemonset.yaml 的文件

apiVersion: v1

kind: ServiceAccount

metadata:

name: fluentd-es

namespace: logging

labels:

k8s-app: fluentd-es

kubernetes.io/cluster-service: "true"

addonmanager.kubernetes.io/mode: Reconcile

---

kind: ClusterRole

apiVersion: rbac.authorization.k8s.io/v1

metadata:

name: fluentd-es

labels:

k8s-app: fluentd-es

kubernetes.io/cluster-service: "true"

addonmanager.kubernetes.io/mode: Reconcile

rules:

- apiGroups:

- ""

resources:

- "namespaces"

- "pods"

verbs:

- "get"

- "watch"

- "list"

---

kind: ClusterRoleBinding

apiVersion: rbac.authorization.k8s.io/v1

metadata:

name: fluentd-es

labels:

k8s-app: fluentd-es

kubernetes.io/cluster-service: "true"

addonmanager.kubernetes.io/mode: Reconcile

subjects:

- kind: ServiceAccount

name: fluentd-es

namespace: logging

apiGroup: ""

roleRef:

kind: ClusterRole

name: fluentd-es

apiGroup: ""

---

apiVersion: apps/v1

kind: DaemonSet

metadata:

name: fluentd-es

namespace: logging

labels:

k8s-app: fluentd-es

kubernetes.io/cluster-service: "true"

addonmanager.kubernetes.io/mode: Reconcile

spec:

selector:

matchLabels:

k8s-app: fluentd-es

template:

metadata:

labels:

k8s-app: fluentd-es

kubernetes.io/cluster-service: "true"

# 此注释确保如果节点被驱逐,fluentd不会被驱逐,支持关键的基于 pod 注释的优先级方案。

annotations:

scheduler.alpha.kubernetes.io/critical-pod: ''

spec:

serviceAccountName: fluentd-es

containers:

- name: fluentd-es

image: quay.io/fluentd_elasticsearch/fluentd:v3.0.1

env:

- name: FLUENTD_ARGS

value: --no-supervisor -q

resources:

limits:

memory: 500Mi

requests:

cpu: 100m

memory: 200Mi

volumeMounts:

- name: varlog

mountPath: /var/log

- name: varlibdockercontainers

mountPath: /data/docker/containers

readOnly: true

- name: config-volume

mountPath: /etc/fluent/config.d

nodeSelector:

beta.kubernetes.io/fluentd-ds-ready: "true"

tolerations:

- operator: Exists

terminationGracePeriodSeconds: 30

volumes:

- name: varlog

hostPath:

path: /var/log

- name: varlibdockercontainers

hostPath:

path: /data/docker/containers

- name: config-volume

configMap:

name: fluentd-config

为了能够灵活控制哪些节点的日志可以被收集,所以 这里还添加了一个 nodSelector 属性:

nodeSelector:

beta.kubernetes.io/fluentd-ds-ready: "true"

# 意思就是要想采集节点的日志,那么 就需要给节点打上上面的标签

如果你需要在其他节点上采集日志,则需要给对应节点打上标签

$ kubectl label nodes $NodeName beta.kubernetes.io/fluentd-ds-ready=true

另外需要注意的地方是,我这里的测试环境更改了 docker 的根目录:

$ docker info

...

Docker Root Dir: /data/docker

...

所以上面要获取 docker 的容器目录需要更改成/data/docker/containers,这个地方非常重要,当然如果你没有更改 docker 根目录则使用默认的/var/lib/docker/containers目录即可

分别创建上面的 ConfigMap 对象和 DaemonSet:

$ kubectl create -f fluentd-configmap.yaml

$ kubectl create -f fluentd-daemonset.yaml

创建完成后,查看对应的 Pods 列表,检查是否部署成功:

$ kubectl get pods -n logging

NAME READY STATUS RESTARTS AGE

es-0 1/1 Running 0 108m

es-1 1/1 Running 0 107m

es-2 1/1 Running 0 106m

fluentd-es-h4jl2 1/1 Running 0 100m

fluentd-es-vngmd 1/1 Running 0 100m

kibana-5c565c47dd-xj4bd 1/1 Running 0 103m

Fluentd 启动成功后,这个时候就可以发送日志到 ES 了,但是这里是过滤了只采集具有 logging=true 标签的 Pod 日志,所以现在还没有任何数据会被采集。

下面 部署一个简单的测试应用, 新建 counter.yaml 文件,文件内容如下:

apiVersion: v1

kind: Pod

metadata:

name: counter

labels:

logging: "true" # 一定要具有该标签才会被采集

spec:

containers:

- name: count

image: busybox

args: [/bin/sh, -c,

'i=0; while true; do echo "$i: $(date)"; i=$((i+1)); sleep 1; done']

该 Pod 只是简单将日志信息打印到 stdout,所以正常来说 Fluentd 会收集到这个日志数据,在 Kibana 中也就可以找到对应的日志数据了,使用 kubectl 工具创建该 Pod:

$ kubectl create -f counter.yaml

$ kubectl get pods

NAME READY STATUS RESTARTS AGE

counter 1/1 Running 0 9h

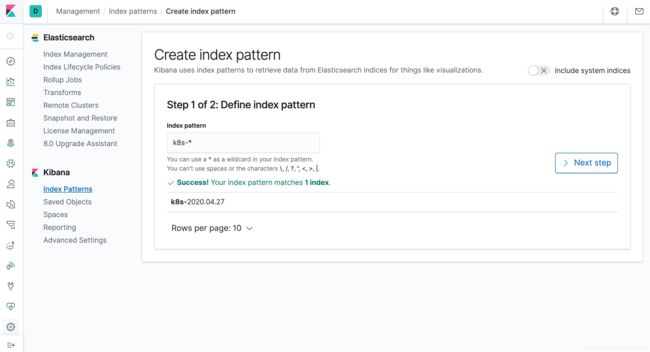

Pod 创建并运行后,回到 Kibana Dashboard 页面,点击左侧最下面的 management 图标,然后点击 Kibana 下面的 Index Patterns 开始导入索引数据:

在这里可以配置需要的 Elasticsearch 索引,前面 Fluentd 配置文件中采集的日志使用的是 logstash 格式,定义了一个 k8s 的前缀,所以这里只需要在文本框中输入k8s-*即可匹配到 Elasticsearch 集群中采集的 Kubernetes 集群日志数据,然后点击下一步,进入以下页面:

日志展示

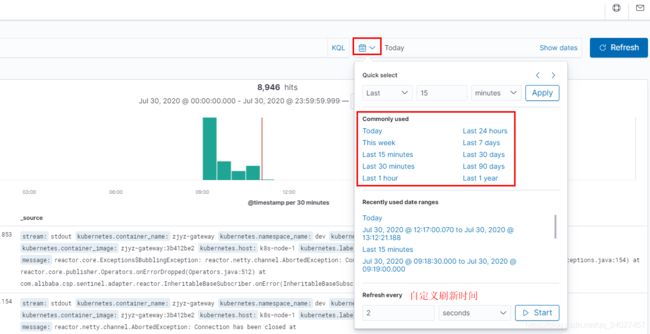

点击左侧导航菜单中的Discover,然后就可以看到一些直方图和最近采集到的日志数据了:

筛选过滤:

点击Search搜索框–>点击-“kubernetes.container_name.keyword”–>点击"equals some value"–>选择要查看的项目名称

- 1.选择查询关键字

- 2.更新查询条件

- 3.自定义日志展示字段

- 设置刷新时间间隔