李松南:智能全真时代的多媒体技术——关于8K、沉浸式和人工智能的思考

点击上方“LiveVideoStack”关注我们

视觉体验在全真时代显得越发重要,如何提高用户的视觉体验?更好的编码标准带来的低码率高画质、超分等视频处理手段带来的画质提升、三维视频带来深度感知、任意视点视频或者VR360视频带来的用户交互、扩展现实与虚拟现实带来的超现实感;另一方面,智能时代革新了音视频技术,通过音视频分析更好的理解数据与连接用户、通过辅助创作让音视频内容极大丰富。LiveVideoStack2021北京站邀请到腾讯多媒体实验室视频技术总监—李松南,带领我们一起发掘在全真时代与智能时代里多媒体技术的无限可能。

文/李松南

整理/LiveVideoStack

大家好,我叫李松南,来自腾讯多媒体实验室,我报告的题目是《智能全真时代的多媒体技术》,副标题是《关于8K、沉浸式和人工智能的思考》。我将结合在腾讯多媒体实验室的工作经验,跟大家在宏观维度上分享一下我个人对8K、沉浸式和人工智能的一点思考,不对的地方还请大家指正。

我的报告会分为三个部分,首先简单介绍一下多媒体实验室,以及实验室与腾讯云之间的关系。第二个部分介绍一下我对全真的理解,以及我们是如何通过增加视觉信息的维度,来提升沉浸感。第三部分介绍一下在智能时代,深度学习技术如何帮助我们更好的理解和生产多媒体信息。

1. 腾讯多媒体实验室

腾讯多媒体实验室是腾讯云与智慧产业事业群下属的一个实验室,负责人是腾讯杰出科学家刘杉博士。实验室的工作内容主要分为两大类,一类是是多媒体标准的制定,另外一类是对产品的技术支持。在这幅图里,左侧是实验室参与到的国际、国内各种标准组织以及工业论坛的图标,这里有一些可能是大家比较熟悉的,比如ITU、ISO/IEC、MPEG、开放媒体联盟AOM,做编解码的都比较熟悉;3GPP、IEFT,做通讯的都比较熟。右侧是实验室支持到的腾讯内外部产品的logo,其中就包括腾讯云在内。腾讯云是实验室非常重要的合作伙伴,实验室的很多技术,比如视频编解码、视频处理、全景视频、场景三维重建等,都在通过腾讯云进行输出。中间圆形的图案说明实验室在围绕着标准建设的同时,在三个技术方向上为产品提供服务,这三个方向分别是多媒体引擎压缩与传输通信、互动沉浸式媒体,以及智慧融合媒体。多媒体引擎压缩与传输通讯,最主要的研究方向是视频编解码;互动沉浸式媒体,研究内容包含全景视频、自由视角视频、物体和场景的三维重建等等;智慧融合媒体的研究内容主要是多媒体的处理、理解和生产,我个人主要负责智慧融合媒体部分。接下来我要介绍的内容主要来自我在实验室这些年以来的工作经历,以及平日的一些观察和思考,希望对大家有所启发。

2. 全真时代——从8K到沉浸式

继PC互联网、消费互联网、产业互联网之后,马化腾先生又提出了全真互联网的概念。每个人对全真的概念都有自己的解读,我在这里和大家分享一下我的思考。我会从连接、呈现与交互这几个角度来解读全真。从PC互联网、消费互联网、产业互联网再到全真互联网,从“连接”这个角度看,“连接”得变得越来越广泛、越来越全面;从“呈现与交互”这个角度看,“呈现和交互”变得越来越自然、越来越真实。所以更全面的链接和更真实的呈现与交互,是我个人对“全真”的解读。

从连接的角度看。PC互联网、消费互联网,连接的是人与信息,人与服务。我们可以在互联网上搜索信息,购买商品,购买服务,这些都已经成为我们日常生活的一部分。在产业互联网里,我们希望连接万事万物,我们希望真实世界的东西都可以通过互联网进行访问、进行操控,让一切通过互联网、通过AI变得数字化、智能化,比如智慧家居、智慧小区、智慧学校、智慧城市、智慧交通、智慧工业等等。这也逐渐在变为现实。到了全真互联网,我们希望可以把真实世界和虚拟世界进行连接,我们希望可以做数字孪生,创建元宇宙,把真实世界的东西复制到元宇宙,同时创造很多专属于虚拟世界的东西,区块链技术让虚拟世界的东西也可以独一无二,这样就使得虚拟世界中的物品变得更有价值,可能会在全真时代、在元宇宙里开启很多全新的商业模式。

所以,从连接的角度,连接的范围会越来越广,连接的对象会越来越全。接下来,从“交互”这个维度来讲,不管是人与机器之间的交互还是人与人之间的交互,都会变得越来越便捷,越来越真实。人与机器的交流越来越像人与人之间的交流。这里给出了一个人机交互技术的发展路径。人机交互从最早使用打孔卡,到今天仍然在使用的鼠标键盘,到移动互联网时代的触摸屏,再到智能时代的语音、动作,机器可以识别你讲的话、你的手势、你的目光,再到因为Neuralink变得非常受人瞩目的脑机接口,以及Meta(Facebook)、苹果为他们的VR头盔、AR眼镜开发的肌电感知手环、肌电指环等等。大家都切身的体会到,人机交互变得越来越方便,越来越真实,越来越像人与人之间的交互,甚至做到超越。另外一方面,人与人之间的远程交互也有变得越来越像面对面的交互。最开始我们只能通过信件的方式来跟远方的朋友、亲人通信,19世纪初有了电报,19世纪中后期又有了电话,现在有了互联网、有了宽带、有了5G,我们更习惯打开摄像头,用视频的方式和远方的亲友聊天、和同事开会、在手机和电视上看比赛直播等等,当网络带宽进一步提高,AR/VR普及以后,我们可能会带着VR头盔、AR眼镜跟远方的亲人、朋友、同事沟通,感觉就像他们坐在我们对面一样。光场显示设备甚至可以让我们不需要佩戴观看设备实现6DoF的观看体验。所以交互,不管是人机交互还是人与人之间的远程交互,都变的越来越真实。

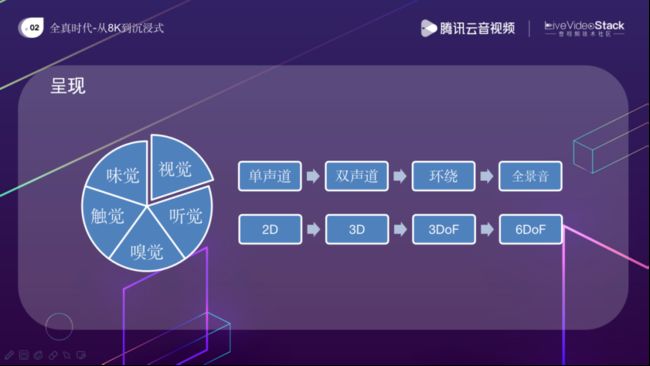

除了“交互”以外,“呈现”也会变得越来越真实。今天我们在互联网上消费的内容主要还是音视频,依赖的是我们的视觉和听觉。有些虚拟现实设备,比如VR手套、VR背心,还会给我一些触觉的反馈。我也接触过一些公司,他们的设备可以合成多种气味,利用到的是我们的嗅觉。利用味觉的设备也有,大家可以在网上搜索一下。所以说,呈现的方式在全真时代会变的越来越丰富,越来越真实。从视觉和听觉的角度讲,我们已经有非常多的体会了。声音上我们从单声道、到立体声、到环绕声、再到全景音。视觉上,从2D到3D、到3DoF、再到我们可以在VR游戏中体验到的6DoF。我们可以切身的体会到,呈现的真实感在不断的增强。这些就是我个人对全真的理解:“连接”体现出的全面以及“交互和呈现”体现出来的真实。因为我在多媒体实验室的工作内容主要与视觉相关,所以接下来我会更具体的讲一讲“视觉”这块的内容,从2D到6DoF,我们可以用哪些技术来提升视觉的真实感、沉浸感。

我们在手机和电视上看到的主要还是2D的图像或者视频。如何提高2D视频的真实感、沉浸感呢?最直接的方式是扩大视角、增加视频的分辨率。在坐的很多人肯定都看过IMAX电影,可能有些家里的电视是4K甚至8K的,当你坐在巨大的屏幕前面,满眼充斥的都是视频内容,你的沉浸感就会很强。为了在大屏前播放视频,屏幕和视频分辨率要足够大,否则视频会有明显的模糊感或者颗粒感。那么如何在带宽有限的前提下来提升视频的分辨率呢,我们需要用到视频编解码。

为了支持大分辨率、高动态范围,我们通常会使用更新的编码标准。比如编码8K、HDR的视频,我们不能用264,只能用265,如果266普及了,我们可能还会用266。最主要的原因是节省码率,因为每一代编码标准都会比它的上一代节省几乎一半的码率。码率降低以后延迟和卡顿也会相应的降低。除了主流的26X标准之外,还有两个系列的标准实验室也有参与,分别是谷歌、AOM的VP9、AV1、AV2,还有我们的国标AVS,从AVS,AVS+,AVS2,到AVS3。这些标准的共性之一是对大分辨率的视频支持的越来越好,这一点从块划分方式上就可以看出来。比如,264只支持16x16的宏块,265支持64x64的编码树单元,266支持128x128的编码树单元。所以编码高分辨率的视频,我们需要尽可能的利用新的编码标准。当然采用哪种编码标准除了考虑压缩效率还需要考虑其他因素,比如硬件的支持、专利的风险等等。

除了使用更新的编码标准之外,我们还可以考虑使用针对不同应用场景的特定编码工具来提高编码效率,也就是所谓的场景编码。这里给的一个场景编码例子是屏幕内容编码。屏幕内容编码在很多标准中都有支持。屏幕内容和摄像头拍摄的视频内容有很大的不同。屏幕内容通常没有噪声、静态居多、色调单一、边界锐利,有很多平滑区域、图像内部有很多重复等等。利用这些特点我们可以开发出具有针对性的编码工具,比如帧内块拷贝、调色板编码等等。用这些技术可以极大的提高编码效率,在码率不变甚至码率变少的情况下,可以提供更高的分辨率。

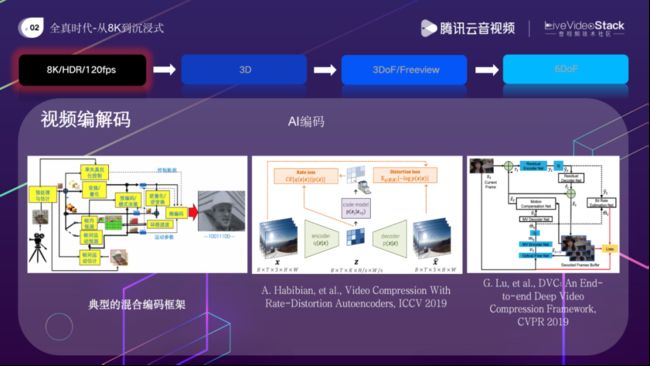

除了场景编码以外,很多学者在尝试使用深度学习来提升编码效率。最左边的图是目前编解码标准中普遍采用的混合编码框架,结合了预测、变换、熵编码等等一些传统信号处理的工具。虽然编码标准一直在不断的迭代,但从H.261开始的混合编码框架,一直沿用到现在。基于神经网络来做视频编码最早可以追溯到八十年代,但那个时候的神经网络只有两、三层,所以效果不是很好。进入到深度学习时代以后,越来越多的学者开始使用更深的神经网络来做编码,比如,有些会使用像中间这幅图展示的autoencoder自编码器这样的结构,有些还会沿用混合编码框架,但用深度神经网络提高部分模块,比如环路滤波、帧间帧内预测、编码模式决策等等。还有一些工作把混合编码框架中所有的模块全部用深度学习替代,实现了端到端的训练,取得了优于传统方法的压缩效率。

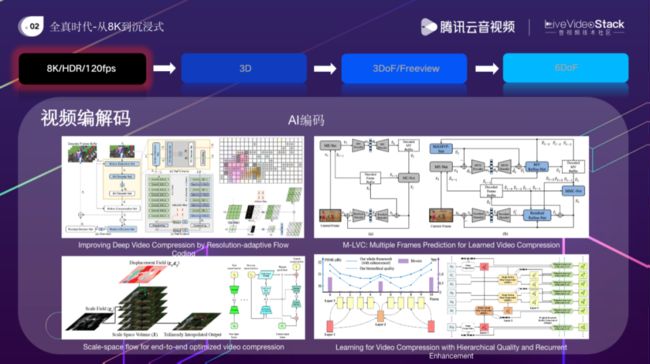

这页PPT中给出了四个实现了端到端编码的例子,其中有些对运动向量的编码方式进行了优化,有些使用了比较创新的帧间对齐方法,有些使用了多参考帧,有些使用了双向参考帧以及层级参考。具体的技术细节就不在这里讨论了。总之已经有很多工作证明了,深度学习应用在视频编解码上是可以提高编码效率的。目前也有很多标准组织在做这方面的规划,比如JEPG AI、JVET NVCC、IEEE FVC等等,都在调研基于AI的编码标准。目前把AI应用在编解码的最大障碍在编解码的复杂度,使用深度学习可能会使得编解码的复杂度提升几十倍、上百倍、甚至上千倍。同时传统方法仍然有进一步的提升空间,所以AI在视频编解码中的应用可能还需要一段时间。

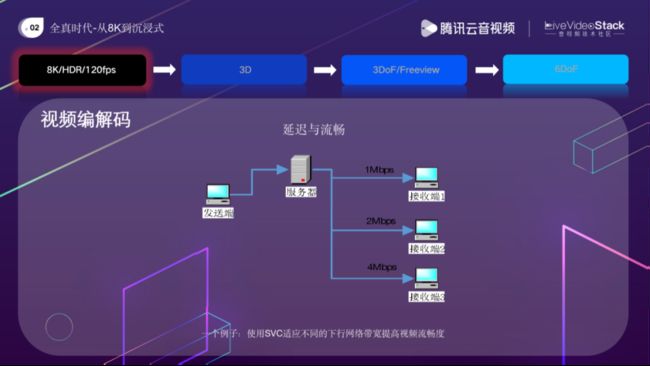

刚才讲到可以通过场景编码、AI编码来提高视频画质。除了画质以外,另外两个影响用户体验的重要因素是延迟和流畅度,或者延迟与卡顿程度。画质好,延迟低、流畅无卡顿,这种视觉体验让我们更有沉浸感。有非常多的手段来减少延迟卡顿。有些是和网络传输相关的,比如结合应用场景使用更适合的传输协议,使用前向纠错减少丢包卡顿等等。有些是和编解码相关的,使用一些编解码工具也可以减少延时和卡顿。比如自适应参考帧技术,当解码端发现有某个参考帧丢失,可以通知编码端,不再用这个丢失的帧作为后续帧的参考帧。再比如这里介绍的可伸缩编码技术。在直播和RTC等场景中,下行带宽通常变化很大,比如像这个图中展示的,有1Mbps的、2Mbps、4Mbps的不等。如果编码端只考虑最高的下行带宽,编码4Mbps的码率,那么1Mbps和2Mbps的用户,就会很卡。如果编码端用1Mbps的,那么2Mbps和4Mbps的客户,他们的带宽就没有被充分利用,大家看到的画面就都很糊。如果发送端同时提供1Mbps、2Mbps、4Mbps的码流,又会造成发送端上行带宽的增加,同时发送端的编码计算量也会增加。还有一种方案是在服务器端做转码,但这样会增加服务器的计算压力,同时也会增加延迟。

在这种情况下,我们可以使用可伸缩视频编码技术SVC。编码端编码出一套分层的码流,比如如图所示的三层码流,这里我们用不同的颜色表示不同的层,红色是layer0,蓝色是layer1,绿色是layer2。解码端可以根据它的带宽情况,选择只使用部分码流,如果它网络差的话,可以只使用layer0,如果网络一般可以使用layer0和layer1,网络好的话三层都可以用起来。这样就避免了只传输一路码流造成的解码端的卡顿或者带宽浪费,也避免了需要服务器进行转码造成的计算消耗以及引入的延时。

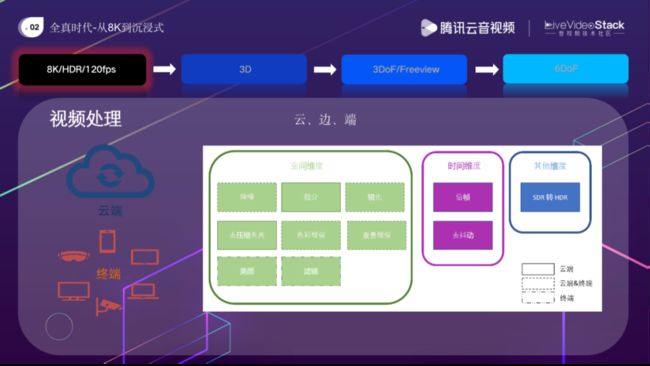

除了视频编解码以外,视频的前后处理也可以帮我们提高视频的画质,让老的视频素材可以焕发新生。我们可以通过视频增强来提高视频的分辨率、动态范围、帧率等等。让标清、高清、SDR,30fps的视频,变成4K、8K、HDR、60或者120fps的视频,让处理后的视屏更适合在大屏上播放。

除了视频增强以外,我们还希望可以通过视频修复来来去除视频中存在的各种失真。这些失真是从视频采集到播放的各个过程中带来的。比如,在视频采集的过程中不可避免的会带来噪声,视频压缩的过程会带来压缩失真,传输过程可能会有丢包带来的失真,像胶片这样的存储介质老化、受损也会带来色偏、划痕、污渍这样的失真。我们希望通过视频修复算法来减弱甚至去除这些失真,同时尽可能的保留视频内容。

视频处理可以在终端实现,也可以在云端实现,两者的区别主要在于算力,云端通常有比较充分的算力来使用深度学习技术,而终端虽然算力也在提升,但因为功耗等原因,使用基于信号处理的传统方法更多。实验室从13年开始做视频处理,目前已经积累了很多中视频处理能力,其中有很多已经被集成到了腾讯云上,有这方面需求的朋友可以直接在腾讯云上体验。

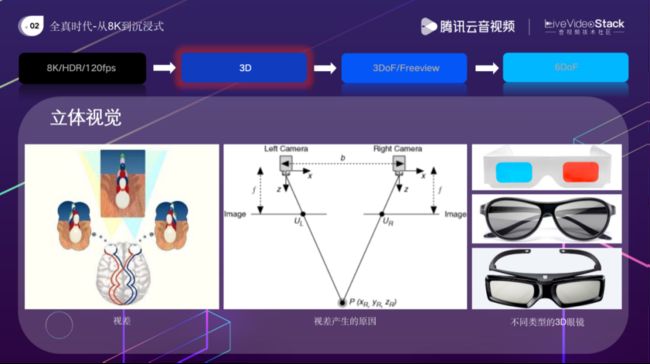

刚才我介绍了如何通过视频编码、视频处理技术来提高2D视频的沉浸感。为了进一步提高视频的沉浸感,我们可以把2D的内容变为3D的,增加立体感。视觉的立体感来自很多方面,比如近大远小、遮挡、运动视差等等,但最重要的来源是两眼的视差,如左边的图展示的,左右眼看到的画面其实是稍有不同的,原因从中间的图可以看出来,左右两个摄像头可以认为是我们的两只眼睛,一个三维点P在左侧画面和右侧画面上的投影点是不一样,投影点的差异代表的就是所谓的视差,因为有视差,我们才有了对深度的感知,才有了立体感。相信在座的大部分朋友都在影院看过3D电影,看3D电影的时候我们需要戴眼镜,戴眼镜的目的就是为了分离出带有视差的两幅画面,分别送给左眼和右眼,让我们有立体感。最早影院里是用红蓝眼镜来分离左眼和右眼画面的,我上小学的时候看过一次这样的电影,电影内容已经记不清楚了,印象比较深刻的是看完以后觉得特别晕。现在影院里用的是偏振光的镜片,很轻,左右眼的颜色、亮度都比较一致,所以现在在影院看到3D电影已经不会再感觉到不舒服了。

为了生产3D视频我们可以用双目摄像头进行拍摄,早期很多电影是用双目摄像头拍摄的,因为和传统的电影拍摄流程不通,所以拍摄成本可能有10倍以上的增加。所以现在很多的3D电影其实是通过2D转3D技术生产出来的。将2D视频转换为3D视频,需要我们为左眼和右眼生成两路带有视差的视频。为了正确的生成带有视差的视频,我们需要生成视频中每帧图像的深度图作为中间结果,辅助我们生成带有视差的两路视频。有很多工作在结合多视图几何与深度学习来估计视频的深度,这里给出了几个例子,感兴趣的朋友可以搜索一下看看。

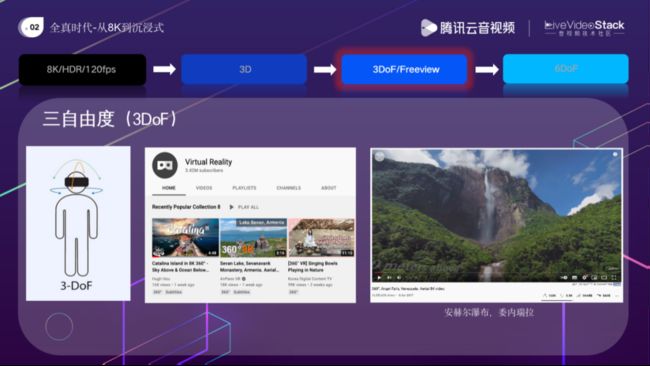

除了3D,我们还可以通过3DoF来提升沉浸感。3DoF是三自由度的缩写,头在围绕XYZ三个方向的轴转动的时候,画面内容会跟着变。VR360视频就是三自由度的,VR360视频已经越来越普及了。目前最大的VR360平台是Youtube,Youtube自己的VR官方账号,Virtual Reality,已经有超过300万的订阅者。Youtube上目前观看最多的VR影片是这个关于天使瀑布的短片,这个瀑布接近1000米,是世界上最高的瀑布,由于落差太大,水从瀑布上流下时,在落地之前会散开成雨状,因此瀑布底部没有水潭,是难得一见的景观,这个视频的观看次数超过1千6百万次。

刚才介绍了3D和3DoF,是否可以把两个结合起来实现立体的三自由度?是完全可以的,在网络上也可以找很多这样的视频内容。那如何实现呢?是不是简单的用两个全景摄像头,并排放在一起同时拍摄就可以了呢?左图展示的是这用情况,红色和蓝色表示并排放置的两个全景摄像头拍摄到的内容,可以看到,拍摄摄像头中心连线垂直方向可以有正确的视差,但在拍摄摄像头中心连线方向的物体时,就完全没有视差了,因此就体会不到立体效果。为了实现立体三自由度我们需要采集非常多的全景画面,就像中间这幅图中展示的这样,对于这些灰色的轨迹点,每一个点上都需要记录左右眼看到的全景画面,这样需要记录的数据量就非常大,也为后续的传输、渲染过程造成很大的负担。一种折中的方式是使用这种Omni-Directional Stereo(ODS)的方式进行记录,这种方式只需要生成两个全景视频,除了数据生成过程之外,后续的传输、渲染都与普通的VR360视频渲染过程差别不大。

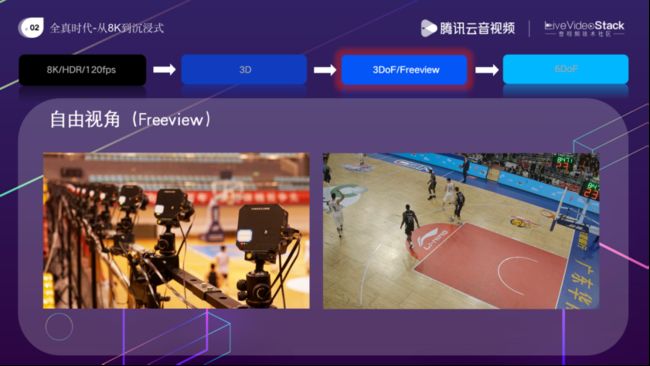

除了3D、三自由度以外,还有一种可以增强沉浸感的技术是自由视角,今年的东京奥运会已经大量的使用了这个技术,明年的北京冬奥会也会使用这种技术。自由视角提供了一个子弹时间的体验,让大家可以从不同的角度欣赏视频内容,而且不需要佩戴VR头盔,普通显示器上就可以播放。

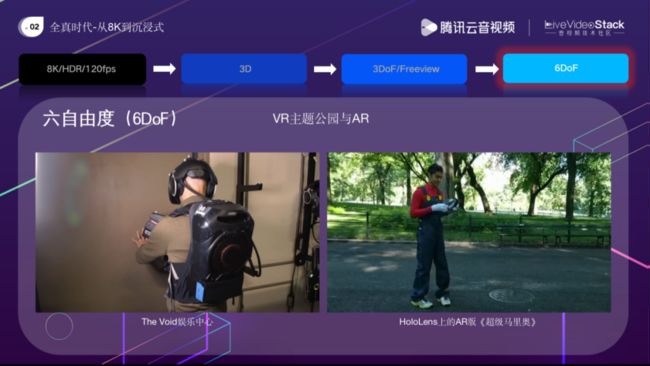

最后我们来看一下6DoF,6自由度。刚才讲到3自由度是指头部转动,我们可以看到不同内容,但我们在空间从一个位置换到另外一个位置的时候画面内容是不变的,这个我们在真实世界中的视觉体验是不同的。而6自由度就和我们在真实世界中的视觉体验是一致的,不管是你头部转动还是上下左右前后移动,看到的画面内容都是随着你的运动变化的。VR游戏是6自由度的。现在的VR头盔价格大幅下降,2000元左右就可以入手。显示分辨率、用户体验有比较大的提升。出现了很多一体机产品,不需要外设对头盔和手柄做定位,也不需要用有线的方式和PC机连在一起,使用起来更方便。VR内容上越来越丰富,出现了很多非常受欢迎的VR游戏,比如这个游戏叫《Beat saber》,用光剑来切方块,开发这款游戏的团队只有三个人,是一款非常成功的VR小游戏。3AVR大作目前最受认可的是《半条命Alyx》,有些人说玩VR游戏不要一开始就玩《半条命Alyx》,否则会有“曾经沧海难为水”的感觉,玩其他VR游戏的时候会不自觉的对比,感觉其他VR游戏体验不够好。

更极致的沉浸式体验可以在VR主题公园中找到。比如这个视频里的是The Void娱乐中心。它可以让四位玩家共同对战敌人,每位玩家都需要穿上全套的VR装备,包括一个头戴显示器、一个定制的高科技背心,和一杆金属质感的枪械。进入游戏场地以后,最大的感受就是所谓的MR沉浸感,比如说,你能触摸和感觉到你所看到的墙和栅栏,当你看到一把椅子的时候,你也可以坐上去;另外,墙上的火把,你不但可以拿来照亮黑暗的走廊,还能够感受到它的热度。在剧情中,你能够实实在在的感受到被枪击中的冲击力,可以感受到微风、震动和温度的变化。

除了虚拟现实外,扩展现实的展现方式也是六自由度的。扩展现实是要把虚拟的物体添加到真实的场景中,比如这个例子是AR版的《超级马里奥》。因为透过眼镜看到的现实场景是6自由度的,所以我们叠加到真实场景中的虚拟内容也必须是6自由度的,我们需要定位AR眼镜在三维空间中的位置和角度,这个和VR头盔是非常类似的。但AR眼镜不能做的像VR头盔那么大,电池、电路板都要小很多。现在有很多AR眼镜会做成分离式的,AR眼镜和手机连在一起,计算都在手机上进行。

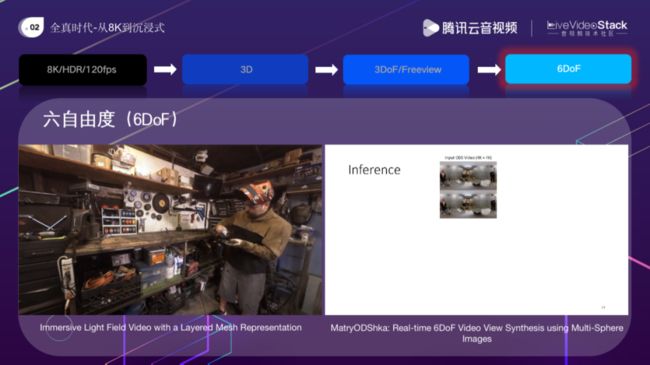

刚才提到的ARVR游戏,游戏里面的内容都是人造的,是通过三维建模、动画软件制作出来。如果我们希望可以将现实世界的东西制作成VR内容,用6自由度的方式观看,通常有两种方式,一种是做三维重建、三维渲染,另外一种方式是做光场采集、光场渲染。左面的图是一个立体捕捉设备,可以用来重建一个小规模的动态三维场景。右面的视频是个VR MV,可以在VR头盔中播放,在VR头盔里你可以从不同角度观察这个歌手的表演。

另外一种方式是光场采集,尽量多的捕捉从各个方向上打过来的光,再用他们来生成全新的视角。左边的这个工作用到了46个摄像头,这些摄像头分布在一个半球面上。把这些摄像头捕捉到的画面,送到深度模型中,可以用来生成多个层层嵌套的球面图像,每个球面图像除了有RGB信息外还有alpha通道,记录了这些球面图像的透明度信息。为了实现数据传输,文章还提出了对这些层层嵌套的球面图像进行压缩的方法,以及如何对压缩后生成的数据进行6自由度渲染的方法,对细节感兴趣的朋友可以阅读以下这篇文章。这是谷歌的工作,他们之前的工作是针对静态场景做采集和渲染的,这个工作可以对动态场景做采集和渲染。右面的工作来自布朗大学和CMU,他们提出了一种方法可以将ODS视频,也就是刚才提到的立体三自由度视频,转换为6自由度视频的方法,同样是用了深度模型,同样使用了层层嵌套的球面图像。因为层层嵌套的球面容易让人想起俄罗斯的套娃,所以这边工作也用“套娃”来给自己命名。

3. 智能时代—从理解到创作

刚才和大家分享了一些关于全真多媒体技术的思考,除了全真之外,我还想在这里和大家分享一些关于智能多媒体技术的思考。

人工智能在每个行业都有很多用途,在多媒体领域也一样。这个图里面给出了从媒体生产到消费的一个简单流程,AI在很多环节都可以发挥作用,比如做剪辑,审核、推荐、标签,质量评价等等,这些环节都可以利用到AI。这里有很多应用是和多媒体理解相关的,使用AI的目的是为了让我们可以更方便快速的理解多媒体数据中包含的语义信息,这些语义信息可以用来做审核、认证、推荐、搜索等等应用。AI除了被用在做多媒体理解之外,会越来越多的被用来做多媒体内容的创作。

大家都知道多媒体内容包含各种各样的形式,像视频、图片、声音、文字,三维点云、三维网格、光场信息等等。

按照算法的输入输出类型,我们可以把多媒体算法粗略的分为两大类,第一类算法如左图所示,它的输入是各种模态的多媒体数据,视频、图片、声音、文字等等,输出的是属性信息。可能是一个属性,也可能有多个属性,可能是离散值,也可能是连续值,可能是针对整体的,也可能是针对部分的。比如对于一幅图片,它可能代表图片的场景信息、图片中都有哪些物体,这些物体在什么位置等等,或者描述图片的质量,有没有过曝或者欠曝,噪声程度,美学程度等等。我们认为这些算法是和理解相关的,是理解类的算法。两外一类算法是和内容生产相关的,如右图所示,涉及到的是不同模态数据之间的转化,比如,输入是一段文字描述,输出是符合这段文字描述的一张图片。或者输入是一段视频,输出是这段视频的文字描述,等等。当然这里没有体现的情况是,无中生有的输出媒体内容。比如从一个噪声信号生成一张人脸图片。或者输入是某种属性,输出是媒体内容,比如指定一个音乐风格,生成一首具有该风格的音乐等等。理解类的算法有非常多的应用场景,很多算法也非常成熟了。内容生产类的算法应用场景也非常多,但相对而言技术成熟度还不高,所以在内容生产领域,学术界和工业就都开始有越来越多的投入。接下来我给出几个理解类和内容生产类算法的具体例子。

首先是理解类的算法。这页中给出的是图片的例子,包括图片分类、检测、分割,这些都是和理解相关的。分类是给整张图一个属性值。检测是对图片中的矩形框区域一些属性值。分割输出的是像素粒度的属性标注。

这页中给出的是关于文本的例子。可判断一段文字的情感属性,是正向的、中性的还是负面的,可以用来统计评论的情感倾向。再比如句法分析,判断一句话的句法结构,区分名词、动词、介词、动词性短语、动词性短语、介词性短语等等。最后一个例子是实体关系抽取,给一段文字,提取其中的实体词以及实体之间的关系,可以用来搭建知识图谱。

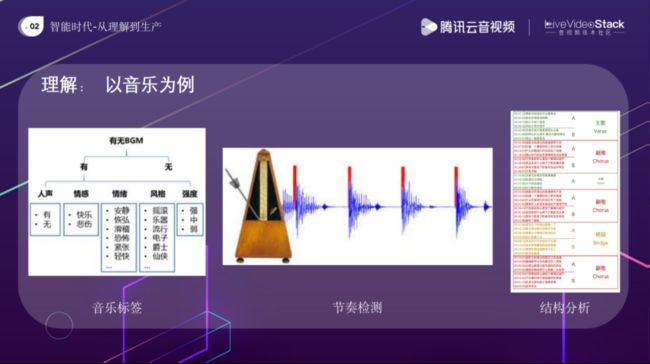

最后一页是和音乐理解相关的。比如音乐标签,给定一段音乐,算法可以判断这段音乐是否是纯音乐还是有人声的,可以给出情感、情绪、风格、强度这样的属性标签。再比如节奏检测,可以提取出音乐中的节拍位置,我们可以用这些节拍位置信息做视频编辑,让视频转场的位置与音乐节拍的位置匹配在一起,这样制作出来的视频会比较有节奏感。最右边的例子是音乐结构分析,判断一段音乐的主歌、副歌在一段歌曲中的的起止位置。

下面给几个内容生产的例子,这里我用视频作为算法的输入模态。首先是视频到视频的转化,输入和输出都是视频。刚才讲到的视频处理就是这样一个例子,输入是一段低质视频,输出是去除了失真、质量增强了的视频。这页PPT中还有其他三个例子。左边的横屏转竖屏,通过裁剪的方式,把视频中的显著区域裁剪出来,与添加黑边的方式相比,由于内容是全屏显示的,因此更有沉浸感。中间的例子是视频集锦,给一段90分钟的足球视频,我们可以分析出其中的精彩片段,像射门、进球这些通常可以认为是精彩片段,把精彩的部分拼接在一起做成一个精彩集锦,快速的生成短视频内容。右侧的例子是视频上色,输入一段黑白视频,输出一段彩色视频。

这页里的几个例子是视频到其他模态数据的转换。比如视频封面,给一段视频找到最具代表性的视频帧作为封面来提升视频点击量,这个是视频到图片的转换。左侧第二个例子是为视频生成标题和弹幕,这个是视频到文字的转换。第三个例子是视频配乐,我们可以到曲库中找到与一段视频最相衬的背景音乐。最右边的例子是使用Structure from Motion进行三维重建,给一段视频,生成视频中拍摄对象的三维网格模型。

刚才介绍的几个和视频相关的例子都来自于实验室的智媒平台。这页左边的图是OpenAI的工作,给一段文字,可以生成对应段文字的图片,比如这些图片对应的文字是:一张穿着西服的皮卡丘在看电视的图片,生成图片的质量还是很不错的。右侧是实验室为2021年的迪拜世博会做的水墨画小程序,用户输入山脉的线条,可以自动生成一幅水墨画。你还可以输出你的名字、昵称、或者其他文字,算法会根据这些文字生成一首诗。算法还会从曲库里选择一首合适的音乐作为你创作的这副图片的背景音乐。

有很多算法可以用无中生有的方式来创造内容。最有名的可能就是StyleGAN,可以把一段噪声信号,转化生成非常高清的人脸图片。类似的,也可以生成一段音乐,感兴趣的朋友可以搜索一下AIVA,一个AI作曲算法,网上有很多AIVA的作品。右侧是实验室的算法写的歌词,可以为作词者提供一些创作灵感。

好的,这就是我要分享的全部内容,感谢大家的聆听!右侧是刚才介绍的水墨画小程序,感兴趣的朋友可以扫码玩一玩。

讲师招募

LiveVideoStackCon 2022 音视频技术大会 上海站,正在面向社会公开招募讲师,无论你所处的公司大小,title高低,老鸟还是菜鸟,只要你的内容对技术人有帮助,其他都是次要的。欢迎通过 [email protected] 提交个人资料及议题描述,我们将会在24小时内给予反馈。

喜欢我们的内容就点个“在看”吧!