Hadoop (三) --------- Hadoop 运行环境搭建 (虚拟机)

目录

- 一、模板虚拟机环境准备

-

- 1. 配置电脑

- 2. 安装系统 (CentOS 7)

- 3. 虚拟机的使用引导界面

- 4. 切换root用户

- 5. 虚拟机网络配置

- 6. Windows的网络配置

- 7. 虚拟机网络IP修改地址配置

- 8. 修改主机名和hosts文件

- 9. 远程终端工具安装

- 10. 模板虚拟机额外配置

- 二、克隆虚拟机

-

- 1. 克隆三台虚拟机

- 2. 修改克隆机IP

- 3. 修改克隆机主机名

- 4. 在 hadoop102 安装 JDK

- 5. 在 hadoop102 安装 Hadoop

- 三、Hadoop 目录结构

一、模板虚拟机环境准备

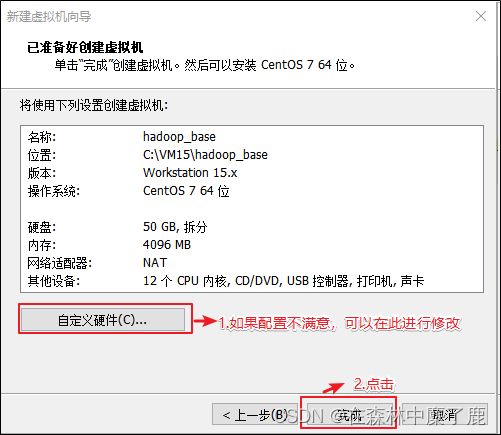

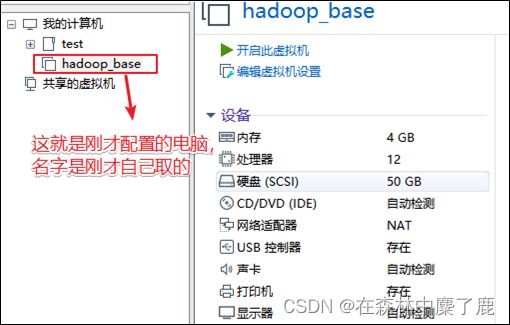

1. 配置电脑

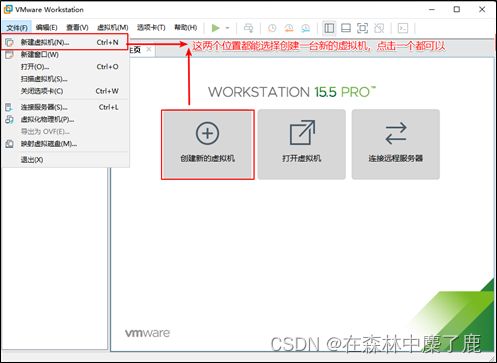

进入VMware

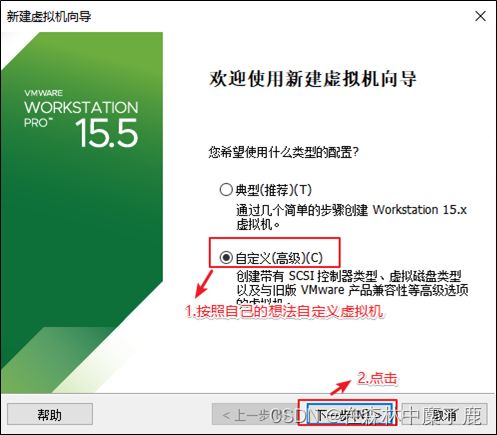

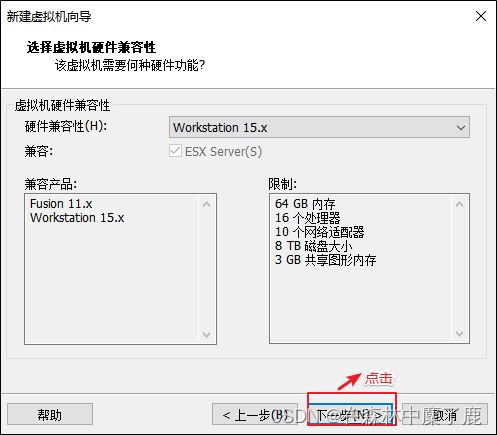

定义新的虚拟机

我们先配置电脑,再安装系统。

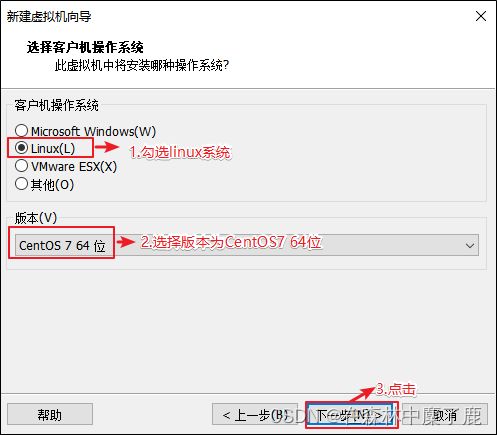

因为不同的操作系统需要解决不同的兼容性问题,所以需要选择将来用什么系统,提前做适配。

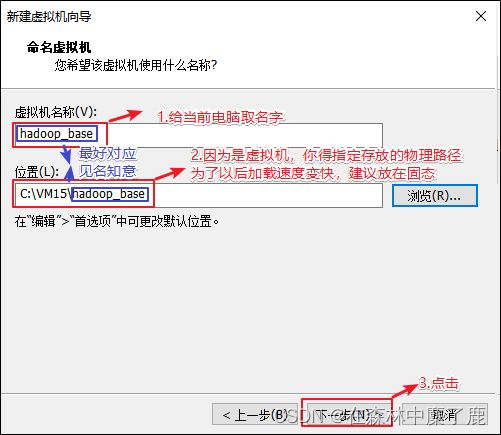

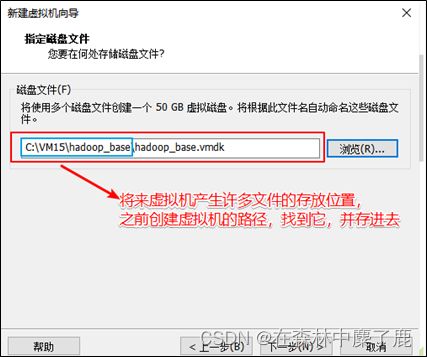

给自己配置电脑取个名字,并存放在物理机的位置在哪。

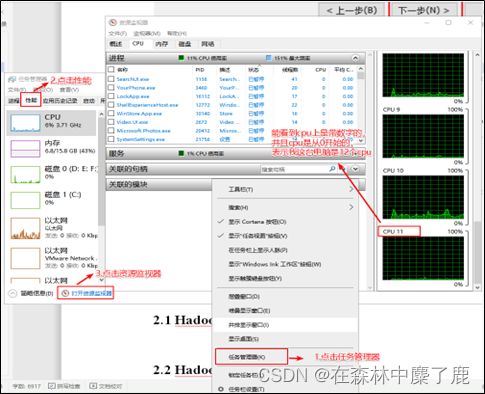

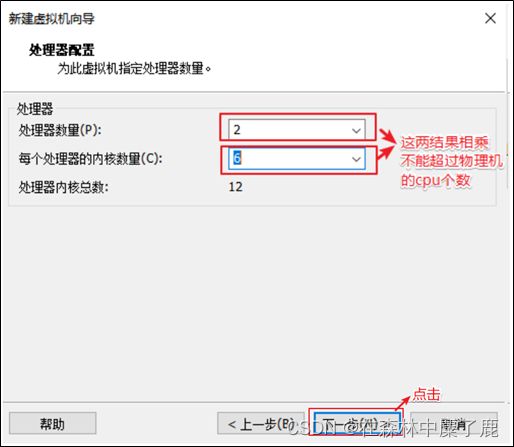

有个原则就是选满(跟物理机的CPU个数相同,但是不能超过)

查看物理机CPU个数(Windows10为例)

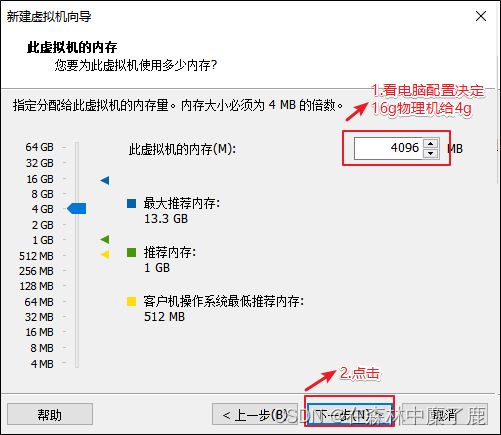

内存大小有一定要求,建议4G,不能给太多,后期会有多台虚拟机同时启动。

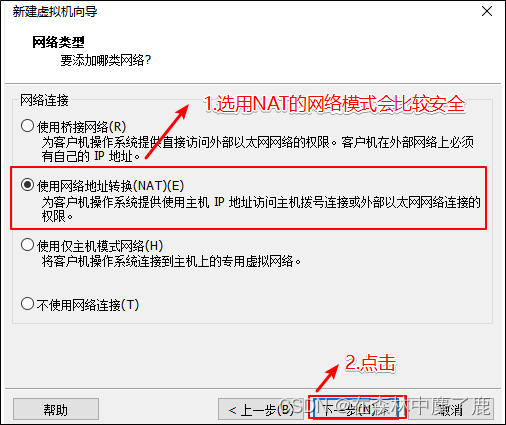

选择 NAT 的方式

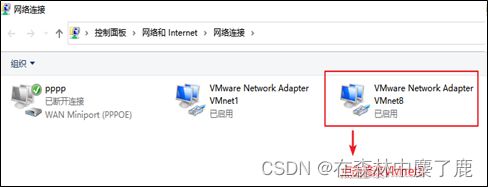

没有 VMware 之前物理机的网络适配器信息 (每个人不同,我只有3个)

![]()

安装 VMware 之后物理机的网络适配器信息 (会多两个vmnet1和vmnet8)

注:vmnet8是虚拟机使用NAT模式上网的网卡

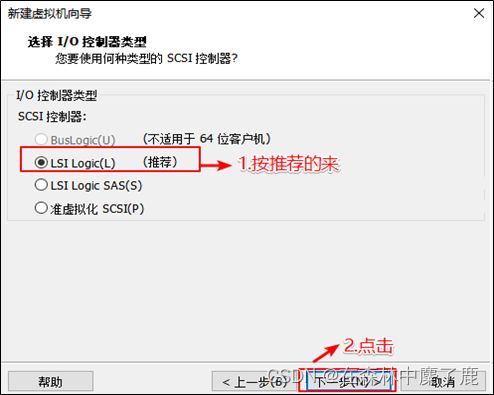

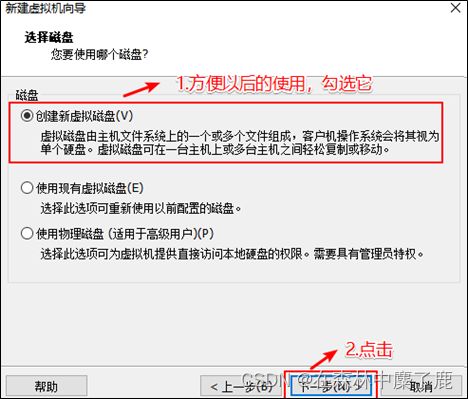

选择对应的文件系统的IO方式

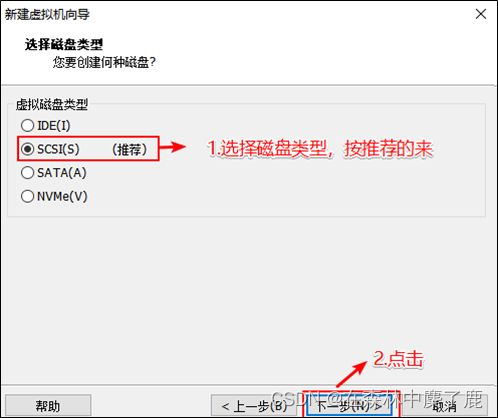

选择磁盘的类型

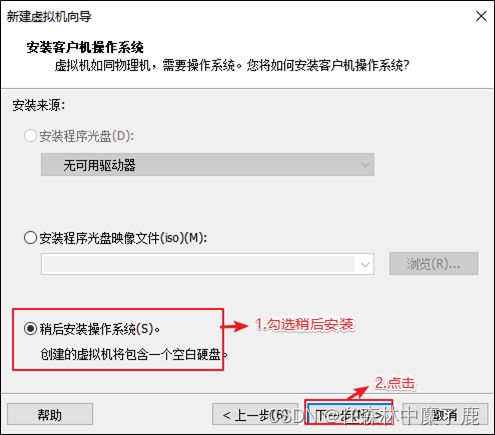

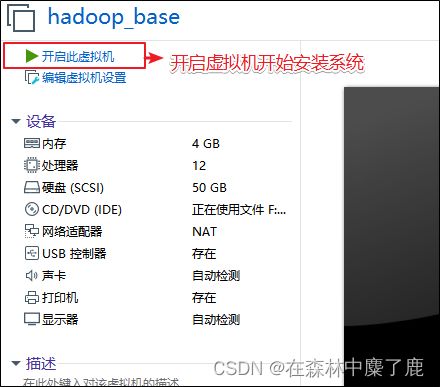

2. 安装系统 (CentOS 7)

注意:在安装系统之前需要检查自己虚拟机的bios的虚拟化是否打开

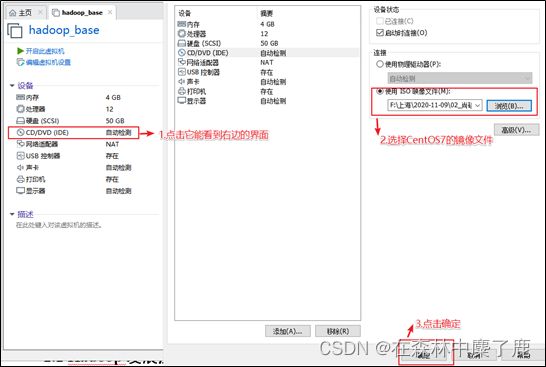

选择 CD/DVD 的方式安装系统

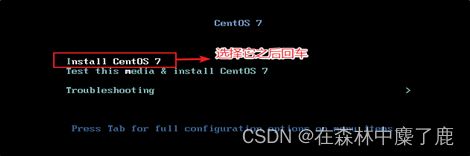

你得需要将鼠标点击进入界面中,但是鼠标会消失,你此刻得用键盘的上下键来控制选项,图标变白了表示当前选中的是哪个选项,然后敲回车,表示执行所选选项。

注意:如果这个时候你需要鼠标可以使用 ctrl+alt一起按呼出鼠标。

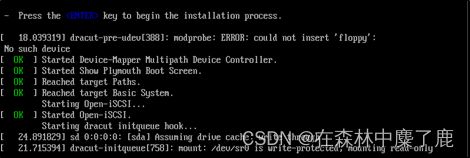

耐心等待它的安装

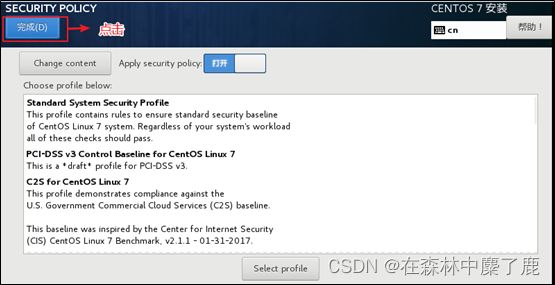

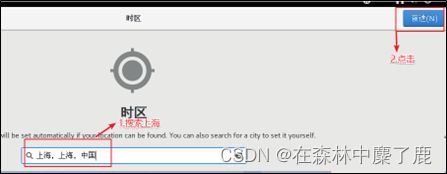

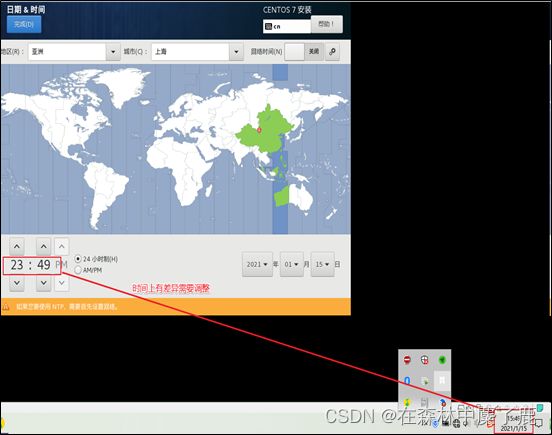

按照编号依次点击

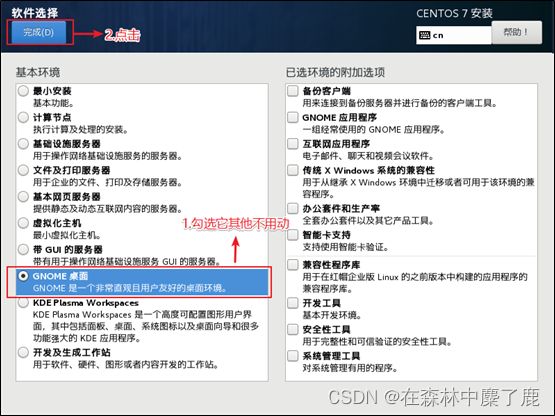

安装 GHOME (图形化界面的方式) 注意图上标注的点击顺序

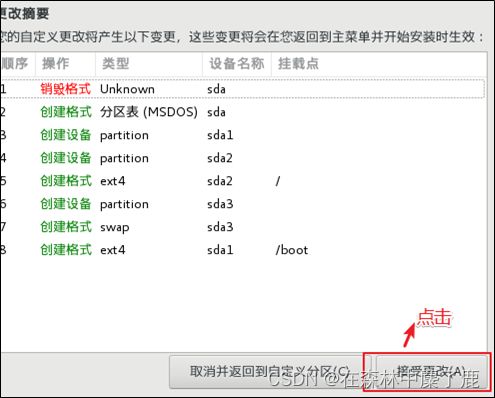

配置磁盘分区

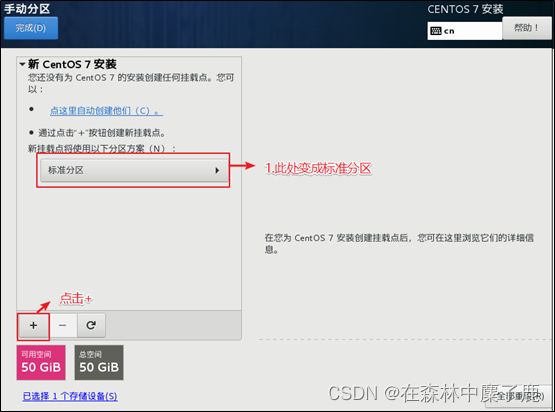

手动添加分区

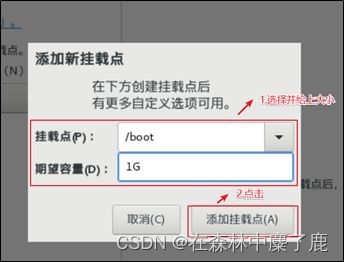

添加 boot 区 给上1G容量后点击添加挂载点

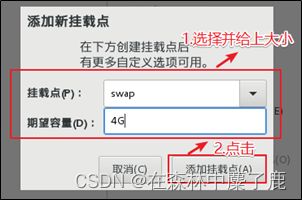

添加swap交换分区

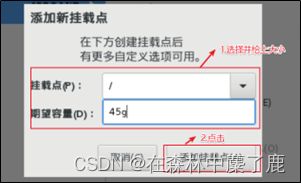

配置根(/)目录

根目录作为存储使用,将剩下的空间都给他 (50 - 4 - 1) = 45G

3个分区都配置完毕过后可以点击完成

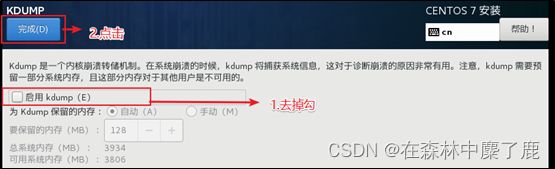

本身虚拟机内存就不够,他会吃掉一部分内存,我们尽量省一点

开启与否都可以

开始安装

安装时间比较长,大概需要10几分钟 (设置root用户密码,一定要设置)

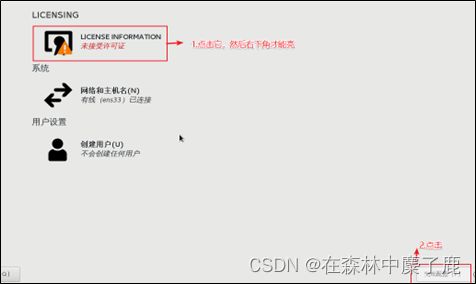

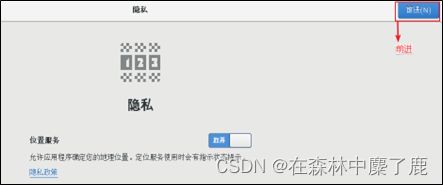

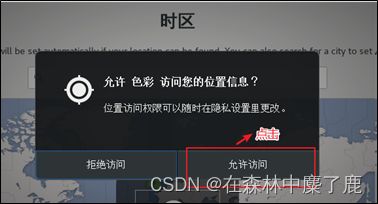

3. 虚拟机的使用引导界面

安装完成,重启虚拟机

4. 切换root用户

当前登录的用户是刚刚创建的用户,权限会缺少,所以使用 root,修改一些内容更加方便

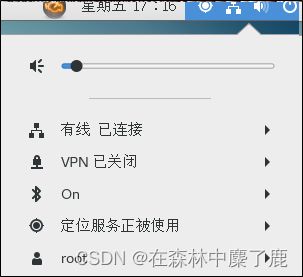

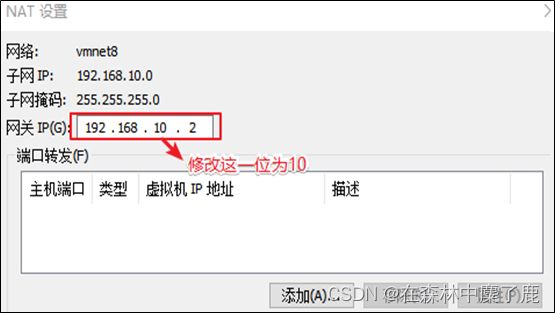

5. 虚拟机网络配置

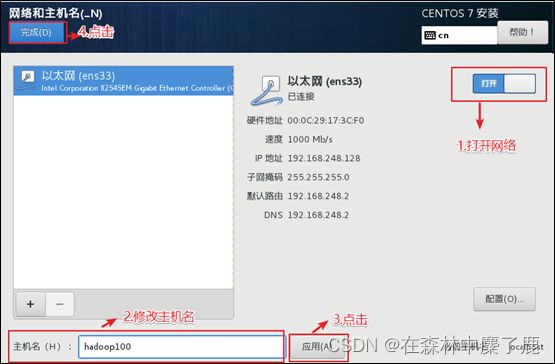

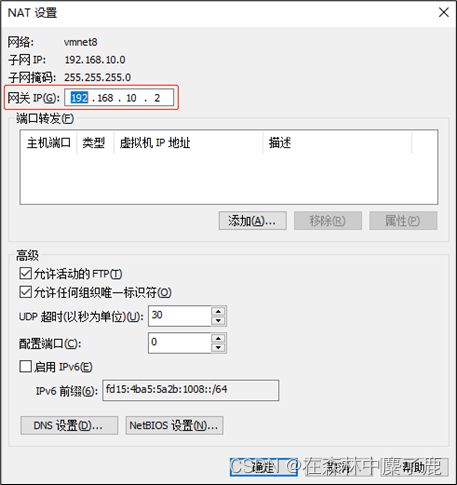

对安装好的 VMware 进行网络配置,方便虚拟机连接网络,本次设置建议选择NAT 模式,需要宿主机的 Windows 和虚拟机的 Linux 能够进行网络连接,同时虚拟机的 Linux 可以通过宿主机的 Windows 进入互联网。

编辑VMware的网络配置

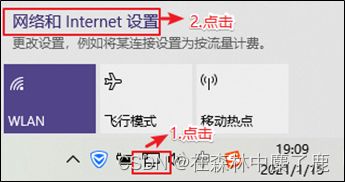

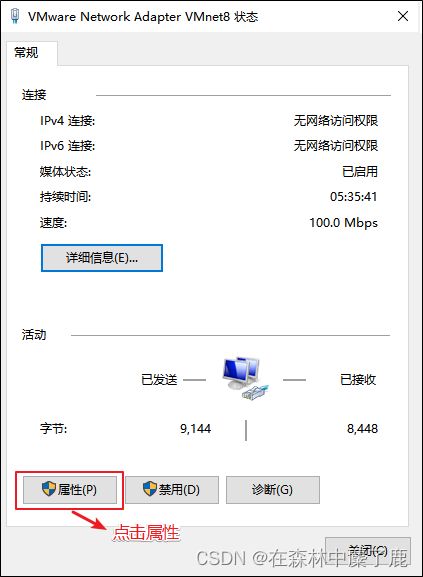

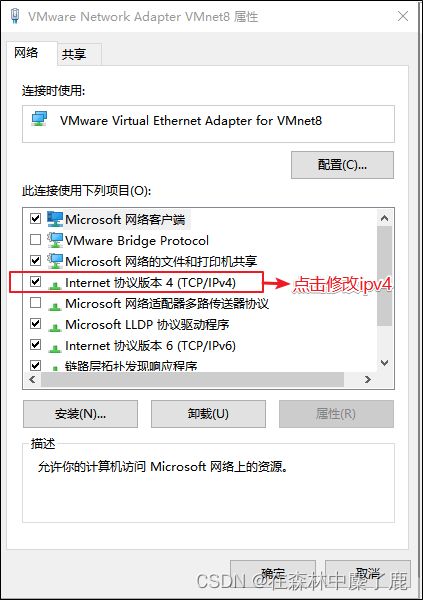

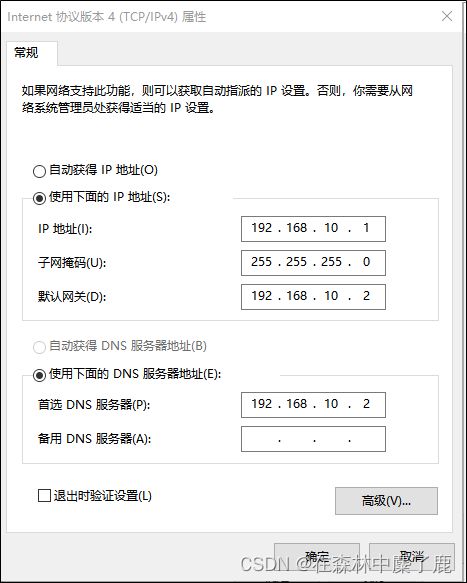

6. Windows的网络配置

以下以 Window10 为例

找到

按如上格式修改IP信息 (地址,网关,DNS服务器) ,修改完毕后全部点击确定退出。

7. 虚拟机网络IP修改地址配置

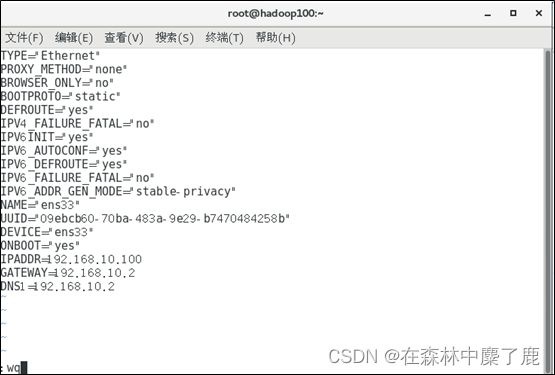

1)修改网络IP地址为静态IP地址,避免IP地址经常变化,从而方便节点服务器间的互相通信。

[root@hadoop100 ~]# vim /etc/sysconfig/network-scripts/ifcfg-ens33

2)有值的按照下面的值修改,没有该项的则需要增加。

TYPE="Ethernet" #网络类型(通常是Ethemet)

PROXY_METHOD="none"

BROWSER_ONLY="no"

BOOTPROTO="static" #IP的配置方法[none|static|bootp|dhcp](引导时不使用协议|静态分配IP|BOOTP协议|DHCP协议)

DEFROUTE="yes"

IPV4_FAILURE_FATAL="no"

IPV6INIT="yes"

IPV6_AUTOCONF="yes"

IPV6_DEFROUTE="yes"

IPV6_FAILURE_FATAL="no"

IPV6_ADDR_GEN_MODE="stable-privacy"

NAME="ens33"

UUID="e83804c1-3257-4584-81bb-660665ac22f6" #随机id

DEVICE="ens33" #接口名(设备,网卡)

ONBOOT="yes" #系统启动的时候网络接口是否有效(yes/no)

#IP地址

IPADDR=192.168.10.100

#网关

GATEWAY=192.168.10.2

#域名解析器

DNS1=192.168.10.2

修改IP地址后的结果如图所示,执行:wq命令,保存退出

4)执行systemctl restart network命令,重启网络服务。如果报错,则执行reboot命令,重启虚拟机

[root@hadoop100 ~]# systemctl restart network

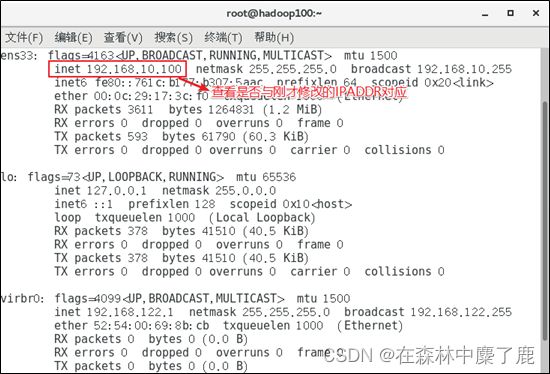

5)使用ifconfig命令查看当前IP

[root@hadoop100 ~]# ifconfig

6)保证 Linux 系统 ifcfg-ens33 文件中IP地址、虚拟网络编辑器地址和 Windows系统VM8网络IP地址相同

8. 修改主机名和hosts文件

1)修改主机名称

[root@hadoop100 ~]# vim /etc/hostname

hadoop100

2)配置Linux克隆机主机名称映射hosts文件,打开 /etc/hosts

[root@hadoop100 ~]# vim /etc/hosts

添加如下内容

192.168.10.100 hadoop100

192.168.10.101 hadoop101

192.168.10.102 hadoop102

192.168.10.103 hadoop103

192.168.10.104 hadoop104

192.168.10.105 hadoop105

192.168.10.106 hadoop106

192.168.10.107 hadoop107

192.168.10.108 hadoop108

3)重启克隆机hadoop100

[root@hadoop100 ~]# reboot

4)修改windows的主机映射文件(hosts文件)

如果操作系统是window7,可以直接修改

(a)进入C:\Windows\System32\drivers\etc路径

(b)打开hosts文件并添加如下内容,然后保存

192.168.10.100 hadoop100

192.168.10.101 hadoop101

192.168.10.102 hadoop102

192.168.10.103 hadoop103

192.168.10.104 hadoop104

192.168.10.105 hadoop105

192.168.10.106 hadoop106

192.168.10.107 hadoop107

192.168.10.108 hadoop108

如果操作系统是window10,先拷贝出来,修改保存以后,再覆盖即可

(a)进入C:\Windows\System32\drivers\etc路径

(b)拷贝hosts文件到桌面

(c)打开桌面hosts文件并添加如下内容

192.168.10.100 hadoop100

192.168.10.101 hadoop101

192.168.10.102 hadoop102

192.168.10.103 hadoop103

192.168.10.104 hadoop104

192.168.10.105 hadoop105

192.168.10.106 hadoop106

192.168.10.107 hadoop107

192.168.10.108 hadoop108

(d)将桌面hosts文件覆盖C:\Windows\System32\drivers\etc路径hosts文件

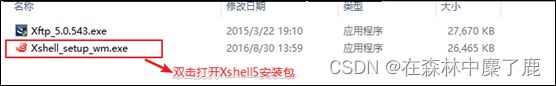

9. 远程终端工具安装

通常在工作过程中,公司中使用的真实服务器或者是云服务器,都不允许除运维人员之外的员工直接接触,因此就需要通过远程登录的方式来操作。所以,远程登录工具就是必不可缺的,目前,比较主流的有Xshell,SecureCRT等,同学们可以根据自己的习惯自行选择,以下以Xshell5为例。

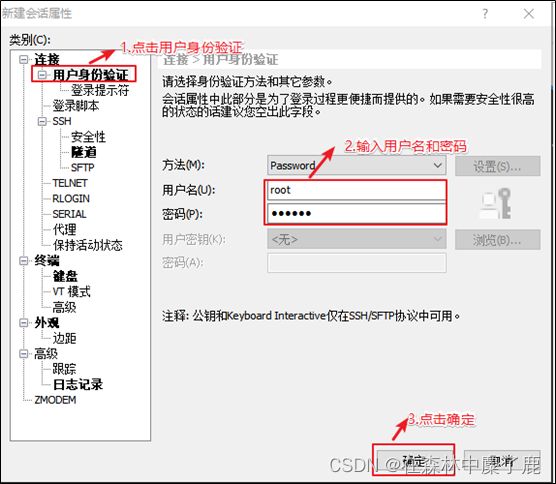

Xshell5安装和配置

一直点击下一步,但是有一页收费页,点击免费版,图如下

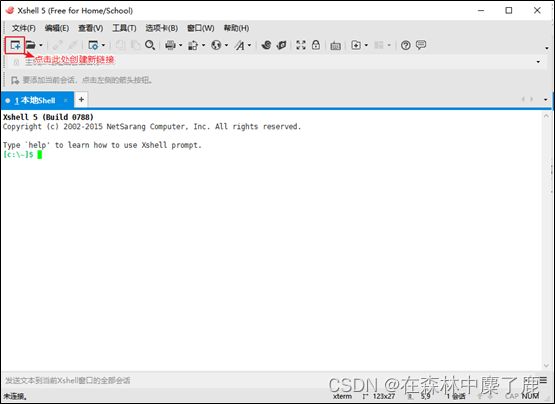

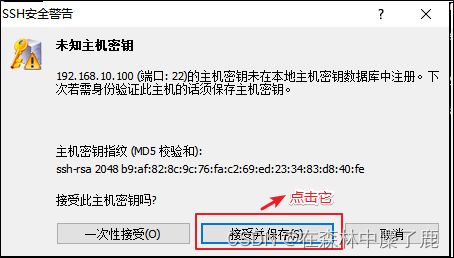

打开安装好的Xshell

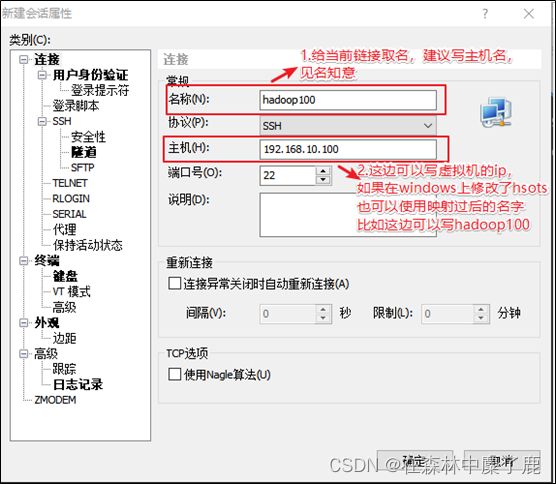

编辑新链接

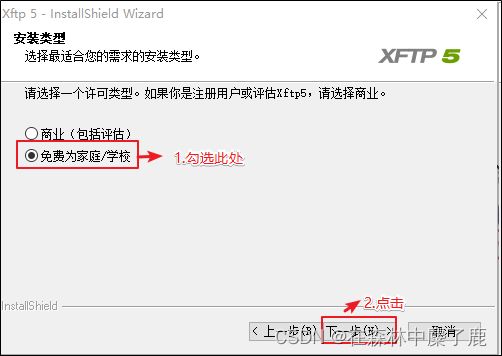

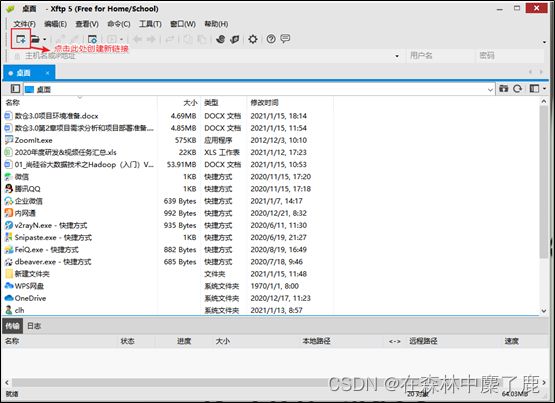

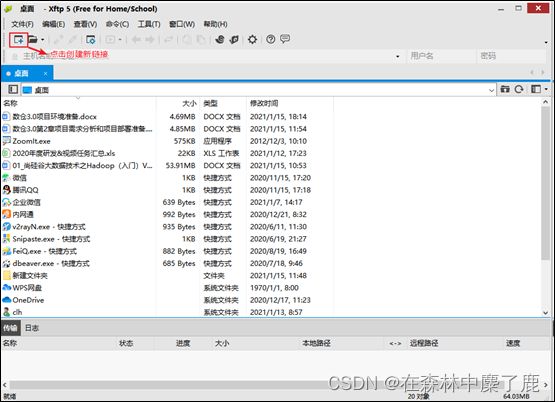

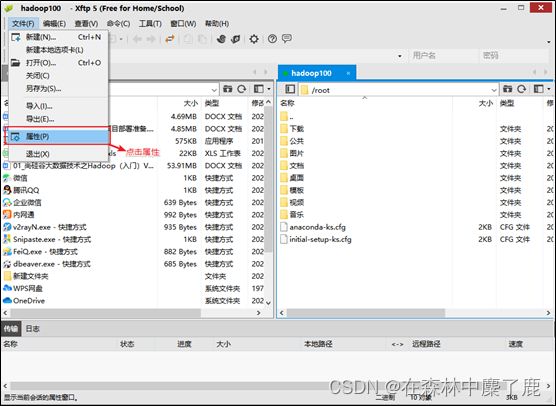

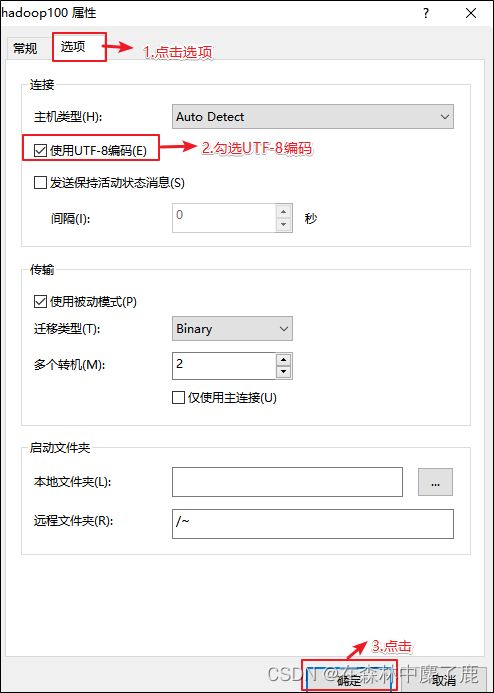

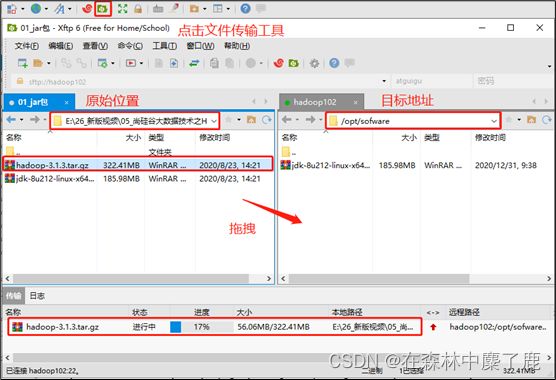

Xftp传输工具

安装Xftp

1)一直点击下一步,但是有一页收费页,点击免费版,图如下

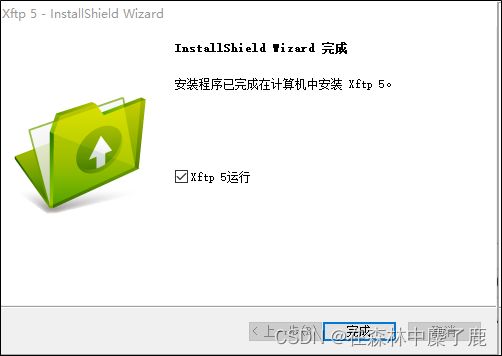

出现如下界面表示安装成功

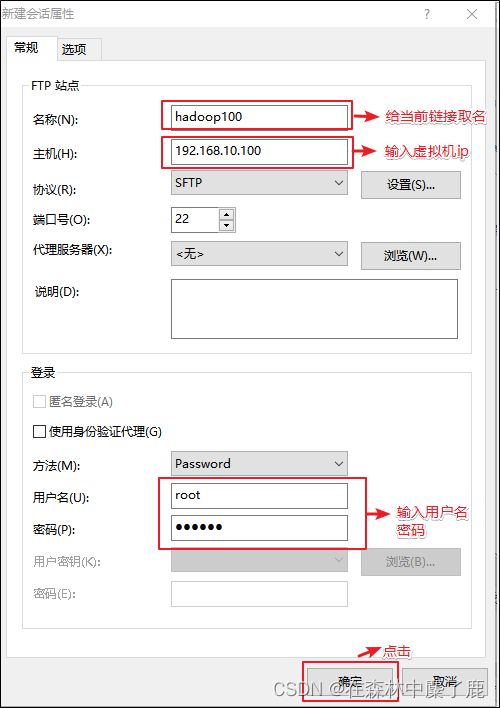

配置Xftp

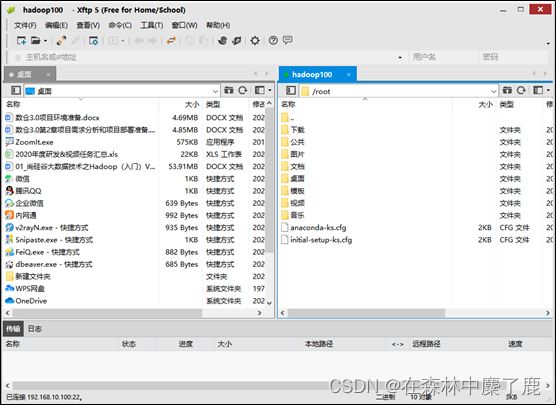

出现以上界面表示链接成功,可以进行 windows 和 linux 系统互传数据

注:有可能会有部分人右边是乱码,可以使用以下方式修改,修改后重启Xftp

10. 模板虚拟机额外配置

使用yum安装需要虚拟机可以正常上网,yum安装前可以先测试下虚拟机联网情况

[root@hadoop100 ~]# ping www.baidu.com

PING www.baidu.com (14.215.177.39) 56(84) bytes of data.

64 bytes from 14.215.177.39 (14.215.177.39): icmp_seq=1 ttl=128 time=8.60 ms

64 bytes from 14.215.177.39 (14.215.177.39): icmp_seq=2 ttl=128 time=7.72 ms

安装epel-release

注:Extra Packages for Enterprise

Linux是为“红帽系”的操作系统提供额外的软件包,适用于RHEL、CentOS和Scientific Linux。相当于是一个软件仓库,大多数rpm包在官方 repository 中是找不到的)

[root@hadoop100 ~]# yum install -y epel-release

注意:

如果Linux安装的是最小系统版,还需要安装如下工具;如果安装的是Linux桌面标准版,不需要执行如下操作

net-tool:工具包集合,包含ifconfig等命令

[root@hadoop100 ~]# yum install -y net-tools

vim:编辑器

[root@hadoop100 ~]# yum install -y vim

关闭防火墙,关闭防火墙开机自启

[root@hadoop100 ~]# systemctl stop firewalld

[root@hadoop100 ~]# systemctl disable firewalld.service

注意:在企业开发时,通常单个服务器的防火墙时关闭的。公司整体对外会设置非常安全的防火墙

创建fancyry用户,并修改fancyry用户的密码

[root@hadoop100 ~]# useradd fancyry

[root@hadoop100 ~]# passwd fancyry

配置 fancyry 用户具有root权限,方便后期加sudo执行root权限的命令

[root@hadoop100 ~]# vim /etc/sudoers

修改/etc/sudoers文件,在%wheel这行下面添加一行,如下所示:

## Allow root to run any commands anywhere

root ALL=(ALL) ALL

## Allows people in group wheel to run all commands

%wheel ALL=(ALL) ALL

fancyry ALL=(ALL) NOPASSWD:ALL

注意:fancyry这一行不要直接放到root行下面,因为所有用户都属于wheel组,你先配置了fancyry具有免密功能,但是程序执行到%wheel行时,该功能又被覆盖回需要密码。所以fancyry要放到%wheel这行下面。

在/opt目录下创建文件夹,并修改所属主和所属组

(1)在/opt目录下创建module、software文件夹

[root@hadoop100 ~]# mkdir /opt/module

[root@hadoop100 ~]# mkdir /opt/software

(2)修改module、software文件夹的所有者和所属组均为fancyry用户

[root@hadoop100 ~]# chown fancyry:fancyry /opt/module

[root@hadoop100 ~]# chown fancyry:fancyry /opt/software

(3)查看module、software文件夹的所有者和所属组

[root@hadoop100 ~]# cd /opt/

[root@hadoop100 opt]# ll

总用量 12

drwxr-xr-x. 2 fancyry fancyry 4096 7月 11 19:37 module

drwxr-xr-x. 2 root root 4096 3月 26 2015 rh

drwxr-xr-x. 2 fancyry fancyry 4096 7月 11 19:37 software

卸载虚拟机自带的JDK

注意:如果你的虚拟机是最小化安装不需要执行这一步。

[root@hadoop100 ~]# rpm -qa | grep -i java | xargs -n1 rpm -e --nodeps

- rpm -qa:查询所安装的所有rpm软件包

- grep -i:忽略大小写

- xargs -n1:表示每次只传递一个参数

- rpm -e –nodeps:强制卸载软件

重启虚拟机

[root@hadoop100 ~]# reboot

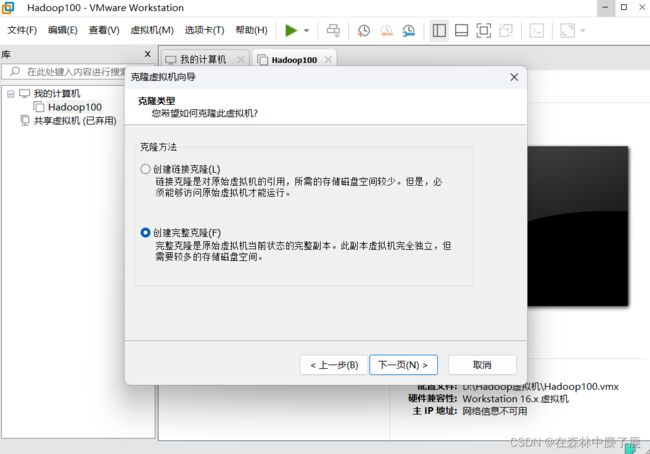

二、克隆虚拟机

1. 克隆三台虚拟机

利用模板机hadoop100,克隆三台虚拟机:hadoop102 hadoop103 hadoop104

以下以 克隆 hadoop102 为例

注意:克隆时,要先关闭 hadoop100

2. 修改克隆机IP

以下以hadoop102举例说明

(1)修改克隆虚拟机的静态IP

[root@hadoop100 ~]# vim /etc/sysconfig/network-scripts/ifcfg-ens33

改成

DEVICE=ens33

TYPE=Ethernet

ONBOOT=yes

BOOTPROTO=static

NAME="ens33"

IPADDR=192.168.10.102

PREFIX=24

GATEWAY=192.168.10.2

DNS1=192.168.10.2

(2)查看Linux虚拟机的虚拟网络编辑器,编辑->虚拟网络编辑器->VMnet8

(3)查看Windows系统适配器VMware Network Adapter VMnet8的IP地址

(4)保证Linux系统ifcfg-ens33文件中IP地址、虚拟网络编辑器地址和Windows系统VM8网络IP地址相同。

3. 修改克隆机主机名

以下以hadoop102举例说明

(1)修改主机名称

[root@hadoop100 ~]# vim /etc/hostname

hadoop102

(2)配置 Linux 克隆机主机名称映射hosts文件,打开 /etc/hosts

[root@hadoop100 ~]# vim /etc/hosts

添加如下内容

192.168.10.100 hadoop100

192.168.10.101 hadoop101

192.168.10.102 hadoop102

192.168.10.103 hadoop103

192.168.10.104 hadoop104

192.168.10.105 hadoop105

192.168.10.106 hadoop106

192.168.10.107 hadoop107

192.168.10.108 hadoop108

(3)重启克隆机hadoop102

[root@hadoop100 ~]# reboot

(4)修改windows的主机映射文件(hosts文件)

上文已给出步骤

4. 在 hadoop102 安装 JDK

1)卸载现有JDK

注意:安装JDK前,一定确保提前删除了虚拟机自带的JDK。详细步骤见问文档3.1节中卸载JDK步骤。

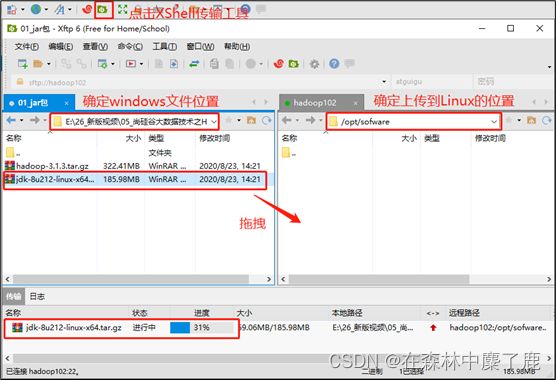

2)用 XShell 传输工具将 JDK 导入到 opt 目录下面的 software 文件夹下面

3)在Linux系统下的opt目录中查看软件包是否导入成功

[fancyry@hadoop102 ~]$ ls /opt/software/

看到如下结果:

jdk-8u212-linux-x64.tar.gz

4)解压JDK到/opt/module目录下

[fancyry@hadoop102 software]$ tar -zxvf jdk-8u212-linux-x64.tar.gz -C /opt/module/

5)配置JDK环境变量

(1)新建/etc/profile.d/my_env.sh文件

[fancyry@hadoop102 ~]$ sudo vim /etc/profile.d/my_env.sh

添加如下内容

#JAVA_HOME

export JAVA_HOME=/opt/module/jdk1.8.0_212

export PATH=$PATH:$JAVA_HOME/bin

(2)保存后退出

:wq

(3)source一下/etc/profile文件,让新的环境变量PATH生效

[fancyry@hadoop102 ~]$ source /etc/profile

6)测试JDK是否安装成功

[fancyry@hadoop102 ~]$ java -version

如果能看到以下结果,则代表Java安装成功。

java version "1.8.0_212"

注意:重启(如果java -version可以用就不用重启)

[fancry@hadoop102 ~]$ sudo reboot

5. 在 hadoop102 安装 Hadoop

Hadoop下载地址:https://archive.apache.org/dist/hadoop/common/hadoop-3.1.3/

1)用 Xftp 文件传输工具将 hadoop-3.1.3.tar.gz 导入到 opt 目录下面的 software 文件夹下面

2)进入到Hadoop安装包路径下

[fancyry@hadoop102 ~]$ cd /opt/software/

3)解压安装文件到/opt/module下面

[fancyry@hadoop102 software]$ tar -zxvf hadoop-3.1.3.tar.gz -C /opt/module/

4)查看是否解压成功

[fancyry@hadoop102 software]$ ls /opt/module/

hadoop-3.1.3

5)将Hadoop添加到环境变量

(1)获取Hadoop安装路径

[fancyry@hadoop102 hadoop-3.1.3]$ pwd

/opt/module/hadoop-3.1.3

(2)打开/etc/profile.d/my_env.sh文件

[fancyry@hadoop102 hadoop-3.1.3]$ sudo vim /etc/profile.d/my_env.sh

在my_env.sh文件末尾添加如下内容:shift+g

#HADOOP_HOME

export HADOOP_HOME=/opt/module/hadoop-3.1.3

export PATH=$PATH:$HADOOP_HOME/bin

export PATH=$PATH:$HADOOP_HOME/sbin

保存并退出: :wq

(3)让修改后的文件生效

[fancyry@hadoop102 hadoop-3.1.3]$ source /etc/profile

6)测试是否安装成功

[fancyry@hadoop102 hadoop-3.1.3]$ hadoop version

Hadoop 3.1.3

7)重启(如果Hadoop命令不能用再重启虚拟机)

[fancyry@hadoop102 hadoop-3.1.3]$ sudo reboot

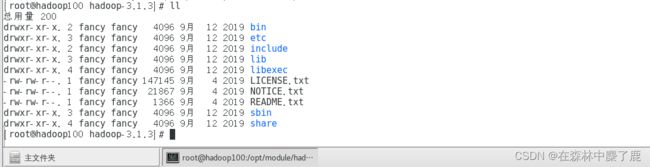

三、Hadoop 目录结构

1)查看Hadoop目录结构

[fancyry@hadoop102 hadoop-3.1.3]$ ll

总用量 52

drwxr-xr-x. 2 fancyry fancyry 4096 5月 22 2017 bin

drwxr-xr-x. 3 fancyry fancyry 4096 5月 22 2017 etc

drwxr-xr-x. 2 fancyry fancyry 4096 5月 22 2017 include

drwxr-xr-x. 3 fancyry fancyry 4096 5月 22 2017 lib

drwxr-xr-x. 2 fancyry fancyry 4096 5月 22 2017 libexec

-rw-r--r--. 1 fancyry fancyry 15429 5月 22 2017 LICENSE.txt

-rw-r--r--. 1 fancyry fancyry 101 5月 22 2017 NOTICE.txt

-rw-r--r--. 1 fancyry fancyry 1366 5月 22 2017 README.txt

drwxr-xr-x. 2 fancyry fancyry 4096 5月 22 2017 sbin

drwxr-xr-x. 4 fancyry fancyry 4096 5月 22 2017 share

2)重要目录

(1)bin目录:存放对Hadoop相关服务(hdfs,yarn,mapred)进行操作的脚本

(2)etc目录:Hadoop的配置文件目录,存放Hadoop的配置文件

(3)lib目录:存放Hadoop的本地库(对数据进行压缩解压缩功能)

(4)sbin目录:存放启动或停止Hadoop相关服务的脚本

(5)share目录:存放Hadoop的依赖jar包、文档和官方案例