朴素贝叶斯分类器_以python为工具【Python机器学习系列(十三)】

朴素贝叶斯分类器_以python为工具【Python机器学习系列(十三)】

文章目录

- 1. 朴素贝叶斯算法原理

- 2. sklearn提供的朴素贝叶斯算法

- 3. 伯努利朴素贝叶斯 BernoulliNB()

- 4. 多项式朴素贝叶斯 MultinomialNB()

- 5. 高斯朴素贝叶斯 GaussianNB()

ʚʕ̯•͡˔•̯᷅ʔɞʚʕ̯•͡˔•̯᷅ʔɞʚʕ̯•͡˔•̯᷅ʔɞʚʕ̯•͡˔•̯᷅ʔɞʚʕ̯•͡˔•̯᷅ʔɞʚʕ̯•͡˔•̯᷅ʔɞʚʕ̯•͡˔•̯᷅ʔɞʚʕ̯•͡˔•̯᷅ʔɞ

![]()

![]()

![]()

![]()

![]()

ʚʕ̯•͡˔•̯᷅ʔɞʚʕ̯•͡˔•̯᷅ʔɞʚʕ̯•͡˔•̯᷅ʔɞʚʕ̯•͡˔•̯᷅ʔɞʚʕ̯•͡˔•̯᷅ʔɞʚʕ̯•͡˔•̯᷅ʔɞʚʕ̯•͡˔•̯᷅ʔɞʚʕ̯•͡˔•̯᷅ʔɞʚʕ̯•͡˔•̯᷅ʔɞʚʕ̯•͡˔•̯᷅ʔɞ

大家好,我是侯小啾!![]()

![]() 今天分享的话题是朴素贝叶斯分类器算法。

今天分享的话题是朴素贝叶斯分类器算法。

꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ

1. 朴素贝叶斯算法原理

使用贝叶斯算法,首先需要理解的是以下两个公式:

全概率公式

P ( B ) = P ( A 1 ) × P ( B ∣ A 1 ) + P ( A 2 ) × P ( B ∣ A 2 ) + . . . + P ( A n ) × P ( B ∣ A n ) P(B)=P(A_1)×P(B|A_1)+P(A_2)×P(B|A_2)+...+P(A_n)×P(B|A_n) P(B)=P(A1)×P(B∣A1)+P(A2)×P(B∣A2)+...+P(An)×P(B∣An)

贝叶斯公式

P ( A ∣ B ) = P(A|B)= P(A∣B)= P ( A ) × P ( B ∣ A ) P ( B ) \frac{P(A)×P(B|A)}{P(B)} P(B)P(A)×P(B∣A)

或

P ( A n ∣ B ) = P(A_n|B)= P(An∣B)= P ( A n ) × P ( B ∣ A n ) P ( B ) \frac{P(A_n)×P(B|A_n)}{P(B)} P(B)P(An)×P(B∣An)

通俗地讲,假设需要将对某样本分为为0和1二类,其有A,B,C三个特征且值分别为a、b、c,

则只需要求出,在类别为0前提下特证A、B、C分别为a、b、c的概率:

即 P ( A = a , B = b , C = c ∣ 类别为 0 ) P(A=a,B=b,C=c|类别为0) P(A=a,B=b,C=c∣类别为0)

和在类别为1的前提下特征A、B、C分别为a、b、c的概率:

即 P ( A = a , B = b , C = c ∣ 类别为 1 ) P(A=a,B=b,C=c|类别为1) P(A=a,B=b,C=c∣类别为1)

即可。

然后将这两个概率作比较,大者,则为朴素贝叶斯决策结果所属类别。

或者也可以求出在特征为目标特征的前提下,类别为某类别的概率,这样比较出的结果也是会是一致的。

2. sklearn提供的朴素贝叶斯算法

在python的scikit-learn库中,一共提供了3个朴素贝叶斯的分类算法,分别是GaussianNB(),MultinomialNB()和BernoulliNB()。

其中,

BernoulliNB() 则表示先验为 伯努利分布 的朴素贝叶斯;

MultinomialNB() 表示先验为 多项式分布 的朴素贝叶斯;

GaussianNB() 表示先验为 高斯分布(即正态分布)的朴素贝叶斯。

伯努利朴素贝叶斯

其中伯努利分布的较为简单,因为伯努利分布的样本的特征值是离散型的分布,且特征都只有两个取值(比如0或1,是或否)。

多个特征,则对应多个相互独立的伯努利实验,每个实验只进行一次。比如,特征甲,可以是抛一枚硬币,结果可以是正面和反面。特征乙可以是昨天是否下雨,结果可以是“是”或“否”。

如果特征值是连续的,则算法中可以设定一个阈值(参数名为binarize),对特征值进行二值化处理,后即可满足伯努利分布。

多项式朴素贝叶斯

多项式分布则是在伯努利分布的基础上进行了多次实验。多项式分布下的多个特征依然分别对应着相互独立的实验,但与伯努利不同的是,每个特征的实验进行了多次。比如,特征甲可以是抛10次硬币正面的次数,特征乙可以是过去七天中下雨的天数(假设每天下雨的概率都一样)。

高斯朴素贝叶斯

伯努利朴素贝叶斯算法和多项式朴素贝叶斯算法都是对于离散特征的,高斯朴素贝叶斯则常用于连续特征的情况下。高斯朴素贝叶斯假设特征满足高斯分布(正态分布)。如特征为“某地高中生的身高”时,就使用高斯朴素贝叶斯。

3. 伯努利朴素贝叶斯 BernoulliNB()

导包,并准备一组数据,代码如下图所示:

import numpy as np

from sklearn.naive_bayes import BernoulliNB

from sklearn.datasets import make_blobs

from sklearn.model_selection import train_test_split

# 500个样本,3个特征,3个标签,范围为(-10.0,10.0)。

X, y = make_blobs(n_samples=500, n_features=3, centers=3, center_box=(-10.0, 10.0),random_state=10)

print(X)

print("=================================================================")

print(y)

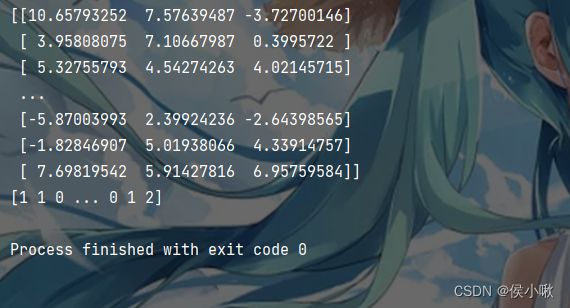

数据如图所示,可以看到,特征数据X的取值为连续的,因此要想使用伯努利朴素贝叶斯,需要先对特征数据做二值化处理。做二值化处理需要在实例化BernoulliNB()的时候,选择binarize属性。该属性默认值为0。

官方文档解释:

binarize : float or None, default=0.0

Threshold for binarizing (mapping to booleans) of sample features.

If None, input is presumed to already consist of binary vectors.

binarize:浮点类型或None,默认值为0.0

样本特征二值化(映射到布尔值)的阈值。

如果为None,则假定输入的特征数据已经是二值化的向量了。

训练模型,并使用测试集数据检验模型得分:

X_train,X_test,y_train,y_test=train_test_split(X, y, random_state=10)

nb = BernoulliNB()

nb.fit(X_train, y_train)

print('模型得分:{:.3f}'.format(nb.score(X_test, y_test)))

输出预测结果:

pred = nb.predict(X_test)

print(pred)

4. 多项式朴素贝叶斯 MultinomialNB()

MultinomialNB()实现了服从多项分布数据的朴素贝叶斯算法。

也是用于文本分类的两大经典朴素贝叶斯算法之一(文本分类领域中数据往往以词向量表示,尽管在实践中 tf-idf 向量在预测时表现良好)。

生成两组随机数,用于示例展示。一组特征值,一组标签。

import numpy as np

from sklearn.naive_bayes import MultinomialNB

from sklearn.model_selection import train_test_split

# 设置随机数种子

np.random.seed(10)

# 1000个样本,5个特征,每个样本的取值是[0,9]的整数

X = np.random.randint(10, size=(1000, 5))

# 标签可以有的取值为0,1,2

y = np.random.randint(3, size=[1000])

print(X)

print(y)

# 分割数据

X_train, X_test, y_train, y_test = train_test_split(X, y, random_state=10)

# 训练多项式朴素贝叶斯模型

nb = MultinomialNB()

nb.fit(X_train, y_train)

print('模型得分:{:.3f}'.format(nb.score(X_test, y_test)))

pred = nb.predict(X_test)

print(pred)

模型得分及预测结果如下图所示:

因为数据是随机生成的,所以这里的特征与标签之间无逻辑关系可言,以至于这里的模型得分偏低。但是算法是有效的。

5. 高斯朴素贝叶斯 GaussianNB()

符合高斯分布的数据也是连续的数值,所以不像伯努利分布的特征数据那样直接可以直接计算概率,但是也不是要做二值化处理。因为其符合正态分布,所以可以直接从正态分布中找到其概率值,

假设以某学校同学的身高数据为例,其中男生身高满足均值为176,标准差差为10的正态分布,则已知某同学为男生,其身高为180的概率为:

print(stats.norm.pdf(180, 174, 6))

这个概率值虽然不大,但是如果与女生的数据相比,若女生的身高为180的概率小于0.0368,则由此可以判断出该同学为男生。

根据这样原理,我们使用sklearn库做如下高斯贝叶斯代码示例:

import numpy as np

from sklearn.naive_bayes import GaussianNB

from sklearn.model_selection import train_test_split

# 设置随机数种子

np.random.seed(10)

# 特征值:均值为4,标准差为5的正态分布,10000个样本,3个特征

X = np.random.normal(4, 5, (10000, 3))

# 标签值:0,1,2

y = np.random.randint(3, size=[10000])

print(X)

print(y)

X_train, X_test, y_train, y_test = train_test_split(X, y, random_state=10)

nb = GaussianNB()

nb.fit(X_train, y_train)

print('模型得分:{:.3f}'.format(nb.score(X_test, y_test)))

pred = nb.predict(X_test)

print(pred)

本次分享就到这里,小啾感谢您的关注与支持!

꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ꧔ꦿ