基于双流融合网络的遥感图像融合 论文笔记

Remote sensing image fusion based on two-stream fusion network

期刊:information fusion

年份:2020

作者:Xiangyu Liua, Qingjie Liua,b,∗, Yunhong Wang

摘要: 受卷积神经网络(CNN)启发,本文提出了一种双流融合网络(TFNet)来解决这一问题。 与许多以前基于CNN的方法不同,这些方法认为泛锐化是一个超分辨率问题,并通过将堆叠的PAN和MS映射到目标高分辨率MSIM来执行泛锐化。 提出的TFNet旨在将PAN和MS图像融合在特征域中,并从融合的特征中重建泛锐化图像。TFNet主要由三部分组成。第一部分由两个分别从PAN和MS图像中提取特征的网络组成。随后的网络将它们融合在一起,形成紧凑的特征,同时表示PAN和MS图像的空间和光谱信息。最后,通过图像重建网络从融合的特征中提取出所需要的高空间分辨率的MS图像。在Quickbird和GaoFen-1图像上的实验表明,所提出的TFNet能够有效地融合PAN和MS图像。

双流融合网络

人们普遍认为PAN和MS图像包含不同的信息。 PAN图像是几何细节(空间)信息的载体,而MS图像保留光谱信息。 目标 潘森宁将空间细节和光谱信息结合起来,生成一幅新的高分辨率MS图像。 然而,很难确定究竟是什么空间和光谱信息 是和如何独立地表示它们。 以往的研究,如ARSIS概念方法[9,12],认为空间信息在于PAN图像的高频率。 CS方法[50,51]在MS图像上应用线性变换来获得包含退化空间信息的分量,然后用PAN图像替换,注入空间信息信息。 最近提出的基于CNN的方法要么认为泛锐化是一个超分辨率问题[24],要么使用CNN作为提取空间细节的工具( 残差)[36,37]。 这些方法可以产生具有良好视觉质量的结果,但仍然受到光谱畸变或伪影的影响。 这主要是因为几乎不可能分别提取特征空间或光谱信息。 虽然PAN被认为是空间信息的载体,但里面也可能存在光谱信息。 考虑到CNN是一个非常强大的工具来表示输入的层次特征,并且图像可以从这些特征完美地重建[52,53], 我们提议在特征域中融合PAN和MS图像,然后从融合的特征中恢复PAN和MS图像。 因为我们想结合PAN和MS的优点,泛锐化图像的特征应该包含PAN和MS的信息。

假设![]() 是一个特征提取器,使得

是一个特征提取器,使得![]() 提取的特征是输入图像

提取的特征是输入图像![]() 的完整表示,这意味着

的完整表示,这意味着![]() 可以是从

可以是从![]() (

(![]() )中恢复而不丢失任何信息。 大多数手工制作的功能,如HOG、LBP和SIFT都不能满足这一需求。 稀疏编码,它表示具有学习过完备字典的图像,可以作为一个很好的特征提取器。 利用稀疏表示技术[15,16]开发了泛锐化方法。 然而,融合仍然在图像域中进行。 目前还不清楚如何融合稀疏域中两幅图像的特征。

)中恢复而不丢失任何信息。 大多数手工制作的功能,如HOG、LBP和SIFT都不能满足这一需求。 稀疏编码,它表示具有学习过完备字典的图像,可以作为一个很好的特征提取器。 利用稀疏表示技术[15,16]开发了泛锐化方法。 然而,融合仍然在图像域中进行。 目前还不清楚如何融合稀疏域中两幅图像的特征。

CNN为我们同时完成特征提取和融合提供了一个很好的解决方案。 基于上述讨论,首先我们使用CNN作为特征提取器来表示PAN和MS图像。为了方便起见,在下面我们使用![]() 和

和![]() 分别表示MS和PAN的CNN。 对于代表PAN和MS的

分别表示MS和PAN的CNN。 对于代表PAN和MS的![]() 和

和![]() 两幅图像,CNN提取的特征可以写出来 作为

两幅图像,CNN提取的特征可以写出来 作为![]() 和

和![]() ,上标l表示从第

,上标l表示从第![]() 层提取特征。 在获得PAN和MS的特性后,随后的步骤将它们融合在一起。 由于CNNs提取的特征以信道特征映射的形式存在,因此融合的一种可能方法是在两个特征映射上应用池操作,例如最大池或平均池。 然而,这将丢失信息。 或者,我们认为 通过简单地将它们连接在一起来实现融合策略,

层提取特征。 在获得PAN和MS的特性后,随后的步骤将它们融合在一起。 由于CNNs提取的特征以信道特征映射的形式存在,因此融合的一种可能方法是在两个特征映射上应用池操作,例如最大池或平均池。 然而,这将丢失信息。 或者,我们认为 通过简单地将它们连接在一起来实现融合策略,

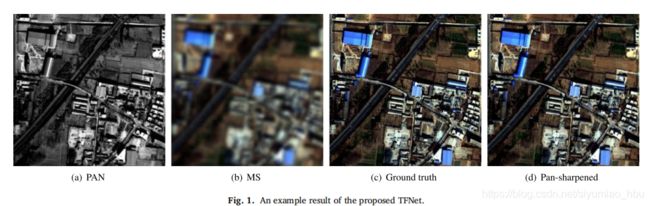

其中![]() 是融合的特征,“⊕”意味着级联操作。 然后将连接的特征输入到融合网络中,形成更紧凑的表示,然后进行重建网络恢复泛锐化图像。 这些阶段可以集成到一个网络中,并以端到端的方式进行训练。 由于所提出的网络接受两个输入,因此具有双流体系结构,我们将其称为双流融合网络(TFNet2)。 一个示例结果如图 1.所示。

是融合的特征,“⊕”意味着级联操作。 然后将连接的特征输入到融合网络中,形成更紧凑的表示,然后进行重建网络恢复泛锐化图像。 这些阶段可以集成到一个网络中,并以端到端的方式进行训练。 由于所提出的网络接受两个输入,因此具有双流体系结构,我们将其称为双流融合网络(TFNet2)。 一个示例结果如图 1.所示。

TFNet

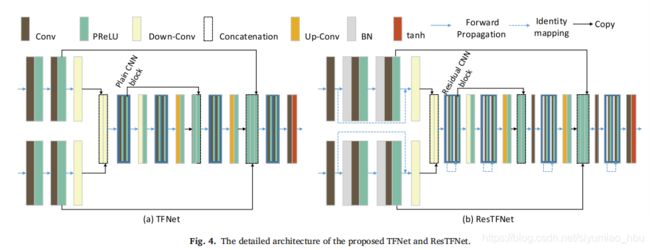

在这一部分中,我们给出了我们的TFNet的详细结构,它具有类似编码器的体系结构,由三个部分组成,包括特征提取、特征融合和图像重建。 前两部分的作用就像编码器从输入的PAN和MS图像中提取和编码特征。 最后部分对融合特征进行解码,以重建所需的高分辨率MS图像。 所提出的TFNet的原理图如图 2所示。

拟议TFNet的示意图。 FEN是特征提取网络的简称. MS图像上采样到相同大小的PAN,然后输入MSFEN。

1. 特征提取网络

我们使用两个子网络ΦP和ΦM分别从PAN和MS图像中提取特征。 这两个子网具有相似的结构,但权重不同。 一个子网需要一个4波段的MSI 图片作为输入,另一个以单个波段PAN图像作为输入。 每个特征提取子网络由两个连续的卷积层组成,然后是一个参数校正线性单元(PRELU)[54]和一个下采样层。 大多数CNN架构使用最大或平均池来获得尺度和旋转不变特征,但细节信息更重要。 在泛锐化中,因此在整个网络中,我们使用步长为2的卷积核进行下采样,而不是简单的池策略。

2. 融合网络

经过特征提取,我们有两卷特征映射![]() 和

和![]() 分别表示PAN和MS图像。 这两个特征映射明确捕获互补信息 PAN和MS的合成。 考虑到所需的高分辨率MS图像在空间和光谱领域都应该具有高分辨率,它的特征必须捕获空间和光谱信息。 为此,两个特征映射被连接在一起,就像在等式(1)中描述。 在此之后,应用具有三个卷积层的融合网络将级联的特征映射编码成更紧凑的表示。 融合网络的终结 是一个[w/4,h/4,256]3张量,它编码两个输入图像的空间和光谱信息。

分别表示PAN和MS图像。 这两个特征映射明确捕获互补信息 PAN和MS的合成。 考虑到所需的高分辨率MS图像在空间和光谱领域都应该具有高分辨率,它的特征必须捕获空间和光谱信息。 为此,两个特征映射被连接在一起,就像在等式(1)中描述。 在此之后,应用具有三个卷积层的融合网络将级联的特征映射编码成更紧凑的表示。 融合网络的终结 是一个[w/4,h/4,256]3张量,它编码两个输入图像的空间和光谱信息。

3. 图像重建网络

所提出的TFNet的最后一阶段是从融合的特征中恢复所需的高分辨率MS图像。 编码的特征映射只占输入宽度和高度比例的1/4×1/4,. 特征映射的空间分辨率应逐步向上采样,以满足泛锐化图像的分辨率。 人们可以使用传统的方法,如线性插值到向上 充分的特征映射,然而可学习的方式是更好的[55]。 我们使用向后步长卷积层(也称为转置卷积层)来重建高分辨率MS图像, 并将每两层的特征映射作为对称结构向编码器采样(如特征提取和融合网络)

因为高层特征映射编码图像的语义和抽象信息[53],很难从高层特征中恢复细节纹理。 为了恢复精细而真实的细节,利用所有级别 更好地的表示。 然而,这将给计算带来沉重的负担。 受U-Net[56]中使用的“裁剪和复制”操作的启发,对于相应的“扩展路径”,该操作复制“契约”中的特性 ,我们在网络的编码器和解码器之间添加跳过连接,具体地说,在每个上采样步骤之后,如图4所示,将编码器中的特征图复制到解码器并与相应的特征图连接,以注入在下采样过程中丢失的更多细节。 在实验中,我们将讨论通过将较低的特性添加到更高的级别来提高性能的程度。 最后一层输出所需的高分辨率4波段MS图像.. 4(a)显示了TFNet的详细结构。

4. 用残差块改进

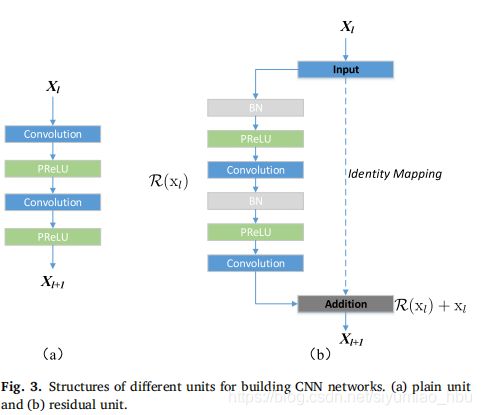

最近提出的剩余学习框架[46,57]推进了许多视觉任务[37,48]。在这项工作中,我们还试图利用剩余CNN的力量,通过用剩余单元替换普通的CNN单元来进一步提高我们的TFNet的性能。 每个剩余单元可以作为一般形式加以说明:

其中![]() 和

和![]() 是

是![]() 残余单元的输入和输出,

残余单元的输入和输出,![]() 是残差函数,

是残差函数,![]() 是激活函数,

是激活函数,![]() 是身份映射函数,典型的是

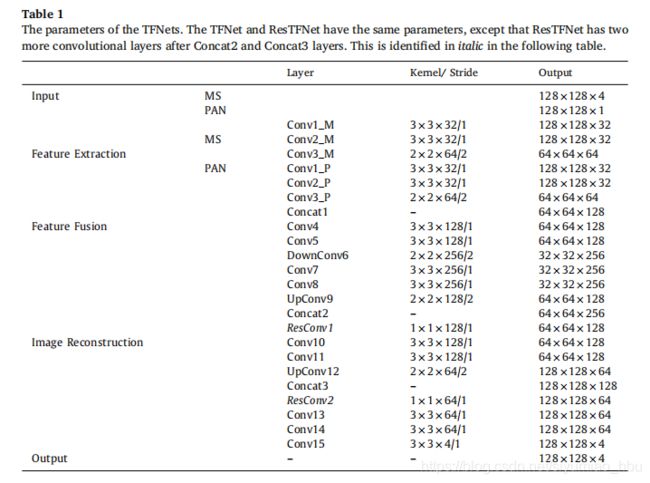

是身份映射函数,典型的是![]() 。 图3显示了当建造 TFNet(Res TFNet)时一个普通单元和残差单元之间的差异,每两个连续的卷积层被一个残差单元所取代。 在每个连接层之后立即添加一个额外的1×1卷积层,以减少这些特征映射的大小。 因此,ResTFNet比TFNet有两个更多的卷积层。 ResTFNet的详细架构如图4所示。 4(b)和表1说明了拟议的TFNet及其剩余变化Res TFNet的参数。

。 图3显示了当建造 TFNet(Res TFNet)时一个普通单元和残差单元之间的差异,每两个连续的卷积层被一个残差单元所取代。 在每个连接层之后立即添加一个额外的1×1卷积层,以减少这些特征映射的大小。 因此,ResTFNet比TFNet有两个更多的卷积层。 ResTFNet的详细架构如图4所示。 4(b)和表1说明了拟议的TFNet及其剩余变化Res TFNet的参数。

5. 损失函数

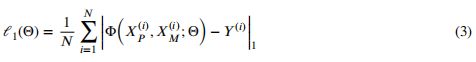

通过最小化泛锐化图像与相应的地面真实图像之间的损失,对TFNet的参数Θ进行了优化。 除了网络体系结构外,损失函数是另一个重要因素影响重建图像质量的重要因素。 以前的大多数恢复任务使用2范数作为损失函数[19,20,24,37],但是这将产生图像受到模糊效应的影响。 一些研究表明,在执行图像恢复任务时,1损失是一个更好的选择[48,58],因此在本工作中,1作为损失函数来训练我们的网络。 给定一组训练样本 ![]() 其中

其中![]() 是PAN和低分辨率MS图像,

是PAN和低分辨率MS图像,![]() 是相应的高分辨率MS图像,1损失定义为:

是相应的高分辨率MS图像,1损失定义为:

其中N是小批量训练样本的数量。