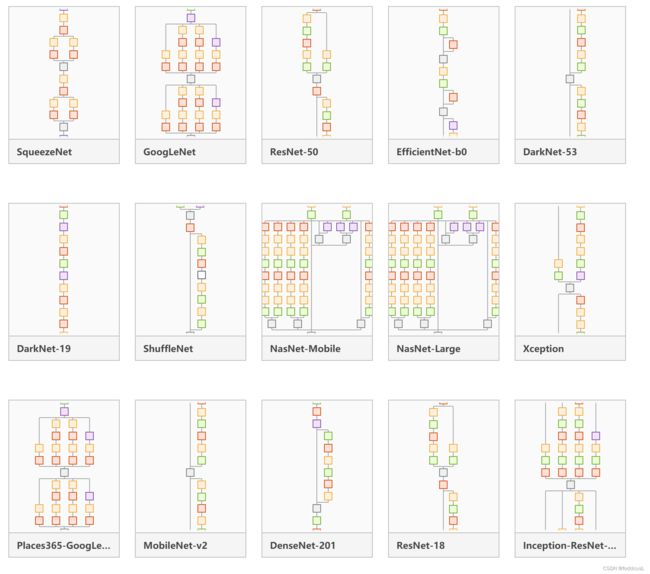

深度学习神经网络各网络简介及资料汇总 (matlab :deep network designer )

该介绍包括matlab2022a deepNetworkDesigner 中提供各种预训练的网络模型介绍

SqueezeNet (2016)

SqueezeNet是Han等提出的一种轻量且高效的CNN模型,它参数比AlexNet少50x,但模型性能(accuracy)与AlexNet接近。SqueezeNet是一个深18层的卷积神经网络。matlab提供的模型为经过ImageNet数据库中的100多万张图像进行训练的预训练版本的网络。经过预先训练的网络可以将图像分类为1000个对象类别(包括以下所有模型),如键盘、鼠标、铅笔和许多动物。

特点:参数较少,适合入门学习;规模小,方便迁移和更新;适用于部署在性能有限的计算机中。

详细讲解:SqueezeNet详解 - 知乎 (zhihu.com)

论文地址:[1602.07360] SqueezeNet: AlexNet-level accuracy with 50x fewer parameters and <0.5MB model size (arxiv.org)

Google LeNet (Places365)(2014)

GoogLeNet是2014年Christian Szegedy提出的一种全新的深度学习结构,在这之前的AlexNet、VGG等结构都是通过增大网络的深度(层数)来获得更好的训练效果,但层数的增加会带来很多负作用,比如overfit、梯度消失、梯度爆炸等。inception的提出则从另一种角度来提升训练结果:能更高效的利用计算资源,在相同的计算量下能提取到更多的特征,从而提升训练结果。(来源:GoogLeNet_百度百科 (baidu.com))。

matlab提供的Googlenet是一个已经经历验证的模型,已在Imagenet数据库的一个子集上进行了训练,该模型用于Imagenet大规模视觉识别挑战(ILSVRC)。而其中的places365模型是使用places数据库训练的模型,可以识别出365种不同场景。

特点:首创了Inception的方法,是一种具有进步代表性模型;后续许多模型为其变种

论文地址:

(PDF) Gradient-Based Learning Applied to Document Recognition (researchgate.net)(远古开山之作)

Going deeper with convolutions | IEEE Conference Publication | IEEE Xplore

详细讲解:【论文笔记】—GoogLeNet(Inception-V1)—2015-CVPR_chaikeya的博客-CSDN博客_inception v1论文

ResNet-50 & 18 &101(2015)

全称深度残差网络(Deep residual network, ResNet),ResNet-50在2015年赢得了ImageNet大规模视觉识别挑战(ILSVRC)比赛。该模型训练了100多万张图像,共有177层,对应50层残差网络(后面的18及101对应的就是残差网络层数)。其为深度学习的退化问题提供了新的思路,该模型的作者何恺明也因此摘得CVPR2016最佳论文奖。

特点:区别于传统神经网络,其拥有更深的网络和更好的新能

详细讲解:

你必须要知道CNN模型:ResNet - 知乎 (zhihu.com)

论文地址:[1512.03385] Deep Residual Learning for Image Recognition (arxiv.org)

EfficientNet-b0(2019)

以往的深度学习网络一般需要工程经验来进行手动调优,而该网络提出了一个更有原则性的方法来扩大 CNN 的规模,从而可以获得更好的准确性和效率。

详细解释:EfficientNet-可能是迄今为止最好的CNN网络 - 知乎 (zhihu.com)

EfficientNet网络详解_太阳花的小绿豆的博客-CSDN博客_efficientnet网络结构

论文地址:[1905.11946] EfficientNet: Rethinking Model Scaling for Convolutional Neural Networks (arxiv.org)

DarkNet-53 & DarkNet-19(YOLOv3 2018,YOLOv2 2016)

Darknet是基于C语言设计的,没有其他的依赖项。Darknet-53是模型yolo v3用于提取特征的backbone,他借鉴了yolo v2中的网络(Darknet-19)结构,相当于Darknet19的升级版。

其结合Resnet的特点在保证对特征进行超强表达的同时又避免了网络过深带来的梯度问题,主要有Darknet19和Darknet53;其主要特点是相较于ResNet 保证精确度的情况下,拥有更快的处理速度。

论文地址:[1804.02767] YOLOv3: An Incremental Improvement (arxiv.org)

[1612.08242] YOLO9000: Better, Faster, Stronger (arxiv.org)

详解:yolov3网络(DarkNet53)结构详解以及Pytorch代码实现_一颗磐石的博客-CSDN博客_darknet53网络结构图

YOLOv2-darknet 内容解析 - pprp - 博客园 (cnblogs.com)

ShuffleNet (2018)

shuffleNet结合了Channel Shuffle的Group convolutions,是一种轻量化的深度学习模型;其对标谷歌的MobileNet,是移动端深度学习的优秀解决方案。ShuffleNet使用Group-wise CNN与Shuffle module结合的思想来优化1x1 conv的bottleneck模块,有效地节省理论所需的计算,从而在一定算力的限定内,实现尽可能高的分类准确率。

详解

轻量级神经网络——shuffleNet_秃头小苏的博客-CSDN博客_shufflenet

论文地址:ShuffleNet: An Extremely Efficient Convolutional Neural Network for Mobile Devices | IEEE Conference Publication | IEEE Xplore

NasNet-Mobile & NasNet-Large (2017)

在 NASNet 中,作者首先对 CIFAR-10 中最佳的卷积层或神经元进行搜索,之后通过将该神经元复制多次并连接在一起以应用在 ImageNet 数据集上。该研究还提出了“ScheduledDropPath” 这一新的正则化技术,该方法有效地改善了 NASNet 的生成效果。相较于以往的神经网络架构,NASNet 生成的神经网络模型更简洁,运算复杂度更低(以每秒浮点运算次数衡量)。Mobebile与Large为其网络不同的规模对应轻量与大型。

详解:

NASNet学习笔记_穿越5极限的博客-CSDN博客_nasnet

NAS详解 - 知乎 (zhihu.com)

论文地址:Learning Transferable Architectures for Scalable Image Recognition | IEEE Conference Publication | IEEE Xplore

Xception (2017)

Xception为LeNet的后续变种之一,主要是在Inception v3的基础上引入了depthwise separable convolution,进一步提高了模型精度。可以说是Inception思想的极端伸延。

详解:

[论文笔记] ShuffleNet - 知乎 (zhihu.com)

论文地址:

Xception: Deep Learning with Depthwise Separable Convolutions | IEEE Conference Publication | IEEE Xplore

MobileNet (v1:2017;v2:2018;v3:2019)

顾名思义,轻量化的神经网络,是Google致力于移动端的神经网络模型,使模型在cpu上也能拥有不错的速度。

详解: mobilenet网络的理解_BigCowPeking的博客-CSDN博客

卷积神经网络学习笔记——轻量化网络MobileNet系列(V1,V2,V3) - 战争热诚 - 博客园 (cnblogs.com)

论文地址:(PDF) MobileNets: Efficient Convolutional Neural Networks for Mobile Vision Applications (researchgate.net)

DenseNet (2017)

DenseNet模型是ResNet的后辈。因为其建立前面所有层与后面层的密集连接(dense connection),它的名称也是由此而来。DenseNet的另一大特色是通过特征在channel上的连接来实现特征重用(feature reuse)。这些特点让DenseNet在参数和计算成本更少的情形下实现比ResNet更优的性能,DenseNet也因此斩获CVPR 2017的最佳论文奖。matlab中提供的DenseNet201即是一个深度201层的DenseNet。

详解:

DenseNet:密集连接卷积网络 - 简书 (jianshu.com)

论文地址:

Densely Connected Convolutional Networks | IEEE Conference Publication | IEEE Xplore

Inception-ResNet(2016)

Google的inception v4版本通过将残差连接的思想引入v3,也就是Inception-ResNet网络来提升卷积神经网络的性能。

详解:

Inception-ResNet卷积神经网络 - 知乎 (zhihu.com)

论文地址:[1602.07261] Inception-v4, Inception-ResNet and the Impact of Residual Connections on Learning (arxiv.org)

Inceptionv3(2016)

脱身于LeNet(Inceptionv1),V2、V3主要是提高了计算效率以及减少网络参数。

详解:

(82条消息) 深度学习之基础模型-Inception-V3_leo_whz的博客-CSDN博客

深入解读Inception V1(附源码) - 知乎 (zhihu.com)

论文地址:Rethinking the Inception Architecture for Computer Vision | IEEE Conference Publication | IEEE Xplore

VGG (2014)

VGG就是基于LeNet、AlexNet提出的更深的卷积神经网络,VGG主要采用增加卷积层的方法来加深网络,结果发现深度越深,网络学习能力越好,分类能力越强。当深度增加到16-19层时,识别效果有较大提升,即VGG-16,VGG-19。VGG-16、VGG-19(论文阅读《Very Deep Convolutional NetWorks for Large-Scale Image Recognition》)_zz_走走停停的博客-CSDN博客_vgg16论文

详解: 深度学习图像分类网络(一):VGG VGGNet16/19网络架构演变以及模型搭建_码农男孩的博客-CSDN博客_vgg19论文

论文地址:[1409.1556] Very Deep Convolutional Networks for Large-Scale Image Recognition (arxiv.org)

AlexNet(2012)

掀起深度学习热潮的历史性模型!模型名称按论文一作名字Alex名字命名。并在2012年的ILSVRC竞赛中获得了第一名。而发表的论文已经被引用接近12万次。入坑必看作之一

详解:(82条消息) 论文笔记:ImageNet Classification with Deep Convolutional Neural Networks(AlexNet)_snoopy_21的博客-CSDN博客

论文地址:ImageNet classification with deep convolutional neural networks | Communications of the ACM

相关模型资源(free)

深度学习模型汇总(matlab|deeplearningdesigner)第一部分-深度学习文档类资源-CSDN文库

深度学习模型汇总(matlab|deeplearningdesigner)第二部分-深度学习文档类资源-CSDN文库

深度学习模型汇总(matlab|deeplearningdesigner)第三部分-深度学习文档类资源-CSDN文库