语义分割-ICCV2017 Unpaired Image-to-Image Translation using Cycle-Consistent Adversarial Networks循环一致对抗网

Image-to-Image Translation using Cycle-Consistent Adversarial Networks:使用循环一致对抗网络进行图像到图像的翻译

- 0.摘要

- 1.概述

- 2.相关工作

-

- 2.1.生成对抗网络GAN

- 2.2.图像到图像的翻译

- 2.3. 未配对图像到图像的翻译

- 2.4.循环一致性

- 2.5.神经风格转移

- 3.公式

-

- 3.1.对抗损失

- 3.2.循环一致性损失

- 3.3.整个优化对象

- 4.实现

-

- 4.1.网络结构

- 4.2.训练细节

- 5.结果

-

- 5.1.评估

-

- 5.1.1.评估指标

- 5.1.2.基线

- 5.1.3.与基线的比较

- 5.1.4.损失函数的分析

- 5.1.5.图像重建质量

- 5.1.6.配对数据集的其他结果

- 5.2.应用

- 6.限制和讨论

- 7.附录

-

- 7.1.训练细节

- 7.2. 网络架构

- 参考文献

代码地址

论文地址

0.摘要

图像到图像的翻译是一类视觉和图形问题,其目标是使用对齐的图像对训练集来学习输入图像和输出图像之间的映射。然而,对于许多任务,成对的训练数据是不可用的。我们提出了一种学习在没有成对例子的情况下将图像从源域X转换为目标域Y的方法。我们的目标是学习一种映射G: X→Y,使G(X)的图像分布与使用对抗性损失的分布Y难以区分。由于这个映射是高度欠约束的,我们将它与一个逆映射F: Y→X耦合,并引入一个循环一致性损失来强制F (G(X))≈X(反之亦然)。在不存在配对训练数据的几个任务上给出了定性结果,包括采集风格转换、对象变形、季节转换、照片增强等。与以前几种方法的定量比较表明了我们的方法的优越性。

1.概述

图2:成对训练数据(左)由训练实例{Xi,Yi} Ni=1组成,其中对应于每个Xi的Yi给出[20 ]。相反,我们考虑不成对的训练数据(右),由源集{xi} Ni=1∈ X组成和目标集{yj}Mj=1∈ Y,没有提供关于xi匹配的信息yi。

在本文中,我们提出了一种方法,可以学习做同样的事情:捕获一个图像集合的特殊特征,并找出如何将这些特征转化为另一个图像集合,所有这些都不需要任何成对的训练示例。

这个问题可以更广泛地描述为图像到图像的转换[22],将图像从给定场景的一种表示形式x转换为另一种表示形式y,例如灰度到颜色、图像到语义标签、边缘映射到照片。计算机视觉、图像处理、计算摄影和图形学方面的研究已经在有监督的环境中产生了强大的翻译系统,其中示例图像对{xi,yi}Ni=1可用(图2,左),例如[11,19,22,23,28,33,45,56,58,62]。然而,获得成对的训练数据可能既困难又昂贵。例如,对于语义分割(例如[4])等任务,只有几个数据集存在,而且它们相对较小。由于所需的输出非常复杂,通常需要艺术创作,因此为艺术风格化等图形任务获取输入-输出对可能会更加困难。用于许多任务,如物体变形(例如斑马↔horse,图1(上中),所需的输出甚至没有很好的定义。

因此,我们寻求一种算法,可以在没有成对输入输出示例的情况下学习在域之间进行翻译(图2,右图)。我们假设这些域之间存在某种潜在关系——例如,它们是同一潜在场景的两个不同渲染——并试图了解这种关系。虽然我们缺乏成对示例形式的监控,但我们可以利用集合级别的监控:我们在域X中获得一组图像,在域Y中获得另一组图像。我们可以训练一个映射G:X→Y,使得输出y∧=G(x)(x∈X,y∈Y) 与y无法被训练得到的对抗网络图像区分。理论上,该目标所生成的Y∧上产生的分布应当和经验分布pdata(Y)相匹配(通常,这要求G是随机的)[16]。因此,最优G将域X转换为与Y相同分布的域Y∧。然而,这样的转换并不能保证单个输入x和输出y以有意义的方式配对——有无限多个映射G会在y∧上产生相同的分布。此外,在实践中,我们发现,孤立地优化对抗目标很困难:标准程序通常会导致众所周知的模式崩溃问题,即所有输入图像映射到同一输出图像,优化无法取得进展[15]。

这些问题要求为我们的目标增加更多的结构。因此,我们利用了翻译应该是“循环一致”的特性,即如果我们将一个句子从英语翻译成法语,然后将其从法语翻译回英语,我们应该回到原始句子[3]。从数学上来说,如果我们有一个翻译器G:X→ Y和另一位翻译F:Y→ X、 那么G和F应该是彼此的倒数,两个映射都应该是双射。我们通过同时训练映射G和F,并添加一个鼓励F(G(x))的循环一致性损失[64],来应用这个结构性假设 F(G(x))≈ x和G(F(y))≈ y。将这种损失与域X和y上的对抗性损失结合起来,我们就可以实现未配对图像到图像的翻译。我们将我们的方法应用到广泛的应用中,包括收集样式转换、对象变形、季节转换和照片增强。我们还与以前的方法进行了比较,这些方法要么依赖于手工定义的风格和内容分解,要么依赖于共享的嵌入函数,并且表明我们的方法优于这些基线。我们提供PyTorch和Torch实现。在我们的网站上查看更多结果。

2.相关工作

2.1.生成对抗网络GAN

生成性对抗网络[16,63]在图像生成[6,39]、图像编辑[66]和表征学习[39,43,37]方面取得了令人印象深刻的成果。最近的方法在条件图像生成应用中采用了相同的想法,如text2image[41]、图像修复[38]和未来预测[36],以及视频[54]和3D数据[57]等其他领域。GANs成功的关键在于对抗性损失迫使生成的图像在原则上与真实照片无法区分。这种损失对于图像生成任务来说尤其效果尤为强大,因为这正是许多计算机图形学旨在优化的目标。我们采用对抗性丢失来学习映射,这样翻译后的图像就无法与目标域中的图像区分开来 。

2.2.图像到图像的翻译

图像到图像转换的想法至少可以追溯到Hertzmann等人的图像类比[19],他们在单个输入输出训练图像对上采用了非参数纹理模型[10]。最近的方法使用输入输出示例数据集,使用CNN学习参数转换函数(例如[33])。我们的方法基于Isola等人[22]的**“pix2pix”框架**,该框架使用条件生成对抗网络[16]来学习从输入到输出图像的映射。类似的想法也被应用到各种任务中,比如从草图[44]或从属性和语义布局[25]生成照片。然而,与前面的工作不同,我们学习映射时没有成对的训练示例。

2.3. 未配对图像到图像的翻译

其他几种方法也可以处理未配对设置,其目标是关联两个数据域:X和Y。Rosales等人[42]提出了一个贝叶斯框架,该框架包括从源图像计算的基于补丁的马尔可夫随机场的先验知识和从多个样式图像获得的似然项。最近,CoGAN[32]和跨模态场景网络[1]使用权重共享策略来学习跨域的公共表示。与我们的方法同时,Liu等人[31]将上述框架扩展为可变自动编码器[27]和生成性对抗网络[16]的组合。另一种并行工作[46、49、2]鼓励输入和输出共享特定的“内容”特征,尽管它们在“风格”上可能有所不同。这些方法还使用对抗性网络,并使用额外的术语来强制输出在预定义的度量空间(如类标签空间[2])中接近输入、图像像素空间[46]和图像特征空间[49]。

与上述方法不同,我们的公式不依赖于输入和输出之间任何特定于任务的预定义相似性函数,也不假设输入和输出必须位于同一低维嵌入空间中。这使我们的方法成为许多视觉和图形任务的通用解决方案。我们在第5.1节中直接比较了几种先前和当代的方法。

2.4.循环一致性

使用转递性来规范结构化数据的想法由来已久。在视觉跟踪中,强制执行简单的前后一致性几十年来一直是一个标准技巧[24,48]。在语言领域,通过“反向翻译和协调”验证和改进翻译是人类翻译人员[3](幽默地说,包括马克·吐温[51])以及机器[17]使用的一种技术。最近,高阶循环一致性被用于运动结构[61]、三维形状匹配[21]、共分段[55]、密集语义对齐[65,64]和深度估计[14]。其中,Zhou等人[64]和Godard等人[14]与我们的工作最为相似,因为他们使用循环一致性损失作为使用及物性监督CNN培训的一种方式。在这项工作中,我们引入了一个类似的损耗来推动G和F相互一致。与我们的工作同时,在这些相同的程序中,Yi等人[59]在机器翻译的双重学习[17]的启发下,独立使用了一个类似的未配对图像到图像翻译的目标。

2.5.神经风格转移

神经风格转换[13,23,52,12]是执行图像到图像转换的另一种方法,它通过匹配预先训练的深度特征的Gram矩阵统计信息,将一幅图像的内容与另一幅图像(通常是一幅画)的风格相结合,合成一幅新图像。另一方面,我们主要关注的是通过尝试捕捉更高层次的外观结构之间的对应关系,学习两个图像集合之间的映射,而不是两个特定图像之间的映射。因此,我们的方法可以应用于其他任务,例如绘画→ 照片、物体变形等,单一样本转移方法效果不佳。我们在第5.2节中比较了这两种方法。

3.公式

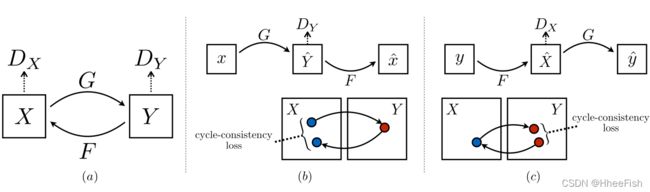

我们的目标是学习两个域X和Y给定的训练样本{xi}Ni=1之间的映射函数,其中xi∈ X和{yj}Mj=1,其中yj∈ Y 。我们将数据分布表示为x∼ pdata(x)和y∼ pdata(y)。如图3(a)所示,我们的模型包括两个映射G:X→ Y和F:Y→X 此外,我们引入了两个对抗性鉴别器DX和DY,其中DX旨在区分图像{X}和翻译图像{F(y)};同样,DY的目的是区分{y}和{G(x)}。我们的目标包括两类:对抗性损失[16],用于将生成的图像分布与目标域中的数据分布相匹配;循环一致性损失,以防止学习到的映射G和F相互矛盾。

图3:(a)我们的模型包含两个映射函数G:X→ Y和F:Y→ X、 以及相关的对抗性鉴别器DY和DX。DY鼓励G将X转换为与域Y不可区分的输出,反之亦然,用于DX、F和DX。为了进一步正则化映射,我们引入了两个“周期一致性损失”,它们捕捉到了这样一种直觉:如果我们从一个域转换到另一个域,然后再转换回来,我们应该到达我们开始的地方:(b)前向周期一致性损失:x→ G(x)→ F(G(x))≈ x、 和(c)反向循环一致性损失:y→ F(y)→ G(F(y))≈ y

3.1.对抗损失

我们将对抗性损失[16]应用于两个映射函数。对于映射函数G:X→ Y及其鉴别器DY,我们将目标表示为:

其中,G试图生成看起来与域Y中的图像相似的图像G(x),而DY的目的是区分翻译样本G(x)和真实样本Y。G的目的是最小化这个目标,以对抗试图最大化它的对手D,即minG maxDY LGAN(G,DY,X,Y)我们为映射函数F:Y→ X引入了类似的对抗损失及其鉴别器DX:即minF maxDX LGAN(F,DX,Y,X)

3.2.循环一致性损失

从理论上讲,对抗性训练可以学习映射G和F,它们分别产生与目标域Y和X相同分布的输出(严格来说,这要求G和F是随机函数)[15]。然而,如果容量足够大,网络可以将同一组输入图像映射到目标域中的任意图像随机排列,其中任何学习到的映射都可以产生与目标分布匹配的输出分布。因此,仅仅对抗性的损失不能保证习得的函数可以将单个输入xi映射到期望的输出yi。为了进一步减少可能的映射函数的空间, 我们认为,所学的映射函数应该是周期一致的:如图3(b)所示,对于域x中的每个图像x,图像转换循环应该能够将x带回原始图像,即x→ G(x)→ F(G(x))≈ x、 我们称之为前向循环一致性。类似地,如图3(c)所示,对于来自域Y的每个图像y、G和F,也应该满足反向循环一致性:y→ F(y)→ G(F(y))≈ y、 我们使用周期一致性损失来激励这种行为:

在初步实验中,我们还尝试用F(G(x))和x之间,以及G(F(y))和y之间的对抗性损失来替换这种损失中的L1范数,但没有观察到性能的改善。

在图4中可以观察到由循环一致性损失引起的行为:重构图像F(G(x))最终与输入图像x紧密匹配

3.3.整个优化对象

我们的全部目标是: .

其中λ控制两个目标的相对重要性。我们的目标是解决:

请注意,我们的模型可以被视为训练两个“自动编码器”[20]:我们学习一个自动编码器F◦ G:X→ X联合另一个G◦ F:Y→ Y。然而,这些自动编码器都有特殊的内部结构:它们通过中间表示将图像映射到自身,中间表示是将图像转换到另一个域中。这种设置也可以被视为“对抗性自动编码器”[34]的特例,它使用对抗性损失来训练自动编码器的瓶颈层,以匹配任意目标分布。在我们的例子中,X→ X的目标分布自动编码器是域Y的自动编码器。

在第5.1.4节中,我们将我们的方法与整个目标的消融进行了比较,包括单独的对抗性损失LGAN和单独的周期一致性损失Lcyc,并从经验上证明,这两个目标在获得高质量结果方面起着关键作用。我们还评估了我们的方法,仅在一个方向上有周期损失,并表明单个周期不足以正则化这个欠约束问题的训练。

4.实现

4.1.网络结构

我们采用了Johnson等人[23]的生成网络架构,他们在神经风格转换和超分辨率方面取得了令人印象深刻的结果。该网络包含三个卷积、几个剩余块[18],两个步幅为1-2的分步卷积,以及一个将特征映射到RGB的卷积。我们对128×128图像使用6个块,对256×256及更高分辨率的训练图像使用9个块。与Johnson等人[23]类似,我们使用实例规范化[53]。对于鉴别器网络,我们使用70×70补丁[22,30,29],其目的是分类70×70重叠图像补丁是真是假。这种面片级鉴别器结构的参数比全图像鉴别器少,可以以完全卷积的方式处理任意化的图像[22]。

4.2.训练细节

我们应用最近工作中的两种技术来稳定我们的模型训练过程。首先,对于LGAN(方程式1),我们将负对数似然目标替换为最小二乘损失[35]。这种损失在训练期间更稳定,并产生更高质量的结果。特别地,对于GAN损耗LGAN(G,D,X,Y),我们训练G以最小化Ex∼pdata(x)[(D(G(x))− 1) 2]并对D进行训练,以尽量减少Ey∼pdata(y)[(D(y)− 1)2]+Ex∼pdata(x)[D(G(x))2]。

其次,为了减少模型振荡[15],我们遵循Shrivastava等人的策略[46],使用生成图像的历史记录而不是最新生成的图像更新discriminator。我们保留一个图像缓冲区,用于存储之前创建的50幅图像。对于所有实验,我们在方程3中设置λ=10。我们使用批次大小为1的Adam solver[26]。所有网络都从零开始接受培训,学习率为0.0002。我们在前100个时期保持相同的学习率,在接下来的100个时期内线性衰减到零。有关数据集、体系结构和培训程序的更多详细信息,请参见附录(第7节)。

5.结果

首先,我们将我们的方法与最近在成对数据集上进行未配对图像到图像翻译的方法进行比较,在配对数据集上,地面真值输入输出对可用于评估。然后,我们研究了对抗性损失和周期一致性损失的重要性,并将我们的完整方法与几种变体进行了比较。最后,我们展示了我们的算法在不存在成对数据的广泛应用中的通用性。为了简单起见,我们将我们的方法称为CycleGAN。PyTorch和Torch代码、模型和完整结果可在我们的网站上找到。

5.1.评估

使用与“pix2pix”相同的评估数据集和指标[22],我们将我们的方法与几个基线进行定性和定量比较。这些任务包括语义标签↔城市景观数据集[4]上的照片和地图↔从谷歌地图上截取的数据上的航拍照片。我们还对全损失函数进行了消融研究。

5.1.1.评估指标

Amazon Mechanical Turk perceptual studies

在地图上↔在航拍任务中,我们对Amazon Mechanical Turk (AMT)进行“真假”知觉研究,以评估我们输出的真实性。我们遵循与Isola等人[22]相同的知觉研究方案,只是我们只从每个测试算法的25名参与者那里收集数据。向参与者展示一系列成对的图像,一张是真实的照片或地图,另一张是假的(由我们的算法或基线生成),并要求他们点击他们认为是真实的图像。每节课的前10次试验都是练习,并就参与者的回答是否正确给出反馈。剩下的40项试验用于评估每种算法欺骗参与者的比率。每个环节只测试一个算法,参与者只允许完成一个环节。我们在这里报告的数字与[22]中的数字没有直接的可比性,因为我们对地面真相图像的处理略有不同2,我们测试的参与者池可能与[22]中测试的参与者池的分布不同(因为在不同的日期和时间进行实验)。因此,我们的数字应该只用于比较我们当前的方法与基线(在相同条件下运行

FCN分数 **

虽然知觉研究可能是评估图形真实性的黄金标准,但我们也寻求一种不需要人类实验的自动定量测量方法。为此,我们采用[22]中的“FCN分数”,并使用它来评估城市景观标签→拍照任务。FCN度量根据现成的语义分割算法(完全卷积网络,FCN,摘自[33])评估生成的照片的可解释性。FCN预测生成照片的标签图。然后,可以使用标准语义segmen在测试时在512×512图像上卷积运行**,将该标签图与输入的地面真相标签进行比较。在我们的实验中,我们选择256×256,因为许多基线无法扩展到高分辨率图像,而且COGA无法完全卷积测试。下文介绍了这些指标。直觉是,如果我们从**“道路上的汽车”的标签地图生成一张照片**,那么如果应用于生成的照片的FCN检测到“道路上的汽车”,我们就成功了。

语义分割度量 **

评估照片的性能→标签,我们使用城市景观基准[4]中的标准度量,包括像素精度、每类精度和联合上的平均类交集**(类IOU)[4]。

5.1.2.基线

CoGAN **

该方法学习一个用于域X的GAN生成器和一个用于域Y的GAN生成器**,在前几层上绑定权重以共享潜在表示。从X到Y的转换可以通过找到生成图像X的潜在表示,然后将该潜在表示渲染为样式Y来实现。

SimGAN

与我们的方法一样,Shrivastava等人[46]使用对抗性损失训练从X到Y的翻译。正则化项||x− G(x)||1用于惩罚在像素级进行大的变化。

Feature loss + GAN

我们还测试了SimGAN[46]的一种变体,其中L1损耗是使用预训练网络(VGG-16 relu4 2[47])在深度图像特征上计算的,而不是在RGB像素值上计算的。像这样在深层特征空间中计算距离有时也被称为使用“感知损失”[8,23]。

BiGAN/ALI **

无条件GANs[16]学习生成器G:Z→X,这将随机噪声z映射到图像X**。BiGAN[9]和ALI[7]还建议学习逆映射函数F:X→ Z.虽然它们最初设计用于将潜在向量Z映射到图像x,但我们实现了将源图像x映射到目标图像y的相同目标。

pix2pix

我们还将其与pix2pix[22]进行了比较,pix2pix[22]是根据成对数据进行训练的,以观察在不使用任何成对数据的情况下,我们能多接近这个“上限”。

为了进行公平比较,我们使用与我们的方法相同的架构和细节来实现所有基线,除了CoGAN[32]。CoGAN建立在生成器的基础上,该生成器从共享的潜在表示生成图像,这与我们的图像到图像网络不兼容。我们使用CoGAN的公共实现。

5.1.3.与基线的比较

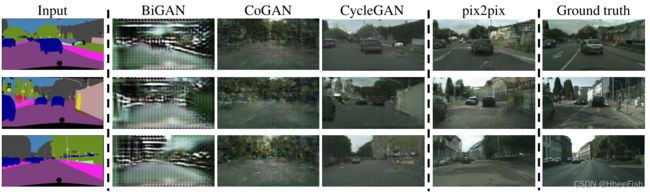

图5:绘制航空照片的不同方法↔谷歌地图上的地图。从左到右:输入、BiGAN/ALI[6,7]、CoGAN[28]、CycleGAN(我们的)、根据配对数据训练的pix2pix[20]和地面真相。

图6:映射标签方法的不同变体↔在城市景观上训练的照片。从左到右:输入,仅循环一致性损失,仅对抗性损失,GAN+前向循环一致性损失(F(G(x))≈ x) ,GAN+反向循环一致性损失(G(F(y))≈ y) 、CycleGAN(我们的完整方法)和地面真相。Cycle One和GAN+backward都无法生成与目标域相似的图像。GAN单独和GAN+正向受到模式崩溃的影响,无论输入照片如何,都会产生相同的标签贴图。

如图5和图6所示,我们无法在任何基线上取得令人信服的结果。 我们的方法另一方面可以生成通常与完全监督的pix2pix具有相似质量的翻译。

表1报告了AMT知觉现实主义任务的表现。在这里,我们可以看到,我们的方法可以在两张地图上的大约四分之一的试验中欺骗参与者→航拍照片方向和航拍照片→以256×256分辨率映射方向3。所有的基线几乎从未欺骗过参与者。

表1:地图上的AMT“真假”测试↔航拍照片

表2:城市景观标签上评估的不同方法的FCN分数→照片。

表3:照片的分类性能→城市景观上不同方法的标签。

表2评估了标签的性能→城市景观上的照片任务。表3评估了相反的地图(照片→标签)。在这两种情况下,我们的方法再次优于基线。

5.1.4.损失函数的分析

在表4和表5中,我们比较了我们全部损失的消融情况。去除GAN损耗会显著降低结果,去除循环一致性损耗也是如此。因此,我们得出结论,这两个术语对我们的结果都至关重要。我们还评估了我们的方法,周期损耗仅在一个方向:GAN+正向周期损耗Ex∼pdata(x)[||F(G(x))−x||1]或GAN+反向循环损耗Ey∼pdata(y)[||G(F(y))−y||1](方程式2),发现它通常会导致训练不稳定,并导致模式崩溃,尤其是对于移除的映射方向。图7显示了几个定性示例。

5.1.5.图像重建质量

图4:映射标签的不同方法→在城市景观上训练的照片。从左到右:输入、BiGAN/ALI[6,7]、CoGAN[28]、CycleGAN(我们的)、根据配对数据训练的pix2pix[20]和地面真相

在图4中,我们展示了重建图像F(G(x))的几个随机样本。我们观察到,在训练和测试时,重建的图像往往接近原始输入x,即使在一个域代表更多样化信息的情况下,如map↔航空照片。

5.1.6.配对数据集的其他结果

图8显示了“pix2pix”[22]中使用的其他成对数据集的一些示例结果,例如架构标签↔来自CMP Facade数据库的照片[40],以及边缘↔UT Zapposo50K数据集中的鞋子[60]。我们的结果的图像质量接近于完全监督的pix2pix,而我们的方法在没有成对监督的情况下学习映射

5.2.应用

我们在几个不存在成对训练数据的应用中演示了我们的方法。有关数据集的更多详细信息,请参阅附录(第7节)。我们观察到,训练数据的翻译通常比测试数据的翻译更具吸引力,训练和测试数据的所有应用程序的完整结果都可以在我们的项目网站上查看。

集合样式转换(图10和图11)

我们在Flickr和WikiArt下载的风景照片上训练模型。与最近关于“神经风格转移”的研究不同[13],我们的方法学习模仿整个艺术作品集的风格,而不是转移单个选定艺术作品的风格。因此,我们可以学习以梵高(V an Gogh)的风格生成照片,而不仅仅是星夜的风格。对于塞尚、莫奈、梵高和浮世绘,每个艺术家/风格的数据集大小分别为526、1073、400和563。

**对象变形(图13) **

该模型经过训练,可以将一个对象类从ImageNet[5]转换为另一个对象类(每个类包含大约1000个训练图像)。Turmukhambetov等人[50]提出了一个子空间模型,将一个对象转换为同一类别的另一个对象,而我们的方法侧重于两个视觉相似类别之间的对象变形。

**季节转换(图13) **

该模型接受了从Flickr下载的854张冬季照片和1273张夏季照片的训练。

**从绘画中生成照片(图12) **.

用于绘画→我们发现,引入额外的损失有助于鼓励映射以保持输入和输出之间的颜色组成。特别是,我们采用了Taigman等人[49]的技术,当目标域的真实样本作为生成器的输入时,将生成器正则化为接近身份映射:即Lidentity(G,F)=Ey∼pdata(y)[||G(y)− y||1]+Ex∼pdata(x)[||F(x)− x||1]。

如果没有Lidentity,生成器G和F可以在无需更改输入图像的色调时自由更改。例如,在学习莫奈绘画和Flickr照片之间的映射时,生成器通常会将白天的绘画映射到日落时拍摄的照片,因为这种映射在对抗性损失和周期一致性损失下可能同样有效。这种身份映射丢失的影响如图9所示。

在图12中,我们展示了将莫奈的绘画转化为照片的其他结果。此图和图9显示了训练集中包含的绘画的结果,而对于本文中的所有其他实验,我们只评估和显示测试集的结果。因为训练集不包含配对数据,所以为训练集绘制提供一个合理的翻译是一项不平凡的任务。事实上,由于莫奈不再能够创作新的绘画作品,将其概括为看不见的“测试集”,绘画并不是一个紧迫的问题。

**照片增强(图14) **

我们表明,我们的方法可以用于生成景深较浅的照片。我们在Flickr下载的花朵照片上训练模型。源域由智能手机拍摄的花朵照片组成,由于孔径较小,这些照片通常具有较深的自由度。目标包含由具有较大光圈的单反相机拍摄的照片。我们的模型成功地从智能手机拍摄的照片生成了景深较浅的照片。

**与Gatys等人的比较。 **

在图15中,我们将我们的结果与照片风格化的神经风格转移[13]进行了比较。对于每一行,我们首先使用两件具有代表性的艺术品作为[13]的风格图像。另一方面,我们的方法可以生成整个收藏风格的照片。为了与整个集合的神经风格转移进行比较,我们计算了整个目标域的平均Gram矩阵,并使用该矩阵转移Gatys等人[13]的“平均风格”。

图16展示了其他翻译任务的类似比较。我们观察到,Gatys等人[13]要求找到与所需输出非常匹配的目标样式图像,但仍然经常无法产生真实照片效果,而我们的方法成功地生成了与目标域类似的自然外观结果。

6.限制和讨论

虽然我们的方法在很多情况下都能取得令人信服的结果,但结果远不是一致的积极结果。图17显示了几种典型的故障情况。在涉及颜色和纹理变化的翻译任务中,正如上文所述,这种方法通常会成功。我们还探索了需要几何变化的任务,但收效甚微。例如,关于狗的任务→cat变形,学习的翻译退化为对输入进行最小的更改(图17)。这种故障可能是由我们的发电机架构造成的,这些架构是为在外观变化方面的良好性能而定制的。处理更加多样和极端的变换,尤其是几何变化,是未来工作的一个重要问题。

一些故障案例是由训练数据集的分布特征引起的。例如,我们的方法在马身上被搞糊涂了→ 斑马示例(图17,右),因为我们的模型是在ImageNet的野马和斑马合成集上训练的,它不包含骑马或斑马的图像。

我们还观察到,配对训练数据的结果与未配对方法的结果之间仍然存在差距。在某些情况下,这一差距可能很难缩小,甚至不可能缩小:例如,我们的方法有时会在照片的输出中排列树和建筑物的标签→标签任务。解决这种歧义可能需要某种形式的弱语义监督。集成弱数据或半监督数据可能会产生更强大的翻译人员,但其成本仍然只是完全监督系统的注释成本的一小部分。

尽管如此,在许多情况下,完全不成对的数据是充分可用的,应该加以利用。本文突破了在这种“无监督”环境下可能发生的事情的界限。

7.附录

7.1.训练细节

我们从头开始训练我们的网络,学习率为0.0002。在实践中,我们将目标除以2,同时优化D,这会降低D相对于G的学习速度。我们在前100个阶段保持相同的学习速度,并在接下来的100个阶段线性衰减到零。根据高斯分布N(0,0.02)初始化权重。

城市景观标签↔照片

2975来自城市景观训练集[4]的训练图像,图像大小为128×128。我们使用Cityscapes val集进行测试。

地图↔航空照片

1096张训练图像是从谷歌地图[22]上截取的,图像大小为256×256。这些图像是从纽约市及其周边地区采集的。然后将数据分为关于采样区域的中间纬度的训练和测试(添加缓冲区以确保测试集中没有出现训练像素)。

建筑立面标签↔图

400 CMP Facade数据库中的训练图像[40]。边缘→来自UT Zapposo50K数据集的大约50000张训练图像[60]。该模型训练了5个时期。

马↔斑马和苹果↔橙

我们使用关键词野马、斑马、苹果和脐橙从ImageNet[5]下载了这些图像。图像被缩放到256×256像素。每个班级的训练集大小:939(马)、1177(斑马)、996(苹果)和1020(橙色)。

夏天↔冬天

使用Flickr API下载图像,带有yosemite标记和DateTake字段。黑白照片被删掉了。图像被缩放到256×256像素。每个类的训练规模:1273(夏季)和854(冬季)。

照片↔艺术风格转换

艺术图片是从Wikiart下载的。一些素描或太淫秽的艺术品被手工修剪。这些照片是从Flickr下载的,结合了景观和景观摄影。黑白照片被删掉了。图像被缩放到256×256像素。每个班级的培训规模分别为1074(莫奈)、584(塞尚)、401(梵高)、1433(浮世绘)和6853(照片)。莫奈的数据集被特别删减,只包括风景画,梵高的数据集只包括代表他最知名艺术风格的后期作品。

莫奈的绘画→照片

为了在保存内存的同时获得高分辨率的照片,我们使用原始图像的随机方形裁剪进行训练。为了生成结果,我们将宽度为512像素、纵横比正确的图像作为输入传递到生成器网络。恒等映射损失的权重为0.5λ,其中λ是循环一致性损失的权重。我们设定λ=10。

花朵照片增强

通过使用搜索文本Flower搜索苹果iPhone 5、5s或6拍摄的照片,可以从Flickr下载智能手机上拍摄的花朵图片。具有浅自由度的DSLR图像也通过搜索标签flower,DoF从Flickr下载。这些图像按宽度缩放到360像素。采用同一映射失重0.5λ。智能手机和DSLR数据集的训练集大小分别为1813和3326。我们设定λ=10。

7.2. 网络架构

我们提供PyTorch和Torch实现。

生成器架构

我们采用Johnson等人[23]的架构。对于128×128的训练图像,我们使用6个残差块,对于256×256或更高分辨率的训练图像,我们使用9个残差块。下面,我们遵循Johnson等人的Github存储库中使用的命名约定。

设c7s1-k表示一个7×7卷积-InstanceNorm-RELU层,带有k滤波器和步长1。dk表示一个3×3卷积InstanceNRM ReLU层,带有k个滤波器和步长2。反射填充用于减少伪影。Rk表示包含两个3×3卷积层的剩余块,两层上的滤波器数量相同。uk表示3×3分数步进卷积Stanconorm ReLU层,带有k滤波器和步进1/2。

**鉴别器结构 **

对于鉴别器网络,我们使用70×70 PatchGAN[22]。设Ck表示一个4×4卷积瞬时形式的漏层,带有k个滤波器和跨步2。在最后一层之后,我们应用卷积来产生一维输出。我们在第一个C64层中不使用InstanceNorm。我们使用的是坡度为0.2的leaky ReLUs。鉴别器结构为:C64-C128-C256-C512

参考文献

[1] Y . Aytar, L. Castrejon, C. V ondrick, H. Pirsiavash, and A. Torralba. Cross-modal scene networks. PAMI, 2016. 3

[2] K. Bousmalis, N. Silberman, D. Dohan, D. Erhan, and D. Krishnan. Unsupervised pixel-level domain a^daptation with generative adversarial networks. In CVPR, 2017. 3

[3] R. W. Brislin. Back-translation for cross-cultural research. Journal of cross-cultural psychology, 1(3):185–216, 1970. 2, 3

[4] M. Cordts, M. Omran, S. Ramos, T. Rehfeld, M. Enzweiler, R. Benenson, U. Franke, S. Roth, and B. Schiele. The cityscapes dataset for semantic urban scene understanding. In CVPR, 2016. 2, 5, 6, 18

[5] J. Deng, W. Dong, R. Socher, L.-J. Li, K. Li, and L. Fei-Fei. Imagenet: A large-scale hierarchical image database. In CVPR, 2009. 8, 13, 18

[6] E. L. Denton, S. Chintala, R. Fergus, et al. Deep generative image models using a laplacian pyramid of adversarial networks. In NIPS, 2015. 2

[7] J. Donahue, P . Krähenbühl, and T. Darrell. Adversarial feature learning. In ICLR, 2017. 6, 7

[8] A. Dosovitskiy and T. Brox. Generating images with perceptual similarity metrics based on deep networks. In NIPS, 2016. 7

[9] V . Dumoulin, I. Belghazi, B. Poole, A. Lamb, M. Arjovsky, O. Mastropietro, and A. Courville. Adversarially learned inference. In ICLR, 2017. 6, 7

[10] A. A. Efros and T. K. Leung. Texture synthesis by non-parametric sampling. In ICCV, 1999. 3

[11] D. Eigen and R. Fergus. Predicting depth, surface normals and semantic labels with a common multi-scale convolutional architecture. In ICCV, 2015. 2

[12] L. A. Gatys, M. Bethge, A. Hertzmann, and E. Shechtman. Preserving color in neural artistic style transfer. arXiv preprint arXiv:1606.05897, 2016. 3

[13] L. A. Gatys, A. S. Ecker, and M. Bethge. Image style transfer using convolutional neural networks. CVPR, 2016. 3, 8, 9, 14, 15

[14] C. Godard, O. Mac Aodha, and G. J. Brostow. Unsupervised monocular depth estimation with left-right consistency. In CVPR, 2017. 3

[15] I. Goodfellow. NIPS 2016 tutorial: Generative adversarial networks. arXiv preprint arXiv:1701.00160, 2016. 2, 4, 5

[16] I. Goodfellow, J. Pouget-Abadie, M. Mirza, B. Xu, D. Warde-Farley, S. Ozair, A. Courville, and Y . Bengio. Generative adversarial nets. In NIPS, 2014. 2, 3, 4, 7

[17] D. He, Y . Xia, T. Qin, L. Wang, N. Y u, T. Liu, and W.-Y . Ma. Dual learning for machine translation. In NIPS, 2016. 3

[18] K. He, X. Zhang, S. Ren, and J. Sun. Deep residual learning for image recognition. In CVPR, 2016. 5

[19] A. Hertzmann, C. E. Jacobs, N. Oliver, B. Curless, and D. H. Salesin. Image analogies. In SIGGRAPH, 2001. 2, 3

[20] G. E. Hinton and R. R. Salakhutdinov. Reducing the dimensionality of data with neural networks. Science, 313(5786):504–507, 2006. 5

[21] Q.-X. Huang and L. Guibas. Consistent shape maps via semidefinite programming. In Symposium on Geometry Processing, 2013. 3

[22] P . Isola, J.-Y . Zhu, T. Zhou, and A. A. Efros. Imageto-image translation with conditional adversarial networks. In CVPR, 2017. 2, 3, 5, 6, 7, 8, 18

[23] J. Johnson, A. Alahi, and L. Fei-Fei. Perceptual losses for real-time style transfer and super-resolution. In ECCV, 2016. 2, 3, 5, 7, 18

[24] Z. Kalal, K. Mikolajczyk, and J. Matas. Forwardbackward error: Automatic detection of tracking failures. In ICPR, 2010. 3

[25] L. Karacan, Z. Akata, A. Erdem, and E. Erdem. Learning to generate images of outdoor scenes from attributes and semantic layouts. arXiv preprint arXiv:1612.00215, 2016. 3

[26] D. Kingma and J. Ba. Adam: A method for stochastic optimization. In ICLR, 2015. 5

[27] D. P . Kingma and M. Welling. Auto-encoding variational bayes. ICLR, 2014. 3

[28] P .-Y . Laffont, Z. Ren, X. Tao, C. Qian, and J. Hays. Transient attributes for high-level understanding and editing of outdoor scenes. ACM TOG, 33(4):149, 2014. 2

[29] C. Ledig, L. Theis, F. Huszár, J. Caballero, A. Cunningham, A. Acosta, A. Aitken, A. Tejani, J. Totz, Z. Wang, et al. Photo-realistic single image superresolution using a generative adversarial network. In CVPR, 2017. 5

[30] C. Li and M. Wand. Precomputed real-time texture synthesis with markovian generative adversarial networks. ECCV, 2016. 5

[31] M.-Y . Liu, T. Breuel, and J. Kautz. Unsupervised image-to-image translation networks. In NIPS, 2017. 3

[32] M.-Y . Liu and O. Tuzel. Coupled generative adversarial networks. In NIPS, 2016. 3, 6, 7

[33] J. Long, E. Shelhamer, and T. Darrell. Fully convolutional networks for semantic segmentation. In CVPR, 2015. 2, 3, 6

[34] A. Makhzani, J. Shlens, N. Jaitly, I. Goodfellow, and B. Frey. Adversarial autoencoders. In ICLR, 2016. 5

[35] X. Mao, Q. Li, H. Xie, R. Y . Lau, Z. Wang, and S. P . Smolley. Least squares generative adversarial networks. In CVPR. IEEE, 2017. 5

[36] M. Mathieu, C. Couprie, and Y . LeCun. Deep multiscale video prediction beyond mean square error. In ICLR, 2016. 2

[37] M. F. Mathieu, J. Zhao, A. Ramesh, P . Sprechmann, and Y . LeCun. Disentangling factors of variation in deep representation using adversarial training. In NIPS, 2016. 2

[38] D. Pathak, P . Krahenbuhl, J. Donahue, T. Darrell, and A. A. Efros. Context encoders: Feature learning by inpainting. CVPR, 2016. 2

[39] A. Radford, L. Metz, and S. Chintala. Unsupervised representation learning with deep convolutional generative adversarial networks. In ICLR, 2016. 2

[40] R. ˇS. Radim Tyleˇcek. Spatial pattern templates for recognition of objects with regular structure. In Proc. GCPR, Saarbrucken, Germany, 2013. 8, 18

[41] S. Reed, Z. Akata, X. Y an, L. Logeswaran, B. Schiele, and H. Lee. Generative adversarial text to image synthesis. In ICML, 2016. 2

[42] R. Rosales, K. Achan, and B. J. Frey. Unsupervised image translation. In ICCV, 2003. 3

[43] T. Salimans, I. Goodfellow, W. Zaremba, V . Cheung, A. Radford, and X. Chen. Improved techniques for training GANs. In NIPS, 2016. 2

[44] P . Sangkloy, J. Lu, C. Fang, F. Y u, and J. Hays. Scribbler: Controlling deep image synthesis with sketch and color. In CVPR, 2017. 3

[45] Y . Shih, S. Paris, F. Durand, and W. T. Freeman. Datadriven hallucination of different times of day from a single outdoor photo. ACM TOG, 32(6):200, 2013. 2

[46] A. Shrivastava, T. Pfister, O. Tuzel, J. Susskind, W. Wang, and R. Webb. Learning from simulated and unsupervised images through adversarial training. In CVPR, 2017. 3, 5, 6, 7

[47] K. Simonyan and A. Zisserman. V ery deep convolutional networks for large-scale image recognition. In ICLR, 2015. 7

[48] N. Sundaram, T. Brox, and K. Keutzer. Dense point trajectories by gpu-accelerated large displacement optical flow. In ECCV, 2010. 3

[49] Y . Taigman, A. Polyak, and L. Wolf. Unsupervised cross-domain image generation. In ICLR, 2017. 3, 8

[50] D. Turmukhambetov, N. D. Campbell, S. J. Prince, and J. Kautz. Modeling object appearance using context-conditioned component analysis. In CVPR, 2015. 8

[51] M. Twain. The jumping frog: in english, then in french, and then clawed back into a civilized language once more by patient. Unremunerated Toil, 3, 1903. 3

[52] D. Ulyanov, V . Lebedev, A. V edaldi, and V . Lempitsky. Texture networks: Feed-forward synthesis of textures and stylized images. In ICML, 2016. 3

[53] D. Ulyanov, A. V edaldi, and V . Lempitsky. Instance normalization: The missing ingredient for fast stylization. arXiv preprint arXiv:1607.08022, 2016. 5

[54] C. V ondrick, H. Pirsiavash, and A. Torralba. Generating videos with scene dynamics. In NIPS, 2016. 2

[55] F. Wang, Q. Huang, and L. J. Guibas. Image cosegmentation via consistent functional maps. In ICCV, 2013. 3

[56] X. Wang and A. Gupta. Generative image modeling using style and structure adversarial networks. In ECCV, 2016. 2

[57] J. Wu, C. Zhang, T. Xue, B. Freeman, and J. Tenenbaum. Learning a probabilistic latent space of object shapes via 3d generative-adversarial modeling. In NIPS, 2016. 2

[58] S. Xie and Z. Tu. Holistically-nested edge detection. In ICCV, 2015. 2

[59] Z. Yi, H. Zhang, T. Gong, Tan, and M. Gong. Dualgan: Unsupervised dual learning for image-to-image translation. In ICCV, 2017. 3

[60] A. Y u and K. Grauman. Fine-grained visual comparisons with local learning. In CVPR, 2014. 8, 18

[61] C. Zach, M. Klopschitz, and M. Pollefeys. Disambiguating visual relations using loop constraints. In CVPR, 2010. 3

[62] R. Zhang, P . Isola, and A. A. Efros. Colorful image colorization. In ECCV, 2016. 2

[63] J. Zhao, M. Mathieu, and Y . LeCun. Energy-based generative adversarial network. In ICLR, 2017. 2

[64] T. Zhou, P . Krahenbuhl, M. Aubry, Q. Huang, and A. A. Efros. Learning dense correspondence via 3dguided cycle consistency. In CVPR, 2016. 2, 3

[65] T. Zhou, Y . J. Lee, S. Y u, and A. A. Efros. Flowweb: Joint image set alignment by weaving consistent, pixel-wise correspondences. In CVPR, 2015. 3

[66] J.-Y . Zhu, P . Krähenbühl, E. Shechtman, and A. A. Efros. Generative visual manipulation on the natural image manifold. In ECCV, 2016. 2