AI安检:北航提出安检场景下的危险品检测基准和去遮挡注意力模块

©作者 | 尉言路、陶仁帅

学校 | 北京航空航天大学

研究方向 | 目标检测、小样本学习

随着公共交通枢纽中人群密度的不断增加,安全检查在保护公共空间免受恐怖主义等安全威胁方面的作用越来越重要。安检通常采用 X 射线扫描仪来检查行李中是否含有违禁物品。然而,在安检场景中,在行李箱中的物品是随机摆放的,并且彼此严重重叠,因此安检员要检测出违禁物品十分困难。同时,经过长时间地聚精会神地观看复杂的 X 光图像,安检人员难以准确检测出违禁物品。而频繁人员换班会耗费大量人力资源。因此,社会迫切需要一种快速、准确、自动化的方法来帮助安检员检测 X 射线扫描图像中的违禁物品。

随着深度学习技术的发展,特别是卷积神经网络的发展,在 X 射线图像中识别被遮挡的违禁物品可以看作是计算机视觉中的一个目标检测问题。北京航空航天大学研究团队发表在 ACM Multimedia 2020 上的本一篇题为《Occluded Prohibited Items Detection: An X-ray Security Inspection Benchmark and De-occlusion Attention Module》,提出了针对安检场景下的目标检测任务而设计的高质量数据集 OPIXray,该数据集中所有图片所包含的危险品都由某机场的专业安检员手动标注。

此外,该论文还提出了一种用于检测安检场景下遮挡的违禁物品的方法,该方法的核心是一个能够去遮挡的注意力模块(DOAM)。该模块可以作为一个即插即用的模块插入到大多数检测器中,目的是检测 X 光图像中被遮挡的危险品。

目前该论文提出的数据集和代码均已开源。

论文地址:

https://dl.acm.org/doi/10.1145/3394171.3413828

数据集和代码地址:

https://github.com/OPIXray-author/OPIXray

OPIXray数据集

一个高质量的含有违禁物品标注的专业数据集对于模型的训练和评估是必要的,因此,我们建立了第一个针对被遮挡的违禁物品检测任务的 X 光图片数据集。

1.1 数据采集

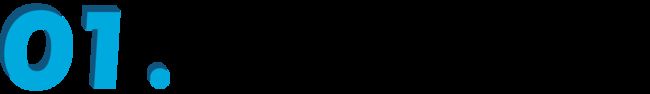

OPIXray 数据集的所有图像均由安检机扫描,并由国际机场的专业检查人员手工标注,标注标准为安检人员的培训标准。这些 X 射线图像仍然保留特定的特性,即不同的材质显示出不同的颜色,并且每个违禁物品都由一个方框进行定位。

▲ 图1 安检 X 光下不同刀具的成像

1.2 数据结构

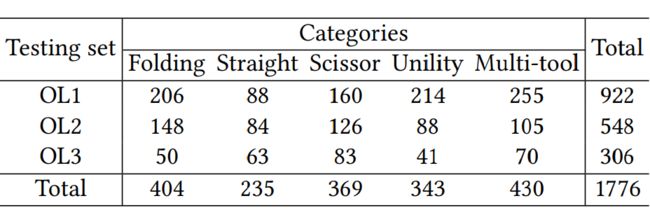

OPIXray 数据集包含 5 类刀具,一共 8885 张图像。5 类刀具分别是折叠刀、直刀、剪刀、美工刀、多功能刀。所有图像均以 JPG 格式存储,分辨率为 1225×954。数据集分为训练集和测试集,前者包含 80% 的图像(7109),后者包含 20% 的图像(1776),比例约为 4:1。

▲ 表1 数据集不同类别图片分布表

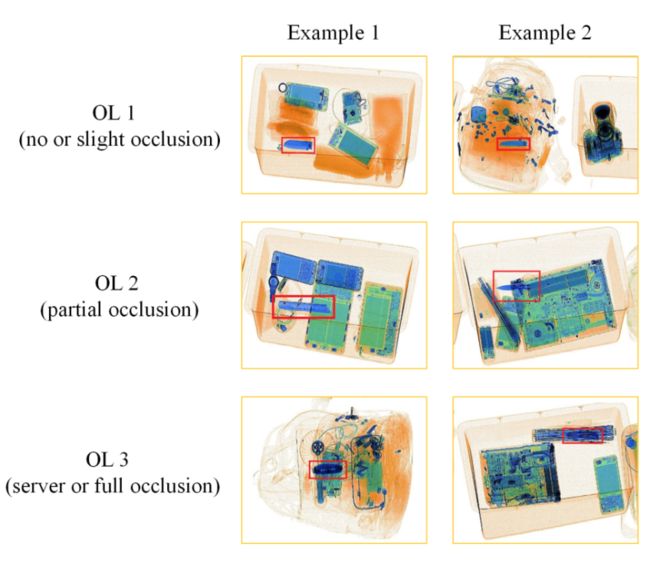

1.3 数据遮挡级别

为了研究违禁物品的遮挡等级带来的影响,我们将测试集分为三个子集,分别命名为遮挡级别 1(OL1)、遮挡级别 2(OL2)和遮挡级别 3(OL3)。其中数字表示图像中违禁物品的遮挡级别。OL1 表示违禁物品无遮挡或轻度遮挡,OL2 表示部分遮挡。为了最大限度地评估模型处理遮挡问题的能力,我们通过选择物体中存在严重遮挡或完全遮挡的图像来构建 OL3。

▲图2 不同遮挡等级的图片示意图

▲表2 数据集中不同遮挡等级的图片分布表

去遮挡注意力模块DOAM

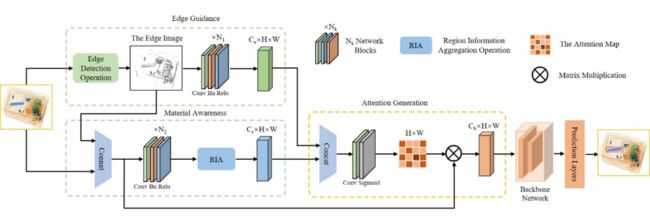

DOAM 的核心部件是三个子模块:边缘信息引导模块(Edge Guidance)、材质信息感知模块(Material Awareness)和注意力图生成模块(Attention Generation)。Edge Guidance 和 Material Awareness 分别捕获危险品的边缘信息和材质信息,Attention Generation 利用分别由边缘信息引导模块和材质信息感知模块生成的特征来生成注意力图,从而为检测器提供一个改良后的特征图。

▲ 图3 去遮挡注意力网络架构图

2.1 边缘信息引导模块(Edge Guidance)

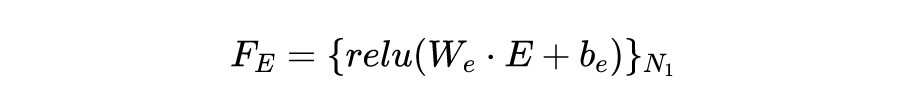

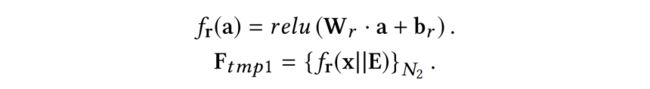

对于边缘信息引导模块,假设数据集中有 张训练图像 ,对于每个输入图像 ,我们使用 sobel 算子的水平核 与垂直核 分别计算水平和垂直方向的边缘图像 和 ,之后得到最终的边缘图为 ,并将 和输入的 RGB 图像 x 在通道维度进行拼接,以增强图像中所有对象的边缘信息。同时为了使边缘信息引导模块仅放大感兴趣对象的边缘信息,我们使用 N1 个网络块,每个块由一个卷积核大小为 3×3 的卷积层,一个 BN 层和一个 ReLU 层组成,用以提取边缘图像 PE 的特征图 ,该操作可以表述为:

其中 表示将操作重复 次,, 是卷积层的参数。提取特征图 后,模型会通过优化来自适应地关注特征图 FE 内的危险品的边缘信息。

2.2 材质信息感知模块(Material Awareness)

我们认为,材质信息主要体现在颜色和纹理上,这可以通过聚合区域信息来表示,因此我们提出了材质信息感知模块。我们首先利用 N2 个网络块来提取输入数据的特征图,该操作可以表述为:

其中 || 表示通道拼接操作。

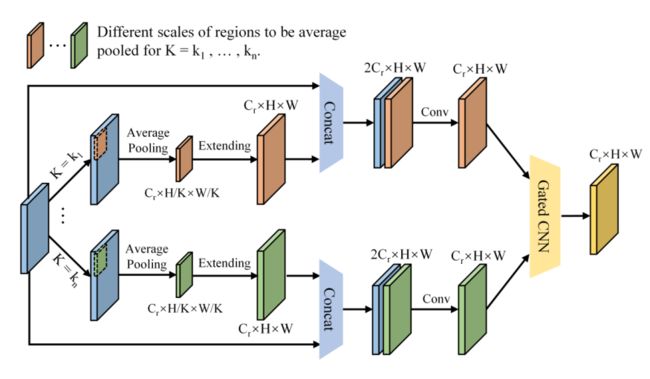

▲ 图4 区域聚合模块的架构图

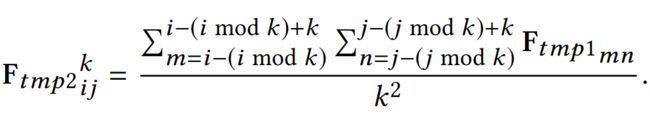

之后,我们对特征进行区域信息聚合操作(RIA),我们使用平均池化来聚合各个区域的信息,并对每个区域生成聚合区域尺度为 时的区域聚合特征图,从而进一步定义不同聚合区域尺度下的特征集,该操作可以表述为:

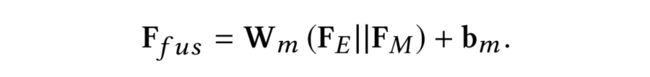

2.3 注意力图生成模块(Attention Generation)

对于边缘信息引导模块和材质信息感知模块分别输出的特征图 与 ,将其进行拼接来融合两个模块的特征信息,随后使用 1×1 的卷积核对通道维度进行压缩,生成用于计算注意力分数的特征图 ,该操作可以表述为:

其中 || 表示级联操作,, 是卷积层的参数。

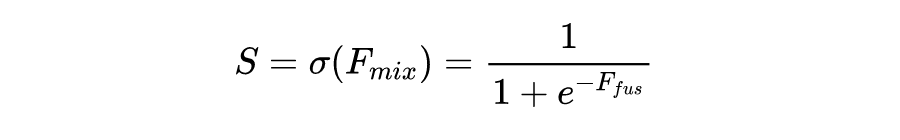

随后将 作为 Sigmoid 激活函数的输入,并以此生成注意力分数图,操作如下:

其中 ,与输入数据的维度大小一致。

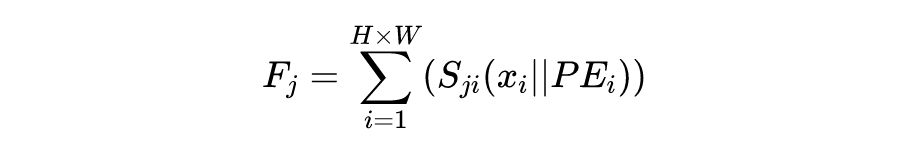

最终,使用得到的注意力分数图 S 与输入数据计算内积得到经过注意力聚焦后的特征信息作为后续卷积网络的输入来提取特征用于危险品的预测,该操作可以描述为:

其中 为注意力聚焦后的特征信息也就是最终生成的特征图。

实验结果

我们将 DOAM 和常见的注意力机制 DANet、SENet、Non-local 进行了对比,并将我们的模块整合到常见的检测算法上(SSD、Yolo-v3、FCOS),然后分别和整合之前的检测算法进行了对比。我们还进行了消融实验,并对我们的注意力机制进行了可视化。

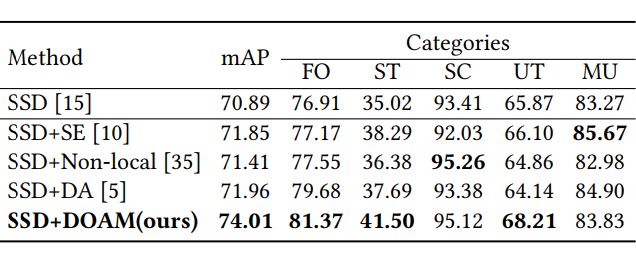

3.1 与常见注意力机制对比实验

如下图所示,我们以 SSD 框架为基本框架,分别在上面添加 SE、Non-local、DA、DOAM 注意力机制,然后在我们数据集(不分遮挡等级)上进行了实验。实验结果表明,在 X 光安检图片上,我们的模块普遍优于现有的注意力机制。

▲ 表3 在不同类别上对比场景注意力机制实验结果

我们还在遮挡等级分级后的数据集上进行了实验,实验结果表明,我们的模块优于现有的注意力机制。并且可以看到,当遮挡等级越高时,我们的模块比其他注意力机制提升的效果越多。

▲ 表4 在不同遮挡等级上对比场景注意力机制实验结果

3.2 与常见检测算法的对比实验

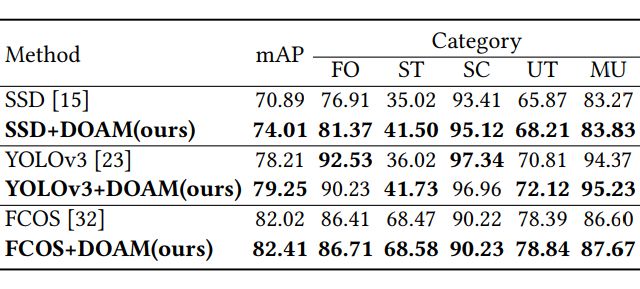

我们将我们的模块添加到了不同的检测算法 SSD、Yolo-v3、FCOS 上,如下表所示,结果表明,添加后的新算法明显优于基础算法。

▲ 表5 对比常见的检测算法

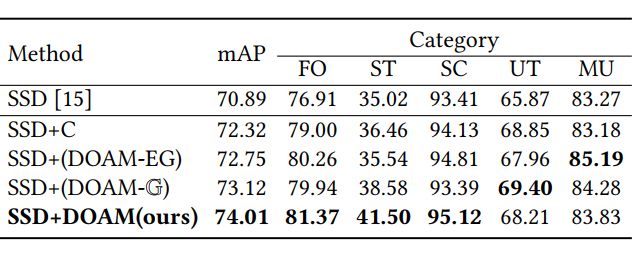

3.3 消融实验

我们对模块进行了消融实验,来证明各个部分都是有效的。如下表所示:

▲ 表6 消融实验

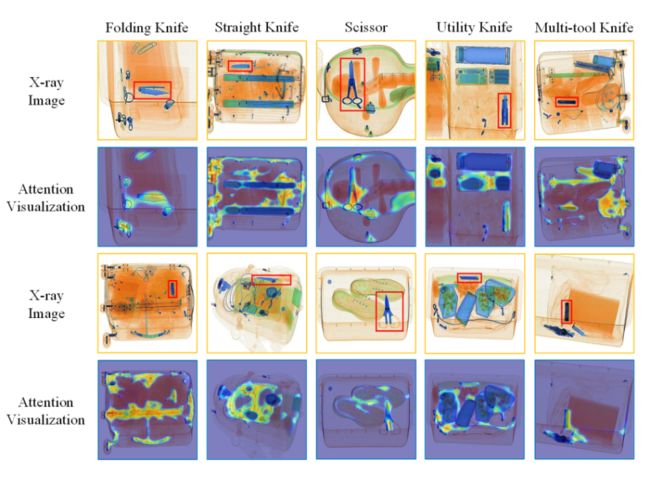

3.4 注意力机制可视化

我们对模块的注意力机制进行了可视化,效果如下图所示,可以看到,注意力机制使得模型更加关注于危险品所在的区域,印证了我们利用边缘信息和材质信息的有效性。

▲ 图4 注意力分数图可视化效果展示图

未来展望

计算机视觉技术的进步推动着人工智能时代的到来,视觉技术在我们日常生活中应用广泛,产生了巨大的社会价值。在视觉技术中,热门领域主要为人脸识别、自动驾驶、行人检测等,这些技术的发展极大改善了我们的生活。

AI 安检是一个相对小众的话题,如果能够成功应用于生活实践中,不仅能够提升我们进入火车站、机场的效率,同时极大地节省人工成本,将带来巨大的社会效益。然而,由于在安检过程中,由于行李包裹中的物品随意摆放,互相遮挡,导致机器在 X 光检测的图片中要找出危险物品十分困难。我们应当以更加积极的心态和更加挑剔的眼光去看待 AI 安检,现有技术距离 AI 安检成熟落地还有很多工作要做。

作者简介

尉言路(共同第一作者),北京航空航天大学硕士生,已入职中国移动通信研究院,主要研究方向为小目标检测、小样本学习。已有研究成果在 ACM MM,ICCV,CVPR 等国际顶级计算机视觉与多媒体会议上发表多篇论文,获 2020 年度硕士研究生国家奖学金。

陶仁帅(共同第一作者),北京航空航天大学博士在读,主要研究方向为复杂场景下的目标识别,包括去遮挡、域适应、小样本等,已在 CVPR、ICCV、ACM MM 等国际顶级计算机视觉与多媒体会议上发表多篇论文,获 2021 年度博士研究生国家奖学金。

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

投稿通道:

• 投稿邮箱:[email protected]

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

·