人工智能-第三阶段-k近邻算法1-算法理论、kd树、鸢尾花数据

机器学习(数据科学库):matplotlib 、numpy、pandas、seaborn

获取数据集—数据基本处理—特征工程—机器学习—模型评估

1.1 k-近邻简介KNN

根据你的邻居来推断出你的类别

多个邻居中,最多的种类作为自己的种类。

距离公式:欧式距离

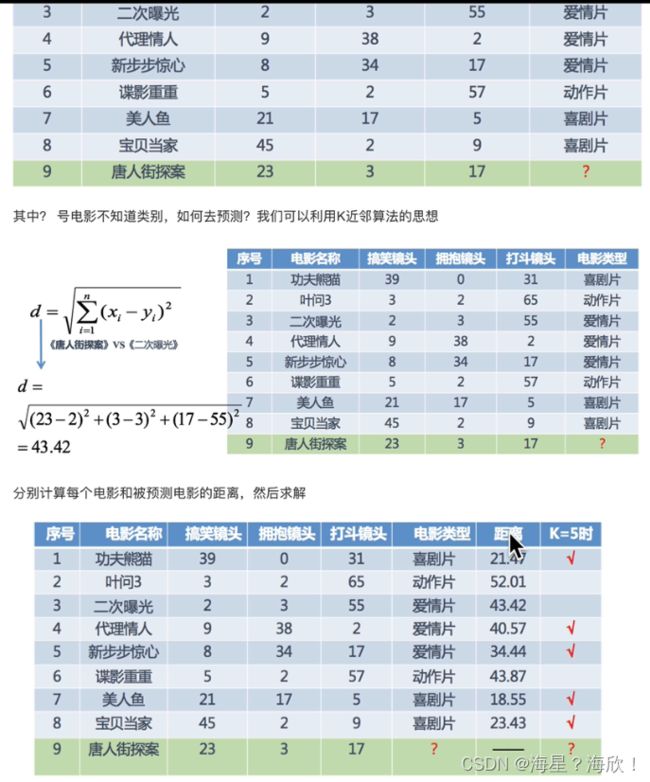

案例:判断电影类型

计算好距离,

如果只选定一个,则美人鱼18.55距离最近,所以判断属于喜剧片

如果选定5个,则最近的五个中,3个喜剧片,2两个爱情片,也判断为喜剧片

步骤

1,计算已知类别数据集中点与当前点距离

2,递增排序

3,选取最近的k个

4,计算前k个中,类别的各个频率

5,频率最高的类别作为当前点的预测

1.2 k-近邻初步使用

from sklearn.neighbors import KNeighborsClassifier

#1,构造数据

x = [[1],[2],[10],[20]]

y = [0,0,1,1]

#2,训练模型

#2.1 实例化一个估计器对象

estimator = KNeighborsClassifier(n_neighbors =1)

#n_neighbors邻居选定一个如果不设定默认取5

#2.2 调用fit方法,进行训练

estimator.fit(x,y)

#3,数据预测

ret = estimator.predict([[0]])

print(ret) #输出:[0]预测属于类别0

1.3 距离度量

距离公式的基本性质:非负性、统一性、对称性、直递性

1,欧式距离

2,曼哈顿距离

(x1,y1)与(x2,y2)的距离:d = |x1-x2|+|y1-y2|

(x1,y1,z1)与(x2,y2,z2)的距离:d = |x1-x2|+|y1-y2|+|z1-z2| 以此类推

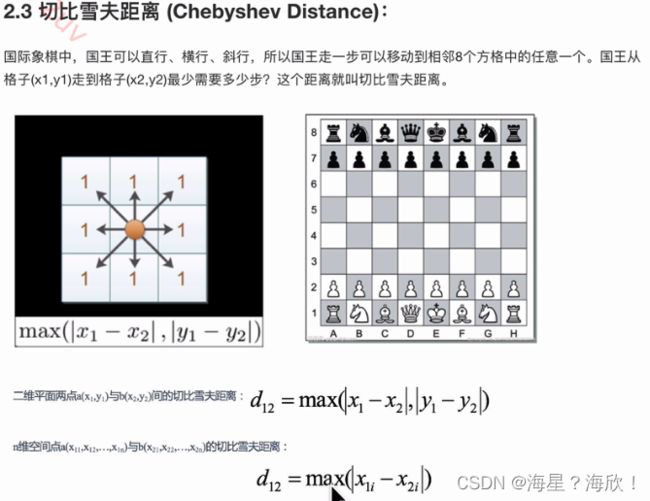

3,切比雪夫距离

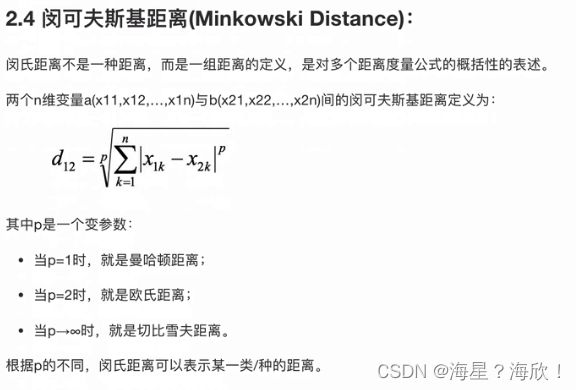

4,闵可夫斯基距离

1.4 K值的选择

k值过小:容易受到异常点的影响;容易出现过拟合

K值过大:受到样本均衡的问题(类别a和类别b的频数都一样多)

实际应用中,K值一般选择的较小3,5,7等,可以通过交叉验证选择出来

近似误差 :—对训练集的误差,有时候近似误差过小会出现过拟合

估计误差:对测试集的误差,更加重要

1.5 Kd树

如何快速进行距离搜索,穷举搜索很耗时,从而引入kd树

kd树基本原理:如果A和B距离远,B与C距离近,那么A与C的距离也很远

穷尽搜索的算法复杂度: D倍N的N次方

Kd 树优化后的算法复杂度:DNlogN

中位数不断分割

Kd树是一种二叉树

构造方法:

1,构造根节点

2,递归方法,不断对K维空间进行切分,生成子节点,直到子区域没有节点为止

问题:

- 划分应该先从哪一个维度进行划分?

对于简单的数据可以随机选择某一维度或者按照顺序进行选择,但更好的方法是在数据比较分散的那一维度上进行划分(看方差) - 如何划分数据?

好的划分方法可以使构建的树比较平衡,可以每次选择中位数来进行划分

小案例

先确定位置,找到最近的点,再回溯经过的点,比较单的x值/y值的距离

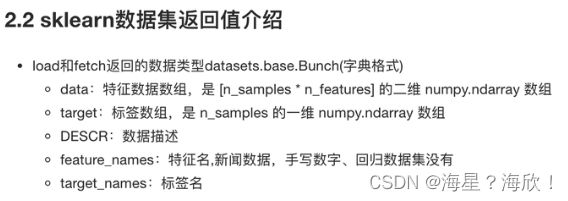

1.6 案例1:鸢尾花种类预测-数据处理

鸢尾花数据集合:

特征值:花瓣、花萼的长度、宽度;

目标值:三种鸢尾花

数据来源于sklearn.datasets

from sklearndatasets import load_iris

iris = load_iris() #获取小数据集

print(iris) #打印出全部数据信息

#news = fetch_20newsgroups()

#print(news) #获取大数据集

from sklearndatasets import load_iris

iris = load_iris() #获取小数据集

#2.数据集属性描述

print('数据集特征值是:\n',iris.data) #特征列的取值

print('数据集目标值是:\n',iris['target']) #目标列的取值

print('数据集特征值名字是:\n',iris.feature_names) #特征列名称

print('数据集目标值名字是:\n',iris.target_name) #目标列名称

print('数据集的描述:\n',iris.data) #各列数据的均值,最小值这些

1.6.3 查看数据分布

seaborn介绍:基于matplotlib核心库进行了更高级的API封装

import seaborn as sns

import matplotlib.pyplot as plt

import pandas as pd

from sklearn.datasets import load_iris

#3,可视化

iris_d = pd.DataFrame(data=iris.data,columns= ['Sepal_Length','Sepal_width','Petal_Length','Petal_Width'])

iris_d['target'] = iris.target

#print(iris_d)

def iris_plot(data,col1,col2):

sns.lmplot(x=col1,y=col2,data=data)

plt.show()

iris_plot(iris_d,'Sepal_Width','Petal_Length')

#出现不同类别对应不同颜色的散点图

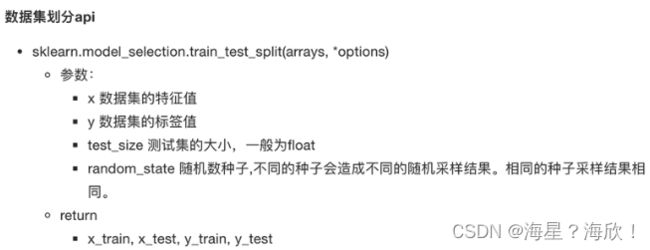

1.6.4 数据集的划分

from sklearn.model_selection import train_test_split

#4,数据集的划分

x_train,x_test,y_train,y_test = train_test_split(iris.data,iris.target,test_size=0.2,random_state=22) #特征值x,目标值y,划分占比,随机种子

print('训练集的特征值是:\n',x_train)

print('测试集的特征值是:\n',x_test)

print('训练集的目标值是:\n',y_train)

print('测试集的目标值是:\n',y_test)