医学图像分割的深度学习:综述

Title:Deep Learning for Medical Image Segmentation:Tricks, Challenges and Future Directions

摘要

最近的医学图像分割领域其主要贡献往往侧重于网络架构,训练策略和损失函数方面的提升,而无意中忽略了一些边缘细节(也被称作技巧)。

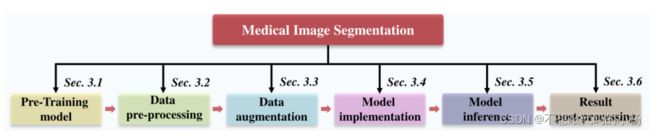

在这篇文章中,我们收集了不同模型实现阶段(即预训练模型、数据预处理、数据增强、模型实现、模型推理和结果后处理)的一系列医学图像分割的技巧。

Introduction

将医学图像分割模型分为六个实现阶段即预训练模型,数据预处理,数据增强,模型实现,模型推理和结果后处理

本文的主要贡献在于:1)我们收集了不同实施阶段的一系列MedISeg技巧,并通过实验探索了这些技巧在一致CNN基线模型上的有效性。

2)明确阐明了这些技巧的有效性,并且在2D和3D医学图像数据集上的大量可靠实验结果弥补了MedISeg中的实施忽视。

本文选择了2DUNet和3DUNet作为基础模型。

方法

3.1预训练模型

预训练模型(即,使用预训练的权重作为模型微调的初始参数)提供了有利的参数,从而可以容易的加速模型训练收敛,并且潜在模型可以获得强大的泛化能力。在医学图像分割任务中常用的预训练权重。预训练权重可以分为两个大类:完全监督的权重和自监督权重。

pytorch官方权重:这个训练权重是由torchvision提供的骨干预训练权重,这些预先训练的权重是通过在ImageNet 1k数据集[111]上训练用于单标签图像分类任务的相应骨干网络而获得的。

Model-oriented ImageNet 1k weights:通过训练ResNet-50[18]在ImageNet 1k数据集上进行图像分类来获得面向模型的ImageNet1k权重。

Model-oriented ImageNet 21k weights:与ImageNet 1k[111]相比,ImageNet21k是一个更通用和全面的数据集版本,它总共有大约21000个对象类[125],用于(弱监督或半监督或完全监督)图像分类。因此,ImageNet 21k上的训练权重更有利于提高下游计算机视觉模型的识别性能。

SimCLR weights:在特征表示和对比学习损失之间引入可学习的非线性变换可以大大的提高模型表示质量。SimCLR主要包括三个实现步骤:1)首先将输入图像分组为若干图像块;2) 然后对不同批次的图像块实施不同的数据增强策略;3) 最后对模型进行训练,以获得具有不同增强的相同图像块的相似结果,并相互排除其他结果。

MOCO Weights:MoCo是经典的自我监督对比学习方法之一。它旨在解决存储体中采样特征不一致的问题.

Model genesis (ModelGe) weights:ModelGe是一种先进的自监督模型预训练技术,通常包括四种变换操作(即非线性、局部像素混洗、外绘和补绘),用于计算机断层扫描和磁共振成像图像上的单个图像恢复

3.2数据预处理

由于深度CNN的3D医学图像的数据特异性,数据预处理对于获得令人满意的识别性能是很有必要的。在本小节中主要讨论3DUNet中常用四种图像预处理技术的有效性。这四种策略分别为:patching , oversampling(OverSam) , resampling (ReSam) , and intensity normalization (IntesNorm)

Patching:一些特定类型的医学图像(例如磁共振图像和病理图像)其往往在空间尺寸上非常大,并且在定量方面缺乏足够的样本。因此无法使用这些图像直接训练医学图像分割样本。通常的做法是将这个图像重新采样为较小空间尺度的不同图像块,从而可以用更少的GPU内存成本来实现这个模型,并且可以更好的训练这个模型。具体来说Patch的大小是影响模型性能最重要的因素之一。

OverSam:为了解决正负样本之间的类不平衡问题,过采样策略得以提出。OverSam策略主要用于少数样本类。目前存在的过采样策略包括:随机过采样。合成少数过采样,边界平滑以及自适应合成采样。

ReSam:重采样策略通过机器学习模型提高所用数据集的表示能力。由于可用的样本能力有时是有限和异构的,因此可以通过随机OR非随机重采样策略获得更好的子样本数据。在其实现过程中,重采样主要包括4个步骤:1)间距插值 2)窗口变换 3)获取有效的掩码范围 4)子图像的生成。

IntesNorm:IntersNorm是一种特定的标准化策略,主要用于医学图像。通常是有两种方法:1)所有模态的Z-Score和计算机断层扫描图像。

实验结果表明:PatchSize越大模型的性能越好。

3.3数据增强

数据增强通常用于处理量化方面训练样本不足的问题,用于缓解过拟合问题,提供强大的模型泛化能力。用于医学图像的分割的数据增强主要分为以下几类即基于几何变换的数据增强(GTAug)和基于生成对抗网络的数据增强。

基于几何变换的数据增强(GTAug):GTAug被提出用于消除训练图像中某些几何对象变化的影响,例如位置、比例和视角。普遍使用的GTAug包括翻转、裁剪、旋转、平移、颜色抖动、对比度、低分辨率模拟、高斯噪声注入、混合图像、随机擦除、高斯模糊、混合和剪切。

基于生成对抗网络的数据增强:数据增强的内在前提是将领域知识或其他增量信息引入训练数据集。从这一方面来看,GANAG可以被视为一个损失函数,它专注于引导网络生成一些接近源数据集域的真实数据。

3.4模型实现

医学图像分割由许多实现细节组成,在实现中每个不相关的变换都会对性能产生潜在的影响。因此模型实现细节对于医学图像分割模型很重要。在本文中介绍三种常用的实现技巧。并讨论了其分割效果。三类为:深监督,类别平衡损失,困难样本挖掘,和实例归一化。

DeepS深监督:深监督是一种辅助学习技巧。它通过直接或者间接的方式在一些中间隐藏层添加辅助分类器或者分割器来实现,从而对骨干网络进行监督,它可以用来解决梯度消失或者收敛速度慢的问题,而对于图像分割,这个技巧通常通过添加图像级分类损失来实现的。

CBL类平衡损失:CBL通常用于学习一般类权重,即每个类的权重仅与对象类别相关。与类不平衡数据集上的一些传统分割损失函数(例如,交叉熵损失)相比。CBL可以提高模型的表示能力。在使用的数据集中,CBL引入有效样本数来表示所选数据集的预期体积表示,并根据有效样本数而非原始样本数对不同类别进行加权。

OHEM:OHEM的核心思想是首先通过损失函数过滤掉一些困难学习样本(即图像、对象和像素)。这些选定的困难样本都对识别任务有很大影响[178]。然后,将这些样本应用于模型训练过程中的梯度下降。

实例归一化IntNorm:IntNorm是一种流行的标准化算法,适用于对单个像素有更高要求的识别任务。在其实现中,在计算统计归一化时,考虑了每个单个样本和样本的单个通道的所有元素。在医学图像领域,使用IntNorm的一个重要原因是,在训练过程中,批次大小通常被设置为一个较小的值(尤其是对于3D图像),这使得批次规格化的使用无效

3.5模型推理

在本文中主要探讨两种常用的推理技巧即测试时间增强(TTA)和模型集成。

TTA:TTA目前是模型推理阶段的一种流行的数据增强机制,用于提高模型精度。TTA可以用于提高识别性能,而无需训练,因此具有即插即用的潜力。同时,它可以提高模型校准的能力,这有利于视觉任务。

模型集成:模型集成策略旨在联合多个训练模型,并基于特定集成机制在测试集上实现多模型融合结果,从而最终结果可以从每个训练模型中学习,并提高总体泛化能。常用的模型集成方法有投票,平均,叠加和非交叉叠加

3.6结果后处理

后处理操作的目的是通过不可学习的方法来提高模型性能,例如可以通过聚集全局信息来细化分割结果。包括两种结果后处理方式为最大分量抑制(ABL-CS)和小面积去除(RSA)

ABL-CS:ABL-CS旨在基于生物体物理特性的知识去除分割结果中的一些错误区域[199]。例如,对于心脏分割任务,我们都知道每个人只有一个心脏,因此如果在获得的掩模中存在小的分割区域,我们需要移除这些小区域

RSA:在医学图像分割领域中成像协议通常不变,因此每个实例分割掩模的面积也保持不变。基于此物理特性,我们可以设置像素级阈值,以移除所获得的分割掩模中太小(即,低于给定阈值)的一些实例掩模。