Swin Transformer、ViT作者等共话:好的基础模型是CV 研究者的朴素追求

2021-2022 年,随着 Transformer 被引入计算机视觉领域,视觉基础模型研发迎来了又一个新的高潮。一时间,基于视觉 Transformer 的骨干模型设计、自监督学习、模型扩展、下游应用等研究井喷式爆发。在 2022 年 6 月 1 日的智源大会「视觉模型」专题论坛中,Swin Transformer 作者曹越、ViT 作者翟晓华、HRNet 作者王井东、华为王云鹤以及中国科学院大学叶齐祥等共聚一堂,针对视觉模型的发展展开了精彩的演讲和激烈的讨论。

整理:熊宇轩、张虎

论坛专家名单:

曹越 | 微软亚洲研究院视觉计算组主管研究员

王云鹤 | 华为算法应用部部长

翟晓华 | 瑞士苏黎世谷歌大脑团队主管研究员

叶齐祥 | 中国科学院大学长聘教授,鹏城国家实验室研究员

王井东 | 百度计算机视觉首席科学家

自监督预训练之图像掩码预测:方法、机理与数据可扩展性

曹越 | 微软亚洲研究院视觉计算组主管研究员

【研究背景及意义】

Yann LeCun的“蛋糕理论”中将强化学习比作蛋糕上的樱桃,监督学习比作糖霜,而自监督学习比作是蛋糕坯子,强调了自监督学习的基石作用。自监督学习无需人为的数据标注,从而可以利用近乎无限的数据进行学习。

2018年,BERT 的出现将自然语言处理领域的自监督预训练推向了顶峰。但如何有效地使用自监督学习进行视觉预训练仍有待探索。在报告中曹越主要介绍了其研究组在近一年时间中在视觉自监督预训练方向的探索,主要回答了如下三个问题:

(1)是否存在一种简单有效的掩码图像建模(Masked Image Modeling,MIM)框架?

(2)如何理解 MIM 框架在自监督学习预训练中的工作机理?

(3)MIM能否获益于大规模数据集?

【研究方法】

1. 在方法层面:其团队提出了一种简单的MIM框架,发现在MIM预训练中使用:简单的随机掩码匹配较大的掩码块大小、一层线性预测头、直接对像素进行回归作为预测目标即可在广泛的主干网络(ViT, Swin, ResNet)和下游任务(ImageNet分类,COCO目标检测,ADE20K语义分割)中取得当时最好的性能。

2. 在工作机理层面:其团队分别从可视化和实验对比的角度来理解 MIM 的工作原理。从可视化中,发现MIM方法给模型带来了一些局部性归纳偏置,随着层数的加深,有监督模型的所有注意力头都关注到全局区域,而MIM模型一直都有部分头关注局部而其他关注全局,也给注意力头带来了多样性。从实验中,发现MIM对于弱语义的下游任务,比如姿态估计、深度估计、目标跟踪等任务表现出色,无需特殊设计,使用标准的SwinV2和MIM预训练即可在这三类任务的重要数据集中取得当前最好的性能。

3. 在数据可扩展性层面:其团队使用了5种不同大小的 Swin Transformer和5种不同大小的图像数据集来探索MIM预训练在不同训练轮数下的数据可扩展性。实验结果表明:随着模型大小和训练轮数的增加,MIM训练所需要的数据量也随之增加,当数据量充足时,性能可以稳步提升;在数据量不足时依然会出现过拟合的情况,使用更大的模型和更长的轮数时性能几乎持平或变差。由此,验证损失可以作为MIM模型预训练好坏的关键指标,和三种下游任务的性能也呈正相关关系。

【总结及展望】

曹越研究员从三个角度介绍了其研究组在自监督预训练领域的一些进展。首先从方法层面提出了一种简化的MIM框架,然后利用注意力可视化图和广泛任务上的实验对比来理解MIM的内在工作机理,最后展示了数据可扩展性的研究。由于掩码预测方法的通用性,他也希望在这个方面的探索可以帮助CV和NLP搭建一个更好的桥梁。

底层视觉大模型以及大模型的压缩

王云鹤 | 华为算法应用部部长

【研究背景及意义】

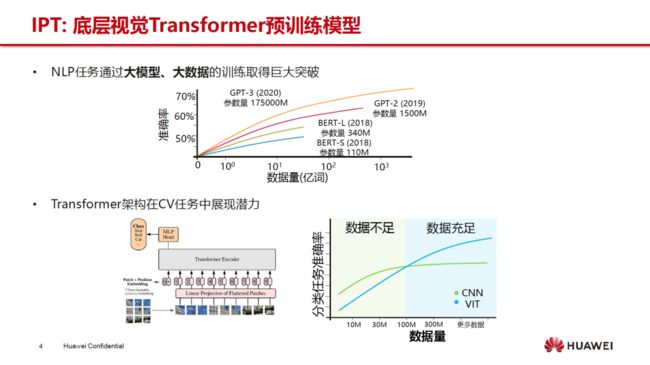

视觉Transformer的研究和演进对整个深度学习领域意义重大,基于大规模的数据集和大规模的模型可学习参数已经突破了现有深度模型精度的瓶颈。如果基于Transformer的模型在参数大小和精度上能达到很好的平衡,对于工业界来说则意义深远,既可以统一模型架构,也可以简化硬件上的算子设计。设计统一的大模型,解决更直接的底层视觉任务,并将其部署于终端设备上有重大的使用价值。

【研究方法】

王云鹤研究员团队结合机器翻译的思想,提出了首个将底层视觉的各个任务统一起来的Transformer预训练大模型(IPT)。并且为了有效地将大规模的深度神经网络算法应用在端侧设备上,降低了使用人工智能解决实际问题的成本。王云鹤团队探索设计了一些针对视觉大模型进行压缩的新策略。

在设计底层视觉大模型的过程中,王云鹤博士主要总结了以下三点:

1. 在数据处理过程中,由于Transformer通常需要大规模数据进行训练,因此王云鹤团队在设计底层视觉Transformer模型时,主要将ImageNet上海量的无标注数据作为干净的高质量图像。然后采取人工添加雨痕、噪音等方面来构建一个大规模数据集。Transformer在数据量充足时,通常会取得显著的性能提升。

2. IPT 主要采取无监督训练,采用对比学习损失函数,再进行有监督训练,利用超参数来进行调节最终的损失。

3. 底层视觉 Transformer 的改进方向包括:设计更高效的网络结构,高效的预训练机制,针对具体底层视觉任务做定制化处理等等。

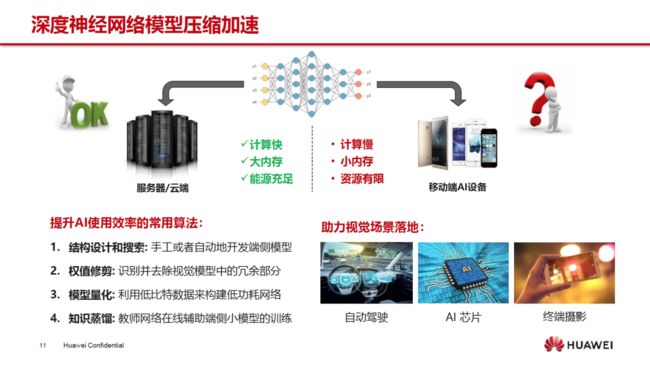

在大模型的压缩方面,王云鹤研究员主要总结了以下4点方法:

1. 对现有AI结构进行修改和优化:比如自动化搜索或者手工设计轻量化的端侧模型;

2. 权值修剪:主要用来识别并去除视觉模型中的冗余部分,达到降低内存、节约计算量的目的,比如剪枝操作;

3. 模型量化:将模型参数和特征利用低比特数据来构建低功耗网络;

4. 知识蒸馏:利用预训练好的教师网络在线辅助端侧小模型的训练,从而使得小模型达到更好的效果。

【总结及展望】

王云鹤博士团队提出了底层视觉大模型IPT,它主要采用大量的数据去做预训练,然后构建了一个共享的视觉Transformer主干,最后只需根据具体底层视觉任务的不同进行微调即可。而在底层视觉模型大压缩方面,王云鹤团队主要提出了三个工作,具体总结如下:

1. PS-ViT:对视觉Transformer中的Patch数进行修剪,降低patch间存在的冗余信息;

2. PTQ:视觉Transformer后训练量化,量化后无需重训练所有数据,仅需一小部分训练数据;

3. 基于流形学习的视觉Transformer细粒度知识蒸馏,充分利用了Transformer所特有的细粒度patch结构;

大规模通用视觉表征学习

翟晓华 | 瑞士苏黎世谷歌大脑团队主管研究员

【研究背景及意义】

大规模通用视觉表征学习的目的是,在给定一个大规模预训练数据集的情况下,能够学习出一个模型,使用任意迁移学习的算法,将其适配到不同的下游任务中。翟博士指出,在只有少量学习样本的条件下使用预训练和知识迁移来达到类似于人类的分类识别效果是十分重要的课题。因此,研究人员需要解决如下问题:

(1)通过大模型预训练来提高模型性能

(2)通过零训练样本的知识迁移来支持大模型在新任务上的应用。

【研究方法】

针对第一个问题,翟博士团队在论文「Scaling Vision Transforme」中系统地研究了大模型预训练的方法。通过变化数据集大小、模型大小和计算资源,生成大量实验组合,来进行预训练并测试下游任务性能。实验最多使用了30亿张图像,以及包含20亿参数的大模型。通过大量实验结果,翟博士总结出了以下 5 条经验规律:

1. 当数据集规模不足时,使用大量计算资源长时间训练将会导致过拟合。只有同时扩大数据、模型和计算资源时,视觉表征的性能才会得到提升;

2. 视觉通用表征能力通常会被模型的大小所制约,小模型无法充分发挥大数据的作用;

3. 大模型可以从额外数据中获得更多的性能增益。即使数据量从十亿增加到三十亿,也能取得明显的性能提升;

4. 大模型通常具有更高的样本有效性。大模型使用更少的训练样本数量,便可达到小模型的错误率;

5. 缩放定律(Scaling laws)仍然适用于包含1400万张图像的ImageNet-21K 数据集。

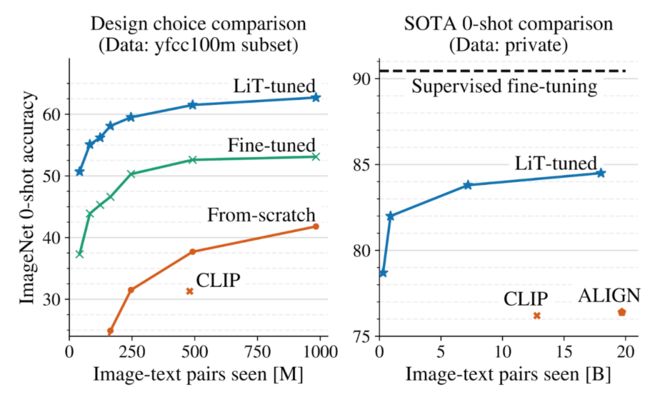

针对第二个问题,翟博士在论文「LiT: Zero-Shot Transfer with Locked-image Text Tuning」中指出:研究人员通常针对具体任务对预训练好的大模型进行微调(Fine tune),性能优势显著,而代价是每一个新任务都需要采集训练数据并微调模型。另一种文本图像对比学习方法通过将文本和图像映射到一个可直接计算距离的表征空间中,利用对比学习让属于同一对的文本与图像之间的距离尽可能接近,让属于不同对的文本与图像间的距离尽可能远离。在下游任务中,给定一张新图像和对应的新类别名称,该方法可以直接计算图像和类别文本之间的距离,将距离最近的类别作为分类结果输出,从而支持零样本的分类或检索新任务。然而这一类方法由于文本图像训练数据噪声较大,与微调相比性能差距较大。

LiT模型充分结合了这两种思路的优点,大幅度提高了零样本分类的效果,主要思想如下:

1. 利用预训练的视觉模型来生成图像的表征,例如前述的ViT-g/14模型。在训练过程中,视觉模型的权重不更新;

2. 仅仅训练一个与之配对的文本模型,在训练过程中,使用文本图像对比学习损失来更新文本模型的权重;

3. 随着训练时间和迭代次数的增加,文本的表征在语义空间里面越来越接近预训练的视觉模型的表征。从而通过训练一个文本模型,来“读”出视觉模型的表征。

【总结及展望】

针对当前大规模通用视觉存在的两个问题,翟博士介绍了团队在这个方面的两个最新工作。翟博士总结了大模型预训练的经验规律,并指出数据集大小、模型大小可能会成为性能瓶颈,大模型的样本有效性更高。而LiT模型通过训练一个文本模型来“读”出视觉大模型的表征,支持零样本的任意新任务而不需要更新视觉模型(adaptation),这提供了一种不同于代价较高的微调方法的新思路。

Conformer: 耦合局部和全局线索的视觉表征模型

叶齐祥 | 中国科学院大学长聘教授,鹏城国家实验室研究员

【研究背景及意义】

传统的卷积运算非常善于提取局部特征,但是难以捕获远距离依赖。近年来,人们基于注意力机制提出了一系列视觉 Transformer 的工作。视觉 Transformer 模型会建立每两个图块(Patch)之间的相关矩阵,提供远距离依赖的线索,但是会忽略局部的细节特征。

卷积神经网络和视觉 Transformer 分别代表了「从局部到整体」和「从整体到局部」这两种提取视觉特征、形成语义表达的思路。脑科学研究者发现,人脑中存在 PFC 投影通道,可以首先通过「瞥视」(Glance)快速捕获粗略的大范围信息,再完成从底层到高层局部信息的抽象。基于上述观察合法县,叶齐祥教授团队研发了结合局部和全局线索的视觉主干模型 Conformer 及其串行运算变体 HiViT,在图像分类、目标检测等任务上取得了全球领先的性能。

【研究方法】

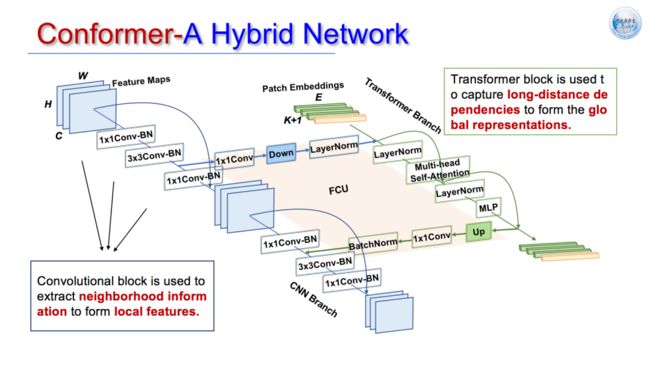

Conformer 模型通过并行的卷积模块和 Transformer 模块分别实现了对局部特征和全局表征的提取,并通过特征耦合单元实现了卷积分支和 Transformer 分支的特征融合和对齐。该模型主要由 3 个部分组成:

(1)卷积模块。由卷积层、BatchNorm 层、池化层、残差连接等结构组成,用于提取邻近区域内的信息,形成局部特征。

(2)Transformer 模块。由多头自注意力层、LayerNorm 层、多层感知机、残差连接等结构组成,用于捕获远距离依赖,形成全局表征。

(3)特征耦合单元(FCU)。卷积分支和 Transformer 分支的特征分辨率存在差异,FCU 将卷积分支的特征图通过 1*1 卷积层、下采样层、LayerNorm 层的处理将其与 Transformer 的 Token 向量融合;将Transformer 分支的特征通过上采样层、1*1 卷积层、BatchNorm 层的处理将其与卷积特征图融合。作者团队尝试使用了元素相加、Concat、自注意力等特征融合方法。

相较于卷积神经网络,Conformer 不再使用类高斯感受野,提供了不规则的感受野,激活图能够更完整覆盖目标物体;相较于视觉 Transformer,Conformer 引入了局部特征,增强了边缘的特征,提升了模型的判别能力。通过各种残差连接的设置方法,并行的 Conformer 模型隐式地包含了各种串行计算模式。

研究人员需要精心调整并行的卷积神经网络和视觉 Transformer 的配比,该模型的训练难度较大。谷歌大脑团队提出的 CoAtNet 等串行模型可以通过加深网络深度提升表征性能。受此启发,叶齐祥教授团队奖 CoAtNet 中的卷积模块替换为多层感知机模块,让网络自由学习全局特征和局部特征的比例,实现了自适应的感受野约束。HiViT 在模型准确率和泛化性方面均处于国际领先地位。

叶齐祥教授团队基于鹏城实验室的「鹏城云南」平台对 Conformer 模型进行了放大,实现了对网络宽度深度、宽度的扩展,得到了 Conformer-L 模型。在此基础上,叶齐祥教授团队开展了一系列探索实验,例如:基于 Confident Learning 方法缓解了数据噪声的影响,参考 Beit 的方法对 Conformer 进行蒸馏训练,基于 Conformer 特征和掩码图像建模的离散 Token 生成。

Conformer-L 模型在目标检测、基于元学习的图像分类、多模态融合的点云语义分割等任务上取得了国际领先的性能,证明了该模型的泛化性、通用性。

【总结及展望】

叶齐祥教授团队结合卷积神经网络和视觉 Transformer 的优点,设计了包含卷积分支、Transformer 分支、特征耦合单元的 Conformer 架构,能够同时提取局部特征和全局表征。在此基础上,受到 CoAtNet 等网络的启发,叶教授团队提出了具有自适应感受野的串行架构 HiViT。基于鹏城云脑算力,叶教授团队将 Conformer 模型扩展为 Conformer-L,在图像分类、目标检测、点云语义分割等任务上取得了国际领先的性能。

基于 Context Autoencoder 的自监督表征预训练

王井东 | 百度计算机视觉首席科学家

【研究背景及意义】

对于图像分类、目标检测、语义分割、人脸对齐、姿态估计等计算机视觉任务来说,表征预训练的质量至关重要。在上述任务中,网络首先通过表征预训练学习到的编码器将图像映射为中间表征,再通过具体的解码器头完成下游任务。近年来,计算机视觉领域的预训练经历了从有监督预训练到自监督预预训练的演变。

表征预训练规模化目标包括:

(1)样本规模化

(2)语义概念规模化。现有的监督式预训练分为四类:(1)监督式预训练,需要标注,无法满足以上两个目标(2)半监督预训练,难以实现语义概念扩展。(3)视觉-语言预训练,图像数量多,语义信息广。(4)自监督预训练,可以同时实现以上两个目标。

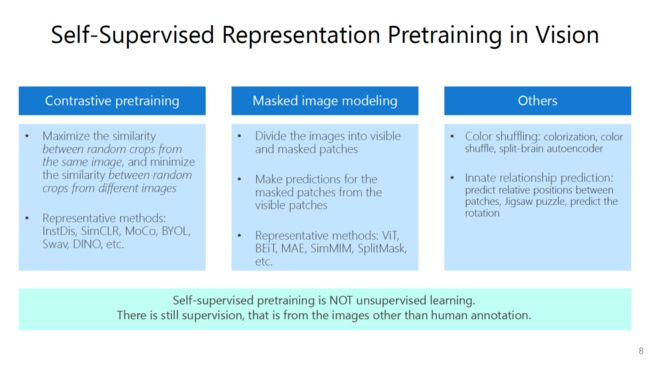

目前的自监督表征预训练主要包括:

1. 对比学习预训练

2. 掩码图像建模(MIM)

3. 其它预训练方法

王井东指出,自监督预训练不等价于无监督预训练,它仍然需要图像自身的监督信号。

然而,以前方法BEiT 等自监督预训练方法令视觉 Transformer 主干网络同时承担了一部分编码器和解码器的工作,影响了编码的性能和表征的质量。MAE 等基于 MIM 的自监督预训练方法的解码器部分与 BeiT 类似,编码器部分仅仅处理可见图块的信息。因此 MAE 的解码器较浅,否则可能将大部分表征过程置于解码器中。

基于对比学习的自监督预训练方法之所以奏效,是因为采样得到的裁剪出的图像大多集中于原始图像的中间部分,而 ImageNet 1K 数据集中的物体大多数也集中于图像中央,从而对比学习学到的语义信息基本是图像中间的,也就是1000类信息。而 MIM 方法则可以关注图像各个区域的信息,不止1000类信息。

【研究方法】

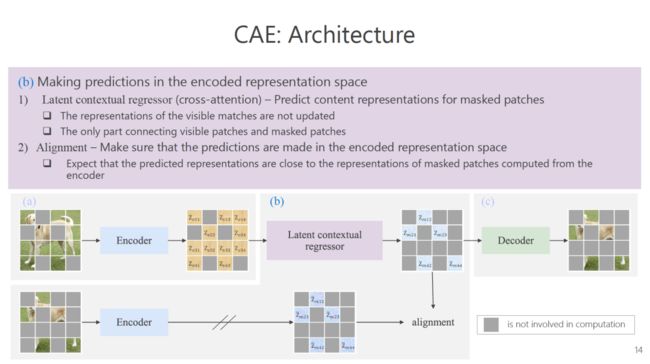

王井东等人提出用于视觉自监督预训练的上下文自编码器(CAE),旨在学习一个编码器,将图像映射为可以被迁移到下游任务上的表征。CAE 具有以下特征:

1. 在编码的表征空间中,利用可见图块的特征预测被遮盖图像的特征

2. 仅仅在编码器中学习表征

3. 预测头与编码器分离

CAE 由以下三个部分组成:

1. 编码器。输入可见图块,得到其表征。

2. 隐含上下文回归器。输入可见图块表征,通过隐含上下文回归模块预测被掩码的图块的表征。将被掩码的图块通过编码器得到的表征与通过上下文回归模块预测的表征对齐,确保仅仅在潜在表征空间中进行预测。

3. 解码器。将预测出的图块表征映射回图像。

为了评估 CAE 等基于 MIM 的自监督预训练模型的性能。王井东等人提出了 Attentive Probing 方法,引入了新的 [CLS] Token,自适应地关注图像中 1,000 类物体(ImageNet 1K)的信息。该评测方法可以显示出 MIM 类自监督预训练方法相较于对比学习预训练方法的优势,可以更好地学习图像中央之外的信息。消融实验结果表明,在隐空间里预测 MIM 对于分割、检测等下游任务十分重要 ,也是性能超越MAE和BEiT的原因。

【总结及展望】

王井东博士提出了基于上下文自编码器(CAE)的自监督表征预训练方法。CAE 在编码的表征空间中进行预测,将编码过程和解码头分离。MIM 与对比学习自监督预训练的差别在于,MIM 学习所有区域信息,对比学习预训练重点关注图像中央区域的信息。为了更好地评测视觉预训练模型,王井东博士等人提出了新的 Attentive Probing 方法。在 ImageNet 上进行调优是不恰当的。

王井东博士也简要介绍了百度视觉基础模型文心·CV大模型以及行业大模型。

圆桌讨论

Q1:视觉大模型为什么如此重要,它能解决哪些计算机视觉领域中存在的难题?

曹越:近年来,NLP 领域陆续出现了一些基础性的预训练大模型,例如:GPT 系列模型可以在不需要调优的情况下解决大多数下游任务。人类也可以通过同一个模型解决各种丰富的任务,我们期待 CV 领域也出现类似于 GPT 的模型,可以解决大量的下游任务,助力早日实现通用人工智能。

王云鹤:骨干模型的性能对于下游任务十分重要,该技术的突破会引发一系列的连锁反应。对于基础视觉模型的研究是许多 CV 从业者的追求。

叶齐祥:设计好的基础模型一直是 CV 领域研究者的朴素追求,无论在手工设计模型的时代还是深度学习时代都是如此。

王井东:实际上,CV 研究者对「基础模型」的定义还没有形成明确的共识。从 RCNN 的时代开始,CV 领域就成功地应用了预训练方法,取得了一系列进展。进一步取得突破的难度相较于 NLP 领域或许更大。此外,CV 领域里以前的预训练学习往往需要标签,而自然语言是人类创造的,本身就蕴含很强的规则。人们对基础模型的研究更多还是集中在表征学习层面,自监督学习的范畴更大,包括预测。

山世光:计算机视觉领域或许也需要一个「世界模型」,让模型不仅仅能够学习局部的概念,对世界中存在的知识有更全面的理解,从而形成更大更好的概念。

Q2:相较于上千亿参数的语言预训练大模型和多模态预训练大模型,视觉的基础模型的规模要小两三个数量级。这种现象背后的原因是什么?是否必须弥补这种差距?怎么弥补?

曹越:CV 领域现有的学习方法难以支撑更大的模型。计算机视觉领域一直都在使用有监督的预训练,这对数据量的要求非常大。目前,有监督数据量的限制制约了模型规模的扩展。而自监督预训练可能可以缓解数据焦虑,其中MIM已经被证明可以从模型层面实现扩展,从而可以训练比有监督学习方法更大的模型,但是其上限还有待探究。

王井东:百度近期发布了多任务有监督预训练模型 UFO,它可以被用于分类、分割、检测等任务,包含 170 亿参数、100 亿参数、数十亿参数等多个版本。模型性能确实随规模的提升而改善。但数据仍然有限。一味追求大的模型规模不见得是我们现在主要的目标,我们应该更加关注如何将知识融入模型,思考需要怎样的知识。此外,从优化的角度如何设计能够处理大量数据的学习方法也十分重要。

王云鹤:CV 领域的大模型训练也是一个棘手的工程问题。随着供训练的图像的尺寸越来越大,即使是较小的模型也可能具有很大的计算量。CV 模型的规模提升可能也有赖于硬件的革新。

叶齐祥:图像的语义密度是很关键的问题,一张 1024*1024 的图像可能只拍摄了一个动物,从自然语言领域迁移而来的 ViT 还有很大的改进空间。ViT 比自然语言领域的 Transformer 模型的搜索空间要大很多,它打破了图块之间的原始位置关系,又通过位置编码重建位置,面临着巨大的学习困难。此外,数据量往往也不足以支撑具有超大规模参数的模型。相较之下,CNN 对空间拓扑关系的约束能够相对缓解这一问题。

Q3:Transformer 是否会成为视觉基础模型的不二选择,未来还可能出现怎样的变化?

叶齐祥:自然语言中的拓扑关系是天然存在的。ViT 将图块之间的拓扑关系打散了,要设计新的机制快速重建图块的位置关系,仅仅依靠注意力机制来做到这一点还十分困难。

王云鹤:华为最近在尝试使用图神经网络等经典的网络建模图块之间的关系,与 Transformer 相融合,取得了不错的效果。目前看来,Transformer 并不一定会成为必要的骨干网络。最近许多研究者们「回退」到了卷积网络上。我们最近有一篇名为 CMT 的论文使用轻量卷机模型实现了优于 ViT 的效果。

王井东:从骨干网络的角度来看, Transformer 可能与 CNN 相比没有明显区别。而从解决问题的角度来看,越来越多的视觉任务都有望引入 Transformer。视觉任务涉及两个基本问题:特征、匹配。Attention 同时完成了这两个任务,具有更强的可解释性。

曹越:从模型扩展和多模态融合的角度来说,Transformer 是必不可少的。即使 CNN 可能也具有扩展的潜力,但目前已经证明 Transformer 在 NLP 领域被可以被用于设计大规模预训练模型。Transformer 具有动态特征,能更好适应不同模态的输入,处理差异较大的数据。

推荐阅读

Richard Sutton:经验是AI的终极数据,四个阶段通向真正AI的发展之路

机器学习泰斗Michael I. Jordan与张宏江共话青年成长之路:研究者要对复杂时代有所贡献

梅宏院士:如何构造人工群体智能?| 智源大会特邀报告回顾

图灵奖得主Adi Shamir最新理论,揭秘对抗性样本奥秘 | 智源大会特邀报告回顾