机器学习 西瓜书 第二章 模型评估与选择

机器学习

第二章 模型评估与选择

2-1 经验误差与过拟合

一些评估模型的标准概念 (3对概念)

精度:1—错误率

错误率:m个样本 a个分类错误的 a/m就是错误率

经验误差(训练误差) PS: 做过的题再做一遍

发生在训练集上的

泛化误差

对于新样本上的误差

过拟合: 无法避免 把一些不太一般的特性也学习到了 (只能做到缓解)

欠拟合:由于学习能力不足产生的

2-2 评估方法

训练集:学习样本数据集,通过匹配一些参数来建立一个分类器。建立一种分类的方式,主要是用来训练模型的。

验证集:对学习出来的模型,调整分类器的参数,如在神经网络中选择隐藏单元数。验证集还用来确定网络结构或者控制模型复杂程度的参数。

测试集:主要是测试训练好的模型的分辨能力(识别率等)

显然:

训练集是用来训练模型或确定模型参数的,如ANN中权值等;

验证集是用来做模型选择(model selection),即做模型的最终优化及确定的,如ANN的结构;

测试集则纯粹是为了测试已经训练好的模型的推广能力。

当然,test set这并不能保证模型的正确性,他只是说相似的数据用此模型会得出相似的结果。但实际应用中,一般只将数据集分成两类,即training set 和test set,大多数文章并不涉及validation set。

怎样从数据集中公平合理地选择出测试集??

训练集的训练量要足够模型训练的

用 测试集上的测试误差 近似代替 泛化误差

在选择训练集和测试集的时候要保持数据分布的一致性

1和2 都是适合于数据样本较多的情况

-

留出法 一部分为训练集 剩下的则为测试集

须 分层采样 在D中 +:- 是 1:1 , 在Test中 也得 +:- 是1:1

须 多次随机划分

-

交叉验证法

即 每个数据都是要当做测试集的

k折交叉验证 即将数据集分为k份 每份数据都要当一次验证集

十次十折交叉验证: 每次划分(将数据集进行十次不同的划分) 都进行十折交叉 共得到100次划分结果 进行100次训练

留一法 :交叉验证法的特例 每个子集只包含一个样本 不受样本划分方式的影响 即 训练集与初始数据集相比较只少了一个样本 评估结果较为准确 但是数据量多的时候 计算量大

-

自助法(适用于小样本,且数据集难以划分时)

有放回的采样

有的样本会重复被选到 而有 36.8% 的样本 是不会出现在训练集的 就作为测试集

验证集:用于评估测试模型的数据集 根据在验证集上的表现进行调参和模型的选择

2-3 性能度量

回归问题: 输出的 y 是一个确切的数值 没有对错之分 只有准不准确

回归任务常用的评估的性能度量是“均方误差”

查准率 与 查全率 是一个此消彼长的关系

F1 调和均值度量,是一个中和的关系。

查准率:(准确)被分为正类中,实际为正类的比例

我认为是好瓜中 真正好瓜的概率

查全率:(全)实际为 + ,被分为 + 的比例

所有真的好瓜中,我找出了多少

F1 : 一般形式是Fβ β>0 度量了查全率对查准率的相对重要性 β=1 退化为标准的F1 β>1 查全率更有影响 β<1 查准率更有影响

ROC:真正例率 纵轴 ;假正例率 横轴 表示学习器的对于预测结果的排序性能

AUC:ROC曲线下的面积 用来判断两个学习器的性能 考虑的是样本预测结果的排序质量

预测结果排序 = 排在前面的是最有可能是正例的样本,后面的是负例样本

符合理想模型,正例往上走,负例往右走。

代价敏感错误率:

产生原因:不同类型的错误产生的代价不同,用非均等代价衡量,用代价敏感曲线描述。

在非均等代价下,目的不是最小化错误次数,而是最小化“总体代价”。

评估方法是如何对泛化能力进行评估,性能度量是评价泛化能力。

2-4 比较检验

•测试集上分类器A比B好,但是在统计意义上该结果有多大把握?需要用到假设检验。

•性能比较 常用方法:

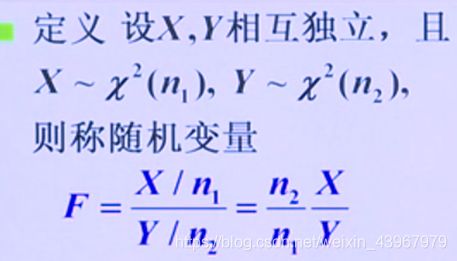

•交叉验证t检验、McNemar检验、Friedman检验和Nemenyi后续检验

•法1. 成对双边t检验(在一个数据集上比较两个分类器的性能)。

•法2:friendman检验(在一个数据集上比较多个分类器的性能)。

•法3:在n个数据集上比较k个算法,将每个算法在每个数据集上的测试结果排序赋值,得出所有算法在每个数据集上的平均数值(如在数据集A上,10个算法的平均值),基于这种平均数值,计算出F检验的统计量,若所比较的算法存在显著不同,则需要进行后续检验(Nemenyi检验)进一步区分算法的性能。

2-5 偏差-方差

•泛化性能的优劣用“偏差-方差分解”反映,不是衡量。在训练不足时,数据即方差的影响小,在此偏差即拟合能力对泛化能力起决定作用。反之成立。

•误差:结果与真实值之间的差值

•偏差:结果与平均值之间的差值,反映了算法的拟合能力

•方差:整体预测期望值散度的大小,同样大小的数据集变动导致学习性能的变化

噪声则表达了在当前任务上任何学习算法所能达到的期望泛化误差下界,即问题本身的难度。

泛化性能是由学习算法的能力(偏差)、数据的充分性(方差)及学习任务本身的难度(噪音)所决定的。

高偏差 — 欠拟合

方法:

1.引入更多相关属性

2.采用多项式特征

3.减少正则化参数 β

高方差 — 过拟合

方法:

1.引入更多相关特征

2.采用多项式特征

3.增加正则化参数 β

拟合能力和泛化能力:

•拟合能力是模型在训练集上的效果与真实效果的对比,

•泛化能力是模型在测试集上的效果与真实效果的对比。

拟合能力描述的是模型在训练集对样本属性的拟合能力,即表达能力;泛化能力是模型对其他数据集的适应能力。

2-6 统计学三种检验方法

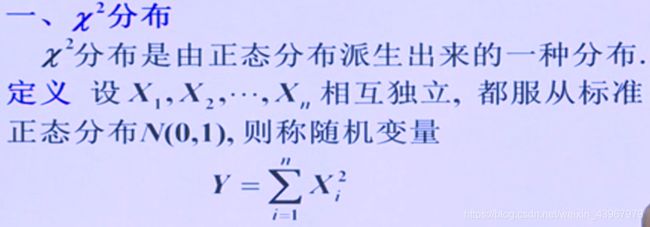

卡方检验

统计样本的实际观测值与理论推断值之间的偏离程度,实际观测值与理论推断值之间的偏离程度就决定卡方值的大小。

卡方值越大,越不符合;卡方值越小,偏差越小,越趋于符合。

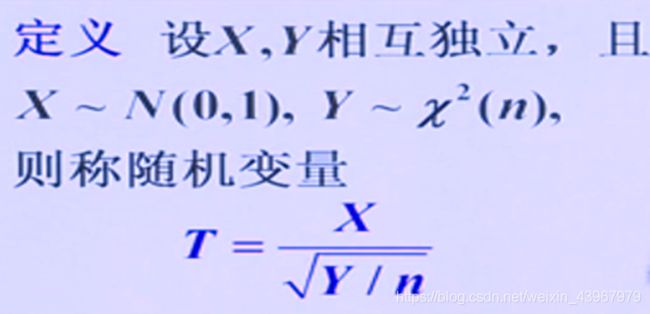

T检验:

是用t分布理论来推论差异发生的概率,从而比较两个平均数的差异是否显著,可分为单总体检验和双总体检验,以及配对样本检验。