【云原生之K8S】kubeadm v1.20 部署K8S 集群架构

目录

一、环境配置

1.2 将桥接的 IPv4 流量传递到 iptables 的链

编辑

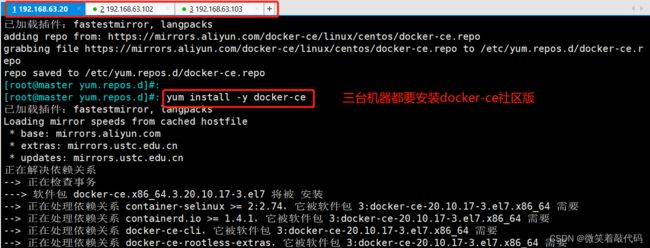

1.3 docker安装

1.4 设置阿里云镜像源 【三台都要配置】

1.5 安装docker-ce 社区版

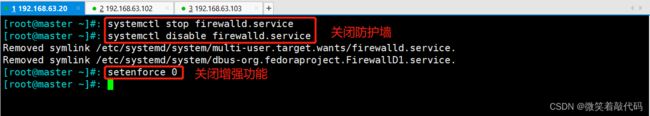

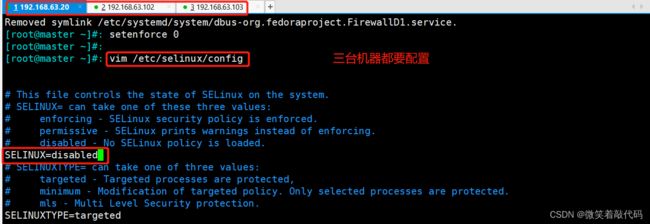

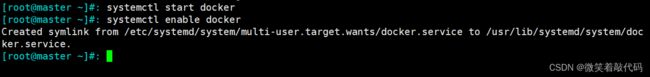

1.6 环境配置

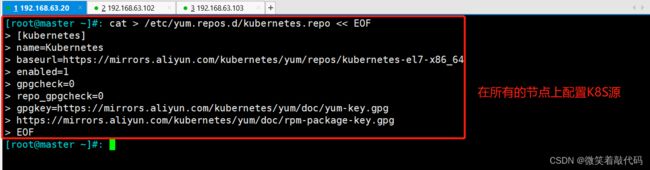

1.7 所有节点配置K8S源

1.8 安装 kubelet、kubeadm、kubectl 组件

1.9 master节点制作

1.10 创建K8S组件的家目录 提权(必做)

1.11 复制、记录申请加入集群命令【在两个节点服务器上写】

1.12 重新生成token

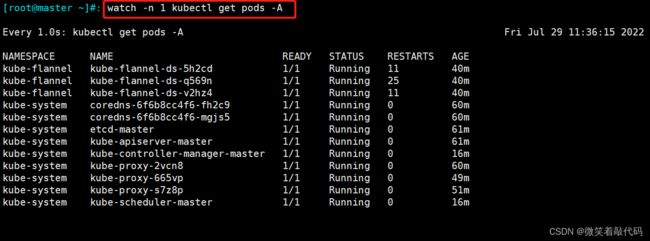

1.13 或者使用镜像包导入的方式完成flannel的部署#【三台都要写】

1.14 给node节点打上“node”的标签

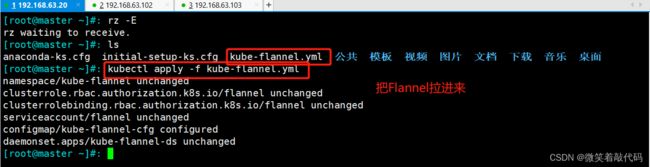

1.15在三个服务器上面都要配置这个,把flannel配置文件拉进去,然后执行他!

一、环境配置

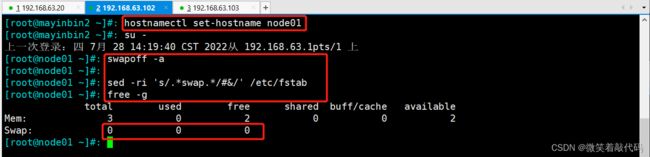

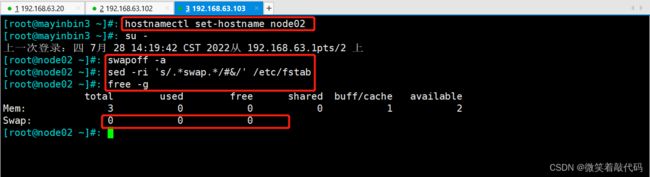

master01(ectd节点1):192.168.63.20

node01(ectd节点2):192.168.63.102

node02(ectd节点3):192.168.63.103

swapoff -a #临时

sed -ri 's/.*swap.*/#&/' /etc/fstab #永久

free -g #验证,swap 必须为 0;

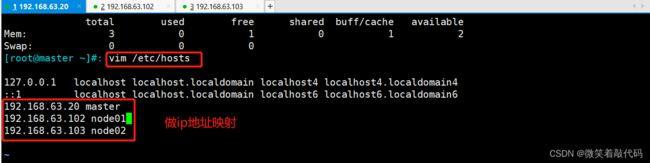

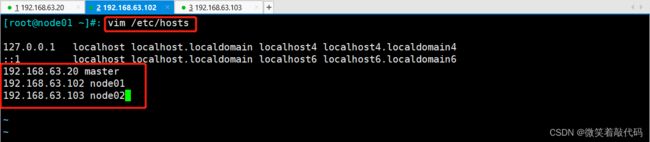

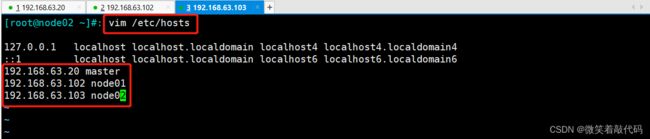

vim /etc/hosts

192.168.63.20 master

192.168.63.102 node01

192.168.63.103 node02

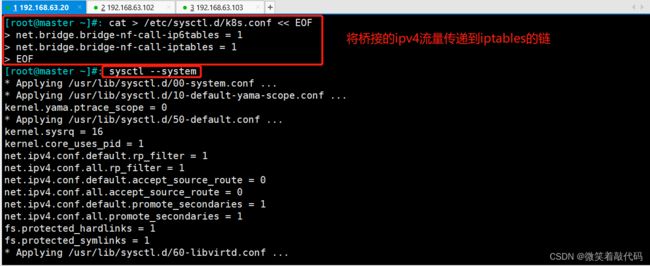

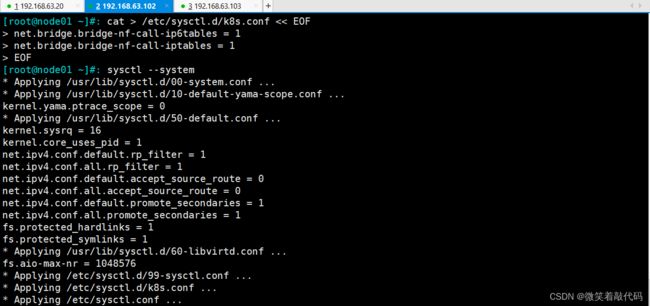

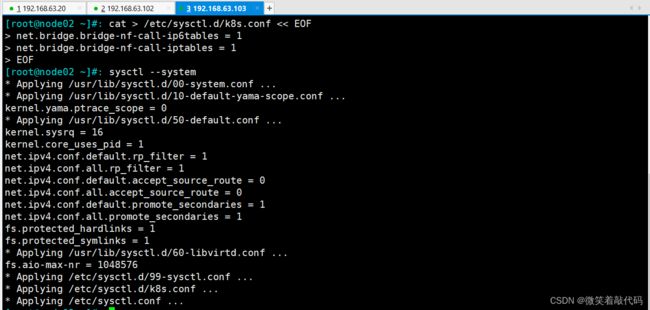

1.2 将桥接的 IPv4 流量传递到 iptables 的链

cat > /etc/sysctl.d/k8s.conf << EOF

net.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

EOF

sysctl --system

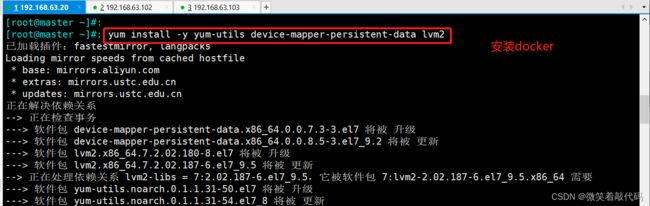

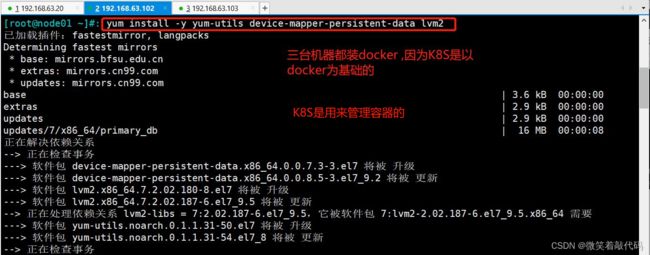

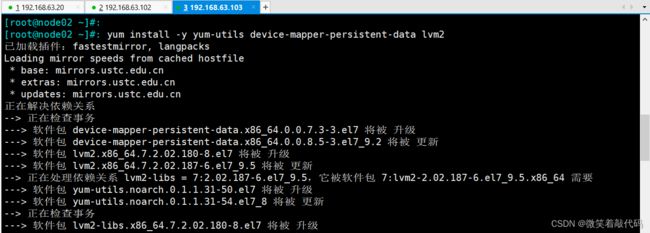

1.3 docker安装

安装依赖包

yum install -y yum-utils device-mapper-persistent-data lvm2

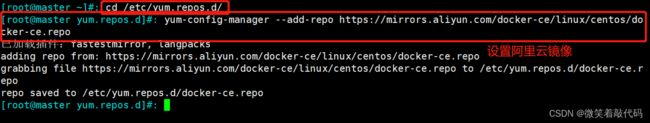

1.4 设置阿里云镜像源 【三台都要配置】

cd /etc/yum.repos.d/

yum-config-manager --add-repo https://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

1.5 安装docker-ce 社区版

yum install -y docker-ce1.6 环境配置

systemctl stop firewalld

systemctl disable firewalld

setenforce 0

vim /etc/selinux/config

SELINUX=disabled

systemctl start docker

systemctl enable docker

1.7 所有节点配置K8S源

cat > /etc/yum.repos.d/kubernetes.repo << EOF

[kubernetes]

name=Kubernetes

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64

enabled=1

gpgcheck=0

repo_gpgcheck=0

gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg

https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

EOF

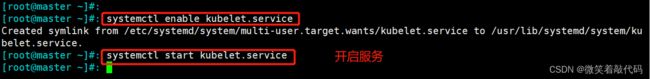

1.8 安装 kubelet、kubeadm、kubectl 组件

yum list|grep kube

yum install -y kubelet-1.21.3 kubeadm-1.21.3 kubectl-1.21.3

systemctl enable kubelet

systemctl start kubelet

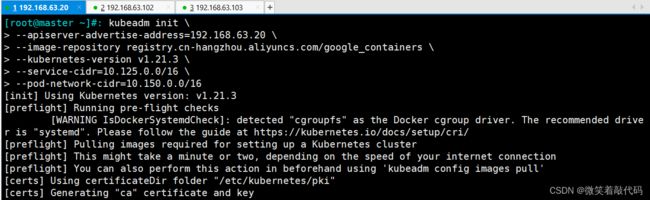

1.9 master节点制作

kubeadm init \

--apiserver-advertise-address=192.168.63.20 \

--image-repository registry.cn-hangzhou.aliyuncs.com/google_containers \

--kubernetes-version v1.21.3 \

--service-cidr=10.125.0.0/16 \

--pod-network-cidr=10.150.0.0/16

如有问题 :【用这个】

kubeadm init --apiserver-advertise-address=192.168.190.2 --image-repository registry.cn-hangzhou.aliyuncs.com/google_containers --kubernetes-version v1.21.3 --service-cidr=10.125.0.0/16 --pod-network-cidr=10.150.0.0/16

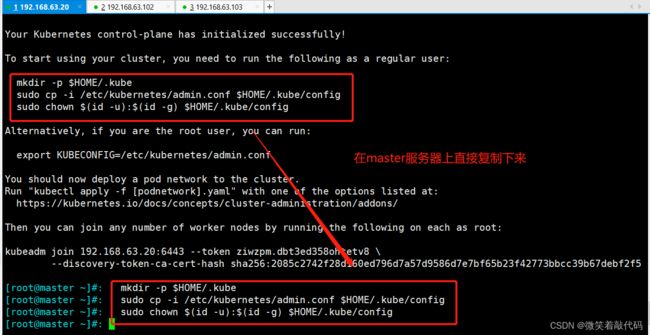

1.10 创建K8S组件的家目录 提权(必做)

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config

##镜像批量导出,方便以后使用docker save docker images | grep -v TAG | awk '{print $1":"$2}' -o name.tar.gz

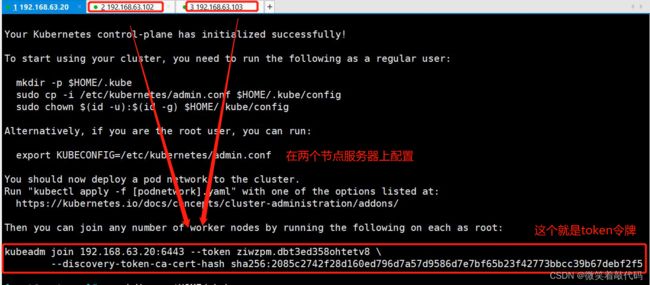

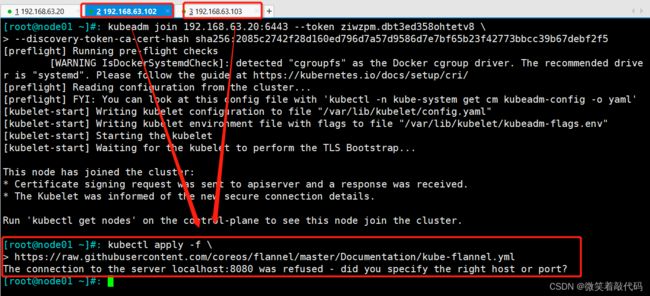

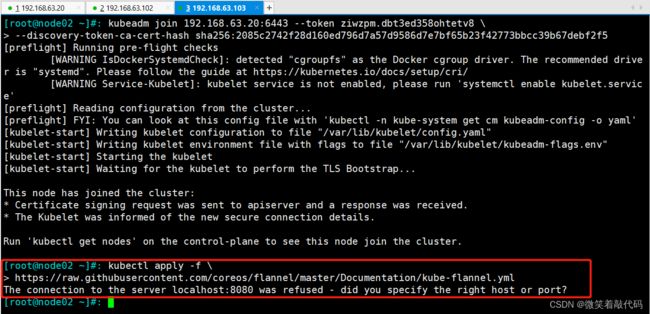

1.11 复制、记录申请加入集群命令【在两个节点服务器上写】

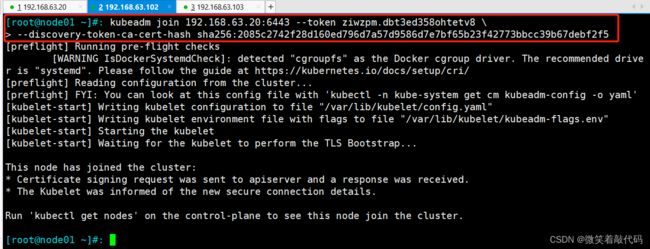

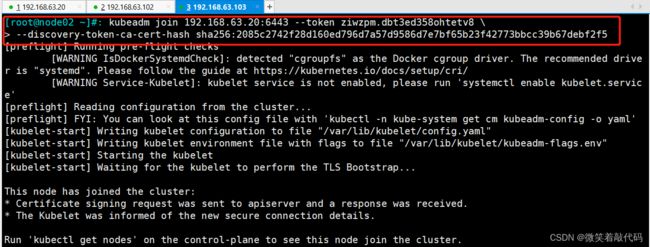

kubeadm join 192.168.63.20:6443 --token ziwzpm.dbt3ed358ohtetv8 \

--discovery-token-ca-cert-hash sha256:2085c2742f28d160ed796d7a57d9586d7e7bf65b23f42773bbcc39b67debf2f51.12 重新生成token

#若token 过期或丢失,需要先申请新的token 令牌【令牌过期时间是:24小时,等过了24小时之后,令牌失效,使用下面这个命令进行刷新重新生成令牌!】

kubeadm token create

#列出token

kubeadm token list | awk -F" " '{print $1}' |tail -n 1

#然后获取CA公钥的的hash值

openssl x509 -pubkey -in /etc/kubernetes/pki/ca.crt | openssl rsa -pubin -outform der 2>/dev/null | openssl dgst -sha256 -hex | sed 's/^ .* //'

#替换join中token及sha256:

kubeadm join 192.168.63.20:6443 --token ziwzpm.dbt3ed358ohtetv8 \

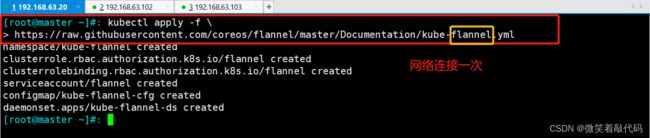

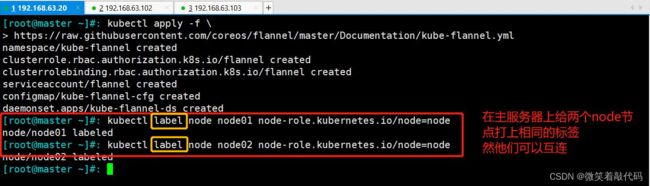

--discovery-token-ca-cert-hash sha256:2085c2742f28d160ed796d7a57d9586d7e7bf65b23f42773bbcc39b67debf2f51.13 或者使用镜像包导入的方式完成flannel的部署#【三台都要写】

kubectl apply -f \

https://raw.githubusercontent.com/coreos/flannel/master/Documentation/kube-flannel.yml

1.14 给node节点打上“node”的标签

[root@master ~]# kubectl label node node01 node-role.kubernetes.io/node=node

node/node01 labeled

[root@master ~]# kubectl label node node02 node-role.kubernetes.io/node=node

node/node02 labeled

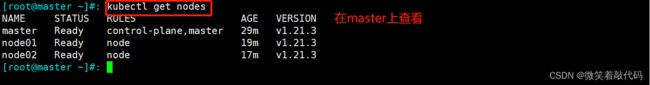

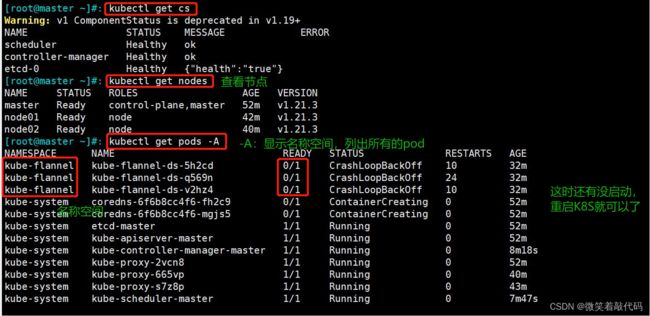

[root@master ~]# kubectl get nodes

NAME STATUS ROLES AGE VERSION

master Ready control-plane,master 7m11s v1.21.3

node01 Ready node 2m32s v1.21.3

node02 Ready node 2m32s v1.21.3

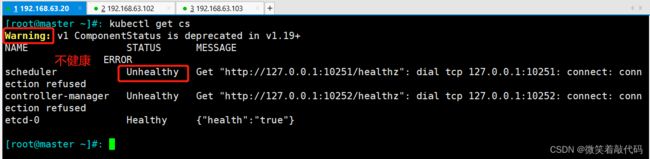

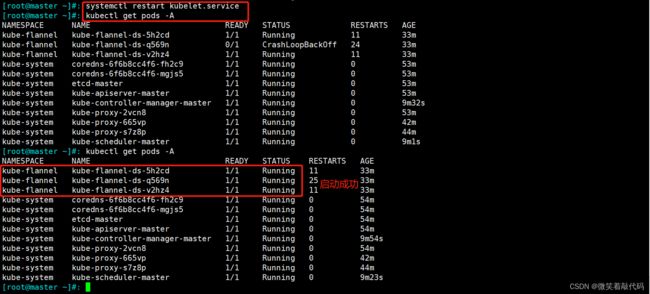

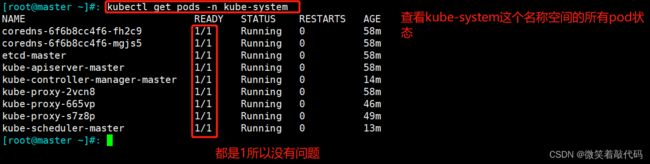

//如果 kubectl get cs 发现集群不健康,更改以下两个文件

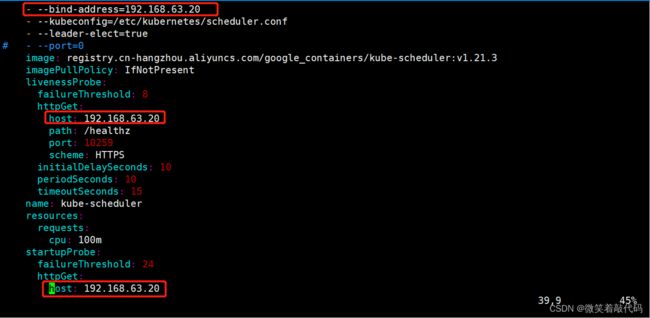

vim /etc/kubernetes/manifests/kube-scheduler.yaml

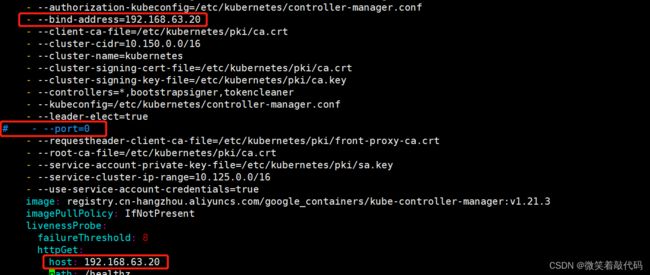

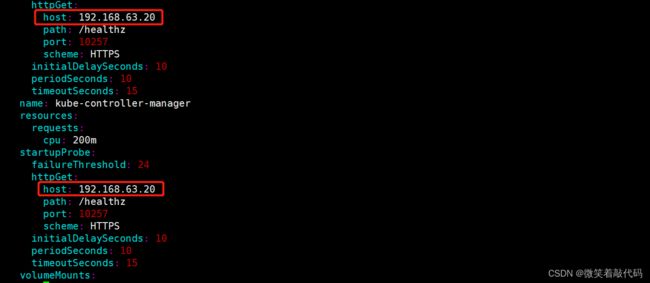

vim /etc/kubernetes/manifests/kube-controller-manager.yaml

# 修改如下内容

把--bind-address=127.0.0.1变成--bind-address=192.168.63.20 #修改成k8s的控制节点master01的ip

把httpGet:字段下的hosts由127.0.0.1变成192.168.63.20(有两处)

#- --port=0 # 搜索port=0,把这一行注释掉

systemctl restart kubelet

PS:这是控制资源管理器

PS:这是资源调度器