ICCV2019超分辨率方向论文整理笔记

ICCV2019超分辨率篇

IEEE International Conference on Computer Vision,即国际计算机视觉大会,与计算机视觉模式识别会议(CVPR))和欧洲计算机视觉会议(ECCV)并称计算机视觉方向的三大顶级会议。不同于在美国每年召开一次的CVPR和只在欧洲每两年召开一次的ECCV,ICCV在世界范围内每两年召开一次。ICCV论文录用率非常低,是三大会议中公认级别最高的。

ICCV共举行了4天,在超分辨率上收录文章13篇。这里仅对单图像超分辨率相关的5篇论文作介绍。

相关笔记:

- ECCV2020超分辨率方向论文整理笔记

- CVPR2020超分辨率方向论文整理笔记

- NTIRE介绍和近年来超分SR结果展示

- 图像超分辨率SR的背景概念性知识总结和几篇重要论文介绍

文章目录

-

-

- ICCV2019超分辨率篇

-

- 1. EBRN: Embedded Block Residual Network

- 2. KMSR: Kernel Modeling

- 3. SROBB

- 4. Wavelet Domain Style Transfer

- 5. RankSRGAN

- 个人总结

-

1. EBRN: Embedded Block Residual Network

Embedded Block Residual Network: A Recursive Restoration Model for Single-Image Super-Resolution,paper

块残差模块:不同的模块可恢复不同频率的信息,将前层难以恢复的信息传入更深的层进行恢复。

问题描述:

现有的模型方法无法区分图像频率,这些模型中每一层都是根据上一层恢复的恢复来恢复纹理。对于浅层,参数可能适合于低频信息(具有简单纹理),但不适合高频信息(具有复杂纹理)。对于较深的层,这些参数可以适合于高频信息,但在低频信息上过拟合。另外,低频信息由更简单的结构和纹理组成,可以用更简单的模块来进行恢复;较高频率的信息由复杂的结构和纹理组成,可以使用复杂的模块来实现。这就要求构建一个模块,将低频和高频分开。尽管残差连接提供了一种将信息拆分为已恢复和未恢复信息的方法,但其残差连接结构与分频原理无关。相反,这些方法主张残差连接以密集和直接的方式将浅层信息传递到深层。但是,深层很容易在图像的低频信息上过度拟合。

基于以上分析,本文提出一种块残差模块(Block Residual Modual, BRM)的结构,将低频和高频分开,旨在恢复部分HR信息,同时将剩余信息传递给更深层的模块以进行恢复。

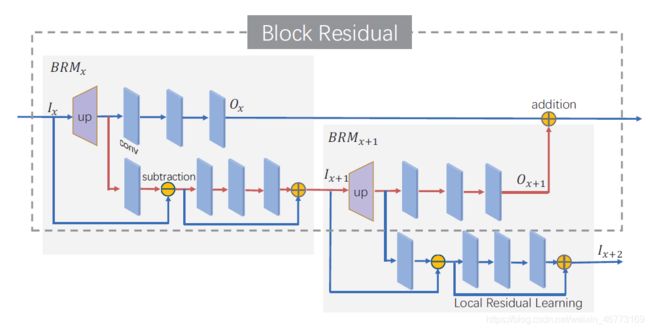

如图,该模块包含两个数据流:超分辨率流和反投影流。

超分辨率流用以恢复较低频率的信息,是一个基本的反卷积网络,LR特征图 I x I_x Ix 通过使用一个反卷积层(也称为转置卷积,图中up块)和三个卷积层的堆叠,输出为超分辨率特征图 O x O_x Ox,

反投影流用于计算超分辨率流尚未恢复的信息。反投影流采用一种操作,该操作首先将反卷积特征图下采样到LR空间大小,然后计算下采样特征图和输入LR特征图的负值。计算出的残差传达了超分辨率流无法恢复的信息。然后,该残差由局部残差学习阶段处理,输出一组编码特征 I x + 1 I_{x+1} Ix+1,这些特征形成下一个BRM的输入。

BRM以嵌入的方式构成,而不是简单的堆叠方式。即,后一个BRM连接到前一个BRM的反投影流的输出,依此类推。每个BRM都负责恢复其先前BRM的反投影流所产生的残差特征图,反过来说,难以恢复的较高频率的信息将传递给后续模块。因此,较深的BRM总是尝试还原较浅的BRM尚未还原的内容。这符合我们的期望。

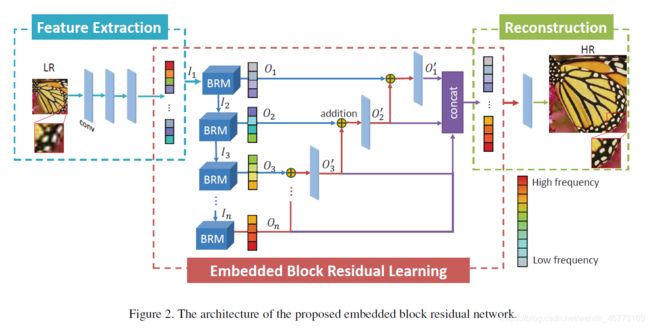

网络的整体架构:

为了结合所有BRM的输出,作者注意到深层模块恢复的信息可以帮助改善浅层模块的恢复。对此,论文提出了一种递归融合技术,而不是简单的求和。如图,将每个BRM的超分辨率流输出从最后一个BRM开始向前递归融合,然后接一个卷积层。与简单求和相比,该技术能够以平滑的方式处理输出,从而实现更好的重构。此外,为了避免训练中出现梯度消失的问题,作者建议将每个BRM的输出直接Concat连接到图像重建模块。最后利用3×3×64卷积核,产生3通道RGB图像。

作者使用L1损失作为训练目标,然后使用L2损失进行微调。

结果对比:

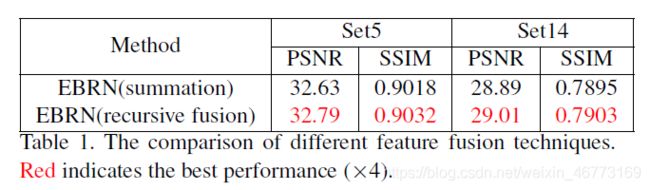

作者采样简单的相加方式和递归融合方式进行了实验对比

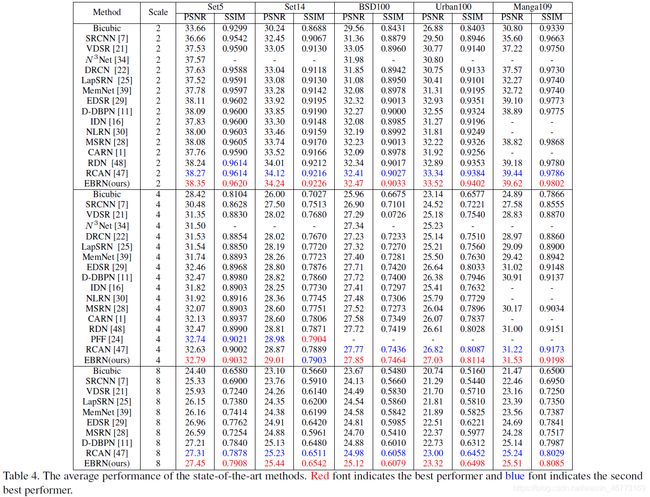

在测试集上的结果如下

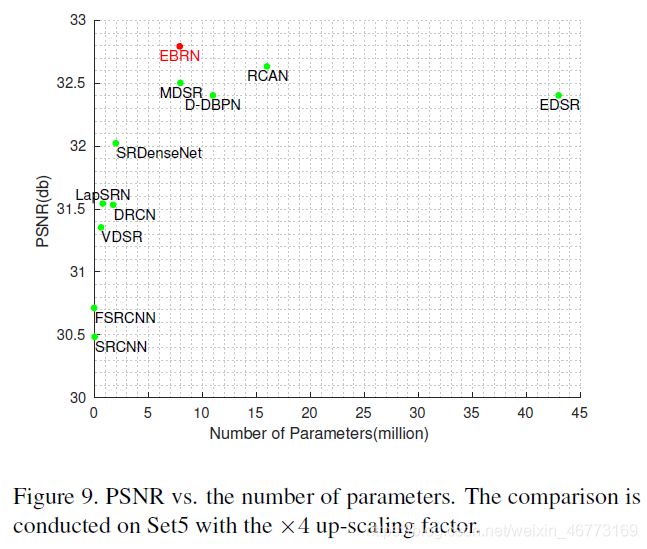

参数比较

2. KMSR: Kernel Modeling

Kernel Modeling Super-Resolution on Real Low-Resolution Images,paper,code

模糊核估计:在网络训练时注入模糊核以模拟真实图像的退化过程。

问题描述:

给定高分辨率图像(HR) y y y,经过退化后的对应低分辨率图像(LR) x x x,这一过程可用下列公式表示:

x = ( y ∗ k ) ↓ s + n x=(y*k)\downarrow^s\large + n x=(y∗k)↓s+n

k k k:未知模糊核

↓ s \downarrow^s ↓s:尺度为 s 的下采样操作

n n n:噪声

这表明,LR图像本质上是通过HR图像使用不同类型的模糊核生成的。以前的大多数方案LR图像基本是从对应HR图像进行双三次插值获得,即单一已知模糊核,与真实世界图像退化的方式明显不同,因此其在现实场景中泛化和鲁棒性都不高。作者提出了一个内核建模超分辨率网络(Kernel Modeling Super-Resolution, KMSR),该网络在训练中纳入了模糊核建模。KMSR包括两个阶段:首先使用生成的对抗网络(GAN)建立一个现实的模糊核池,然后使用HR和由生成的内核构建的相应LR图像训练超分辨率网络。

假设从 n = 0 n=0 n=0,使用传统的双三次插值(bicubic)将LR放大到低质量HR图像 x ′ x^{\prime} x′ :

x ′ = ( x ∗ b s ) x^{\prime}=(x*b_s) x′=(x∗bs)

b s b_s bs:尺度为 s 的双三次放大核

于是有: x ′ = ( ( y ∗ k ) ↓ s ) ∗ b s x^{\prime}=((y*k)\downarrow^s)*b_s x′=((y∗k)↓s)∗bs,简化为:

x ′ = y ∗ k ′ x^{\prime}=y*k^{\prime} x′=y∗k′

k ′ = ( k ∗ b s ) ↓ s k^{\prime}=(k*b_s)\downarrow^s k′=(k∗bs)↓s

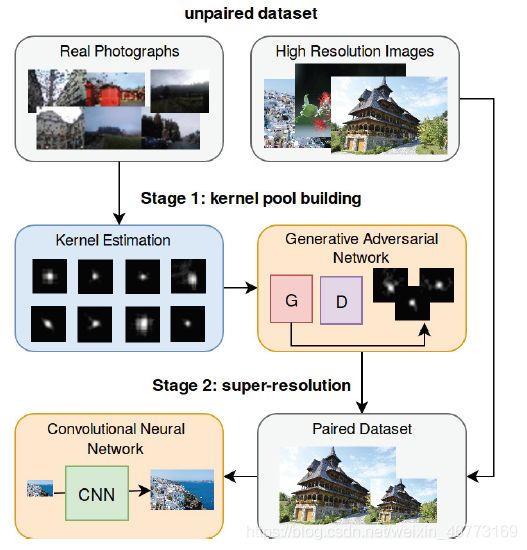

要训练盲超分(模糊核未知),根据等式,我们需要获得成对的训练数据 y y y 和 x ′ x^{\prime} x′。而训练GAN比较困难且不稳定,并且很难生成无伪影的图像。因此,作者使用GAN产生模糊核而不是图像。整体流程如下:

第一个阶段:从真实图像中估计模糊核,这被用于训练GAN网络,以产生大量逼真的模糊核。

第二个阶段:将上面生成的模糊核用于创建相应的HR和LR图像的配对数据集,以训练CNN网络。

模糊核池构建:

对真实图像,使用基于暗通道先验方式进行核估计(具体见论文3.2节),得到模糊核集 K ′ K^{\prime} K′。输入的LR很难获得,且核估计算法比较昂贵,这导致收集的核数量核多样性可能会受到限制。因此,作者使用GAN对估计的模糊核集 K ′ K^{\prime} K′ 的分布进行建模,并生成一个更大的模糊核池 K + K^+ K+。这里,作者使用WGAN-GP进行生成模糊核建模。

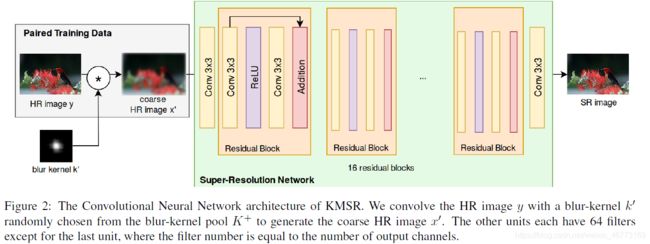

整体网络架构:

对HR图像y,从模糊核池中随机选取模糊核 k ′ k^{\prime} k′ 与HR卷积生成低质量HR图像 x ′ x^{\prime} x′,组成image-pairs进行训练。

训练设置: 作者使用DPED数据集训练GAN以生成模糊核池,使用DIV2K数据集作为HR图像,随机选取模糊核池中模糊核与之进行卷积,得到输入图像,以此训练SR网络。

特别地:论文在3.1节中写到"We upscale the LR image to a coarse HR image x ′ x^{\prime} x′ with the desired size r 1 × r 2 r_1×r_2 r1×r2 with traditional bicubic interpolation by the same factor s s s",表明粗(低质量)HR图像 x ′ x^{\prime} x′ 尺寸为 r 1 × r 2 r_1×r_2 r1×r2 ,那么这里SR网络的输入为HR的尺寸大小,图2中也没有看到放大模块进行尺寸的放大。以此可以推理出,在实际测试的时候,对低分辨率图像LR(尺寸为 r 1 / s × r 2 / s r_1/s ×r_2/s r1/s×r2/s ),先将其上采样到HR尺寸(即为低质量HR图像,按作者公式,上采样应为bicubic上采样),然后输入到SR网络中,进行高质量HR重建,即完全的模糊核估计,实际SR网络不包含上采样放大部分。

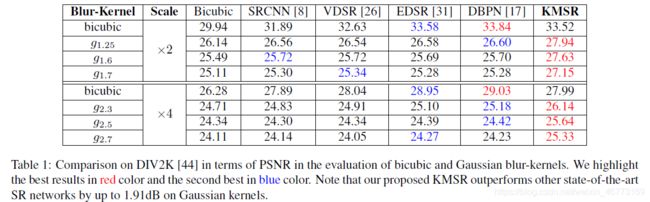

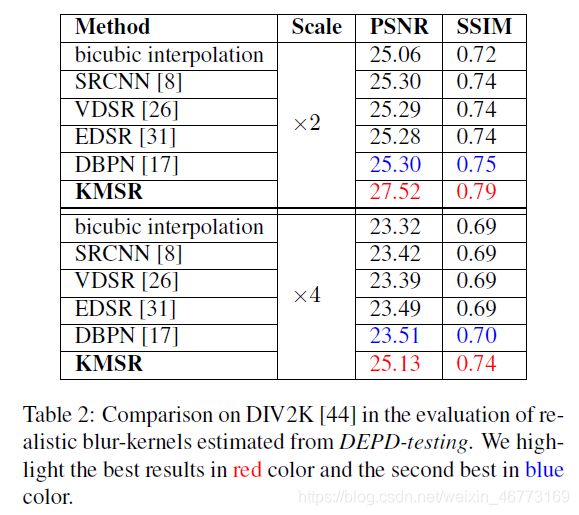

结果对比:

3. SROBB

SROBB: Targeted Perceptual Loss for Single Image Super-Resolution,paper

损失函数新设计方式:从分割标签生成OOB(Object, Background and Boundary) 标签,来估计边界合适的感知损失,同时考虑背景的纹理相似性。

现有的方法在整张图像上用相同的方式来估计重建误差,而不考虑语义信息。因此,作者提出基于感知损失的新估计方式,使用逐像素损失、对抗损失和所提的目标感知损失优化网络,对不同语义级别的图像执行不同的惩罚。

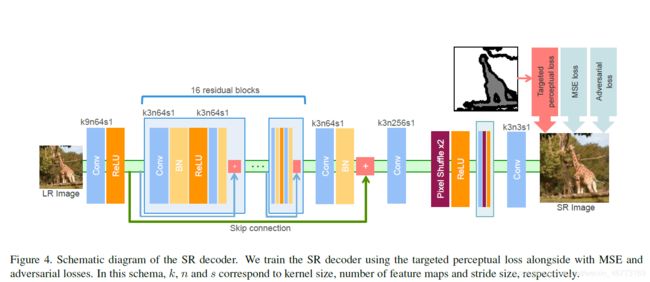

网络的整体架构:

主架构与一些经典方法没有太大的差别,作者主要关注于充分利用感知损失,使目标函数强制执行语义细节(图像包含对象、背景和边界)。新的目标感知损失的生成方式示意图如下:

分割标签经过OBB生成器生成OBB标签,与主网络生成的SR图像求其损失。

OBB标签创建:

使用来自COCO-Stuff数据集随机的50K张图像,其中包含91个类别的用于分割任务的的语义标签,考虑了具有“天空”、“植物”、“地面”和“水”类中的一个或多个景观。然后将这些类分为一个“背景”类,再通过下图的方式按像素分割注释转换成OBB标签。

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-7UcE43Tk-1603160437160)(ICCV2019.assets/OBB.png)]

首先,在颜色空间中通过边缘检测算法(这里为计算分割标签的导数)检测图像内不同对象的边缘,为了使检测出的对象类别的边缘条带更粗,使用大小为 d 1 d_1 d1 的圆盘进行膨胀,使条带穿过所有边界。最后,将结果区域标记为“边界”类,它涵盖了图像内不同类之间的边界。特别地,将细分标签中的“天空”、“植物”、“地面”和“水”类视为“背景”,所有剩余的对象类别都被视为“对象”类别。

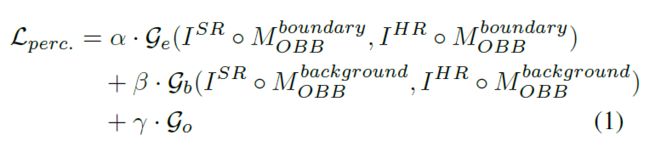

总目标感知损失:

与边缘相对应的边界掩模: M O B B b o u n d a r y M_{OBB}^{boundary} MOBBboundary ,与纹理相对应的背景掩模: M O B B b a c k g r o u n d M_{OBB}^{background} MOBBbackground。

G b \mathcal{G}_b Gb , G e \mathcal{G}_e Ge , G o \mathcal{G}_o Go 为分别计算边界,背景和对象的任意两个给定图像之间的特征空间距离的函数。由于不考虑对象的任何感知损失,直接将 γ \gamma γ 置0。

∘ \circ ∘ 表示逐像素相乘。

Background ( G b \mathcal{G}_b Gb) :计算任意两个给定图像之间特征将四个类别作为背景:“天空”,“植物”,“地面”和“水”,选择这些类别是因为它们的外观特殊。具有这些标签的区域的整体纹理比局部空间关系和边缘更重要。计算中级CNN特征以估计SR和HR图像之间的感知相似度。在这里,使用VGG-16的ReLU 4-3层。

Boundary ( G e \mathcal{G}_e Ge) :分离对象和背景的所有边缘均视为边界。估计SR和HR图像之间早期CNN层的特征距离,该特征距离更多地集中在低层空间信息上,主要是边缘和斑点。特别是,最小化VGG-16的ReLU 2-2层的感知损失。

Object ( G o \mathcal{G}_o Go) :由于现实世界中形状和纹理方面的物体种类繁多,因此要决定是否更适合使用早期或较深层的特征来进行感知损失具有挑战性;例如,在斑马图像中,较锐利的边缘比整体纹理更重要。话虽如此,强迫网络估计树中的精确边缘可能会误导优化过程。因此,作者不对定义为对象的区域进行任何类型的知觉损失,方法是将它们加权为零,并依赖MSE和对抗损失。从直觉上讲,通过“背景”和“边界”感知损失项解决更逼真的纹理和更锐利的边缘,也将导致物体更具吸引力。

为了计算特定图像区域的感知损失,作者对语义类进行了二进制分割掩码(对于感兴趣的类,其像素值为1;在其他位置,其像素值为0)。每个掩模分类地表示图像的不同区域,并且分别与HR图像和估计的超分辨图像SR逐元素相乘。换句话说,对于给定的类别,在通过CNN特征提取器之前,图像会被转换为只有一个可见区域的黑色图像。

训练过程:

对SR解码器进行25 epochs的预训练,仅使用像素均方误差作为损失函数,然后加入所提的目标感知损失和对抗损失,继续执行训练55 epochs。

结果对比:

PSNR/SSIM指标不能反映重构的质量;使用所提的方法和SRGAN的重建图像没有排名第一,但他们产生了更现实和吸引力的超分辨图像。因此,在这里,作者只给出BSD100测试集上的定性结果。放大尺度为4。

LPIPS:the Learned Preceptual Image Patch Similarity,衡量SR与HR失真度的指标,越小越好。

图源自补充材料。

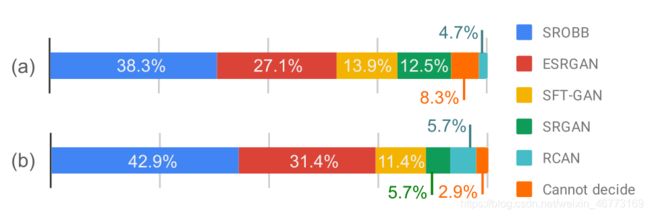

另外,作者经过用户研究,要求用户针对真实图像对各种方法生成的图像进行投票选出效果更好的图像,另外为了公平性,还设置了"无法决定"选项。结果如下:

(a)投票百分比

(b)多数投票赢得图像的百分比

4. Wavelet Domain Style Transfer

Wavelet Domain Style Transfer for an Effective Perception-distortion Tradeoff in Single Image Super-Resolution,paper

小波域风格迁移:二维平稳小波变换将图像分解为低频和高频分量,达到超分图像低失真和高感知质量之间的权衡。

问题描述:

在SISR中,人们希望找到一种既准确又逼真的高分辨率(HR)版本。最近,已经证明在低失真和高感知质量之间存在基本的权衡,并且生成对抗网络(GAN)被证明可以有效地接近感知失真(Perception-distortion, PD)。目前的很多方法在信噪比(PSNR)上获得很好的表现,但在感知方面却差强人意,如下图不同SISR方法的感知失真性能比较:

蓝点代表针对客观质量的方法,绿点代表针对感知质量的方法,橙色点代表针对感知与失真之间权衡的方法。PSNR值越高表示目标质量越好,NRQM(No-Reference Quality Metric)得分越高则感知质量越好,左下角是最好的。作者的方法在所有“橙色”方法中实现了最佳折衷。

客观和感知质量受图像中不同元素的影响。当整体进行优化时,客观质量的提高可能会导致感知质量的下降,反之亦然。为了获得最佳折衷,应该将影响客观质量的要素与影响感知质量的要素分开,并分别进行优化。而作者发现,低频分量在客观质量中起重要作用,而高频分量则可以显著影响感知质量。在论文中,作者使用小波变换来实现这种分离。分离后,为了获得最佳折衷,使用增强网络来改善低频子带的客观质量,并使用小波域风格迁移来提高高频子带的感知质量。

客观质量:为了提高客观质量,大多数方法都试图将重建图像与真实图像之间的MSE损失降至最低。这种方法可以生成具有高客观质量的HR图像。但是,由于缺少高频细节,这些图像通常在视觉上令人不快且边缘模糊,尤其是对于较大的放大系数。

感知质量:由于MSE损失无法测量两个图像之间的感知相似性,而VGG损失擅长表示两个图像之间的感知相似性,并且对抗性损失会使恢复的图像看起来逼真,因此感知损失定义为VGG损失和对抗损失的加权和,之后又有方法提出增加纹理匹配损失,在重建具有高感知质量的图像方面取得了良好的效果。

平稳小波变换:

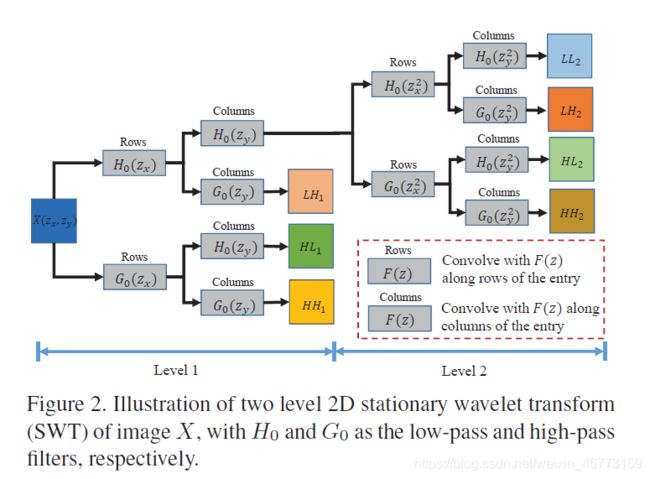

小波变换允许对图像进行多分辨率分析。经典离散小波变换(DWT)不具有平移不变性,不适合SR任务。平稳小波变换(SWT)通过消除DWT中的下采样操作来克服这一缺点。下图给出了2D SWT过程:

其中 L L i LL_i LLi 表示第 i 级的低频信息( i 为小波分解级数), L H i , H L i , H H i LH_i,HL_i, HH_i LHi,HLi,HHi 分别表示第 i 级的水平、垂直和对角的细节,即其高频信息。

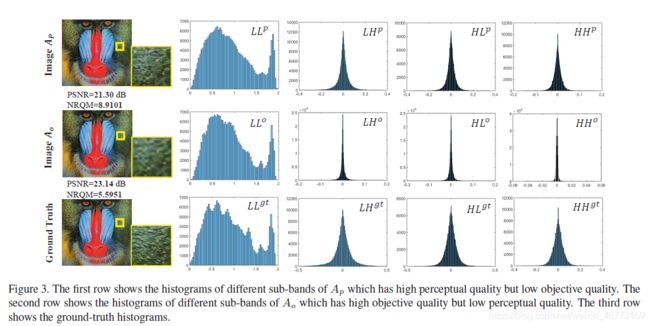

2D SWT可以将图像分解为多个子带,包括一个低频子带和几个高频子。作者考虑了两个超分辨图像:具有高感知质量但客观质量较低的 A p A_p Ap 和具有高客观质量但感知质量较低的 A o A_o Ao ,图3显示了这两个图像以及SWT之后它们的子带的直方图。

可以看到,对低频子带, A o A_o Ao 与真实图像更相似,说明低频子带对图像的客观质量有重要影响;对高频子带, A p A_p Ap 与真实图像更相似,说明高频自带对感知质量有显着影响。

网络整体架构:

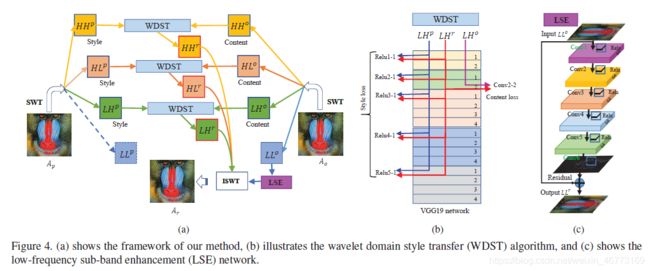

给定一个高感知质量的图像 A p A_p Ap 和一个高客观质量的 A o A_o Ao,分别进行2D SWT。然后,使用LSE网络提高 A o A_o Ao 的客观质量(低频子带 L L o LL_o LLo);对于高频子带,使用WDST将它们融合成一个新的子带。最后,将所有融合的高频子带和提高的 L L o LL_o LLo 通过ISWT获得图像 A r A_r Ar。

低频子带增强(Low-frequency sub-band enhancement, LSE):对于低频子带 L L o LL_o LLo,旨在增强其客观质量。采样VDSR架构,网络输入为 L L o LL_o LLo,学习目标为真实图像的 L L g t LL^{gt} LLgt,损失函数为 L2 损失。

小波域风格迁移(Wavelet domain style transfer, WDST):对于高频子带,旨在提高其感知质量。以子带对 L H p LH^p LHp 和 L H o LH^o LHo 为例, L H p LH^p LHp 中的小波系数比 L H o LH^o LHo 中的丰富,即 L H p LH^p LHp 比 L H o LH^o LHo 包含更多非零的小波系数。因此,我们希望在 L H p LH^p LHp 到 L H o LH^o LHo 中传递详细的小波系数,以使 L H o LH^o LHo 具有更高的感知质量。网络采样VGG19架构, L H p LH^p LHp 为风格样式输入, L H o LH^o LHo 为生成内容输入,以生成输出子带 L H r LH^r LHr 。与输入为像素值的传统风格转换算法不同,作者在WDST中使用小波系数作为输入。子带 L H LH LH 的总损失为

L c L_c Lc:内容损失,定义为两个特征图之间的MSE

L s L_s Ls :风格损失,定义为两个特征图Gram矩阵之间的MSE

∣ ∣ L H r ∣ ∣ 1 ||LH^r||_1 ∣∣LHr∣∣1: ℓ 1 \ell_1 ℓ1 正则损失,用以保存小波系数的稀疏性

训练设置: 对2D SWT,使用 b i o r 2.2 bior2.2 bior2.2 作为默认的小波滤波器,小波分解级数为2,意味着有一个低频子带和6个高频子带(如图2)。使用EDSR方法获得 A o A_o Ao,使用CX方法获得 A p A_p Ap,使用NRQM计算感知分数。

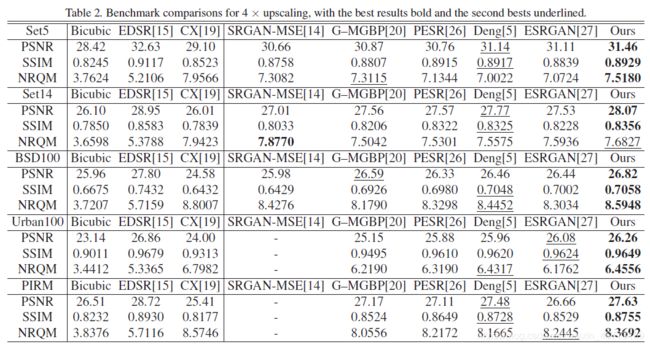

结果对比:

不同方式获取 A o A_o Ao 和 A p A_p Ap 的结果:

5. RankSRGAN

RankSRGAN: Generative Adversarial Networks with Ranker for Image Super-Resolution,paper,code

摘要:生成对抗网络(GAN)展示了为单个图像超分辨率(SISR)恢复现实细节的潜力。为了进一步改善超分辨结果的视觉质量,PIRM2018-SR Challenge使用了感知指标来评估感知质量,例如PI,NIQE和Ma。但是,现有方法无法直接优化这些不可区分的感知指标,这些指标与人类评级高度相关。为了解决该问题,我们提出了带有Ranker的SuperResolution生成对抗网络(RankSRGAN),以在感知指标的方向上优化生成器。具体来说,我们首先训练一个Ranker,它可以学习感知指标的行为,然后引入一种新颖的等级内容损失来优化感知质量。最吸引人的部分是,该方法可以结合不同SR方法的优势来产生更好的结果。大量的实验表明,RankSRGAN在视觉效果上达到令人愉悦的效果,并达到了最先进的性能。

参考解读:

ICCV 2019 | RankSRGAN:基于排序学习的生成对抗超分辨率重建方法

图像超分辨论文解读丨RankSRGAN

个人总结

第一篇论文采用嵌入块构建基本块,使用两支路的方式将低频和高频分开进行分别恢复,并使用反向级联的方式融合基本块的输出。

第二篇论文用HR图像估计模糊核,然后使用GAN生成模糊核池,并与前人不同的是,将同尺寸的低质HR图像作为CNN网络的输入,得到SR图像。

第三篇论文设计新的损失函数优化网络,使用HR图像的对象、背景核边界标签生成目标感知损失,强制网络学习细节信息。

第四篇论文是小波变换在超分的应用,作者创新地将低失真高感知图像和高感知低失真图像分别执行小波变换,提取其中地高感知和高保真信息,“强强联合”以生成高感知高质图像。