#每天一篇论文#(217/365)EDVR: Video Restoration with Enhanced Deformable Convolutional Networks

原文

EDVR:基于变卷积神经网络的视频重建

摘要

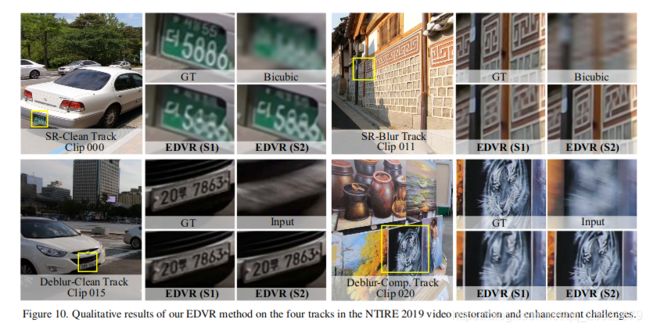

视频恢复任务,包括超分辨率、去模糊等,正引起计算机视觉界越来越多的关注。在NTIRE19挑战赛中发布了一个具有挑战性的基准名称DREDS。该方法从两个方面对现有方法提出了挑战:(1)如何在大运动情况下对齐多帧,以及(2)如何有效地融合不同运动和模糊的帧。在这项工作中,我们提出了一个新的视频恢复框架,称为edvr,以解决这些挑战。首先,为了处理大的运动,我们设计了一个金字塔,cascadind和可变形(pcd)对齐模块,其中帧对齐是在特征层用可变形卷积从粗到细的方式完成的。其次,我们提出了一个时间和空间注意力(tsa)融合模块,在该模块中,注意在时间和空间上都被应用,以强调后续恢复的重要特征。多亏了这些模块,我们的edvr在ntire19视频恢复和增强挑战中赢得了cham-pions,并在所有四首曲目中以较大的优势超过了第二名。edvr还显示出在视频超分辨率和去模糊方面优于最新提出的方法。

贡献

我们提出了一个统一的框架,称为虚拟现实,它可以扩展到各种视频恢复任务,包括超分辨率和去模糊。edvr的核心是(1)称为金字塔、级联和可变形卷积(pcd)的对准模块,和(2)称为时间和空间注意(tsa)的融合模块。

PCD模块受tdan[40]的启发,使用可变形卷积在特征级别将每个相邻帧与参考帧对齐。与tdan不同,我们以从粗到细的方式执行对齐,以处理大型和复杂的运动。具体地说,我们使用apyramid结构,该结构首先将较低尺度的特征与粗略估计对齐,然后将偏移量和对齐特征传播到较高尺度,以促进精确的运动补偿,类似于光流估计中采用的概念[7,9]。此外,为了进一步提高对齐的稳健性,我们在金字塔对齐操作后级联一个额外的可变形卷积,所提出的tsa是一个融合模块,它可以帮助聚合门信息跨越多个对齐特征。为了更好地考虑每一帧的视觉信息性,我们通过计算参考帧特征和相邻帧特征之间的元素相关性来引入时间注意。然后,相关系数在每个位置对每个相邻特征进行加权,表示重建参考图像的信息量很低,然后将所有帧的加权特征卷积并融合在一起。在融合时间注意力之后,我们进一步利用空间注意力对每个通道中的每个位置进行权重分配,以更有效地利用跨通道和空间信息。