多源遥感图像分割和目标检测中基于生成对抗网络的图像级域迁移的评价

Evaluating generative adversarial networks based image-level domain transfer for multi-source remote sensing image segmentation and object detection论文翻译

多源遥感图像分割和目标检测中基于生成对抗网络的图像级域迁移的评价

ABSTRACT:

遥感影像的外观和质量受到不同大气条件、传感器质量和辐射校准的影响。这极大地挑战了深度学习或其他机器学习模型的泛化能力:当应用于不同的目标数据集时,在源遥感数据集上预先训练的模型的性能会显著下降。流行的生成对抗网络(GANs)可以实现源和目标数据集之间的风格或外观迁移,通过生成与源样本相似的新目标图像来提高深度学习模型的性能。在本研究中,我们对基于卷积神经网络(CNN)的图像处理模型在一个数据集上训练,在另一个数据集上测试的基于GAN的图像级迁移方法的性能进行了综合评价。首先,我们设计了评价过程的框架。该框架主要由两部分组成,一是基于GAN的图像级域适应,将目标图像转换为与源图像空间概率分布相似的新图像;二是基于CNN的图像处理任务,用于测试基于GAN的域适应效果。其次,采用CycleGAN和AgGAN两种主流的GAN方法实现了领域适应。图像处理包括两个主要任务,分割和目标检测。前者和后者都是在广泛应用的U-Net和 Faster R-CNN基础上设计的。最后,三个实验,与三个数据集,旨在涵盖不同的应用情况下,检测情况改变时态数据收集来自同一场景,两个城市情况图片收集来自不同地区和two-sensor情况分别从空中和卫星平台获得图像。结果表明,在变化检测情况下,基于GAN的图像迁移可以显著提高分割模型的性能,但并没有超过传统方法;在另外两种情况下,基于GAN的方法得到的结果较差。在目标检测方面,几乎所有的方法都不能提高Faster R-CNN的性能,基于GAN的方法性能最差。

Introduction:

虽然深度学习在遥感图像处理中得到了广泛应用,如图像检索、土地覆被分类、目标检测。迁移能力(或称为泛化能力)受限的一个主要障碍是由于各种因素,如非均匀照明和大气条件下,传感器、质量和辐射校准影响定量遥感信息。与广泛收集大量的样品和昂贵的手工工作通常需要训练深卷积神经网络(CNN)相比,我们更期望的是CNN模型训练数据集(称为源领域数据集)可以直接应用到另一个数据集(称为目标领域数据集),避免单调乏味的过程的注释和重复训练。目标和源域数据集之间的差异可以概念化为两个域数据集的概率分布之间的差距。一种通过扩展训练数据的分布来提高模型泛化能力的解决方案;另一种解决方案是将目标域分布和源域分布之间的差距缩小到最小。

数据增加属于第一个解决方案。数据扩增通过增加从原始数据中模拟得到的数据,扩展了样本空间。基本的数据增强是通过图像操作来实现的,如旋转、平移、裁剪、翻转和添加噪声。Inoue 提出了一种样本配对方法。最近的一种混淆方法通过结合先验知识扩展了样本分布。AutoAugment 在自动搜索中执行数据增强。生成的对抗网络

(GAN) 可以产生新的各种样本用于数据扩充。例如,BigGAN可以合成高保真的自然图像。但是,没有一种数据扩充方法可以无限地增加样本空间;因此,样本空间不能覆盖目标域数据的分布,特别是在遥感图像中,这些图像是由光子在不断变化的大气中长距离旅行而形成的。

领域适应属于第二种,分为两个层次:特征层次适应和图像层次适应。特征层次适应的目的是对齐从源域和目标域提取的特征的概率分布。Long和Wang将提取自cnn的深度特征的最大平均差异最小化。其他测量距离的方法包括Kullback-Leibler散度,Jensen-Shannon divergence Wasserstein distance。

图像级自适应试图对齐原始像素空间的分布。与特征级自适应相比,图像级自适应独立于特定的图像处理任务,具有更强的通用性。利用像素值的统计信息,如每个波段的均值和方差,构建一个参数函数,将源图像的颜色转换为目标图像的颜色。平方根分解,线性Monge-Kantorovitch 也属于参数变换,它可以提供更精确的迁移结果,但更加复杂。也有一些非参数方法。Yoo等人使用了一个直接记录整个映射范围的查找表来搜索源和目标图像中的原色。Pitie, Kokaram, and Dahyot(2005)提出了一种n维概率密度分布函数(PDF)色彩转移方法。Gatys, Ecker, and Bethge(2015)用CNN来转换艺术风格。然而,迁移的图像通常显示颜色失真。提出了真实感风格迁移的修复方法。Luan等人(2017)开发了一种将语义分割和现实正则化结合到(Gatys, Ecker, and Bethge 2015)研究中的方法来解决失真问题。Li et al.(2018)首先通过预先训练好的深度网络应用样式转换,然后进行平滑处理。Cycle-Consistent对抗的网络(CycleGAN) 设计了一种循环网络结构,保证源域和目标域之间的双向迁移。Attention-guided对抗网络 (AgGAN) 增加了一种基于CycleGAN的注意机制。

结果表明,数据扩增不可能将源遥感数据的样本空间扩大到覆盖不断变化的目标遥感数据的空间。虽然已有多种基于GAN的方法用于近景图像的风格转换,但在遥感图像域转换中缺乏基于gan的方法。据我们所知,将CycleGAN应用于遥感图像分割的工作只有一项,但测试数据非常有限,没有涉及到目标检测。

本文首先对近年来基于GAN的多源遥感图像传输方法以及后续用于分割和目标检测的模型传输方法的性能进行了全面的评价,并回答了当前的GANs是否优于传统的图像级域迁移方法。首先,实验旨在涵盖不同的情况下的遥感应用程序,包括一个变化检测情况时态数据收集来自同一场景,两个城市情况图片收集来自不同地区,和two-sensor情况分别从空中和卫星平台获得图像。据此,编制了包括WHU变化在内的三个具有代表性的数据集进行综合评价检测数据集由多时间航拍影像组成Inria数据集,包含来自多个城市的航拍图像由航空影像和相应的卫星影像组成的武汉数据集。其次,我们选择两种主流的遥感图像处理技术,即图像分割(像素级分类)和目标检测进行评价。这两种技术都是通过流行的基于cnn的学习方法实现的。对GANs迁移的目标图像分别采用分割模型和目标检测模型进行处理。比较了该模型与原始目标图像和传统图像迁移方法处理后的模型的性能。我们选择建筑物作为前景,是因为它不仅是遥感图像中具有代表性的目标,而且具有很好的分割和目标检测能力。

2. Methods:

在本节中,我们首先介绍了GANs的原理以及最近被广泛使用的两种GANs,即CycleGAN和AgGAN。在此基础上,设计了基于两种GANs的从多源遥感数据集建立分割和检测网络。并介绍了常用的比较方法。

2.1. Generative adversarial networks:

生成对抗网络(GAN)的核心思想来自博弈论中的纳什均衡。博弈双方的利益和损失之和始终为零,即利益空间是固定的。为了赢,两个游戏玩家在竞争中根据对手的行动改变他们的策略。当一方强于另一方时,游戏就会有赢家。当双方理想地没有任何错误地实现他们的最佳策略时,博弈达到纳什均衡。

生成对抗过程可以用数学的方法来描述。数据的真实分布是![]() 。将两个游戏者具体化为生成器(记为G)和判别器(记为D),其中G和D是两个模型,可以从简单的高斯函数变化到复杂的CNNs。具体来说,G和D是两个模型,可以从简单的高斯函数变化到复杂的CNNs。当G和D用神经网络实现时,称为GAN。生成器调整其参数

。将两个游戏者具体化为生成器(记为G)和判别器(记为D),其中G和D是两个模型,可以从简单的高斯函数变化到复杂的CNNs。具体来说,G和D是两个模型,可以从简单的高斯函数变化到复杂的CNNs。当G和D用神经网络实现时,称为GAN。生成器调整其参数![]() 使其分布

使其分布![]() 接近

接近![]() 。判别器D评估

。判别器D评估![]() 和

和![]() 之间的差异。利用交叉熵损失,生成对抗过程的目标函数为:

之间的差异。利用交叉熵损失,生成对抗过程的目标函数为:

生成器G的训练过程是最小化交叉熵V(G, D),而判别器D的训练过程是最大化对G生成的假样本的判别。即D与G对值函数V(G, D)有最小最大化对策,用L(G, D)表示:

2.2. CycleGAN:

CycleGAN是近年来在图像翻译中发展起来的一种常的GAN结构。它利用两个对称的GANs组成的环状网络,实现两个未配对的图像集之间的相互映射,如图1(a)所示两个发生器G和G '是可逆的,每个发生器都有对应的判别器D和D '。G试图将图像从X域转换到Y'域接近Y域。G'是相反的。如图1(b)所示,CycleGAN添加循环一致性损失Lcyc以促进G’(G(x))≈x,G(G ' (y))≈y:

式中,x为X域中的图像,y为Y域中的图像。CycleGAN的损失函数为:

CycleGAN的生成器是通过ResNet或U-net实现的。ResNet发生器由编码器、转换器和解码器三部分组成。编码器由一系列具有快捷方式和跳连接的卷积块组成。转换器由6或9个残差块组成。解码器用于反卷积。最后一层,即输出层,生成一个模拟图像。ResNet结构的生成器如图1(c)所示。U-Net结构的生成器如图1(d)所示。它具有步长为2的用于卷积的编码器和用于反卷积的解码器。同样大小的编码器和解码器层之间也有跳连接。

受pip2pix的启发,CycleGAN设计了PatchGAN 判别器。它确定的是图像中的一小块,比如一个70×70的区域,而不是整个图像。

2.3. AgGAN:

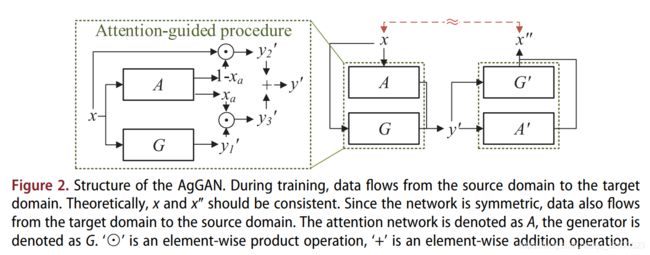

在接下来的目标检测或分割的图像翻译任务中,期望在不破坏其他部分(背景)的情况下,对感兴趣的区域(称为前景)进行更好的翻译。为了实现这一点,AgGAN在CycleGAN上增加了一个注意机制。注意网络针对源图像和目标图像中最容易识别的区域生成识别图,判别器考虑该区域以指导生成过程。

AgGAN和CycleGAN在结构上相似。AgGAN的总体结构如图2所示。AgGAN生成图像的过程包括三个步骤。首先,源域的输入图像进入注意网络A(图2),计算注意图Xa。其次,将源域内的图像在生成器G的目标域中转换为图像![]() ,并且AgGAN在Xa和

,并且AgGAN在Xa和![]() 之间执行一个element-wise的乘积(记为⊙)获取前景唯一图像

之间执行一个element-wise的乘积(记为⊙)获取前景唯一图像![]() 。第三,执行源域图像和反转注意图(1- Xa)的内积从而得到仅背景图像

。第三,执行源域图像和反转注意图(1- Xa)的内积从而得到仅背景图像![]() ,

,![]() 和

和![]() 逐像素添加得到最终生成的图像y'。在判别的过程中,AgGAN只关注前景。AgGAN中的判别器结构与PatchGAN中的CycleGAN相一致。AgGAN中的注意力网络结构采用最近邻上采样的方法来恢复图像的大小。网络的最后一层使用sigmoid激活来改变像素值为1(前景)或0

逐像素添加得到最终生成的图像y'。在判别的过程中,AgGAN只关注前景。AgGAN中的判别器结构与PatchGAN中的CycleGAN相一致。AgGAN中的注意力网络结构采用最近邻上采样的方法来恢复图像的大小。网络的最后一层使用sigmoid激活来改变像素值为1(前景)或0

(背景)。

2.4. GAN-based transfer for building segmentation and detection:

由于建筑物在分割和检测中都是具有代表性的土地覆盖对象,因此我们对建筑物分割和检测中的图像级域适应方法进行了评价。语义分割过程为输入图像的每个像素分配一个二值标签,检测过程识别带有矩形边框的构建实例。

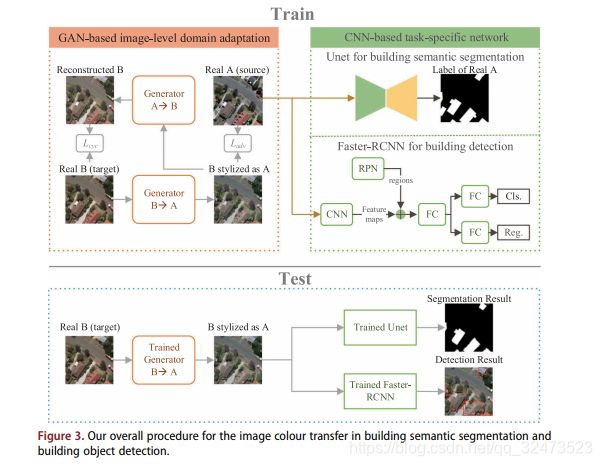

我们在建筑分割和建筑检测领域适应的总体框架如图3所示。该框架将图像级域自适应过程与目标网络解耦,即域自适应阶段和分割/目标检测阶段,从而可以在不需要对整个网络进行重新训练的情况下轻松切换域传输方法或具体任务。

训练过程分为两个阶段,第一阶段是通过CycleGAN或AgGAN实现的图像级域自适应(第2.1节)。图像级域适应有效地编码视觉线索,如外观、形状和上下文,与特征级域适应相比,图像级域适应不容易受到复杂的高维特征的影响。我们分别使用目标域图像和源域图像训练CycleGAN和AgGAN。在训练过程中,目标域分布逐渐映射到源域分布。最后,通过训练好的CycleGAN和AgGAN,将目标图像转换为源格式图像。通过对齐目标域和源域之间的边缘分布,减少了目标域和源域之间分布的间隙。实验中使用的CycleGAN和AgGAN模型可以被其他先进的图像级域自适应方法所替代。

第二阶段利用带有可用标签的源域图像训练基于cnn的网络。分段网络采用U-net实现(Ronneberger, Fischer, and Brox 2015),广泛应用于语义分割。对于建筑检测任务,我们使用了著名的Faster-RCNN (Ren et al. 2015)作为建筑检测模型,它是目标检测任务中的基线网络。

在预测中,利用预训练的GANs将目标域图像转换为源风格化图像,输入到预训练的模型中,输出分割映射或目标的边界盒。通过与原始目标图像输入结果的比较,评价了该算法在泛化能力方面的改进基于gan的图像级域适应方法,用于分割和目标检测。

2.5. Method comparison:

我们比较带有三个经典色彩迁移基于GAN的方法,即:1)基于Wallis过滤器的颜色一致性方法,这是广泛应用于遥感领域消除不同图像之间的颜色或亮度的差异,2)线性Monge-Kantorovitch (LMK)解决方案,3)迭代分布传输(IDT)算法。

未完,待续。。。。。。