半监督学习近几年论文解读(分割)

分割部分半监督(更新中.....)

一.PseudoSeg: Designing Pseudo Labels for Semantic Segmentation(ICLR2021)

论文地址:https://arxiv.org/abs/2010.09713

Code:https://github.com/googleinterns/wss

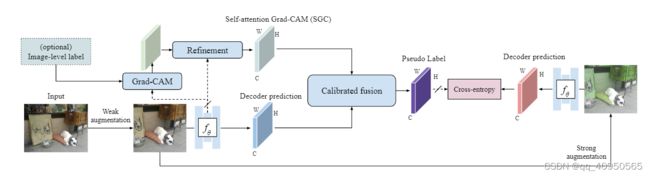

他们对输入的图像X做两次不同的数据增强,一种“弱增强”(random crop/resize/flip),一种“强增强”(color jittering)。他们将两个增强后图像输入同一个网络f(θ),得到两个不同的输出。因为“弱增强”下训练更加稳定,他们用“弱增强”后的图像作为target。

下面是具体流程图

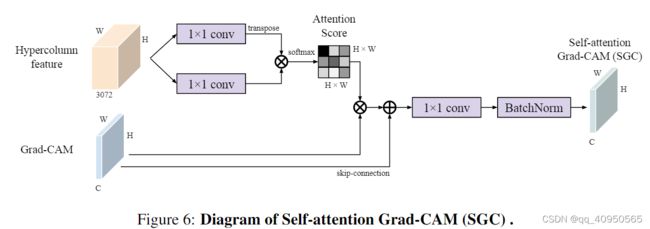

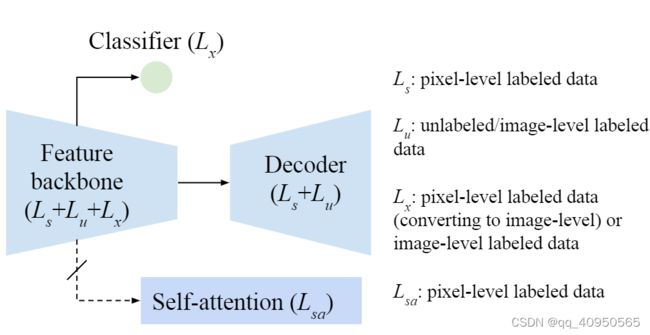

原文图6所示为self-attention Grad-CAM模块的示意图,方程(3)所示为SGC的数学表达方程。先从Backbone网络的最后两层feature maps拼接而来的Hypercolumn feature开始,分别用两个11卷积对每个区域上的CAM score线性变换,这一操作可以看做核函数思想中先做维度变换再进行相似度求解的操作,两个11卷积分别对应(3)中的Wk和Wv。之后通过矩阵相乘求得Grad-CAM各个区域之间的相似度,经过softmax后得到attention加权系数,再将Grad-CAM处理为HWC的flatten 2D map,利用self-attention weights对各个区域上的CAM score进行propagation得到新的一系列refined CAM scores。这里一个细节是,进行CAM propagation时借用了skip connection的思想,使用跳跃连接避免attention的过度纠正;

二.Guided Collaborative Training for Pixel-wise Semi-Supervised Learning(ECCV2020)

二.Guided Collaborative Training for Pixel-wise Semi-Supervised Learning(ECCV2020)

论文地址:https://arxiv.org/abs/2008.05258

Code:https://github.com/ZHKKKe/PixelSSL

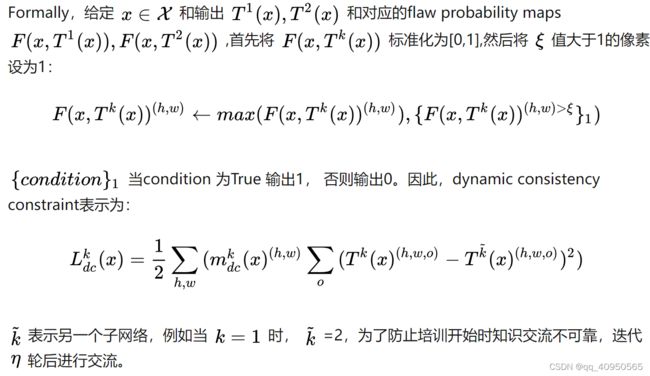

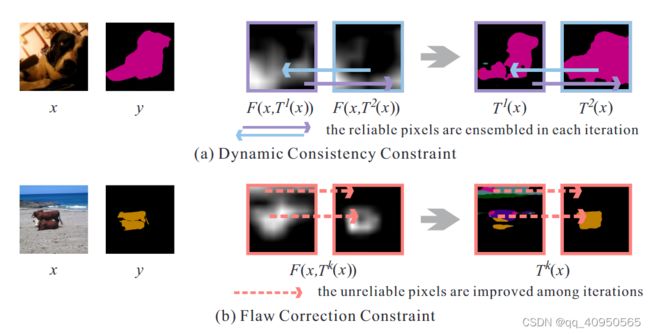

Dynamic Consistency Constraint

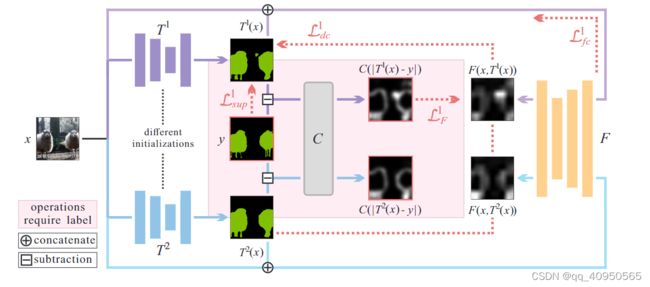

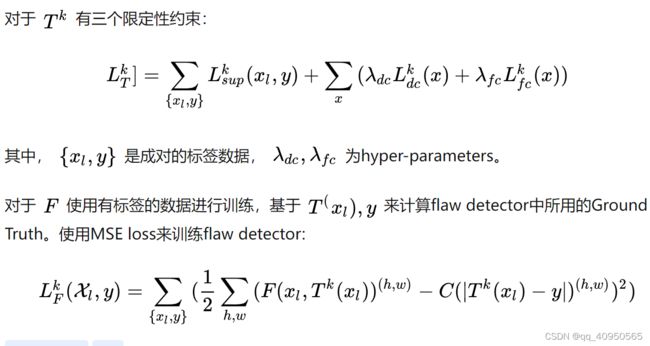

由于对 x 进行不同的扰动, 造成T1(x),T2(x) 的输出不同,本文中使用![]() 对两个子网络进行限制。与其他的一致性不同,

对两个子网络进行限制。与其他的一致性不同,![]() 是双向的。如下图所示。直观上说,如果T1(x) 有low flaw probability,将其作为T2(x) 的伪标签,反之亦然。为了确定伪标签的质量,引入了flaw 阈值 ,经过上述过程,在模型内部形成了知识交互

是双向的。如下图所示。直观上说,如果T1(x) 有low flaw probability,将其作为T2(x) 的伪标签,反之亦然。为了确定伪标签的质量,引入了flaw 阈值 ,经过上述过程,在模型内部形成了知识交互

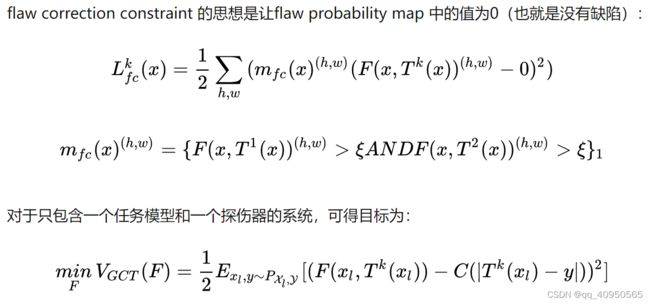

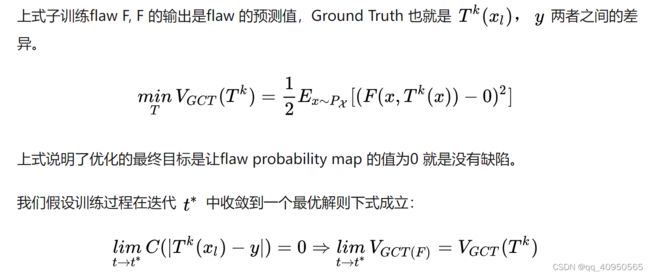

Flaw Correction Constraint

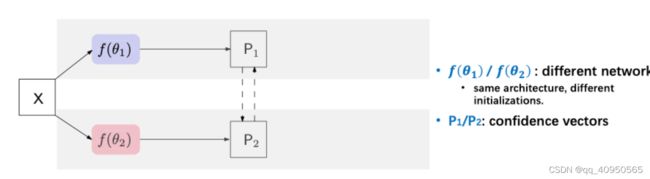

本文的思想就是将相同的输入,输入到不同的两个网络中(结构不同,初始化方式不同)利用Consistency learning的思想,约束两个输出是相似的

三.ClassMix: Segmentation-Based Data Augmentation for Semi-Supervised

Learning(WACV2021)

论文地址:https://arxiv.org/abs/2007.07936

Code:https://github.com/WilhelmT/ClassMix

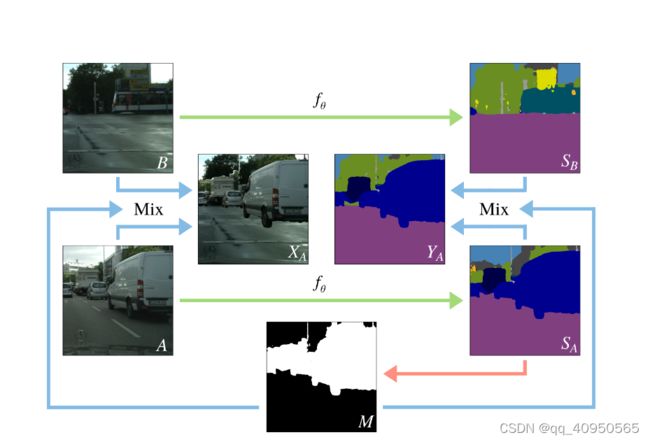

所提出的方法通过使用一种新的数据增强技术--ClassMix来进行半监督的半分类,该技术使用数据集中未标记的样本来合成新的图像和相应的人工标签("人工标签 "在这里指的是在增强锚定设置中用于训练增强图像的目标)。ClassMix使用两张没有标签的图像作为输入,并输出一张新的增强图像,以及相应的人工标签。这个增强的输出是由输入的混合组成的,其中一个图像的一半语义类别被贴在另一个图像上,从而产生了一个新颖多样的输出,但仍然与数据集中的其他图像相当相似。图1说明了ClassMix工作的本质。两张没有标签的图像,A和B,从数据集中取样。两张图片都被送入分割网络fθ,该网络输出预测值SA和SB。一个二进制掩码M是通过随机选择存在于argmaxed预测SA中的一半类别,并将这些类别中的像素设置为M中的值1,而所有其他像素的值为0来生成的。然后,这个掩码被用来将图像A和B混合到增强的图像XA中,该图像将包含掩码为1的A的像素和其他地方的B的像素。同样的混合也被用于预测SA和SB,从而产生了人工标签YA。由于混合策略的性质,可能会出现假象,但随着训练的进行,假象会越来越少,越来越小。此外,在不完善的标签下,一致性调节也倾向于产生良好的性能,这一点在我们强有力的结果中得到了进一步的证实

四.Semi-Supervised Semantic Segmentation with Cross Pseudo Supervision(CVPR2021)

论文地址:https://arxiv.org/abs/2106.01226

Code:https://github.com/charlesCXK/TorchSemiSeg

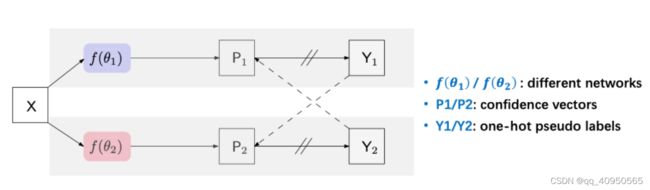

我们可以看到,CPS的设计非常的简洁。训练时,我们使用两个网络f(θ1) 和 f(θ2)。这样对于同一个输入图像X,我们可以有两个不同的输出P1和P2。我们通过argmax操作得到对应的one-hot标签Y1和Y2。类似于self-training中的操作,我们将这两个伪标签作为监督信号。举例来说,我们用Y2作为P1的监督,Y1作为P2的监督,并用cross entropy loss约束。

对于这两个网络,我们使用相同的结构,但是不同的初始化。我们用PyTorch框架中的kaiming_normal进行两次随机初始化,而没有对初始化的分布做特定的约束。当然了,如果设计特定的初始化,没准CPS的效果会更好~

在测试的时候,我们只使用其中一个网络进行inference,所以不增加任何测试/部署时候的开销。

五:Uncertainty-aware Self-ensembling Model for Semi-supervised 3D Left Atrium Segmentation (MICCAI2019)

论文:https://arxiv.org/abs/1907.07034

Code:https://github.com/yulequan/UA-MT

这里重点介绍教师模型的不确定性指导部分:

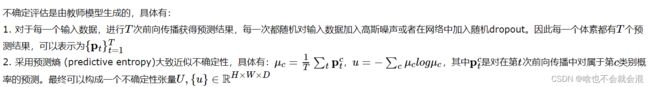

受贝叶斯网络中的不确定性估计的启发,使用 Monte Carlo Dropout 估计不确定性。

总结:这篇文章整合了Mean Teacher (NIPS2017) 和不确定性估计来进行半监督学习,通过不确定性图来指导(加权)Mean Teacher模型从未标注的数据上逐步学习。不确定性图的计算采用了经典的蒙特卡洛 Dropout多次推理来获得,这样会带来一些额外的计算开销,但带来了性能的提升,可以得到不错的效果,