【Python】Win10 Nvidia GPU 、tensorflow深度学习环境

文章目录

-

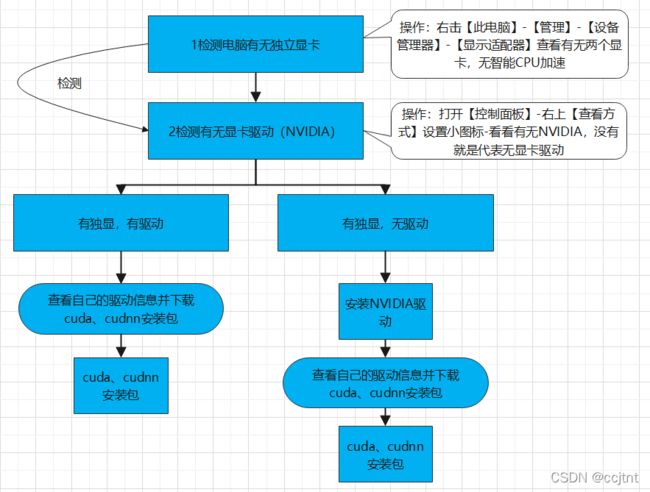

- 1流程步骤

- 2详细

-

- 1、查看有无独显

- 2、查看有无NAVIDIA驱动

-

- 2.1、有独显无驱动

- 2.2 、安装NAVIDIA显卡驱动

- 3、安装CUDA

-

- 3.1、查看cuda版本支持

- 3.2、下载对应显卡驱动版本的cuda

- 3.3、下载对应版本的cudnn

随着人工智能的发展,越来越多人都想往人工智能方向发展,可是人工智能环境配置对于小白来说非常发展恶心,之前我学习时也吃了不少亏,百度搜索各种操作指南参之不齐,很多都是直接了。这里我亲自操作(把俺电脑那些显卡驱动都删了重新演示一遍给小白)

1流程步骤

2详细

安装之前先说明一下几个概念:

1、显卡驱动、CUDA、cudnn之间的关系

显卡驱动:是封装成软件的程序,硬件厂商根据操作系统编写的配置文件。安装成功后成为了操作系统中的一小块代码,它是硬件所对应的软件,有了它,计算机就可以与显卡进行通信,驱使其工作。如果没有显卡驱动,显卡就无法工作。

cuda:其是由NVIDIA发明的并行计算平台以及编程模型,它可以显著的提高GPU的计算性能

cudnn:NVIDIA的cuDNN是针对深度神经网络计算的一个GPU加速库,为标准例程提供了高度优化的实现,比如向前、向后卷积,池化,规范化和激活层。其是NVIDIA Deep Learning SDK的一部分。

简而言之,显卡驱动让底层显卡硬件正常工作,CUDA的本质是一个使用显卡运算能力的工具包(ToolKit)。cuda既可以离线安装也可以在线安装,但离线安装的CUDA工具包会默认携带与之匹配的最新的驱动程序

显卡驱动与cuda的关系:NVIDIA的显卡驱动器与CUDA并不是一一对应的,CUDA本质上只是一个工具包而已,所以我可以在同一个设备上安装很多个不同版本的CUDA工具包,比如可以同时安装 CUDA 9.0、CUDA 9.2、CUDA 10.0三个版本。一般情况下,我只需要安装最新版本的显卡驱动,然后根据自己的选择选择不同CUDA工具包就可以了,但是由于使用离线的CUDA总是会捆绑CUDA和驱动程序,所以在使用多个CUDA的时候就不要选择离线安装的CUDA了,否则每次都会安装不同的显卡驱动,这不太好,我们直接安装一个最新版的显卡驱动,然后在线安装不同版本的CUDA即可。

CUDA、cuDNN的关系:CUDA与cuDNN也不是一一对应的。CUDA看作是一个工作台,上面配有很多工具,如锤子、螺丝刀等。cuDNN是基于CUDA的深度学习GPU加速库,有了它才能在GPU上完成深度学习的计算。它就相当于工作的工具,比如它就是个扳手。但是CUDA这个工作台买来的时候,并没有送扳手。想要在CUDA上运行深度神经网络,就要安装cuDNN,就像你想要拧个螺帽就要把扳手买回来。这样才能使GPU进行深度神经网络的工作,工作速度相较CPU快很多。

1、查看有无独显

2、查看有无NAVIDIA驱动

2.1、有独显无驱动

2.2 、安装NAVIDIA显卡驱动

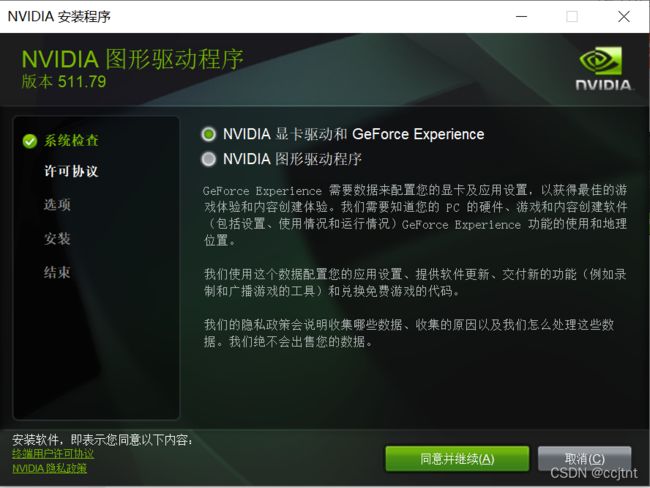

1双击已下好的先科驱动

2【同意并继续】

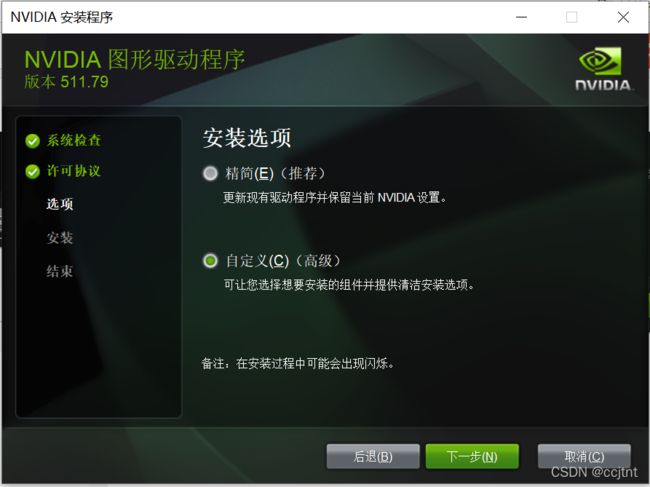

3这里默认是精简,这里选择自定义,【下一步】

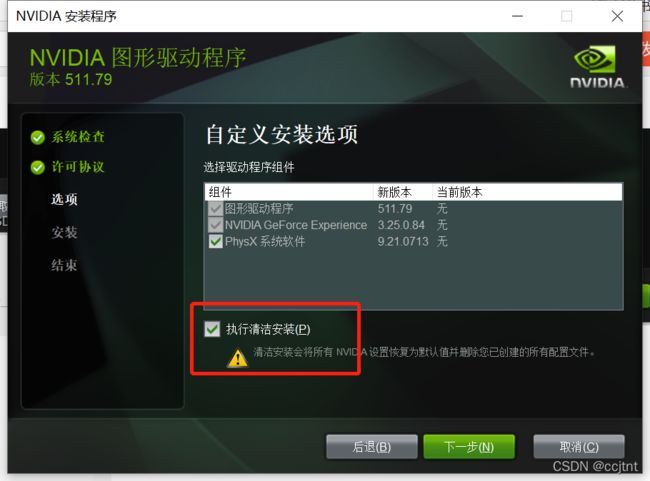

4勾选需要的组件,这里全部够了,注意一定要把圈红勾上,【下一步】

5【关闭】OK这里显卡驱动已完成

3、安装CUDA

3.1、查看cuda版本支持

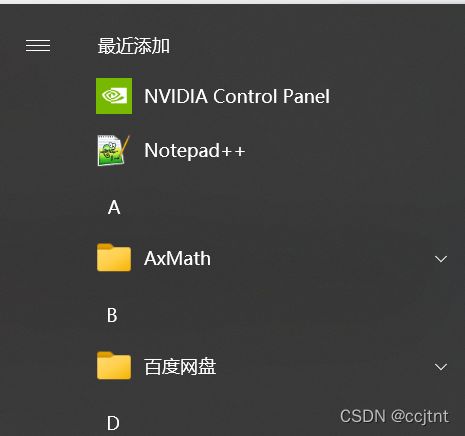

1打开【NVIDIA控制面板】

2左下角【系统信息】

3【组件】

3【组件】

即可查看显卡驱动支持的cuda版本,或者键盘【Win】+R -》 输入cmd -》进入命令行输入

nvidia-smi

上图进行解释

上图进行解释

第一栏的Fan:风扇转速,从0到100%之间变动,这个速度是计算机期望的风扇转速,实际情况下如果风扇堵转,可能打不到显示的转速。有的设备不会返回转速,因为它不依赖风扇冷却而是通过其他外设保持低温(比如实验室的服务器是常年放在空调房间里)。

第二栏的Temp:是温度,单位摄氏度。

第三栏的Perf:是性能状态,从P0到P12,P0表示最大性能,P12表示状态最小性能。

第四栏下方的Pwr:能耗。

第五栏的Bus-Id是涉及GPU总线的东西,domaindevice.function

第六栏的Disp.A是Display Active,表示GPU的显示是否初始化。

第五、第六栏下方的Memory Usage是显存使用率。

第七栏是浮动的GPU利用率。

第八栏上方是关于ECC的东西。

第八栏下方Compute M是计算模式。

3.2、下载对应显卡驱动版本的cuda

1如果不知道tensorflow对于的Python和cuda版本对应关系,可以查看这个tensorflow-python-cuda速查表

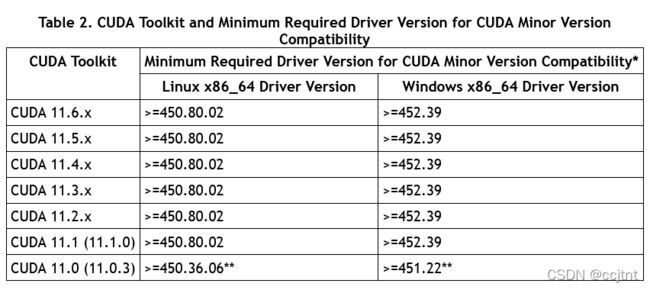

2如果cuda和电脑显卡驱动对应关系,可以参考-》https://docs.nvidia.com/cuda/cuda-toolkit-release-notes/index.html

3cuda下载官网:https://developer.nvidia.com/cuda-toolkit-archive

3.3、下载对应版本的cudnn

官网:https://developer.nvidia.com/rdp/cudnn-archive

这里需要注册登录,我们可以注册一个账号,由于我之前注册了

![]() #### 3.4、CUDA、cudnn安装

#### 3.4、CUDA、cudnn安装

1双击cuda,待检测完毕后,这里选择自定义【下一步】

- 精简:适合小白

- 自定义:不用说了

2 visual studio integration这一项没有勾选是因为我并没有使用VS环境【下一步】

2 visual studio integration这一项没有勾选是因为我并没有使用VS环境【下一步】

只需选择CUDA下面这4项就够了(默认是全选的。。。)这一步之后,会询问这些组件的安装路径,可以直接使用C盘的默认位置,当然我自定义了一下(请记住这些安装路径,后面配置环境变量需要用到)

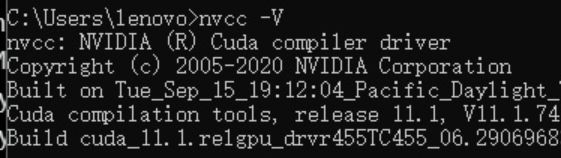

3查看cuda安装是否成功:

4安装cudnn

解压安装包

![]()

将该文件夹复制到cuda安装路径下:

5配置环境变量

在系统变量 PATH 的末尾添加:

%CUDA_LIB_PATH%;%CUDA_BIN_PATH%;%CUDA_SDK_LIB_PATH%;%CUDA_SDK_BIN_PATH%;

再添加如下4条(默认安装路径):

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v8.0\lib\x64;

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v8.0\bin;

C:\ProgramData\NVIDIA Corporation\CUDA Samples\v8.0\common\lib\x64;

C:\ProgramData\NVIDIA Corporation\CUDA Samples\v8.0\bin\win64;

如果你选用了自定义路径,上述这些默认路径都应该相应替换为你的自定义路径

这样环境已经搭建好了

接下来就是安装tensorflow那些包,可以参照下俩

至于其他,可以参考下面我两篇好的文章:

win0:

win10下CUDA和CUDNN的安装(超详细)

Win10系统下使用anaconda在虚拟环境下安装多版本CUDA及CUDNN

win11:

win11+tensorflow2.7+CUDA11.6+cuDNN8.3.2

Linux上配置可参考:

ubuntu18.04安装NVIDIA驱动,CUDA-9.0,CUDNN-7.05,tensorflow

这里提供一个包的离线下载:

tensorflow离线安装文件whl: