双边滤波(bilateral filter)以及联合双边滤波(joint bilateral filter)

文章目录

- 双边滤波

-

- 理论公式

- 代码(C++)

- 数学辅助理解

- 联合双边滤波(joint bilateral filter)

-

- 参考链接

双边滤波

自用备忘,若侵则删。

理论公式

利用二维高斯函数生成空间域核,一维高斯函数生成颜色域核。

- 空间域核:

其中, ( k , l ) (k,l) (k,l)为核中心坐标, ( i , j ) (i,j) (i,j)为核内邻域坐标。 σ d \sigma_d σd为高斯函数的标准差,我个人感性上认为就是 σ \sigma σ小的时候,高斯函数瘦瘦高高的,反之,矮矮胖胖的。

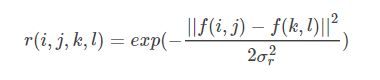

- 色彩域核(下式仅为灰度值的表示):

f ( i , j ) f(i,j) f(i,j)代表图像在 ( i , j ) (i,j) (i,j)处的灰度值,其他标识与空间域一致。

- 双边滤波器模板: 空间域核 色彩域核

- 思考一下,为什么可以保边?

虽然说在边缘处,空间域的权重很大,但是色彩变化大,这就导致了色彩域的权重很小,空间域的大权重优势被色彩域的小权重拉了下来,因此边界邻域的像素作用不大,保住了边缘自身。而对于平坦区域来说,色彩域的作用不大,几乎纯靠空间域核来撑,也就近似于普通的高斯滤波了。

代码(C++)

/*

双边滤波器思想:

1. 在高斯滤波器基础上增加了图像像素之间的相似度的考虑,进而达到保边的效果。

双边滤波器的实现:

1. 分别求空间域以及颜色域的权重系数

2. 根据双边公式,移动窗口,处理整张影像

*/

#include "opencv2/opencv.hpp"

#include"opencv2/highgui/highgui.hpp"

#include 数学辅助理解

- 一维高斯分布:

高斯函数的 σ \sigma σ设置越小则越窄。

σ \sigma σ太小的时候平滑效果不明显。

联合双边滤波(joint bilateral filter)

联合双边滤波相对于双边滤波来说,最大的特点就是引入了一幅引导影像。

具体可使用以下数学表达:

J p = 1 k p ∑ q ∈ Ω I q f ( ∥ p − q ∥ ) g ( ∥ I ~ p − I ~ q ∥ ) J_{p}=\frac{1}{k_{p}} \sum_{q \in \Omega} I_{q} f(\|p-q\|) g\left(\left\|\tilde{I}_{p}-\tilde{I}_{q}\right\|\right) Jp=kp1q∈Ω∑Iqf(∥p−q∥)g(∥∥∥I~p−I~q∥∥∥)

其中 I ~ p \tilde I_{p} I~p以及 I ~ q \tilde I_{q} I~q就是引导影像上的像素灰度值。

在opencv的contrib模块中,也提供了联合双边滤波的API:jointBilateralFilter(引导图,待滤波的图,滤波后的图,像素邻域直径,灰度域sigma,空间域sigma)。

简单的代码实现思路可以为将双边滤波中灰度域权重的计算过程进行修改,取引导影像上的灰度而非待处理影像的灰度,在此不赘述。至于opencv中API调用的代码则为:

#include 参考链接

https://blog.csdn.net/panda1234lee/article/details/52839205