单目标跟踪——常用数据集和指标

单目标跟踪常用的数据集有两个:OTB、VOT

两个数据集的评价指标不同。先大概介绍下两个数据集,再介绍评价指标。

一、数据集

1. OTB数据集

Online Object Tracking Benckmark

官网:Visual Tracker Benchmark

分为OTB50和OTB100,表示数据集里的视频数量分别为50个和100个(OTB100包括OTB50)

特点:

- 由25%的灰度数据和75%的彩色数据组成

- 涉及到11个属性:光照变化、尺度变化、遮挡、形变、运动模糊、快速运动、平面内旋转、平面外旋转、出视野、背景干扰、低像素

关于该数据集的两篇论文 :

Online Object Tracking:A Benchmark

Object Tracking Benchmark

链接: https://pan.baidu.com/s/18TnATmYtM_jESa8TNHgqKA

密码: 92nj

Online Object Tracking : A Benchmark 翻译

2. VOT数据集

Visual Object Tracking

数据集网址:VOT2021 Challenge |Dataset

数据集的使用:VOT Challenge| Setting up VOT workspace

特点:

- 都是彩色数据

- 从2013年开始,每年更新,部分年份会有重复

3. OTB与VOT的区别

- VOT没有灰度数据

- VOT标注更精细

- VOT分辨率普遍更高

- VOT从第一帧开始;OTB从随机帧开始,且矩形框初始化时加随机干扰

- VOT强调检测、跟踪不分离;OTB强调初始化的鲁棒性(从时间和空间上扰乱真实目标位置的初始状态)

- 评价指标不同

二、评价指标

1. OTB

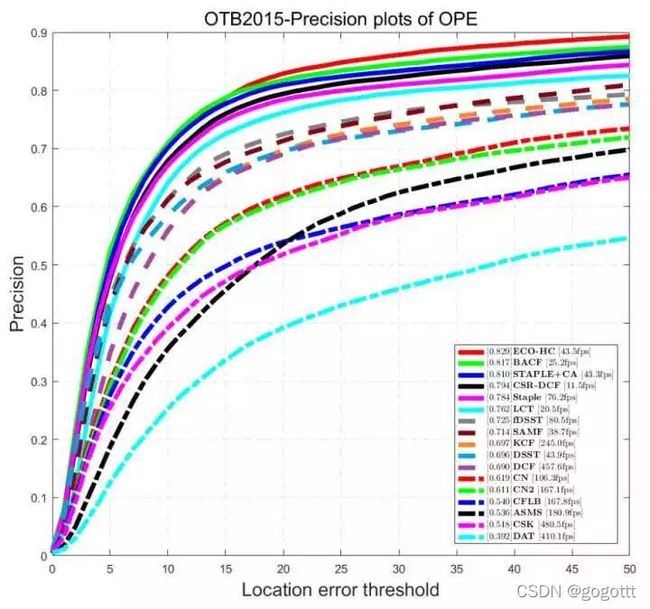

1) 精确度图 Precision Plot

精确度图反映:中心位置误差小于给定阈值的视频帧的百分比曲线。

中心位置误差:跟踪的中心位置(bounding box)和准确的中心位置(ground-truth)之间的平均欧氏距离。

横坐标:给定阈值

纵坐标:百分比

Precision:精度图中阈值为20时的值

APE(平均像素误差 Average Pixel Error):中心位置误差按帧取平均

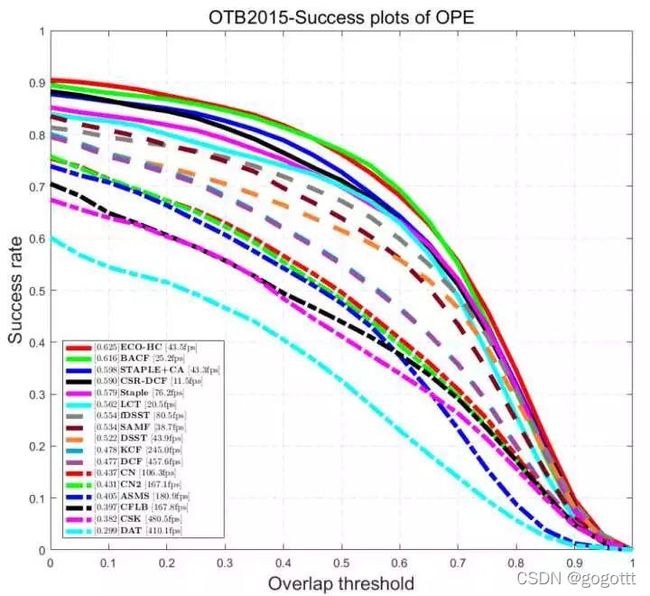

2) 成功率图 Success Plot

成功率图反映:边框重叠率大于给定阈值的视频帧的百分比曲线。

边界框的重叠率(Overlap Score,OS):S = |γt∩γa | / |γt∪γa |,γt为跟踪的边界框,γa为准确的边界框,| · |指区域内的像素点个数。即:重叠率=两个边界框交集内的像素点个数/两个边界框并集内的像素点个数。

横坐标:给定阈值

纵坐标:百分比

AUC:成功率图的曲线下面积

AOR(平均重叠率 Average Overlap Rate):边界框的重叠率按帧取平均

* Precision Plot和Success Plot都是从视频第一帧开始,且用ground-truth中目标的位置初始化。这种方法被称为OPE(One-Pass Evaluation)。 以下两种均为非OPE的评价方式。

3) 时间鲁棒性 Temporal Robustness Evaluation

将视频序列在时间轴上平均找出20个点作为起点,终点还是原来的最后一帧。以ground-truth作为初始化位置。通过对20段视频序列运行算法,绘制平均的精确度图或成功率图。

TRE score:以上结果的平均值

4) 空间鲁棒性 Spatial Robustness Evaluation

从第一帧开始,以真实位置稍作偏移作为初始化位置,测试12段(8个方向,4个尺度),绘制平均的精确度图或成功率图。

SRE score:以上结果的平均值

2.VOT

1) 准确率 Accuracy

在单个测试序列下的平均重叠率(即AOR),只考虑有效帧,即跟踪成功的帧。

2) 鲁棒性 Robustness

在单个测试序列下的跟踪失败的次数。重叠率为0即为跟踪失败。跟丢后序列中止,5帧后重启。

3) 等效滤波操作 Equivalent Filter Operations

用于衡量跟踪速度。为减少硬件平台和编程语言等外在因素对跟踪速度的影响,先测量在一个600*600的灰度图像上用30*30最大值滤波器进行滤波的时间,作为基准单位,再以这个基准单位衡量跟踪的速度。

EFO:speed = 跟踪算法耗时/滤波时间

4) 平均重叠期望图

反映序列长度与平均准确率的关系,同时考虑准确率和鲁棒性。将所有序列按长度分类,相同长度的序列测得的准确率取平均。以长度为横坐标,平均准确率为纵坐标绘图。

EAO(平均重叠期望 Expected Average Overlap):不同长度序列求得的准确率平均值再取平均

三、总结

VOT普遍质量较高,如果只能选一个数据集,建议VOT。

如果选OTB,不同算法间比较AUC、SPEED(fps)

如果选VOT,不同算法间比较EAO、A、R、EFO