T-PAMI-2021论文Semi-Supervised Multi-View Deep Discriminant Representation Learning阅读笔记

提示:文

0.论文信息

题目:Semi-Supervised Multi-View Deep Discriminant Representation Learning

期刊: IEEE Transactions on Pattern Analysis and Machine Intelligence (T-PAMI)

链接1:Semi-Supervised Multi-View Deep Discriminant Representation Learning | IEEE Journals & Magazine | IEEE Xplore

链接2:http://www.hezhenyu.cn/papers/paper_files/XiaodongJia2020_Semi-supervised_Multi-View_DeepDidcriminantRepresentationLearning.pdf

关键字:多视图学习、多视图表示学习、孪生网络(Siamese Network)、对抗学习(Adversarial Training)、一致性(Consensus)、互补性(Complementarity)、半监督学习、密度峰值聚类(Density Peak Clustering)。

1. Introduction

多视图学习及多视图表示学习的研究意义,重要性与必要性,这部分介绍省略……

1.1多视图数据的基本特性

T-PAMI这样的期刊愿意接收通用的方法。要想提出通用的方法,就不能仅仅是改进某一种已有的方法,而是需要从数据的本质出发提出新的方法。因此这一部分先介绍多视图数据的基本特性。

多视图数据有两个优势和一个劣势。两个优势是多视图数据具有一致性Consensus和互补性Complementarity。劣势是多视图数据中存在冗余。

1.1.1多视图数据的两个优势——一致性和互补性。

首先说多视图数据的一致性。由于多视图数据不同视图之间存在天然的对应关系(Pairwise Information),且对于一条多视图Sample来说,多个视图描述的是同一个Object,因此多视图数据中存在一致性。这个一致性可以从分类器和信息两个角度去理解。从分类器的角度来说,由于多个视图描述的是同一个Object,一个Object只能够属于一个类别,因此如果从多个视图学习到多个分类器,那么对于同一条多视图样本来说,不同分类器给出的分类结果应该是一致的。从特征、表示、信息的角度来说,从不同视图中学习到的特征或者信息有一部分是共享的、相同的,或者说是语义关联的(本论文中称为Shared)。

其次,多视图数据还存在互补性。互补性也可以从分类器和特征(信息)的角度来解释。从分类器的角度来看,假如现在有100个多视图样本,从第一个视图中学习到的分类器可以对前80个样本正确分类,后20个样本错误分类;从第二个视图中学习到的分类器可以对后80个样本正确分类,前20个样本错误分类。那么这两个分类器能够同时分对的中间的60个样本是Shared样本,第一个分类器的前20个样本和第二个分类器的后20个样本体现了视图之间的互补性。从信息的角度来看,每个视图中除了一些和其他视图共享的信息之外,还存在一些信息是这个视图所独有的、其他视图没有的信息(也正是这些信息使得从这个视图学习到的分类器可以分对一些从其他视图所学到的分类器无法分对的样本),这个信息被称为互补信息或者Specific信息。

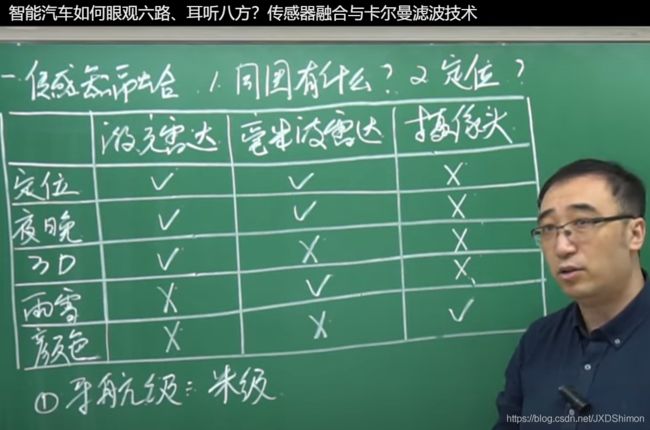

另外讲一句,互补性也是多视图、多模态能够work的主要原因。例如在自动驾驶中:激光雷达、毫米波雷达可以获取车辆定位信息、周围场景的3D信息,但是这些雷达无法区分颜色,碰到红绿灯就傻眼了。而摄像头虽然无法获取准确的3D信息,但能够区分颜色,能够识别红绿灯,补充了雷达的不足,这就是互补性。再比如,在雨雪天气下,激光雷达就不太好使了,而毫米波雷达不惧雨雪。在夜晚或者低光照的情况下,摄像头基本无法工作,而雷达可以照常工作,这也是互补性(图像截取自李永乐老师的视频:传感器融合与卡尔曼滤波技术)。

1.1.2多视图数据的劣势——冗余

由于视图之间存在Shared信息(实际上,视图之间大部分信息是Shared的,因为在实际中很难找到完全互补的视图,视图与视图之间大概率是语义相关的),因此多视图数据中存在冗余。信息冗余是多视图数据的劣势,冗余会给分类器带来负面影响,不然的话,就不会有那么多去冗余和降维的方法了。

了解了多视图数据的基本特性之后,我们看一下现有多视图表示学习领域的主流做法。

1.2现有多视图表示学习方法Taxonomy

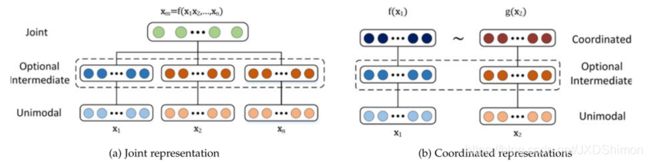

主流的多视图表示学习综述(TPAMI-2019综述:Multimodal Machine Learning: A Survey and Taxonomy,TKDE-2019综述:A Survey of Multi-View Representation Learning)将现有的多视图表示学习方法分为两大类:Joint方法与Alignment方法。Joint方法直接将不同的视图Concatenate到一起,这种方式简洁、粗暴,虽然无脑地将不同的视图的特征连接到一起没有什么物理意义,语义上也无法解释,但一般情况下效果还不错。Alignment方法将不同的视图映射到同一个语义空间,然后在这个空间中对不同视图的数据进行语义对齐,并最大化不同视图语义表示之间的Agreement。

结合多视图数据的基本特性,Joint方法利用了多视图数据的互补性(虽然用得不怎么样),但忽视了多视图数据的一致性和冗余。Alignment方法利用了多视图数据的一致性,但是在最大化View之间Agreement的过程中,每个视图的互补信息、Specific信息会被丢掉(因为这些独有的信息无法被Align,对最大化Agreement做负功),因此Alignment方法无法有效利用多视图数据的互补性。

那么有没有可以同时利用这两种特性的方法呢?的确有一些方法考虑到了,但是这类方法处于萌芽阶段,还不太成熟,例如T-PAMI-2017的论文Sharable and Individual Multi-view Metric Learning、Restricted Deep Belief Networks for Multi-view Learning。这些方法尝试将每个视图中的Shared信息和Specific分解开,然后再融合成为一个统一的表示。但这些方法的主要问题在于,虽然它们在尝试将Shared信息与Specific分解开,但是没有注意在不加任何约束或者损失的情况下,每个视图的Shared信息与Specific信息是不会自动分解开的。这就会造成从每个视图中抽取出的Shared信息和Specific信息互相污染,无法真正地将二者分开,进而损害多视图表示学习的性能。

1.3动机

综上所述,本文的动机就很明显了:本文旨在提出一种能够同时利用多视图数据一致性和互补性,并能有效降低多视图数据冗余的多视图表示学习方法。

1.4贡献

- 基于现有主流的多视图表示学习Taxonomy,本文提出了一种新的多视图表示学习Taxonomy。

- 本文通过加约束解决了现有Shared and Specific表示学习方法中的问题提出了一种较为成熟的Shared and Specific多视图表示学习方法。

- 通过将Siamese Network与Density Clustering结合,本文提出了一种新的标记扩散方法来实现半监督学习。

2.Proposed Approach

2.1Shared and Specific Multi-view Representation Learning Framework

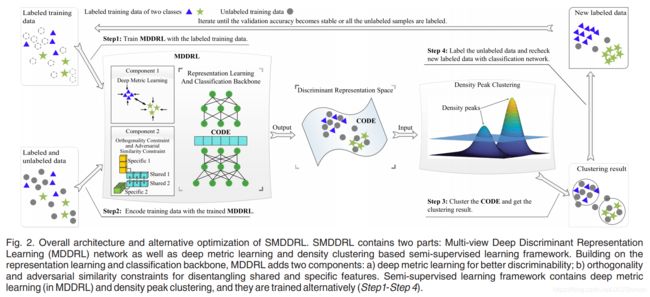

不同于传统的Joint方法或Alignment方法,对每一个视图只用一个特征学习网络,本文所提的方法对每个视图使用两个网络来分别提取Shared特征和Specific特征(下图中间一部分)。

为了将从每个视图得到的Shared特征和Specific特征分离开来,本文引入正交约束(Orthogonality Constraint,中间部分的红线),使得Shared特征和Specific特征正交。

关于Alignment,本文使用了对抗相似损失(Adversarial Similarity Constraint,图中右半部分)来将从不同视图学习到的Shared特征进行对齐。

为了提升所学表示的鉴别能力,本文引入了Deep Metric Learning,并用孪生网络Siamese Network实现(图中左半部分)。另外,为了加速Siamese Network的收敛,本文将样本均值引入到Siamese Network中。

2.2半监督学习方法

2.2.1动机

本文使用了Deep Metric Learning,并用Siamese Network实现。Siamese Network,或者说是Deep Metric Learning,也或者是Metric Learning,这些模型损失函数的目标就是将同一类别的样本拉近,把属于不同类的样本推开。因此当原始数据经过Siamese Network编码之后,可以使得类别之间的Decision Boundary变得更加清晰。而Decision Boundary变得清晰正是聚类方法所希望的。

因此本文拟将Siamese Network与密度峰值聚类结合起来进行标记传播。关于为什么使用密度峰值聚类,文中解释道:密度峰值聚类时间复杂度较低,且能够发现任意形状的Cluster。

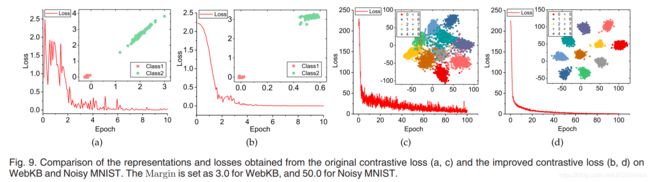

本文还给出了一个在WebKB上的实验验证:

2.2.2方法

半监督标记扩散的具体流程如下:

第一步,用有标记数据学习一个Siamese Network和分类网络。

第二步,用学习到的Siamese Network将有标记数据和无标记数据编码到同一个空间。

第三步,使用密度聚类方法对上一步得到的编码进行聚类。

第四步,用聚类结果对无标签数据打标,并用第一步学到的分类网络对新打标的数据进行检查,只保留聚类结果标签与分类标签一致的新打标样本。

在本文中Siamese Network与密度峰值聚类相辅相成、互相帮助。具体来说,Siamese Network能够使得聚类空间的Decision Boundary更加清晰,这有利于密度峰值聚类;反过来,密度聚类可以为Siamese Network提供更多的有标签样本,有利于Siamese Network学习到更好的表示空间。

3.Experiments

本文的几个实验:

- 与State-of-the-art方法对比,验证所提出方法的有效性

- 多视图网页分类对比(WebKB、AD)

- 多视图图像分类对比(NUS-Object、Noisy MNIST)

- 多视图文本分类对比(BBC、Reuters)

- Metric:Accuracy、F1-score

- 数据集和一些对比方法都给出了下载链接

- 验证并解释在Siamese Network中引入均值的有效性

- 验证了引入均值能够加速Siamese Network的收敛

-

- 用间隔理论解释了原因,引入均值可以优化间隔分布。

- Ablation Study

- 验证了不同模块对性能提升的贡献。

- 对比不同Alignment策略的有效性与时间消耗

- 由于其他Alignment策略如Dot product、余弦相似度等需要进行两两视图之间的约束,其时间复杂度随着视图个数的增加迅速增加。而对抗相似损失的时间复杂度与视图的个数无关,因此对抗相似损失在视图较多的情况下有优势。

- 对比了不同半监督策略的有效性

- 本文提出的方法和一些方法效果持平。

- 参数分析实验与收敛性分析实验

- 常规操作。

4. Conclusion and Future Work

Conclusion和贡献差不多,重点翻译一下Future Work:

- 在Multi-view Representation Learning中,引入Theory of Minds,然后实现View之间的Communication。

- 尝试对多视图数据中的噪声建模以解决multi-view learning中的non-realizable case。

5.参考资料

本论文IEEE版:Semi-Supervised Multi-View Deep Discriminant Representation Learning | IEEE Journals & Magazine | IEEE Xplore

本论文可直接下载的PDF:http://www.hezhenyu.cn/papers/paper_files/XiaodongJia2020_Semi-supervised_Multi-View_DeepDidcriminantRepresentationLearning.pdf

CSDN中关于本论文的另一个阅读笔记(比较详细):

【论文笔记】半监督的多视图学习:Semi-supervised Multi-view Deep Discriminant Representation Learning_喜欢什么的只是说说而已的博客-CSDN博客

章写完后,目录可以自动生成,如何生成可参考右边