YOLOv7——训练自己的数据集

论文地址:https://arxiv.org/abs/2207.02696

源码地址:https://github.com/WongKinYiu/yolov7

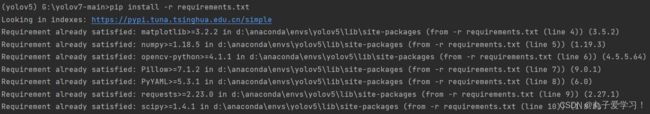

下载好代码包,解压后配置环境,在终端直接下载requirements.txt的代码就好

(本人环境:torch 1.8.0,当然有一些tensorboard、wandb等工具包需要自己下载啦~)

pip install -r requirements.txtwandb安装教程看这个:wandb使用_ai-ai360的博客-CSDN博客_wandb使用

输入后就是以下情况(我的环境名称叫做yolov5,这个忽视掉....)

一、数据集准备

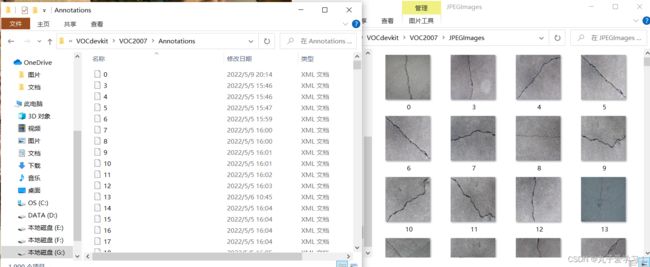

本人数据集是自己标注的VOC格式的建筑裂缝目标检测数据集,以此为例。

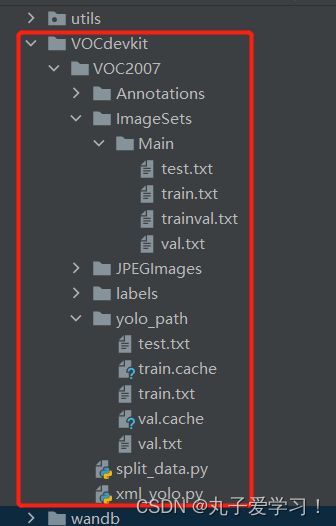

(✔文件中的内容需要自己提前准备好的, ImageSets - Main、labels、yolo_path是需要自己创建的空文件夹,文件里的内容后续代码生成。)

文件分别为:✔Annotations(.xml格式标注标签)

ImageSets - Main(存放训练集、测试集等划分.txt格式文件)

✔JPEGImages(.jpg格式图像)

labels(转化为yolo可使用的.txt格式标注标签)

yolo_path(训练集、测试集等.txt格式路径)

划分数据集(split_data.py)

split_data.py是用来划分训练集、验证集的代码,需要放在和Annotations、ImageSets的同级目录下,运行后生成的 ImageSets - Main下的test.txt、train.txt等内容。(就是抽取的图像的名称而已,我是按照0-1899的数字命名的,所以就是这些数字)

split_data.py

# coding:utf-8

import os

import random

import argparse

parser = argparse.ArgumentParser()

parser.add_argument('--xml_path', default='Annotations', type=str, help='input xml label path')

parser.add_argument('--txt_path', default='ImageSets/Main', type=str, help='output txt label path')

opt = parser.parse_args()

trainval_percent = 0.9 # 训练集和验证集所占比例

train_percent = 0.9 # 训练集所占比例

xmlfilepath = opt.xml_path

txtsavepath = opt.txt_path

total_xml = os.listdir(xmlfilepath)

if not os.path.exists(txtsavepath):

os.makedirs(txtsavepath)

num = len(total_xml)

list_index = range(num)

tv = int(num * trainval_percent)

tr = int(tv * train_percent)

trainval = random.sample(list_index, tv)

train = random.sample(trainval, tr)

file_trainval = open(txtsavepath + '/trainval.txt', 'w')

file_test = open(txtsavepath + '/test.txt', 'w')

file_train = open(txtsavepath + '/train.txt', 'w')

file_val = open(txtsavepath + '/val.txt', 'w')

for i in list_index:

name = total_xml[i][:-4] + '\n'

if i in trainval:

file_trainval.write(name)

if i in train:

file_train.write(name)

else:

file_val.write(name)

else:

file_test.write(name)

file_trainval.close()

file_train.close()

file_val.close()

file_test.close()

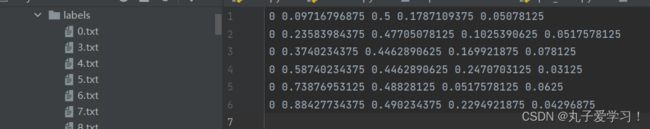

生成labels标签和图像路径(xml_yolo.py)

xml_yolo.py是用来生成labels标签和yolo图像路径的

labels下是每个图像标注的内容(0是我只有裂缝一个类别,后面四个是坐标)

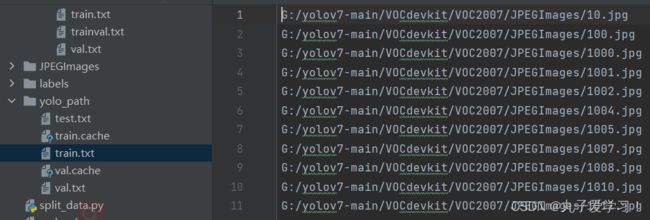

yolo_path下面是各个训练集、测试集图像对应的全局路径

xml_yolo.py

其中27、28、57、58、59、61、62、64、66要根据自己的全局路径改一下(注意/和\)

# -*- coding: utf-8 -*-

import xml.etree.ElementTree as ET

import os

from os import getcwd

sets = ['train', 'val', 'test']

classes = ["crack"]

abs_path = os.getcwd()

print(abs_path)

def convert(size, box):

dw = 1. / (size[0])

dh = 1. / (size[1])

x = (box[0] + box[1]) / 2.0 - 1

y = (box[2] + box[3]) / 2.0 - 1

w = box[1] - box[0]

h = box[3] - box[2]

x = x * dw

w = w * dw

y = y * dh

h = h * dh

return x, y, w, h

def convert_annotation(image_id):

in_file = open('G:/yolov7-main/VOCdevkit/VOC2007/Annotations/%s.xml' % (image_id), encoding='UTF-8')

out_file = open('G:/yolov7-main/VOCdevkit/VOC2007/labels/%s.txt' % (image_id), 'w')

tree = ET.parse(in_file)

root = tree.getroot()

size = root.find('size')

w = int(size.find('width').text)

h = int(size.find('height').text)

for obj in root.iter('object'):

difficult = obj.find('difficult').text

# difficult = obj.find('Difficult').text

cls = obj.find('name').text

if cls not in classes or int(difficult) == 1:

continue

cls_id = classes.index(cls)

xmlbox = obj.find('bndbox')

b = (float(xmlbox.find('xmin').text), float(xmlbox.find('xmax').text), float(xmlbox.find('ymin').text),

float(xmlbox.find('ymax').text))

b1, b2, b3, b4 = b

# 标注越界修正

if b2 > w:

b2 = w

if b4 > h:

b4 = h

b = (b1, b2, b3, b4)

bb = convert((w, h), b)

out_file.write(str(cls_id) + " " + " ".join([str(a) for a in bb]) + '\n')

wd = getcwd()

for image_set in sets:

if not os.path.exists('G:/yolov7-main/VOCdevkit/VOC2007/labels/'):

os.makedirs('G:/yolov7-main/VOCdevkit/VOC2007/labels/')

image_ids = open('G:/yolov7-main/VOCdevkit/VOC2007/ImageSets/Main/%s.txt' % (image_set)).read().strip().split()

if not os.path.exists('G:/yolov7-main/VOCdevkit/VOC2007/yolo_path/'):

os.makedirs('G:/yolov7-main/VOCdevkit/VOC2007/yolo_path/')

list_file = open('yolo_path/%s.txt' % (image_set), 'w') # 相对路径

for image_id in image_ids:

list_file.write('G:/yolov7-main/VOCdevkit/VOC2007/JPEGImages/%s.jpg\n' % (image_id))

convert_annotation(image_id)

list_file.close()

由于我的图像数据集名称‘JPEGImages’,和以往yolo系列‘imgaes’名称有区别,因此要在utils文件下的datasets.py中的第349行进行更改,将‘imgaes’更改为‘JPEGImages’(如果本来就是images的话就没必要改了)

如果找不到的话,就ctrl+f,搜一下images,一个个看就能定位到了

至此数据集方面就完成啦,接下来就是配置文件啦。

二、配置文件

自己数据集的配置文件

在data目录下新建一个.yaml格式文件(本文crack_data.yaml),文件内容就是训练集、验证集的全局路径(注意train:后需要空格),以及数据集包含的种类数量、类别的名称。(我就一个裂缝)

train: G:/yolov7-main/VOCdevkit/VOC2007/yolo_path/train.txt # 训练集路径文件

val: G:/yolov7-main/VOCdevkit/VOC2007/yolo_path/val.txt # 验证集集路径文件

nc: 1 # 种类

names: ['crack'] # 类别名称训练需更改的配置

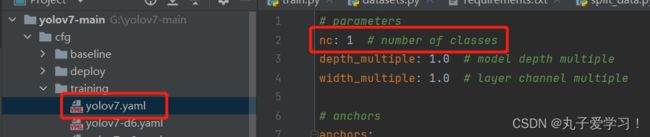

更改cfg文件中training文件夹下的yolov7.yaml中的nc量,就是根据自己数据集所包含类别数量改

(如果没有对yolov7的网络结构做其他更改,此yaml文件就不做其他更改)

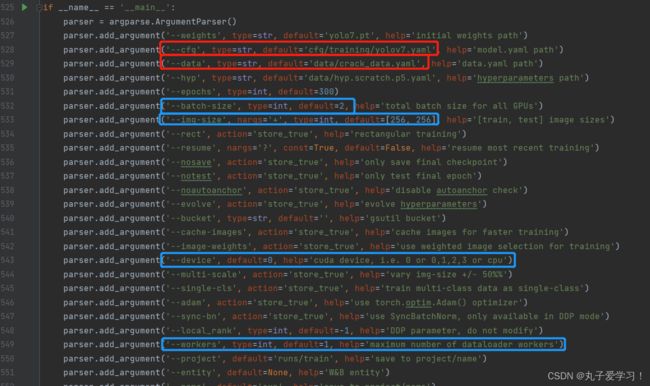

参数更改

这一步可以在train.py下直接更改好,也可以在终端输入运行命令的时候再补充,这里就是提前先改好。红色的是需要根据上面配置的路径进行更改,蓝色的根据自己电脑配置更改

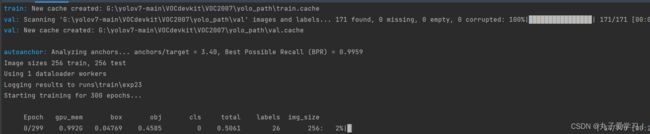

三、训练

本人在训练的时候遇到很多问题,代码始终跑不通,没有直接跑train.py程序,而是在终端运行,但是直接使用python train.py会报错,综合网上的信息最保险的运行代码(因为啥我倒是没搞明白)

python train.py --weights 'yolov7.pt'然后就可以训练自己的数据集了

PS

由于本人的电脑的gpu是1050,不够给力,待遇到其他报错问题会对本文章进行补充

希望大家根据本文章可以使用yolov7训练自己的数据集哦~