【深度学习图像识别课程】keras实现CNN系列:(1)MLP实现手写数字MNIST分类

一、MNIST分类:MLP实现

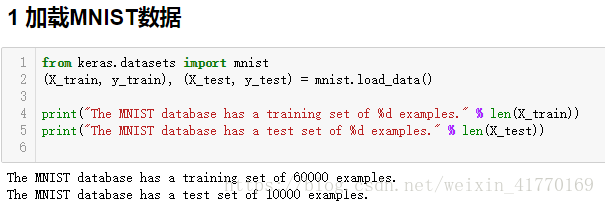

MNIST有60000张训练图片,10000张测试图片。每张图片大小28*28。

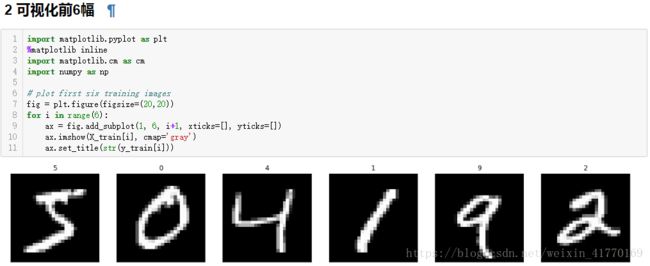

matplotlib.cm:colormap(具体可参考文章matplotlib使用参考文档)

3 看一张图的细节

def visualize_input(img, ax):

ax.imshow(img, cmap='gray')

width, height = img.shape

thresh = img.max()/2.5

for x in range(width):

for y in range(height):

ax.annotate(str(round(img[x][y],2)), xy=(y,x),

horizontalalignment='center',

verticalalignment='center',

color='white' if img[x][y]astype:类型强制转换 array converted to a specified type

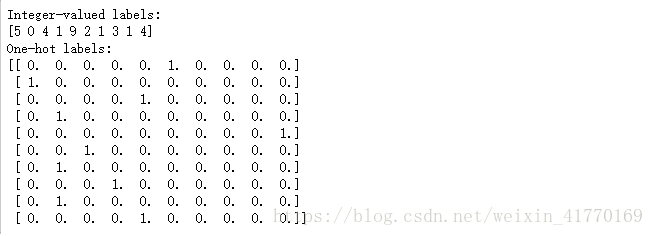

np_utils.to_categorical:本博客文章“keras框架学习和项目实战二”第5部分有解释

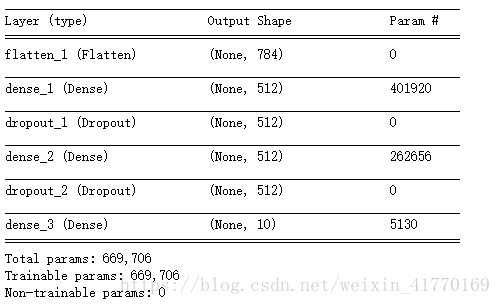

6 模型定义

from keras.models import Sequential

from keras.layers import Dense, Dropout, Flatten

# define the model

model = Sequential()

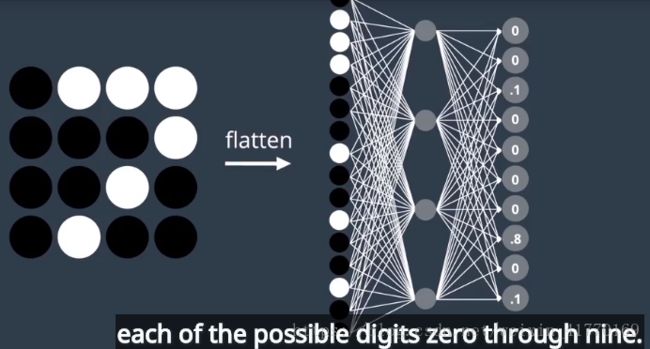

model.add(Flatten(input_shape=X_train.shape[1:]))

model.add(Dense(512, activation='relu'))

model.add(Dropout(0.2))

model.add(Dense(512, activation='relu'))

model.add(Dropout(0.2))

model.add(Dense(10, activation='softmax'))

# summarize the model

model.summary()Flatten(input_shape=X_train.shape[1:]):用来将输入压平,这里是把28*28的图像输入压成1*784。

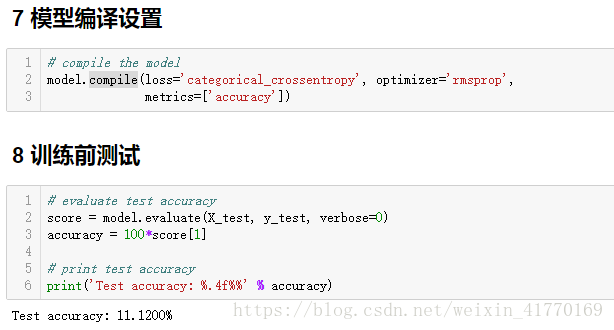

keras.callbacks modelcheckpoint:每次epoch之后,如果validation error减少,则记下模型参数,并覆盖上一次记录。

并保存在filepath中。参考:https://keras.io/callbacks/

- filepath: 保存模型的文件

- monitor: 监视器

- verbose: 0 or 1

- save_best_only: 如果为True,则监视器检测到的最近一次的最优模型将会被覆盖。

- mode: one of {auto, min, max}.

- save_weights_only: 如果为True,则仅保存模型的权重;否则保存这个模型。

- period: checkpoints之间间隔的epoch数

model.load_weights:从文件中把模型参数读到内存里,再进行测试。

二、MLP项目说明

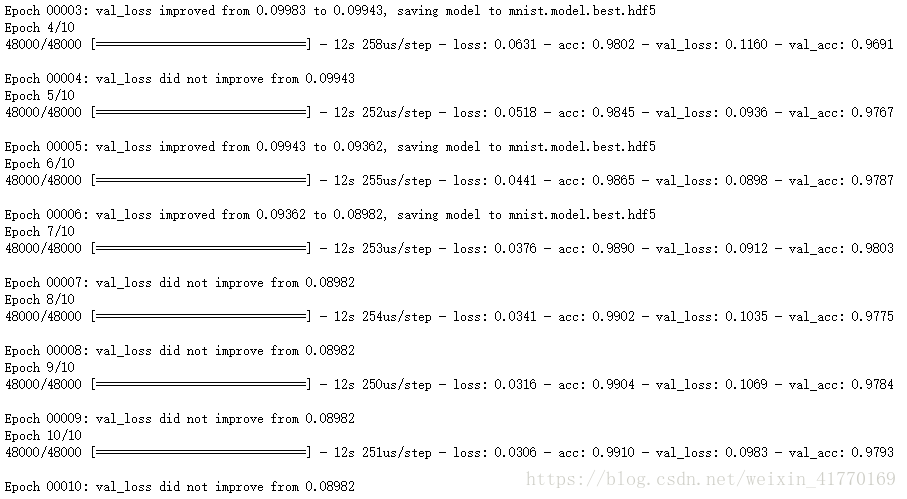

上面代码的准确率为:隐藏层单元数512,优化器rmsprop,有drop层,激活函数,batch尺寸128

loss: 0.0306 - acc: 0.9910 - val_loss: 0.0898 - val_acc: 0.9787 Test accuracy: 98.0200%通过如下的修改,看损失和正确率的变化情况:

1、增加隐藏层面的节点数量为2048:有过拟合的迹象,测试损失0.0433远小于验证损失0.1508

loss: 0.0433 - acc: 0.9911 - val_loss: 0.1508 - val_acc: 0.9772 Test accuracy: 97.7000%2、减少隐藏层面的节点数量128:

loss: 0.0636 - acc: 0.9800 - val_loss: 0.0903 - val_acc: 0.9761 Test accuracy: 97.8500%3、删除网络中的丢弃层

loss: 0.0101 - acc: 0.9969 - val_loss: 0.1352 - val_acc: 0.9780 Test accuracy: 97.5700%4、删除ReLU激活函数:测试正确率下降

loss: 0.3193 - acc: 0.9106 - val_loss: 0.3229 - val_acc: 0.9103 Test accuracy: 91.4500%5、每个像素除以255,删除预处理步骤:测试正确率大大降低

loss: 8.3681 - acc: 0.4807 - val_loss: 8.2894 - val_acc: 0.4856 Test accuracy: 49.0200%6、尝试其他优化器,比如SGD:测试正确率下降

loss: 0.2810 - acc: 0.9189 - val_loss: 0.2256 - val_acc: 0.9356 Test accuracy: 93.4900%7、增加batch尺寸为512:

loss: 0.0115 - acc: 0.9960 - val_loss: 0.0971 - val_acc: 0.9801 Test accuracy: 98.2500%8、减少batch尺寸为32:

loss: 0.0659 - acc: 0.9885 - val_loss: 0.1802 - val_acc: 0.9780 Test accuracy: 97.7400%

MLP的缺点:

1、对于28*28大小的图像,参数已经高达50万

2、输入时将图像压平,丢失了图像的二维信息

引入CNN:

1、更稀疏的连接层

所有隐藏层权重共享:比如判断一张图是否有猫咪,则不管猫咪在哪个角落都时满足条件、不应该有任何差异,因此权重共享可以实现这个要求。

2、接受矩阵输入