【MEF:GAN:注意力机制】

MEF-GAN: Multi-exposure Image Fusion via Generative Adversarial Networks(2020)

(MEF-GAN: 通过生成对抗网络进行多曝光图像融合)

本质就是GAN+自我注意力机制

介绍

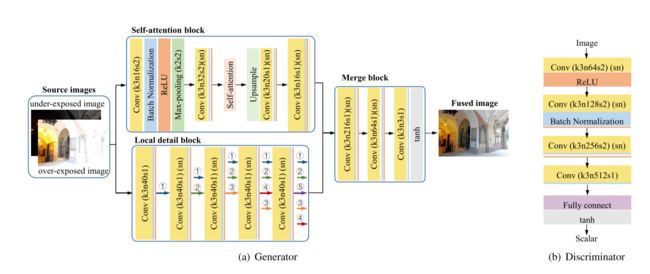

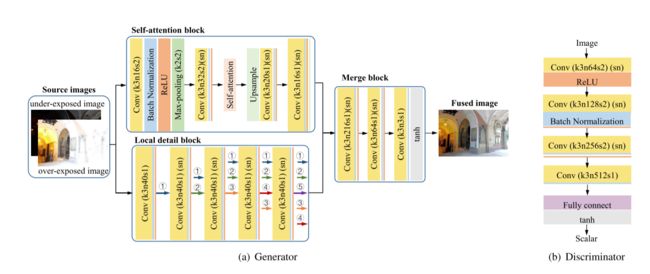

在我们的MEF-GAN中,生成器网络由三个块组成: 通过引入自我注意机制来允许注意力驱动和远程依赖的自我注意块—>适合解决区域过度或不足-曝光问题,保留和融合局部细节的局部细节块,以及合并由上述两个块获得的特征的合并块。

贡献

1)这是第一次使用生成对抗网络 (GANs) 来融合多曝光图像。

2)提出的MEF-GAN是一种基于端到端深度学习的方法,这开拓了以特征提取和融合规则设计作为研究重点新领域。

3)我们还将自我注意机制引入到MEF问题中,以获得更好的融合性能。

相关工作

Existing Multi-exposure Image Fusion Methods

i) 基于像素的方法

一种是基于权重和梯度的方法。基于权重的方法的关键是计算像素级融合的权重 。基于梯度的方法致力于保留源图像中的最大梯度。

另一种是基于多尺度变换的方法,包括金字塔,小波,contourlet,shearlet,主成分分析,密集尺度不变特征变换等。这些方法主要包括三个阶段: 图像变换,系数融合和逆变换。与第一类方法相比,这些方法可以获得更好的视觉感知。作为代表,GFF将图像分解为基础层和细节层。提出了一种新颖的基于引导滤波的加权平均技术,以充分利用空间一致性来融合这些层。此外,基于高斯金字塔变换,FLER 首先合成具有中等曝光的虚拟图像,以使曝光不足的区域变亮,并使曝光过度的区域变暗。然后使用高斯金字塔将虚拟图像和两个源图像融合。然而,这些方法的一个常见限制是它们不能很好地表示图像的曲线和边缘。

ii) 基于稀疏表示的方法

稀疏表示是一种新颖的表示理论,由于具有清晰的分量和纹理而没有伪影的优点而被广泛应用。首先,根据相同的超完备字典,源图像可以由相应的稀疏系数表示。然后,对系数执行融合过程。最后,可以通过系数和字典获得融合图像。但是,如何获得系数和如何构造字典是这些基于稀疏表示的方法的两个普遍问题 。

iii) 基于Tone映射的方法

通过在多个LDR图像上通过HDR重建技术压缩高动态范围,可以在普通设备上显示HDR场景。在过去的几年中,已经提出了许多不同的映射方法。

iv) 基于深度学习的方法

Deepfuse首次将深度学习引入多曝光图像融合领域。Deepfuse采用度量MEF-SSIM 作为损失函数,并构建了一种新颖的CNN架构来实现无监督学习。MEF-SSIM的定义是基于SSIM。在MEF-SSIM中,源图像被转换为期望的结果。然后,通过测量期望结果与实际结果之间的相似性来计算MEF-SSIM。为了获得所需的结果,将源图像中的补丁建模为SSIM框架中的三个组件: 对比度,结构和亮度。由于局部补丁中的亮度比较微不足道,因此丢弃了亮度分量。通过使用输入补丁的结构的权重和输入补丁的对比度的最高对比度值,仅获得源图像的结构和对比度,并将其保留在所需的结果中。因此,仅仅依靠MEF-SSIM来指导融合图像的生成会导致其他关键信息的丢失,因为它只关注结构和对比度失真。此外,在Deepfuse中,CNN仅应用于Y通道中进行特征提取和重建,而色度通道的融合规则仍由手动设计。但是,手动设计的方式可能仍然无法完全保留色度通道中的信息。

Generative Adversarial Networks

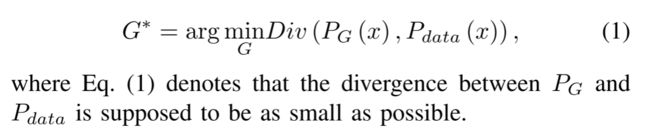

GAN最初被提出用于估计生成模型。在GAN框架中,生成网络G和鉴别器网络D同时被训练并形成对抗过程。给定从潜在空间采样的噪声变量z,生成网络G应该生成样本x = G(z)。训练G的目的是学习概率分布PG(x),作为来自真实样本 {x1,x2,·,xm} 的真实分布Pdata(x) 的估计。然后应用鉴别器D来确定样本是来自PG(x) 还是Pdata(x)。通过不断的对抗过程,G产生的样本会逐渐逼近真实样本。在传统方法中,生成模型通常由已知分布组成,例如高斯混合模型。然后,可以方便地执行最大似然估计。但是,这些预定义的分布限制了生成模型的拟合能力。如果Pdata(x) 复杂得多,则似然函数将更难计算,并且估计将更具挑战性。由于深度学习的承诺是发现丰富且分层的模型,因此深度网络更适用于捕获数据分布。因此,在GAN的框架内,使用发生器网络G来生成新样本。由于G的目标是使PG(x) 尽可能接近Pdata(x),因此优化公式定义如下:

由于Pdata(x) 是待求解的分布,PG(x) 由网络G决定,因此散度Div(PG(x),Pdata(x)) 不能具体表示和求解。在这种情况下,应用网络D来估计样本来自Pdata而不是PG的概率,其表示为D(x)。因此,PG和Pdata的Jensen-Shannon (JS) 散度可以表示为:

当我们训练生成器G时,鉴别器D是固定的,同样,当我们训练D时G是固定的。然后,G和D形成对抗关系,并组成了两人最小最大游戏,其中G被训练为愚弄D,而D试图区分生成的样本。随着对抗过程的推进,G生成的数据将越来越与真实数据没有区别。

Variants of GAN and Their Applications

迫使PG(x) 与Pdata(x) 尽可能接近的对抗损失使GAN变得更适合图像生成任务。受GAN的启发,Ledig等人推出了一种用于图像超分辨率的超分辨率GAN (SRGAN),通过训练GAN来增强内容损失函数的对抗性损失。为了提高生成图像的质量并提高训练过程的稳定性,最小二乘GAN (LSGAN)采用最小二乘损失函数作为鉴别器。因此Ma等人提出了一种新颖的基于LSGAN的方法,名为FusionGAN,它是一种用于处理红外和可见光图像融合任务的端到端模型。通过将一些额外的信息作为附加输入层提供给生成器和鉴别器,GAN被扩展到条件GAN (cGAN)。基于cGAN,通过在修改之前引入VGG特征和L1-regularized梯度,可以从模糊图像中恢复清晰的图像。Wasserstein GAN (WGAN)没有使用JS散度来比较PG(x) 和Pdata(x),而是引入了Wasserstein距离来提高稳定性并摆脱模式崩溃等问题。通过应用WGAN和感知相似性,Yang等人提出了一种用于LDCT图像去噪的当代深度神经网络。通过应用分布匹配的对抗损失和周期一致性损失来防止学习到的映射,Zhu等人提出了周期一致的GAN (CycleGAN) 来学习在没有配对示例的情况下从源域到目标域的转换。为了解决传统GAN仅作为空间局部点的函数生成高分辨率细节的问题,Zhang等人提出了允许注意力驱动的远程依赖建模的自我注意GAN。因此,可以使用来自所有特征位置的提示来生成细节。此外,为了从复杂的数据集生成高分辨率和多样化的样本,Brock等人在最大的规模上训练了GANs,并研究了这种规模特有的不稳定性 。

方法

Loss Function

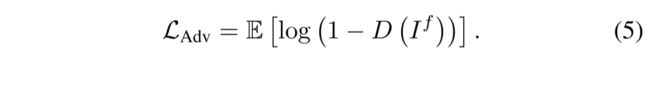

生成器G被训练以学习从源图像 (即曝光不足的图像Iu和曝光过度的图像Io) 到曝光良好的图像If = G(Iu,Io) 的映射。为了捕获地面真理Igt的真实概率分布,G的对抗性损失定义如下:

通过试图愚弄区分If和Igt的同时训练的鉴别器D,LAdv迫使G生成的融合图像驻留在地面真相的流形上。

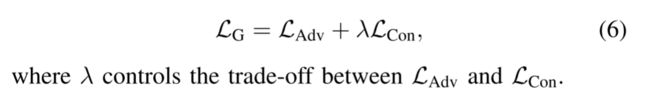

在先前的研究中,由于不稳定的行为,伪像和误差或嘈杂的结果,GAN的成功和应用受到限制。基于cGAN的图像生成任务的先前工作,通过额外的内容损失 (例如L1,L2范式或其他损失) 来增加生成器的对抗性损失,可以受益并提高生成器的性能。因此,在我们的工作中,除了LAdv之外,我们还使用内容损失LCon来增强发电机损失函数。所以生成器损耗函数LG可以定义为:

为了以像素方式衡量和限制内容中If和Igt之间的相似性,我们将均方误差 (MSE) 损失包括为内容损失,其表示如下:

通常已知,基于MSE的优化可能导致解决方案中缺少高频内容。由于纹理平滑,解决方案在感知上不令人满意。为了弥补MSE损耗的不足,并保留具有高频率的内容 (通常表示为梯度信息),我们使用基于梯度的损耗LMSE扩展LMSE,其定义为:

其中,▽是梯度操作,函数 Γ(·) 表示将RGB通道中的图像转换为灰色通道的操作。因此,通过引入权重 ξ 来控制权衡,内容损失最终可以写成:

MEF-GAN中的鉴别器D被训练以区分生成的图像If 和地面真相Igt 。D的输出是介于0和1之间的标量,表示输入图像来自地面真实的概率。我们将D的对抗性损失函数表示为:

Network Architecture

(生成器网络和鉴别器网络的体系结构,其中k,n和s分别表示每个卷积层指示的相应内核大小,特征图的数量和步幅。相同颜色的层表示具有相同功能但不共享参数的层 (sn: 光谱归一化)。在局部细节块中,相同的数字和颜色表示相同的特征图)

(如图2(a) 所示,生成器包含5层。在第一层中,为了加速训练并避免爆炸/消失梯度,在卷积层之后添加了批归一化。整流线性单元 (ReLU) 用作激活函数。在第一卷积层之后,应用maxpooling层,内核和步幅设置为2。在下一个卷积层中,我们对卷积核执行光谱归一化。实际上,在本文中,我们在生成器和鉴别器体系结构 (缩写为sn) 中介绍了光谱归一化。光谱归一化最初由Miyato等人提出,并通过限制各层的频谱范数而应用于鉴别器网络,具有不需要额外的超参数调谐的优点。然后,Zhang等人发现,将光谱归一化引入到发生器G的训练中,可以防止参数幅度的上升并避免不寻常的梯度,这有利于GAN性能中G的调节。在前两层之后,特征图的高度和宽度都是原始输入的8分之1。然后将这些特征图通过自我注意层。然后使用最近邻插值对输出特征图进行上采样。然后通过图中所示的另外两个卷积层和上采样层,最终获得了该块的特征图。)

GAN中的光谱归一化

1) Generator Architecture:

生成器网络由三个子部分组成: 自我注意块,局部细节块和合并块,如图2(a) 所示。多个网络的组合用于捕获具有多个尺度和多个接收字段的特征。自我注意块通过引入注意驱动和远程依赖性来提取特征,以考虑来自所有其他特征位置的提示,而不是周围的受限制场。但是,由于此块中的maxpooling层会减小特征图的比例并导致失真,因此我们添加了局部细节信息块(local detail block)以保留一些可能丢失的详细信息。由于此细节信息块中的图层都具有有限的相应字段,因此我们将此块命名为局部细节信息块。然后,将合并块应用于合并由自我注意块和局部细节块获得的特征,并生成最终融合图像。

a) Self-attention block

在一系列多曝光图像中,由于曝光设置的原因,每个图片中捕获的细节都受到限制。这些细节随空间位置变化很大。以图1中的图像为例,过度曝光图像中的清晰细节集中在图像左侧的走廊和窗口上,而在曝光不足的图像中,图像右侧的墙壁明显更加突出。在这种情况下,特征提取和融合应伴随注意力驱动和远程依赖机制。因此,有必要绘制全局依赖性以关联融合结果和源图像之间的不同位置。由于内核大小有限,对普通卷积层来说是一项艰巨的任务,需要更深层,因此提出了实现这一思想的自我注意机制。

我们遵循已有文献中的自我注意机制,如图3(a) 所示。通过1 × 1卷积获得两个特征空间f(x) 和g(x)。这两个特征空间形成一个查询和一组键值对。为了计算注意力图,f(x) 和g(x) 都被展平。然后将g(x) 与转置的f(x) 的矩阵乘法结果通过softmax处理得到 β。类似地,将x通过另一个1 × 1卷积的结果,即h(x),并与 β 相乘,以生成自我注意特征图o。使用学习的参数 γ,输出特征图可以表示为y = γ × o +x。

从图3(a) 中可以清楚地看到,通过将平坦的g(x) 与形状 [B,H × W,c] 以及将平坦和转置(transpose)的f(x) 与形状 [B,c,H × W] 相乘而获得注意图 β。因此,获得的注意力图具有较大的尺寸,并且尺寸为 [B,H × W,H × W]。如果H和W的值约为几百,则注意力图 β 的大小将为HW × HW,其中HW约为数万。而且有了多个批次,这将是对存储空间和计算能力的挑战。此外,在训练阶段,训练数据集中的图像被剪切成许多补丁并馈送到生成器中。这些补丁的高度和重量比原始的过度曝光或曝光不足的图像要小得多。在测试阶段,如果将测试的源图像以相同的方式剪切成补丁,然后将其缝合在一起以获得融合的图像,则自我注意层的引入将导致补丁之间的亮度和色度的显着差异。那么融合图像的视觉效果将受到严重影响。综合考虑训练和测试过程,并在性能和计算成本之间进行权衡,在自我注意层之前采用最大池化层和卷积层中的较长步幅。为了弥补这些操作造成的细节损失,我们并行添加了另一个块,该块仅包含几个简单的层。该块被命名为局部细节信息块。

局部细节块包含五个卷积层。所有这些层都伴随着批归一化和ReLU激活功能。在每个层中,无论该层的输入通道数如何,该层始终通过3 × 3过滤器生成40个特征图。所有的步幅都设置为1。此外,为了减轻梯度的消失和重用先前计算的特征,在局部细节块中应用密集连接的块以弥补特征损失,如图2所示,在密集连接的块中,所有先前计算的特征都直接连接到后续层以用于特征重新使用。在第二层到第四层中,还应用了频谱归一化,以防止参数幅度上升并避免异常梯度。

c) Merge block

将自我注意块和局部细节块获得的特征串接为合并块的输入。合并块由三个卷积层组成。一个区别是,仅在前两层采用光谱归一化,而在第三层不采用。另一个区别是,前两层使用ReLU激活函数,最后一层将其替换为tanh激活函数,以获得最终的融合图像。

Discriminator Architecture:

由于区分两个图像的任务比为神经网络生成图像更容易,因此D的体系结构比G的体系结构复杂。具体地,如图2(b) 所示,在鉴别器中有五层。前四层是卷积层,然后是批归一化或ReLU函数,或两者。在这四个层中,前三个卷积层的步幅设置为2,并在这些卷积层之前应用光谱归一化。到最终的卷积层,步幅设置为1。将第四层的输出输入到完全连接的层中,并由tanh函数激活以生成标量,该标量估计输入图像是地面真相而不是生成的融合图像的概率。