关于深度学习的研究综述

来源作者:曹阳

多伦多大学的神经网络专家Geoffrey Hinton[2]等人于2006年首次提出了深度学习的概念,从此拉开了深度学习研究和应用的序幕。近些年来,深度学习引起了计算机视觉、搜索技术、自然语言处理、语音识别等领域的广泛关注,并取得了很多成果。如最早应用深度学习进行计算机视觉研究的华人团队香港中文大学的多媒体实验室在2015年世界级人工智能竞赛LFW(大规模人脸识别竞赛)上,力压FaceBook夺得冠军,使得人工智能在该领域的识别能力首次超越真人。2019年,李飞飞及其斯坦福计算机视觉实验室[3]提出了基于深度学习的神经网络架构搜索实现语义分割。针对自然语言处理中语义语法难理解等问题,Tomas Mikolov[4]等人提出word2vector模型,与传统的词袋模型(bag of words)相比,word2vector能够更好地表达语法信息。针对语音识别难等问题,Geoffrey Hinton[5]、Dario Amodei[6]、W.Xiong[7]基于深度学习算法在语音识别的问题上分别取得了突破性的进展。

基于以上分析,对深度学习的研究与应用主要集中在图像、语言、文字三大领域,结合人工智能和机器学习等相关算法,提出了计算机视觉、自然语言处理等主要热点研究领域。

1. 计算机视觉

计算机视觉是以图像(视频)为输入,以对环境的表达和理解为目标,研究图像信息组织、物体和场景识别、进而对事件给予解释的学科。

1.1 重点研究单位

将深度学习应用于计算机视觉的成功,主要得益于数据积累和计算能力的提高。目前,研究深度学习与计算机最著名的莫过于计算机视觉的三大国际会议:国际计算机视觉会议(ICCV),欧洲计算机视觉会议(ECCV)和计算机视觉和模式识别会议(CVPR)。从近年来三大会议上发表的论文可以看出,目前,都在利用深度学习来“取代”计算机视觉中的传统方法。

此外,一些国内外重点大学内的一些团队也是计算机视觉重点研究单位,如斯坦福计算机视觉实验室、华中科技大学图像识别与人工智能研究所、南加州大学计算机视觉实验室、浙江大学图像技术研究与应用(ITRA)团队、香港中文大学多媒体实验室等。

当然,将计算机视觉技术应用落到实处的少不了商业的推广。微软、谷歌、商汤科技等公司致力于引领人工智能核心“深度学习”技术突破,构建人工智能、大数据分析行业解决方案。他们成功聚集了当下较有影响力的深度学习、计算机视觉科学家。

1.2 重要人员

李飞飞,美国斯坦福大学红杉讲席教授、斯坦福人工智能实验室主任、Google Cloud AI的负责人及首席科学家。她带领团队创办了计算机视觉领域著名的ImageNet计划,这项推动计算机自动识别图像的技术以及由此带来的海量数据,对计算机视觉以及深度学习的发展都有着巨大的帮助。

卡内基梅隆大学、多伦多大学、伦敦大学学院的辛书冕(Shumian Xin),Sotiris Nousias,他们合作的论文《A Theory of Fermat Paths for Non-Line-of-Sight Shape Reconstruction》获得了CVPR2019最佳论文奖。这篇论文为非视距(NLOS)重建做出了重大贡献,尤其是赋予了智能体看到角落的能力。

1.3 重要成果与研究趋势

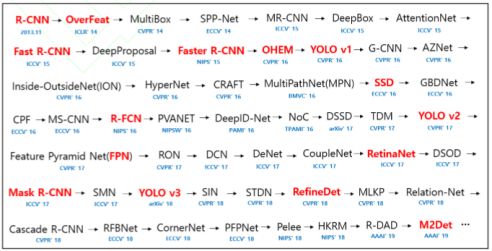

针对图像中的对象检测问题,Liu[8]等人提出的SSD、Redmon[9][10]等人提出的YOLO、Dai[11]等人提出的R-FCN都是非常有效的方法,被广泛应用于物体检测。现在,对象检测的主要研究趋势是转向更快、更高效的检测系统。下图给出了近些年来优秀的目标检测算法。

图2-1 2013年11月至2019年10月标检测算法总览

针对图像分割等问题,FAIR[12]从2015年开始继续深入研究DeepMask。2016年,Fair[13]推出了SharpMask,改进了DeepMask提供的“mask”,纠正了细节的缺失,改善了语义分割。为了寻找替代网络配置来解决规模和本地化问题。Khoreva[14]等人基于Deeplab早期的工作,提出了一种弱监督训练方法,可以获得与完全监督网络相当的结果。

计算机视觉领域并不仅仅是为了扩展机器的伪认知能力,神经网络的强大的可塑性以及其他ML技术常常适用于各种其他新颖的应用,如超分辨率,风格转移和着色。RAISR[15]、生成对抗网络(GAN)均为快速而准确的图像超分辨率方法。

此外,试图找出人体部位的方向和构型的人体姿势估计[16][17][18]、应用于三维空间重构的SLAM[19]方法等都是近些年计算机视觉深度学习研究领域的热点问题。

从目前的研究现状看,目前还主要聚焦在图像信息的组织和识别阶段,对事件解释、3D世界的了解很少。将这些3D表示及其相关知识传递给人造系统是下一个计算机视觉的前沿。

2. 自然语言处理

自然语言处理(NLP)是计算机科学,人工智能,语言学关注计算机和人类自然语言之间的相互作用的领域。它研究能实现人与计算机之间用自然语言进行有效通信的各种理论和方法。

2.1 重点研究单位

微软亚洲研究院、Goole、Facebook、百度、科大讯飞等企业均在机器翻译、语音识别等自然语言处理领域作出了一定的贡献。另外,还包括一些高校的团队,如斯坦福大学自然语言处理小组、哈尔滨工业大学智能技术与自然语言处理研究室、清华大学智能技术与系统国家重点实验室信息检索课题组等。同时,自然语言处理也拥有ACL/EMNLP/NAACL三大会议。

2.2 重要人员

刘群,中国科学院自然语言处理研究组组长,都柏林大学自然语言处理组组长、项目负责人。主要研究方向是中文自然语言处理,具体包括汉语词法分析、汉语句法分析、语义处理、统计语言模型、辞典和语料库、机器翻译、信息提取、中文信息处理和智能交互中的大规模资源建设、中文信息处理以及智能交互中的评测技术等。曾负责863重点项目“机器翻译新方法的研究”和“面向跨语言搜索的机器翻译关键技术研究”等。

新加坡国立大学黄伟道教授,自然语言处理和信息检索专家,精通于核心分辨率和语义处理以及语义语料库的开发,ACL2005程序委员会主席,已发表学术论文百余篇,被引用超8200次;

Christopher D.Manning,斯坦福大学计算机科学与语言学习的教授,致力于研究能够智能处理、理解和生成人类语言材料的计算机,在自然语言处理的深度学习领域有着深入研究,包括递归神经网络、情感分析、神经网络依赖分析等。

2.3 重要成果

从2008年到现在,在图像识别和语音识别领域的成果激励下,人们也逐渐开始引入深度学习来做自然语言处理研究,由最初的词向量到2013年的word2vec[4],将深度学习与自然语言处理的结合推向了高潮,并在机器翻译、问答系统、阅读理解等领域取得了一定成功。RNN[20]已经是自然语言处理最常用的方法之一,GRU[21]、LSTM[22]等模型相继引发了一轮又一轮的热潮。

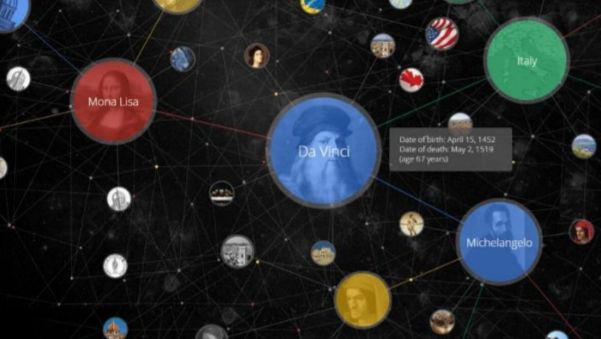

知识图谱也是自然语言处理的关键技术之一,是为了表示知识,描述客观世界的概念、实体、事件等之间关系的一种表示形式。Tim Berners Lee[23]提出的语义网和关联数据都可以说是知识图谱的前身。

图2-1 知识图谱示意图

2012年5月,Google推出Google知识图谱,并将其应用在搜索引擎中增强搜索能力,改善用户搜索质量和搜索体验,标志着大规模知识图谱在互联网语义搜索中的成功应用。

机器翻译是自然语言处理最为人知的应用场景,一般是将机器翻译作为某个应用的组成部分,例如跨语言的搜索引流等。目前以IBM、谷歌、微软为代表的国外科研机构和企业均相继成立机器翻译团队,专门从事智能翻译研究。如IBM于2009年9月推出ViaVoiceTranslator机器翻译软件,为自动化翻译奠定了基础;2011年开始,伴随着语音识别、机器翻译技术、DNN(深度神经网络)技术的快速发展和经济全球化的需求,口语自动翻译研究成为当今信息处理领域新的研究热点;Google于2011年1月正式在其Android系统上推出了升级版的机器翻译服务;微软的Skype于2014年12月宣布推出实时机器翻译的预览版、支持英语和西班牙语的实时翻译,并宣布支持40多种语言的文本实时翻译功能。

2.4 趋势方向

随着深度学习时代的来临,神经网络成为一种强大的机器学习工具,自然语言处理取得了许多突破性发展,情绪分析、自动问答、机器翻译等领域都飞速发展。下图分别是AMiner计算出的自然语言处理近期热点和全球热点。

图2-2 自然语言处理近期热点图

图2-3 自然语言处理全球热点图

通过对1994-2017年间自然语言处理领域有关论文的挖掘,总结出二十多年来,自然语言处理的领域关键词主要集中在计算机语言、神经网络、情感分析、机器翻译、词义消歧、信息提取、知识库和文本分析等领域。旨在基于历史的科研成果数据的基础上,对自然语言处理热度甚至发展趋势进行研究。

目前,深度学习在自然语言处理中的应用极大的促进了行业的发展。但是,即使使用深度学习,仍然有许多问题只能达到基本的要求,如问答系统、对话系统、对话翻译等。如何有效利用海量信息已成为自然语言处理发展的一个关键性。

3. 结论

与浅学习相比,深度学习具有许多优点,如在网络表达复杂目标函数的能力方面,浅结构神经网络有时无法很好地实现高变函数等复杂高维函数的表示,而用深度结构神经网络能够较好地表征;在仿生学角度方面,深度学习网络结构是对人类大脑皮层的最好模拟。与大脑皮层一样,深度学习对输入数据的处理是分层进行的,用每一层神经网络提取原始数据不同水平的特征。

但深度学习目前仍然存在一些问题,相对浅层学习模型来说,深度学习模型对非线性函数的表示能力更好。但相对浅层模型,深度学习模型需要较多的参数。关于深度学习训练的计算复杂度也是我们需要关心的问题。另外,网络模型训练所需要消耗的计算资源很难预估,对网络的优化技术仍有待进步。由于深度学习模型的代价函数都是非凸的,这也造成理论研究方面的困难。