加州大学提出个性化Transformer序列推荐模型SSE-PT(已开源)

SSE-PT: Sequential Recommendation Via Personalized Transformer

Liwei Wu, Shuqing Li, Cho-Jui Hsieh, James Sharpnack

University of California

RecSys 2020

https://dl.acm.org/doi/pdf/10.1145/3383313.3412258

时序信息在推荐场景中非常重要,这是因为用户的偏好是会随着时间推移而自然得动态变化。

最近深度学习进展迅速,除了自然语言处理中广泛使用的RNN和CNN,已经涌现出多种多样的注意力机制以及新的网络结构,这有助于更好地利用每个用户发生交互的商品的时序信息。

SASRec这种模型是受自然语言处理中的Transformer模型启发而产生的,取得了STOA效果。但是,SASRec,跟原始的Transformer模型类似,本质上是非个性化模型,不包含个性化的用户embedding。

为了克服这种限制,作者们提出个性化Transformer模型,SSE-PT,在NDCG@10这种指标上差不多优于SASRec 5%。此外,随机选择若干用户的行为历史,分析发现,作者们所提模型不仅解释性更强,而且针对每个用户的推荐会集中在用户的最近行为模式上。

此外,SSE-PT模型稍加修改,得到SSE-PT++,可以处理非常长的序列行为,在训练速度基本相当的前提下排序结果层面效果优于SASRec,在性能和速度方面可以取得平衡。

作者们的主要创新在于随机共享embedding(SSE)正则,在个性化推荐中非常必要。

作者们提出的模型没有跟基于Bert的模型对比

基于会话的模型和序列模型具有一定的区别

目前一些正则化方法有如下几种

序列推荐中数据集分割方式以及评价指标如下

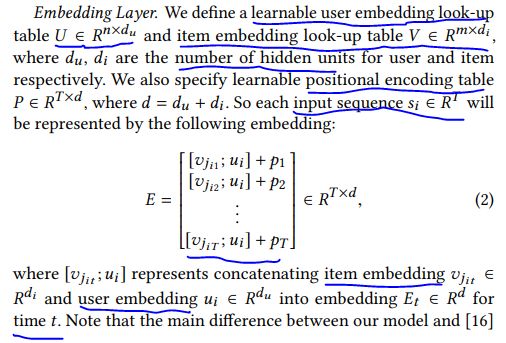

embedding层形式如下

Transformer编码层简介如下

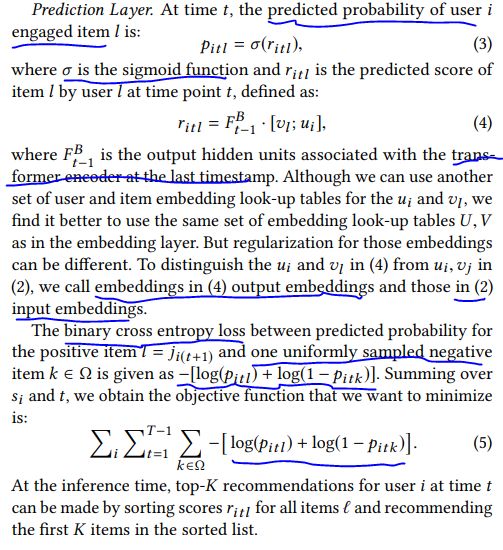

预测层简介如下

SSE简介如下

常用的正则化方法有以下几种

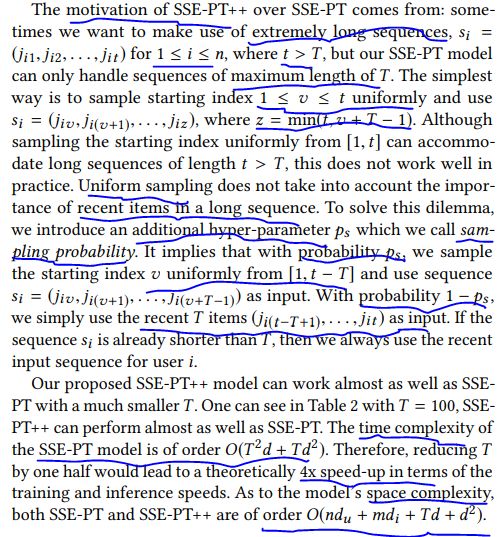

适用于特长序列的模型简介以及空间时间复杂度分析如下

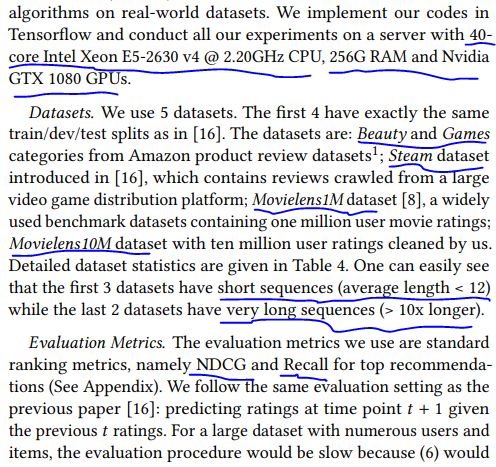

实验环境、数据集简介和评价标准如下

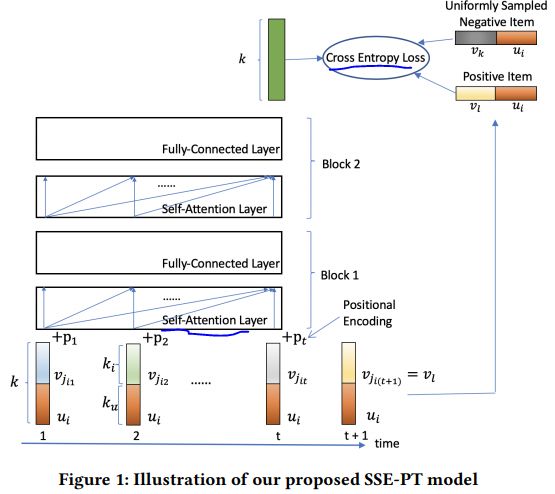

这篇文章提出的网络结构图示如下

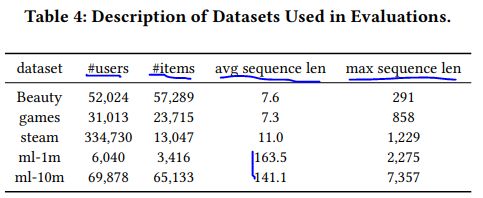

数据集信息统计如下

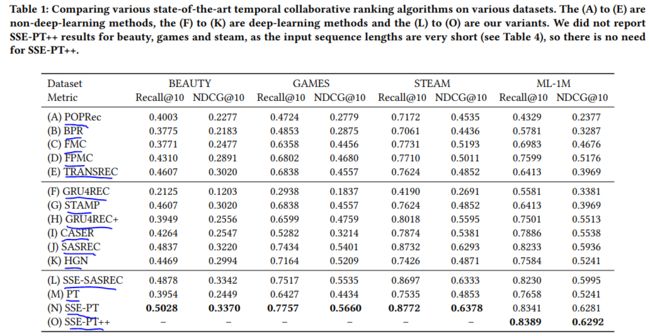

参与对比的几种方法有

数据集分割及训练模型的参数设置如下

几种方法的效果对比如下

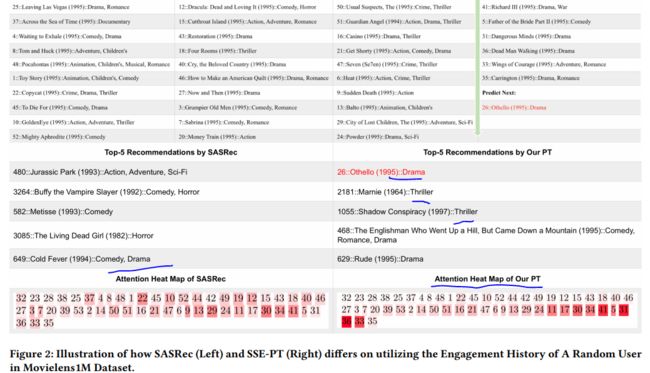

注意力热图图示如下

训练速度及对应的指标变化图示如下

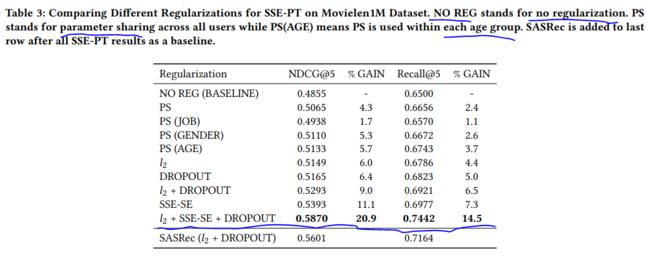

不同的正则方法对模型效果影响图示如下

不同的随机共享embedding概率对模型效果影响如下

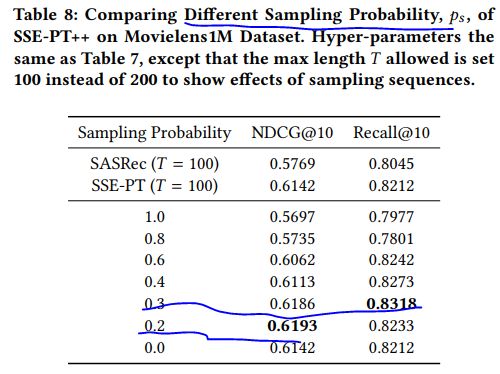

不同的采样概率对模型效果影响如下

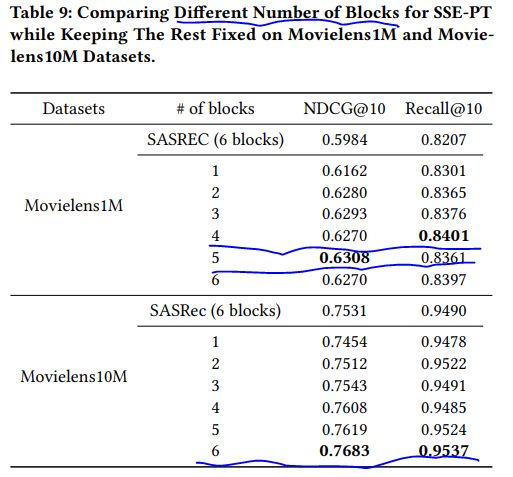

不同的block数量对模型效果影响如下

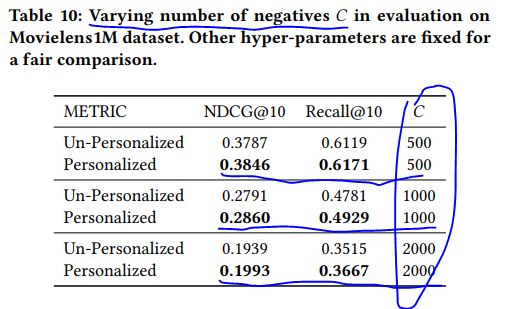

不同的负样本数量对模型效果影响如下

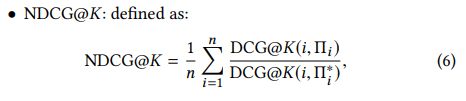

下面是排序度量标准简介

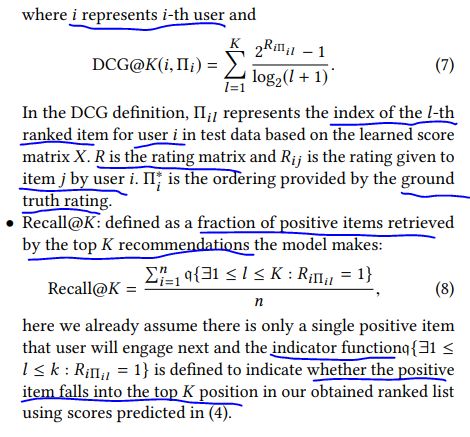

下面是几种常见的正则化方法简介

几种参与对比的非深度模型简介如下

几种参与对比的深度模型简介如下

代码地址

https://github.com/wuliwei9278/SSE-PT

您可能感兴趣

谷歌提出深层哈希embedding用于大规模类别型特征表示

微软提出基于知识图谱的深度神经网络DKN用于新闻推荐

谷歌提出改进版DCN(DCNV2)用于大规模推荐系统

ADKDD2017|深度交叉网络DCN在广告点击预估中的应用

WWW2018|FwFM加权域分解机在CTR预估中的应用

WSDM2020|InterHAt分层注意力可解释CTR预估(已开源)

CIKM2019|Fi-GNN图神经网络学习特征交互在CTR预估中的应用(已开源)

CIKM2019|AutoInt自注意力神经网络自动学习特征交互(已开源)

WSDM2019|近似解耦随机游走RecWalk在top-N推荐中的应用(已开源)

CIKM2013|深层结构语意模型DSSM在web搜索中的应用

WSDM2019|社交注意力记忆网络在推荐系统中的应用(已开源)

SIGIR2020|基于序贯行为的高效迁移学习在用户建模及推荐中的应用(已开源)

WSDM2019|门限注意力自编码在内容感知推荐中的应用(已开源)

WWW2019|对偶图注意力网络在推荐系统中的应用(已开源)

KDD2019|个性化注意力在新闻推荐中的应用

SIGIR2020|序贯元学习方法在重新训练推荐系统中的应用(已开源)

WSDM2019|动态图注意力网络在基于会话的社交推荐中的应用

IJCAI2017|基于注意力机制的FM模型AFM在学习特征交互权重中的应用(已开源)

KDD2020|自动特征交互选择(AutoFIS)分解机模型在CTR预估中的应用(已开源)

SIGIR2020|LightGCN图卷积网络在推荐系统中的应用(已开源)

WWW2019|图神经网络在社交推荐中的应用

AAAI2019|自注意力度量学习在下一个商品推荐中的应用

WWW2020|基于隐含意图的注意力序列模型在下一个商品推荐中的应用

WWW2015|深度学习在推荐系统跨域用户建模中的应用

ICDE2020|多图卷积网络在草药推荐中的应用

ATM|注意力转移模型在预测下一个商品中的应用

IJCAI2019|深层自注意力网络在序列推荐中的应用

AAAI2020|深度学习在表格分析中的应用