论文阅读:MVIN: Learning Multiview Items for Recommendation

MVIN: Learning Multiview Items for Recommendation

- 概述

- Introduction

- 相关工作

-

-

- KG-aware Recommendation models

- User-Item Interaction

-

- MVIN介绍

-

- 1. user-entity interaction (模型目的之一为丰富用户-实体交互)

-

- 1.1 user-oriented relation attention 面向用户的关系注意力

- 1.2 User-Oriented Entity Projection

- 1.3 KG-Enhanced User Representation

- 2 Entity-Entity Interaction (模型目的之二为细化实体-实体交互)

- 3 Learning Algorithm

-

- 3.1 Fixed-size sampling 固定大小采样

- 3.2 Stage-wise Training

- 3.3 Time Complexity Analysis

- 实验

-

-

- 数据集

- 对比的baseline

- 实验结果

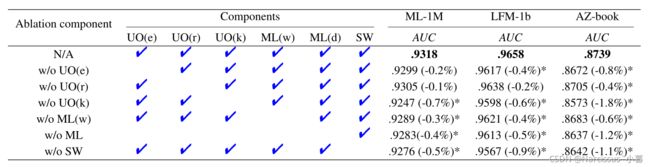

- 消融实验

-

- User-Oriented Information

- KG-enhanced User-Oriented Information

- Mixing layer-wise GCN

- Mixing layer-wise GCN information (在高邻域采样尺寸 K n K_n Kn下)

- High-Order connectivity information

- Stage-wise Training

- 参数敏感性

-

- 总结

- Reference

概述

本文发布于SIGIR 2020

作者为来自台北中央研究院的 Tai Chang-You, Wu Meng-Ru 团队

代码链接:https://github.com/johnnyjana730/MVIN

原文链接:https://arxiv.org/pdf/2005.12516.pdf

从用户视图来看,面向用户的模块根据包含用户点击信息的异构知识图实体对特性进行评分和聚合,从而从个性化的角度提出建议。从实体视图来看,混合层对比各层的图神经网络信息,进一步从异构知识图(KG)内部实体-实体交互中获得综合特征

在现实世界中,每个用户对给定的项目都有不同的看法视图(views),在实体视图中,项目表示由异构知识图(KG)中连接到它的实体来定义的。这也对应了多视图的两大问题:如何丰富用户视图Graph,如何细化实体视图Graph。论文提出的MVIN,从user和item来学习多个视角下的商品表示,进而进行商品推荐

Introduction

和很多其他具有大量数据的实际应用一样,推荐系统(RSs)也能从深度神经网络中受益匪浅。基于矩阵分解[1]的协同过滤(CF)是最成功的推荐方法之一。然而基于CF的方法依赖于用户和项目过去的交互,这会导致冷启动问题[2],使用该种方法,没有交互的项目永远不会被推荐。为了缓解这一问题,现在更多的研究在整合辅助信息,比如社交网络[3],图片[4]和评论[5]

在众多辅助信息中,Knowledge Graph (以下简称为KGs) 以机器可读的 实体-关系-实体 三元组的形式包含丰富的信息,得到了广泛的应用。目前KGs已经在节点分类,句子补全和摘要生成等应用中陆续被使用。比如RippleNet[6]会传播用户在KG中的潜在偏好,并探索他们的层次兴趣。也有很多产品采用KG图卷积网络(GCN)[7],该网络被合并到GNN中以生成高阶项连通性。然而该种网络仍然有缺点,比如缺少不同层实体之间的比较

总体而言,基于GNN的推荐模型仍然面临挑战:user-view GNN enrichment(浓缩) 和 entity-view GCN refinement(精炼)。这篇论文研究了基于GNN的推荐,并提出了一种能满足上述两种挑战的网络。提出的知识图多视图项目网络MVIN,是一种基于GNN的推荐模型,该模型具有用户-实体和实体-实体交互模块

为了丰富用户和实体的交互,该模型首先学习了KG增强的用户表示,使用它面向用户的模块表征了每个实体之间关系的重要性和信息性

为了优化实体与实体之间的交互,该论文提出了一个混合层来进一步改进GCN聚合实体的嵌入,并允许MVIN从各个层的邻域特征中捕获混合的GCN信息

此外,为了保持计算效率和接近整个邻域的全景,本论文采用了分阶段策略[8]和采样策略[9,10]来更好地利用KG信息

论文贡献包括:

- 启用用户视图和个性化GNN

- 通过广泛和深入的GCN从实体视图中提炼项目嵌入,这为高阶连接带来了层次上的差异

- 通过真实数据集证明了MVIN具有的鲁棒性和优势,证明了该模型可以捕获识别用户兴趣的实体

相关工作

KG-aware Recommendation models

除了基于图神经网络(GNN)的方法外,还有另外两类KG-aware推荐

第一种是基于嵌入的方法,将KG的实体和关系结合到连续的向量空间中,然后通过增强语义表示对推荐系统进行辅助。比如,DKN[11]融合了新闻的语义级和知识级表示,并将KG表示合并到新闻推荐中。此外CKE[4]将CF模块与结构化的、文本的和可视化的知识组合成为一个统一的推荐扩展。然而这些机遇嵌入的知识图嵌入算法(KGE)更加适合于图内应用,比如链路预测

第二种是基于路径的方法,利用元路径和相关用户-物品对,探索KG中物品之间的连接模式。例如MCRec[12]在推荐中学习元路径的显式表示。此外,还考虑了元路径和用户-项目对之间的相互影响。与基于嵌入的方法相比,基于路径的方法直接使用图算法,更自然,直观的挖掘KG结构。然而,他们严重依赖元路径,这需要相关的领域知识和手工处理,因此不适合端到端的training

User-Item Interaction

由于用户和项目是推荐中设计的两个主要实体,许多研究都试图通过研究用户和项目之间的交互来提高推荐性能

例如[9]提出的KGCN,它表征了关系对用户的重要性。而KGCN中的聚合方法没有考虑与用户不同的实体的信息量。[13]提出了MCRec,它考虑了用户对元路径的不同偏好,却忽略了与用户关系的语义差异。此外,由于这两种方法不使用GCN,因此关于高阶连接的信息是有限的

[14]认为用户通常既有长期偏好又有短期兴趣,因此提出了LSTUR,该模型将用户表示添加到GRU中,以捕获用户个人的长期和短期兴趣

MVIN介绍

用户和项目的集合表示为 U = { u 1 , u 2 ⋯ } U=\{u_1,u_2 \cdots\} U={u1,u2⋯}和 V = { v 1 , v 2 ⋯ } V=\{v_1,v_2 \cdots\} V={v1,v2⋯},用户项交互矩阵根据隐式用户反馈定义为 Y = { y u v ∣ u ∈ U , v ∈ V } Y=\{y_{uv}|u\in U, v \in V\} Y={yuv∣u∈U,v∈V}。如果观察到用户u和物品v之间存在交互作用,则 y u v y_{uv} yuv记录为 y u v = 1 y_{uv}=1 yuv=1,否则为 y u v = 0 y_{uv}=0 yuv=0

为了提高推荐质量,使用知识图 G G G中的信息。知识图由实体-关系-实体三元组 { ( h , r , t ) ∣ h , t ∈ ε , r ∈ R } \{(h,r,t)|h,t \in \varepsilon, r \in R \} {(h,r,t)∣h,t∈ε,r∈R},这个三元组描述从头实体 h h h到尾实体 t t t的关系 r r r, ε \varepsilon ε和 R R R表示G中实体和关系的集合

一个项目 v ∈ V v\in V v∈V可以与G中的一个或者多个实体 e e e相关联; N ( v ) N(v) N(v)指的是v周围的相邻实体。鉴于交叉矩阵Y和知识图G,该文试图预测是否用户u存在对项目v的潜在兴趣。最终目标是学习预测函数 y ^ u v = F ( u , v , Θ ) \hat{y}_{uv}=F(u,v,\Theta) y^uv=F(u,v,Θ),其中 y ^ u v \hat{y}_{uv} y^uv是用户u与项目v有交互的概率, Θ \Theta Θ为函数 F F F的模型参数

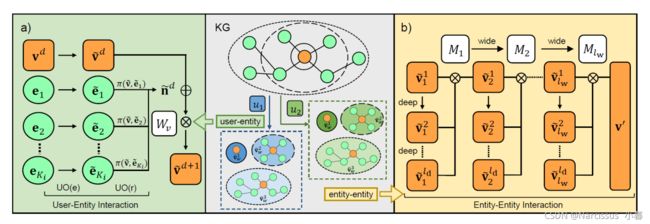

MVIN框架,通过用户-实体和实体-实体交互增强了项目表示

对于用户-实体交互,包含(a)面向用户的关系注意 U O ( r ) UO(r) UO(r)和实体投影模块 U O ( e ) UO(e) UO(e),从用户的角度收集KG实体信息

对于实体-实体交互,混合层允许MVIN不仅使用(a)聚合高阶连接信息,并且(b)按层混合GCN信息

1. user-entity interaction (模型目的之一为丰富用户-实体交互)

为了提高面向用户的性能,我们将用户实体交互分为面向用户的关系关注、面向用户的实体投影和kg增强的用户表示

用户和物品定义为 U = { u 1 , u 2 , … } , V = { v 1 , v 2 … } U=\{ u_1,u_2, \dots\} , V=\{ v_1,v_2 \dots \} U={u1,u2,…},V={v1,v2…}

三元组为 { ( h , r , t ) ∣ h , t ∈ ε , r ∈ R } \{ (h,r,t)|h,t \in \varepsilon, r \in \mathbb{R} \} {(h,r,t)∣h,t∈ε,r∈R}

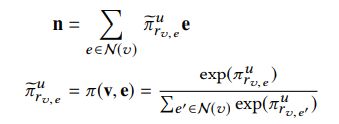

1.1 user-oriented relation attention 面向用户的关系注意力

当MVIN从KG中给定商品的邻域收集信息时,它会以用户特有的方式为该商品的某个关系打分。所提出的面向用户的关系注意力机制利用给定用户、产品和关系的信息来确定连接到该产品的哪个邻居信息更加丰富。因此,领域的每个实体权重由分数 π r v , e u \pi_{r_{v,e}}^u πrv,eu表示, u u u表示不同的用户, r v , e r_{v,e} rv,e表示从实体 v v v到相邻实体 e e e的关系 r r r。分数计算公式如下:

该论文聚合加权邻域实体嵌入,并生成最终面向用户的邻域信息 n n n如下:

论文将关系 r r r,项目表示 v v v和用户嵌入 u u u进行连接,然后将他们转化为最终面向用户的分数 π r v , e u \pi_{r_{v,e}}^u πrv,eu,计算如下:

![]()

其中 W r ∈ R 3 s W_r \in R^{3s} Wr∈R3s和 b r ∈ R b_r \in R br∈R为可训练参数

1.2 User-Oriented Entity Projection

为了进一步增加用户实体的交互,本文提出了一个面向用户的实体投影模块

对于不同的用户,KG实体应该有不同的信息量来描述其属性。实体投影机制通过将每个实体 e e e投影到用户透视图 u u u来细化实体嵌入。公式包括线性和非线性:

e ~ = W e ( e + u ) + b e e ~ = σ ( W e ( e u ) + b e ) \widetilde{e}=W_e(e+u)+b_e \\ \widetilde{e}=\sigma(W_e(e_u)+b_e) e =We(e+u)+bee =σ(We(eu)+be)

其中 W e W_e We和 b e b_e be是可训练参数, σ \sigma σ是非线性激活函数

面向用户的实体投影模块可以看作是增加用户实体交互的早期层。然后面向用户的关系注意模块以用户特有的方式聚合临近信息

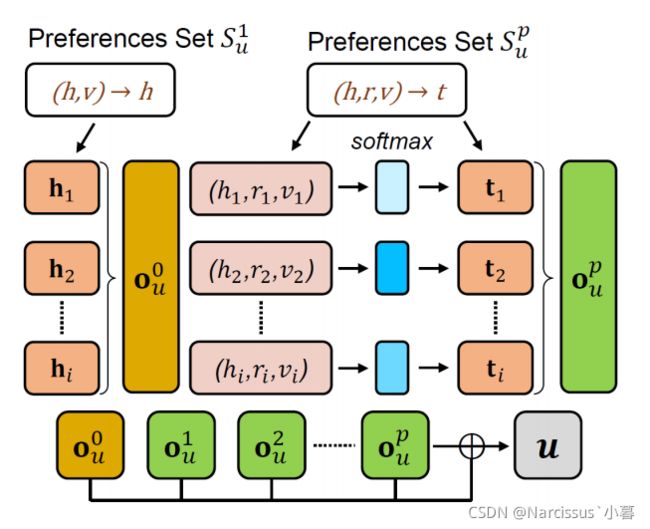

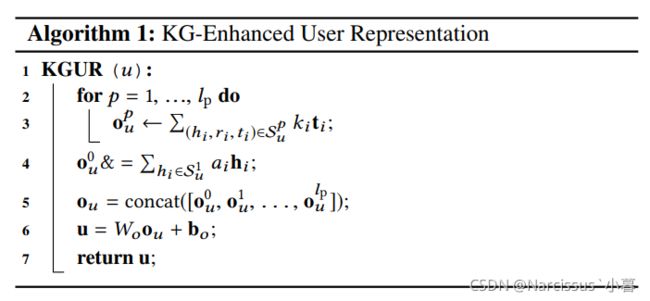

1.3 KG-Enhanced User Representation

为了提高接收到的面向用户的信息的质量,我们根据包含用户单击信息的KG实体来丰富用户表示。从KG中获取用户偏好信息需要咨询KG中所有相关实体,实体之间的联系可以帮助我们找到潜在的用户兴趣。用户兴趣的提取符合所提出的面向用户的模块

在此基础上,用KG实体对用户进行建模,并通过KG增强的用户表示来增强面向用户的信息,整体流程及算法如下:

Preference Set

用户 u u u交互过的物品集合为 V u = { v ∣ y u v = 1 } V_u=\{v|y_{uv}=1\} Vu={v∣yuv=1}

用这些物品作为起点,探索偏好集

ε u p = { t ∣ ( h , r , t ) ∈ G a n d h ∈ ε u p − 1 } , p = 1 , 2 … l p S u p = { ( h , r , t ) ∣ ( h , r , t ) ∈ G a n d h ∈ ε u p − 1 } , p = 1 , 2 … l p ε u 0 = V u \varepsilon_u^p=\{t|(h,r,t) \in \mathbb{G} and h \in \varepsilon_u^{p-1} \},p=1,2 \dots l_p \\ S_u^p=\{(h,r,t)|(h,r,t) \in \mathbb{G} and h \in \varepsilon_u^{p-1} \},p=1,2 \dots l_p \\ \varepsilon_u^0=V_u εup={t∣(h,r,t)∈Gandh∈εup−1},p=1,2…lpSup={(h,r,t)∣(h,r,t)∈Gandh∈εup−1},p=1,2…lpεu0=Vu

Preference Propagation 传播偏好

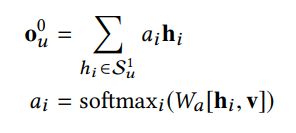

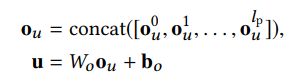

KG增强的用户表示由传播偏好集 S u S_u Su生成的用户偏好响应 o u o_u ou构建

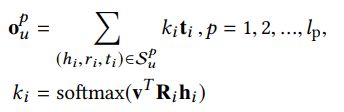

首先,我们定义hop 0 处的用户偏好响应为 o i 0 o_i^0 oi0,该响应由用户点击的物品 h i ∈ S u 1 h_i \in S_u^1 hi∈Su1计算得到;考虑到不同的项目表示, v v v对用户偏好响应的影响程度不同。 W a W_a Wa是一个可训练参数

在hop-p (其中p>0),用户偏好响应 o i p o_i^p oip计算为对应关联概率 ( k i ) (k_i) (ki)加权后的尾的和。其中关系空间嵌入 R R R有助于计算项目表示v和实体表示h的相关性

在整合所有用户偏好响应 o i p o_i^p oip后,生成最终的用户偏好嵌入。其中 W o W_o Wo和 b o b_o bo是可训练的参数

2 Entity-Entity Interaction (模型目的之二为细化实体-实体交互)

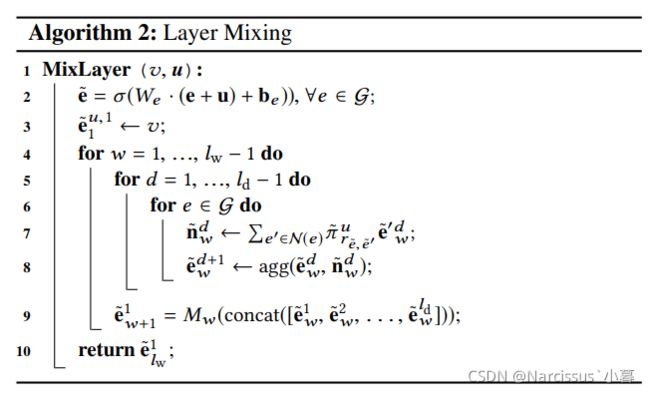

在实体-实体交互中,该论文提出了 层混合 ,并着重于捕获高阶连通性和分层混合信息。分别从深度和广度来介绍这两个方面,该过程如下算法:

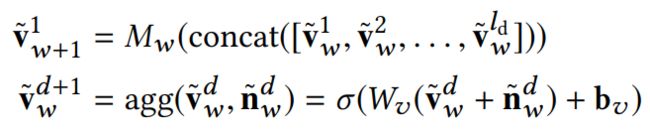

对于深度,该论文整合面向用户的信息,收益高阶连接信息来生成实体 v ~ w d \widetilde{v}_w^d v wd,和领域信息 n ~ w d \widetilde{n}_w^d n wd,随后聚合生成下一个表示 v ~ w d + 1 \widetilde{v}_w^{d+1} v wd+1

利用分层的实体宽度差异,允许不同级别的实体之间的比较。该论文混合了不同距离的邻居的特征表示,以进一步提高后序推荐的性能。

在每一层,都利用层矩阵混合分层的GCN信息 ( v ~ w 1 , v ~ w 2 … , v ~ w d ) (\widetilde{v}_w^1,\widetilde{v}_w^2 \dots ,\widetilde{v}_w^d) (v w1,v w2…,v wd),生成下一个表示 v ~ w + 1 1 \widetilde{v}_{w+1}^1 v w+11

3 Learning Algorithm

对于给定的用户-物品对 ( u , v ) (u,v) (u,v)(对应算法3的line2),首先生成用户表示 u u u(line7)和物品表示 v ′ v' v′(line 8),使用他们来计算点击概率 y ^ u v \hat{y}_{uv} y^uv,其中 σ ′ \sigma' σ′为s函数

y ^ u v = σ ′ ( u T v ′ ) \hat{y}_{uv}=\sigma'(u^Tv') y^uv=σ′(uTv′)

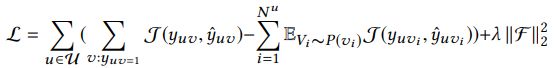

为了优化模型,该论文训练中使用负采样,损失函数为

J J J为交叉熵损失函数, P P P为负采样分布并且符合均匀分布, N u N^u Nu是对用户 u u u负采样的个数,最后一项为 L 2 L_2 L2正则化项

3.1 Fixed-size sampling 固定大小采样

在真实世界的知识图中, N N N的大小变化很大。 S u p S_u^p Sup可能随着hop数量增长过快。为了保持计算效率,采用固定大小的策略,并对实体集进行采样。对于每个实体 v v v均匀采样一个领域 N ′ ( v ) N'(v) N′(v),其中 ∣ N ′ ( v ) ∣ = K n |N'(v)|=K_n ∣N′(v)∣=Kn,对于hop-p, ∣ S u p ∣ = K m |S_u^p|=K_m ∣Sup∣=Km

3.2 Stage-wise Training

为了解决固定大小的采样策略可能会限制所有实体的使用,最近提出了分段训练的方法,从KG中收集 更多的实体关系,以接近整个邻域的全景。在每个阶段,阶段式训练将重新取样另一组实体,以允许MVIN从KG收集更多的实体信息。分段训练的算法如以下算法所示

3.3 Time Complexity Analysis

在每个batch中,MVIN的时间成本主要来自生成KG增强的用户表示和混合层。用户表示生成的计算复杂度为 O ( l p K m s 2 ) O(l_pK_ms^2) O(lpKms2),用于计算所有 l p l_p lp层的相关概率 k i k_i ki。混合层要通过deep layer l d l_d ld和wide layer l w l_w lw进行聚合,其计算复杂度为 O ( K n l w l d s 2 ) O(K_n^{l_wl_d}s^2) O(Knlwlds2)。因此整体的训练复杂度是 O ( l p K m s 2 + K n l w l d s 2 ) O(l_pK_ms^2+K_n^{l_wl_d}s^2) O(lpKms2+Knlwlds2)。

实验

数据集

该论文使用三个真实世界的数据集:

1)ML-1M

是个关于电影推荐的数据集,由来自6036个用户的,对于2445个项目的大约100万个明确的评分(范围从1到5)。它的KGs是由微软satori构建的,其置信度大于0.9

2)LFM-1b

一个音乐数据集,记录了艺术家、专辑、曲目、用户以及个人的收听事件。包含了来自12134个用户的15471个项目的大约300万个评级。它的KGs是通过标题匹配建立的

3)AZ-book.

记录了用户对于图书的偏好。该数据集记录了关于用户、项目、评级和事件时间戳的信息。该数据集包含了大约50万条来自7000名用户对于9854个项目的记录。它的KGs是通过标题匹配建立的

该论文将评分装换为二进制的反馈:如果项目被用户评分,则条目标记为1;否则标记为0。

对比的baseline

1)FM

一种特征交互建模因子分解方法。本篇论文将用户、项目和相关KG知识的标识连接起来作为输入特征

2)NFM

一种基于因子分解的方法,无缝的结合了神经网络的线性和非线性来建模用户-项目交互

3)GC-MC

用于矩阵完成的基于图的紫铜编码器框架,是一个基于GCN的推荐模型。该baseline通过图卷积矩阵完成对于用户项的编码

4)CKE

一种基于正则化的方法。该模型结合了结构、文本和视觉知识,并共同学习推荐。

5)MCRec

通过更加精细的元路径来连接用户和项目的协同关注模型,该模型能学习到上下文表示。共同关注机制以相互增强的方式改进了基于元路径的上下文、用户和项目表示

6)KGCN

利用GCN从KG收集高阶邻域信息。为了找到用户可能更感兴趣的邻域,它使用用户表示关注不同的关系来计算邻域的权重

7)RippleNet

一种类似记忆网络的方法,通过用户的相关项目来表示用户。该模型使用KG中的所有相关实体来传播用户的推荐表示

8)KGAT

一个配备了图attention网络的GNN推荐模型。使用知识图和用户项目图的混合结构作为协作知识图。采用了一种注意力机制来区分邻居的重要性

实验结果

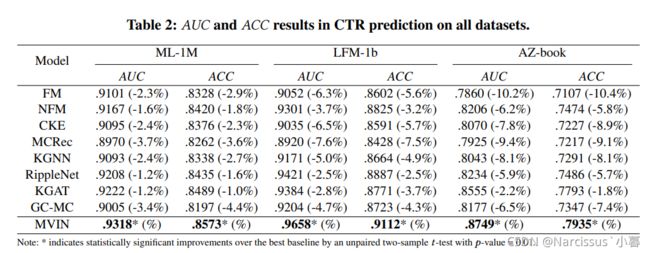

MVIN和基线预测点击率(CTR)的结果,即以用户-商品对作为输入,预测用户参与该商品的概率。实验采取二值分类中常用的AUC和ACC来评价CTR预测的性能

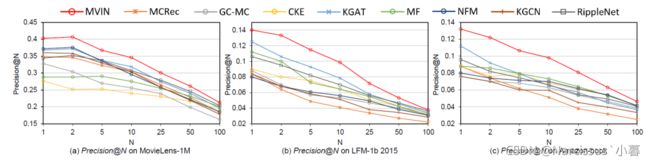

本文还测试了每个用户的 top-N recommendation,为每个用户选择N个预测点击概率最高的项目,使用 precision@N对推荐集进行评估,结果如下:

可以看出MVIN具有较好的性能,同时在 top-N 推荐中具有较为突出的表现

基于路径的两种baseline - RippleNet 和 KGAT 优于基于CF的方法 FM 和NFM, 说明使用KG有助于提升推荐效果。RippleNet 和 KGAT 虽然有较为优异的性能,但任然没有超过MVIN,这是因为 RippleNet 既没有将用户点击历史条目引入用户表示,也没有引入高阶连接(high-order connectivities). KGAT 没有混合GCN层信息,在收集KG信息的时候没有考虑用户偏好

针对 KGCN 和 MCRec, 他们相对较差的性能是由于没有充分利用用户点击项目的信息。相比之下,MVIN通过用户点击KG中的项目和所有相关实体来丰富用户表示,然后对附近的实体进行加权,对重要的实体进行强调。KGCN只在每一层使用GCN,不允许在相邻层上进行对比。MCRec一个缺点是需要更加精细定义的元路径,需要额外的工作及领域知识

基于CF的NFM在 LFM-1b和AZ-books上取得了超过KGCN的结果,这是因为通过嵌入链接实体丰富了他的项目表征。此外NFM的设计涉及建模高阶和非线性特征交互,从而更好的捕捉用户和物品嵌入之间的交互。这些观测结果符合论文[16]的结论

基于正则化的CKE表现比NFM要差。因为CKE没有充分利用KG,他只是由KG的正确三联体正则化 (correct triplets), 此外,CKE忽略了高阶连接

虽然GC-MC在用户和物品表示中引入了高阶连通性,但由于只利用了用户-物品二部图(bipartite graph),忽略了KG实体之间的语义信息,因此性能相对较差

消融实验

User-Oriented Information

在去除所提出的面向用户的关系注意 U O ( r ) UO(r) UO(r)和面向用户的实体投影 U O ( e ) UO(e) UO(e)模块之后, M V I N w / o U O ( r ) MVIN_{w/o UO(r)} MVINw/oUO(r)和 M V I N w / o U O ( e ) MVIN_{w/o UO(e)} MVINw/oUO(e)在所有的数据集中性能都不如WVIN。说明在聚合实体和关系时考虑用户偏好可以提高推荐结果

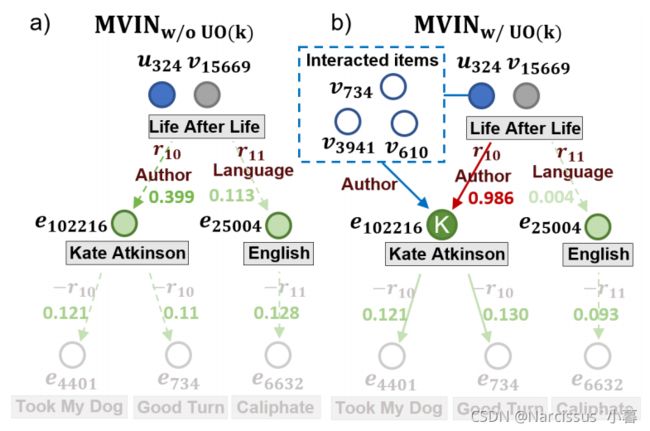

KG-enhanced User-Oriented Information

为了增强面向用户的信息,该论文使用KG信息作为预处理步骤来丰富用户表示。在消融实验中,将没有KG增强的面向用户信息的MVIN表示为 M V I N w / o U O ( k ) MVIN_{w/o UO(k)} MVINw/oUO(k),比较后发现MVIN的性能远远大于 M V I N w / o U O ( k ) MVIN_{w/o UO(k)} MVINw/oUO(k),这证明KG增强的用户表示能够改善面向用户的信息

Mixing layer-wise GCN

在混合层中,宽部分 M L ( w ) ML(w) ML(w)允许MVIN表示一般的层邻域混合。为了研究 M L ( w ) ML(w) ML(w)的作用,本文从MVIN中去除掉 M L ( w ) ML(w) ML(w),记为 M V I N w / o M L ( w ) MVIN_{w/o ML(w)} MVINw/oML(w),比较后发现这样导致了性能的下降,这表明混合来自不同距离的特性提高了推荐性能

Mixing layer-wise GCN information (在高邻域采样尺寸 K n K_n Kn下)

结果表明,在同质图中,混合层效益取决于同质水平。在MVIN中,混合层工作在KGs中,即异构图。研究发现,当 K n K_n Kn比较大的时候,KG中的实体链接更多不同的实体,类似于低同质水平。下图说明ML(w)在异质图中是有效的。混合层不仅提高了MVIN的性能,而且对于较大 K n K_n Kn的MVIN来说是必不可少的

High-Order connectivity information

除了混合层的宽部分,本文提出的深部分允许MVIN聚合高阶连通性消息。在去除混合层(ML)之后, M V I N w / o M L MVIN_{w/o ML} MVINw/oML表现比较差,说明了高阶连通性的重要性。这一观察结果与工作[15,16,10]一致

Stage-wise Training

去除 stage-wise Traning(SW),表示为 M V I N w / o S W MVIN_{w/o SW} MVINw/oSW,性能有了较大的恶化。这表明阶段训练通过从KG手机更多的实体关系来近似整个邻居的全景,帮助MVIN获得更好的性能。与KGAT相比, M V I N w / o S W MVIN_{w/o SW} MVINw/oSW表明KG中有限数量的实体,但仍然显著优于所有的baseline(p-value=0.01),这再次说明了MVIN的有效性

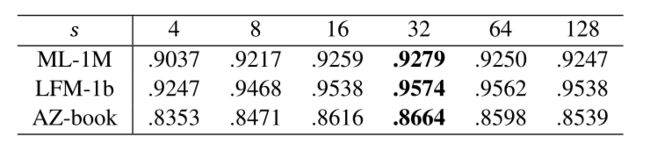

参数敏感性

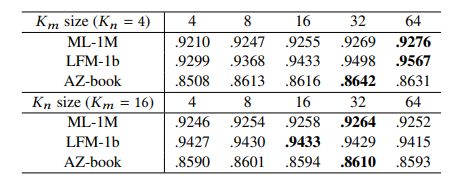

- 偏好集样本大小 K m K_m Km

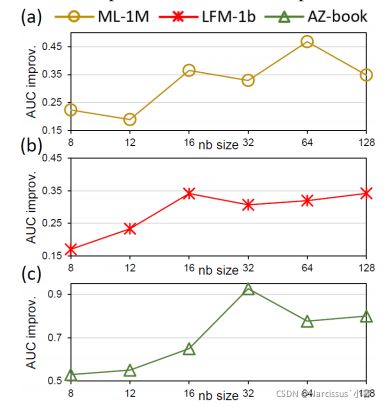

当 K m K_m Km设置为较大值的时候,MVIN性能有所提高(AZ-book)除外。当用户交互项很少的时候,一个小的 K m K_m Km依旧允许MVIN找到足够的信息来表示用户 - 邻域实体样本量 K n K_n Kn

可以看出当邻域节点大小设置为16或者32的时候,MVIN能实现最佳性能,这可能是由于 K n K_n Kn过大时会引入噪声

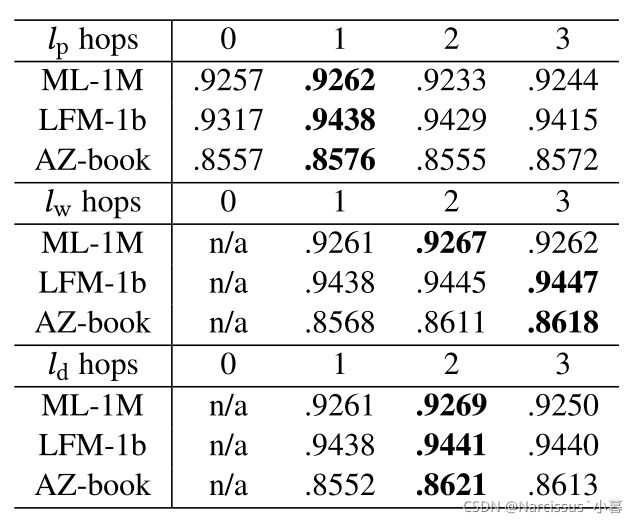

- 首选跳数 l p l_p lp

可以看出当 l p h o p l_p hop lphop设置为1的时候,MVIN的性能最好。而值越大,相关实体越少,噪声越大 - wide hop 数量 l w l_w lw 和deep hop 数量 l d l_d ld

当条数设置为2/1的时候,性能更好,说明增加跳数可以实现高阶连通性的建模,从而提高性能。但是当跳数更大的时候,性能会下降。说明考虑实体之间的二阶关系即可 - 嵌入尺寸 s s s

可以看出增大 s s s最初会提高性能,因为较大的 s s s包含更多有用的用户和实体信息,过大的s则会导致过拟合

总结

本文提出了MVIN,一种基于GNN的推荐模型,从用户视图和实体视图两方面改进了项目的表示

该模型基于用户视图和实体视图的特性,再用户试图中收集个性化的知识信息并进一步考虑layers(实体视图)之间的差异,最终增强项目表示

在实际数据上的测试验证了MVIN的优越性,消融实验验证了各部分的有效性。提出的模块是通用的,所以可以应用于以知识图形式利用结构化信息的场合,比如社交网络与实体上下文中,能够有较为广泛的应用

Reference

[1]Yehuda Koren, Robert Bell, and Chris Volinsky. 2009. Matrix factorization techniques for recommender systems. Computer 42, 8.

[2]Steffen Rendle, Zeno Gantner, Christoph Freudenthaler, and Lars Schmidt-Thieme.2011. Fast Context-aware Recommendations with Factorization Machines. In Proceedings of the 34th International ACM SIGIR Conference (SIGIR ’11). ACM, New York, NY, USA, 635–644. https://doi.org/10.1145/2009916.2010002

[3]Mohsen Jamali and Martin Ester. 2010. A Matrix Factorization Technique with Trust Propagation for Recommendation in Social Networks. In Proceedings of the Fourth ACM Conference on Recommender Systems (Barcelona, Spain) (RecSys’10). ACM, New York, NY, USA, 135–142. https://doi.org/10.1145/1864708.1864736

[4]Fuzheng Zhang, Nicholas Jing Yuan, Defu Lian, Xing Xie, and Wei-Ying Ma. 2016. Collaborative Knowledge Base Embedding for Recommender Systems. In Proceedings of the 22Nd ACM SIGKDD International Conference on Knowledge Discovery and Data Mining (KDD ’16). 353–362. https://doi.org/10.1145/2939672.2939673

[5]Lei Zheng, Vahid Noroozi, and Philip S. Yu. 2017. Joint Deep Modeling of Users and Items Using Reviews for Recommendation. CoRR abs/1701.04783 (2017). arXiv:1701.04783 http://arxiv.org/abs/1701.04783

[6]Hongwei Wang, Fuzheng Zhang, Jialin Wang, Miao Zhao, Wenjie Li, Xing Xie, and Minyi Guo. 2018. Ripple Network: Propagating User Preferences on the Knowledge Graph for Recommender Systems. CoRR abs/1803.03467 (2018). arXiv:1803.03467 http://arxiv.org/abs/1803.03467

[7]Thomas N. Kipf and Max Welling. 2016. Semi-Supervised Classification with Graph Convolutional Networks. arXiv e-prints, Article arXiv:1609.02907 (Sep 2016), arXiv:1609.02907 pages. arXiv:1609.02907 [cs.LG]

[8]Elnaz Barshan and Paul Fieguth. 2015. Stage-wise Training: An Improved Feature Learning Strategy for Deep Models. In Proceedings of the 1st International Workshop on Feature Extraction: Modern Questions and Challenges at NIPS 2015 (Proceedings of Machine Learning Research). PMLR, 49–59. http://proceedings. mlr.press/v44/Barshan2015.html

[9]Hongwei Wang, Miao Zhao, Xing Xie, Wenjie Li, and Minyi Guo. 2019. Knowledge Graph Convolutional Networks for Recommender Systems. CoRR abs/1904.12575 (2019). arXiv:1904.12575 http://arxiv.org/abs/1904.12575

[10]Rex Ying, Ruining He, Kaifeng Chen, Pong Eksombatchai, William L. Hamilton, and Jure Leskovec. 2018. Graph Convolutional Neural Networks for Web-Scale Recommender Systems. CoRR abs/1806.01973 (2018). arXiv:1806.01973 http://arxiv.org/abs/1806.01973

[11]Hongwei Wang, Fuzheng Zhang, Xing Xie, and Minyi Guo. 2018. DKN:Deep Knowledge-Aware Network for News Recommendation. arXiv e-prints, Article arXiv:1801.08284 (Jan 2018), arXiv:1801.08284 pages. arXiv:1801.08284 [stat.ML]

[12]Binbin Hu, Chuan Shi, Wayne Xin Zhao, and Philip S. Yu. 2018. Leveraging Metapath Based Context for Top- N Recommendation with A Neural Co-Attention Model. In Proceedings of the 24th ACM SIGKDD International Conference on Knowledge Discovery (KDD ’18). https://doi.org/10.1145/3219819.3219965

[13]Rik Koncel-Kedziorski, Dhanush Bekal, Yi Luan, Mirella Lapata, and Hannaneh Hajishirzi. 2019. Text Generation from Knowledge Graphs with Graph Transformers. In Proceedings of the 2019 Conference of the North American Chapter of the Association for Computational Linguistics. 2284–2293. https://doi.org/10.18653/v1/N19-1238

[14]Mingxiao An, Fangzhao Wu, Chuhan Wu, Kun Zhang, Zheng Liu, and Xing Xie. 2019. Neural News Recommendation with Long- and Short-term User Representations. https://doi.org/10.18653/v1/P19-1033

[15]Hongwei Wang, Fuzheng Zhang, Mengdi Zhang, Jure Leskovec, Miao Zhao,Wenjie Li, and Zhongyuan Wang. 2019. Knowledge Graph Convolutional Networks for Recommender Systems with Label Smoothness Regularization. CoRR abs/1905.04413 (2019). arXiv:1905.04413 http://arxiv.org/abs/1905.04413

[16]Xiang Wang, Xiangnan He, Yixin Cao, Meng Liu, and Tat-Seng Chua. 2019. KGAT: Knowledge Graph Attention Network for Recommendation. CoRR abs/1905.07854 (2019). arXiv:1905.07854 http://arxiv.org/abs/1905.07854