机器学习4-线性回归算法推导

目录

一、深入理解回归:

二、误差分析:

三、最大似然估计:

四、高斯分布-概率密度函数:

五、误差总似然:

六、最小二乘法MSE:

七、总结归纳:

一、深入理解回归:

回归简单来说就是“回归平均值”(regression to the mean)。但是这里的 mean 并不是把 历史数据直接当成未来的预测值,而是会把期望值当作预测值。 追根溯源回归这个词是一个叫高尔顿的人发明的,他通过大量观察数据发现:父亲比较高,儿子也比较高;父亲比较矮,那么儿子也比较矮!正所谓“龙生龙凤生凤老鼠的儿子会打洞”!但是会存在一定偏差~

父亲是 1.98,儿子肯定很高,但有可能不会达到1.98。

父亲是 1.69,儿子肯定不高,但是有可能比 1.69 高。

大自然让我们回归到一定的区间之内,这就是大自然神奇的力量。

高尔顿是谁?达尔文的表弟,这下可以相信他说的十有八九是对的了吧!

人类社会很多事情都被大自然这种神奇的力量只配置:身高、体重、智商、相貌……

这种神秘的力量就叫正态分布。大数学家高斯,深入研究了正态分布,最终推导出了线性回归的原理:最小二乘法 !

!

接下来,我们跟着高斯的足迹继续向下走~

二、误差分析:

三、最大似然估计:

最大似然估计(maximum likelihood estimation, MLE)一种重要而普遍的求估计量的方法。最大似然估计明确地使用概率模型,其目标是寻找能够以较高概率产生观察数据的系统发生树。最大似然估计是一类完全基于统计的系统发生树重建方法的代表。

是不是,有点看不懂,太学术了,我们举例说明~

假如有一个罐子,里面有黑白两种颜色的球,数目多少不知,两种颜色的比例也不知。我们想知道罐中白球和黑球的比例,但我们不能把罐中的球全部拿出来数。现在我们可以每次任意从已经摇匀的罐中拿一个球出来,记录球的颜色,然后把拿出来的球再放回罐中。这个过程可以重复,我们可以用记录的球的颜色来估计罐中黑白球的比例。假如在前面的一百次重复记录中,有七十次是白球,请问罐中白球所占的比例最有可能是多少?请告诉我答案!

很多小伙伴,甚至不用算,凭感觉,就能给出答案:70%!

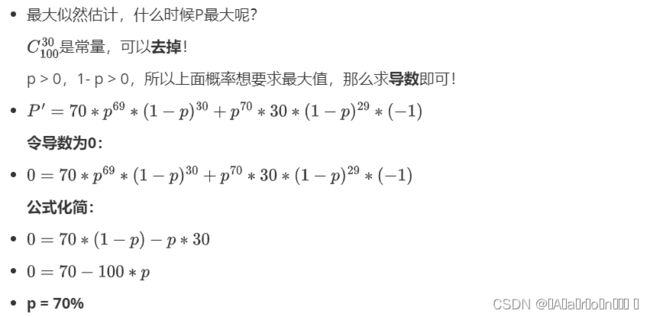

下面是详细推导过程:

-

最大似然估计,计算

-

白球概率是p,黑球是1-p(罐子中非黑即白)

-

罐子中取一个请问是白球的概率是多少?

-

p

-

-

罐子中取两个球,两个球都是白色,概率是多少?

-

p^2

-

-

罐子中取5个球都是白色,概率是多少?

-

p^5

-

-

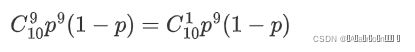

罐子中取10个球,9个是白色,一个是黑色,概率是多少呢?

-

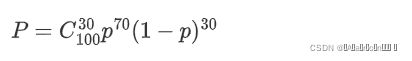

罐子取100个球,70次是白球,30次是黑球,概率是多少?

四、高斯分布-概率密度函数:

四、高斯分布-概率密度函数:

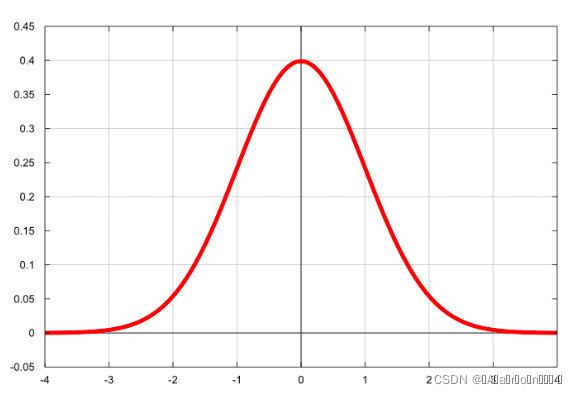

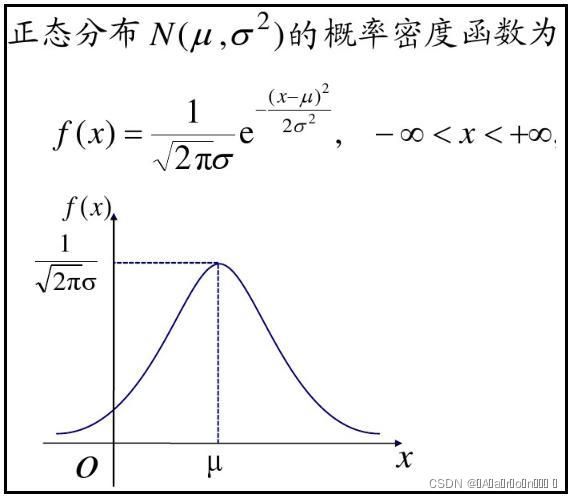

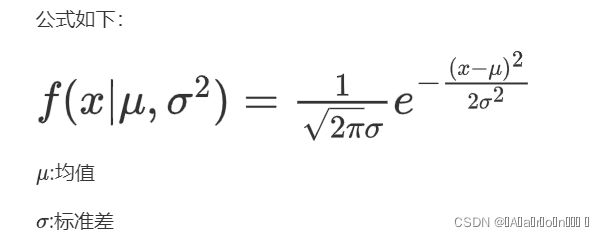

最常见的连续概率分布是正态分布,也叫高斯分布,而这正是我们所需要的,其概率密度函数如下:

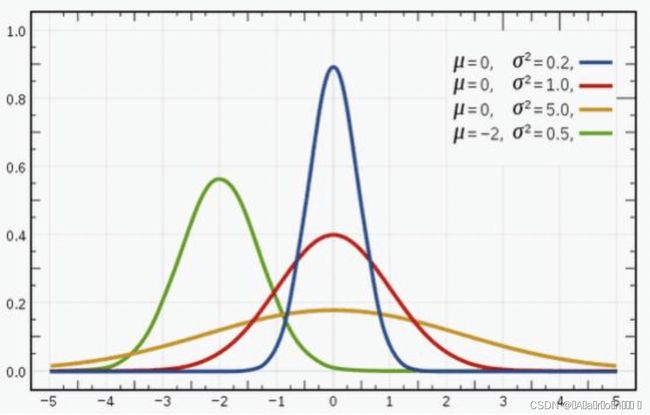

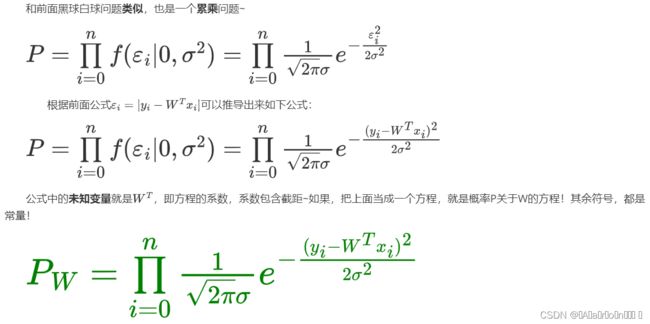

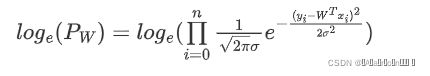

随着参数μ和σ变化,概率分布也产生变化。 下面重要的步骤来了,我们要把一组数据误差出现的总似然,也就是一组数据之所以对应误差出现的整体可能性表达出来了,因为数据的误差我们假设服从一个高斯分布,并且通过截距项来平移整体分布的位置从而使得μ=0,所以样本的误差我们可以表达其概率密度函数的值如下:

五、误差总似然:

现在问题,就变换成了,求最大似然问题了!不过,等等~

累乘的最大似然,求解是非常麻烦的!

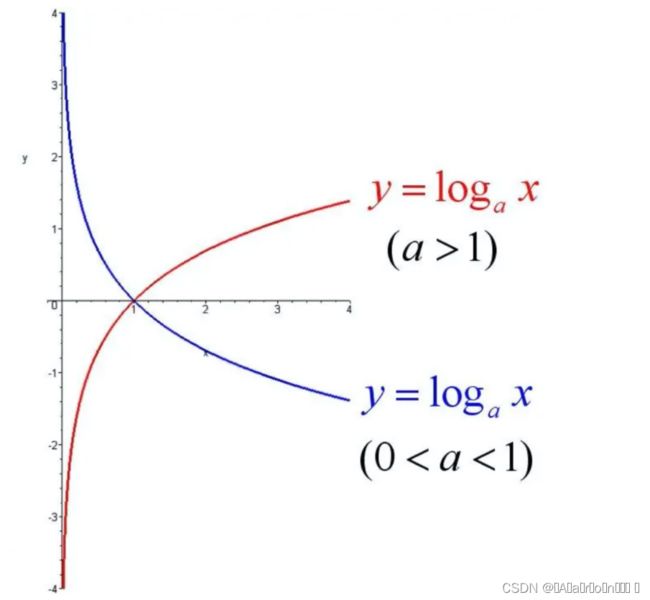

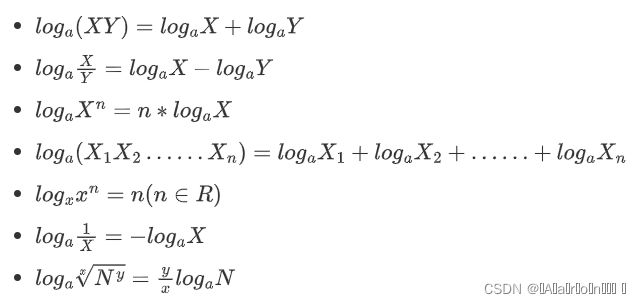

接下来,我们通过,求对数把累乘问题,转变为累加问题(加法问题,无论多复杂,都难不倒我了!)

六、最小二乘法MSE:

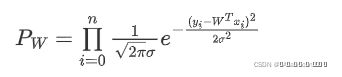

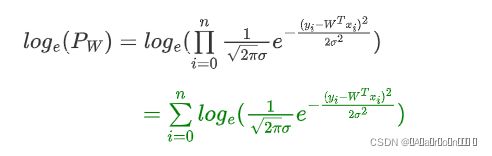

根据对数,单调性,对上面公式求自然底数e的对数,效果不变~

接下来 log 函数继续为你带来惊喜,数学上连乘是个大麻烦,即使交给计算机去求解它也得哭出声来。惊喜是:

累乘问题变成累加问题~

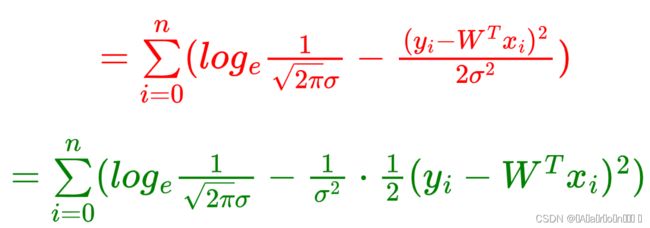

乘风破浪,继续推导--->

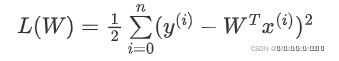

上面公式是最大似然求对数后的变形,其中\pi、\sigma都是常量,而(y_i - W^Tx_i)^2肯定大于零!上面求最大值问题,即可转变为如下求最小值问题:

L代表Loss,表示损失函数,损失函数越小,那么上面最大似然就越大~

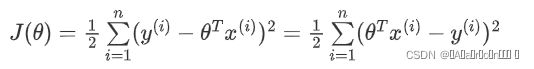

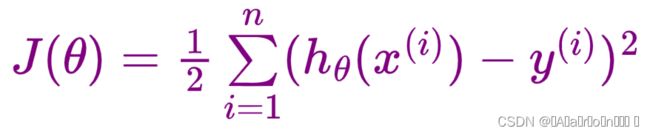

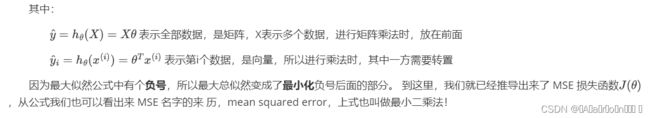

有的书本上公式,也可以这样写,用J(\theta)表示一个意思,\theta 的角色就是W:

进一步提取:

七、总结归纳:

这种最小二乘法估计,其实我们就可以认为,假定了误差服从正太分布,认为样本误差的出现是随机的,独立的,使用最大似然估计思想,利用损失函数最小化 MSE 就能求出最优解!所以反过来说,如果我们的数据误差不是互相独立的,或者不是随机出现的,那么就不适合去假设为正太分布,就不能去用正太分布的概率密度函数带入到总似然的函数中,故而就不能用 MSE 作为损失函数去求解最优解了!所以,最小二乘法不是万能的~

还有譬如假设误差服从泊松分布,或其他分布那就得用其他分布的概率密度函数去推导出损失函数了。

所以有时我们也可以把线性回归看成是广义线性回归。比如,逻辑回归,泊松回归都属于广义线性回归的一种,这里我们线性回归可以说是最小二乘线性回归。