《因果科学周刊》第7期:2021因果强化学习第一课

为了帮助大家更好地了解因果科学的最新科研进展和资讯,我们因果科学社区团队本周整理了第7期《因果科学周刊》,推送近期因果科学领域值得关注的论文和资讯信息。本期的主题是“因果强化学习”,它在众多通向通用人工智能的路径中备受关注,我们非常荣幸邀请到了剑桥博士陆超超,研究方向是因果强化学习,一位在此领域特别有活力的青年科学家,他精心为大家挑选了因果强化学习领域的10篇干货论文,并给本期周报撰写了前言、背景动机,而且还盘点了Judea Peal、Bernhard Schölkopf 、Yann Lecun 、 Gary Marcus 、Elias Bareinboim 这几位AI顶级专家对因果强化学习的独到见解,非常生动地为大家带来了2021年因果强化学习入门的第一课!

本期作者:陆超超 Alchemist 方文毅 许雄锐 陈晗曦 赵江杰 汪昕 李欣怡 陈正鸣 赵江杰 卓卓 龚鹤扬 常政

前言

近些年来,在游戏领域强化学习取得了巨大的进展,已经能够打败人类最顶级的玩家。但在现实生活中,我们却罕见强化学习的成功应用。带着这种疑惑,我们将探访机器学习中一个全新的领域——因果强化学习。因果强化学习不仅可以为传统强化学习中那些棘手的问题提供一种新的解决方案,更重要的是,它还为通用人工智能提供一种解决思路。隐藏在因果强化学习背后的哲学理念是迷人的:回顾科学发展的历史,人类也是走着相似的道路。具体来说,人类是在不断地与自然交互探索的过程中总结经验和规律,然后利用这些经验和规律更好地指导下一次与自然的交互探索,以此来不断地发展进步。因果强化学习就是在模仿人类的这种行为:智能体在于环境的交互过程中学习和发现其因果关系,然后利用学到的因果关系来优化自己的策略以指导下一步的交互。正是由于这个原因,因果强化学习可以被视为一种通用的学习算法,在现实生活中有着广泛的应用,比如:计算机视觉、机器人、生物医药、健康医疗、推荐系统,自动驾驶,金融、社会学等等。

本期周刊首先阐述因果强化学习的背景动机,然后罗列一些著名学者对因果强化学习的观点,关于这两部分更加详细的内容请参考文献[1-7]。最后精选了因果强化学习四个主题下的十篇文章。四个主题分别是:去除强化学习算法里的混杂效应、在强化学习中应用反事实框架、因果表示学习、以及使用强化学习的方法进行因果发现。希望能激发相关研究人员进一步的思考。

背景动机

从强化学习的角度来看,利用因果推理可以解决强化学习中最根本的缺陷 [1,2,3,4]。目前大多数的强化学习系统只能在游戏或者类似游戏的场景中取得很好的效果,比如Atari和围棋。这些场景通常具有两个共同点:(1)人们可以很容易获取充足的数据;(2)场景本身有着清晰定义的规则。但现实中大部分场景无法满足这两个要求,这就导致强化学习很难应用在具体的实际任务中。幸运的是,这两个强化学习中最根本的问题恰好可以通过因果推理来解决。对于第一个问题,其主要原因是,与监督学习中的标签信息相比,强化学习中的激励信号要稀疏很多。特别是与强化学习中高维度的状态信息相比,这么稀疏的激励信号很难指导智能体在如此巨大的状态空间进行有效地探索,这就意味着智能体需要大量的数据才能得到足够多的激励信号来完成探索任务。我们可以利用因果推理从历史数据中推断状态,动作和激励信号之间的因果关系,以此来优化下一步的探索策略,进而帮助智能体更高效、更有效地学习价值函数或策略。对于第二个问题,我们可以通过因果推理中干预的概念更好地理解强化学习中的动作的概念,也就是说,智能体可以利用动作(干预)来执行因果发现任务。更具体地说,智能体可以根据其当前状态,通过采取不同的动作(干预)来观察环境状态的变化,以此能更好地发现环境的因果关系,使场景中的规则更加清晰,这样可以帮助智能体更快地完成学习任务。

从自然科学的角度来看,因果强化学习与人们发现自然规律的两种过程是一致的 [1,2]。在爱因斯坦之前,人们观察到的物理现象相对比较简单。例如,伽利略通过做些自由落体或者小球在斜坡往下滚动的实验,得到一些简单的数据就能归纳出一些公式进而发展出一套理论,然后通过这些理论演绎出一些物理性质来对未来进行预测。但从爱因斯坦开始,由于物理现象越来越复杂,或者实验越来越困难甚至根据当时的条件根本没有办法进行实验,科学家们就反其道而行之。具体来说,他们先假设一些物理性质(比如对称性),然后根据这个假设发展出一套理论(比如相对论),最后可能过了几十年等实验条件成熟之后再做实验验证这套理论。因果强化学习恰好包含了这两个相反的科学发现过程。前者就是强化学习的过程,智能体通过不断的与环境交互作用(做实验)来得到一些结论,后者就是因果推理的过程,先给出一些假设(因果图),然后根据这些假设得出一些因果的结论,最后再通过实验去验证这些结论。因此,因果强化学习与人们发现自然规律的过程是一致的。

从认知科学的角度来看,因果强化学习与人们的认知过程是一致的 [1,2]。事实上,回顾人类的认知史,我们总是以一种类似因果强化学习的方式前进。更具体地说,人类从与大自然的互动中总结出规则或经验,然后利用这些经验来提高自己在下一次探索中的适应能力。因果强化学习所做的就是模拟人类的这种认知行为:智能体从与环境沟通的过程中学习因果关系,然后根据所学到的因果关系优化其下一步探索的策略。从上面的描述中,我们可以看到这个过程分为三个阶段:与自然或环境交互沟通、学习和总结因果关系、利用学到的因果关系进行下一步探索。令人惊讶的是,我们从历史文献中可以找到很多著名学者的论述来一一佐证这每个阶段的观点。心理学创始人之一Jean Piaget曾说过:“玩是一切新事物的答案。” 这里的“玩”就是指因果强化学习中的动作(干预),所以这句话可以理解为:通过动作(干预)才能得到新的知识(新的因果关系)。蒙纳士大学哲学教授Jakob Hohwy曾说过:“我们对世界的了解,即我们反映其因果结构的方式,受到我们大脑中推理能力的支配。” 这也就是说,我们人类认识世界是通过推理总结其因果结构的方式。因果科学的创始人之一David Hume也说过:“关于事实的所有推理似乎都建立在因果关系上。仅凭因果关系,我们就可以超越记忆和感官的证据。” 换言之,人们可以通过因果关系来指导自己进行下一步对未知世界的探索。

鉴于以上几点,我们有理由相信因果强化学习可以作为实现通用人工智能的一种途径,是终极算法[8]的一种实现方式。

——From 陆超超

学者观点

Judea Pearl [5]

Is RL an exercise in causal inference? Of course! Albeit a restricted one. By deploying interventions in training, RL allows us to infer consequences of those interventions, but ONLY those interventions. A causal model is needed to go BEYOND, i.e., to actions not used in training.

The relation between RL and causal inference has been a topic of some debate. It can be resolved, I believe, by understanding the limits of each.

陆超超简评:Pearl认为强化学习就是在做因果推理,但只是局限在因果之梯的第二层(干预层)。如果利用因果之梯的第三层(反事实推理层)的信息可以更好地进行强化学习。

Bernhard Schölkopf [6]

Question 1: why is RL on the original high-dimensional Atari games harder than on downsampled versions?

Question 2: why is RL easier if we permute the replayed data?

RL is closer to causality research than the machine learning mainstream in that it sometimes effectively directly estimates do-probabilities (on-policy learning). However, as soon as off-policy learning is considered, in particular in the batch (or observational) setting, issues of causality become subtle.

陆超超简评:Schölkopf认为,相比于主流机器学习,强化学习更加接近因果科学的研究,原因与上述Pearl的观点是一致的,都认为强化学习可以做因果之梯第二层的操作。

Yann Lecun and Gary Marcus [7]

[model-free] Reinforcement learning is not the answer, either.

AI systems still need better internal forward models.

Commonsense reasoning remains fundamentally unsolved.

陆超超简评:Lecun和Marcus曾经关于通用人工只能有过一次广为人知的辩论。尽管他们的分歧很多,但他们在七个方面达成了共识,其中上述三点就与因果强化学习相关。首先,他们都认为不基于模型的强化学习不是实现通用人工智能的方式,这一点我们在上面背景动机一节已经部分讨论过,换句话说,为了实现通用人工智能,强化学习需要基于模型,但是需要什么样的模型呢?这就是后面两点所阐述的:需要更好的内部前馈模型和能够进行常识推理的模型,这两点正是因果模型的优势所在 [1,2]。

Elias Bareinboim [4]

Our goal is to provide a cohesive framework that takes advantage of the capabilities of both formalisms (i.e., RL and CI) (from first principles), and that allows us to develop the next generation of AI systems.

陆超超简评:Bareinboim认为结合强化学习和因果推理是开发下一代人工智能系统的关键所在。

精选论文

下面是我们按照因果强化学习的四个主题,精选推荐的十篇论文。

1)去除强化学习算法里的混杂效应(Regarding confounding)

Bareinboim et al. Bandits with Unobserved Confounders: A Causal Approach. 2015

Lu et al. Deconfounding Reinforcement Learning in Observational Settings. 2018

de Haan et al. Causal Confusion in Imitation Learning. 2019

2)在强化学习中应用反事实框架(Regarding counterfactuals)

Bottou et al. Counterfactual Reasoning and Learning Systems: The Example of Computational Advertising. 2013

Buesing et al. Woulda, Coulda, Shoulda: Counterfactually-Guided Policy Search. 2019

Pitis et al. Counterfactual Data Augmentation using Locally Factored Dynamics. 2020

3)因果表示学习(Regarding causal representation learning)

Dietterich et al. Discovering and Removing Exogenous State Variables and Rewards for Reinforcement Learning. 2018.

Zhang et al. Invariant Causal Prediction for Block MDPs. 2020

4)使用强化学习的方法进行因果发现(Regarding causal structure learning)

Madumal et al. Explainable Reinforcement Learning Through a Causal Lens. 2019

Zhu et al. Causal Discovery with Reinforcement Learning. 2020

论文翻译和解读

1)去除强化学习算法里的混杂效应

Bareinboim et al. Bandits with Unobserved Confounders: A Causal Approach. 2015

摘要:多臂赌博机问题构成了顺序决策的原型设定,渗透到了包括工程、商业和医学在内的多个领域。多臂赌博机的一个重要特点是代理人通过主动干预来探索其环境的能力,这与通过估计行动与付出之间的关联关系来被动收集数据的能力具有显著不同。由于不可观测的混杂因素的存(即同时影响行动和结果变量的不可测变量)这两种数据收集模式得到的结果通常不一致。在本篇论文,我们表明将这种区分形式化对多臂赌博机设置具有概念和算法上的意义。当前这一代的赌博机算法隐式地试图根据对实验分布的估计来最大化收益,我们证明该策略并不总是最佳的。的确,要在某些现实类型的赌博机问题(即面对未观察到的混杂因素)中获得较低的遗憾,理性的代理人既需要实验量,也需要观察量。认识到这一点之后,我们提出了一个赌博机 Agents 应该追求的优化指标(同时采用实验分布和观察分布),并阐释了其相较于传统算法的优势。

译者:徐培

简评:多臂赌博机是强化学习环境的一个简化情况。文章在强化学习的环境中形式化地给出了混杂因素的形式,讨论了混杂效应其带来的问题。基于此,作者改进了赌博机问题中的优化目标,并且得到了更优的结果。

Lu et al. Deconfounding Reinforcement Learning in Observational Settings. 2018

摘要:提出了一个用于解决使用观测数据的强化学习(RL)问题的一般架构。也就是说,我们考虑了仅从历史数据中学习策略的问题,而数据中未观察到的因子(混杂因子)会影响到行动和奖励。我们的架构允许我们扩展一个有代表性的RL算法(Actor-Critic方法),使之成为一个去混杂因子的变体算法,这种扩展架构也很容易被应用于其他RL算法。除此之外,我们还通过修改OpenAI的 Gym environments和 MNIST数据集得到一个新的基准来进行评估。利用这个基准,我们展示了这个算法在混杂环境的数据的情况下比传统的RL算法更优秀。据我们所知,这是第一次考虑使用混杂因素解决有观测数据的RL问题。

译者:方文毅

简评:文章提出了一个在RL架构中考虑混杂因子的一般框架,并且在Actor-Critic方法中成功应用在实际数据集上。其中Actor-Critic方法同时考虑了策略和价值函数进行学习,是强化学习算法的重要里程碑。

de Haan et al. Causal Confusion in Imitation Learning. 2019

摘要:通过训练一个判别模型来预测给定观测数据下的专家动作,行为克隆(behavioral cloning)将策略学习转变为一个监督学习问题。但这些判别模型通常是非因果的(non-causal):训练程序并不知道专家与环境交互过程中的因果结构。本文指出,由于模仿学习中存在分布偏移(distributional shift),忽略因果会导致破坏性的后果,特别是会出现一种反直觉的“因果错误识别(causal misidentification)”现象:数据越多,效果反而越差。本文研究了这个问题出现的原因,并提出了一种通过定向干预(targeted interventions)——基于环境互动或专家询问——来决定正确因果模型的方法,从而避免这种问题出现。文章展示了在一些基准控制领域(benchmark control domains)和现实驾驶情况下出现的因果错误识别,并对比了本文的解决方法与数据聚合(DAgger)及其它方法的效果。

译者:许雄锐

简评:这篇文章从因果的角度研究了模仿学习中的行为克隆,发现了一类特定的因果关系导致的错误,并且提出了通过干预选择正确因果模型的方法。实验上,这篇文章在基准控制以及现实驾驶的情况下实现了模拟和应用。

2)在强化学习中应用反事实框架

Bottou et al. Counterfactual Reasoning and Learning Systems: The Example of Computational Advertising. 2013

摘要:本文工作展示了如何利用因果推断来理解复杂学习系统的和环境交互的行为,以及预测系统变化产生的后果。这种预测允许人类和算法来选择可以提升系统性能的改变。本工作在Bing搜索引擎的广告投放系统上展示了实验。

译者:陈晗曦

简评:本文通过广告投放的例子,展示了Pearl提出的因果推断方法在设计与环境交互的学习系统中起的核心作用。由于现实世界中学习系统通常会涉及除了自动化处理以外的人类决策,因此文章对学习算法和如何抓取驱动算法的信号做了清晰的区分。此外文章还发现,为分析物理系统提出的一些数学、哲学工具,对于分析因果系统和其均衡性同样非常有效。文章的整体研究思路,很有控制论的思想。

Buesing et al. Woulda, Coulda, Shoulda: Counterfactually-Guided Policy Search. 2019

摘要:强化学习算法对现实经验有很大的需求,但获取现实经验需要花费比较大的代价,使用 模型通过学习策略来合成数据刚好可以解决这个问题。但是在很多复杂环境下从头模拟真实 经验是一个很难的问题,通常会导致基于模型策略评价和搜索的偏差。为了替代这种从头 合成数据的方法,我们假定记录真实经验,并且通过反事实动作(即现实中该动作并未发生) 模拟该经验的替代结果。基于此基础上,我们提出了反事实引导策略搜索(CF-GPS)算法, 从 off-policy 经验中学习部分可观测马尔可夫决策过程(POMDPs)中的策略,利用结构因果 模型对off-policy 的某个回合(episodes)的可能策略进行反事实评估。CF-GPS还能通过利用 真实数据做偏差消除预测,从而改进model-based强化学习算法。和一般基于数据重赋权的 重要性采样(importance sampling)off-policy算法不同的是,CF-GPS利用模型明确考虑可替代的结果,让算法可以更好的利用经验数据。从经验上我们发现,在非平凡网格世界任务 (non-trivial grid-world)上,我们的算法优点转换为了策略评估和搜索结果的改进。最后 论文还展示了CF-GPS的泛化性,可以将引导策略搜索和基于重参数化的随机值梯度(Stochastic Value Gradient)转化为反事实方法。

译者:赵江杰

简评:文章提出了反事实引导策略搜索(CF-GPS)算法, 学习部分可观测马尔可夫决策过程(POMDPs)中的策略,利用结构因果模型(并未实施的)其他可能策略进行反事实评估。CF-GPS利用模型明确考虑可替代的结果,让算法可以更好的利用经验数据,具有很好的泛化性。

Pitis et al. Counterfactual Data Augmentation using Locally Factored Dynamics. 2020

摘要:许多动态过程都涉及到一些相互作用的子流程,包括机器人控制和强化学习(RL)中一些的常见场景。尽管子流程并非独立,但是他们之间的交互通常很稀疏,且任意时间步的动态过程通常可以分解为局部独立的因果机制。这种局部因果结构可以用来提高序列预测和离线策略强化学习的样本效率。我们通过引入局部因果模型(LCMs)使其形式化,这个模型是通过条件作用于状态空间的子集而从全局因果模型中归纳出来的。我们提出了一种基于面向对象状态表示的推断这些结构的方法,以及一种新的反事实数据增强算法(CoDA)。CoDA使用局部结构和经验重现来产生在全局模型中因果有效的反事实经验。我们发现CoDA显著地提高了局部因子任务中RL代理的表现,包括批约束和目标条件设置。

译者:汪昕

简评:文章通过引入局部因果模型的机制,对于稀疏的因果关系进行建模,并且通过反事实数据增强的方法消除观测数据带来的偏差。

3)因果表示学习

Dietterich et al. Discovering and Removing Exogenous State Variables and Rewards for Reinforcement Learning. 2018.

摘要:外生状态的变量和奖励能够通过将不受控的变化注入奖励信号来减缓强化学习。我们将外生状态的变量和奖励形式化,并且确定了具有外生状态的MDP(马尔科夫决策过程)可以被分解为只包含了一个外生状态+奖励的外生马尔可夫奖励过程,和一个仅针对内生奖励定义的内生马尔可夫决策过程的条件。我们也导出了方差-协方差条件,在该条件下,与使用了完整MDP相比,对内生MDP的蒙特卡洛方法评估得到了加速。类似的加速可能会延伸到所有强化学习的算法中。我们开发了两种去发现外生变量的算法,并且在多个MDP上对其进行了测试。结果表明,该算法是实用的,并可以显著地提升强化学习的速度。

译者:李欣怡

简评:该文章对外生状态的马尔可夫决策过程理论进行了发展。文章表明一个原始的MDP可以分解为一个外生马尔可夫奖励过程和一个内生马尔可夫决策决策过程,并且内生MDP的任何最优决策都是原始MDP的最优决策。文章最后指出了一个重要的开放性问题:如何最好地探索MDP以达成学习内-外分解的目的。

Zhang et al. Invariant Causal Prediction for Block MDPs. 2020

摘要:跨环境的泛化能力是强化学习算法成功应用于现实的重要挑战。在这篇文章中,我们考虑了在马尔可夫决策过程块(block MDPs)中更一般的学习抽象问题,它是一类观测值不同,但具有共享的隐状态空间的环境族和该隐空间上的动态结构。我们利用因果推理中的工具,提出了一种不变性预测的方法来学习模型无关状态抽象(MISA),这种抽象在多环境设置下可以推广到新的观测数据中。我们证明了对于某些特定类型的环境,该方法以高概率输出一个对应于返回的因果特征集的状态抽象。我们进一步给出了在多环境设定下模型误差和泛化误差的更一般的边界,在这个过程中体现了因果变量选择与MDPs状态抽象框架之间的联系。我们给出的实验证明了我们的方法在线性和非线性环境下都有效,相比现存的单任务和多任务的方法,我们的方法有更好的泛化能力。

译者:陈正鸣

简评:本文的主要贡献是拓展强化学习中环境迁移能力。而对于迁移学习来说,主要回答的是什么是不变的,也即什么是可迁移的。对此本论文给出的答案是给出了学习状态抽象在某些条件下,等于因果特征的学习,也即用因果来解释其可迁移性(泛化能力),换句话说,正是由于模型学到了具有因果性的状态抽象,才具备了优秀的跨环境泛化能力。

4)使用强化学习的方法进行因果发现

Madumal et al. Explainable Reinforcement Learning Through a Causal Lens. 2019

摘要:认知科学中流行的理论认为,人类通过因果关系来理解和表示世界知识。为了理解这个世界,我们在头脑中建立因果模型来编码事件的因果关系,并以此解释新事件发生的原因。在本文中,我们使用因果模型来推导强化学习智能体(agents)行为的因果解释。我们提出了一种通过强化学习来学习结构因果模型,并编码感兴趣变量之间因果关系的方法。然后,根据因果模型的反事实分析,使用该模型生成对智能体行为的解释。然后,根据因果模型的反事实分析,使用该模型生成对智能体行为的解释。我们报告了一项研究,120名参与者观察智能体玩一款实时战略游戏(Starcraft II),然后收到智能体行为的解释。我们研究了:1)参与者通过任务预测解释获得的理解增益;2)解释满意度和3)信任度。我们的结果表明,与其他两个基线解释模型相比,因果模型解释在这些度量上表现更好。

译者:陈天豪

简评:将强化学习算法应用于因果发现,学习了一个相对简单的结构因果模型,在实际问题中取得了比较好的结果。

Zhu et al. Causal Discovery with Reinforcement Learning. 2020

摘要:从一组变量中发现因果结构是很多经验学科的一个基础问题。传统的基于评分的因果发现 方法,依赖于局部各种启发规则,通过预定义的评分函数来搜索有向无环图(DAG)。同时 还有些方法,例如贪婪等价搜索(GES),当样本无限多而且确定模型假设条件下可能会有 不错的效果,但是在实际中这样的条件很少能得到满足,因为一般情况下样本是有限的, 假设条件也不能完全确定。在近年来进展较快的的神经组合优化思想的影响下,我们提出 了一种通过强化学习值优化搜索DAG的方法。将观察数据输入到我们的encoder-decoder 模型中,生成计算相应奖励的图邻接矩阵。这个奖励包含了预定义的值函数和控制无环生成 的惩罚项。和典型的强化学习以最优策略作为输出不同,我们将强化学习作为一个搜索策略, 从训练过程中生成的所有图中,返回奖励最大的那个图作为输出结果。通过在合成数据以及 真实数据上的实验表明,我们的方法不仅能提高图搜索性能,还能在无环约束条件下作为一种 灵活的评分函数使用。

译者:赵江杰

简评:通过基于自注意力机制的encoder-decoder神经网络模型探索数据之间的关系,结合因果结构的条件,并使用策略梯度的强化学习算法对神经网络参数进行训练,以因果图结构作为最终的输出。

近期资讯

1)陆超超北大报告:Causal Reinforcement Learning in Healthcare and Medicine

2021年1月13日,剑桥博士陆超超应邀在北京大学公共卫生学院生物统计系举办的学术讲座中,做了《Causal Reinforcement Learning in Healthcare and Medicine》的主题演讲。在演讲中,陆超超对因果强化学习做了简明扼要的介绍,并讨论了它在健康医疗和医药领域的潜在应用。关于详细内容,可以参阅本次演讲报告的PDF文档。

PDF地址:

https://causallu.files.wordpress.com/2021/01/talkpekinguniv13jan2021.pdf

2)AI debate 2020,Judea Pearl 、Robert Ness 畅想因果革命新引擎

2020年12月23日下午(北京时间24日凌晨),继2019年Gary Marcus 与 Yoshua Bengio 辩论之后,AI Debate再次召开,有Judea Pearl、Rich Sutton 、 Robert Ness 、李飞飞等16位顶尖AI专家参与。在会上,Judea Pearl 发表了主题为「The Domestication of Causal Reasoning」的演讲。他表示深度学习是个金矿,「我为推动因果革命而打造的新引擎可以表示心理状态的计算模型,即『深度理解』」。Pearl 表示,深度理解将成为回答「What is?」、「What if?」和「If Only?」这些问题的唯一系统。

接下来,机器学习研究科学家 Robert Ness 谈论了「因果推理与(深度)概率编程」。Ness 表示:「概率编程将是解决因果推理的关键。」概率编程可以构建能够反事实推理的智能体,而这是因果推理的关键。他认为这可以解决 Pearl 关于「If only?」的问题。

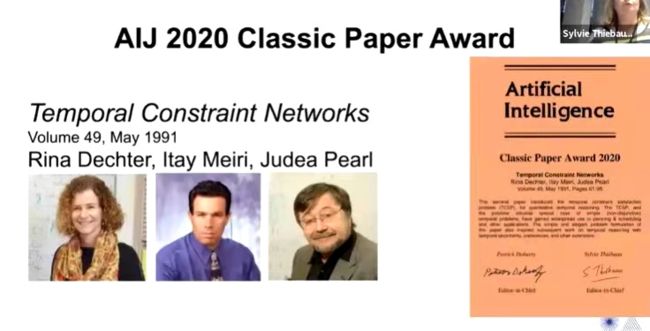

3) Judea Pearl 三十年前论文获人工智能(AIJ) 奖

受疫情影响,IJCAI-PRICAI 2020即第29届国际人工智能联合会议和第17届环太平洋人工智能国际会议(International Joint Conference on Artificial Intelligence-Pacific Rim International Conference on Artificial Intelligence)于2021年1月11日开幕。在会上,Judea Pearl科研团队在30年前发表的一篇论文“Temporal Constraint Networks”荣获“人工智能(AIJ) 奖”。人工智能(AIJ) 奖,用于颁发给至少 15 年前发布在 AI Journal 上极具影响力的重要论文。这篇获奖论文发表于 1991 年,涉及的主题是上世纪八十年代的热门话题——时间约束。目前,该论文被引用次数接近 2500。Judea Pearl是这篇论文的第三作者,第一作者和第二作者分别是他的博士生:Rina Dechter、Itay Meiri。

参考文献

[1] Chaochao Lu. Causal Reinforcement Learning: Motivation, Concepts, Challenges, and Applications. Slides: https://causallu.files.wordpress.com/2020/11/talkswarmacampus29nov2020.pdf

[2] Chaochao Lu. Causal Reinforcement Learning: A Road to Artificial General Intelligence. Slides: https://causallu.files.wordpress.com/2019/11/talkbelllabs28nov2019.pdf

Video: https://youtu.be/sqKcbjuXGn8

[3] Chaochao Lu. Introduction to Causal RL. https://causallu.com/2018/12/31/introduction-to-causalrl/

[4] Elias Bareinboim: Causal Reinforcement Learning. https://crl.causalai.net/

[5]Judea Pearl.

https://twitter.com/yudapearl/status/1065871039387693056?s=20

[6] Bernhard Schölkopf. Causality for Machine Learning. 2019.

[7] Yann Lecun vs Gary Marcus. Artificial Intelligence Debate: Does AI need more innate machinery? https://youtu.be/aCCotxqxFsk

[8] Pedro Domingos. The Master Algorithm: How the quest for the ultimate learning machine will remake our world. 2015

因果科学社区愿景:回答因果问题是各个领域迫切的需求,当前许多不同领域(例如 AI 和统计学)都在使用因果推理,但是他们所使用的语言和模型各不相同,导致这些领域科学家之间沟通交流困难。因此我们希望构建一个社区,通过组织大量学术活动,使得科研人员能够掌握统计学的核心思想,熟练使用当前 AI 各种技术(例如 Pytorch/Pyro 搭建深度概率模型),促进各个领域的研究者交流和思维碰撞,从而让各个领域的因果推理有着共同的范式,甚至是共同的工程实践标准,推动刚刚成型的因果科学快速向前发展。具备因果推理能力的人类紧密协作创造了强大的文明,我们希望在未来社会中,因果推理融入到每个学科,尤其是紧密结合和提升 AI ,期待无数具备攀登因果之梯能力的 Agents (Causal AI) 和人类一起协作,共建下一代的人类文明!

如果您有适当的数学基础和人工智能研究经验,既有科学家的好奇心也有工程师思维,希望参与到”因果革命“中,教会机器因果思维,为因果科学作出贡献,请加入我们微信群:扫描下面社区小助手二维码加入(请备注“因果科学”,以及本人的“姓名+单位/学校/研究方向”)????

![]()

阅读往期《因果科学周刊》,请点击下面链接:

《因果科学周刊》第一期:因果社区诚邀加入,打造因果推理共同范式

《因果科学周刊》第二期:如何解决混淆偏差?

《因果科学周刊》第三期:因果助力 Stable Learning

《因果科学周刊》第四期:因果赋能推荐系统

《因果科学周刊》第五期:ODD泛化

《因果科学周刊》第六期:领域自适应