Python + OpenCV一步一步地实现图像拼接(原理与代码)

图像拼接可以理解为三大步:

- 按顺序读取多幅图像,并保证图像按照从左到右的顺序。

- 发现这些图像像素之间的相关性(涉及到单应性)。

- 将这些图像拼接成为一张全景图像。

首先,需要了解如下几个概念。

SIFT特征提取

Python OpenCV SIFT特征提取的原理与代码实现_乔卿的博客-CSDN博客如果对图像扩大规模,如缩放,如下图所示,那么原本的角点在变换后的某些窗口中可能就不是角点,因此,HarrisDetectors不具有尺度不变性。例如,在上图中,低σ的高斯核可以为小角点提供高值,而高σ的高斯核则适合于大角点。因此,我们可以在尺度空间中找到局部极大值。...https://qiaoxs.blog.csdn.net/article/details/125849051?spm=1001.2014.3001.5502

图像匹配

Python OpenCV 图像匹配(Brute-Force与FLANN)的原理与代码实现_乔卿的博客-CSDN博客获得两张图像的关键点之后,下一步就是找到它们之间的对应关系,找到那些相匹配的点,从而基于这些点,实现图像拼接。这一方法即暴力搜索法,它选择第一个集合中一个特征的描述符,计算与第二个集合中的所有其他特征描述符之间的距离,返回最接近的一个。该方法返回的结果是DMatch对象的列表。......https://blog.csdn.net/qq_41112170/article/details/125849423

计算单应矩阵

假设我们使用同一部相机,用不同视角拍了两张照片,那么如何对这两张图片视角变换进行建模,将相邻的两张图片联系起来,就成为了一个问题。

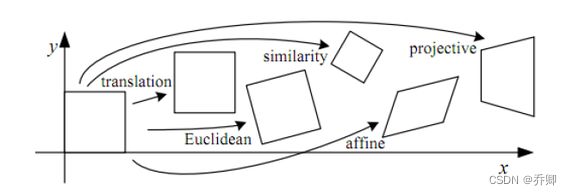

上图展示了一些几何变换。单应矩阵的作用在于,将图像平面P1转换为另一个图像平面P2。下面是一个例子:

上面的projective(射影变换)可以表示为:I1=H×I2

其中H即为单应矩阵。单应矩阵保持图像中的直线,因此,唯一可能的变换是平移、仿射等。H矩阵可以表示为:

h11 h12 h13

h21 h22 h23

h31 h32 h33

在图像拼接这一问题中,我们一旦获得了图像之间的匹配,下一步就是计算单应矩阵。单应矩阵将使用这些匹配的关键点估计图像之间的相对方向变换。

那么,对于全景拼接过程中两张图像相邻的情况,怎样计算单应矩阵呢?我们注意到,这涉及到RANSAC算法,在OpenCV中,调用findHomography()方法时指定cv2.RANSAC参数。

给定原始图像与目标图像,则相应的单应矩阵可以用OpenCV中的findHomography()方法求得。

# pts_src与pts_dst都是numpy arrays

h, status = cv2.findHomography(pts_src, pts_dst, cv2.RANSAC)给定原始图像与单应矩阵,则转换后的图像可以用OpenCV中的warpPerspective()方法求得。

# im_src是numpy arrays

# size的格式:(width,height)

im_dst = cv2.warpPerspective(im_src, h, size)拼接(warping)

单应矩阵告诉了我们:两张图片的角度之间有什么关系。基于这一点,我们可以把两张图像转换到同一个空间中,这一过程称为warping。warping分为如下三种:

- 平面:其中每个图像是一个平面表面的元素,经过平移和旋转。

- 圆柱形:其中每个图像都表示为圆柱形的坐标系。图像绘制在圆柱体的曲面上。

- 球面:上述的附加物为球面,而非圆柱体,作为参考模型。

由于时间有限,这里仅先实现平面扭曲。由于已经计算出单应矩阵,可以使用该矩阵将第一张图像转换到第二张图像的平面上。对于在同一平面上的两张图像,一个很直观的思路是,迭代两幅图像,发现匹配的区域则覆盖,否则置为0。

def stitch(image_left_path, image_right_path):

# 读取图像

image_left = cv2.imread(image_left_path)

image_right = cv2.imread(image_right_path)

# 提取SIFT特征

kp1, des1 = sift_algorithm(image_left)

kp2, des2 = sift_algorithm(image_right)

# 匹配关键点

matches, H, status = bf_match(image_left, image_right, kp1, kp2, des1, des2)

# 拼接

result = cv2.warpPerspective(image_right, H, (image_right.shape[1] + image_left.shape[1], image_right.shape[0]))

result[0: image_left.shape[0], 0: image_left.shape[1]] = image_left

# plt.imshow(result)

# plt.show()

cv2.imwrite('step_by_step_result.jpg', result)

return result