当BERT-whitening引入超参数:总有一款适合你

©PaperWeekly 原创 · 作者 | 苏剑林

单位 | 追一科技

研究方向 | NLP、神经网络

在《你可能不需要 BERT-flow:一个线性变换媲美 BERT-flow》中,笔者提出了 BERT-whitening,验证了一个线性变换就能媲美当时的 SOTA 方法 BERT-flow。此外,BERT-whitening 还可以对句向量进行降维,带来更低的内存占用和更快的检索速度。然而,在《无监督语义相似度哪家强?我们做了个比较全面的评测》中我们也发现,whitening 操作并非总能带来提升,有些模型本身就很贴合任务(如经过有监督训练的 SimBERT),那么额外的 whitening 操作往往会降低效果。

为了弥补这个不足,本文提出往 BERT-whitening 中引入了两个超参数,通过调节这两个超参数,我们几乎可以总是获得“降维不掉点”的结果。换句话说,即便是原来加上 whitening 后效果会下降的任务,如今也有机会在降维的同时获得相近甚至更好的效果了。

方法概要

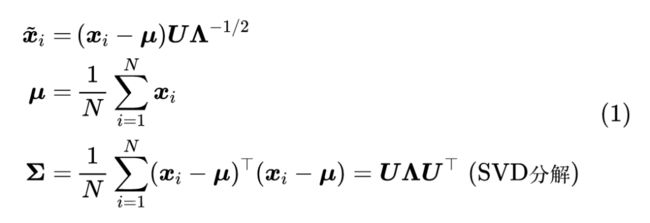

目前 BERT-whitening 的流程是:

其中 是给定的句向量(如无说明,向量默认为行向量), 是变换后的向量,SVD 分解的结果中, 是正交矩阵, 是对角矩阵,并且对角线的元素非负且从大到小排列。可以看到,目前的流程是完全固定的,即没有任何可调的超参数。

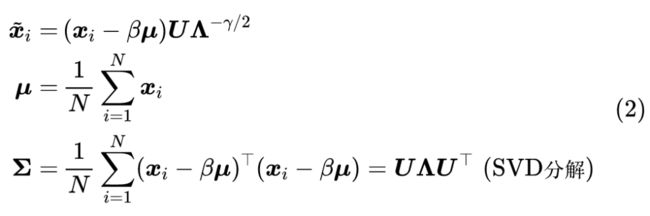

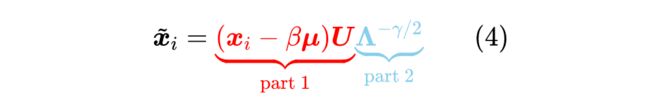

为了增加一定的调节空间,我们可以往里边引入两个超参数 (标量),使其变为

思路分析

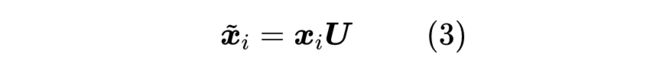

可以看到,当 时,就是原来的 BERT-whitening;而当 时,净变换就是

由于 是正交矩阵,所以不改变内积结果,即

402 Payment Required

,所以当我们用余弦相似度作为相似度量时,它不会改变原有结果。换句话说,引入这组超参数后,它提供了“不逊色于变换前的效果”的可能性,那么当我们精调这组参数时,就有可能取得比变换前更好的效果。这也是这两个超参数的设计思路。此外,在这样的改动之下,原来的降维能力还是得以保留的。我们可以将变换拆开为两部分看:

第一部分主要是正交变换 , 是 矩阵 SVD 分解之后的结果,它能将向量 变换成每个分量尽量独立的新向量,并且新向量的每个分量与 0 的平均波动正好是由 的对角线元素来衡量,如果对应的波动很接近于 0,那么我们就可以认为它实际就是0 ,舍去这个分量也不会影响余弦值的计算结果,这就是降维的原理。而由于 SVD 分解的结果已经提前将 从大到小排好了顺序,因此我们可以直接通过保留前 维的操作 就可以实现降到 维了。

至于第二部分 ,我们可以理解为当前任务对各向同性的依赖程度,如果 ,那么相当于每个分量都是各平权的,这可以作为一个无监督的先验结果,但未必对所有任务都是最优的,所以我们可以通过调节 来更好地适应当前任务。

实验结果

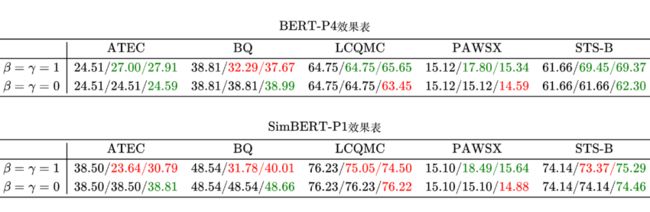

文章《无监督语义相似度哪家强?我们做了个比较全面的评测》已经显示,在 ATEC、BQ、LCQMC 三个任务上,SimBER T加上默认的 whitening 操作(即 )都会导致效果下降,而如果我们取 ,那么结果就不一样了(随便演示了两个组合,其他组合结果相似):

跟之前的文章一样,表格中的每个元素是 的形式,代表该任务在该模型下“不加 whitening”的得分为 、“加 whitening”的得分为 、“加 whitening 并降到 256 维”的得分为 ;如果 ,那么 显示为绿色,小于则显示为红色;如果 ,那么 显示为绿色,小于则显示为红色。前面说了,如果不降维的话, 的净变换就是 ,不改变余弦值结果,因此 时的 都是相等的。

在这个表格中,我们主要看 中的第三个结果 ,它是将向量从 768 维降低到 256 维的结果,可以看到当 时,不管是无监督的 BERT 还是有监督的 SimBERT,该结果基本都很接近原始向量的结果(即 ),部分结果甚至还有提升。这就意味着, 这个组合几乎可以算是“免费的午餐”,几乎无损效果,并且实现了降维。

笔者也试过精调 ,在一些任务上确实能取得比上述两个组合更好的效果,但精调需要标签数据,争议性可能会比较大,这里就不演示了。如果原来的句向量模型本就是有监督训练得到的,用 BERT-whitening 仅仅是奔着降维去的,那么就可以用验证集来精调一下 和 了,这种场景下就是无争议的了。

文章小结

本文通过引入两个超参数的方式来赋予 BERT-whitening 一定的调参空间,使其具备“不逊色于变换前的效果”的可能性,并且保留了降维的能力。换言之,即便是之前已经训练好的句向量模型,我们也可以用新的 BERT-whitening 将它降维,并且保持效果基本不变,有时候甚至还更优~

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

投稿通道:

• 投稿邮箱:[email protected]

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

·