附代码 ConvNeXts:A ConvNet for the 2020s

A ConvNet for the 2020s 论文解读

代码链接: https://github.com/facebookresearch/ConvNeXt

参考链接:https://zhuanlan.zhihu.com/p/458016349

摘要:

卷积网络和Swin Transformer 的不同和相似:它们都具有相似的归纳偏差,但在训练过程和宏观/微观架构设计上存在显著差异。在这项工作中,我们研究了卷积网络和Transformer之间的架构区别,并试图在比较网络性能时识别混杂变量。我们的研究旨在弥合前和后时代之间的差距,以及测试纯网络所能实现的极限。

即 How do design decisions in Transformers impact ConvNets’ performance?

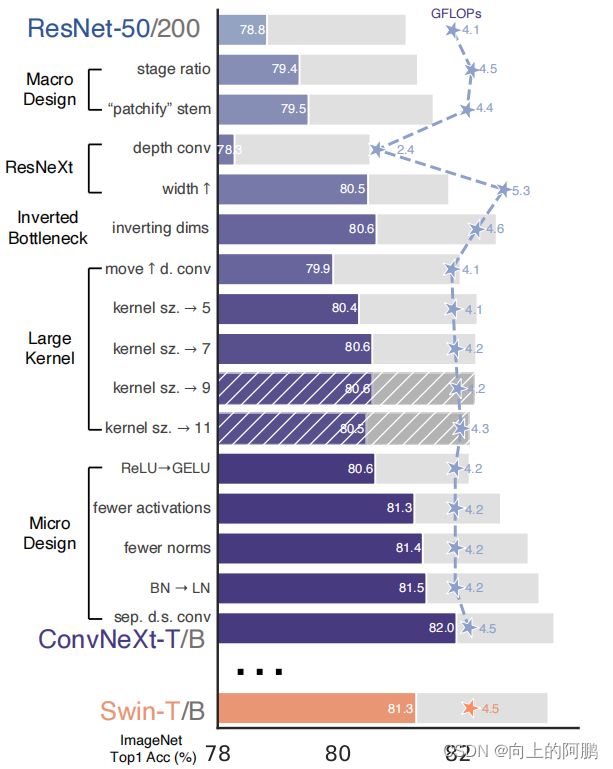

从一个标准的ResNet(例如ResNet-50)开始,用一个改进的程序进行训练。ResNet逐渐实现“现代化”建筑,以构建一个层次化的VIT。

路线图:从ResNet到ConvNeXt

总结为

1)宏观设计

2)ResNeXt

3)倒置瓶颈

4)大卷积核

5)各种层次的微观设计。

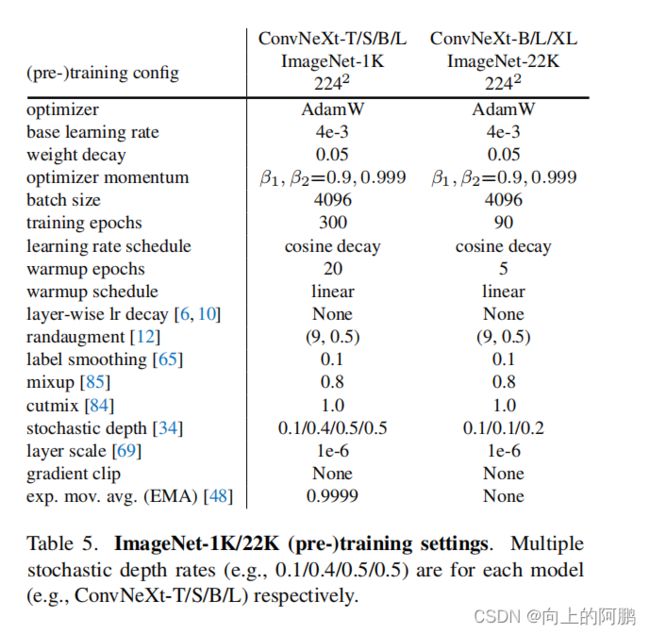

训练策略

VIT不仅带来了结构上的设计,还带来不同的训练策略,使用了一个接近DeiT的和Swin变压器的的训练配方。该训练从原来的90个时代扩展到300个时代。我们使用AdamW优化器,数据增强技术,如Mixup,Cutmix,随机增强,随机擦除,和正则化方案,包括随机深度和标签平滑。这种增强的训练配方将ResNet-50模型的性能从76.1%[1]提高到78.8%。具体如下图:其中,EMA为Exponential Moving Average。

一,宏观设计

改变stage的比例:在ResNet中,跨阶段的计算分布的原始设计主要是经验性的。沉重的“res4”阶段是为了兼容下游任务,如目标检测。而另一方面,Swin-T遵循相同的原理,但阶段计算比例略有不同,为1:1:1:3:1。对于较大的Swin Transofmer,这个比例是1:1:9:1。根据设计,我们将每个阶段的块数从ResNet-50中的(3,4,6,3)调整到(3,3,9,3),将模型精度从78.8%提高到79.4%。不过这里要注意的一点是,调整后其实blocks数量增加了,模型的FLOPs从原来的4G增加至4.5G,基本和Swin-T一致了,所以这个性能的提升很大程度上归功于FLOPs的增加。

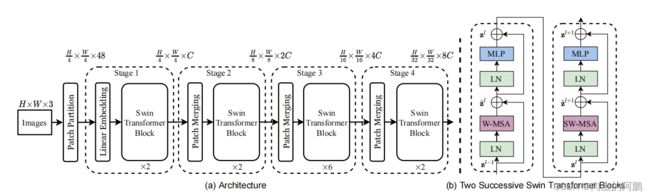

对输入进行补丁化:下图为Swin Transformer 的流程图,可以看到图像在输入的时候进行了补丁操作,即使用4X4 步距为4的卷积层,将图像分为4X4的补丁图像,因此使用在ResNet中使用4X4步距为4的卷积层对图像进行补丁化操作,准确率从79.4%变到79.5%。

1,ResNeXt化:用于增加网络宽度与SWIN-T相同。即加入类self attention的结构

相比ResNet,ResNeXt通过采用group conv来提升性能,标准的conv其输入是所有的channels,而group conv会对channels进行分组来减少计算量,这样节省下来的计算量用来增加网络的width即特征channels。为了在引入ResNet结构的同时,进一步减少计算量,使用depthwise conv即DWConv(其中组的数量等于通道的数量)。根据ResNeXt中提出的策略,我们将网络宽度增加到与swint相同的通道数量(从64增加到96)。随着流量(5.3G)的增加,网络性能达到80.5%。

我们注意到,depthwise conv类似于自注意中的加权和运算,它在每个通道的基础上操作,即只在空间维数中混合信息,因此我们可以把他看作Self attention层(MSA)。

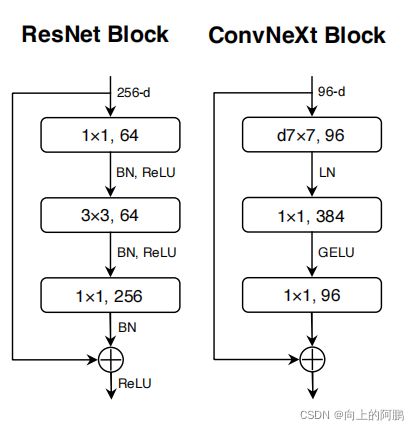

2,Inverted Bottleneck化

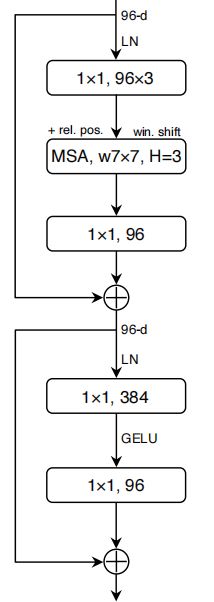

如果把self-attention(即MSA)看成一个dw conv的话(这里忽略self-attention的linear projection操作),那么一个transformer block可以近似看成一个inverted bottleneck,即创建了一个反向瓶颈,因为MLP块的隐藏维度比输入维度宽四倍(MLP块可以看作1X1卷积)。如下所示,有趣的是,这种设计与倒置瓶颈设计有关。

因此,我们探讨了反向瓶颈设计。下图说明了这些配置。尽管深度卷积层的FLOPs增加,但由于降采样剩余块的捷径1×1conv层,FLOPs显著减少。有趣的是,这导致了略微改善的性能(80.5%到80.6%)

3,大卷积核设计

Swin Transformer最显著的方面之一是它们的非局部自注意,这使每一层都有一个全局的接受域。虽然Swin Transformer重新将局部窗口引入了自注意块,但窗口大小至少为7×7,明显大于ResNe(X)t内核大小为3×3。

向上移动深度卷积:前面提到了DW conv可以看作self attention层(MSA),而在Swin Transformer中MSA块放置在MLP层之前。因此我们将DW conv移动到上方,放置在1X1卷积上方,如下图。由于我们有一个反向的瓶颈块,则复杂/低效的模块(MSA,大内核conv)将有更少的通道,而高效、密集的1×1层将完成繁重的工作。这一中间步骤将流量降低到4.1G,导致性能暂时下降到79.9%。

增加卷积核大小:采用更大的内核大小的卷积可以增大接收域,可以模仿Swin Transformer非局部自注意,这使每一层都有一个全局的接受域。我们实验了几个内核大小,包括3、5、7、9和11。网络的性能从79.9%(3×3)增加到80.6%(7×7),而网络的FLOPS大致保持不变。同时,我们发现,卷积核大小在7x7的时候,好处就达到饱和了。

二,微观设计

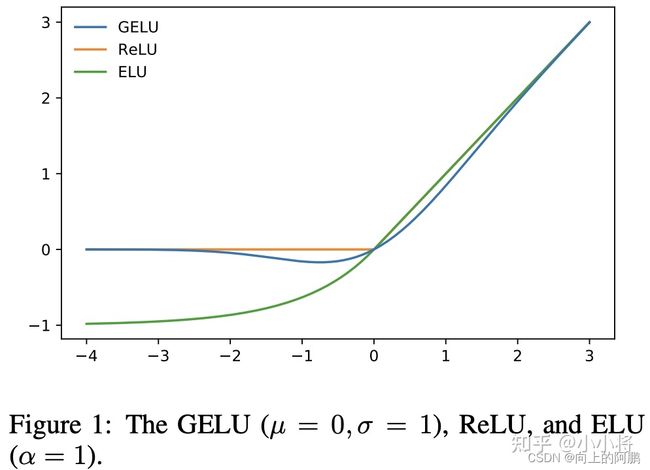

激活函数-用GELU替换ReLU:高斯误差线性单元(ELU),或GELU,可以被认为是ReLU的一个更平滑的变体(如下图),在最先进的Transformer中被使用,包括谷歌的BERT和OpenAI的GPT-2,以及最近的ViTs。我们发现,在我们的ConvNet中,ReLU也可以用GELU代替,尽管准确率保持不变(80.6%)。因此将ReLU用GELU代替。

使用更少的激活函数:Transformer和ResNet块之间的一个小区别是,Transformer只在MLP中间采用了非线性激活,而ResNet模型常常每个conv之后就会用跟一个非线性激活函数,包括1个×1conv。在这里,我们将研究当我们坚持相同的策略时,性能将如何变化。我们从残余块中删除了所有的GELU层,只保留两个1×1层之间的激活函数,复制了一个变压器块的风格。该过程将结果提高了0.7%至81.3%,与Swin-T的性能基本匹配。

使用更少的标准化层:对于norm层,也存在和激活函数一样的问题,transformer中只在self-attention和MLP的开始采用了LayerNorm,而ResNet每个conv之后采用BatchNorm,比transformer多一个norm层。这里去掉其它的BatchNorm,只保留中间1x1 conv前的BatchNorm,此时模型性能有0.1%的提升。实际上要和transformer保持一致,应该在block最开始增加一个BatchNorm,但是这个并没有提升性能,所以最终只留下了一个norm层。

用LN代替BN:在Transformer中使用了更简单的层归一化(LN),从而在不同的应用场景中具有良好的性能。在原始ResNet中直接用LN代替BN将导致次优性能。但通过对网络架构和训练技术的所有修改,我们的ConvNet模型在LN训练中没有任何困难;事实上,性能稍好一些,获得了81.5%的准确率。

分离下采样层:在ResNet中,空间降采样是通过每个阶段开始时的残差块实现的,使用3X3步距为2的卷积层(其中shortcut为1×1步距为2的卷积)。而在Swin Transformer中,是在各个阶段之间添加了一个单独的降采样层。因此我们探索了一种类似的策略,即单独使用2个×2的conv层进行空间降采样,即下采样是放在两个stage之间。但是实验发现,如果直接改用Swin-T的下采样,会出现训练发散问题,因此在改变空间分辨率的地方添加归一化层有助于稳定训练。一个在每个下采样层之前,一个在stem之后,即补丁化之后,一个在最终的全局平均池之后。可以将准确率提高到82.0%,显著超过Swin-T的81.3%。

模型结构:

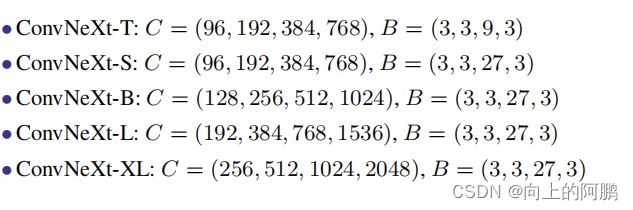

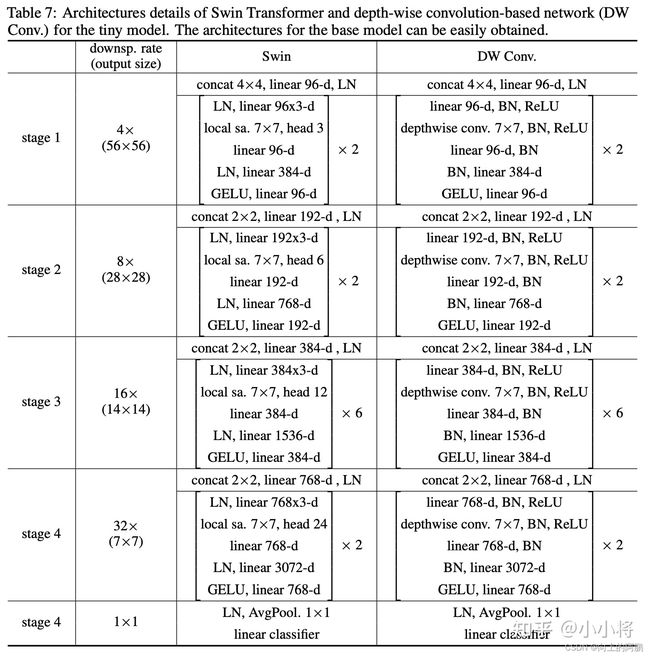

经过6个方面的修改或者优化,最终得到的模型称为ConvNeXt,其模型结构如下所示,可以看到,ConvNeXt-T和Swin-T整体结构基本一致,而且模型FLOPs和参数量也基本一样,唯一的差异就是dw conv和W-MSA(MSA的前面和后面都包含linear projection,等价1x1 conv),由于dw conv和W-MSA的计算量存在差异,所以ConvNeXt-T比Swin-T包含更多的blocks。另外MSA是permutation-invariance的,所以W-MSA采用了相对位置编码;而且Swin-T需要采用shifted window来实现各个windows间的信息交互;而相比之下,ConvNeXt-T不需要这样的特殊处理。

从上面的分析来看,dw conv的性能是不低于W-MSA的,这个其实早在微软的论文Demystifying Local Vision Transformer: Sparse Connectivity, Weight Sharing, and Dynamic Weight中被验证过,这篇论文设计了DW Conv模型,它也和Swin模型结构一致,差别是将W-MSA直接换成了7x7 DW conv,由于保留了两个linear层,所以各个stage的blocks数量也一致。DW Conv-T和Swin-T的性能是一样的(81.3%),略低于ConvNeXt-T。

代码:

# Copyright (c) Meta Platforms, Inc. and affiliates.

# All rights reserved.

# This source code is licensed under the license found in the

# LICENSE file in the root directory of this source tree.

import torch

import torch.nn as nn

import torch.nn.functional as F

from timm.models.layers import trunc_normal_, DropPath

from timm.models.registry import register_model

class Block(nn.Module):

r""" ConvNeXt Block. There are two equivalent implementations:

(1) DwConv -> LayerNorm (channels_first) -> 1x1 Conv -> GELU -> 1x1 Conv; all in (N, C, H, W)

(2) DwConv -> Permute to (N, H, W, C); LayerNorm (channels_last) -> Linear -> GELU -> Linear; Permute back

We use (2) as we find it slightly faster in PyTorch

Args:

dim (int): Number of input channels.

drop_path (float): Stochastic depth rate. Default: 0.0

layer_scale_init_value (float): Init value for Layer Scale. Default: 1e-6.

"""

def __init__(self, dim, drop_path=0., layer_scale_init_value=1e-6):

super().__init__()

self.dwconv = nn.Conv2d(dim, dim, kernel_size=7, padding=3, groups=dim) # depthwise conv

self.norm = LayerNorm(dim, eps=1e-6)

self.pwconv1 = nn.Linear(dim, 4 * dim) # pointwise/1x1 convs, implemented with linear layers

self.act = nn.GELU()

self.pwconv2 = nn.Linear(4 * dim, dim)

self.gamma = nn.Parameter(layer_scale_init_value * torch.ones((dim)),

requires_grad=True) if layer_scale_init_value > 0 else None

self.drop_path = DropPath(drop_path) if drop_path > 0. else nn.Identity()

def forward(self, x):

input = x

x = self.dwconv(x)

x = x.permute(0, 2, 3, 1) # (N, C, H, W) -> (N, H, W, C)

x = self.norm(x)

x = self.pwconv1(x)

x = self.act(x)

x = self.pwconv2(x)

if self.gamma is not None:

out = self.gamma * x

x = out

x = x.permute(0, 3, 1, 2) # (N, H, W, C) -> (N, C, H, W)

x = input + self.drop_path(x)

return x

class ConvNeXt(nn.Module):

r""" ConvNeXt

A PyTorch impl of : `A ConvNet for the 2020s` -

https://arxiv.org/pdf/2201.03545.pdf

Args:

in_chans (int): Number of input image channels. Default: 3

num_classes (int): Number of classes for classification head. Default: 1000

depths (tuple(int)): Number of blocks at each stage. Default: [3, 3, 9, 3]

dims (int): Feature dimension at each stage. Default: [96, 192, 384, 768]

drop_path_rate (float): Stochastic depth rate. Default: 0.

layer_scale_init_value (float): Init value for Layer Scale. Default: 1e-6.

head_init_scale (float): Init scaling value for classifier weights and biases. Default: 1.

"""

def __init__(self, in_chans=3, num_classes=1000,

depths=[3, 3, 9, 3], dims=[96, 192, 384, 768], drop_path_rate=0.,

layer_scale_init_value=1e-6, head_init_scale=1.,

):

super().__init__()

self.downsample_layers = nn.ModuleList() # stem and 3 intermediate downsampling conv layers

stem = nn.Sequential(

nn.Conv2d(in_chans, dims[0], kernel_size=4, stride=4),

LayerNorm(dims[0], eps=1e-6, data_format="channels_first")

)

self.downsample_layers.append(stem)

for i in range(3):

downsample_layer = nn.Sequential(

LayerNorm(dims[i], eps=1e-6, data_format="channels_first"),

nn.Conv2d(dims[i], dims[i + 1], kernel_size=2, stride=2),

)

self.downsample_layers.append(downsample_layer)

self.stages = nn.ModuleList() # 4 feature resolution stages, each consisting of multiple residual blocks

dp_rates = [x.item() for x in torch.linspace(0, drop_path_rate, sum(depths))]

cur = 0

for i in range(4):

stage = nn.Sequential(

*[Block(dim=dims[i], drop_path=dp_rates[cur + j],

layer_scale_init_value=layer_scale_init_value) for j in range(depths[i])]

)

self.stages.append(stage)

cur += depths[i]

self.norm = nn.LayerNorm(dims[-1], eps=1e-6) # final norm layer

self.head = nn.Linear(dims[-1], num_classes)

self.apply(self._init_weights)

self.head.weight.data.mul_(head_init_scale)

self.head.bias.data.mul_(head_init_scale)

def _init_weights(self, m):

if isinstance(m, (nn.Conv2d, nn.Linear)):

trunc_normal_(m.weight, std=.02)

nn.init.constant_(m.bias, 0)

def forward_features(self, x):

for i in range(4):

x = self.downsample_layers[i](x)

x = self.stages[i](x)

return self.norm(x.mean([-2, -1])) # global average pooling, (N, C, H, W) -> (N, C)

def forward(self, x):

x = self.forward_features(x)

x = self.head(x)

return x

class LayerNorm(nn.Module):

r""" LayerNorm that supports two data formats: channels_last (default) or channels_first.

The ordering of the dimensions in the inputs. channels_last corresponds to inputs with

shape (batch_size, height, width, channels) while channels_first corresponds to inputs

with shape (batch_size, channels, height, width).

"""

def __init__(self, normalized_shape, eps=1e-6, data_format="channels_last"):

super().__init__()

self.weight = nn.Parameter(torch.ones(normalized_shape))

self.bias = nn.Parameter(torch.zeros(normalized_shape))

self.eps = eps

self.data_format = data_format

if self.data_format not in ["channels_last", "channels_first"]:

raise NotImplementedError

self.normalized_shape = (normalized_shape,)

def forward(self, x):

if self.data_format == "channels_last":

return F.layer_norm(x, self.normalized_shape, self.weight, self.bias, self.eps)

elif self.data_format == "channels_first":

u = x.mean(1, keepdim=True)

s = (x - u).pow(2).mean(1, keepdim=True)

x = (x - u) / torch.sqrt(s + self.eps)

x = self.weight[:, None, None] * x + self.bias[:, None, None]

return x

model_urls = {

"convnext_tiny_1k": "https://dl.fbaipublicfiles.com/convnext/convnext_tiny_1k_224_ema.pth",

"convnext_small_1k": "https://dl.fbaipublicfiles.com/convnext/convnext_small_1k_224_ema.pth",

"convnext_base_1k": "https://dl.fbaipublicfiles.com/convnext/convnext_base_1k_224_ema.pth",

"convnext_large_1k": "https://dl.fbaipublicfiles.com/convnext/convnext_large_1k_224_ema.pth",

"convnext_tiny_22k": "https://dl.fbaipublicfiles.com/convnext/convnext_tiny_22k_224.pth",

"convnext_small_22k": "https://dl.fbaipublicfiles.com/convnext/convnext_small_22k_224.pth",

"convnext_base_22k": "https://dl.fbaipublicfiles.com/convnext/convnext_base_22k_224.pth",

"convnext_large_22k": "https://dl.fbaipublicfiles.com/convnext/convnext_large_22k_224.pth",

"convnext_xlarge_22k": "https://dl.fbaipublicfiles.com/convnext/convnext_xlarge_22k_224.pth",

}

@register_model

def convnext_tiny(pretrained=False, in_22k=False, **kwargs):

model = ConvNeXt(depths=[3, 3, 9, 3], dims=[96, 192, 384, 768], **kwargs)

if pretrained:

url = model_urls['convnext_tiny_22k'] if in_22k else model_urls['convnext_tiny_1k']

checkpoint = torch.hub.load_state_dict_from_url(url=url, map_location="cpu", check_hash=True)

model.load_state_dict(checkpoint["model"])

return model

@register_model

def convnext_small(pretrained=False, in_22k=False, **kwargs):

model = ConvNeXt(depths=[3, 3, 27, 3], dims=[96, 192, 384, 768], **kwargs)

if pretrained:

url = model_urls['convnext_small_22k'] if in_22k else model_urls['convnext_small_1k']

checkpoint = torch.hub.load_state_dict_from_url(url=url, map_location="cpu")

model.load_state_dict(checkpoint["model"])

return model

@register_model

def convnext_base(pretrained=False, in_22k=False, **kwargs):

model = ConvNeXt(depths=[3, 3, 27, 3], dims=[128, 256, 512, 1024], **kwargs)

if pretrained:

url = model_urls['convnext_base_22k'] if in_22k else model_urls['convnext_base_1k']

checkpoint = torch.hub.load_state_dict_from_url(url=url, map_location="cpu")

model.load_state_dict(checkpoint["model"])

return model

@register_model

def convnext_large(pretrained=False, in_22k=False, **kwargs):

model = ConvNeXt(depths=[3, 3, 27, 3], dims=[192, 384, 768, 1536], **kwargs)

if pretrained:

url = model_urls['convnext_large_22k'] if in_22k else model_urls['convnext_large_1k']

checkpoint = torch.hub.load_state_dict_from_url(url=url, map_location="cpu")

model.load_state_dict(checkpoint["model"])

return model

@register_model

def convnext_xlarge(pretrained=False, in_22k=False, **kwargs):

model = ConvNeXt(depths=[3, 3, 27, 3], dims=[256, 512, 1024, 2048], **kwargs)

if pretrained:

assert in_22k, "only ImageNet-22K pre-trained ConvNeXt-XL is available; please set in_22k=True"

url = model_urls['convnext_xlarge_22k']

checkpoint = torch.hub.load_state_dict_from_url(url=url, map_location="cpu")

model.load_state_dict(checkpoint["model"])

return model

if __name__ == '__main__':

input = torch.ones(1, 3, 224, 224)

m = convnext_tiny()

out = m(input)

print(out)