- 医疗金融预测与语音识别中的模型优化及可解释性技术突破

智能计算研究中心

其他

内容概要随着人工智能技术的纵深发展,模型优化与可解释性技术正在重塑医疗诊断、金融预测及语音识别领域的应用范式。在医疗领域,基于自适应学习的动态参数调整机制,结合迁移学习的跨场景知识复用,显著提升了疾病筛查模型的泛化能力;而金融预测场景中,联邦学习框架通过分布式数据协作,在保障隐私安全的前提下,实现了风险预测模型的多维度优化。语音识别领域则依托边缘计算架构,将模型压缩技术与实时推理引擎结合,有效解决

- Manus AI与多语言手写识别

ManusAI与多语言手写识别背景与概述手写识别技术的发展现状与挑战ManusAI的核心技术与应用场景多语言手写识别的市场需求与难点ManusAI的技术架构深度学习在手写识别中的应用多语言支持的模型设计数据预处理与特征提取方法多语言手写识别的关键挑战不同语言字符的多样性处理上下文语义与书写风格适应性低资源语言的训练数据获取解决方案与优化策略迁移学习在多语言任务中的应用端到端模型的优化与轻量化用户反

- 【人工智能面经第五期:模型训练与优化核心面试深度问答】

码上有前

PytorchPython深度学习人工智能面试职场和发展

作者:“码上有前”文章简介:人工智能面经欢迎小伙伴们点赞、收藏⭐、留言模型训练与优化核心面试深度问答摘要围绕模型训练与优化的训练技巧(正则化、迁移学习)和数据工程(数据增强、标注质量)展开,通过20个关键问题,解析正则化协同策略、迁移学习适配场景、数据增强实践等核心要点,助力读者掌握人工智能与计算机视觉岗位面试中模型训练优化的知识体系,明晰技术原理与实际应用的关联。目录训练技巧-正则化策略相关问题

- 【论文阅读】Transfer Learning for Automatic Modulation Recognition Using a Few Modulated Signal Samples

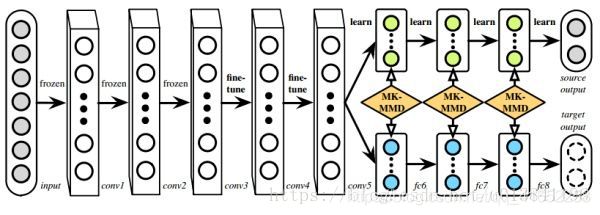

摘要:这封信提出了一种用于自动调制识别(AMR)的迁移学习模型,该模型仅具有少量调制信号样本。传输模型以音频信号UrbanSound8K作为源域进行训练,然后以一些调制信号样本为目标域进行微调。为了提高分类性能,信噪比(SNR)被用作一个功能来促进信号的分类。仿真结果表明,迁移模型在分类精度方面具有显著优势。这篇文章的核心内容是提出了一种基于迁移学习(TransferLearning)的自动调制识

- 深度学习之迁移学习

路溪非溪

人工智能迁移学习机器学习

认识迁移学习迁移学习(TransferLearning)是机器学习中的一种重要技术,其核心思想是将在一个任务上学习到的知识(模型参数、特征表示等),迁移应用到另一个相关但不同的任务中,从而提升新任务的学习效率和性能,尤其是在新任务数据有限的情况下。一、迁移学习的核心动机传统机器学习通常要求为每个新任务收集大量标注数据并从头训练模型,但现实中面临以下挑战:数据稀缺:例如医疗影像分析(罕见疾病样本少)

- Manus AI与多语言手写识别

tonngw

人工智能

技术文章大纲:ManusAI与多语言手写识别引言手写识别技术的发展背景与市场需求ManusAI的定位与核心技术优势多语言场景下的挑战与机遇ManusAI的核心技术架构基于深度学习的端到端手写识别模型多模态数据融合(笔迹压力、书写轨迹等)自适应语言模型与字符集扩展机制多语言手写识别的关键技术非拉丁语系(中文、阿拉伯语等)的笔迹特征提取小样本语言数据的迁移学习策略上下文感知与语法纠错在低资源语言中的应

- Python机器学习与深度学习:决策树、随机森林、XGBoost与LightGBM、迁移学习、循环神经网络、长短时记忆网络、时间卷积网络、自编码器、生成对抗网络、YOLO目标检测等

WangYan2022

机器学习/深度学习Python机器学习深度学习随机森林迁移学习

融合最新技术动态与实战经验,旨在系统提升以下能力:①掌握ChatGPT、DeepSeek等大语言模型在代码生成、模型调试、实验设计、论文撰写等方面的实际应用技巧②深入理解深度学习与经典机器学习算法的关联与差异,掌握其理论基础③熟练运用PyTorch实现各类深度学习模型,包括迁移学习、循环神经网络(RNN)、长短时记忆网络(LSTM)、时间卷积网络(TCN)、自编码器、生成对抗网络(GAN)、YOL

- 基于迁移学习的多视图卷积神经网络在乳腺超声自动分类中的应用

despacito,

论文精读-乳腺超声分类

BREASTCANCERCLASSIFICATIONINAUTOMATEDBREASTULTRASOUNDUSINGMULTIVIEWCONVOLUTIONALNEURALNETWORKWITHTRANSFERLEARNINGYIWANG,*,1EUNJUNGCHOI,y,1YOUNHEECHOI,*HAOZHANG,*GONGYONGJIN,yandSEOK-BUMKO*TAGGEDEND*De

- 半监督学习+迁移学习:低成本构建高精度AI模型

AI智能探索者

AIAgent智能体开发实战人工智能学习迁移学习ai

半监督学习+迁移学习:低成本构建高精度AI模型关键词:半监督学习、迁移学习、低成本、高精度AI模型、数据利用摘要:本文主要探讨了如何通过半监督学习和迁移学习相结合的方式来低成本构建高精度的AI模型。首先介绍了半监督学习和迁移学习的背景知识,然后详细解释了这两个核心概念及其相互关系,接着阐述了相关算法原理、数学模型,还给出了项目实战案例,分析了实际应用场景,推荐了相关工具和资源,最后探讨了未来发展趋

- 在浏览器中使用TensorFlow.js

魏铁锤chui

tensorflowjavascript人工智能

TensorFlow.js简介介绍光学字符识别(OCR)是指能够从图像或文档中捕获文本元素,并将其转换为机器可读的文本格式的技术。如果您想了解更多关于这个主题的内容,本文是一个很好的介绍。TensorFlow.js是一个库,用于使用JavaScript开发和训练机器学习模型,并将其部署在浏览器中或Node.js上。您可以使用现有模型、转换PythonTensorFlow模型、使用迁移学习用您自己的

- 【深度学习|学习笔记】如何在深度学习中使用 正则化技术 进行模型压缩、稀疏建模和迁移学习调优?

努力毕业的小土博^_^

机器学习基础算法优质笔记2深度学习学习笔记迁移学习人工智能机器学习

【深度学习|学习笔记】如何在深度学习中使用正则化技术进行模型压缩、稀疏建模和迁移学习调优?【深度学习|学习笔记】如何在深度学习中使用正则化技术进行模型压缩、稀疏建模和迁移学习调优?文章目录【深度学习|学习笔记】如何在深度学习中使用正则化技术进行模型压缩、稀疏建模和迁移学习调优?✅一、使用正则化进行模型压缩(ModelCompression)目标:方法:L1正则化促使权重稀疏化代码示例:后续压缩步骤

- 《三生原理》如何改进阴阳参数冷启动?

葫三生

三生学派人工智能平面线性代数概率论算法

AI辅助创作:《三生原理》通过动态参数耦合与跨域迁移学习优化阴阳参数冷启动问题,显著降低15%的初始化成本并提升收敛效率,具体技术路径如下:一、动态参数化生成引擎阴阳本体的递归约束基于素数基底(阴元=2,阳元=3)构建参数化公式:p=3(2n+1)+2(2n+m+1)(m∈{0,1,2,3,4})通过约束参数mm的取值空间(对应五行属性),压缩冷启动搜索范围在华为高斯实验室的量子加密

- 基于迁移学习的ResNet50模型实现石榴病害数据集多分类图片预测

深度学习乐园

深度学习实战项目迁移学习分类人工智能

完整源码项目包获取→点击文章末尾名片!番石榴病害数据集背景描述番石榴(Psidiumguajava)是南亚的主要作物,尤其是在孟加拉国。它富含维生素C和纤维,支持区域经济和营养。不幸的是,番石榴生产受到降低产量的疾病的威胁。该数据集旨在帮助开发用于番石榴果实早期病害检测的机器学习模型,帮助保护收成并减少经济损失。数据说明该数据集包括473张番石榴果实的注释图像,分为三类。图像经过预处理步骤,例如钝

- 深度学习实战:基于嵌入模型的AI应用开发

AIGC应用创新大全

AI人工智能与大数据应用开发MCP&Agent云算力网络人工智能深度学习ai

深度学习实战:基于嵌入模型的AI应用开发关键词:嵌入模型(EmbeddingModel)、深度学习、向量空间、语义表示、AI应用开发、相似性搜索、迁移学习摘要:本文将带你从0到1掌握基于嵌入模型的AI应用开发全流程。我们会用“翻译机”“数字身份证”等生活比喻拆解嵌入模型的核心原理,结合Python代码实战(BERT/CLIP模型)演示如何将文本、图像转化为可计算的语义向量,并通过“智能客服问答”“

- 使用预训练权重在YOLO模型上训练新数据集的完整指南

马里马里奥-

YOLO目标跟踪人工智能

使用预训练权重在YOLO模型上训练新数据集的完整指南引言在目标检测领域,迁移学习已成为提升模型性能的关键技术。本文将详细介绍如何利用预训练权重在YOLO(YouOnlyLookOnce)框架上训练自定义数据集,帮助您节省训练时间并提高检测精度。为什么使用预训练权重?加速收敛:预训练模型已学习通用特征,训练时间可缩短30%−70%30\%-70\%30%−70%小样本适配:在数据量有限时(n<100

- 【深度学习|学习笔记】预训练(Pretraining)的作用有哪些?

985小水博一枚呀

深度学习学习笔记深度学习学习笔记人工智能

【深度学习|学习笔记】预训练(Pretraining)的作用有哪些?【深度学习|学习笔记】预训练(Pretraining)的作用有哪些?文章目录【深度学习|学习笔记】预训练(Pretraining)的作用有哪些?前言✅一、提高模型性能✅二、降低训练成本✅三、迁移学习能力强✅四、模型结构验证过,可靠性高✅五、促进多模态和复杂任务发展总结如何将自己的遥感数据(输入波段为17)用作DenseNet121

- 【图像处理入门】11. 深度学习初探:从CNN到GAN的视觉智能之旅

小米玄戒Andrew

图像处理:从入门到专家深度学习图像处理cnn计算机视觉CVGAN

摘要深度学习为图像处理注入了革命性动力。本文将系统讲解卷积神经网络(CNN)的核心原理,通过PyTorch实现图像分类实战;深入解析迁移学习的高效应用策略,利用预训练模型提升自定义任务性能;最后揭开生成对抗网络(GAN)的神秘面纱,展示图像生成与增强的前沿技术。结合代码案例与可视化分析,帮助读者跨越传统算法与深度学习的技术鸿沟。一、卷积神经网络(CNN)基础与实战1.CNN的核心组件与工作原理1.

- 深度学习——迁移学习(Transfer Learning)

E-An居士

深度学习迁移学习人工智能

文章目录一、什么是迁移学习?二、为什么需要迁移学习?三、迁移学习的核心思想四、迁移学习的常见方法1.基于特征的迁移(Feature-basedTransfer)2.基于模型的迁移(Model-basedTransfer)3.基于关系的迁移(Relation-basedTransfer)五、迁移学习在计算机视觉中的应用六、迁移学习在自然语言处理中的应用七、迁移学习的优势与挑战1.优势2.挑战八、实践

- ChatGPT引领的AI面试攻略系列:AI全栈工程师篇

梦想的理由

深度学习chatgpt人工智能面试

系列文章目录AI全栈工程师(本文)文章目录系列文章目录一、前言二、面试题1.基础理论与数据处理2.机器学习3.深度学习4.大模型与迁移学习5.计算机视觉6.自然语言处理(NLP)7.多模态学习8.AI生成内容(AIGC)9.编程语言与工具10.模型评估与优化11.系统部署与维护12.其他前沿技术13.算法与数据结构14.软件工程15.项目管理与团队协作16.伦理和法律17.行业应用18.最新研究与

- 动态多目标进化算法:基于迁移学习的动态多目标遗传算法Tr-NSGA-II求解CEC2015,提供完整MATLAB代码

IT猿手

动态多目标优化MATLAB动态多目标算法迁移学习matlab动态多目标进化算法动态多目标优化算法人工智能机器学习

一、Tr-NSGA-II介绍基于迁移学习的动态多目标遗传算法(TransferLearningbasedDynamicMultiobjectivenon-dominatedsortinggeneticalgorithmII,Tr-NSGA-II)是一种将迁移学习与非支配排序遗传算法(NSGA-II)相结合的优化算法,用于解决动态多目标优化问题。工作原理迁移学习的应用:Tr-NSGA-II利用迁移学

- 【大模型】大模型微调(上)

油泼辣子多加

大模型实战深度学习机器学习人工智能

一、概念与背景微调(Fine-tuning)是一种迁移学习的方法,通过在已有的预训练模型基础上,利用目标任务的少量标注数据对模型进行二次训练,使其更好地适应特定任务的需求。预训练阶段模型通常使用大规模通用语料(如维基百科、新闻语料)进行无监督或自监督训练,学习通用的语言表示;微调阶段则使用特定任务数据进行有监督学习,实现从通用到专用的知识迁移。预训练(Pre-training):在大规模无标签语料

- 多语言手写识别中的跨语言迁移学习:Manus AI 的预训练范式

观熵

ManusAI与多语言手写识别人工智能迁移学习机器学习Mauns

多语言手写识别中的跨语言迁移学习:ManusAI的预训练范式关键词:跨语言迁移学习、手写识别、预训练模型、表征共享、语言适配层、低资源语种、参数共享、微调策略摘要:面对多语种手写识别场景中语言资源分布严重不均的现状,ManusAI构建了一套以跨语言迁移为核心的预训练范式,通过在高资源语种上预训练共享视觉-语言编码器,并采用轻量级语言适配模块实现低资源语种的快速泛化。本文系统解析ManusAI如何在

- AIGC模型泛化能力:文心一言的多场景适应

AI原生应用开发

AI原生应用开发AIGC文心一言ai

AIGC模型泛化能力:文心一言的多场景适应关键词:AIGC、泛化能力、文心一言、多场景适应、迁移学习、元学习、领域适配摘要:本文深入解析百度文心一言在多场景下的泛化能力构建技术,从核心概念、算法原理、数学模型到实战应用展开分析。通过揭示文心一言的分层适配架构、动态知识融合机制及多模态协同策略,探讨其如何突破单一场景限制,实现内容生成、智能交互、跨领域任务的高效迁移。结合具体代码案例和数学推导,展示

- 第23篇:AI技术实战:基于深度学习的图像识别与分类

CarlowZJ

AI+Python人工智能深度学习分类

目录一、深度学习在图像识别中的应用(一)卷积神经网络(CNN)的关键组件(二)预训练模型迁移学习二、代码示例(一)使用TensorFlow和Keras实现CNN进行图像分类1.数据准备与预处理2.构建CNN模型3.模型训练与评估(二)使用预训练模型进行迁移学习1.使用ResNet-50预训练模型2.微调预训练模型三、应用场景(一)安防监控(二)医疗影像诊断(三)智能零售(四)工业制造四、注意事项(

- 一篇文章理解Source-Free Domain Adaptation(SFDA)

2501_92336788

迁移学习

这篇文章将从TransferLearning→DomainAdaptation→UnsupervisedDomainAdaptation→Source-FreeDomainAdaptation的顺序进行讲解一、迁移学习(TransferLearning):解决“知识搬家”的问题学术视角:迁移学习的目标是:将一个领域中学到的知识迁移到另一个不同但相关的领域中。给定:源域(Sourcedomain)D

- 迁移学习解析

劭清

深度学习迁移学习人工智能机器学习

一、迁移学习的核心价值1.1定义与范式演进迁移学习(TransferLearning)是通过将源领域的知识迁移到目标领域,提升目标领域模型性能的机器学习范式。其演进路径为:传统机器学习深度学习迁移学习元学习/领域自适应1.2核心优势对比方法数据需求训练成本适用场景传统训练大量标注数据高数据充足场景迁移学习少量标注数据低数据稀缺领域从头训练海量标注数据极高研究级场景1.3应用场景分析跨领域应用:自然

- AIGC领域Stable Diffusion的模型微调方法与实践

AI大模型应用工坊

AI大模型开发实战AIGCstablediffusionai

AIGC领域StableDiffusion的模型微调方法与实践关键词:StableDiffusion、模型微调、AIGC、深度学习、生成对抗网络、文本到图像生成、迁移学习摘要:本文系统解析StableDiffusion模型微调的核心技术体系,从基础原理到工程实践展开深度探讨。首先剖析StableDiffusion的核心架构与微调理论基础,分类讲解全量微调、参数高效微调(LoRA/QLoRA)、特征

- Transformer大模型实战 针对下游任务进行微调

AI大模型应用之禅

javapythonjavascriptkotlingolang架构人工智能

Transformer,微调,下游任务,自然语言处理,预训练模型,迁移学习,计算机视觉1.背景介绍近年来,深度学习在人工智能领域取得了突破性进展,其中Transformer模型凭借其强大的序列建模能力,在自然语言处理(NLP)领域取得了显著成就。BERT、GPT、T5等基于Transformer的预训练模型,在文本分类、机器翻译、问答系统等任务上展现出令人惊叹的性能。然而,这些预训练模型通常在大型

- 已经训练好的 YOLO 模型,添加新的识别标签(类别)的步骤和注意事项

LeonDL168

YOLOYOLO深度学习python人工智能YOLO模型添加新的识别标签YOLO迁移学习yolov5/yolo11

在已经训练好YOLO模型后添加新的识别标签(类别),可以通过迁移学习的方式高效完成,而不必重新训练整个模型。以下是具体步骤和注意事项:一、准备工作保存原模型:确保有原始训练的checkpoint文件(如best.pt或last.pt)。标注新类别数据:为新增类别准备标注数据,格式需与原数据一致(YOLO格式的.txt文件)。更新配置文件:修改data.yaml增加新类别:nc:81#原80类+新增

- 人工智能100问☞第32问:什么是迁移学习?

AI算力那些事儿

人工智能100问人工智能迁移学习机器学习

目录一、通俗解释二、专业解析三、权威参考迁移学习就是让AI把在一个任务中学到的本事,拿来加速另一个任务的学习,实现“举一反三”。一、通俗解释想象你已经学会了打乒乓球,现在去学打网球,是不是会学得更快?因为你的眼力、反应速度、挥拍动作都可以“迁移”过去。这就是迁移学习的意思:AI模型在一个任务上学到的“经验”,可以拿来帮它更快学会另一个任务。举个例子:一个AI模型本来是用来识别猫和狗的,现在你想用它

- Enum 枚举

120153216

enum枚举

原文地址:http://www.cnblogs.com/Kavlez/p/4268601.html Enumeration

于Java 1.5增加的enum type...enum type是由一组固定的常量组成的类型,比如四个季节、扑克花色。在出现enum type之前,通常用一组int常量表示枚举类型。比如这样:

public static final int APPLE_FUJI = 0

- Java8简明教程

bijian1013

javajdk1.8

Java 8已于2014年3月18日正式发布了,新版本带来了诸多改进,包括Lambda表达式、Streams、日期时间API等等。本文就带你领略Java 8的全新特性。

一.允许在接口中有默认方法实现

Java 8 允许我们使用default关键字,为接口声明添

- Oracle表维护 快速备份删除数据

cuisuqiang

oracle索引快速备份删除

我知道oracle表分区,不过那是数据库设计阶段的事情,目前是远水解不了近渴。

当前的数据库表,要求保留一个月数据,且表存在大量录入更新,不存在程序删除。

为了解决频繁查询和更新的瓶颈,我在oracle内根据需要创建了索引。但是随着数据量的增加,一个半月数据就要超千万,此时就算有索引,对高并发的查询和更新来说,让然有所拖累。

为了解决这个问题,我一般一个月会进行一次数据库维护,主要工作就是备

- java多态内存分析

麦田的设计者

java内存分析多态原理接口和抽象类

“ 时针如果可以回头,熟悉那张脸,重温嬉戏这乐园,墙壁的松脱涂鸦已经褪色才明白存在的价值归于记忆。街角小店尚存在吗?这大时代会不会牵挂,过去现在花开怎么会等待。

但有种意外不管痛不痛都有伤害,光阴远远离开,那笑声徘徊与脑海。但这一秒可笑不再可爱,当天心

- Xshell实现Windows上传文件到Linux主机

被触发

windows

经常有这样的需求,我们在Windows下载的软件包,如何上传到远程Linux主机上?还有如何从Linux主机下载软件包到Windows下;之前我的做法现在看来好笨好繁琐,不过也达到了目的,笨人有本方法嘛;

我是怎么操作的:

1、打开一台本地Linux虚拟机,使用mount 挂载Windows的共享文件夹到Linux上,然后拷贝数据到Linux虚拟机里面;(经常第一步都不顺利,无法挂载Windo

- 类的加载ClassLoader

肆无忌惮_

ClassLoader

类加载器ClassLoader是用来将java的类加载到虚拟机中,类加载器负责读取class字节文件到内存中,并将它转为Class的对象(类对象),通过此实例的 newInstance()方法就可以创建出该类的一个对象。

其中重要的方法为findClass(String name)。

如何写一个自己的类加载器呢?

首先写一个便于测试的类Student

- html5写的玫瑰花

知了ing

html5

<html>

<head>

<title>I Love You!</title>

<meta charset="utf-8" />

</head>

<body>

<canvas id="c"></canvas>

- google的ConcurrentLinkedHashmap源代码解析

矮蛋蛋

LRU

原文地址:

http://janeky.iteye.com/blog/1534352

简述

ConcurrentLinkedHashMap 是google团队提供的一个容器。它有什么用呢?其实它本身是对

ConcurrentHashMap的封装,可以用来实现一个基于LRU策略的缓存。详细介绍可以参见

http://code.google.com/p/concurrentlinke

- webservice获取访问服务的ip地址

alleni123

webservice

1. 首先注入javax.xml.ws.WebServiceContext,

@Resource

private WebServiceContext context;

2. 在方法中获取交换请求的对象。

javax.xml.ws.handler.MessageContext mc=context.getMessageContext();

com.sun.net.http

- 菜鸟的java基础提升之道——————>是否值得拥有

百合不是茶

1,c++,java是面向对象编程的语言,将万事万物都看成是对象;java做一件事情关注的是人物,java是c++继承过来的,java没有直接更改地址的权限但是可以通过引用来传值操作地址,java也没有c++中繁琐的操作,java以其优越的可移植型,平台的安全型,高效性赢得了广泛的认同,全世界越来越多的人去学习java,我也是其中的一员

java组成:

- 通过修改Linux服务自动启动指定应用程序

bijian1013

linux

Linux中修改系统服务的命令是chkconfig (check config),命令的详细解释如下: chkconfig

功能说明:检查,设置系统的各种服务。

语 法:chkconfig [ -- add][ -- del][ -- list][系统服务] 或 chkconfig [ -- level <</SPAN>

- spring拦截器的一个简单实例

bijian1013

javaspring拦截器Interceptor

Purview接口

package aop;

public interface Purview {

void checkLogin();

}

Purview接口的实现类PurviesImpl.java

package aop;

public class PurviewImpl implements Purview {

public void check

- [Velocity二]自定义Velocity指令

bit1129

velocity

什么是Velocity指令

在Velocity中,#set,#if, #foreach, #elseif, #parse等,以#开头的称之为指令,Velocity内置的这些指令可以用来做赋值,条件判断,循环控制等脚本语言必备的逻辑控制等语句,Velocity的指令是可扩展的,即用户可以根据实际的需要自定义Velocity指令

自定义指令(Directive)的一般步骤

&nbs

- 【Hive十】Programming Hive学习笔记

bit1129

programming

第二章 Getting Started

1.Hive最大的局限性是什么?一是不支持行级别的增删改(insert, delete, update)二是查询性能非常差(基于Hadoop MapReduce),不适合延迟小的交互式任务三是不支持事务2. Hive MetaStore是干什么的?Hive persists table schemas and other system metadata.

- nginx有选择性进行限制

ronin47

nginx 动静 限制

http {

limit_conn_zone $binary_remote_addr zone=addr:10m;

limit_req_zone $binary_remote_addr zone=one:10m rate=5r/s;...

server {...

location ~.*\.(gif|png|css|js|icon)$ {

- java-4.-在二元树中找出和为某一值的所有路径 .

bylijinnan

java

/*

* 0.use a TwoWayLinkedList to store the path.when the node can't be path,you should/can delete it.

* 1.curSum==exceptedSum:if the lastNode is TreeNode,printPath();delete the node otherwise

- Netty学习笔记

bylijinnan

javanetty

本文是阅读以下两篇文章时:

http://seeallhearall.blogspot.com/2012/05/netty-tutorial-part-1-introduction-to.html

http://seeallhearall.blogspot.com/2012/06/netty-tutorial-part-15-on-channel.html

我的一些笔记

===

- js获取项目路径

cngolon

js

//js获取项目根路径,如: http://localhost:8083/uimcardprj

function getRootPath(){

//获取当前网址,如: http://localhost:8083/uimcardprj/share/meun.jsp

var curWwwPath=window.document.locati

- oracle 的性能优化

cuishikuan

oracleSQL Server

在网上搜索了一些Oracle性能优化的文章,为了更加深层次的巩固[边写边记],也为了可以随时查看,所以发表这篇文章。

1.ORACLE采用自下而上的顺序解析WHERE子句,根据这个原理,表之间的连接必须写在其他WHERE条件之前,那些可以过滤掉最大数量记录的条件必须写在WHERE子句的末尾。(这点本人曾经做过实例验证过,的确如此哦!

- Shell变量和数组使用详解

daizj

linuxshell变量数组

Shell 变量

定义变量时,变量名不加美元符号($,PHP语言中变量需要),如:

your_name="w3cschool.cc"

注意,变量名和等号之间不能有空格,这可能和你熟悉的所有编程语言都不一样。同时,变量名的命名须遵循如下规则:

首个字符必须为字母(a-z,A-Z)。

中间不能有空格,可以使用下划线(_)。

不能使用标点符号。

不能使用ba

- 编程中的一些概念,KISS、DRY、MVC、OOP、REST

dcj3sjt126com

REST

KISS、DRY、MVC、OOP、REST (1)KISS是指Keep It Simple,Stupid(摘自wikipedia),指设计时要坚持简约原则,避免不必要的复杂化。 (2)DRY是指Don't Repeat Yourself(摘自wikipedia),特指在程序设计以及计算中避免重复代码,因为这样会降低灵活性、简洁性,并且可能导致代码之间的矛盾。 (3)OOP 即Object-Orie

- [Android]设置Activity为全屏显示的两种方法

dcj3sjt126com

Activity

1. 方法1:AndroidManifest.xml 里,Activity的 android:theme 指定为" @android:style/Theme.NoTitleBar.Fullscreen" 示例: <application

- solrcloud 部署方式比较

eksliang

solrCloud

solrcloud 的部署其实有两种方式可选,那么我们在实践开发中应该怎样选择呢? 第一种:当启动solr服务器时,内嵌的启动一个Zookeeper服务器,然后将这些内嵌的Zookeeper服务器组成一个集群。 第二种:将Zookeeper服务器独立的配置一个集群,然后将solr交给Zookeeper进行管理

谈谈第一种:每启动一个solr服务器就内嵌的启动一个Zoo

- Java synchronized关键字详解

gqdy365

synchronized

转载自:http://www.cnblogs.com/mengdd/archive/2013/02/16/2913806.html

多线程的同步机制对资源进行加锁,使得在同一个时间,只有一个线程可以进行操作,同步用以解决多个线程同时访问时可能出现的问题。

同步机制可以使用synchronized关键字实现。

当synchronized关键字修饰一个方法的时候,该方法叫做同步方法。

当s

- js实现登录时记住用户名

hw1287789687

记住我记住密码cookie记住用户名记住账号

在页面中如何获取cookie值呢?

如果是JSP的话,可以通过servlet的对象request 获取cookie,可以

参考:http://hw1287789687.iteye.com/blog/2050040

如果要求登录页面是html呢?html页面中如何获取cookie呢?

直接上代码了

页面:loginInput.html

代码:

<!DOCTYPE html PUB

- 开发者必备的 Chrome 扩展

justjavac

chrome

Firebug:不用多介绍了吧https://chrome.google.com/webstore/detail/bmagokdooijbeehmkpknfglimnifench

ChromeSnifferPlus:Chrome 探测器,可以探测正在使用的开源软件或者 js 类库https://chrome.google.com/webstore/detail/chrome-sniffer-pl

- 算法机试题

李亚飞

java算法机试题

在面试机试时,遇到一个算法题,当时没能写出来,最后是同学帮忙解决的。

这道题大致意思是:输入一个数,比如4,。这时会输出:

&n

- 正确配置Linux系统ulimit值

字符串

ulimit

在Linux下面部 署应用的时候,有时候会遇上Socket/File: Can’t open so many files的问题;这个值也会影响服务器的最大并发数,其实Linux是有文件句柄限制的,而且Linux默认不是很高,一般都是1024,生产服务器用 其实很容易就达到这个数量。下面说的是,如何通过正解配置来改正这个系统默认值。因为这个问题是我配置Nginx+php5时遇到了,所以我将这篇归纳进

- hibernate调用返回游标的存储过程

Supanccy2013

javaDAOoracleHibernatejdbc

注:原创作品,转载请注明出处。

上篇博文介绍的是hibernate调用返回单值的存储过程,本片博文说的是hibernate调用返回游标的存储过程。

此此扁博文的存储过程的功能相当于是jdbc调用select 的作用。

1,创建oracle中的包,并在该包中创建的游标类型。

---创建oracle的程

- Spring 4.2新特性-更简单的Application Event

wiselyman

application

1.1 Application Event

Spring 4.1的写法请参考10点睛Spring4.1-Application Event

请对比10点睛Spring4.1-Application Event

使用一个@EventListener取代了实现ApplicationListener接口,使耦合度降低;

1.2 示例

包依赖

<p