MySQL这一章就够了(一)

前言:呕心沥血5个月淦出本文,整理所有MySQL知识。我愿称之为地表最强MySQL。

MySql笔记

MySQL是关系型数据库,基于SQL查询的开源跨平台数据库管理系统。它最初是由瑞典MySQL AB公司开发的。现在它是Oracle Corporation的分支机构。

Mysql特点: 开源、兼容多个平台、扩展性强

数据库三大范式:

为避免数据冗余、操作异常和性能问题,需进行数据规范化。

数据库的三大范式:

第一范式:确保每列都是不可再分的最小数据单元

第二范式:确保每列都与主键相关

第三范式:确保表中各列必须和主键相关,不存在依赖关系。

一、SQL简述

1、SQL的概述

Structure Query Language(结构化查询语言)简称SQL,它被美国国家标准局(ANSI)确定为关系型数据库语言的美国标准,后被国际化标准组织(ISO)采纳为关系数据库语言的国际标准。数据库管理系统可以通过SQL管理数据库;定义和操作数据,维护数据的完整性和安全性。

MySQL是一个关系型数据库管理系统,由瑞典MySQL AB公司开发,目前属于Oracle公司。

MySQL是一种关联数据库管理系统,将数据保存在不同的表中,而不是将所有的数据放在一个大仓库内,这样就增加了速度并提高了灵活性。

MySQL是开源的,所以你不需要支付额外的费用。

MySQL支持大型的数据库,可以处理拥有上千万条记录的大型数据库。

MySQL使用标准的SQL数据语言形式。

MySQL可以允许于多个系统上,并且支持多种语言。这些编程语言包括C、C++、Python、Java、Perl、PHP、Ruby和Tcl等。

MySQL对PHP有很好的支持,PHP是目前最流行的Web开发语言。

MySQL单表的上限,主要与操作系统支持的最大文件大小有关。MySQL支持大型数据库,支持5000万条记录的数据仓库,32位系统表文件最大可支持4GB,64位系统支持最大的表文件为8TB。 经过数据库的优化后5千万条记录(10G)下运行良好。

InnoDB 存储引擎将InnoDB 表保存在一个表空间内,该表空间可由数个文件创建。这样,表的大小就能超过单独文件的最大容量。表空间可包括原始磁盘分区,从而使得很大的表成为可能。表空间的最大容量为64TB。

mysql最大连接数是1000。

MySQL是可以定制的,采用lGPL协议,你可以修改源码来开发自己的MySQL系统。

GPL协议最主要的几个原则:

1、确保软件自始至终都以开放源代码形式发布,保护开发成果不被窃取用作商业发售。任何一套软件,只要其中使用了受 GPL 协议保护的第三方软件的源程序,并向非开发人员发布时,软件本身也就自动成为受 GPL 保护并且约束的实体。也就是说,此时它必须开放源代码。

2、GPL 大致就是一个左侧版权(Copyleft,或译为“反版权”、“版权属左”、“版权所无”、“版责”等)的体现。你可以去掉所有原作的版权 信息,只要你保持开源,并且随源代码、二进制版附上 GPL 的许可证就行,让后人可以很明确地得知此软件的授权信息。GPL 精髓就是,只要使软件在完整开源 的情况下,尽可能使使用者得到自由发挥的空间,使软件得到更快更好的发展。

3、无论软件以何种形式发布,都必须同时附上源代码。例如在 Web 上提供下载,就必须在二进制版本(如果有的话)下载的同一个页面,清楚地提供源代码下载的链接。如果以光盘形式发布,就必须同时附上源文件的光盘。

4、开发或维护遵循 GPL 协议开发的软件的公司或个人,可以对使用者收取一定的服务费用。但还是一句老话——必须无偿提供软件的完整源代码,不得将源代码与服务做捆绑或任何变相捆绑销售。

2、MySQL历史:

MySQL数据库隶属于MySQL AB公司,总部位于瑞典。

08年被sun公司收购。

09年sun被oracle公司收购。

1、MySQL的历史可以追溯到1979年,一个名为Monty Widenius的程序员在为TcX的小公司打工,并且用BASIC设计了一个报表工具,使其可以在4MHz主频和16KB内存的计算机上运行。当时,这只是一个很底层的且仅面向报表的存储引擎,名叫Unireg。

2、1990年,TcX公司的客户中开始有人要求为他的API提供SQL支持。Monty直接借助于mSQL的代码,将它集成到自己的存储引擎中。令人失望的是,效果并不太令人满意,决心自己重写一个SQL支持。

3、 1996年,MySQL 1.0发布,它只面向一小拨人,相当于内部发布。到了1996年10月,MySQL 3.11.1发布(MySQL没有2.x版本),最开始只提供Solaris下的二进制版本。一个月后,Linux版本出现了。在接下来的两年里,MySQL被依次移植到各个平台。

4、1999~2000年,MySQL AB公司在瑞典成立。Monty雇了几个人与Sleepycat合作,开发出了Berkeley DB引擎, 由于BDB支持事务处理,因此MySQL从此开始支持事务处理了。

5、2000,MySQL不仅公布自己的源代码,并采用GPL(GNU General Public License)许可协议,正式进入开源世界。同年4月,MySQL对旧的存储引擎ISAM进行了整理,将其命名为MyISAM。

6、2001年,集成Heikki Tuuri的存储引擎InnoDB,这个引擎不仅能持事务处理,并且支持行级锁。后来该引擎被证明是最为成功的MySQL事务存储引擎。MySQL与InnoDB的正式结合版本是4.0

7、2003年12月,MySQL 5.0版本发布,提供了视图、存储过程等功能。

8、2008年1月,MySQL AB公司被Sun公司以10亿美金收购,MySQL数据库进入Sun时代。在Sun时代,Sun公司对其进行了大量的推广、优化、Bug修复等工作。

9、2008年11月,MySQL 5.1发布,它提供了分区、事件管理,以及基于行的复制和基于磁盘的NDB集群系统,同时修复了大量的Bug。

10、2009年4月,Oracle公司以74亿美元收购Sun公司,自此MySQL数据库进入Oracle时代,而其第三方的存储引擎InnoDB早在2005年就被Oracle公司收购。

11、2010年12月,MySQL 5.5发布,其主要新特性包括半同步的复制及对SIGNAL/RESIGNAL的异常处理功能的支持,最重要的是InnoDB存储引擎终于变为当前MySQL的默认存储引擎。MySQL 5.5不是时隔两年后的一次简单的版本更新,而是加强了MySQL各个方面在企业级的特性。Oracle公司同时也承诺MySQL 5.5和未来版本仍是采用GPL授权的开源产品。

MySQL 其实是分为 server层 和 引擎层两部分。

- Server 层:它主要做的是 MySQL 功能层面的事情;

- 引擎层:负责存储相关的具体事宜。

3、SQL的优点

1) 功能强大

MySQL 中提供了多种数据库存储引擎,各引擎各有所长,适用于不同的应用场合,用户可以选择最合适的引擎以得到最高性能,可以处理每天访问量超过数亿的高强度的搜索 Web 站点。MySQL5 支持事务、视图、存储过程、触发器等。

2) 支持跨平台

MySQL 支持至少 20 种以上的开发平台,包括 Linux、Windows、FreeBSD 、IBMAIX、AIX、FreeBSD 等。这使得在任何平台下编写的程序都可以进行移植,而不需要对程序做任何的修改。

3) 运行速度快

高速是 MySQL 的显著特性。在 MySQL 中,使用了极快的 B 树磁盘表(MyISAM)和索引压缩;通过使用优化的单扫描多连接,能够极快地实现连接;SQL 函数使用高度优化的类库实现,运行速度极快。

4) 支持面向对象

PHP 支持混合编程方式。编程方式可分为纯粹面向对象、纯粹面向过程、面句对象与面向过程混合 3 种方式。

5) 安全性高

灵活和安全的权限与密码系统,允许基本主机的验证。连接到服务器时,所有的密码传输均采用加密形式,从而保证了密码的安全。

6) 成本低

MySQL 数据库是一种完全免费的产品,用户可以直接通过网络下载。

7) 支持各种开发语言

MySQL 为各种流行的程序设计语言提供支持,为它们提供了很多的 API 函数,包括 PHP、ASP.NET、Java、Eiffel、Python、Ruby、Tcl、C、C++、Perl 语言等。

8) 数据库存储容量大

MySQL 数据库的最大有效表尺寸通常是由操作系统对文件大小的限制决定的,而不是由 MySQL 内部限制决定的。InnoDB 存储引擎将 InnoDB 表保存在一个表空间内,该表空间可由数个文件创建,表空间的最大容量为 64TB,可以轻松处理拥有上千万条记录的大型数据库。

9) 支持强大的内置函数

PHP 中提供了大量内置函数,几乎涵盖了 Web 应用开发中的所有功能。它内置了数据库连接、文件上传等功能,MySQL 支持大量的扩展库,如 MySQLi 等,可以为快速开发 Web 应用提供便利。

4、SQL语言的分类

1、DDL(Data Definition Language) 数据定义语言,用来操作数据库、表、列等; 常用语句:create、alter、drop

2、DML(Data Manipulation Language) 数据操作语言,用来操作数据库中表里的数据;常用语句:insert、update、delete

3、DCL(Data Control Language) 数据控制语言,用来操作访问权限和安全级别; 常用语句:grant、deny

4、DQL(Data Query Language) 数据查询语言,用来查询数据 常用语句:select

5、TCL(Transaction Control Language)事务控制语言。

5、MySQL的语法规范

1、不区分大小写,但建议关键字大写,表名、列名小写

2、每条命令最好用分号结尾(DOS命令行必须,可视化工具最好加分号)。在一些场景下用\g,或者不加也行。

3、每条命令根据需要,可以进行缩进或换行

4、注释:

- 单行注释:#注释文字,

- 单行注释:-- 注释文字

- 多行注释:/* 注释文字*/

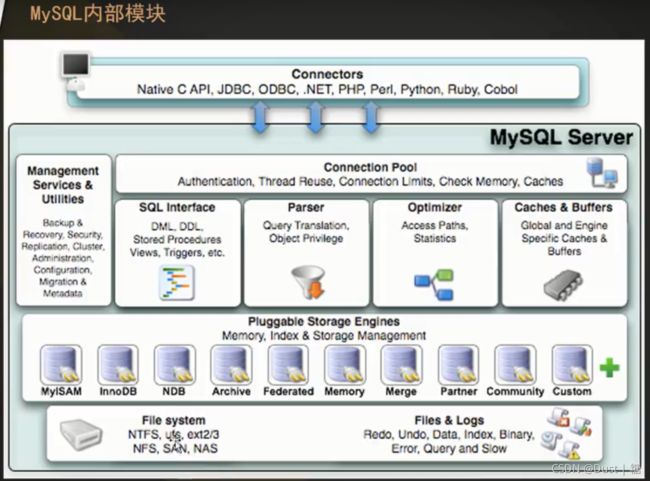

6、MySQL内部模块

和其他数据库相比,MySQL有点与众不同,它的架构可以在多种不同场景中应用并发挥良好作用。主要体现在存储引擎的架构上。

插件式的存储引擎架构将查询处理和其它的系统任务以及数据的存储提起相分离 。这种架构可以根据业务的需求和实际需要选择合适的存储引擎。

-

连接层

最上层是一些客户端和连接服务,包含本地sock通信和大多数基于客户端/服务端工具实现的类似于tcp/ip的通信。主要完成一些类似于连接处理、授权认证、及相关的安全方案。在该层上引入了线程池的概念,为通过认证安全接入的客户端提供线程。同样在该层上可以实现基于SSL的安全链接。服务器也会为安全接入的每个客户端验证它所具有的操作权限。

-

服务层

第二层架构主要完成大多少的核心服务功能,如SQL接口,并完成缓存的查询,SQL的分析和优化及部分内置函数的执行。所有跨存储引擎的功能也在这一层实现,如过程、函数等。在该层,服务器会解析查询并创建相应的内部解析树,并对其完成相应的优化如确定查询表的顺序,是否利用索引等,最后生成相应的执行操作。如果是select语句,服务器还会查询内部的缓存。如果缓存空间足够大,这样在解决大量读操作的环境中能够很好的提升系统的性能。

-

引擎层

存储引擎层,存储引擎真正的负责了MySQL中数据的存储和提取,服务器通过API与存储引擎进行通信。不同的存储引擎具有的功能不同,这样我们可以根据自己的时机需要进行选取。主要是MyISAM和InnoDB引擎。

-

存储层

数据存储层,主要是将数据存储在运行与裸设备的文件系统之上,并完成与存储引擎的交互。

7、DB、DBS、DBMS

数据库DB、数据库系统DBS、数据库管理系统DBMS三者关系:

DB:数据库(Database,简称DB)是指:长期储存在计算机内的、有组织的、可共享的大量数据集合。一个应用系统通常包含多个数据库。存取数据的容器。

DBMS:数据库管理系统(Database Management System,简称 DBMS )是位于用户(应用程序)与操作系统之间的一层数据库管理软件,DBMS是独立、开放的数据库管理软件(提供多种外部接口,管理的数据可以被其它外部应用程序调用),用于科学地组织和存储数据以及高效地获取和维护数据。又称为数据库软件(产品),用于管理DB中的数据。

- 基于共享文件系统的DBMS(Access)

- 基于客户机——服务器的DBMS。(MySQL、Oracle、SqlServer)

DBS:数据库系统(Database System,简称DBS)是指在计算机应用系统中引入数据库后的系统构成。数据库系统由数据库、数据库管理系统(及其开发工具)、应用系统、数据库管理员(和用户)构成。

SQL:结构化查询语言(Structure Query Language):专门用来与数据库通信的语言。用于和DBMS通信的语言。

所以DBS包含DB和DBMS,DBS的核心是DBMS,对于程序员来讲,DBMS提供了很大的便利,可以更加专注程序本身。DBS与普通软件系统的最大区别在于:普通软件自己管理数据及数据安全,DBS由DBMS帮我们管理数据和安全性。

8、MySQL存储数据时的特点:

- 数据存放到表中,然后表再放到库中。

- 一个库中可以有多张表,每张表具有唯一的表名来标识自己。

- 表中有一个或多个列,列有称为“字段”,相当于java中的“属性”。

- 表中的没一行数据,相当于java中的“对象”。

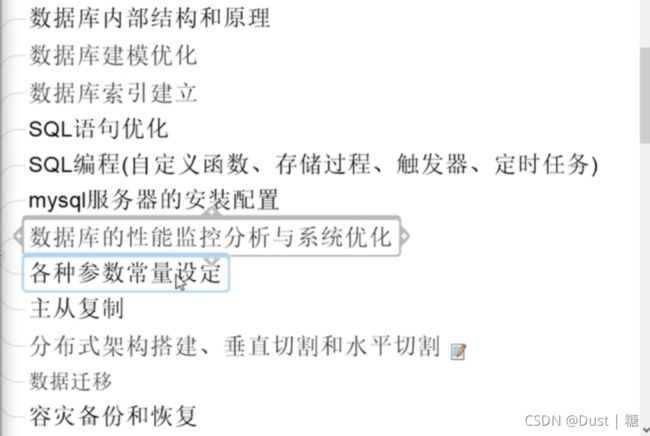

9、Mysql高手是怎么炼成的:

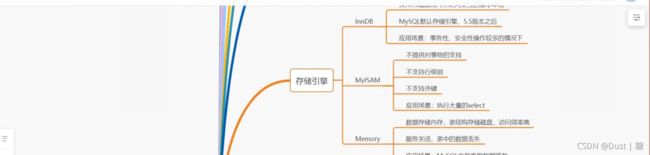

二、Mysql中的数据库引擎

数据库中的存储引擎其实是对使用了该引擎的表进行某种设置,数据库中的表设定了什么存储引擎,那么该表在数据存储方式、数据更新方式、数据查询性能以及是否支持索引等方面就会有不同的“效果”。

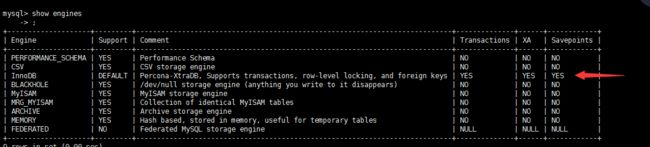

MySQL有以下几种引擎:InnoDB、ISAM、MyISAM、HEAP(也称为MEMORY)、CSV、BLACKHOLE、ARCHIVE、PERFORMANCE_SCHEMA、Berkeley、Merge、Federated和Cluster/NDB等。 除此以外我们也可以参照MySQL++ API创建自己的数据库引擎。

InnoDB:

该存储引擎为MySQL表提供了ACID事务支持、系统崩溃修复能力和多版本并发控制(即MVCC Multi-Version Concurrency Control)的行级锁;该引擎支持自增长列(auto_increment),自增长列的值不能为空,如果在使用的时候为空则自动从现有值开始增值,如果有但是比现在的还大,则直接保存这个值; 该引擎存储引擎支持外键(foreign key) ,外键所在的表称为子表而所依赖的表称为父表。该引擎在5.5后的MySQL数据库中为默认存储引擎。

1.将数据存储在表空间中,表空间由一系列的数据文件组成,由InnoDB管理;2.支持每个表的数据和索引存放在单独文件中(innodb_file_per_table);3.支持事务,采用MVCC来控制并发,并实现标准的4个事务隔离级别,支持外键;4.索引基于聚簇索引建立,对于主键查询有较高性能;5.数据文件的平台无关性,支持数据在不同的架构平台移植;6.能够通过一些工具支持真正的热备。如XtraBackup等;7.内部进行自身优化如采取可预测性预读,能够自动在内存中创建hash索引等。

ISAM:

该引擎在读取数据方面速度很快,而且不占用大量的内存和存储资源;但是ISAM不支持事务处理、不支持外来键、不能够容错、也不支持索引。该引擎在包括MySQL 5.1及其以上版本的数据库中不再支持。

MyISAM:

该引擎基于ISAM数据库引擎,除了提供ISAM里所没有的索引和字段管理等大量功能,MyISAM还使用一种表格锁定的机制来优化多个并发的读写操作,但是需要经常运行OPTIMIZE TABLE命令,来恢复被更新机制所浪费的空间,否则碎片也会随之增加,最终影响数据访问性能

1.MySQL5.1中默认,不支持事务和行级锁;2.提供大量特性如全文索引、空间函数、压缩、延迟更新等;3.数据库故障后,安全恢复性差;4.对于只读数据可以忍受故障恢复,MyISAM依然非常适用;5.日志服务器的场景也比较适用,只需插入和数据读取操作;6.不支持单表一个文件,会将所有的数据和索引内容分别存在两个文件中;7.MyISAM对整张表加锁而不是对行,所以不适用写操作比较多的场景;8.支持索引缓存不支持数据缓存。

Mrg_MyISAM引擎:

将多个MYISAM表合并为一个。本身并不存储数据,数据存在MyISAM表中间。

Memory(也称HEAP):

该存储引擎通过在内存中创建临时表来存储数据。每个基于该存储引擎的表实际对应一个磁盘文件,该文件的文件名和表名是相同的,类型为.frm。该磁盘文件只存储表的结构,而其数据存储在内存中,所以使用该种引擎的表拥有极高的插入、更新和查询效率。这种存储引擎默认使用哈希(HASH)索引,其速度比使用B-+Tree型要快,但也可以使用B树型索引。由于这种存储引擎所存储的数据保存在内存中,所以其保存的数据具有不稳定性,比如如果mysqld进程发生异常、重启或计算机关机等等都会造成这些数据的消失,所以这种存储引擎中的表的生命周期很短,一般只使用一次。

将数据在内存中缓存,不消耗IO。存储数据速度较快但不会被保留,一般作为临时表的存储被使用。

如果需要快速地访问数据,并且这些数据不会被修改,重启以后丢失也没有关系,那么使用Menory表时非常有用。Memory表至少比MyISAM表至少比MyISAM表要快一个数量级。

CSV:

(Comma-Separated Values逗号分隔值)

使用该引擎的MySQL数据库表会在MySQL安装目录data文件夹中的和该表所在数据库名相同的目录中生成一个.CSV文件(所以,它可以将CSV类型的文件当做表进行处理),这种文件是一种普通文本文件,每个数据行占用一个文本行。该种类型的存储引擎不支持索引,即使用该种类型的表没有主键列;另外也不允许表中的字段为null。

可以打开CSV文件存储的数据,可以将存储的数据导出,并利用excel打开。可以作为一种数据交换的机制使用。

CSV引擎可以将普通的CSV文件作为MySQL的表来处理,但不支持索引。

CSV引擎可以作为一种数据交换的机制,非常有用。

CSV存储的数据直接可以在操作系统里,用文本编辑器,或者execl读取。

CSV文件格式:

![]()

BLACKHOLE(黑洞引擎):

该存储引擎支持事务,而且支持mvcc的行级锁,写入这种引擎表中的任何数据都会消失,主要用于做日志记录(二进制日志)或同步归档的中继存储,会在一些特殊需要的复制架构的环境中使用。

Blackhole引擎没有实现任何存储机制,它会丢弃所有插入的数据,不做任何保存。但服务器会记录Blackhole表的记录,所以可以用于复制数据到备库,或者简单地记录到日志。但这种应用会碰到很多问题,因此并不推荐。

Archive:

该存储引擎适合存储大量独立的、作为历史记录的数据。

1.只支持insert和select操作;

2.缓存所有的写数据并进行压缩存储,支持行级锁但不支持事务;

3.适合高速插入和数据压缩,减少IO操作,适用于日志记录和归档服务器。

4.不支持索引,所以查询性能较差一些。

在MySQL5.1之前不支持索引。Archive表适合日志和数据采集类应用。

根据英文的结论来看,Archive表比MyISAM表要小大学75%,比支持事务处理的InnoDB表小大约83%。

PERFORMANCE_SCHEMA:

performance_schema

该引擎主要用于收集数据库服务器性能参数。这种引擎提供以下功能:提供进程等待的详细信息,包括锁、互斥变量、文件信息;保存历史的事件汇总信息,为提供MySQL服务器性能做出详细的判断;对于新增和删除监控事件点都非常容易,并可以随意改变mysql服务器的监控周期,例如(CYCLE、MICROSECOND)。

Berkeley(BDB):

该存储引擎支持COMMIT和ROLLBACK等其他事务特性。该引擎在包括MySQL 5.1及其以上版本的数据库中不再支持。

Merge:

该引擎将一定数量的MyISAM表联合而成一个整体。

Merge存储引擎允许将一组使用MyISAM存储引擎的并且表结构相同(即每张表的字段顺序、字段名称、字段类型、索引定义的顺序及其定义的方式必须相同)的数据表合并为一个表,方便了数据的查询。

Federated:

该存储引擎可以不同的Mysql服务器联合起来,逻辑上组成一个完整的数据库。这种存储引擎非常适合数据库分布式应用。

比如:跨库的连表查询。

Federated引擎是访问其他MySQL服务器的一个代理,尽管改引擎看起来提供了一种很好的跨服务器的灵活性,但也经常带来问题,因此默认是禁用的。

Cluster/NDB:

该存储引擎用于多台数据机器联合提供服务以提高整体性能和安全性。适合数据量大、安全和性能要求高的场景。

MySQL Cluster专用。

阿里巴巴和淘宝的引擎:

| 产品 | 价格 | 目标 | 主要功能 | 是否可投入生产? |

|---|---|---|---|---|

| Percona Server | 免费 | 提供XtraDB存储引擎的包装器和其他分析工具 | XtraDB | 是 |

| MariaDB | 免费 | 扩展MySQL以包含XtraDB和其他性能改进 | MariaDB | 是 |

| Drizzle | 免费 | 提供MySQL更强大的可扩展性和性能改进 | 高可用性 | 是 |

Percona为MySQL数据库服务器进行了改进,在功能和性能上较MySQL有着很显著的提升。该版本提升了在高负载情况下的InnoDB的性能、为DBA提供一些非常有用的性能诊断工具:另外有更多的参数和命令来控制服务器行为。

该公司新建了一款存储引擎叫xtradb完全可以替代innodb,并且在性能和并发上做的更好。

阿里巴巴大部分mysql数据库其实使用的percona的原型加以修改。

AliSql+AliRedis。

Percona 数据库

Percona 数据库

Percona介绍

Percona Server由领先的MySQL咨询公司Percona发布。 Percona Server是一款独立的数据库产品,其可以完全与MySQL兼容,可以在不更改代码的情况了下将存储引擎更换成XtraDB 。

Percona团队的最终声明是“Percona Server是由Oracle发布的最接近官方MySQL Enterprise发行版的版本”,因此与其他更改了大量基本核心MySQL代码的分支有所区别。 Percona Server的一个缺点是他们自己管理代码,不接受外部开发人员的贡献,以这种方式确保他们对产品中所包含功能的控制。

Percona提供了高性能XtraDB引擎,还提供PXC高可用解决方案,并且附带了perconatoolkit等DBA管理工具箱

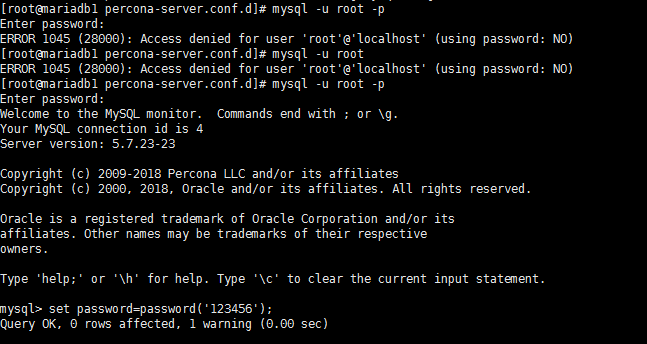

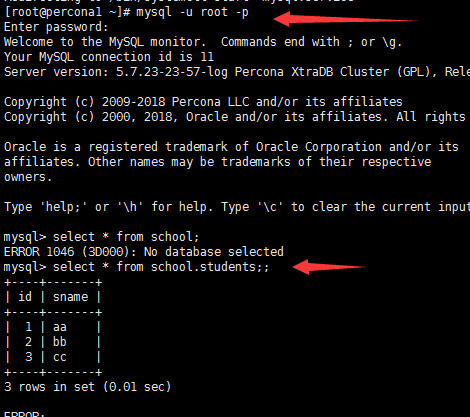

Percona 安装

#首先安装yum源

yum -y install https://www.percona.com/redir/downloads/percona-release/redhat/latest/percona-release-0.1-6.noarch.rpm

#安装percona server

yum install -y Percona-Server-server-57

#查看/etc/my.cnf的配置信息:

!includedir /etc/my.cnf.d/

!includedir /etc/percona-server.conf.d/

datadir=/var/lib/mysql

socket=/var/lib/mysql/mysql.sock

# Disabling symbolic-links is recommended to prevent assorted security risks

symbolic-links=0

log-error=/var/log/mysqld.log

pid-file=/var/run/mysqld/mysqld.pid

#初始化数据库:

mysqld --initialize --user=mysql

#启动数据库

service mysqld start

#查看mysql进程

ps –ef|grep mysql

#获取root初始化密码:

在/var/log/mysqld.log中所有password关键词,获取初始化密码:

#修改root 密码

Percona存储引擎

Percona XtraDB 是 InnoDB 存储引擎的增强版,被设计用来更好的使用更新计算机硬件系统的性能,同时还包含有一些在高性能环境下的新特性。 XtraDB 存储引擎是完全的向下兼容,在 MariaDB 中, XtraDB 存储引擎被标识为”ENGINE=InnoDB”,这个与 InnoDB 是一样的,所以你可以直接用XtraDB 替换掉 InnoDB而不会产生任何问题。 Percona XtraDB 包含有所有 InnoDB’s 健壮性,可依赖的 ACID 兼容设计和高级MVCC 架构。 XtraDB 在InnoDB 的坚实基础上构建,使 XtraDB 具有更多的特性,更好调用,更多的参数指标和更多的扩展。从实践的角度来看, XtraDB 被设计用来在多核心的条件下更有效的使用内存和更加方便,更加可用。新的特性被用来降低 InnoDB 的局限性。性能层面, XtraDB与内置的MySQL 5.1 InnoDB引擎相比,它每分钟可处理2.7倍的事务。

这是以前的数据对比, 现在新版mysql 5.7.x 或者 mysql 8.x 的 Innodb 对比 ,处理已近差不多了。

Percona高可用架构

• MHA

• MMM

• ATLAS

• MyCAT

其配置方法也和MySQL一样

Percona XtraDB Cluster (PXC)架构

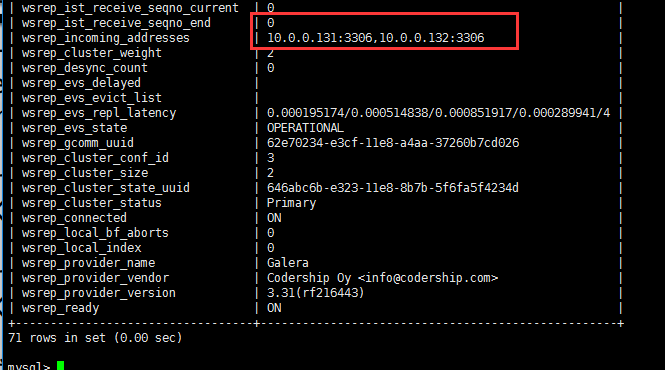

Percona XtraDB Cluster是MySQL高可用性和可扩展性的解决方案.

Percona XtraDB Cluster提供的特性有

1.同步复制,事务要么在所有节点提交或不提交。`

2.多主复制,可以在任意节点进行写操作。`

3.在从服务器上并行应用事件,真正意义上的并行复制。`

4.节点自动配置。`

5.数据一致性,不再是异步复制。

Percona XtraDB Cluster完全兼容MySQL和Percona Server,表现在:

- 数据的兼容性

- 应用程序的兼容性:无需更改应用程序 。

集群是有节点组成的,推荐配置至少3个节点,但是也可以运行在2个节点上。 每个节点都是普通的mysql/percona服务器,可以将现有的数据库服务器组成集群,

从PXC机器群可以拆分成单独的服务器。 - 每个节点都包含完整的数据副本。

PXC 优缺点

优点如下:

1.当执行一个查询时,在本地节点上执行。因为所有数据都在本地,无需远程访问。

2.无需集中管理。可以在任何时间点失去任何节点,但是集群将照常工作。

3.良好的读负载扩展,任意节点都可以查询。

缺点如下:

1.加入新节点,开销大。需要复制完整的数据

2.不能有效的解决写缩放问题,所有的写操作都将发生在所有节点上。

3.有多少个节点就有多少重复的数据

Percona XtraDB Cluster基于XtraDB的Percona Server以及包含写复制集补丁。 使用Galera 2.x library,事务型应用下的通用的多主同步复制插件。

Percona XtraDB Cluster 搭建

3个节点环境

| 主机名 | ip | 数据库版本 |

|---|---|---|

| percona1 | 10.0.0.130 | percona 5.7.23 |

| percona2 | 10.0.0.131 | percona 5.7.23 |

| percona3 | 10.0.0.132 | percona 5.7.23 |

#关闭了selinux ,防火墙

#各节点做好host解析

/etc/hosts 中添加

10.0.0.130 percona1

10.0.0.131 percona2

10.0.0.132 percona3

#每个节点删除原本安装的percona server软件:

yum erase -y Percona-Server-server-57

yum erase -y Percona-Server-client-57

#每个节点安装软件:

yum install -y Percona-XtraDB-Cluster-57

在log文件中找到root的临时密码:

每个节点修改root密码:我这省略

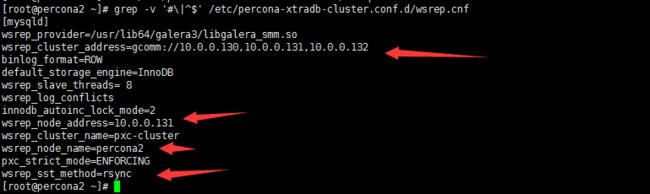

配置各个节点的/etc/percona-xtradb-cluster.conf.d/wsrep.cnf文件:

[mysqld]

wsrep_provider=/usr/lib64/galera3/libgalera_smm.so

wsrep_cluster_address=gcomm://10.0.0.130,10.0.0.131,10.0.0.132

binlog_format=ROW

default_storage_engine=InnoDB

wsrep_slave_threads= 8

wsrep_log_conflicts

innodb_autoinc_lock_mode=2

wsrep_node_address=10.0.0.130

wsrep_cluster_name=pxc-cluster

wsrep_node_name=percona1

pxc_strict_mode=ENFORCING

wsrep_sst_method=rsync

#第一个节点启动必须用下面这种方式:

systemctl start mysql@bootstrap.service

[mysqld]

wsrep_provider=/usr/lib64/galera3/libgalera_smm.so

wsrep_cluster_address=gcomm://10.0.0.130,10.0.0.131,10.0.0.132

binlog_format=ROW

default_storage_engine=InnoDB

wsrep_slave_threads= 8

wsrep_log_conflicts

innodb_autoinc_lock_mode=2

wsrep_node_address=10.0.0.131

wsrep_cluster_name=pxc-cluster

wsrep_node_name=percona2

pxc_strict_mode=ENFORCING

wsrep_sst_method=rsync

#其他节点启动percona

service mysql start

[mysqld]

wsrep_provider=/usr/lib64/galera3/libgalera_smm.so

wsrep_cluster_address=gcomm://10.0.0.130,10.0.0.131,10.0.0.132

binlog_format=ROW

default_storage_engine=InnoDB

wsrep_slave_threads= 8

wsrep_log_conflicts

innodb_autoinc_lock_mode=2

wsrep_node_address=10.0.0.132

wsrep_cluster_name=pxc-cluster

wsrep_node_name=percona3

pxc_strict_mode=ENFORCING

wsrep_sst_method=rsync

#第三个节点启动

service mysql start

#查看所有的的pxc的状态

show status like 'wsrep_%';

第一个节点:

第二个节点:

![]()

关闭第一个节点,对外操作的也没影响

恢复第一节点

其他节点插入数据,

第一节点恢复启动,数据也是同步的

MyISAM与InnoDB 的区别:

MyISAM:只支持表级锁(table-level locking);

InnoDB:既支持行级锁(row-level locking),也支持表级锁;默认行级锁。

InnoDB和MyISAM的最大不用有两点:一是支持事务、二是innodb采用行级锁 MyISAM采用表级锁。

| 对比项 | MyISAM | InnoDB |

|---|---|---|

| 主外键 | 不支持 | 不支持 |

| 事务 | 不支持 | 不支持 |

| 行表锁 | 表锁,即使操作一条记录也会锁住整个表,不适合高并发的操作 | 行锁,操作时只锁某一行,不对其他行有影响,适合高并发的操作。 |

| 缓存 | 只缓存索引,不缓存真实数据 | 不仅缓存索引还要缓存真实数据,对内存要求较高,而且内存大小对性能有决定性的影响。 |

| 关注点 | 性能 | 事务 |

| 默认安装 | Y | Y |

-

InnoDB支持事务,MyISAM不支持,对于InnoDB每一条SQL语言都默认封装成事务,自动提交,这样会影响速度,所以最好把多条SQL语言放在begin和commit之间,组成一个事务;

-

InnoDB支持外键,而MyISAM不支持。对一个包含外键的InnoDB表转为MYISAM会失败;

-

InnoDB是聚集索引,使用B+Tree作为索引结构,数据文件是和(主键)索引绑在一起的(表数据文件本身就是按B+Tree组织的一个索引结构),必须要有主键,通过主键索引效率很高。但是辅助索引需要两次查询,先查询到主键,然后再通过主键查询到数据。因此,主键不应该过大,因为主键太大,其他索引也都会很大。

MyISAM是非聚集索引,也是使用B+Tree作为索引结构,索引和数据文件是分离的,索引保存的是数据文件的指针。主键索引和辅助索引是独立的。

也就是说:InnoDB的B+树主键索引的叶子节点就是数据文件,辅助索引的叶子节点是主键的值;而MyISAM的B+树主键索引和辅助索引的叶子节点都是数据文件的地址指针。

![]()

![]()

4. InnoDB不保存表的具体行数,执行select count(*) from table时需要全表扫描。而MyISAM用一个变量保存了整个表的行数,执行上述语句时只需要读出该变量即可,速度很快(注意不能加有任何WHERE条件);

那么为什么InnoDB没有了这个变量呢?

因为InnoDB的事务特性,在同一时刻表中的行数对于不同的事务而言是不一样的,因此count统计会计算对于当前事务而言可以统计到的行数,而不是将总行数储存起来方便快速查询。InnoDB会尝试遍历一个尽可能小的索引除非优化器提示使用别的索引。如果二级索引不存在,InnoDB还会尝试去遍历其他聚簇索引。

如果索引并没有完全处于InnoDB维护的缓冲区(Buffer Pool)中,count操作会比较费时。可以建立一个记录总行数的表并让你的程序在INSERT/DELETE时更新对应的数据。和上面提到的问题一样,如果此时存在多个事务的话这种方案也不太好用。如果得到大致的行数值已经足够满足需求可以尝试SHOW TABLE STATUS

-

Innodb不支持全文索引,而MyISAM支持全文索引,在涉及全文索引领域的查询效率上MyISAM速度更快高;PS:5.7以后的InnoDB支持全文索引了

-

MyISAM表格可以被压缩后进行查询操作

-

InnoDB支持表、行(默认)级锁,而MyISAM支持表级锁

InnoDB的行锁是实现在索引上的,而不是锁在物理行记录上。潜台词是,如果访问没有命中索引,也无法使用行锁,将要退化为表锁。

例如:

t_user(uid, uname, age, sex) innodb;

uid PK

无其他索引

update t_user set age=10 where uid=1; 命中索引,行锁。

update t_user set age=10 where uid != 1; 未命中索引,表锁。

update t_user set age=10 where name='chackca'; 无索引,表锁。

-

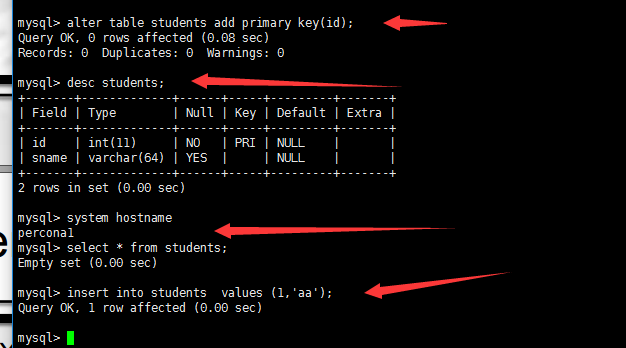

InnoDB表必须有唯一索引(如主键)(用户没有指定的话会自己找/生产一个隐藏列Row_id来充当默认主键),而Myisam可以没有

-

Innodb存储文件有frm、ibd,而Myisam是frm、MYD、MYI

Innodb:frm是表定义文件,ibd是数据文件

Myisam:frm是表定义文件,myd是数据文件,myi是索引文件

两者如何选择:

1、是否要支持事务,如果要请选择innodb,如果不需要可以考虑MyISAM;

2、如果表中绝大多数都只是读查询,可以考虑MyISAM,如果既有读也有写,请使用InnoDB。

3、系统奔溃后,MyISAM恢复起来更困难,能否接受;

4、 MySQL5.5版本开始Innodb已经成为Mysql的默认引擎(之前是MyISAM),说明其优势是有目共睹的,如果你不知道用什么,那就用InnoDB,至少不会差。

InnoDB为什么推荐使用自增ID作为主键?

答:自增ID可以保证每次插入时B+索引是从右边扩展的,可以避免B+树和频繁合并和分裂(对比使用UUID)。如果使用字符串主键和随机主键,会使得数据随机插入,效率比较差。

InnoDB的索引实现,InnoDB使用聚集索引,数据记录本身被存于主索引(一颗B+Tree)的叶子节点上。这就要求同一个叶子节点内(大小为一个内存页或磁盘页)的各条数据记录按主键顺序存放,因此每当有一条新的记录插入时,MySQL会根据其主键将其插入适当的节点和位置,如果页面达到装载因子(InnoDB默认为15/16),则开辟一个新的页(节点)。

如果表使用自增主键,那么每次插入新的记录,记录就会顺序添加到当前索引节点的后续位置,当一页写满,就会自动开辟一个新的页。如下图所示:

![]()

这样就会形成一个紧凑的索引结构,近似顺序填满。由于每次插入时也不需要移动已有数据,因此效率很高,也不会增加很多开销在维护索引上。

如果使用非自增主键(如果身份证号或学号等),由于每次插入主键的值近似于随机,因此每次新纪录都要被插到现有索引页得中间某个位置:

![]()

此时MySQL不得不为了将新记录插到合适位置而移动数据,甚至目标页面可能已经被回写到磁盘上而从缓存中清掉,此时又要从磁盘上读回来,这增加了很多开销,同时频繁的移动、分页操作造成了大量的碎片,得到了不够紧凑的索引结构,后续不得不通过OPTIMIZE TABLE来重建表并优化填充页面。

因此,只要可以,请尽量在InnoDB上采用自增字段做主键。

UUID:

UUID是Universally Unique Identifier的缩写,它是在一定的范围内(从特定的名字空间到全球)唯一的机器生成的标识符。

由于 UUID 是全局唯一的,重复 UUID 的概率接近零,可以忽略不计。所以 Java 的 UUID 通常可用于以下地方:

- 随机生成的文件名;

- Java Web 应用程序的 sessionID;

- 数据库表的主键;

- 事务 ID(UUID 生成算法非常高效,每台计算机每秒高达 1000 万次)。

M 表示 UUID 的版本,N 为 UUID 的变体(Variants)。

M 的值有 5 个可选项:

-

版本 1:UUID 是根据时间和 MAC 地址生成的;

-

版本 2:UUID 是根据标识符(通常是组或用户 ID)、时间和节点 ID生成的;

-

版本 3:UUID 是通过散列(MD5 作为散列算法)名字空间(namespace)标识符和名称生成的;

-

版本 4 - UUID 使用随机性或伪随机性生成;

-

版本 5 类似于版本 3(SHA1 作为散列算法)。

为了能兼容过去的 UUID,以及应对未来的变化,因此有了变体(Variants)这一概念。

目前已知的变体有下面 4 种:

-

变体 0:格式为 0xxx,为了向后兼容预留。

-

变体 1:格式为 10xx,当前正在使用的。

-

变体 2:格式为 11xx,为早期微软的 GUID 预留。

-

变体 3:格式为 111x,为将来的扩展预留,目前暂未使用。

在 Java 中,就有一个叫 UUID 的类,在java.util包下。

package java.util;

public final class UUID implements java.io.Serializable, Comparable<UUID> {

}

该类只有一个构造方法:

public UUID(long mostSigBits, long leastSigBits) {

this.mostSigBits = mostSigBits;

this.leastSigBits = leastSigBits;

}

要使用构造方法创建 UUID 对象的话,就需要传递两个参数,long 型的最高位 UUID 和最低位的 UUID。

long msb = System.currentTimeMillis();

long lsb = System.currentTimeMillis();

UUID uuidConstructor = new UUID(msb, lsb);

System.out.println("UUID : "+uuidConstructor);

输出结果如下所示:

UUID : 00000173-8efd-1b7c-0000-01738efd1b7c

UUID 类提供了一个静态方法 randomUUID() :

public static UUID randomUUID() {

SecureRandom ng = UUID.Holder.numberGenerator;

byte[] randomBytes = new byte[16];

ng.nextBytes(randomBytes);

randomBytes[6] &= 0x0f; /* clear version */

randomBytes[6] |= 0x40; /* set to version 4 */

randomBytes[8] &= 0x3f; /* clear variant */

randomBytes[8] |= 0x80; /* set to IETF variant */

return new UUID(randomBytes);

}

randomUUID() 方法生成了一个版本 4 的 UUID,这也是生成 UUID 最方便的方法。如果只使用原生 JDK 的话,基本上都用的这种方式。 示例如下:

UUID uuid4 = UUID.randomUUID();

int version4 = uuid4.version();

System.out.println("UUID:"+ uuid4+" 版本 " + version4);

程序输出结果如下所示:

UUID:8c943921-d83e-424a-a627-a12d3cb474db 版本 4

除此之外,UUID 类还提供了另外两个静态方法,其一是nameUUIDFromBytes():

public static UUID nameUUIDFromBytes(byte[] name) {

MessageDigest md;

try {

md = MessageDigest.getInstance("MD5");

} catch (NoSuchAlgorithmException nsae) {

throw new InternalError("MD5 not supported", nsae);

}

byte[] md5Bytes = md.digest(name);

md5Bytes[6] &= 0x0f; /* clear version */

md5Bytes[6] |= 0x30; /* set to version 3 */

md5Bytes[8] &= 0x3f; /* clear variant */

md5Bytes[8] |= 0x80; /* set to IETF variant */

return new UUID(md5Bytes);

}

nameUUIDFromBytes()会生成一个版本 3 的 UUID,不过需要传递一个名称的字节数组作为参数。

示例如下:

UUID uuid3 = UUID.nameUUIDFromBytes("test".getBytes());

int version3 = uuid3.version();

System.out.println("UUID:"+ uuid3+" 版本 " + version3);

程序输出结果如下所示:

UUID:098f6bcd-4621-3373-8ade-4e832627b4f6 版本 3

其二是 fromString() :

public static UUID fromString(String name) {

int len = name.length();

if (len > 36) {

throw new IllegalArgumentException("UUID string too large");

}

int dash1 = name.indexOf('-', 0);

int dash2 = name.indexOf('-', dash1 + 1);

int dash3 = name.indexOf('-', dash2 + 1);

int dash4 = name.indexOf('-', dash3 + 1);

int dash5 = name.indexOf('-', dash4 + 1);

// For any valid input, dash1 through dash4 will be positive and dash5

// negative, but it's enough to check dash4 and dash5:

// - if dash1 is -1, dash4 will be -1

// - if dash1 is positive but dash2 is -1, dash4 will be -1

// - if dash1 and dash2 is positive, dash3 will be -1, dash4 will be

// positive, but so will dash5

if (dash4 < 0 || dash5 >= 0) {

throw new IllegalArgumentException("Invalid UUID string: " + name);

}

long mostSigBits = Long.parseLong(name, 0, dash1, 16) & 0xffffffffL;

mostSigBits <<= 16;

mostSigBits |= Long.parseLong(name, dash1 + 1, dash2, 16) & 0xffffL;

mostSigBits <<= 16;

mostSigBits |= Long.parseLong(name, dash2 + 1, dash3, 16) & 0xffffL;

long leastSigBits = Long.parseLong(name, dash3 + 1, dash4, 16) & 0xffffL;

leastSigBits <<= 48;

leastSigBits |= Long.parseLong(name, dash4 + 1, len, 16) & 0xffffffffffffL;

return new UUID(mostSigBits, leastSigBits);

}

fromString() 方法会生成一个基于指定 UUID 字符串的 UUID 对象,如果指定的 UUID 字符串不符合 UUID 的格式,将抛出 IllegalArgumentException 异常。

示例如下:

UUID uuid = UUID.fromString("38400000-8cf0-11bd-b23e-10b96e4ef00d");

int version = uuid.version();

System.out.println("UUID:"+ uuid+" 版本 " + version);

程序输出结果如下所示:

UUID:38400000-8cf0-11bd-b23e-10b96e4ef00d 版本 1

除了使用 JDK 原生的 API 之外,还可以使用com.fasterxml.uuid.Generators,需要先在项目中加入该类的 Maven 依赖。

<dependency>

<groupId>com.fasterxml.uuid</groupId>

<artifactId>java-uuid-generator</artifactId>

<version>3.1.4</version>

</dependency>

然后我们来看一下如何使用它:

/**

* @author 沉默王二,一枚有趣的程序员

*/

public class UUIDVersionExample {

public static void main(String[] args) {

UUID uuid1 = Generators.timeBasedGenerator().generate();

System.out.println("UUID : "+uuid1);

System.out.println("UUID 版本 : "+uuid1.version());

UUID uuid2 = Generators.randomBasedGenerator().generate();

System.out.println("UUID : "+uuid2);

System.out.println("UUID 版本 : "+uuid2.version());

}

}

Generators.timeBasedGenerator().generate()可用于生成版本 1 的 UUID,Generators.randomBasedGenerator().generate()可用于生成版本 4 的 UUID。

来看一下输出结果:

UUID : ebee82f5-cfd2-11ea-82a7-8536e13d4951

UUID 版本 : 1

UUID : d2ccc752-c824-4bbc-8cc7-52c8246bbc6a

UUID 版本 : 4

UUID具有以下涵义:

- 经由一定的算法机器生成

为了保证UUID的唯一性,规范定义了包括网卡MAC地址、时间戳、名字空间(Namespace)、随机或伪随机数、时序等元素,以及从这些元素生成UUID的算法。UUID的复杂特性在保证了其唯一性的同时,意味着只能由计算机生成。

- 非人工指定,非人工识别

UUID是不能人工指定的,除非你冒着UUID重复的风险。UUID的复杂性决定了“一般人“不能直接从一个UUID知道哪个对象和它关联。

- 在特定的范围内重复的可能性极小

UUID的生成规范定义的算法主要目的就是要保证其唯一性。但这个唯一性是有限的,只在特定的范围内才能得到保证,这和UUID的类型有关(参见UUID的版本)。

UUID是16字节128位长的数字,通常以36字节的字符串表示,示例如下:

3F2504E0-4F89-11D3-9A0C-0305E82C3301

其中的字母是16进制表示,大小写无关。

Universally Unique IDentifier(UUID),有着正儿八经的[RFC规范](http://www.ietf.org/rfc/rfc4122.txt),是一个128bit的数字,也可以表现为32个16进制的字符,中间用”-”分割。

\- 时间戳+UUID版本号,分三段占16个字符(60bit+4bit),

\- Clock Sequence号与保留字段,占4个字符(13bit+3bit),

\- 节点标识占12个字符(48bit),

GUID(Globally Unique Identifier)是UUID的别名;但在实际应用中,GUID通常是指微软实现的UUID。

UUID Version 1:基于时间的UUID

因为时间戳有满满的60bit,所以可以尽情花,以100纳秒为1,从1582年10月15日算起(能撑3655年,真是位数多给烧的,1582年有意思么)

节点标识也有48bit,一般用MAC地址表达,如果有多块网卡就随便用一块。如果没网卡,就用随机数凑数,或者拿一堆尽量多的其他的信息,比如主机名什么的,拼在一起再hash一把。

顺序号这16bit则仅用于避免前面的节点标示改变(如网卡改了),时钟系统出问题(如重启后时钟快了慢了),让它随机一下避免重复。

但好像Version 1就没考虑过一台机器上起了两个进程这类的问题,也没考虑相同时间戳的并发问题,所以严格的Version1没人实现,接着往下看各个变种吧。

Version1变种 – Hibernate

Hibernate的CustomVersionOneStrategy.java,解决了之前version 1的两个问题

- 时间戳(6bytes, 48bit):毫秒级别的,从1970年算起,能撑8925年….

- 顺序号(2bytes, 16bit, 最大值65535): 没有时间戳过了一秒要归零的事,各搞各的,short溢出到了负数就归0。

- 机器标识(4bytes 32bit): 拿localHost的IP地址,IPV4呢正好4个byte,但如果是IPV6要16个bytes,就只拿前4个byte。

- 进程标识(4bytes 32bit): 用当前时间戳右移8位再取整数应付,不信两条线程会同时启动。

值得留意就是,机器进程和进程标识组成的64bit Long几乎不变,只变动另一个Long就够了。

Version1变种 – MongoDB

MongoDB的ObjectId.java- 时间戳(4 bytes 32bit): 是秒级别的,从1970年算起,能撑136年。

- 自增序列(3bytes 24bit, 最大值一千六百万): 是一个从随机数开始(机智)的Int不断加一,也没有时间戳过了一秒要归零的事,各搞各的。因为只有3bytes,所以一个4bytes的Int还要截一下后3bytes。

- 机器标识(3bytes 24bit): 将所有网卡的Mac地址拼在一起做个HashCode,同样一个int还要截一下后3bytes。搞不到网卡就用随机数混过去。

- 进程标识(2bytes 16bits):从JMX里搞回来到进程号,搞不到就用进程名的hash或者随机数混过去。

可见,MongoDB的每一个字段设计都比Hibernate的更合理一点,比如时间戳是秒级别的。总长度也降到了12 bytes 96bit,但如果果用64bit长的Long来保存有点不上不下的,只能表达成byte数组或16进制字符串。

另外对Java版的driver在自增序列那里好像有bug。

Twitter的snowflake派号器

snowflake也是一个派号器,基于Thrift的服务,不过不是用redis简单自增,而是类似UUID version1,

只有一个Long 64bit的长度,所以IdWorker紧巴巴的分配成:- 时间戳(42bit) 自从2012年以来(比那些从1970年算起的会过日子)的毫秒数,能撑139年。

- 自增序列(12bit,最大值4096), 毫秒之内的自增,过了一毫秒会重新置0。

- DataCenter ID (5 bit, 最大值32),配置值。

- Worker ID ( 5 bit, 最大值32),配置值,因为是派号器的id,所以一个数据中心里最多32个派号器就够了,还会在ZK里做下注册。

可见,因为是派号器,把机器标识和进程标识都省出来了,所以能够只用一个Long表达。

另外,这种派号器,client每次只能一个ID,不能批量取,所以额外增加的延时是问题。

UUID Version 2:DCE安全的UUID

DCE(Distributed Computing Environment)安全的UUID和基于时间的UUID算法相同,但会把时间戳的前4位置换为POSIX的UID或GID。这个版本的UUID在实际中较少用到。

UUID Version 3:基于名字的UUID(MD5)

基于名字的UUID通过计算名字和名字空间的MD5散列值得到。这个版本的UUID保证了:相同名字空间中不同名字生成的UUID的唯一性;不同名字空间中的UUID的唯一性;相同名字空间中相同名字的UUID重复生成是相同的。

UUID Version 4:随机UUID

根据随机数,或者伪随机数生成UUID。这种UUID产生重复的概率是可以计算出来的,但随机的东西就像是买彩票:你指望它发财是不可能的,但狗屎运通常会在不经意中到来。

UUID Version 5:基于名字的UUID(SHA1)

和版本3的UUID算法类似,只是散列值计算使用SHA1(Secure Hash Algorithm 1)算法。

UUID的应用

从UUID的不同版本可以看出,Version 1/2适合应用于分布式计算环境下,具有高度的唯一性;Version 3/5适合于一定范围内名字唯一,且需要或可能会重复生成UUID的环境下;至于Version 4,我个人的建议是最好不用(虽然它是最简单最方便的)。

通常我们建议使用UUID来标识对象或持久化数据,但以下情况最好不使用UUID:

- 映射类型的对象。比如只有代码及名称的代码表。

- 人工维护的非系统生成对象。比如系统中的部分基础数据。

对于具有名称不可重复的自然特性的对象,最好使用Version 3/5的UUID。比如系统中的用户。如果用户的UUID是Version 1的,如果你不小心删除了再重建用户,你会发现人还是那个人,用户已经不是那个用户了。(虽然标记为删除状态也是一种解决方案,但会带来实现上的复杂性。)

UUID生成器

我没想着有人看完了这篇文章就去自己实现一个UUID生成器,所以前面的内容并不涉及算法的细节。下面是一些可用的Java UUID生成器:

- Java UUID Generator (JUG):开源UUID生成器,LGPL协议,支持MAC地址。

- UUID:特殊的License,有源码。

- Java 5以上版本中自带的UUID生成器:好像只能生成Version 3/4的UUID。

此外,Hibernate中也有一个UUID生成器,但是,生成的不是任何一个(规范)版本的UUID,强烈不建议使用。

UUID生成方法:

Shell、libuuid、boost uuid、Qt QUuid、CoCreateGuid、

Shell:

- Unix/Linux环境中大都有一个名为uuidgen的小工具,运行即可生成一个UUID到标准输出

- 读取文件

/proc/sys/kernel/random/uuid即得UUID,例如:

cat /proc/sys/kernel/random/uuid

libuuid:

libuuid是一个用于生成UUID的C库,具体用法参考http://linux.die.net/man/3/libuuid,示例如下:

#include <stdio.h>

#include <uuid/uuid.h>

int main(int argc, char **argv)

{

uuid_t uuid;

char str[36];

uuid_generate(uuid);

uuid_unparse(uuid, str);

printf("%s\n", str);

return 0;

}

```sql

在Linux下编译时需要链接uuid库

```sql

gcc -o uuid uuid.c -luuid

在Ubuntu中,可以用下面的命令安装libuuid:

sudo apt-get install uuid-dev

boost uuid:

Boost库是一个可移植的开源C++库,它提供了UUID的实现。

下面的代码可以生成一个UUID

#include Qt QUuid:

Qt是一个跨平台的C++编程框架,QUuid类实现了UUID的生成、比较、转换等功能。

函数QUuid createUuid();可用于生成一个随即UUID。示例如下

#include

#include

#include

int main()

{

QUuid uuid = QUuid::createUuid();

std::cout << qPrintable(uuid.toString()) << std::endl;

return 0;

}

CoCreateGuid:

Windows下提供了函数CoCreateGuid用于生成GUID。需要使用的头文件是”objbase.h”,需要链接的库是ole32.lib,函数原型为:

HRESULT CoCreateGuid(GUID *pguid);

GUID的原型为 :

typedef struct _GUID

{

DWORD Data1;

WORD Data2;

WORD Data3;

BYTE Data4[8];

} GUID;

Java

JDK 1.5以上支持UUID,用法如下:

import java.util.UUID;

String uuid = UUID.randomUUID().toString();

innodb引擎的4大特性:

插入缓冲(insert buffer),

二次写(double write),

自适应哈希索引(ahi),

预读(read ahead)

插入缓冲:(insert buffer)

Insert Buffer

Insert Buffer 可能是 InnoDB 存储引擎关键特性中最令人激动与兴奋的一个功能。不过这个名字可能会让人认为插入缓冲是缓冲池中的一个组成部分。其实不然, InnoDB 缓冲池中有 Insert Buffer 信息固然不错,但是 Insert Buffer和数据页一样,也是物理页的一个组成部分。

在 InnoDB 存储引擎中,主键是行唯一的标识符。通常应用程序中行记录的插入顺序是按照主键递增的顺序进行插入的。因此,插入聚集索引( Primary Key )一般是顺序的,不需要磁盘的随机读取。比如按下列 SQL 定义表:

CREATE TABLE t (

a INT AUTO INCREMENT ,

b VARCHAR(30) ,

PRIMARY KEY ( a )

);

其中 a 列是自增长的,若对 a 列插入 NULL 值,则由于其具有 AUTO INCREMENT 属性,其值会自动增长。同时页中的行记录按 a 的值进行顺序存放。在一般情况下,不需要随机读取另一个页中的记录。因此,对于这类情况下的插入操作,速度是非常快的。注意并不是所有的主键插入都是顺序的。若主键类是 UUID 这样的类,那么插入和辅助索引一样,同样是随机的。即使主键是自增类型,但是插入的是指定的值,而不是 NULL 值,那么同样可能导致插入并非连续的情况。

但是不可能每张表上只有一个聚集索引,更多情况下,一张表上有多个非聚集的辅助索引( secondary index )。比如,用户需要按照 b 这个字段进行查找,并且 b 这个字段不是唯一的,即表是按如下的 SQL 语句定义的:

CREATE TABLE t (

a INT AUTO INCREMENT ,

b VARCHAR ( 30 ) ,

PRIMARY KEY ( a ) ,

key ( b )

);

在这样的情况下产生了一个非聚集的且不是唯一的索引。在进行插入操作时,数据页的存放还是按主键 a 进行顺序存放的,但是对于非聚集索引叶子节点的插入不再是顺序的了,这时就需要离散地访问非聚集索引页,由于随机读取的存在而导致了插入操作性能下降。当然这并不是这个 b 字段上索引的错误,而是因为 B+树的特性决定了非聚集索引插入的离散性。

需要注意的是,在某些情况下,辅助索引的插入依然是顺序的,或者说是比较顺序的,比如用户购买表中的时间字段。在通常情况下,用户购买时间是一个辅助索引,用来根据时间条件进行查询。但是在插入时却是根据时间的递增而插入的,因此插入也是“较为”顺序的。

InnoDB 存储引擎开创性地设计了 Insert Buffer ,对于非聚集索引的插入或更新操作,不是每一次直接插入到索引页中,而是先判断插入的非聚集索引页是否在缓冲池中,若在,则直接插入;若不在,则先放入到一个 Insert Buffer 对象中,好似欺骗。数据库这个非聚集的索引已经插到叶子节点,而实际并没有,只是存放在另一个位置。然后再以一定的频率和情况进行 Insert Buffer 和辅助索引页子节点的 merge(合并)操作,这时通常能将多个插入合并到一个操作中(因为在一个索引页中),这就大大提高了对于非聚集索引插入的性能。

然而 Insert Buffer 的使用需要同时满足以下两个条件:

- 索引是辅助索引( secondary index ) ;

- 索引不是唯一( unique )的。

当满足以上两个条件时, InnoDB 存储引擎会使用 Insert Buffer ,这样就能提高插入操作的性能了。不过考虑这样一种情况:应用程序进行大量的插入操作,这些都涉及了不唯一的非聚集索引,也就是使用了 Insert Buffer。若此时 MySQL数据库发生了宕机这时势必有大量的 Insert Buffer并没有合并到实际的非聚集索引中去。因此这时恢复可能需要很长的时间,在极端情况下甚至需要几个小时。

辅助索引不能是唯一的,因为在插入缓冲时,数据库并不去查找索引页来判断插入的记录的唯一性。如果去查找肯定又会有离散读取的情况发生,从而导致 Insert Buffer失去了意义。

用户可以通过命令 SHOW ENGINE INNODB STATUS来查看插入缓冲的信息:

seg size显示了当前 Insert Buffer的大小为11336×16KB,大约为177MB; free list len代表了空闲列表的长度;size代表了已经合并记录页的数量。而黑体部分的第2行可能是用户真正关心的,因为它显示了插入性能的提高。 Inserts代表了插入的记录数;merged recs代表了合并的插入记录数量; merges代表合并的次数,也就是实际读取页的次数。 merges: merged recs大约为1:3,代表了插入缓冲将对于非聚集索引页的离散IO逻辑请求大约降低了2/3。

正如前面所说的,目前 Insert Buffer存在一个问题是:在写密集的情况下,插入缓冲会占用过多的缓冲池内存( innodb buffer pool),默认最大可以占用到1/2的缓冲池内存。以下是 InnoDB存储引擎源代码中对于 insert buffer的初始化操作:

这对于其他的操作可能会带来一定的影响。 Percona上发布一些 patch来修正插入缓冲占用太多缓冲池内存的情况,具体可以到 Percona官网进行查找。简单来说,修改IBUF_POOL_SIZE_PER_MAX_SIZE就可以对插入缓冲的大小进行控制。比如将IBUF_POOL_SIZE_PER_MAX_SIZE改为3,则最大只能使用1/3的缓冲池内存。

Insert Buffer的内部实现

通过前一个小节读者应该已经知道了 Insert Buffer的使用场景,即非唯一辅助索引的插入操作。但是对于 Insert Buffer具体是什么,以及内部怎么实现可能依然模糊,这正是本节所要阐述的内容。

可能令绝大部分用户感到吃惊的是, Insert Buffer的数据结构是一棵B+树。在MySQL4.1之前的版本中每张表有一棵 Insert Buffer B+树。而在现在的版本中,全局只有一棵 Insert Buffer B+树,负责对所有的表的辅助索引进行 Insert Buffer。而这棵B+树存放在共享表空间中,默认也就是 ibdata1中。因此,试图通过独立表空间ibd文件恢复表中数据时,往往会导致 CHECK TABLE失败。这是因为表的辅助索引中的数据可能还在 Insert Buffer中,也就是共享表空间中,所以通过ibd文件进行恢复后,还需要进行REPAIR TABLE操作来重建表上所有的辅助索引。

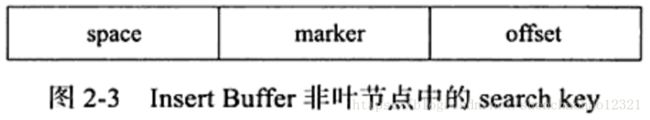

Insert Buffer是一棵B+树,因此其也由叶节点和非叶节点组成。非叶节点存放的是查询的 search key(键值),其构造如图所示:

search key一共占用9个字节,其中 space表示待插入记录所在表的表空间id,在InnodB存储引擎中,每个表有一个唯一的 space id,可以通过 space id查询得知是哪张表。 space占用4字节。 marker占用1字节,它是用来兼容老版本的 Insert Buffer, offset表示页所在的偏移量,占用4字节。

当一个辅助索引要插入到页(space,offset)时,如果这个页不在缓冲池中,那么InnoDB存储引擎首先根据上述规则构造一个 search key,接下来查询 Insert Buffer这棵B+树,然后再将这条记录插入到 Insert Buffer b+树的叶子节点中。

对于插入到 Insert Buffer B+树叶子节点的记录,并不是直接将待插入的记录插入,而是需要根据如下的规则进行构造:

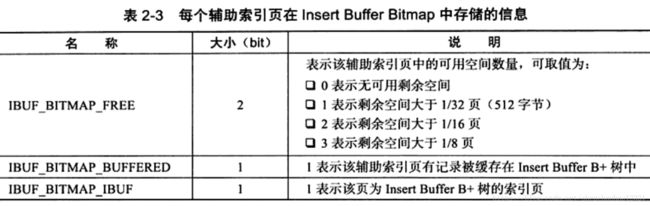

space、 marker、 page no字段和之前非叶节点中的含义相同,一共占用9字节。第4个字段 metadata占用4字节,其存储的内容如下表所示:

IBUF_REC_OFFSET_COUNT是保存两个字节的整数,用来排序每个记录进入Insert Buffer的顺序。因为从 InnodB1.0.x开始支持 Change Buffer,所以这个值同样记录进人 Insert Buffer的顺序。通过这个顺序回放( replay)才能得到记录的正确值。

从 Insert Buffer叶子节点的第5列开始,就是实际插入记录的各个字段了。因此较之原插入记录, Insert Buffer B+树的叶子节点记录需要额外13字节的开销。

因为启用 Insert Buffer索引后,辅助索引页( space, page no)中的记录可能被插入到 Insert Buffer b+树中,所以为了保证每次 Merge Insert Buffer页必须成功,还需要有一个特殊的页用来标记每个辅助索引页(space, page_no)的可用空间。这个页的类型为 Insert Buffer Bitmap每个 Insert Buffer Bitmap页用来追踪16384个辅助索引页,也就是256个区(Extent)。每个 Insert Buffer Bitmap页都在16384个页的第二个页中。

每个辅助索引页在 Insert Buffer Bitmap页中占用4位(bit),由下表中的三个部分组成:

Change Buffer

InnoDB从1.0.x版本开始引入了 Change Buffer,可将其视为 Insert Buffer的升级从这个版本开始, InnodB存储引擎可以对DML操作— INSERT、 DELETE、 UPDATE都进行缓冲,他们分别是: Insert Buffer、 Delete Buffer、 Purge buffer当然和之前 Insert Buffer一样, Change Buffer适用的对象依然是非唯一的辅助索引。

对一条记录进行 UPDATE操作可能分为两个过程:

- 将记录标记为已删除;

- 真正将记录删除

InnoDB从1.0.x版本开始引入了 Change Buffer,可将其视为 Insert Buffer的升级从这个版本开始, InnodB存储引擎可以对DML操作— INSERT、 DELETE、 UPDATE都进行缓冲,他们分别是: Insert Buffer、 Delete Buffer、 Purge buffer当然和之前 Insert Buffer一样, Change Buffer适用的对象依然是非唯一的辅助索引。

从 InnoDB1.2.x版本开始,可以通过参数 innodb_change_buffer_max_size来控制Change Buffer最大使用内存的数量:

mysql> show variables like 'innodb_change_buffer_max_size';

+-------------------------------+-------+

| Variable_name | Value |

+-------------------------------+-------+

| innodb_change_buffer_max_size | 25 |

+-------------------------------+-------+

1 row in set (0.05 sec)

innodb_change_buffer_max_size值默认为25,表示最多使用1/4的缓冲池内存空间。

而需要注意的是,该参数的最大有效值为50在 MySQL5.5版本中通过命令 SHOW ENGINE INNODB STATUS,可以观察到类似如下的内容:

Merge Insert Buffer

通过前面的小节读者应该已经知道了 Insert/Change Buffer是一棵B+树。若需要实现插入记录的辅助索引页不在缓冲池中,那么需要将辅助索引记录首先插入到这棵B+树中。但是 Insert Buffer中的记录何时合并( merge)到真正的辅助索引中呢?这是本小节需要关注的重点。

概括地说, Merge Insert Buffer的操作可能发生在以下几种情况下:

- 辅助索引页被读取到缓冲池时;

- Insert Buffer Bitmap页追踪到该辅助索引页已无可用空间时;

- Master Thread。

第一种情况为当辅助索引页被读取到缓冲池中时,例如这在执行正常的 SELECT査询操作,这时需要检查 Insert Buffer Bitmap页,然后确认该辅助索引页是否有记录存放于 Insert Buffer b+树中。若有,则将 Insert Buffer B+树中该页的记录插入到该辅助索引页中。可以看到对该页多次的记录操作通过一次操作合并到了原有的辅助索引页中,因此性能会有大幅提高。

Insert Buffer Bitmap页用来追踪每个辅助索引页的可用空间,并至少有1/32页的空间。若插入辅助索引记录时检测到插入记录后可用空间会小于1/32页,则会强制进行一个合并操作,即强制读取辅助索引页,将 Insert Buffer B+树中该页的记录及待插入的记录插入到辅助索引页中。这就是上述所说的第二种情况。

还有一种情况,之前在分析 Master Thread时曾讲到,在 Master Thread线程中每秒或每10秒会进行一次 Merge Insert Buffer的操作,不同之处在于每次进行 merge操作的页的数量不同。

在 Master Thread中,执行 merge操作的不止是一个页,而是根据 srv_innodb_io_capactiy的百分比来决定真正要合并多少个辅助索引页。但 InnoDB存储引擎又是根据怎样的算法来得知需要合并的辅助索引页呢?

在 Insert Buffer B+树中,辅助索引页根据(space, offset)都已排序好,故可以根据(space, offset)的排序顺序进行页的选择。然而,对于 Insert Buffer页的选择,InnoDB存储引擎并非采用这个方式,它随机地选择 Insert Buffer B+树的一个页,读取该页中的 space及之后所需要数量的页。该算法在复杂情况下应有更好的公平性。同时,若进行 merge时,要进行 merge的表已经被删除,此时可以直接丢弃已经被 Insert/Change Buffer的数据记录。

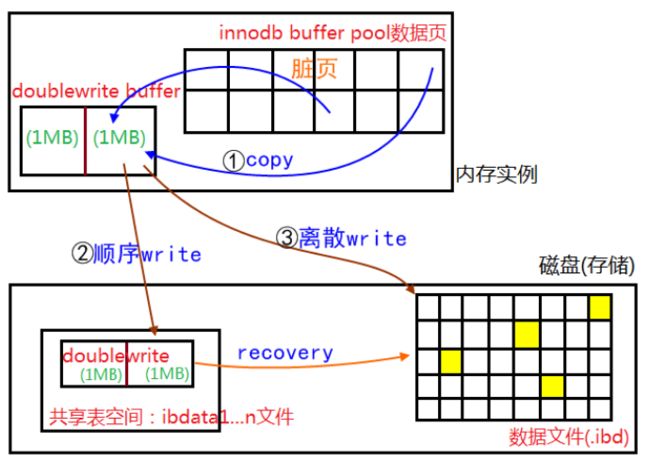

二次写:(double write)

二次写的目的:缓冲池的数据不是直接写入硬盘,而是先写入表空间中的一个地方,之后在写入硬盘,是为了防止出现坏页。

两次写包括两种方法,一种是对单独一个页面刷盘时的两次写,另一种是批量刷盘时的两次写。单一页面刷盘实际上是MySQL5.5版本的实现方式。

什么是两次写:

两次写提出的背景或要解决的问题

两次写(InnoDB Double Write)是Innodb中很独特的一个功能点。因为Innodb中的日志是逻辑的,所谓逻辑就是比如插入一条记录时,它可能会在某一个页面(这条记录最终被插入的位置)的多个偏移位置写入某个长度的值,例如页头的记录数、槽数、页尾槽数据、页中的记录值等。这些本是一些物理操作,而Innodb为了节省日志量及其它原因,设计为逻辑处理的方式,即在一个页面上插入一条记录时,对应的日志内容包括表空间号、页面号、将被记录的各个列的值等内容,在真正物理插入的时候,才会将日志逻辑操作转换为前面的物理操作。

先有逻辑日志,再有物理操作,但是这样需要有一个前提,就是物理操作的页面是正确的。如果那个数据页面本身是错误的,这种错误可能是上次的操作导致的写断裂(1个页面为16KB,分多次写入,后面的可能没有写成功,导致这个页面不完整)或者其它原因,那么这个逻辑操作就没办法完成了。因为如果这个页面不正确的话,里面的数据是无效的,就可能会产生各种不可预料的问题。

因此首先要保证这个页面是正确的,方法就是两次写。

两次写是什么

为了解决partial page write问题,InnoDB实现了double write buffer,简单来说,就是在写数据页之前,先把这个数据页写到一块独立的物理文件位置(ibdata),然后再写到数据页。这样在宕机重启时,如果出现数据页损坏,那么在应用redo log之前,需要通过该页的副本来还原该页,然后再进行redo log重做,这就是double write。

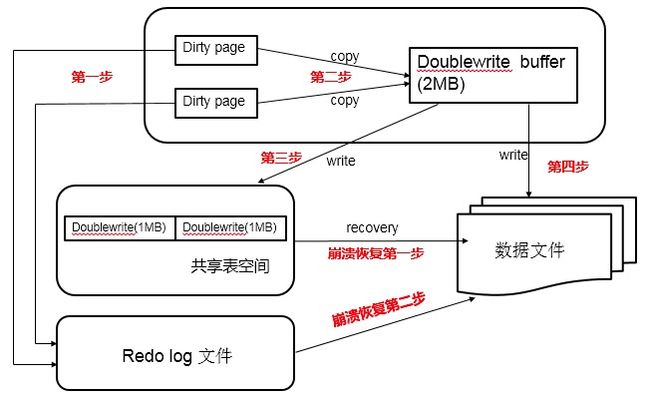

doublewrite由两部分组成,一部分为内存中的doublewrite buffer,其大小为2MB,另一部分是磁盘上共享表空间(ibdata x)中连续的128个页,即2个区(extent),大小也是2M。

1、当一系列机制触发数据缓冲池中的脏页刷新时,并不直接写入磁盘数据文件中,而是先拷贝至内存中的doublewrite buffer中;

2、接着从两次写缓冲区分两次写入磁盘共享表空间中(连续存储,顺序写,性能很高),每次写1MB;

3、待第二步完成后,再将doublewrite buffer中的脏页数据写入实际的各个表空间文件(离散写);(脏页数据固化后,即进行标记对应doublewrite数据可覆盖)

其工作流程如下:

再看redo log 写入关系,可以用下图演示

结构设计及原理

MySQL在系统页面上记录关于两次写的信息如要如下:

| 参数变量 | 信息描述 | 说明 |

|---|---|---|

| TRX_SYS_DOUBLEWRITE_FSEG | 两次写页面所在段的地址信息。 | 存储两次写页面所在段的地址信息,每次使用两次写机制写数据时,都会从这个位置读取到段的位置,找到段的首地址。 |

| TRX_SYS_DOUBLEWRITE_MAGIC | 用来判断是不是已经初始化过两次写页面。 | 存储的是用来验证当前两次写是不是正常或是不是已经申请的标志。 |

| TRX_SYS_DOUBLEWRITE_BLOCK1 | 两次写页面第一个簇的首地址,两次写页面总共两个簇,一个簇为64个页面。 | 存储的是两次写空间的位置,他们在ibdata文件中属于同一个段,在初始化数据库时会确定具体问题,是用来真正存储两次写页面数据的空间,它们对应的空间大小都是一个簇,占用磁盘空间分别为1M。(一个簇为64*16KB=1M;2个簇,就是2M) |

| TRX_SYS_DOUBLEWRITE_BLOCK2 | 第二个簇的首地址。 | 存储的是两次写空间的位置,他们在ibdata文件中属于同一个段,在初始化数据库时会确定具体问题,是用来真正存储两次写页面数据的空间,它们对应的空间大小都是一个簇,占用磁盘空间分别为1M。(一个簇为64*16KB=1M;2个簇,就是2M) |

| RX_SYS_DOUBLEWRITE_REPEAT | 将上面的MAGIC、BLOCK1、BLOCK2重复存储,防止页面自己的不完整。 |

刷盘的过程:

每次刷盘前,都会将要刷盘的页面信息临时保存到内存的数组中,这个空间大小也是128个页面,这个缓存称为两次写缓存数组。有了这些信息,单个页面刷盘的两次写就可以正常运转了。

step 1 先在两次写缓存数组中,找到一个空闲位置,并将这个位置标记为已使用,然后,再把要刷新的页面数据复制到标记的缓存空间中。

step 2 将页面的数据刷到两次写文件中,即ibdata文件中。此时页面是持久化。

复制的数据量是一个页面的大小,偏移位置是这个页面在两次写缓存空间中的位置,对应着TRX_SYS_DOUBLEWRITE_BLOCK1或TRX_SYS_DOUBLEWRITE_BLOCK2的位置。因为内存中的两次写缓存数组是128个元素,而对应的TRX_SYS_DOUBLEWRITE_BLOCK1及TRX_SYS_DOUBLEWRITE_BLOCK2也是128个页面,它们是一一对应的,所以具体刷到什么位置,可以计算出来。

step 3 页面刷盘,即数据刷到真实的位置,也许刷到的是ibdata文件,也许是某一个表的ibd文件中的某一个位置。

需要注意的是,因为Buffer Pool中的页面,刷到真实文件时是异步IO的,那么只有当刷到自己表空间的刷盘操作完成后,两次写缓存数组的数据才可以被覆盖,或者说,这个页面对应的两次写文件中的页面才可以被覆盖,不然有可能造成这个两次写位置的页面被新的页面覆盖的问题。如果此时上次的真实表空间的刷盘没有完成,同时产生了页面断裂的问题,这样就出现了该页面不可恢复的问题,两次写的意义也就没有了。

批量页面刷盘

很明显,单一刷盘情况下开启了两次写,IO次数的增加会导致性能差很多,在新版本MySQL 5.7中,新增加入了针对Buffer Pool 批量刷盘的两次写实现方式。

实现原理

MySQL 5.7的实现方式新增了一个文件,文件路径及名称可以通过参数innodb_parallel_doublewrite_path来控制。启动数据库时,如果两次写文件不存在,那么这个参数可以指定绝对路径的两次写文件,也可以只指定文件名使文件被默认创建到datadir目录下。

批量刷盘包括两种方式,分别是LRU(Least Recently Used,最近最少使用)方式和LIST方式。当Buffer Pool空间不足时,再载入新的页面就必须要将一些不怎么用到的、旧的页面淘汰出去,此时系统就会从LRU链表中找到最老的页面,进行批量刷盘,将释放的空间加入到空闲空间中去,这种情况就是LRU刷盘。当日志空间不足,或者是后台MASTER线程在定时刷盘时,不需要区分页面的新旧状态,只需要选择LSN最小的那些页面,从前到后刷一批页面到文件中,此时所用的策略就是LIST方式。

在批量刷盘的两次写中,这两种刷盘方法对应的两次写空间互不干涉。

InnoDB自身的整个Buffer Pool分为多个Instance,每个Instance管理自身的一套两次写空间,而针对每一个Instance的每一个刷盘方法的批量缓存空间大小,是通过参数innodb_doublewrite_batch_size来控制的,默认值为120(为什么是120?在单一页面刷盘时不是128吗? 答案参照说明部分的6.1)。这样算下来,innodb_parallel_doublewrite_path所指的文件大小的计算方法如下:

两次写文件页面个数=innodb_buffer_pool_instances*2(LIST+LRU)*innodb_doublewrite_batch_size.

从图中可以看出落到最终的每一个shard,其实就是一个batch,对应的参数就是innodb_doublewrite_batch_size。一个shard,有一个数组,长度为innodb_doublewrite_batch_size,与单一页面刷盘的两次写是一样的,只是这个数组只属于一个shard而已。

批量刷盘的过程

假设由于页面淘汰,系统要做一次批量刷盘,这次就是LRU方式的,那么此时系统就需要将当前页面加入到两次写缓存中,首先根据当前页面所在的Instance号及刷盘类型就可以找到对应的shard缓存,找到缓存后,判断当前shard是否已经满了,即是否已经达到innodb_doublewrite_batch_size的大小,如果没有达到,则将当前页面内容追加复制到当前的shard缓存中,这样当前页面的刷盘操作就完成了。这里并不像单一页面那样,先写入缓存空间中,然后写入ibdata文件的两次写空间,最后还需要立即将页面的真实内容刷入表空间,对于批量刷盘来说,只需要写入到shard缓存即可。

如果当前shard中缓存的页面个数已经达到了innodb_doublewrite_batch_size,则说明当前缓存空间已经满了,此时不得不将当前shard缓存的页面写入两次写文件中,写完之后再将两次写文件FLUSH到磁盘,最后将对应的真实页面刷盘,此时可能是随机写入了,因为对应的两次写缓存中虽然是连续的,但对应的真实页面就不会这样了。这里需要注意的一点就是,表空间页面的刷盘,是异步IO操作,此时需要等待异步IO完成,且整个shard中的页面都刷盘后,刷盘操作才可以继续向后执行,而这个shard也可以再次重新使用了,缓存中的数据也都会被清空。

需要注意的是,上面过程中写入是连续innodb_doublewrite_batch_size 个页面,所以性能会比写入多次而每次写入一个页面的情况好很多。批量刷盘的情况下,有可能每隔innodb_doublewrite_batch_size个页面的刷盘操作,就会出现一次等待操作,且等待时间长短不一定,但这也是在单一页面刷盘的基础上优化过的,做了改进。

两次写的作用:

在数据库启动时(异常关闭的情况下),都会做数据库恢复(redo)操作。在恢复的过程中,数据库会检查页面是否合法(校验),如果发现一个页面的校验结果不一致,则此时就会用到两次写机制,用两次写空间中的数据来恢复异常页面的数据,这也正是为处理这样的错误而设计的。此时的处理机制就是,将两次写的两个簇都读出来,再将innodb_parallel_doublewrite_path文件的内容读出来,然后将所有这些页面写回到对应的页面中去,这样就可以保证这些页面是正确的,并且是在写入前已经更新过的(最新数据)。在写回对应页面中去之后,就可以在此基础上继续做数据库恢复了,且不会遇到这样的问题了,因为最后有可能产生写断裂的数据页面都恢复了。

上面所讲的都是数据页面有问题的情况下可以通过两次写页面来恢复,但是如果两次写页面本身发生写断裂怎么办呢? 对于这个问题,大家不必担心。因为如果两次写有问题,则数据页面本身就不会做写操作(一定是先逻辑后物理嘛,逻辑挂了,就没有后面的物理了。),此时系统挂了,发生错误的是两次写页面,而数据页面在挂之前都是在Buffer里面,文件中依然是当前事务操作前的值,并没有变化,还是一致状态,这意味着两次写页面根本就不会被使用到。

说明

批量刷盘中批量缓存空间大小由参数innodb_doublewrite_batch_size来控制的,默认值为120,而单一页面刷盘时是128。

一个double write buffer 有2MB, 共128个page,在MySQL 5.6中, 默认有120个page用于批量刷新(如 LRU Flush 或者 LIST FLUSH),剩下的8个Page用于单个page的flush。120是可以通过参数innodb_doublewrite_batch_size来配置。

doublewrite的崩溃恢复 与 Redo log 恢复

如果操作系统在将页写入磁盘的过程中发生崩溃,在恢复过程中,innodb存储引擎可以从共享表空间的doublewrite中找到该页的一个最近的副本,将其复制到表空间文件,再应用redo log,就完成了恢复过程。因为有副本所以也不担心表空间中数据页是否损坏。

Partial page write问题

介绍double write之前我们有必要了解partial page write(部分页失效)问题。

InnoDB的Page Size一般是16KB,其数据校验也是针对这16KB来计算的,将数据写入到磁盘是以Page为单位进行操作的。我们知道,由于文件系统对一次大数据页(例如InnoDB的16KB)大多数情况下不是原子操作,这意味着如果服务器宕机了,可能只做了部分写入。16K的数据,写入4K时,发生了系统断电/os crash ,只有一部分写是成功的,这种情况下就是partial page write问题。

有经验的DBA可能会想到,如果发生写失效,MySQL可以根据redo log进行恢复。这是一个办法,但是必须清楚地认识到,redo log中记录的是对页的物理修改,如偏移量800,写’aaaa’记录。如果这个页本身已经发生了损坏,再对其进行重做是没有意义的。MySQL在恢复的过程中检查page的checksum,checksum就是检查page的最后事务号,发生partial page write问题时,page已经损坏,找不到该page中的事务号。在InnoDB看来,这样的数据页是无法通过checksum验证的,就无法恢复。即时我们强制让其通过验证,也无法从崩溃中恢复,因为当前InnoDB存在的一些日志类型,有些是逻辑操作,并不能做到幂等。

为了解决这个问题,InnoDB实现了double write buffer,简单来说,就是在写数据页之前,先把这个数据页写到一块独立的物理文件位置(ibdata),然后再写到数据页。这样在宕机重启时,如果出现数据页损坏,那么在应用redo log之前,需要通过该页的副本来还原该页,然后再进行redo log重做,这就是double write。double write技术带给innodb存储引擎的是数据页的可靠性,下面对doublewrite技术进行解析,让大家充分理解double write是如何做到保障数据页的可靠性。

double write体系结构及工作流程

double write由两部分组成,一部分是InnoDB内存中的double write buffer,大小为2M,另一部分是物理磁盘上ibdata系统表空间中大小为2MB,共128个连续的Page,既2个分区。其中120个用于批量写脏,另外8个用于Single Page Flush。做区分的原因是批量刷脏是后台线程做的,不影响前台线程。而Single page flush是用户线程发起的,需要尽快的刷脏并替换出一个空闲页出来。

对于批量刷脏,每次找到一个可做flush的page,对其持有S lock,然后将该page拷贝到dblwr中,当dblwr满后者一次批量刷脏结束时,将dblwr中的page全部刷到ibdata中,注意这是同步写操作;然后再唤醒后台IO线程去写数据页。当后台IO线程完成写操作后,会去更新dblwr中的计数以腾出空间,释放block上的S锁,完成写入。

对于Single Page Flush,则做的是同步写操作,在挑出一个可以刷脏的page后,先加入到dblwr中,刷到ibdata,然后写到用户表空间,完成后,会对该用户表空间做一次fsync操作。

Single Page Flush在buffer pool中free page不够时触发,通常由前台线程发起,由于每次single page flush都会导致一次fsync操作,在大并发负载下,如果大量线程去做flush,很显然会产生严重的性能下降。Percona在5.6版本中做了优化,可以选择由后台线程lru manager来做预刷,避免用户线程陷入其中。

如果发生了极端情况(断电),InnoDB再次启动后,发现了一个Page数据已经损坏,那么此时就可以从double write buffer中进行数据恢复了。

double write工作流程如下 :

当一系列机制(main函数触发、checkpoint等)触发数据缓冲池中的脏页进行刷新到data file的时候,并不直接写磁盘,而是会通过memcpy函数将脏页先复制到内存中的double write buffer,之后通过double write buffer再分两次、每次1MB顺序写入共享表空间的物理磁盘上。然后马上调用fsync函数,同步脏页进磁盘上。由于在这个过程中,double write页的存储时连续的,因此写入磁盘为顺序写,性能很高;完成double write后,再将脏页写入实际的各个表空间文件,这时写入就是离散的了。各模块协作情况如下图(第一步应为脏页产生的redo记录log buffer,然后log buffer写入redo log file,为简化次要步骤直接连线表示):

mysql > show status like "%InnoDB_dblwr%" ;

+ -- -- -- -- -- -- -- -- -- -- -- -- -- -- + -- -- -- -- -- -- +

| Variable_name | Value |

+ -- -- -- -- -- -- -- -- -- -- -- -- -- -- + -- -- -- -- -- -- +

| Innodb_dblwr_pages_written | 61932183 |

| Innodb_dblwr_writes | 15237891 |

+ -- -- -- -- -- -- -- -- -- -- -- -- -- -- + -- -- -- -- -- -- +

2 rows in set ( 0.01 sec )

以上数据显示,double write一共写了 61932183个页,一共写了15237891次,从这组数据我们可以分析,之前讲过在开启double write后,每次脏页刷新必须要先写double write,而double write存在于磁盘上的是两个连续的区,每个区由连续的页组成,一般情况下一个区最多有64个页,所以一次IO写入应该可以最多写64个页。而根据以上我这个系统Innodb_dblwr_pages_written与Innodb_dblwr_writes的比例来看,一次大概在4个页左右,远远还没到64,所以从这个角度也可以看出,系统写入压力并不高。

如果操作系统在将页写入磁盘的过程中发送了崩溃,在恢复过程中,InnoDB存储引擎可以从工序表空间中的double write中找到该页的副本,将其复制到表空间文件,再应用redo log。下面显示了一个由double write进行恢复的过程:

090924 11 : 36 : 32 mysqld restarted

090924 11 : 26 : 33 InnoDB : Database was not shut down normally !

InnoDB : Starting crash recovery .

InnoDB : Reading tablespace information from the .ibd files . . .

InnoDB : Crash recovery may have faild for some .ibd files !

InnoDB : Restoring possible half - written data pages from the doublewrite .

InnoDB : buffer . . .

double write的缺点

dblwr位于共享表空间上的double write buffer实际上也是一个文件,引入了一次额外写的开销,每个数据页都被要求写两次。由于需要大量的fsync操作,所以它会降低MySQL的整体性能,但是并不会降低到原来的50%。这主要是因为:

- double write是一个连接的存储空间,所以硬盘在写数据的时候是顺序写,而不是随机写,这样性能更高。

- 将数据从double write buffer写到真正的segment中的时候,系统会自动合并连接空间刷新的方式,每次可以刷新多个pages。

double write默认开启,参数skip_innodb_doublewrite虽然可以禁止使用double write功能,但还是强烈建议大家使用double write。避免部分写失效问题,当然,如果你的数据表空间放在本身就提供了部分写失效防范机制的文件系统上,如ZFS/FusionIO/DirectFS文件系统,在这种情况下,就可以不开启doublewrite了。

double write在恢复的时候是如何工作的

如果是写double write buffer本身失败,那么这些数据不会被写到磁盘,InnoDB此时会从磁盘载入原始的数据,然后通过InnoDB的事务日志来计算出正确的数据,重新写入到double write buffer。

如果double write buffer写成功的话,但是写磁盘失败,InnoDB就不用通过事务日志来计算了,而是直接用buffer的数据再写一遍。如上图中显示,在恢复的时候,InnoDB直接比较页面的checksum,如果不对的话,Innodb存储引擎可以从共享表空间的double write中找到该页的一个最近的副本,将其复制到表空间文件,再应用redo log,就完成了恢复过程。因为有副本所以也不担心表空间中数据页是否损坏,但InnoDB的恢复通常需要较长的时间。

MariaDB/MySQL/Facebook/Percona 5.7的改进

MariaDB/MySQL改进:

MariaDB使用参数innodb_use_atomic_writes来控制原子写行为,当打开该选项时,会使用O_DIRECT模式打表空间,通过posix_fallocate来扩展文件(而不是写0扩展),当在启动时检查到支持atomic write时,即使开启了innodb_doublewrite,也会关闭掉。

Oracle MySQL同样支持FusionIO的Atomic Write特性(Fusion-io Non-Volatile Memory (NVM) file system),对于支持原子写的文件系统,也会自动关闭double write buffer。

Facebook改进:

实际上这不能算是改进,只是提供了一个新的选项。在现实场景中,宕机是非常低概率的事件。大部分情况下dblwr都是用不上的。但如果我们直接关闭dblwr,如果真的发生例如掉电宕机了,我们需要知道哪些page可能损坏了。

因此Facebook MySQL提供了一个选项,可以写page之前,只将对应的page number写到dblwr中(而不是写全page),在崩溃恢复时,先读出记录在dblwr中的page号,检查对应的数据页是否损坏,如果损坏了,那就需要从备库重新恢复该实例。

Percona 5.7改进:

Percona Server的每个版本都对InnoDB的刷脏逻辑做了不少的优化,进入5.7版本也不例外。在官方5.7中已经实现了多个Page Cleaner,我们可以把Page Cleaner配置成和buffer pool instance的个数相同,可以更好的实现并行刷脏。

但是官方版本中,Page cleaner既要负责刷FLUSH LIST,同时也要做LRU FLUSH(但每个bp instance不超过innodb_lru_scan_depth)。而这两部分任务是可以独立进行的。

因此Percona Server增加了多个LRU FLUSH线程,可以更高效的进行lru flush,避免用户线程陷入single page flush状态。每个buffer pool instance拥有自己的lru flush线程和page cleaner线程。lru flush基于当前free list的长度进行自适应计算。 每个lru线程负责自己的那个Buffer pool。因此不同lru flush线程的繁忙程度可能是不一样的。

在解决上述问题后,bp flush的并行效率大大的提升了。但是对于所有的刷脏操作,都需要走到double write buffer。这意味着dblwr成为了新的瓶颈。为了解决这个问题,dblwr进行了拆分,每个bp instance都有自己的dblwr区域。这样各个Lru flush线程及Page cleaner线程在做page flush时就不会相互间产生锁冲突,从而提升了系统的扩展性。

你可以通过参数来配置一个独立于ibdata之外的文件来存储dblwr,文件被划分成多个区域,分区数为bp instance的个数,每个分区的大小为2 * srv_doublewrite_batch_size,每个batch size默认配置为120个page,其中一个用于刷FLUSH LIST,一个用于刷LRU。

如果fast shutdown设置为2,dblwr文件在正常shutdown时会被删除掉,并在重启后重建。

自适应哈希索引:(ahi)

InnoDB存储引擎会监控对表上各索引页的查询,如果监控到某个索引页被频繁查询,并诊断后发现如果为这一页的数据创建Hash索引会带来更大的性能提升,则会自动为这一页的数据创建Hash索引,并称之为自适应Hash索引。自适应Hash是通过缓冲池中B+树的页进行构建的,建立速度很快,不需要对整张表的数据都构建Hash索引,所以我们又可以把自适应Hash索引看成是索引的索引,。注意一点就是InnoDB只会对热点页构建自适应索引,且是由InnoDB自动创建和删除的,所以不能人为干预是否在一张InnoDB的表中创建Hash索引。

根据InnoDB的官方文档显示,启用自适应哈希索引后,读取和写入速度可以提高2倍;对于辅助索引的连接操作,性能可以提高5倍。在我看来,自适应哈希索引是非常好的优化模式,其设计思想是数据库自优化(self-tuning),即无需DBA对数据库进行调整。

| 名称 | 自适应哈希索引 |

|---|---|

| 适合使用场景 | 适合使用 = 和 IN 操作符的等值查询 |

| 不合适场景 | 不适合使用 like 和 % 的范围查询和高并发的joins |

| 优点 | 提高了Innodb的内存使用率和一些情况下二级索引的查询效率 |

| 缺点 | 占用Innodb的内存缓存,使用了 lacth 锁保护内存中的hash结构 |

开启和关闭

默认情况下自适应索引是开启状态,毕竟是可以提升性能的嘛,我们也可以通过命令开启和关闭,并可以查看自适应索引的

开启

默认就是开启的,可以通过命令show variables like ‘innodb_adaptive_hash_index’;查看自适应哈希索引的状态,并可以在命令行通过show engine innodb status\G查看自适应Hash索引的使用信息(AHI的大小,使用情况,每秒使用AHI搜索的情况等等)

关闭

负载较重的情况下,就不太适合开启自适应Hash索引了,因为这样可以避免额外的索引维护带来的开销,可以在启动的时候通过参数

–skip-innodb-adaptive-hash-index关闭

自适应哈希索引的解释

mysql 术语列表中对自适应哈希索引的解释

AHI 自适应哈希索引

AHI有一个要求,对这个页的连续访问模式必须是一样的。例如对于(a,b)这样的联合索引页,其访问模式可以是下面情况:

1)where a=xxx

2)where a =xxx and b=xxx

访问模式一样是指查询的条件是一样的,若交替进行上述两种查询,那么InnoDB存储引擎不会对该页构造AHI。

AHI还有下面几个要求:

1)以该模式访问了100次

2)页通过该模式访问了N次,其中N=页中记录*1/16

InnoDB存储引擎官方文档显示,启用AHI后,读取和写入速度可以提高2倍,辅助索引的连接操作性能可以提高5倍。AHI的设计思想是数据库自优化,不需要DBA对数据库进行手动调整。

mysql> show engine innodb status\G

下面是部分输出:

-------------------------------------

INSERT BUFFER AND ADAPTIVE HASH INDEX

-------------------------------------

Ibuf: size 1, free list len 0, seg size 2, 0 merges

merged operations:

insert 0, delete mark 0, delete 0

discarded operations:

insert 0, delete mark 0, delete 0

Hash table size 276671, node heap has 0 buffer(s)

0.00 hash searches/s, 0.00 non-hash searches/s

可以看到AHI的使用信息,包括AHI的大小,使用情况,每秒使用AHI搜索的情况。

哈希索引只能用来搜索等值的查询,如select * from table where index_col=’xxx’;

对于其它类型的查找,比如范围查找,是不能使用哈希索引的,因此这里出现了non-hash searches/s的情况。通过hash searches/s和non-hash searches/s可以大概了解使用哈希索引后的效率。

可以通过参数innodb_adaptive_hash_index来考虑禁用或启动此特性,默认是开启状态。

mysql> show variables like 'innodb_adaptive_hash_index';

+----------------------------+-------+

| Variable_name | Value |

+----------------------------+-------+

| innodb_adaptive_hash_index | ON |

+----------------------------+-------+

1 row in set (0.00 sec)

————————————————

-

nnoDB 通过在内存中构造哈希索引,对使用 = 和 IN 运算符 加速查找的表进行优化。MySQL监视表的索引搜索,如果查询可以从哈希索引中受益,它会自动为经常访问的索引页构建一个。从某种意义上说,MySQL在运行时配置自适应哈希索引以利用充足主内存,更接近主内存数据库的体系结构。InnoDB 此功能由 innodb_adaptive_hash_index 配置选项。由于此功能有利于一些工作负载而非所有的工作负载,并且会占用缓冲池中的内存,因此通常您应该使用此功能进行基准测试,无论是启用还是禁用。

-

哈希索引始终基于现有的 InnoDB 二级索引构建 ,该索引被组织为B+树结构。MySQL可以在为B+树定义的任意长度的密钥的前缀上构建哈希索引,具体取决于针对索引的搜索模式。哈希索引可以是部分的; 整个B树索引不需要缓存在缓冲池中。

-

在MySQL 5.6及更高版本中,InnoDB 利用表的快速单值查找的另一种方法是使用InnoDB memcached插件。

自适应哈希索引的描述

mysql 5.7 官方手册对自适应哈希索引的描述

-

所述自适应散列索引(AHI)允许InnoDB执行更喜欢与工作量和用于充足存储器的适当组合,系统内存中的数据库 缓冲池,在不牺牲任何事务特性或可靠性。此功能由配置innodb_adaptive_hash_index 选项启用 ,或使用命令 --skip-innodb_adaptive_hash_index 在服务器启动时关闭 。

-

根据观察到的搜索模式,MySQL使用索引键的前缀构建哈希索引。密钥的前缀可以是任意长度,并且可能只有B树中的某些值出现在哈希索引中。哈希索引是根据需要经常访问的索引页面构建的。

-

如果表几乎完全适合主内存,则哈希索引可以通过启用任何元素的直接查找来加速查询,将索引值转换为一种指针。InnoDB 有一个监视索引搜索的机制。如果 InnoDB通知查询可以从构建哈希索引中受益,则会自动执行此操作。

-

对于某些工作负载,监视索引查找和维护哈希索引结构的额外开销远远超过了自适应哈希索引带来的性能提升。有时,访问时保护自适应哈希索引的 read/write lock 1会带来非常严重的性能消耗,例如高并发的joins。查询使用LIKE操作和% 通配符也往往不会受益于AHI。对于不需要自适应哈希索引的工作负载,将其关闭可减少不必要的性能开销。由于很难预先预测此功能是否适用于特定系统,因此请考虑使用实际工作负载运行启用和禁用的基准测试。对比早期版本,MySQL 5.6及更高版本中的体系结构更改使得更多工作负载适合于禁用自适应哈希索引,尽管默认情况下仍然启用它。

-

在MySQL 5.7中,自适应哈希索引搜索系统被分区。每个索引都绑定到一个特定的分区,每个分区都由一个单独的 latch 锁2保护。分区由 innodb_adaptive_hash_index_parts 配置选项控制 。在早期版本中,自适应哈希索引搜索系统受到单个 latch 锁的保护,这可能成为繁重工作负载下的争用点。innodb_adaptive_hash_index_parts 默认情况下,该 选项设置为8。最大设置为512。

-

哈希索引始终基于表上的现有B树索引构建 。 InnoDB可以在为B树定义的任意长度的键的前缀上构建哈希索引,具体取决于InnoDB为B树索引观察的搜索模式。哈希索引可以是部分的,仅覆盖经常访问的索引的那些页面。

-

您可以使用 SEMAPHORES 查看 SHOW ENGINE INNODB STATUS输出部分中,监视自适应哈希索引的使用及其使用的争用。如果您看到许多线程在创建的RW锁存器上等待 btr0sea.c,那么禁用自适应哈希索引可能会有用。

预读:(read ahead)

磁盘读写,并不是按需读取,而是按页读取,一次至少读一页数据(一般是4K),如果未来要读取的数据就在页中,就能够省去后续的磁盘IO,提高效率。

预读失效:

- 提前把页放入了缓冲池,但最终MySql并没有从页中读取数据,称为预读失效。

预读机制

InnoDB在I/O的优化上有个比较重要的特性为预读,预读请求是一个i/o请求,它会异步地在缓冲池中预先回迁多个页面,预计很快就会需要这些页面,这些请求在一个范围内引入所有页面。

InnoDB以64个page为一个extent,那么InnoDB的预读是以page为单位还是以extent?(根据预读的两种方式不同而不同)

![]()

数据库请求数据的时候,会将读请求交给文件系统,放入请求队列中;相关进程从请求队列中将读请求取出,根据需求到相关数据区(内存、磁盘)读取数据;取出的数据,放入响应队列中,最后数据库就会从响应队列中将数据取走,完成一次数据读操作过程。

接着进程继续处理请求队列,(如果数据库是全表扫描的话,数据读请求将会占满请求队列),判断后面几个数据读请求的数据是否相邻,再根据自身系统IO带宽处理量,进行预读,进行读请求的合并处理,一次性读取多块数据放入响应队列中,再被数据库取走。(如此,一次物理读操作,实现多页数据读取,rrqm>0(# iostat -x),假设是4个读请求合并,则rrqm参数显示的就是4)

两种预读算法

InnoDB使用两种预读算法来提高I/O性能:线性预读(linear read-ahead)和随机预读(randomread-ahead)

为了区分这两种预读的方式,我们可以把线性预读放到以extent为单位,而随机预读放到以extent中的page为单位。线性预读着眼于将下一个extent提前读取到buffer pool中,而随机预读着眼于将当前extent中的剩余的page提前读取到buffer pool中。

线性预读(linear read-ahead)

线性预读方式有一个很重要的变量控制是否将下一个extent预读到buffer pool中,通过使用配置参数innodb_read_ahead_threshold,控制触发innodb执行预读操作的时间。

如果一个extent中的被顺序读取的page超过或者等于该参数变量时,Innodb将会异步的将下一个extent读取到buffer pool中,innodb_read_ahead_threshold可以设置为0-64的任何值(因为一个extent中也就只有64页),默认值为56,值越高,访问模式检查越严格。

mysql> show variables like 'innodb_read_ahead_threshold';

+-----------------------------+-------+

| Variable_name | Value |

+-----------------------------+-------+

| innodb_read_ahead_threshold | 56 |

+-----------------------------+-------+

例如,如果将值设置为48,则InnoDB只有在顺序访问当前extent中的48个pages时才触发线性预读请求,将下一个extent读到内存中。如果值为8,InnoDB触发异步预读,即使程序段中只有8页被顺序访问。

可以在MySQL配置文件中设置此参数的值,或者使用SET GLOBAL需要该SUPER权限的命令动态更改该参数。

在没有该变量之前,当访问到extent的最后一个page的时候,innodb会决定是否将下一个extent放入到buffer pool中。

随机预读(randomread-ahead)

随机预读通过buffer pool中存中的也来预测哪些页可能很快会被访问,而不考虑这些页的读取顺序。

随机预读方式则是表示当同一个extent中的一些page在buffer pool中发现时,Innodb会将该extent中的剩余page一并读到buffer pool中。如果发现buffer pool中存中一个区段的13个连续的页,InnoDB会异步发起预读请求这个区段剩余的页。

mysql> show variables like 'innodb_random_read_ahead';

+--------------------------+-------+

| Variable_name | Value |

+--------------------------+-------+

| innodb_random_read_ahead | OFF |

+--------------------------+-------+

由于随机预读方式给innodb code带来了一些不必要的复杂性,同时在性能也存在不稳定性,在5.5中已经将这种预读方式废弃,默认是OFF。若要启用此功能,即将配置变量设置innodb_random_read_ahead为ON。

通过 SHOW INNODB ENGINE STATUS 命令输出的统计信息可以帮助你评估预读算法的效果,统计信息包含了下面几个值:

1.innodb_buffer_pool_read_ahead 通过预读异步读取到buffer pool的页数

2.innodb_buffer_pool_read_ahead_evicted 预读的页没被使用就被驱逐出buffer pool的页数,这个值与上面预读的页数的比值可以反应出预读算法的优劣。

3.innodb_buffer_pool_read_ahead_rnd 由InnoDB触发的随机预读次数。

监控Innodb的预读

可以通过show engine innodb status\G显示统计信息

mysql> show engine innodb status\G

----------------------

BUFFER POOL AND MEMORY

----------------------

……

Pages read ahead 0.00/s,

evicted without access 0.00/s, Random read ahead 0.00/s

……

1、Pages read ahead:表示每秒读入的pages;

2、evicted without access:表示每秒读出的pages;

3、一般随机预读都是关闭的,也就是0。

通过两个状态值,评估预读算法的有效性

mysql> show global status like '%read_ahead%';

+---------------------------------------+-------+

| Variable_name | Value |

+---------------------------------------+-------+

| Innodb_buffer_pool_read_ahead_rnd | 0 |

| Innodb_buffer_pool_read_ahead | 2303 |

| Innodb_buffer_pool_read_ahead_evicted | 0 |

+---------------------------------------+-------+

3 rows in set (0.01 sec)

1、Innodb_buffer_pool_read_ahead:

通过预读(后台线程)读入innodb buffer pool中数据页数

2、Innodb_buffer_pool_read_ahead_evicted:

通过预读来的数据页没有被查询访问就被清理的pages,无效预读页数

缓冲池

应用系统分层架构,为了加速数据访问,会把最常访问的数据,放在缓存(cache)里,避免每次都去访问数据库。操作系统,会有缓冲池(buffer pool)机制,避免每次访问磁盘,以加速数据的访问。MySQL作为一个存储系统,同样具有缓冲池(buffer pool)机制,以避免每次查询数据都进行磁盘IO。

缓冲池的作用:

缓存表数据和索引数据,把磁盘上的数据加载到缓冲池中,避免每次都进行磁盘IO,起到加速访问的效果.

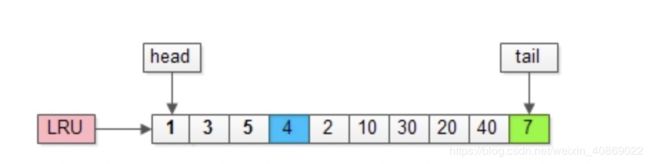

LRU算法(Least recently used):

把入缓存池的页放在LRU的头部,作为最近访问的元素

- 页在缓冲池中的数据,把它放在队列的前面(情景一)

- 页不在缓冲池中的数据,把它放在队列的前面,同时淘汰队列后面的数据(情景二)

情景一

![]()

情景二

![]()

MySQL不用LRU算法原因:

- 预读失效

- 提前把页放入了缓冲池,但最终MySQL并没有从页中读取数据,称为预读失效。

- 缓冲池污染

- 当某一个SQL语句,要批量扫描大量数据时,可能导致把缓冲池的所有页都替换出去,导致大量热数据被换出,MySQL性能急剧下降,这种情况叫缓冲池污染。

缓冲池认为是内存上的cache,用来避免频繁磁盘IO的,但是这个cache不会被100%命中 。如果未命中就预读失败。

命中了叫预读成功。

所以说缓冲池不等于查询缓存,他们两个存在的共同的特点就是都是通过缓存的机制来提升效率。而缓冲池是服务于数据库整体的IO操作,通过建立缓冲池机制来弥补存储引擎的磁盘文件与内存访问之间的效率鸿沟,同时缓冲池会采用“预读”的机器提前加载一些马上会用到的数据,以提升整体的数据库性能。而查询缓存是服务于SQL查询和查询结果集的,因为命中条件苛刻,而且只要当数据表发生了变化,查询缓存就会失效,因此命中率低,在MySQL版本中已经弃用了该功能。

InnoDB的缓冲池缓存什么?有什么用?

缓存表数据与索引数据,把磁盘上的数据加载到缓冲池,避免每次访问都进行磁盘IO,起到加速访问的作用。

速度快,那为啥不把所有数据都放到缓冲池里?

凡事都具备两面性,抛开数据易失性不说,访问快速的反面是存储容量小:

(1)缓存访问快,但容量小,数据库存储了200G数据,缓存容量可能只有64G;

(2)内存访问快,但容量小,买一台笔记本磁盘有2T,内存可能只有16G;

因此,只能把“最热”的数据放到“最近”的地方,以“最大限度”的降低磁盘访问。

什么是预读?

磁盘读写,并不是按需读取,而是按页读取,一次至少读一页数据(一般是4K),如果未来要读取的数据就在页中,就能够省去后续的磁盘IO,提高效率。

预读为什么有效 :

数据访问,通常都遵循“集中读写”的原则,使用一些数据,大概率会使用附近的数据,这就是所谓的“局部性原理”,它表明提前加载是有效的,确实能够减少磁盘IO。

按页(4K)读取,和InnoDB的缓冲池设计有啥关系?

(1)磁盘访问按页读取能够提高性能,所以缓冲池一般也是按页缓存数据;

(2)预读机制启示了我们,能把一些“可能要访问”的页提前加入缓冲池,避免未来的磁盘IO操作;

InnoDB是以什么算法,来管理这些缓冲页呢?

-

最容易想到的,就是LRU(Least recently used)。

-

画外音:memcache,OS都会用LRU来进行页置换管理,但MySQL的玩法并不一样。

传统的LRU是如何进行缓冲页管理?

最常见的玩法是,把入缓冲池的页放到LRU的头部,作为最近访问的元素,从而最晚被淘汰。这里又分两种情况:

(1)页已经在缓冲池里,那就只做“移至”LRU头部的动作,而没有页被淘汰;

(2)页不在缓冲池里,除了做“放入”LRU头部的动作,还要做“淘汰”LRU尾部页的动作;

![]()

假如,接下来要访问的数据在页号为4的页中:

![]()

1.页号为4的页,本来就在缓冲池里;

2.把页号为4的页,放到LRU的头部即可,没有页被淘汰;

画外音:为了减少数据移动,LRU一般用链表实现。

假如,再接下来要访问的数据在页号为50的页中:

![]()

1.页号为50的页,原来不在缓冲池里;

2.把页号为50的页,放到LRU头部,同时淘汰尾部页号为7的页;

传统的LRU缓冲池算法十分直观,OS,memcache等很多软件都在用,MySQL为啥这么矫情,不能直接用呢?

这里有两个问题:

(1)预读失效;

(2)缓冲池污染;

什么是预读失效?

由于预读(Read-Ahead),提前把页放入了缓冲池,但最终MySQL并没有从页中读取数据,称为预读失效。

如何对预读失效进行优化?

要优化预读失效,思路是:

(1)让预读失败的页,停留在缓冲池LRU里的时间尽可能短;

(2)让真正被读取的页,才挪到缓冲池LRU的头部;

以保证,真正被读取的热数据留在缓冲池里的时间尽可能长。

具体方法是:

-

将LRU分为两个部分:

- 新生代(new sublist)

- 老生代(old sublist)

-

新老生代收尾相连,即:新生代的尾(tail)连接着老生代的头(head);

-

新页(例如被预读的页)加入缓冲池时,只加入到老生代头部:

-

如果数据真正被读取(预读成功),才会加入到新生代的头部

-

如果数据没有被读取,则会比新生代里的“热数据页”更早被淘汰出缓冲池

-

![]()

举个例子,整个缓冲池LRU如上图:

(1)整个LRU长度是10;

(2)前70%是新生代;

(3)后30%是老生代;

(4)新老生代首尾相连;

![]()

假如有一个页号为50的新页被预读加入缓冲池:

(1)50只会从老生代头部插入,老生代尾部(也是整体尾部)的页会被淘汰掉;

(2)假设50这一页不会被真正读取,即预读失败,它将比新生代的数据更早淘汰出缓冲池;

![]()

假如50这一页立刻被读取到,例如SQL访问了页内的行row数据:

(1)它会被立刻加入到新生代的头部;

(2)新生代的页会被挤到老生代,此时并不会有页面被真正淘汰;

改进版缓冲池LRU能够很好的解决“预读失败”的问题。

画外音:但也不要因噎废食,因为害怕预读失败而取消预读策略,大部分情况下,局部性原理是成立的,预读是有效的。

新老生代改进版LRU仍然解决不了缓冲池污染的问题

什么是MySQL缓冲池污染?

当某一个SQL语句,要批量扫描大量数据时,可能导致把缓冲池的所有页都替换出去,导致大量热数据被换出,MySQL性能急剧下降,这种情况叫缓冲池污染。

解决MySQL缓冲池污染:

缓冲池污染案例:

有一个数据量较大的用户表,当执行:

select * from user where name like "%shenjian%";

虽然结果集可能只有少量数据,但这类like不能命中索引,必须全表扫描,就需要访问大量的页:

(1)把页加到缓冲池(插入老生代头部);

(2)从页里读出相关的row(插入新生代头部);

(3)row里的name字段和字符串shenjian进行比较,如果符合条件,加入到结果集中;

(4)…直到扫描完所有页中的所有row…

如此一来,所有的数据页都会被加载到新生代的头部,但只会访问一次,真正的热数据被大量换出

怎么这类扫码大量数据导致的缓冲池污染问题呢?

MySQL缓冲池加入了一个“老生代停留时间窗口”的机制:

(1)假设T=老生代停留时间窗口;

(2)插入老生代头部的页,即使立刻被访问,并不会立刻放入新生代头部;

(3)只有满足“被访问”并且“在老生代停留时间”大于T,才会被放入新生代头部;

![]()

继续举例,假如批量数据扫描,有51,52,53,54,55等五个页面将要依次被访问。

![]()

如果没有“老生代停留时间窗口”的策略,这些批量被访问的页面,会换出大量热数据。

![]()

加入“老生代停留时间窗口”策略后,短时间内被大量加载的页,并不会立刻插入新生代头部,而是优先淘汰那些,短期内仅仅访问了一次的页。

![]()

而只有在老生代呆的时间足够久,停留时间大于T,才会被插入新生代头部。

上述原理,对应InnoDB里哪些参数?

有三个比较重要的参数。

![]()

参数:innodb_buffer_pool_size

介绍:配置缓冲池的大小,在内存允许的情况下,DBA往往会建议调大这个参数,越多数据和索引放到内存里,数据库的性能会越好。

参数:innodb_old_blocks_pct

介绍:老生代占整个LRU链长度的比例,默认是37,即整个LRU中新生代与老生代长度比例是63:37。

画外音:如果把这个参数设为100,就退化为普通LRU了。

参数:innodb_old_blocks_time

介绍:老生代停留时间窗口,单位是毫秒,默认是1000,即同时满足“被访问”与“在老生代停留时间超过1秒”两个条件,才会被插入到新生代头部。

总结:happy:

(1)缓冲池(buffer pool)是一种常见的降低磁盘访问的机制;

(2)缓冲池通常以页(page)为单位缓存数据;

(3)缓冲池的常见管理算法是LRU,memcache,OS,InnoDB都使用了这种算法;

(4)InnoDB对普通LRU进行了优化:

- 将缓冲池分为老生代和新生代,入缓冲池的页,优先进入老生代,页被访问,才进入新生代,以解决预读失效的问题

- 页被访问,且在老生代停留时间超过配置阈值的,才进入新生代,以解决批量数据访问,大量热数据淘汰的问题

缓存:

Mysql缓存机制就是缓存sql 文本及缓存结果,用KV形式保存再服务器内存中,如果运行相同的sql,服务器直接从缓存中去获取结果,不需要在再去解析、优化、执行sql。 如果这个表修改了,那么使用这个表中的所有缓存将不再有效,查询缓存值得相关条目将被清空。表中得任何改变是值表中任何数据或者是结构的改变,包括insert,update,delete,truncate,alter table,drop table或者是drop database 包括那些映射到改变了的表的使用merge表的查询,显然,者对于频繁更新的表,查询缓存不合适,对于一些不变的数据且有大量相同sql查询的表,查询缓存会节省很大的性能。

命中条件

缓存存在一个hash表中,通过查询SQL,查询数据库,客户端协议等作为key,在判断命中前,mysql不会解析SQL,而是使用SQL去查询缓存,SQL上的任何字符的不同,如空格,注释,都会导致缓存不命中。如果查询有不确定的数据like now(),current_date(),那么查询完成后结果者不会被缓存,包含不确定的数的是不会放置到缓存中。

工作流程

1.服务器接收SQL,以SQL和一些其他条件为key查找缓存表

2.如果找到了缓存,则直接返回缓存

3.如果没有找到缓存,则执行SQL查询,包括原来的SQL解析,优化等。

4.执行完SQL查询结果以后,将SQL查询结果缓存入缓存表

缓存失败

当某个表正在写入数据,则这个表的缓存(命中缓存,缓存写入等)将会处于失效状态,在Innodb中,如果某个事务修改了这张表,则这个表的缓存在事务提交前都会处于失效状态,在这个事务提交前,这个表的相关查询都无法被缓存。

缓存的内存管理

缓存会在内存中开辟一块内存(query_cache_size)来维护缓存数据,其中大概有40K的空间是用来维护缓存数据的元数据的,例如空间内存,例如空间内存,数据表和查询结果映射,SQL和查询结果映射的。

mysql将这个大内存块分为小内存块(query_cache_min_res_unit),每个小块中存储自身的类型、大小和查询结果数据,还有前后内存块的指针。

mysql需要设置单个小存储块大小,在SQL查询开始(还未得到结果)时就去申请一块内存空间,所以即使你的缓存数据没有达到这个大小也需要这个大小的数据块去保存(like linux filesystem’s block)。如果超出这个内存块的大小,则需要再申请一个内存块。当查询完成发现申请的内存有富余,则会将富余的内存空间是放点,这就会造成内存碎片的问题,见下图

![]()

缓存的使用时机

衡量打开缓存是否对系统有性能提升是一个很难的话题

-

通过缓存命中率判断, 缓存命中率 = 缓存命中次数 (Qcache_hits) / 查询次数 (Com_select)

-

通过缓存写入率, 写入率 = 缓存写入次数 (Qcache_inserts) / 查询次数 (Qcache_inserts)

-

通过 命中-写入率 判断, 比率 = 命中次数 (Qcache_hits) / 写入次数 (Qcache_inserts), 高性能MySQL中称之为比较能反映性能提升的指数,一般来说达到3:1则算是查询缓存有效,而最好能够达到10:1

缓存参数配置

- query_cache_type: 是否打开缓存

可选项- OFF: 关闭

- ON: 总是打开

- DEMAND: 只有明确写了SQL_CACHE的查询才会吸入缓存

- query_cache_size: 缓存使用的总内存空间大小,单位是字节,这个值必须是1024的整数倍,否则MySQL实际分配可能跟这个数值不同(感觉这个应该跟文件系统的blcok大小有关)

- query_cache_min_res_unit: 分配内存块时的最小单位大小

- query_cache_limit: MySQL能够缓存的最大结果,如果超出,则增加 Qcache_not_cached的值,并删除查询结果

- query_cache_wlock_invalidate: 如果某个数据表被锁住,是否仍然从缓存中返回数据,默认是OFF,表示仍然可以返回

GLOBAL STAUS 中 关于 缓存的参数解释:

Qcache_free_blocks: 缓存池中空闲块的个数

Qcache_free_memory: 缓存中空闲内存量

Qcache_hits: 缓存命中次数

Qcache_inserts: 缓存写入次数

Qcache_lowmen_prunes: 因内存不足删除缓存次数

Qcache_not_cached: 查询未被缓存次数,例如查询结果超出缓存块大小,查询中包含可变函数等

Qcache_queries_in_cache: 当前缓存中缓存的SQL数量

Qcache_total_blocks: 缓存总block数

减少碎片策略

- 选择合适的block大小

- 使用 FLUSH QUERY CACHE 命令整理碎片.这个命令在整理缓存期间,会导致其他连接无法使用查询缓存

PS: 清空缓存的命令式 RESET QUERY CACHE

![]()

InnoDB与查询缓存

Innodb会对每个表设置一个事务计数器,里面存储当前最大的事务ID.当一个事务提交时,InnoDB会使用MVCC中系统事务ID最大的事务ID跟新当前表的计数器.

只有比这个最大ID大的事务能使用查询缓存,其他比这个ID小的事务则不能使用查询缓存.

另外,在InnoDB中,所有有加锁操作的事务都不使用任何查询缓存

查询必须是完全相同的(逐字节相同)才能够被认为是相同的。另外,同样的查询字符串由于其它原因可能认为是不同的。使用不同的数据库、不同的协议版本或者不同 默认字符集的查询被认为是不同的查询并且分别进行缓存。

一级缓存:

一级缓存也称本地缓存,sqlSession级别的缓存。一级缓存是一直开启的;与数据库同一次回话期间查询到的数据会放在本地缓存中。

二级缓存

全局缓存;基于namespace级别的缓存。一个namespace对应一个二级缓存。

一级缓存失效的四种情况:

-

sqlSession不同。

-

sqlSession相同,查询条件不同。因为缓存条件不同,缓存中还没有数据。

-

sqlSession相同,在两次相同查询条件中间执行过增删改操作。(因为中间的增删改可能对缓存中数据进行修改,所以不能用)

-

sqlSession相同,手动清空了一级缓存。(如果sqlSession去执行commit操作(执行插入、更新、删除),清空SqlSession中的一级缓存,这样做的目的为了让缓存中存储的是最新的信息,避免脏读。)

二级缓存:全局缓存;基于namespace级别的缓存。一个namespace对应一个二级缓存。

工作机制:

-

一个会话,查询一条数据,这个数据会被放在当前会话的一级缓存中。

-

如果会话被关闭了,一级缓存中的数据会被保存带二级缓存。新的会话查询信息就会参照二级缓存。

-

sqlSession ====> Employee====>employee sqlSession ====>DepartmentMapper=====>Department 不同的namespace查出的数据会放在自己对应的缓存中

效果:查出的数据首先放在一级缓存中,只有一级缓存被关闭或者提交以后,一级缓存数据才会转移到二级缓存

使用步骤:

1.开启全局缓存配置。

2.因为是namespace级别,需要搭配每个xxxMapper.xml中配置二级缓存

eviction:缓存的回收策略:

LRU– 最近最少使用的:移除最长时间不被使用的对象。

FIFO– 先进先出:按对象进入缓存的顺序来移除它们。

SOFT– 软引用:移除基于垃圾回收器状态和软引用规则的对象。

WEAK– 弱引用:更积极地移除基于垃圾收集器状态和弱引用规则的对象。

flushInterval:缓存刷新间隔。缓存多久清空一次,默认不清空。设置一个毫秒值。

readOnly:是否只读。

true:mybatis认为所有从缓存中获取数据的操作都是只读操作,不会修改数据。mybatis为了加快获取速度,直接就会将 数据在缓存中的引用交给用户。不安全,速度快。

false:mybatis觉得获取的数据可能被修改。mybatis会利用序列化和反序列化的技术克隆一份新的数据给用户。安全, 速度快。

size:缓存放多少元素。

type:指定自定义缓存全类名。实现cache接口即可。

3.pojo需要实现序列换接口。

和缓存相关的配置/属性:

-

cacheEnabled:如果是false,关闭二级缓存,不关闭一级缓存。

-

每个select标签都有userCache="true"属性:对一级缓存没有影响。设置为false,二级缓存失效。

-

每个增删改标签都有flushCache="true"属性:一级缓存和二级缓存都会被清空。

-

在查询标签中flushCache="false"属性:如果设置为true,查完会清空,一级二级缓存都会被清空,都不会用缓存。

-

sqlSession.clearn():跟session有关,只会清除一级缓存。

-

localCacheScope:本地缓存作用域。

一级缓存SESSION:当前会话的所有数据保存到回话缓存中。STATEMENT:禁用一级缓存。

缓存首先一进来去查二级缓存,二级缓存没有去找一级缓存,一级缓存没有去找数据库。二级缓存----->一级缓存-------->数据库。

自定义缓存 implements Cache,重写接口中的保存等方法,比如说保存到redis.

Mybatis的一级缓存:

Mybatis的一级缓存是指Session缓存。一级缓存的作用域默认是一个SqlSession。Mybatis默认开启一级缓存。

也就是在同一个SqlSession中,执行相同的查询SQL,第一次会去数据库进行查询,并写到缓存中;

第二次以后是直接去缓存中取。

当执行SQL查询中间发生了增删改的操作,MyBatis会把SqlSession的缓存清空。

一级缓存的范围有session和statement两种,默认是session,如果不想使用一级缓存,可以把一级缓存的范围指定为statement,这样每次执行完一个Mapper中的语句后都会将一级缓存清除。

如果需要更改一级缓存的范围,可以在Mybatis的配置文件中,在下通过localCacheScope指定。

<setting name="localCacheScope" value="STATEMENT"/>

建议不需要修改

需要注意的是:

当Mybatis整合Spring后,直接通过Spring注入Mapper的形式,如果不是在同一个事务中每个Mapper的每次查询操作都对应一个全新的SqlSession实例,这个时候就不会有一级缓存的命中,但是在同一个事务中时共用的是同一个SqlSession。

如有需要可以启用二级缓存。

Mybatis的二级缓存:

Mybatis的二级缓存是指mapper映射文件。二级缓存的作用域是同一个namespace下的mapper映射文件内容,多个SqlSession共享。Mybatis需要手动设置启动二级缓存。

二级缓存是默认启用的(要生效需要对每个Mapper进行配置),如想取消,则可以通过Mybatis配置文件中的元素下的子元素来指定cacheEnabled为false。

<settings>

<setting name="cacheEnabled" value="false" />

</settings>

cacheEnabled默认是启用的,只有在该值为true的时候,底层使用的Executor才是支持二级缓存的CachingExecutor。具体可参考Mybatis的核心配置类org.apache.ibatis.session.Configuration的newExecutor方法实现。

可以通过源码看看

...

public Executor newExecutor(Transaction transaction) {

return this.newExecutor(transaction, this.defaultExecutorType);

}

public Executor newExecutor(Transaction transaction, ExecutorType executorType) {

executorType = executorType == null ? this.defaultExecutorType : executorType;

executorType = executorType == null ? ExecutorType.SIMPLE : executorType;

Object executor;

if (ExecutorType.BATCH == executorType) {

executor = new BatchExecutor(this, transaction);

} else if (ExecutorType.REUSE == executorType) {

executor = new ReuseExecutor(this, transaction);

} else {

executor = new SimpleExecutor(this, transaction);

}

if (this.cacheEnabled) {//设置为true才执行的

executor = new CachingExecutor((Executor)executor);

}

Executor executor = (Executor)this.interceptorChain.pluginAll(executor);

return executor;

}

...

要使用二级缓存除了上面一个配置外,我们还需要在我们每个DAO对应的Mapper.xml文件中定义需要使用的cache

...

<mapper namespace="...UserMapper">

<cache/><!-- 加上该句即可,使用默认配置、还有另外一种方式,在后面写出 -->

...

</mapper>

具体可以看org.apache.ibatis.executor.CachingExecutor类的以下实现

其中使用的cache就是我们在对应的Mapper.xml中定义的cache。

public <E> List<E> query(MappedStatement ms, Object parameterObject, RowBounds rowBounds, ResultHandler resultHandler) throws SQLException {

BoundSql boundSql = ms.getBoundSql(parameterObject);

CacheKey key = this.createCacheKey(ms, parameterObject, rowBounds, boundSql);

return this.query(ms, parameterObject, rowBounds, resultHandler, key, boundSql);

}

public <E> List<E> query(MappedStatement ms, Object parameterObject, RowBounds rowBounds, ResultHandler resultHandler, CacheKey key, BoundSql boundSql) throws SQLException {

Cache cache = ms.getCache();

if (cache != null) {//第一个条件 定义需要使用的cache

this.flushCacheIfRequired(ms);

if (ms.isUseCache() && resultHandler == null) {//第二个条件 需要当前的查询语句是配置了使用cache的,即下面源码的useCache()是返回true的 默认是true

this.ensureNoOutParams(ms, parameterObject, boundSql);

List<E> list = (List)this.tcm.getObject(cache, key);

if (list == null) {

list = this.delegate.query(ms, parameterObject, rowBounds, resultHandler, key, boundSql);

this.tcm.putObject(cache, key, list);

}

return list;

}

}

return this.delegate.query(ms, parameterObject, rowBounds, resultHandler, key, boundSql);

}

还有一个条件就是需要当前的查询语句是配置了使用cache的,即上面源码的useCache()是返回true的,默认情况下所有select语句的useCache都是true,如果我们在启用了二级缓存后,有某个查询语句是我们不想缓存的,则可以通过指定其useCache为false来达到对应的效果。

如果我们不想该语句缓存,可使用useCache=”false

<select id="selectByPrimaryKey" resultMap="BaseResultMap" parameterType="java.lang.String" useCache="false">

select

<include refid="Base_Column_List"/>

from tuser

where id = #{id,jdbcType=VARCHAR}

</select>

cache定义的两种使用方式

上面说了要想使用二级缓存,需要在每个DAO对应的Mapper.xml文件中定义其中的查询语句需要使用cache来缓存数据的。

这有两种方式可以定义,一种是通过cache元素定义,一种是通过cache-ref元素来定义。

需要注意的是

对于同一个Mapper来讲,只能使用一个Cache,当同时使用了和时,定义的优先级更高(后面的代码会给出原因)。

Mapper使用的Cache是与我们的Mapper对应的namespace绑定的,一个namespace最多只会有一个Cache与其绑定。

cache元素定义

使用cache元素来定义使用的Cache时,最简单的做法是直接在对应的Mapper.xml文件中指定一个空的元素(看前面的代码),这个时候Mybatis会按照默认配置创建一个Cache对象,准备的说是PerpetualCache对象,更准确的说是LruCache对象(底层用了装饰器模式)。

具体的可看org.apache.ibatis.builder.xml.XMLMapperBuilder中的cacheElement()方法解析cache元素的逻辑。

...

private void configurationElement(XNode context) {

try {

String namespace = context.getStringAttribute("namespace");

if (namespace.equals("")) {

throw new BuilderException("Mapper's namespace cannot be empty");

} else {

this.builderAssistant.setCurrentNamespace(namespace);

this.cacheRefElement(context.evalNode("cache-ref"));

this.cacheElement(context.evalNode("cache"));//执行在后面

this.parameterMapElement(context.evalNodes("/mapper/parameterMap"));

this.resultMapElements(context.evalNodes("/mapper/resultMap"));

this.sqlElement(context.evalNodes("/mapper/sql"));

this.buildStatementFromContext(context.evalNodes("select|insert|update|delete"));

}

} catch (Exception var3) {

throw new BuilderException("Error parsing Mapper XML. Cause: " + var3, var3);

}

}

...

private void cacheRefElement(XNode context) {

if (context != null) {

this.configuration.addCacheRef(this.builderAssistant.getCurrentNamespace(), context.getStringAttribute("namespace"));

CacheRefResolver cacheRefResolver = new CacheRefResolver(this.builderAssistant, context.getStringAttribute("namespace"));

try {

cacheRefResolver.resolveCacheRef();

} catch (IncompleteElementException var4) {

this.configuration.addIncompleteCacheRef(cacheRefResolver);

}

}

}

private void cacheElement(XNode context) throws Exception {

if (context != null) {

String type = context.getStringAttribute("type", "PERPETUAL");

Class<? extends Cache> typeClass = this.typeAliasRegistry.resolveAlias(type);

String eviction = context.getStringAttribute("eviction", "LRU");

Class<? extends Cache> evictionClass = this.typeAliasRegistry.resolveAlias(eviction);

Long flushInterval = context.getLongAttribute("flushInterval");

Integer size = context.getIntAttribute("size");

boolean readWrite = !context.getBooleanAttribute("readOnly", false).booleanValue();

Properties props = context.getChildrenAsProperties();

this.builderAssistant.useNewCache(typeClass, evictionClass, flushInterval, size, readWrite, props);

//如果同时存在和,这里的设置会覆盖前面的cache-ref的缓存

}

}

空cache元素定义会生成一个采用最近最少使用算法最多只能存储1024个元素的缓存,而且是可读写的缓存,即该缓存是全局共享的,任何一个线程在拿到缓存结果后对数据的修改都将影响其它线程获取的缓存结果,因为它们是共享的,同一个对象。

cache元素可指定如下属性,每种属性的指定都是针对都是针对底层Cache的一种装饰,采用的是装饰器的模式。

- blocking:默认为false,当指定为true时将采用BlockingCache进行封装,blocking,阻塞的意思,使用BlockingCache会在查询缓存时锁住对应的Key,如果缓存命中了则会释放对应的锁,否则会在查询数据库以后再释放锁,这样可以阻止并发情况下多个线程同时查询数据,详情可参考BlockingCache的源码。

简单理解,也就是设置true时,在进行增删改之后的并发查询,只会有一条去数据库查询,而不会并发- eviction:eviction,驱逐的意思。也就是元素驱逐算法,默认是LRU,对应的就是LruCache,其默认只保存1024个Key,超出时按照最近最少使用算法进行驱逐,详情请参考LruCache的源码。如果想使用自己的算法,则可以将该值指定为自己的驱逐算法实现类,只需要自己的类实现Mybatis的Cache接口即可。除了LRU以外,系统还提供了FIFO(先进先出,对应FifoCache)、SOFT(采用软引用存储Value,便于垃圾回收,对应SoftCache)和WEAK(采用弱引用存储Value,便于垃圾回收,对应WeakCache)这三种策略。

这里,根据个人需求选择了,没什么要求的话,默认的LRU即可- flushInterval:清空缓存的时间间隔,单位是毫秒,默认是不会清空的。当指定了该值时会再用ScheduleCache包装一次,其会在每次对缓存进行操作时判断距离最近一次清空缓存的时间是否超过了flushInterval指定的时间,如果超出了,则清空当前的缓存,详情可参考ScheduleCache的实现。

- readOnly:是否只读

默认为false。当指定为false时,底层会用SerializedCache包装一次,其会在写缓存的时候将缓存对象进行序列化,然后在读缓存的时候进行反序列化,这样每次读到的都将是一个新的对象,即使你更改了读取到的结果,也不会影响原来缓存的对象,即非只读,你每次拿到这个缓存结果都可以进行修改,而不会影响原来的缓存结果;

当指定为true时那就是每次获取的都是同一个引用,对其修改会影响后续的缓存数据获取,这种情况下是不建议对获取到的缓存结果进行更改,意为只读(不建议设置为true)。

这是Mybatis二级缓存读写和只读的定义,可能与我们通常情况下的只读和读写意义有点不同。每次都进行序列化和反序列化无疑会影响性能,但是这样的缓存结果更安全,不会被随意更改,具体可根据实际情况进行选择。详情可参考SerializedCache的源码。- size:用来指定缓存中最多保存的Key的数量。其是针对LruCache而言的,LruCache默认只存储最多1024个Key,可通过该属性来改变默认值,当然,如果你通过eviction指定了自己的驱逐算法,同时自己的实现里面也有setSize方法,那么也可以通过cache的size属性给自定义的驱逐算法里面的size赋值。

- type:type属性用来指定当前底层缓存实现类,默认是PerpetualCache,如果我们想使用自定义的Cache,则可以通过该属性来指定,对应的值是我们自定义的Cache的全路径名称。

cache-ref元素定义

cache-ref元素可以用来指定其它Mapper.xml中定义的Cache,有的时候可能我们多个不同的Mapper需要共享同一个缓存的

是希望在MapperA中缓存的内容在MapperB中可以直接命中的,这个时候我们就可以考虑使用cache-ref,这种场景只需要保证它们的缓存的Key是一致的即可命中,二级缓存的Key是通过Executor接口的createCacheKey()方法生成的,其实现基本都是BaseExecutor,源码如下。

public CacheKey createCacheKey(MappedStatement ms, Object parameterObject, RowBounds rowBounds, BoundSql boundSql) {

if (this.closed) {

throw new ExecutorException("Executor was closed.");

} else {

CacheKey cacheKey = new CacheKey();

cacheKey.update(ms.getId());

cacheKey.update(rowBounds.getOffset());

cacheKey.update(rowBounds.getLimit());

cacheKey.update(boundSql.getSql());

List<ParameterMapping> parameterMappings = boundSql.getParameterMappings();

TypeHandlerRegistry typeHandlerRegistry = ms.getConfiguration().getTypeHandlerRegistry();

for(int i = 0; i < parameterMappings.size(); ++i) {

ParameterMapping parameterMapping = (ParameterMapping)parameterMappings.get(i);

if (parameterMapping.getMode() != ParameterMode.OUT) {

String propertyName = parameterMapping.getProperty();

Object value;

if (boundSql.hasAdditionalParameter(propertyName)) {

value = boundSql.getAdditionalParameter(propertyName);

} else if (parameterObject == null) {

value = null;

} else if (typeHandlerRegistry.hasTypeHandler(parameterObject.getClass())) {

value = parameterObject;

} else {

MetaObject metaObject = this.configuration.newMetaObject(parameterObject);

value = metaObject.getValue(propertyName);

}

cacheKey.update(value);

}

}

return cacheKey;

}

}

打个比方我想在MenuMapper.xml中的查询都使用在UserMapper.xml中定义的Cache,则可以通过cache-ref元素的namespace属性指定需要引用的Cache所在的namespace,即UserMapper.xml中的定义的namespace,假设在UserMapper.xml中定义的namespace是cn.chenhaoxiang.dao.UserMapper,则在MenuMapper.xml的cache-ref应该定义如下。

<cache-ref namespace="cn.chenhaoxiang.dao.UserMapper"/>

二级缓存的使用原则

-

只能在一个命名空间下使用二级缓存

由于二级缓存中的数据是基于namespace的,即不同namespace中的数据互不干扰。在多个namespace中若均存在对同一个表的操作,那么这多个namespace中的数据可能就会出现不一致现象。 -

在单表上使用二级缓存

如果一个表与其它表有关联关系,那么久非常有可能存在多个namespace对同一数据的操作。而不同namespace中的数据互补干扰,所以就有可能出现多个namespace中的数据不一致现象。 -

查询多于修改时使用二级缓存

在查询操作远远多于增删改操作的情况下可以使用二级缓存。因为任何增删改操作都将刷新二级缓存,对二级缓存的频繁刷新将降低系统性能。

表缓存:

表缓存是将表对象的字典信息(定义的内容)缓存到内存中,提高访问效率。

相关结构

在mysql server层有两个与table相关的结构,分别为TABLE、TABLE_SHARE

TABLE_SHARE

TABLE_SHARE是表定义缓存,是一个静态表缓存,唯一对应一张表,所有用户都共享这个表对象;其内容从系统表获取(frm),它保存在table_def_cache(hash表,key为表名(含库名))中。

参数: table_definition_cache

TABLE

相对于TABLE_SHARE而言,Table可以看成是动态的,其内容会改变,会记录表操作状态;每个线程都会有TABLE对象,对应于同一个TABLE_SHARE.

当表实例不用时会对表进行缓存,再次使用直接取出即可,在缓存时可能需要调用ha_reset恢复实例状态。(其中会调用handler::reset(),用来重置引擎表状态),handler有可能被复用,如果不定义reset,可能出错。

缓存在表实例缓存空间,同时由TABLE_SHARE的free_table和used_table对表实例的使用情况进行管理。

参数: table_open_cache

实现过程

1、表被访问的时候,MySQL先从缓存中查找这个表,缓存中有这个表的TABLE ,直接读取,没有TABLE,会去系统表中获取TABLE SHARE,表字典对象的缓存是通过hash表来存储管理的,它保存在table_def_cache(hash表,key为表名(含库名))中,

如果这个表在之前访问过,就不需要构建结构体了,直接通过table_def_cache表找到对应的结构体。

2、表打开时,先从系统表中将表的所以信息读入内存,包括表名,库名,列,字符集等信息。读取的信息通过结构体table_share存储,这个表可以让所有用户访问,且不能被修改的,其大小由table_definition_cache控制

3、当用户得到table_share后,系统会**重新构造一个新的对象(名字叫table)**交给当前的操作,从table_share 到table实例的过程叫表结构实例化,当两个用户同时对同一个表进行操作时,就会实例化为两个TABLE,TABLE表的数量由table_open_cache参数。

相关的状态值

Open_table_definitions :代表当前缓存了多少.frm文件。

Opened_table_definitions:代表自从MySQL启动后,缓存了.frm文件的数量。 需要注意的是.frm文件是MySQL用于存放表结构的文件,对应myisam和innodb存储引擎都必须有的,可以通过show open tables 查看 这2个变量的值

Opened_tables :已打开的表的数量。如果opened_tables很大,那么使用table_open_cache价值可能太小了

Open_tables:打开的表的数量

写缓存:

首先的一点,数据库需要保证安全性,所以每一次写入数据库的时候,都会产生redo log,用来在数据库崩溃的时候进行回滚,同时,如果开启了binlog,那么数据库也会在每一条sql语句执行之后记录一条binlog,binlog是直接写入磁盘的,但是binlog是有自己的机制去管理的,与写操作的效率无关,这里可以排除其影响

这里探究的是数据落盘的原理:

我们知道,数据库拥有读缓存的功能,部分页会被从磁盘读到内存中来,那么当一个页在内存中时,发生了写操作,这个时候应该如何处理呢?

当要修改的数据页在内存中时,数据库采用的方式是将数据写入内存中,而不是直接写入磁盘中,然后再将redo log写入到磁盘。那么当这个数据页被从缓存中淘汰的时候,这些“脏数据页”就会被同步地写入磁盘,等于是将这期间发生的n次的落盘合并成了一次落盘。因为redo log是落盘的,所以即使数据库崩溃,缓存中的数据页全部丢失,也可以通过redo log将这些数据页找回来

(redo log是数据库用来在崩溃的时候进行数据恢复的日志,redo log的写入策略可以通过参数控制,并不一定是每一次写操作之后立即落盘redo log,在部分参数下,redo log可能是每秒集中写入一次,也有可能采取其他落盘策略,但是无论采用什么方式,redo log的量都是不会减少的,与数据写入的覆盖性不同,后一条redo log是不会覆盖前一条的,而是增量形式的,因此写redo log的操作,等同于是对磁盘某一小块区域的顺序I/O,而不像数据落盘一样随机在磁盘里写入,需要磁盘在多个地方移动磁头。所以redo log的落盘是IO操作当中消耗较少的一种,比数据直接刷回磁盘要优很多)

那么当一个页不在内存中时,发生了写操作,这个时候应该如何处理呢?

正常思路是将这个页读到内存中,然后对其进行写操作,然后再进行一次正常的内存写操作和redo log的磁盘写操作。但是对于写多读少的业务,每一次写操作不命中内存就需要一次磁盘读操作,这显然会影响性能。

innodb对这里的写入操作进行了优化:写操作并不会立即写入到磁盘,而是只记录缓冲变更,等未来数据从磁盘真正被读出来的时候,才会将缓冲变更合并到缓冲池里,这种做法可以有效减少写操作时候的磁盘读取,提高数据库性能,这里对于数据变更的缓存区,就是写缓冲

写缓冲等于是将写操作没有命中缓存的情况转化为了命中缓存的情况,由于redo log依然是按策略落盘的,可以理解为数据是安全的,而写缓存的数据也不是长期保留在缓存里的,数据库有策略定期将写缓存中的数据写入磁盘的操作,这里的写缓冲写入策略可以由数据库参数控制(有的采取定时写入,有的采取满则写入,也有的采取闲时写入)

注意:当数据库全都是唯一索引的时候,写缓冲是没有办法工作的,因为不将所有数据都读出来,没有办法判断这次写操作是否合法,是否符合唯一索引的条件

相关参数:innodb_change_buffer_max_size:写缓冲占整个缓冲池的大小比例,默认25%,对于写多读少的业务,才需要调大这个参数,对于读多写少的业务,可以调小该数值

innodb_change_buffering:配置使用写缓冲的操作类型,可选all、none、update、deletes等

Sqlsession:

每个线程都应该有它自己的SqlSession实例。SqlSession的实例不能被共享,也是线程不安全的。因此最佳的范围是请求或方法范围。绝对不能将SqlSession实例的引用放在一个类的静态字段甚至是实例字段中。

如果说SqlSessionFactory相当于数据库连接池,那么SqlSession就相当于一个数据库连接(Connection对象),

你可以在一个事务里面执行多条SQL,然后通过它的commit、rollback等方法,提交或者回滚事务。所以它应该存活在一个业务请求中,

处理完整个请求后,应该关闭这条连接,让它归还给SqlSessionFactory,否则数据库资源就很快被消耗精光,系统应付瘫痪,所以用try…catch…fanally语句来保证其正确关闭。

SqlSessionFactoryBuilder:

SqlSessionFactoryBuilder的作用就是在于创建SqlSessionFactory,创建成功后,SqlSessionFactoryBuilder就失去了作用,

所以它只能存在于创建SqlSessionFactory的方法中,而不要让其长期存在

SqlSessionFactory:

SqlSessionFactory可以被认为是一个数据库连接池,它的作用是创建SqlSession接口对象。因为MyBatis的本质就是Java对数据库的操作,

所以SqlSessionFactory的生命周期在于于整个MyBatis的应用之中,所以一旦创建了SqlSessionFactory的生命周期就等同于MyBatis的应用周期。

由于SqlSessionFactory是一个对数据库的连接池,所以它占据着数据库的连接资源。如果创建多个SqlSessionFactory,那么就存在多个数据库连接池,

这样不利于对数据资源的控制,也会导致连接资源被消耗光,出现系统宕机等情况,所以尽量避免发生这样的情况。因此在一般的应用中我们往往希望SqlSessionfactory作为一个单例,让它在应用中不共享。

Mapper:

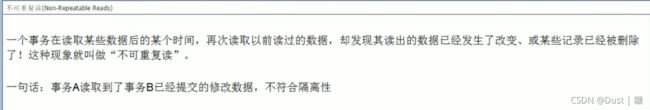

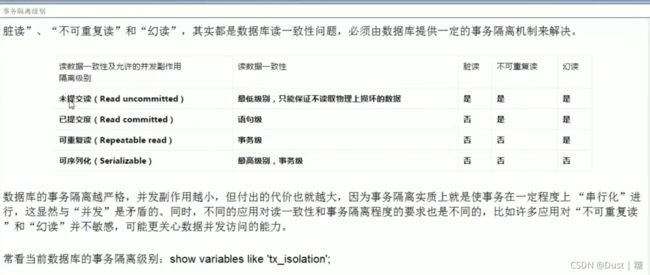

Mapper是一个接口,它由SqlSession所创建,所以它的最大生命周期至多和SqlSession保持一致,尽管它很好用,