第二阶段文献总结

(一)CoSLAM

1、系统功能和亮点

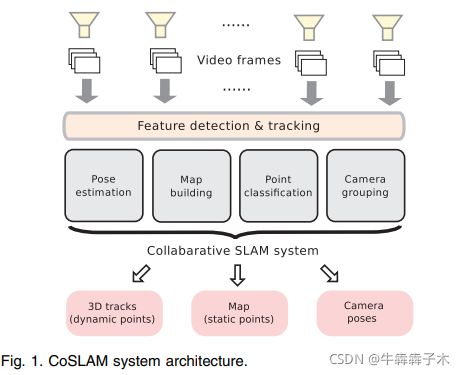

功能:本文是第一个动态场景下多相机合作的同时定位、静态图构建、动态点轨迹估计的SLAM系统

亮点:

- 引入相机间位姿估计和相机间建图解决动态物体问题

- 维护每一个map点的不确定度,提高系统鲁棒性

- 为了方便相机间的操作, 根据摄像机的视图重叠将摄像机分组,并实时管理摄像机组的拆分和合并。

2、系统结构流程

(1) tracking部分:对每个相机的每一帧用KLT光流法计算特征点和光流

(2)相机位姿估计:两种模式(自身估计和相机间估计)

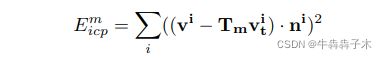

- 自身估计:每个相机独立的跟踪估计(static map 3D-2D),用的是静态点的重投影误差优化

- 相机间估计:当当前帧的可跟踪静态点甚少,前者位姿估计效果差时,可根据相机间overlap动态点形成的相对位姿约束(dynamic map 3D-2D),估计各相机的绝对位姿。(注意c是指一组内的所有相机)

(3)地图维护

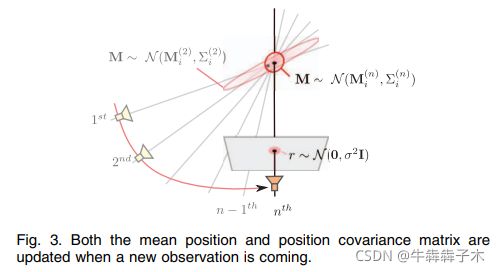

- map points的不确定度:此文只计算map points的三角化不确定度(不像完整的kalmen filter要维护相机状态,各特征点状态相互关系的协方差),其不确定度表示为协方差矩阵,当对于一个map point有新的观测加入时,通过卡尔曼滤增益更新map point pose和其协方差矩阵(注意论文P357相关公式推导),map points不确定度计算可以帮助动态点/静态点区分和

- mapping:静态点创建就是共视帧间三角化并计算点的不确定度;动态点创建需要用到同一时刻同一组相机上的数据:特征匹配用 zero-mean normalized cross correlation (ZNCC)方法,在极线附近搜索,并用周围最近的已有map point作为种子找到其对应的视差向量,与当前匹配点组成的视差向量对比剔除外点。为了减少匹配数量,为同一组的相机建立图,并选择图的一个生成树,只匹配生成树上相连边上的相机特征点。然后根据匹配点三角化得到map point,但是这样的map point只是根据两个相机得到,还需要将其他相机上看到的特征点与map point关联起来,这一过程称为点注册。

- 点注册:(将map points与当前帧的feature point联系起来),将active map points投影到图像上比较马氏距离,找到最近的feature point并用ZNCC判断,若ZNCCscore小于阈值就进一步对比map points到此feature points之前帧上匹配点的马氏距离,若依然很小就注册此feature point到此map point上。每次添加新观测后,用map point上关联的所有feature point重新三角化(retriangulation)来更新map point和其协方差。

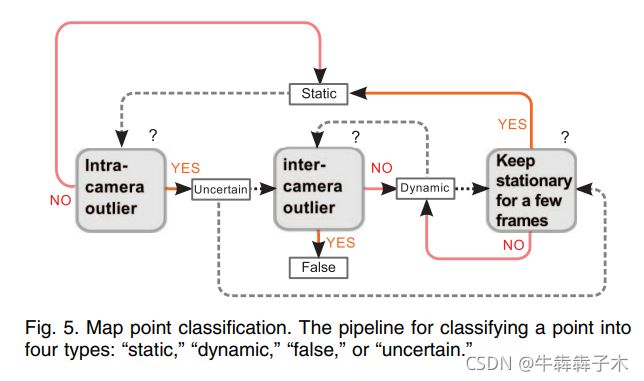

- map points的分类:起始所有map points都设置为static,当每一步map结束后将所有map point,然后经过fig.5从左到右依次进行外点判断,将点区分为static、dynamic和false三类。在点分类过程中,动态点的三维位置会随时间自然更新。因此,系统能够生成运动点的三维轨迹。

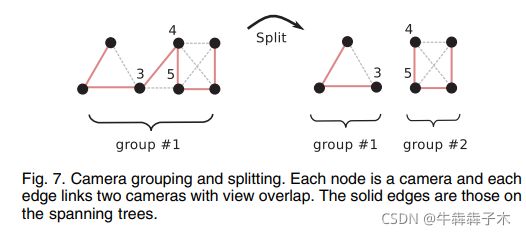

(6)相机分组

- 分组与分割:因为每一个相机上的每个特征点都是指向对应的map point的,故可以方便的统计相机间重叠的map point数量。依次访问相机,若重叠点数量大于阈值则以两个相机为节点以一条边连接(边的权重是重叠点数量),这样就形成一个无向连通图。此图节点即为一个相机分组,同时对此图提取权值最大的生成树(spanning tree),用以约束intercamera过程中的特征匹配复杂度。

- 融合:将A组相机看到的map points投影到B组的图像平面上,如果有30%的map points能在B相机上看到就将两组融合为一组。因为之前的pose估计和map点生成都是在同一组内进行的,当融合之后两组的map会有重复,而且两组的相机位姿尺度也不一致。对于融合后的相机pose和map points重新调整。这里通过提取当前帧上的SURF特征点及描述子,在相机间进行匹配计算相对位姿,做为硬约束,以原来在同组的相互间的位姿作为软约束,进行BA调整,优化融合后的相机pose,然后用优化后的新pose重新三角化更新map points。

3、相关实验及结果

- 实验验证了纯旋转静态场景下的可行性,及回环漂移和尺度漂移(对于没有ground truth的数据可以用类似本文的评价方法,即first与last frame时的位姿漂移或固定标志物的map point偏移,此文是起始和结束时的一堵墙的位置偏差)。

- 验证了动态场景下定位效果(基本可以成功运行,精度可能较低),系统运行效率很高,基本平均每帧38ms。

4、未来工作

本文作者想后续做成在线系统,并做成分布式多相机系统。

点子记录:

- ego用特征点法,object用直接法(实现object的稠密建图和较好的3D bounding box估计),不过这样有点像VDO-SLAM加上个3D bounding box估计的功能

- 系统框架可以为:单目+object(尺寸先验)?、单目+单目深度估计网络、RGB-D+IMU(处理动态点占比较大的情况)

- 单目视觉的尺度确定方法?sfm与slam的区别?

- 如何解决动态点占比大的情况,和动态物不满足刚体假设的情况?

- wider FOV大视野场景定位(多相机组合)

- 雷达或激光扫描系统如何处理动态场景(如何基于滤波方法剔除动点)?

(二) MVO

1、系统功能和亮点

功能:本文是一个不需要环境先验信息和动态物体模型的,可以同时估计相机和动态物体SE(3)的多目标运动估计的视觉里程计。

亮点:

- 在传统VO上使用多模型拟合技术,实现多目标轨迹估计。(e.g., CORAL [3])

- 稀疏的3D特征被分解到独立的刚体上(将相同的特征绑定到同个刚体上)

- 这是第一个不需要依靠简化约束或利用脆弱的初始化来估计多目标轨迹的。

简化约束:

脆弱的初始化:

2、系统结构流程

该方法使用多重标记和估计技术来建模多帧上轨迹特征的运动。CORAL[3]将假设轨迹应用于单个轨迹,这是一种解决多重标记问题的凸优化方法。与最初从场景中采样的其他标记方法不同,这些假设通过模型的拆分和合并得到迭代改进。最后,利用传统的VO批量估计技术对每一运动的完整SE(3)轨迹进行估计。该方法在包含场景中所有运动的地面真实轨迹的数据集上进行评估。

(a)首先提取特征点计算得到3D点并进行帧间track,得到tracklets集合,将tacklets输入Robust Multimotion Fitting模块(多运动引擎)。(b)Robust Multimotion Fitting模块根据轨迹显示的运动(相机和物体运动的组合)对轨迹进行分割。在缺乏关于场景的先验信息的情况下,通过假设这些轨迹属于静态对象,使用每组轨迹来估计相机的运动。这些相机运动假设稍后可以通过识别场景的静态部分(例如,如VO中)转换为相机和对象运动的估计,(b)部分具体操作如下:

(a)首先提取特征点计算得到3D点并进行帧间track,得到tracklets集合,将tacklets输入Robust Multimotion Fitting模块(多运动引擎)。(b)Robust Multimotion Fitting模块根据轨迹显示的运动(相机和物体运动的组合)对轨迹进行分割。在缺乏关于场景的先验信息的情况下,通过假设这些轨迹属于静态对象,使用每组轨迹来估计相机的运动。这些相机运动假设稍后可以通过识别场景的静态部分(例如,如VO中)转换为相机和对象运动的估计,(b)部分具体操作如下:

(1)(Graph Construction)图构建:多运动拟合方法基于整个估计批次中点对之间的距离构建邻域图。将tracklets按照K近邻算法构建为一个graph,一个graph上的节点都是在image space上相近的tracklets,可以用刚体假设。

(2)Label Proposal标签提名:对split后的点通过RANSAC获得inliner最多的label来得到新标签,这样形成标签集。

(3)Label assigntment:方法使用邻域图迭代地拆分和估计新标签、使用CORAL[3]执行cost funtion最小化对每个tracket实现标签分配然后合并被认为是冗余的标签,如此往复迭代直至收敛。

(4)对标签集进行消毒,并通过完整的批量估计步骤生成最终的模型估计:

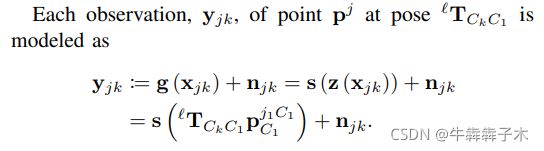

观测值为yjk,优化估计量为点pj和以l标签进行估计的egomotion:

cost function为重投影误差:

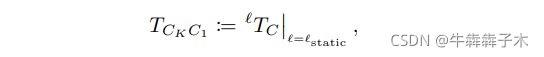

由上边得到的l标签下的egomotion可以进一步得到真实的相机运动:

和object运动:

3、相关实验及结果

4、未来工作

5、扩展阅读

(1)MOT相关技术

- Flow Techniques:基于光流[6]、场景流[7]和稀疏场景流[8]技术,查找场景中像素或特征点的2D或3D速度向量的方法(故此类网络可以计算场景流同时计算rigid motion)。这些速度本质上是平移的,涉及旋转的运动(即SE(3)变换)只能通过三个或更多速度的分段来估计。在存在小旋转的情况下,可以使用流动不连续性[9]或速度之间的矢量距离[8]实现这些分段。在大旋转时,速度变化是平滑的,各点的flow都不同,不能将一个物体上的运动分割为一个整体运动,所以不好分段。故不能用流方法估计rigid的full SE(3)。

- Tracking-by-Detection:首先基于外观进行目标检测,然后kalmen或粒子滤波器在给定运动模型下估计目标运动(此方法不能处理目标检测失败或遮挡的情况)。这中MOT方法只能在camera固定情况下运行,有些方法利用SLAM+MOT/MBSfM实现ego与多目标跟踪[14][15]。此类基于外观的检测方法进行目标跟踪的,遇到外观发生变化或遮挡都会出问题,且不能估计rigid的full SE(3),除非加入motion约束。

- 与上述基于流技术、基于外观的目标检测+tracking技术不同,本文使用基于特征点的技术

- 子空间方法:通过仿射变换替换透视变换,将相机的非线性投影模型进行线性近似,实现降维[16]。[17]使用仿射模型和矩阵分解将跟踪的图像点分解为运动矩阵和形状矩阵。也有直接对透视模型进行因子分解[21]:预先估计深度或运用几何约束。这一降维方法对噪声很敏感。

- 采样方法:如RANSAC方法,通过随机采样进行初始化然后用原始数据拟合,选取拟合数量最多的模型。

- Energy Minimization Methods:构建cost function优化得到最优trajetory。

(2)相关方案

- multiple object tracking (MOT) :

- 场景流相关:[8]P. Lenz, J. Ziegler, A. Geiger, and M. Roser, “Sparse scene flow segmentation for moving object detection in urban environments,” in IV, 2011, pp. 926–932.

- 多模型拟合算法(凸优化方法)CORAL:[3] P. Amayo, P. Pinies, L. M. Paz, and P. Newman, “Geometric Multi-Model Fitting with a Convex Relaxation Algorithm,” in CVPR, 2018.

- 多视图几何:[16] R. Hartley and A. Zisserman, Multiple view geometry in computer vision. Cambridge university press, 2003.

(三)CubeSLAM

1、系统功能和亮点

功能:本文提出了一种将二维和三维目标检测与SLAM姿态估计相结合的系统,用于静态和动态环境,并重点研究了一般的三维目标映射问题。

亮点:

- 一种高效、准确、鲁棒的单目三维长方体检测方法,无需先验对象模型

- 可以使目标检测和SLAM相辅相成,互相促进

- 利用检测得到的动态物体提升动态场景下的定位精度

- 即实现了multimotion估计,又有很好的map功能

2、系统结构流程

关注点:

- 单目情况下物体3D包围框的形成:使用射影几何来寻找长方体以紧密地拟合二维边界框,且可在不用预测对象大小和方向的情况下工作

- 动态场景的多目标定位如何实现?

- object信息如何帮助提升定位精度?

(0)2D目标检测:use the YOLO detector [41] with a probability threshold of 0.25 for indoor scenarios and MS-CNN [42] with a probability of 0.5 for outdoor KITTI. Both run in real time on a GPU

(1)单视图3D对象检测

3D cubiod需要得到9 DoF参数(位姿参数6,尺寸参数3),通过3D包围框投影至2D检测框,投影的角点都在2D检测框这一假设,可已得到4个约束(因为2D检测框有4个边);一般还需要学习(或预先提供)物体的尺寸和方向信息,本文使用VP(灭点常用来估计相机姿态,这里是估计长方体姿态);

- 灭点获取:灭点可由相机相对于物体的旋转矩阵R计算得到,所以此处灭点的选取就是R的选取。R可直接用深度学习预测,本文为了泛化性能选择采样评分方法。对于任意位置的物体需要随机采样三个自由度的R,而对于地面物体,由于SLAM中相机位姿已知,故地面物体的俯仰和滚转已知,只需采样偏航角度。

- 由灭点和一个顶点可以得到cubiod所有8个corners在图像上的2D点(这一个顶点也是采样获取,在top edge上取10点)

- 对于任意位置的物体:有8个2D corners点,一个点可以通过投影模型形成两个约束,四个点就能对物体的9 DoF状态进行约束,但无法确定尺度(八个约束如何约束9 DoF?之后此处的尺度如何与SLAM的尺度统一?)

- 对于地面物体:如果放在地面,则位于地面的corner可以很容易由线面交点计算,然后各边都是经过此点与地面垂直。(重点是如何地面检测并检测哪些顶点在地面上,相机高度如何得到?)

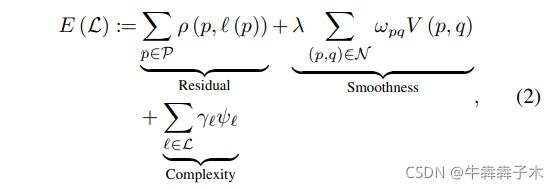

- 3D包围框的样本评分:对于采样后的灭点计算得到许多3D包围框的样本,对样本评分(评分规则很多,此处构造基于边缘对齐的损失函数),选取评分最高作为最优3D cubiod。此损失函数包括三部分:cubiod 边上点到image edges距离惩罚、image line与cubiod 灭点角度惩罚、物体类别尺寸先验惩罚(长宽比的一致性):

(2)object SLAM(针对静态目标):在ORB-SLAM2上改进得来,主要将object加入BA优化。

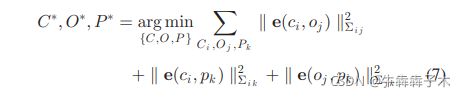

- BA formulation:主要由三部分组成,相机-物体残差、物体-点残差和相机-点残差

- 残差组成:相机-物体残差由两部分。第一项是3D观测项:地图中的object与当前观测的误差(观测是单帧检测到的object的位姿和大小,此项只有当单帧3D检测较为精确时才加入,例如在RGBD数据上进行3D detection时);第二项是2D观测项:将地图中的object的cubiod投影到当前帧与检测出的2D bounding box计算IOU;2D观测项相比3D项的不确定度较低,因为一般2D检测较3D检测精确一些。

物体-点残差就是看map中的属于物体的路标点是否在物体的3D bounding box上:

相机-点残差就是重投影误差:

- 数据关联:1、针对每一帧上的特征点,将其与所在2Dbounding box的物体关联;2、根据共视特征点个数多少将不同帧上的物体进行关联。

- map scale由相机高度得来(如何检测地面,如何从相机高度获得真实尺度?)

(3)动态SLAM(应该是在上边的object SLAM之后进行,针对动态目标)

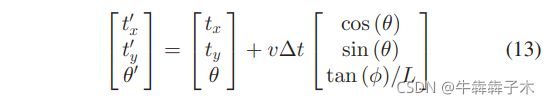

- Object Motion Model:非完整车轮模型(Car motion is represented by linear velocity v and steering angle φ)对于地面上的车辆可以表示为三自由度运动:

- Dynamic Point Observation:动态点在相机下的观测:

- 动态数据关联:1、动态特征点关联,不能用ORB中的特征点匹配策略,因为动态特征点不满足投影一致性,故用光流法跟踪特征点,然后因为已知物体位姿(单目object 3D检测得来)和相机位姿(object SLAM得来)故用三角化可以求得动态点的pose;2、动态物体关联,因为当像素移动距离大时不能用光流法跟踪特征点,所以用共视特征点数量判别是否为同一物体的方法不行,此处用视觉目标跟踪方法(tracking-by-detect)。跟踪对象的二维边界框并根据前一帧预测其位置,然后将其与当前帧中重叠率最大的检测到的边界框匹配。

3、相关实验及结果

(1)单视图3D对象检测

- 实验数据:SUN RGBD [43] and KITTI object [44] data with ground truth 3-D bounding box annotations

- 评价指标:3-D intersection over union (IoU)、average precision (AP)

- 对比对象:SUN RGBD上SUN primitive [10] and 3-D Geometric Phrases (3DGP) [46];KITTI object上用SubCNN和Deep3D

- 结果:SUN RGBD上几种方案近似;KITTI object上Deep3D直接用网络估计车辆朝向和尺寸,所以精度高很多。

(2)object SLAM

4、未来工作:未来,我们还将致力于使用object进行稠密建图。更完整的场景理解也可以与SLAM优化相结合。

点子:

- 做一个对于定位用特征点建立稀疏图,目标跟踪定位用直接法建立稠密点云图的双核方法

- 对象级SLAM将对象信息用于回环检测

- 建立的语义地图,在重定位中使用绝对静态地图中的静态物体拓扑关系进行重定位

- 3D包围框的评分可以用CubeSLAM中提到的semantic segmentation [12]替换。

- 综合CubeSLAM、DynamicSLAM 2中的3D bounding box方法,重点针对固定场景优化遮挡等情况下的3D包围框检测精度

- 加入对象稠密建图,加入更多的场景理解

5、扩展阅读

- 单目3D对象检测:一般结合几何和学习方法[13] [27]地面检测

- 多视图对象级SLAM:1、decoupled approaches:先形成三维点云图,然后基于点云聚类和语义信息进一步检测3D object并优化其位姿[16]–[18] 2、coupled approach(object-level SLAM):[20][21] 3、a real-time monocular object SLAM using the prior object models was proposed in [23] 4、[24] solved multiview 3-D ellipsoid object localization analytically and QuadriSLAM [25] extended it to an online SLAM without prior models 5、Uncertain data association of object SLAM is addressed in [26]

- 动态场景SLAM:[34]没有将动静分离而是utilizing dynamic point BA to improve camera pose estimation [32]使用语义分割和几何代价优化目标位置,但是是在相机固定情况下

- 物体运动模型:非完整车轮模型[39]

(四)ClusterVO

1、系统功能和亮点

功能:本文提出一种立体视觉里程计,可同时对自我和周围刚性物体的运动进行聚类和估计。

亮点:

- 完全基于稀疏地标和二维目标检测,为了利用这种轻量级表示,提出了一种鲁棒的多级概率关联技术(a robust multi-level probabilistic association technique),以有效地跟踪三维空间中随时间变化的低级特征和高级检测。

- 该算法综合考虑了语义包围框、空间关系和运动一致性,提出了一种高效的异构CRF(Conditional Random Field),用于发现新的聚类、聚类新的标志点和细化现有聚类。

2、系统结构流程

(1)多级概率关联技术:目的是将当前帧上观测的特征点与landmark匹配关联,并将当前帧观测到的object与地图中的clusters关联。首先计算landmark的不确定度,根据此不确定度计算各landmark与当前帧特征点关联的概率值,从而实现landmark与特征关联;然后根据特征关联结果,通过香农交叉熵计算各clusters与当前bounding box关联的概率值,进行实例关联;实例关联完成后,可以在bounding box中暴力搜索更多与landmark相匹配的特征点。

(2)异构CRF:目的是对新生成的landmarks点qi进行聚类,标记为现有clusters的id(标记问题)。结合语义、空间和运动信息的heterogeneous CRF,负责聚类分配

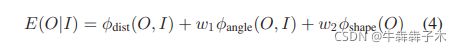

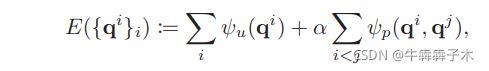

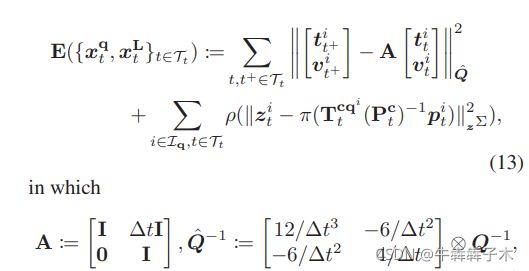

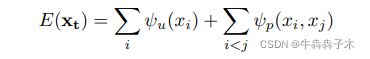

- 最小化以下能量函数:

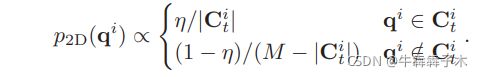

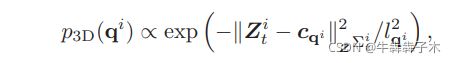

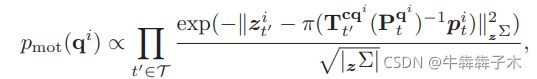

- 一元能量函数表征landmark i属于特定cluster qi的概率,其中p2D包含语义bounding box信息,在bounding box中的点概率大;p3D包含3D空间亲密度,点距离cluster qi的中心 的距离越近概率越大;pmot包含运动信息,将cluster的前几帧运动包含进来计算点的重投影误差:

- 二元能量函数:表示两个landmark离得越近,越有可能是同一cluster,起到保证标签空间连续性的作用(类似于考虑噪声的高斯平滑核函数)

- 前一步只是将当前帧各特征点聚类完成,可能聚类结果已经与之前的聚类分配值有关联,但有可能当前一类cluster的所有landmark对应着之前的不止一类cluster所以就用到二分图匹配方法(匈牙利算法)

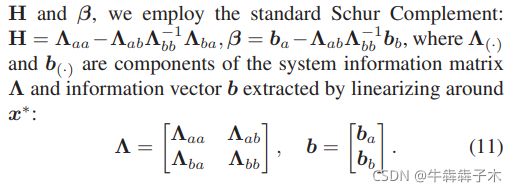

(3)滑动窗口状态估计:主要亮点是用了双跟踪框架,窗口内有时间序列又有空间序列,既保证对快速物体的跟踪,又保证窗内的baseline长度

- 对于静态物体(q=0):整个滑动窗口内优化,利用边缘化方法(加入边缘化残差项)

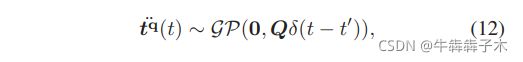

- 对于动态cluster(q!=0):cluster运动模型采用加速度为高斯白噪声的匀速运动,在滑动窗口的时间序列上进行优化,第一个优化项为运动先验,用来平滑运动轨迹,主要由运动模型式(12)得来。

3、相关实验及结果:主要与MVO、DynSLAM对比

While DynSLAM crops the depth map using 2D detections to generate spatial detections,

4、未来工作

- 点子:物体半稠密提取,一方面可以简化系统,一方面可以通过半稠密梯度较大的点后期拟合直线确定bounding box方向,bounding box的优化可以伴随整个系统周期,考虑将物体的轨迹优化与物体结构优化同时在一个窗口内进行(随着看到的物体部分越多,对物体结构刻画越完整)

- 将实例类别信息加入语义信息关联的考虑项中,同类更容易关联

- 每一关键帧同时保存当前帧所观测静态语义信息(方便重定位)

5、扩展阅读

- 3D目标检测及稠密建图:DynSLM:[2] Ioan Andrei Barsan, Peidong Liu, Marc Pollefeys, and An- dreas Geiger. Robust dense mapping for large-scale dynamic environments. In Proceedings of the IEEE International Conference on Robotics and Automation (ICRA), pages 7510–7517. IEEE, 2018. 1, 2, 7, 8 [7] Xiaozhi Chen, Kaustav Kundu, Yukun Zhu, Huimin Ma, Sanja Fidler, and Raquel Urtasun. 3d object proposals using stereo imagery for accurate object class detection. IEEE Transactions on Pattern Analysis and Machine Intelligence (PAMI), 40(5):1259–1272, 2017. 7, 8

(五)DynSLAM:Robust Dense Mapping for Large-Scale Dynamic Environments

1、系统功能和亮点

功能:本文提出一种适用于大尺度动态场景的鲁棒稠密建图算法。

亮点:

- 提出一种基于立体视觉的适用于大尺度动态场景的鲁棒稠密建图算法

- 建立高质量静态地图和单独的3D动态物体重建,建图采用基于体素块散列的体积表示方法。

- 提出了一种地图剪枝技术。

2、系统结构流程

主要流程:

- 由立体视觉(双目)计算depth map对图像进行语义分割,计算帧间稀疏光流;

- 由稀疏光流计算VO;

- 将输入按照分割图像分为背景和潜在运动物体;

- 根据场景流和语义分割信息估计检测出的物体的3D运动;

- 对每个感兴趣的刚性物体进行重建的初始化或更新;

- 更新静态地图的重建;

- 执行体素噪声收集以删除由于深度图中的瑕疵而错误分配的体素。

(1)稠密深度图计算:运用俩个先进的实时立体视图匹配技术计算视差图(Efficient Large-scale Stereo Matching (ELAS) [5] 方法and DispNet [15])。其中ELAS是几何方法,先是稀疏关键点匹配而后稠密匹配,此方法视差估计比较清晰但是不完整,在反光或透明物体部分存在空洞;DispNet是深度学习方法,它对非朗伯面可以鲁棒估计稠密视差图,但是估计结果不清晰,尤其在物体边缘处。本文结合以上两种方法实现优势互补。

(2)目标分割及2D跟踪:本文使用Multi-task Network Cascades [1] (MNC)进行实例分割,案后根据相邻帧的物体IoU大小进行目标跟踪(此过程只对刚性目标进行,将非刚性如行人直接剔除)

(3)稀疏场景流及VO:用的是libviso2 [6]中的方法,由单点及角点的特征匹配得到场景流,而后由RANSAC方法估计相机运动VO。

(4)3D目标跟踪:针对每一个物体实例,通过实例上的稀疏场景流计算“伪相机运动”,即假设目标为静态目标的情况下的相机运动,此结果是实际相机运动与实际物体运动的结合(结合方式见之前的总结);故对于静态物体此方式计算结果就是上一步计算的VO值的逆,通过此方式判断物体的动静。

(5)静态地图及单独的对象重建:本文利用InfiniTAM [11]进行体积融合,类似于《SLAM十四讲》建图中的深度融合部分内容。InfiniTAM [11]是一个实时、大规模深度融合和跟踪的有效框架。本文将静态地图与目标物重建分离单独重建,每个对象都由单个体积模型表示。

- 静态地图重建:VO计算得到的ego-motion、整幅RGB+depth map作为输入

- 目标重建:由分割的mask分割出的RGB+depth map作为虚拟帧,由3D目标跟踪计算得到的目标object 3D-motion、虚拟帧作为输入

(6)地图剪枝条:当在小范围执行体积重建时,例如使用RGBD相机扫描房间大小的环境,与从立体相机估计深度相比,得到的深度估计相关的噪声幅度相对较小。故在大规模的室外场景要考虑深度估计噪声,此噪声会产生建图时与视角相反方向的拖尾。为了去除此拖尾,本文在Nießner et al. [19]提出的方法上进行改进:可对体素块内单个体素进行判断剔除;只对当前帧可视体素进行处理,大大减小处理量(因为室外车辆很少闭环,走过的场景就很少再见,所以对整个体素模型进行处理没必要,等下次碰到再处理)。

3、相关实验及结果

4、未来工作

5、扩展阅读

- 相同的稠密建图方案:Co-Fusion:[14] Martin Runz and Lourdes Agapito. Co-Fusion: Real-time Seg- ¨ mentation, Tracking and Fusion of Multiple Objects. International Conference on Robotics and Automation, pages 4471–4478, 2017.

(六)*Co-fusion

1、系统功能和亮点

功能:本文提出一种可以实时维护全局背景几何模型并且对场景内每一分割出的目标进行建模和跟踪的方法。

亮点:

- 保存的目标模型形式是点云,目标模型分为:激活模型和未激活模型两种

2、系统结构流程

在背景模型及相机运动稳定后,对每一帧输入依次进行以下操作:

(1)Tracking:跟踪激活模型当前帧下的六自由度位姿,损失函数包括两部分:几何误差(dense ICP)和光度损失(类似直接法)

(2)Segmentation:分两种分割,其一是运动分解(将其视为标记问题,通过全连接条件随机场解决,其中单元能量由单像素与刚体模型的ICP构成);其二是语义分割,可将语义信息引入

- 运动分解:通过超像素划分,然后对超像素进行标记(全连接CRF方法),单元势函数就是ICP表征点跟model几何关系。分割之后还要进行连通域确定和抑制,对新物体进行判断添加;

- 语义分割:SharpMask网络,预训练COCO dataset

(3)Fusion:通过获得的6-DOF pose将当前帧的点融合到每个激活模型的稠密3D几何中。

3、实验及结果

实验内容:

- Pose estimation:每个目标轨迹的RMSE;

- Motion segmentation:二维图片上的IoU;

4、未来工作

5、扩展阅读

超像素划分:SLIC super-pixels [1]

surfel maps融合更新:[8]