hive的安装与配置

提示:文章写完后,目录可以自动生成,如何生成可参考右边的帮助文档

文章目录

hive的安装与配置详解

hive 中mysql的配置

前言

hive的安装与配置详解

hive 中mysql的配置

HIVE中配置文件:

链接:https://pan.baidu.com/s/1t4BHq8rvV31cKgnU4w4GAA?pwd=6666

提取码:6666

hive 安装步骤

先把我上面的文件下载到/opt/software/目录下

tar -zxvf apache-hive-3.1.2-bin.tar.gz -C /opt/module/mv /opt/module/apache-hive-3.1.2-bin/ hive配置环境变量

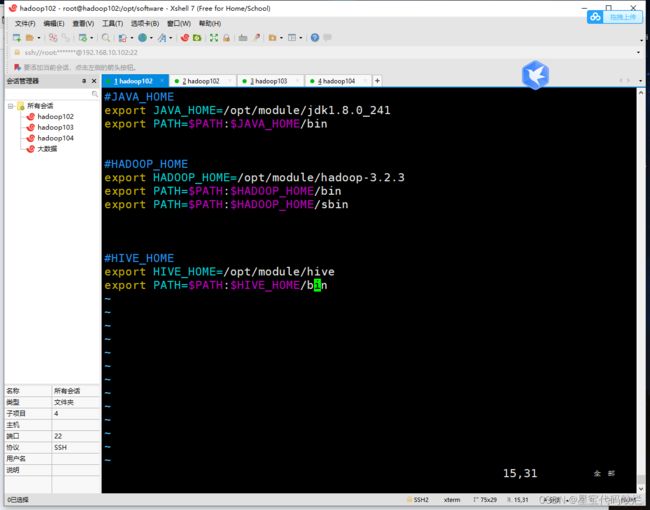

vim /etc/profile.d/my_env.sh加入下面代码

#HIVE_HOME

export HIVE_HOME=/opt/module/hive

export PATH=$PATH:$HIVE_HOME/bin

source /etc/profile.d/my_env.sh解决日志冲突

mv log4j-slf4j-impl-2.10.0.jar log4j-slf4j-impl-2.10.0.bak安装mysql

判断是否已经安装了mysql

rpm -qa | grep mariadb卸载命令

rpm -e --nodeps mariadb-libs将mysql驱动放到/opt/module/hive/lib/下

cp /opt/software/mysql-connector-java-5.1.37.jar ./lib/在 /opt/module/hive/conf 下vim hive-site.xml

添加下面的配置文件

javax.jdo.option.ConnectionURL

jdbc:mysql://hadoop102:3306/metastore?useSSL=false

javax.jdo.option.ConnectionDriverName

com.mysql.jdbc.Driver

javax.jdo.option.ConnectionUserName

root

javax.jdo.option.ConnectionPassword

msy1115

hive.metastore.schema.verification

false

hive.metastore.event.db.notification.api.auth

false

hive.metastore.warehouse.dir

/user/hive/warehouse

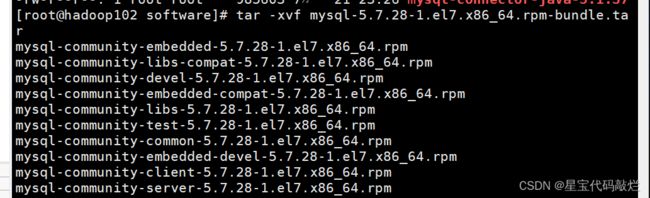

tar -xvf mysql-5.7.28-1.el7.x86_64.rpm-bundle.tar一定要按下面顺序来 !!!!

rpm -ivh mysql-community-common-5.7.28-1.el7.x86_64.rpm

rpm -ivh mysql-community-libs-5.7.28-1.el7.x86_64.rpm

rpm -ivh mysql-community-libs-compat-5.7.28-1.el7.x86_64.rpm

rpm -ivh mysql-community-client-5.7.28-1.el7.x86_64.rpm

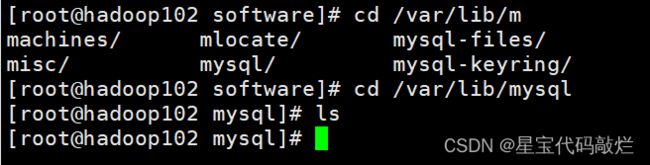

rpm -ivh mysql-community-server-5.7.28-1.el7.x86_64.rpm一般安装完mysql目录下是没东西的

有东西全删掉 删的时候注意!!!!

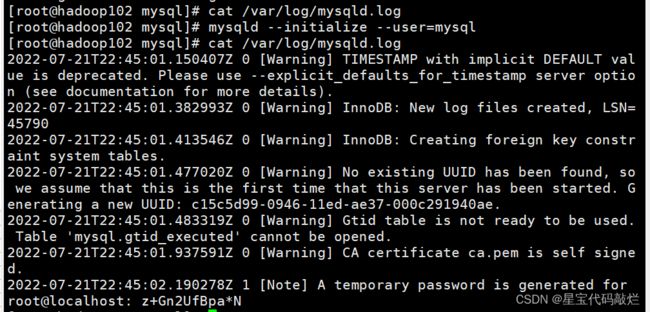

初始化数据库

mysqld --initialize --user=mysql查看临时生成的root用户密码

启动mysql服务

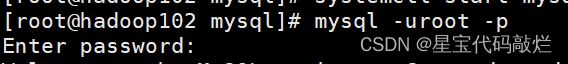

systemctl start mysqld进入mysql后必须先修改密码

修改mysql库下的user表中的root用户允许任意ip连接

mysql> update mysql.user set host='%' where user='root';

刷新一下

flush privileges;

在mysql里面创建 metastore

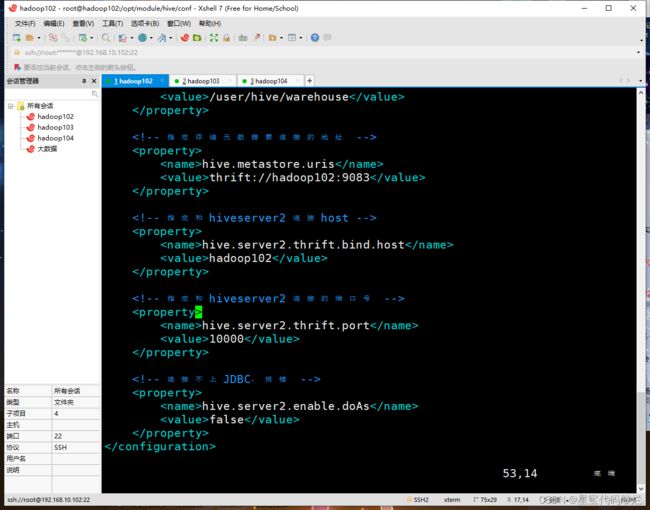

用jdbc来使用hive 需要下面步骤

配置hive-site.xml文件

hive.metastore.uris

thrift://hadoop102:9083

hive.server2.thrift.bind.host

hadoop102

hive.server2.thrift.port

10000

hive.server2.enable.doAs

false

bin/hive --service metastore

bin/hive --service hiveserver2

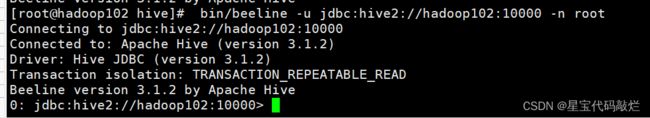

bin/beeline -u jdbc:hive2://hadoop102:10000 -n root编写一键启动metastore hiveserver2的脚本

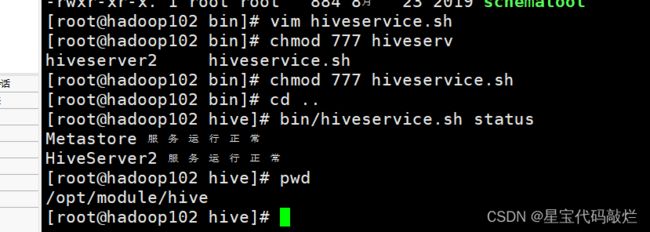

在 /opt/module/hive/bin中创建文件

vim hiveservice.sh脚本内容

HIVE_LOG_DIR=$HIVE_HOME/logs

if [ ! -d $HIVE_LOG_DIR ]

then

mkdir -p $HIVE_LOG_DIR

fi

#检查进程是否运行正常,参数 1 为进程名,参数 2 为进程端口

function check_process()

{

pid=$(ps -ef 2>/dev/null | grep -v grep | grep -i $1 | awk '{print $2}')

ppid=$(netstat -nltp 2>/dev/null | grep $2 | awk '{print $7}' | cut -d '/' -f 1)

echo $pid

[[ "$pid" =~ "$ppid" ]] && [ "$ppid" ] && return 0 || return 1

}

function hive_start()

{

metapid=$(check_process HiveMetastore 9083)

cmd="nohup hive --service metastore >$HIVE_LOG_DIR/metastore.log 2>&1&"

[ -z "$metapid" ] && eval $cmd || echo "Metastroe 服务已启动"

server2pid=$(check_process HiveServer2 10000)

cmd="nohup hiveserver2 >$HIVE_LOG_DIR/hiveServer2.log 2>&1 &"

[ -z "$server2pid" ] && eval $cmd || echo "HiveServer2 服务已启动"

}

function hive_stop()

{

metapid=$(check_process HiveMetastore 9083)

[ "$metapid" ] && kill $metapid || echo "Metastore 服务未启动"

server2pid=$(check_process HiveServer2 10000)

[ "$server2pid" ] && kill $server2pid || echo "HiveServer2 服务未启动"

}

case $1 in

"start")

hive_start

;;

"stop")

hive_stop

;;

"restart")

hive_stop

sleep 2

hive_start

;;

"status")

check_process HiveMetastore 9083 >/dev/null && echo "Metastore 服务运行正常" || echo "Metastore 服务运行异常"

check_process HiveServer2 10000 >/dev/null && echo "HiveServer2 服务运行正常" || echo "HiveServer2 服务运行异常"

;;

*)

echo Invalid Args!

echo 'Usage: '$(basename $0)' start|stop|restart|status'

;;

esac

然后给权限

chmod 777 hiveservice.sh bin/hiveservice.sh statustail -f hive.log查看日志