吃瓜教程task02 第3章 线性模型

第三章 线性模型

2022/5/16 雾切凉宫 至3.2节/视频P3

文章目录

- 第三章 线性模型

-

- 3.1 基本形式

- 3.2 线性回归

-

- P2 一元线性回归

-

- P2.1 最小二乘法

- P2.2 极大似然估计

-

- 误差ε

- 极大似然估计解法

- P2.3 求解w和b

- P2.4 机器学习三要素

- P3 多元线性回归

-

- P3.1 由最小二乘法导出w

3.1 基本形式

线性模型(linear model)试图学得一个通过属性的线性组合来进行预测的函数,即

f ( x ) = w 1 x 1 + w 2 x 2 + … … + w d x d + b f(x)=w_1x_1+w_2x_2+……+w_dx_d+b f(x)=w1x1+w2x2+……+wdxd+b

向量形式:

f ( x ) = w T x + b f(x)=w^Tx+b f(x)=wTx+b

w和b学得之后,模型就得以确定。

3.2 线性回归

数据集D:

D = { ( x 1 , y 1 ) , ( x 2 , y 2 ) , … … ( x m , y m ) , } D=\{(x_1,y_1),(x_2,y_2),……(x_m,y_m),\} D={(x1,y1),(x2,y2),……(xm,ym),}

其中:

x i = ( x i 1 ; x i 2 ; … … ; x i d ) x_i=(x_{i1};x_{i2};……;x_{id}) xi=(xi1;xi2;……;xid)

P2 一元线性回归

p2指的是datawhale吃瓜教程视频p2

P2.1 最小二乘法

均方误差(损失函数):

E ( w , b ) = ∑ i = 1 m ( y i − f ( x i ) ) 2 = ∑ i = 1 m ( y i − w x i − b ) 2 E(w,b)=\sum_{i=1}^m(y_i-f(x_i))^2=\sum_{i=1}^m(y_i-wx_i-b)^2 E(w,b)=i=1∑m(yi−f(xi))2=i=1∑m(yi−wxi−b)2

均方误差损失函数与“欧式距离”相同,基于均方误差求解模型称为最小二乘法

( w , b ) = a r g m i n ( w , b ) ∑ i = 1 m ( y i − w x i − b ) 2 (w,b)=argmin_{(w,b)}\sum_{i=1}^m(y_i-wx_i-b)^2 (w,b)=argmin(w,b)i=1∑m(yi−wxi−b)2

P.S. argmin指后面式子取最小值时(w,b)的值!

P2.2 极大似然估计

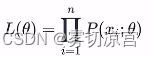

极大似然原理:使得观测样本出现概率最大的分布就是待求分布,也即使得联合概率(似然函数) L(θ)取到最大值的θ*即为θ的估计值。

x 1 , x 2 , x 3 … … , x n 是 n 个 独 立 同 分 布 的 样 本 , x 已 知 θ 未 知 x_1,x_2,x_3……,x_n是n个独立同分布的样本,x已知θ未知 x1,x2,x3……,xn是n个独立同分布的样本,x已知θ未知

他们的联合概率为(似然函数):

说人话:让L(θ)最大的θ值即为待求分布参数θ的值

P.S:分布参数:如正态分布N(μ,σ^2)。

一 般 的 , 使 用 l n L ( θ ) 代 替 L ( θ ) 以 简 化 连 乘 项 一般的,使用lnL(θ)代替L(θ)以简化连乘项 一般的,使用lnL(θ)代替L(θ)以简化连乘项

误差ε

线性回归模型为:

y = w x + b + ε y=wx+b+ε y=wx+b+ε

ε为不受控制的随机误差,通常假设其服从正态分布ε~N(0,σ^2)

故ε的概率分布函数为:

p ( ε ) = 1 2 π σ e − ε 2 2 σ 2 p(ε)=\frac{1}{\sqrt{2π}σ}e^{-\frac{ε^2}{2σ^2}} p(ε)=2πσ1e−2σ2ε2

进而可知:

p ( y ) = 1 2 π σ e − ( y − ( w x + b ) ) 2 2 σ 2 p(y)=\frac{1}{\sqrt{2π}σ}e^{-\frac{(y-(wx+b))^2}{2σ^2}} p(y)=2πσ1e−2σ2(y−(wx+b))2

极大似然估计解法

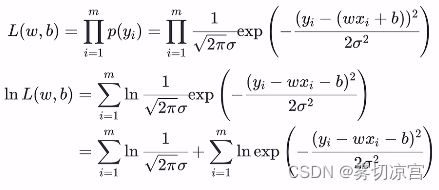

上式可看做y~N(wx+b,σ^2),写出似然函数L(w,b):

根据最大似然理论,求似然函数L(w,b)取最大值时(w,b)的取值。

由于上式中第一项为常数,所以问题简化为求第二项的最大值:

( w ∗ , b ∗ ) = a r g m a x ( w , b ) l n L ( w , b ) = a r g m i n ( w , b ) ∑ i = 1 m ( y i − w x i − b ) 2 (w^*,b^*)=argmax_{(w,b)}lnL(w,b)=argmin_{(w,b)}\sum_{i=1}^m(y_i-wx_i-b)^2 (w∗,b∗)=argmax(w,b)lnL(w,b)=argmin(w,b)i=1∑m(yi−wxi−b)2

可见所得结果与之前使用最小二乘法所得结果一致

P2.3 求解w和b

由之前最小二乘法与极大似然估计法都得出同一个结果:

( w ∗ , b ∗ ) = a r g m i n ( w , b ) ∑ i = 1 m ( y i − w x i − b ) 2 (w^*,b^*)=argmin_{(w,b)}\sum_{i=1}^m(y_i-wx_i-b)^2 (w∗,b∗)=argmin(w,b)i=1∑m(yi−wxi−b)2

E ( w , b ) = ∑ i = 1 m ( y i − w x i − b ) 2 E(w,b)=\sum_{i=1}^m(y_i-wx_i-b)^2 E(w,b)=i=1∑m(yi−wxi−b)2

对于E(w,b)为凸函数的证明这里不再赘述。

分别对w和b求导:

∂ E ( w , b ) ∂ w = 2 ( w ∑ i = 1 m x i 2 − ∑ i = 1 m ( y i − b ) x i ) \frac{\partial{E(w,b)}}{\partial{w}}=2(w\sum_{i=1}^mx_i^2-\sum_{i=1}^m(y_i-b)x_i) ∂w∂E(w,b)=2(wi=1∑mxi2−i=1∑m(yi−b)xi)

∂ E ( w , b ) ∂ b = 2 ( m b − ∑ i = 1 m ( y i − w x i ) ) \frac{\partial{E(w,b)}}{\partial{b}}=2(mb-\sum_{i=1}^m(y_i-wx_i)) ∂b∂E(w,b)=2(mb−i=1∑m(yi−wxi))

由于▽E(w,b)=0时函数取最小值,代入上述二式得:

w = ∑ i = 1 m y i ( x i − x ‾ ) ∑ i = 1 m x i 2 − 1 m ( ∑ i = 1 m x i ) 2 w=\frac{\displaystyle\sum_{i=1}^my_i(x_i-\overline{x})}{\displaystyle\sum_{i=1}^mx_i^2-\frac{1}{m}(\sum_{i=1}^mx_i)^2} w=i=1∑mxi2−m1(i=1∑mxi)2i=1∑myi(xi−x)

b = 1 m ∑ i = 1 m ( y i − w x i ) b=\frac{1}{m}\sum_{i=1}^m(y_i-wx_i) b=m1i=1∑m(yi−wxi)

P2.4 机器学习三要素

- 模型:根据具体问题,确定假设空间

- 策略:根据评价标准,确定选取最优模型的策略(通常会产出一个“损失函数”

- 算法:求解损失函数,确定最优模型

P3 多元线性回归

P3.1 由最小二乘法导出w

模型为:

f ( x i ) = [ w 1 w 2 … w d b ] [ x i 1 x i 2 ⋮ x i d 1 ] f(x_i)=\begin{bmatrix}w_1 & w_2…w_d & b\end{bmatrix}\begin{bmatrix} x_{i1} \\ x_{i2} \\ \vdots \\ x_{id} \\ 1 \\ \end{bmatrix} f(xi)=[w1w2…wdb]⎣⎢⎢⎢⎢⎢⎡xi1xi2⋮xid1⎦⎥⎥⎥⎥⎥⎤

简写为:

f ( x i ^ ) = w T ^ x i ^ f(\hat{x_i})=\hat{w^T}\hat{x_i} f(xi^)=wT^xi^

由最小二乘法可得损失函数E(w):

E ( w ^ ) = ∑ i = 1 m ( y i − f ( x i ^ ) ) 2 = ∑ i = 1 m ( y i − w T ^ x i ^ ) 2 E(\hat{w})=\sum_{i=1}^m(y_i-f(\hat{x_i}))^2=\sum_{i=1}^m(y_i-\hat{w^T}\hat{x_i})^2 E(w^)=i=1∑m(yi−f(xi^))2=i=1∑m(yi−wT^xi^)2

向量化损失函数E(w):

举个例子:

a 2 + b 2 = [ a , b ] [ a b ] a^2+b^2=[a,b]\begin{bmatrix}a\\b\end{bmatrix} a2+b2=[a,b][ab]

所以损失函数E(w)可化简为:

E ( w ^ ) = [ y 1 − w ^ T x 1 ^ y 2 − w ^ T x 2 ^ … y m − w ^ T x m ^ ] [ y 1 − w ^ T x 1 ^ y 2 − w ^ T x 2 ^ ⋮ y m − w ^ T x m ^ ] E(\hat{w})=\begin{bmatrix}y_1-\hat{w}^T\hat{x_1} & y_2-\hat{w}^T\hat{x_2}…y_m-\hat{w}^T\hat{x_m}\end{bmatrix} \begin{bmatrix} y_1-\hat{w}^T\hat{x_1} \\ y_2-\hat{w}^T\hat{x_2} \\ \vdots \\ y_m-\hat{w}^T\hat{x_m} \end{bmatrix} E(w^)=[y1−w^Tx1^y2−w^Tx2^…ym−w^Txm^]⎣⎢⎢⎢⎡y1−w^Tx1^y2−w^Tx2^⋮ym−w^Txm^⎦⎥⎥⎥⎤

又对上式中最后的列向量可以化简:

[ y 1 − w ^ T x 1 ^ y 2 − w ^ T x 2 ^ ⋮ y m − w ^ T x m ^ ] = [ y 1 y 2 ⋮ y m ] [ w ^ T x 1 ^ w ^ T x 2 ^ ⋮ w ^ T x m ^ ] = y − X w ^ \begin{bmatrix} y_1-\hat{w}^T\hat{x_1} \\ y_2-\hat{w}^T\hat{x_2} \\ \vdots \\ y_m-\hat{w}^T\hat{x_m} \end{bmatrix}= \begin{bmatrix} y_1 \\ y_2 \\ \vdots \\ y_m \end{bmatrix} \begin{bmatrix} \hat{w}^T\hat{x_1} \\ \hat{w}^T\hat{x_2} \\ \vdots \\ \hat{w}^T\hat{x_m} \end{bmatrix} =y-X\hat{w} ⎣⎢⎢⎢⎡y1−w^Tx1^y2−w^Tx2^⋮ym−w^Txm^⎦⎥⎥⎥⎤=⎣⎢⎢⎢⎡y1y2⋮ym⎦⎥⎥⎥⎤⎣⎢⎢⎢⎡w^Tx1^w^Tx2^⋮w^Txm^⎦⎥⎥⎥⎤=y−Xw^

最终**损失函数E(w)**为:

E ( w ^ ) = ( y − X w ^ ) T ( y − X w ^ ) E(\hat{w})=(y-X\hat{w})^T(y-X\hat{w}) E(w^)=(y−Xw^)T(y−Xw^)

求w的问题转化为:

w ^ = a r g m i n w ^ E ( w ^ ) = a r g m i n w ^ ( y − X w ^ ) T ( y − X w ^ ) \hat{w}=argmin_{\hat{w}}E(\hat{w})=argmin_{\hat{w}}(y-X\hat{w})^T(y-X\hat{w}) w^=argminw^E(w^)=argminw^(y−Xw^)T(y−Xw^)

同样对于E(w)为凸函数的证明这里不再赘述。

对w求导得:

∂ E ( w ^ ) ∂ w ^ = 2 X T ( X w ^ − y ) \frac{\partial{E(\hat{w})}}{\partial{\hat{w}}}=2X^T(X\hat{w}-y) ∂w^∂E(w^)=2XT(Xw^−y)

由于▽E(w)=0时函数取最小值,代入上式得:

w ^ ∗ = ( X T X ) − 1 X T y \hat{w}^*=(X^TX)^{-1}X^Ty w^∗=(XTX)−1XTy