KafkaAPI--自定义拦截器

拦截器

拦截器(interceptor)是在 Kafka 0.10 版本被引入的,主要用于实现 clients 端的定制化控制逻辑。

Intercetpor 的实现接口是org.apache.kafka.clients.producer.ProducerInterceptor,其定义的方法包括:

-

configure(configs)

获取配置信息和初始化数据时调用。 -

onSend(ProducerRecord):

该方法封装进KafkaProducer.send方法中,即它运行在用户主线程中。

Producer确保在消息被序列化以及计算分区前调用该方法。用户可以在该方法中对消息做任何操作,但最好保证不要修改消息所属的topic和分区,否则会影响目标分区的计算。 -

onAcknowledgement(RecordMetadata, Exception):

该方法会在消息从RecordAccumulator成功发送到Kafka Broker之后,或者在发送过程

中失败时调用。

并且通常都是在producer回调逻辑触发之前。onAcknowledgement运行在producer的IO线程中,因此不要在该方法中放入很重的逻辑,否则会拖慢producer的消息发送效率。 -

close:

关闭interceptor,主要用于执行一些资源清理工作如前所述。

interceptor可能被运行在多个线程中,因此在具体实现时用户需要自行确保线程安全。另外倘若指定了多个interceptor,则producer将按照指定顺序调用它们,并仅仅是捕获每个interceptor可能抛出的异常记录到错误日志中而非在向上传递。这在使用过程中要特别留意。

实例

需求分析

实现一个简单的双拦截器组成的拦截链,第一个拦截器会在消息发送前将时间戳信息加到消息value之前,第二个拦截器会在消息发送后更新成功发送消息数或失败发送消息数。

代码实现

拦截器1:实现消息戳附加

package com.interceptor;

import org.apache.kafka.clients.producer.ProducerInterceptor;

import org.apache.kafka.clients.producer.ProducerRecord;

import org.apache.kafka.clients.producer.RecordMetadata;

import java.util.Map;

public class TimeInterceptor implements ProducerInterceptor<String,String> {

@Override

public ProducerRecord<String, String> onSend(ProducerRecord<String, String> producerRecord) {

// 1.取出数据

String value = producerRecord.value();

// 2.创建一个新的ProducerRecord对象并返回

return new ProducerRecord<String,String>(producerRecord.topic(),producerRecord.partition(),producerRecord.key(),System.currentTimeMillis()+","+value);

}

@Override

public void onAcknowledgement(RecordMetadata recordMetadata, Exception e) {

}

@Override

public void close() {

}

@Override

public void configure(Map<String, ?> map) {

}

}

拦截器2:实现消息发送统计

package com.interceptor;

import org.apache.kafka.clients.producer.ProducerInterceptor;

import org.apache.kafka.clients.producer.ProducerRecord;

import org.apache.kafka.clients.producer.RecordMetadata;

import java.util.Map;

public class CounterInterceptor implements ProducerInterceptor<String,String> {

int success;

int error;

@Override

public ProducerRecord<String, String> onSend(ProducerRecord<String, String> producerRecord) {

return producerRecord;

}

@Override

public void onAcknowledgement(RecordMetadata recordMetadata, Exception e) {

// 1.

if(recordMetadata != null){

success ++;

}else{

error++;

}

}

@Override

public void close() {

System.out.println("success:"+success);

System.out.println("error:"+error);

}

@Override

public void configure(Map<String, ?> map) {

}

}

生产者

package com.producer;

import org.apache.kafka.clients.producer.KafkaProducer;

import org.apache.kafka.clients.producer.Producer;

import org.apache.kafka.clients.producer.ProducerRecord;

import java.util.ArrayList;

import java.util.Properties;

import java.util.concurrent.ExecutionException;

public class InterceptorProducer {

public static void main(String[] args) throws ExecutionException, InterruptedException{

// 创建Kafka生产者配置对象

Properties props = new Properties();

// 连接指定的kafka集群

props.put("bootstrap.servers", "ch2:9092");

// 设置ack应答级别

props.put("acks", "all");

// 重试次数

props.put("retries", 1);

// 批次大小

props.put("batch.size", 16384);

// 等待时间

props.put("linger.ms", 1);

// RecordAccumulator 缓冲区大小

props.put("buffer.memory", 33554432);

// key的序列化

props.put("key.serializer", "org.apache.kafka.common.serialization.StringSerializer");

// 添加拦截器

ArrayList<String> interceptors= new ArrayList<String>();

interceptors.add("com.interceptor.TimeInterceptor");

interceptors.add("com.interceptor.CounterInterceptor");

props.put("interceptor.classes",interceptors);

// value的序列化

props.put("value.serializer", "org.apache.kafka.common.serialization.StringSerializer");

// 创建生产者对象

Producer<String, String> producer = new KafkaProducer<>(props);

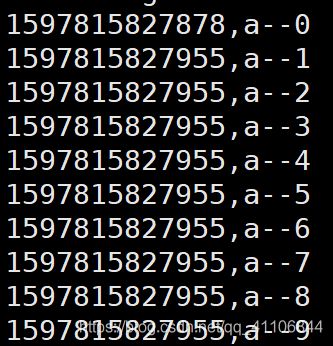

for (int i = 0; i < 10; i++) {

producer.send(new ProducerRecord<String, String>("first","cs","a--"+i));

}

// 释放资源

producer.close();

}

}